-12 43.67993 host stor11

87 5.45999 osd.87 down 0 1.00000

-15 43.67993 host stor14

109 5.45999 osd.109 down 0 1.00000

-17 43.67993 host stor16

125 5.45999 osd.125 down 0 1.00000

127 5.45999 osd.127 down 0 1.00000

-20 43.67993 host stor19

144 5.45999 osd.144 down 0 1.00000

146 5.45999 osd.146 down 0 1.00000

30号凌晨2点左右,ceph集群数据同步还差1.5%,但是已经不同步数据了。其中有7个pgs down

启动了25个down掉的osd,其中大部分osd是以前down的

==================================================================================

service ceph status

一般会有一个盘会化很多分区用来分别存储每一个osd的日志,如这个就是sdg盘(有多少个osd就会有多少个分区)

[root@stor12 dev]# lsblk【列出所有可用块设备的信息,而且还能显示他们之间的依赖关系】

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT【其他硬盘单个做osd】

sda 8:0 0 5.5T 0 disk

└─sda1 8:1 0 5.5T 0 part /var/lib/ceph/osd/ceph-90

sdb 8:16 0 5.5T 0 disk

└─sdb1 8:17 0 5.5T 0 part /var/lib/ceph/osd/ceph-91

sdc 8:32 0 5.5T 0 disk

└─sdc1 8:33 0 5.5T 0 part /var/lib/ceph/osd/ceph-92

sdd 8:48 0 5.5T 0 disk

└─sdd1 8:49 0 5.5T 0 part /var/lib/ceph/osd/ceph-93

sde 8:64 0 5.5T 0 disk

└─sde1 8:65 0 5.5T 0 part /var/lib/ceph/osd/ceph-94

sdf 8:80 0 5.5T 0 disk

└─sdf1 8:81 0 5.5T 0 part /var/lib/ceph/osd/ceph-95

sdg 8:96 0 893.8G 0 disk 【2个固态硬盘做raid1,做日志的软连接存储目录】

├─sdg1 8:97 0 92.2G 0 part

├─sdg2 8:98 0 92.2G 0 part

├─sdg3 8:99 0 92.2G 0 part

├─sdg4 8:100 0 92.2G 0 part

├─sdg5 8:101 0 92.2G 0 part

├─sdg6 8:102 0 92.2G 0 part

├─sdg7 8:103 0 92.2G 0 part

└─sdg8 8:104 0 92.2G 0 part

sdh 8:112 0 5.5T 0 disk

└─sdh1 8:113 0 5.5T 0 part /var/lib/ceph/osd/ceph-88

sdi 8:128 0 5.5T 0 disk

└─sdi1 8:129 0 5.5T 0 part /var/lib/ceph/osd/ceph-89

sdj 8:144 0 5.5T 0 disk 【2个硬盘做raid1,安装系统】

├─sdj1 8:145 0 4M 0 part

├─sdj2 8:146 0 1G 0 part /boot

└─sdj3 8:147 0 582G 0 part

├─rhel_stor12-root 253:0 0 500G 0 lvm /

├─rhel_stor12-swap 253:1 0 32G 0 lvm [SWAP]

└─rhel_stor12-home 253:2 0 50G 0 lvm /home

查看ceph-osd的日志盘

cd /var/lib/ceph/osd【查看全部osd的软连接】

ls -l ceph-*/journal

下面就是每个osd对应的日志软连接,如果和lsblk的对应不上,则表示该服务器重启后软连接便了(盘符变了,比如sdg变成了sda),这时候就会导致启动osd的时候找到不到日志存储盘,所以osd无法up。

[root@stor03 osd]# cd /var/lib/ceph/osd/【进到日志目录】

[root@stor03 osd]# ls -l ceph-*/journal【查看所有软连接】

lrwxrwxrwx 1 root root 9 Dec 30 2019 ceph-16/journal -> /dev/sdg1

lrwxrwxrwx 1 root root 9 Dec 30 2019 ceph-17/journal -> /dev/sdg2

lrwxrwxrwx 1 root root 9 Dec 30 2019 ceph-18/journal -> /dev/sdg3

lrwxrwxrwx 1 root root 9 Dec 30 2019 ceph-19/journal -> /dev/sdg4

lrwxrwxrwx 1 root root 9 Dec 30 2019 ceph-20/journal -> /dev/sdg5

lrwxrwxrwx 1 root root 9 Dec 30 2019 ceph-21/journal -> /dev/sdg6

lrwxrwxrwx 1 root root 9 Dec 30 2019 ceph-22/journal -> /dev/sdg7

lrwxrwxrwx 1 root root 9 Dec 30 2019 ceph-23/journal -> /dev/sdg8

[root@stor03 osd]#

比如发现软连接显示的磁盘目录和lsblk查看的结果不一致,进入到该osd目录,比如ceph-90不一致

cd /var/lib/ceph/osd/ceph-90/

ls -l【核实软连接和lsblk确实不一致】

rm -f journal【删除这个软连接】

ln -s /dev/sdg1 journal【重建这个软连接,以lsblk的为准】

注:上面重建软连接步骤,有多少个盘就重复多少次,比如上面有sdg1~sdg8就需要重复8次该操作。

service ceph status osd.90 【查看osd.90状态】

service ceph start osd.90【启动osd.90,也可以这样:/etc/init.d/ceph start osd.90】

service ceph status【查看全部】

【在存储节点,查看osd.90对应的日志,查看osd是否正常】

cd /var/log/ceph

tail -f ceph-osd.90.log

出现going to standby正常

有time out的是osd down的时间节点

有些软连接是使用的盘名称,所以会发生上述情况,如果使用的是uuid,则一般不会发生上述情况,uuid显示结果如下

[root@stor-3 ~]# cd /var/lib/ceph/osd

[root@stor-3 osd]# ls -l ceph-*/journal

lrwxrwxrwx 1 root root 58 Dec 27 2016 ceph-10/journal -> /dev/disk/by-partuuid/35534a97-7c23-4cd1-9f37-0557a21f1cf5

lrwxrwxrwx 1 root root 58 Dec 27 2016 ceph-13/journal -> /dev/disk/by-partuuid/fd9a7e66-d69e-4cd6-b955-1f65fbd348e4

lrwxrwxrwx 1 root root 58 Dec 27 2016 ceph-14/journal -> /dev/disk/by-partuuid/16d94f0a-92b0-4368-99d0-823d2a6fdd47

lrwxrwxrwx 1 root root 58 Dec 27 2016 ceph-17/journal -> /dev/disk/by-partuuid/0ac7bfe9-5311-4b93-8c1b-b3f512054021

lrwxrwxrwx 1 root root 58 Dec 27 2016 ceph-18/journal -> /dev/disk/by-partuuid/72893f30-0dd6-4183-850b-922b7789fb6a

lrwxrwxrwx 1 root root 58 Dec 27 2016 ceph-1/journal -> /dev/disk/by-partuuid/2ed74354-d0b5-4a15-aa7f-103f9ab6168e

lrwxrwxrwx 1 root root 58 Dec 27 2016 ceph-2/journal -> /dev/disk/by-partuuid/018f6fb7-b5db-4e81-b58b-f099bd4d631f

lrwxrwxrwx 1 root root 58 Dec 27 2016 ceph-5/journal -> /dev/disk/by-partuuid/ba910d2a-4454-4618-b4c0-d002675779db

lrwxrwxrwx 1 root root 58 Dec 27 2016 ceph-6/journal -> /dev/disk/by-partuuid/53631fd2-0895-4077-966d-d7a997eb7cdc

lrwxrwxrwx 1 root root 58 Dec 27 2016 ceph-9/journal -> /dev/disk/by-partuuid/2aeef55b-5e0b-4d8a-aa08-2f5dc906dc08

=================================================================

-

31号下午2点,同步停止,但是还没有同步完,还是有7个pgs down

-

【查看哪些pg处于down+peering】【pgs down 是因为pg 的副本数少于2】【pg有2个副本就能提供服务,少于2就down】

ceph health detail【显示结果大量pg 1.1055状态是down+peering】

- 查看pg 1.1055信息

ceph pg 1.1055 query【查看peer是在哪个osd上】【peer下一行的blocked就有osd的编号】

- 查看osd

ceph daemon osd.87 status【查看osd状态】

- 启动osd

service ceph start osd.87

-

工程师启动了1个29号down掉的osd.87,osd.87启动后有6个pgs down的状态消失

-

1号

凌晨6点,同步停止,但是还没有同步完,还有1个pgs down

还有33 72 125 127 109 osd是29号down的没启动

ceph health detail【显示结果大量pg 4.a3状态是down+peering】

- 查看pg 4.a3信息

ceph pg 4.a3 query【查看不了】

最后

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Java工程师,想要提升技能,往往是自己摸索成长,自己不成体系的自学效果低效漫长且无助。

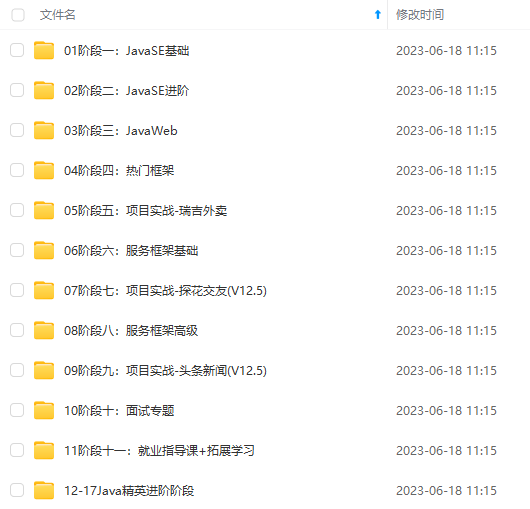

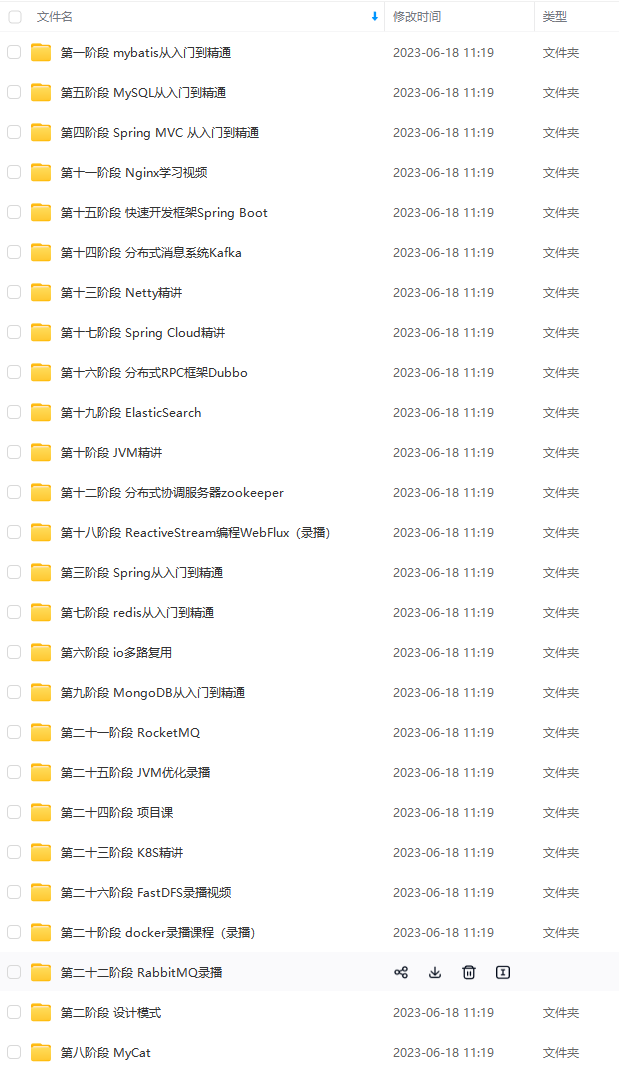

因此收集整理了一份《2024年Java开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Java开发知识点,不论你是刚入门Java开发的新手,还是希望在技术上不断提升的资深开发者,这些资料都将为你打开新的学习之门!

如果你觉得这些内容对你有帮助,需要这份全套学习资料的朋友可以戳我获取!!

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

mg-lTtDUxj6-1715864699600)]

[外链图片转存中…(img-pKZ8hAZy-1715864699601)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Java开发知识点,不论你是刚入门Java开发的新手,还是希望在技术上不断提升的资深开发者,这些资料都将为你打开新的学习之门!

如果你觉得这些内容对你有帮助,需要这份全套学习资料的朋友可以戳我获取!!

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

832

832

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?