如图所示,它主要分为四个部分:

-

Downloader(页面下载)

-

PageProcessor(页面分析及链接抽取)

-

Scheduler(URL管理)

-

Pipeline(后续处理和持久化)

webmagic的用法其实很简单,复杂的部分webmagic都替我们封装好了,接下来开始我们爬虫历程。

1.首先引入webmagic的依赖

us.codecraft

webmagic-core

0.6.1

us.codecraft

0.6.1

webmagic-extension

us.codecraft

webmagic-selenium

0.6.1

org.seleniumhq.selenium

selenium-java

3.3.1

2.创建PageProcessor,用来处理网页数据

/**

- @author linzhiqiang

*/

public class CsdnBlogProcessor implements PageProcessor {

private Site site = Site

.me()

.setDomain(“csdn.net”)

.setSleepTime(3000)

.setUserAgent(

“Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_2) AppleWebKit/537.31 (KHTML, like Gecko) Chrome/26.0.1410.65 Safari/537.31”);

@Override

public void process(Page page) {

System.out.println(“html:”+page.getHtml());

}

@Override

public Site getSite() {

return site;

}

}

site中放置爬取的网站域名、cookie、请求头等信息。 process用来处理爬取到的网页数据,处理完的数据可以通过page.putField(),再通过Pipeline获取存储到数据库。

3.创建Pipeline,存储处理好的网页数据

public class CsdnPipeline implements Pipeline {

@Override

public void process(ResultItems resultItems, Task task) {

//文章题目

String title = resultItems.get(“title”);

//文章内容

String context = resultItems.get(“context”);

System.out.println(“title:” + title);

System.out.println(“context:” + context);

}

}

在process中通过resultItems来获取PageProcessor存储的page数据,最后我们可以将数据存储到redis、数据库、文件等地方。

4.利用Scheduler调度爬取任务

public class RedisScheduler extends DuplicateRemovedScheduler implements

MonitorableScheduler, DuplicateRemover {

@Override

public int getLeftRequestsCount(Task task) {

return 0;

}

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数前端工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

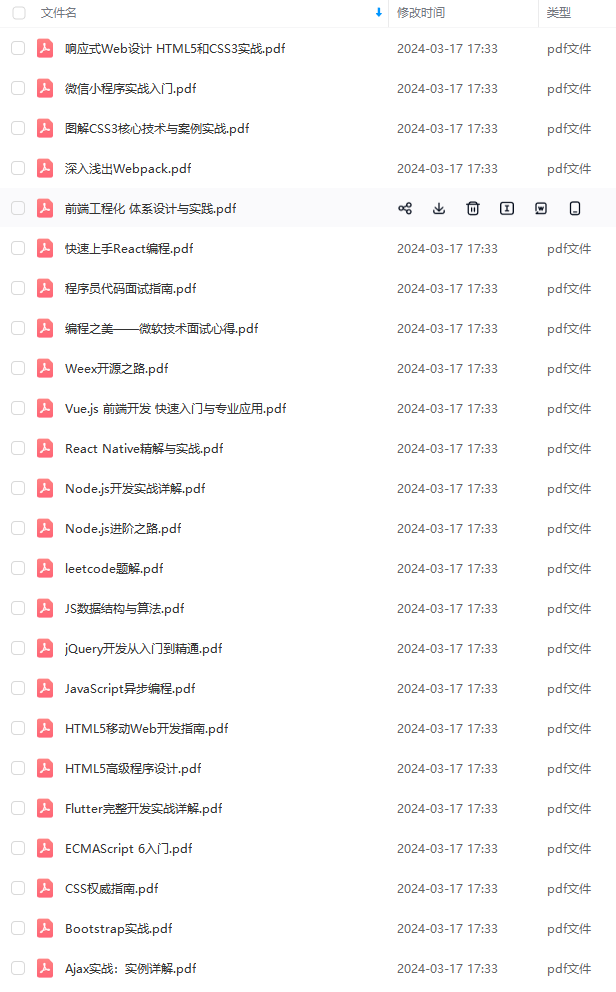

因此收集整理了一份《2024年Web前端开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

如果你觉得这些内容对你有帮助,可以扫码获取!!(备注:前端)

前端面试题是我面试过程中遇到的面试题,每一次面试后我都会复盘总结。我做了一个整理,并且在技术博客找到了专业的解答,大家可以参考下:

由于篇幅有限,只能分享部分面试题,完整版面试题及答案可以【点击我】阅读下载哦~无偿分享给大家

感悟

log.csdnimg.cn/img_convert/9749ea39072fc4b7b27af6f3a4db5ab1.png)

由于篇幅有限,只能分享部分面试题,完整版面试题及答案可以【点击我】阅读下载哦~无偿分享给大家

感悟

春招面试的后期,运气和实力都很重要,自己也是运气比较好,为了回馈粉丝朋友们(毕竟自己也玩了这么久哈哈哈),整理个人感悟和总结以上。最后祝愿大家能够收获理想offer!!

1046

1046

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?