-

安全 传统Linux IPC的接收方无法获得对方进程可靠的UID/PID,从而无法鉴别对方身份;而Android作为一个开放的开源体系,拥有非常多的开发平台,App来源甚广,因此手机的安全显得额外重要;对于普通用户,绝不希望从App商店下载偷窥隐射数据、后台造成手机耗电等等问题,传统Linux IPC无任何保护措施,完全由上层协议来确保。Android系统中对外只暴露Client端,Client端将任务发送给Server端,Server端会根据权限控制策略,判断UID/PID是否满足访问权限,目前权限控制很多时候是通过弹出权限询问对话框,让用户选择是否运行。

-

语言 Linux是基于C语言(面向过程的语言),而Android是基于Java语言(面向对象的语句),而对于Binder恰恰也符合面向对象的思想,将进程间通信转化为通过对某个Binder对象的引用调用该对象的方法,而其独特之处在于Binder对象是一个可以跨进程引用的对象,它的实体位于一个进程中,而它的引用却遍布于系统的各个进程之中

-

开源协议 Linux内核是开源的系统,所开放源代码许可协议GPL保护。该协议具有“病毒式感染”的能力,只要进行了系统调用,调用到内核,那么也必须遵守GPL开源协议。Android 之父 Andy Rubin对于GPL显然是不能接受的,为此,Google巧妙地将GPL协议控制在内核空间,将用户空间的协议采用Apache-2.0协议。同时在GPL协议与Apache-2.0之间的Lib库中采用BSD证授权方法,有效隔断了GPL的传染性

Binder作用

好吧,你说的很多确实很有道理,可是Binder到底有什么作用呢,我日常开发也没用到Binder 啊。

不不不,你错了,你的日常开发肯定用到了Binder,只不过你不知道而已。就以最常见的startActivity来说吧,经过层层调用,最后还是通过Binder来实现的。所以学习好Binder原理,更有利于我们了解Android系统的构建,也能开发出更高质量的APP。也是我们迈向高级Android开发工程师的必经之路~

Binder架构设计

Binder架构也是采用分层架构设计, 每一层都有其不同的功能。分为Java Binder,Native Binder,Kernel Binder 。

Binder进程间通信采用的是C/S架构,也就是常说的客户端,服务端模式。这是一个简化版的示意图

[图片上传中…(image-47e7ce-1599468127798-13)]

可以看到的是,除了clien端和serve端,还多出了一个ServiceManager。ServiceManager用于管理系统中的各种服务。首先,Server需要向ServiceManager中注册服务,然后client如果想要使用Server提供的服务,需要向ServiceManager中查询,查询到了就可以使用服务。需要注意的是,上面这个简化图中client并不能直接使用服务,而是通过Binder跨进程通信的方式间接的使用服务。

这是一个稍微复杂一点的图:

Client端和Server端直接全部都是通过虚线来连接的,也就表示虽然有调用关系,但是并不是直接调用。而是通过Binder实现的间接调用。需要注意的是此处的Service Manager是指Native层的ServiceManager(C++),并非指framework层的ServiceManager(Java)。

Client/Server/ServiceManage之间的相互通信都是基于Binder机制。既然基于Binder机制通信,那么同样也是C/S架构,则图中的3大步骤都有相应的Client端与Server端。

- 注册服务:首先Server注册到

ServiceManager。该过程:Server所在进程是客户端,ServiceManager是服务端。 - 获取服务:Client进程使用Server前,须先向

ServiceManager中获取Server的代理类BpBinder。该过程:BpBinder所在进程(app process)是客户端,ServiceManager是服务端。 - 使用服务: app进程根据得到的代理类

BpBinder,便可以直接与Server所在进程交互。该过程:BpBinder所在进程(app process)是客户端,BBiner所在进程(system_server)是服务端。

这3大过程每一次都是一个完整的Binder IPC过程。

既然第一步是注册服务,那我们先从注册服务开始看起,看看服务到底是如何注册到系统中的。

服务注册

以MediaServer为例,看看它是如何注册的。为了方便阅读,全部剔除了Log等代码。

首先是MediaServer的入口函数:

//frameworks/av/media/mediaserver/main_mediaserver.cpp

int main(int argc __unused, char **argv __unused)

{

signal(SIGPIPE, SIG_IGN);

//获取ProcessState实例

sp proc(ProcessState::self());

//获取BpServiceManager对象

sp sm(defaultServiceManager());

InitializeIcuOrDie();

//注册MediaPlayerService

MediaPlayerService::instantiate();//1

ResourceManagerService::instantiate();

registerExtensions();

//启动Binder线程池

ProcessState::self()->startThreadPool();

//当前线程加入到线程池

IPCThreadState::self()->joinThreadPool();

}

第二行代码是获取ProcessState,ProcessState是何许人也?ProcessState从名称就可以看出来,用于代表进程的状态

我们看一下ProcessState::self()这个方法:

//frameworks/native/libs/binder/ProcessState.cpp

sp ProcessState::self()

{

Mutex::Autolock _l(gProcessMutex);

if (gProcess != NULL) {

return gProcess;

}

gProcess = new ProcessState(“/dev/binder”);//1

return gProcess;

}

这是一个单例模式用于获取ProcessState,每个进程只有一个。眼尖的小伙伴应该发现了一个熟悉的字符串,没错就是这个/dev/binder,这就是没有物理介质的Binder驱动。那么ProcessState的构造方法又做了哪些事情呢?

ProcessState

//frameworks/native/libs/binder/ProcessState.cpp

ProcessState::ProcessState(const char *driver)

: mDriverName(String8(driver))

, mDriverFD(open_driver(driver))//1 这一行很重要,打开了Binder驱动

, mVMStart(MAP_FAILED)

, mThreadCountLock(PTHREAD_MUTEX_INITIALIZER)

, mThreadCountDecrement(PTHREAD_COND_INITIALIZER)

, mExecutingThreadsCount(0)

, mMaxThreads(DEFAULT_MAX_BINDER_THREADS)

, mStarvationStartTimeMs(0)

, mManagesContexts(false)

, mBinderContextCheckFunc(NULL)

, mBinderContextUserData(NULL)

, mThreadPoolStarted(false)

, mThreadPoolSeq(1)

{

if (mDriverFD >= 0) {

//2 mmap内存映射

mVMStart = mmap(0, BINDER_VM_SIZE, PROT_READ, MAP_PRIVATE | MAP_NORESERVE, mDriverFD, 0);

if (mVMStart == MAP_FAILED) {

// sigh

ALOGE(“Using %s failed: unable to mmap transaction memory.\n”, mDriverName.c_str());

close(mDriverFD);

mDriverFD = -1;

mDriverName.clear();

}

}

LOG_ALWAYS_FATAL_IF(mDriverFD < 0, “Binder driver could not be opened. Terminating.”);

}

注释1处,ProcessState的构造方法首先调用了open_driver()方法,这个方法一看名字就知道,是打开驱动嘛,它的参数不就是我们刚才看到的传进去的/dev/binder,也就是说ProcessState在构造方法处打开了Binder驱动。看看它是怎么打开驱动的吧

open_driver

//frameworks/native/libs/binder/ProcessState.cpp

static int open_driver(const char *driver)

{

int fd = open(driver, O_RDWR | O_CLOEXEC);//1

if (fd >= 0) {

…

size_t maxThreads = DEFAULT_MAX_BINDER_THREADS;

result = ioctl(fd, BINDER_SET_MAX_THREADS, &maxThreads);//2

if (result == -1) {

ALOGE(“Binder ioctl to set max threads failed: %s”, strerror(errno));

}

} else {

ALOGW(“Opening ‘%s’ failed: %s\n”, driver, strerror(errno));

}

return fd;

}

注释1处用于打开/dev/binder设备并返回文件操作符fd,这样就可以操作内核的Binder驱动了。

Linux 系统中,把一切都看做是文件,当进程打开现有文件或创建新文件时,内核向进程返回一个文件描述符,文件描述符就是内核为了高效管理已被打开的文件所创建的索引,用来指向被打开的文件,所有执行I/O操作的系统调用都会通过文件描述符。

注释2处的ioctl函数的作用就是和Binder设备进行参数的传递,这里的ioctl函数用于设定binder支持的最大线程数为15(maxThreads的值为15)。

在用户空间,使用ioctl方法系统调用来控制设备。这是方法原型:

/*

fd:文件描述符

cmd:控制命令

…:可选参数:插入argp,具体内容依赖于cmd/

int ioctl(int fd,unsigned long cmd,…);

用户程序所作的只是通过命令码告诉驱动程序它想做什么,至于怎么解释这些命令和怎么实现这些命令,这都是驱动程序要做的事情。所以在用户空间我们想做什么事情都是通过这个方法以命令的形式告诉Binder驱动,Binder驱动收到命令执行相应的操作。

mmap

在刚才的注释2处就是大名鼎鼎的内存映射。内存映射函数mmap,给binder分配一块虚拟地址空间。它会在内核虚拟地址空间中申请一块与用户虚拟内存相同大小的内存,然后再申请物理内存,将同一块物理内存分别映射到内核虚拟地址空间和用户虚拟内存空间,实现了内核虚拟地址空间和用户虚拟内存空间的数据同步操作。

这是函数原型:

//原型

/*

addr: 代表映射到进程地址空间的起始地址,当值等于0则由内核选择合适地址,此处为0;

size: 代表需要映射的内存地址空间的大小,此处为1M-8K;

prot: 代表内存映射区的读写等属性值,此处为PROT_READ(可读取);

flags: 标志位,此处为MAP_PRIVATE(私有映射,多进程间不共享内容的改变)和 MAP_NORESERVE(不保留交换空间)

fd: 代表mmap所关联的文件描述符,此处为mDriverFD;

offset:偏移量,此处为0。

此处 mmap(0, BINDER_VM_SIZE, PROT_READ, MAP_PRIVATE | MAP_NORESERVE, mDriverFD, 0);

/

void mmap(void* addr, size_t size, int prot, int flags, int fd, off_t offset)

总的来说,ProcessState做了两件事情,一是打开Binder驱动并返回文件操作符fd,二是通过mmap为Binder分配了一块虚拟内存空间,以达到内存映射的目的。

MediaPlayerService::instantiate

这个方法呢就是注册服务:

void MediaPlayerService::instantiate() {

//注册服务

defaultServiceManager()->addService(String16(“media.player”), new MediaPlayerService());

}

defaultServiceManager返回的是BpServiceManager,这里先不讲BpServiceManager,你只需要知道BpServiceManager它实现了IServiceManager,并且通过内部有一个变量mRemote= BpBinder,BpBinder用来实现跨进程通信。 故此处等价于调用BpServiceManager->addService。

BpBinder是Client端与Server交互的代理类,而BBinder则代表了Server端。BpBinder和BBinder是一一对应的。BpBinder会通过handle来找到对应的BBinder。在ServiceManager中创建了BpBinder,通过handle(值为0)可以找到对应的BBinder。

来看一下具体代码

//frameworks/native/libs/binder/IServiceManager.cpp

virtual status_t addService(const String16& name, const sp& service, bool allowIsolated) {

Parcel data, reply; //Parcel是数据通信包

//写入头信息"android.os.IServiceManager"

data.writeInterfaceToken(IServiceManager::getInterfaceDescriptor());

data.writeString16(name); // name为 “media.player”

data.writeStrongBinder(service); // MediaPlayerService对象

data.writeInt32(allowIsolated ? 1 : 0); // allowIsolated= false

//remote()指向的是BpBinder对象

status_t err = remote()->transact(ADD_SERVICE_TRANSACTION, data, &reply);

return err == NO_ERROR ? reply.readExceptionCode() : err;

}

服务注册过程:向ServiceManager注册服务MediaPlayerService,服务名为”media.player”。addService函数的作用就是将请求数据打包成data,然后传给BpBinder的transact函数。

data.writeStrongBinder(service)这行代码中,将Binder对象进行了扁平化,转换成flat_binder_object对象。

- 对于Binder实体,则cookie记录Binder实体的指针;

- 对于Binder代理,则用handle记录Binder代理的句柄;(句柄这个翻译真的是脑残,你可以直接理解为ID或者编号)

BpBinder::transact

我们看一下transact函数:

// frameworks/native/libs/binder/BpBinder.cpp

status_t BpBinder::transact(

uint32_t code, const Parcel& data, Parcel* reply, uint32_t flags)

{

if (mAlive) {

status_t status = IPCThreadState::self()->transact(

mHandle, code, data, reply, flags);

if (status == DEAD_OBJECT) mAlive = 0;

return status;

}

return DEAD_OBJECT;

}

Binder代理类调用transact()方法,真正工作还是交给IPCThreadState来进行transact工作。先来 看看IPCThreadState::self的过程。

IPCThreadState::self

//frameworks/native/libs/binder/IPCThreadState.cpp

IPCThreadState* IPCThreadState::self()

{

if (gHaveTLS) {

restart:

const pthread_key_t k = gTLS;

IPCThreadState* st = (IPCThreadState*)pthread_getspecific(k);

if (st) return st;

return new IPCThreadState; //初始IPCThreadState

}

if (gShutdown) return NULL;

pthread_mutex_lock(&gTLSMutex);

if (!gHaveTLS) { //首次进入gHaveTLS为false

if (pthread_key_create(&gTLS, threadDestructor) != 0) { //创建线程的TLS

pthread_mutex_unlock(&gTLSMutex);

return NULL;

}

gHaveTLS = true;

}

pthread_mutex_unlock(&gTLSMutex);

goto restart;

}

TLS是指Thread local storage(线程本地储存空间),每个线程都拥有自己的TLS,并且是私有空间,线程之间不会共享。通过pthread_getspecific/pthread_setspecific函数可以获取/设置这些空间中的内容。从线程本地存储空间中获得保存在其中的IPCThreadState对象。这里可以得知IPCThreadState::self()实际上是为了创建IPCThreadState.

IPCThreadState

//frameworks/native/libs/binder/IPCThreadState.cpp

IPCThreadState::IPCThreadState()

: mProcess(ProcessState::self()),

mMyThreadId(gettid()),

mStrictModePolicy(0),

mLastTransactionBinderFlags(0)

{

pthread_setspecific(gTLS, this);

clearCaller();

mIn.setDataCapacity(256);

mOut.setDataCapacity(256);

}

pthread_setspecific函数用于设置TLS,将IPCThreadState::self()获得的TLS和自身传进去。每个线程都有一个IPCThreadState,每个IPCThreadState中都有一个mIn、一个mOut,它们都是Parcel对象。成员变量mProcess保存了ProcessState变量(每个进程只有一个)。

- mIn 用来接收来自Binder设备的数据,默认大小为256字节;

- mOut用来存储发往Binder设备的数据,默认大小为256字节。

那这里构造完了,看一下IPCThreadState的transact函数:

IPCThreadState::transact

status_t IPCThreadState::transact(int32_t handle,

uint32_t code, const Parcel& data,

Parcel* reply, uint32_t flags)

{

status_t err = data.errorCheck(); //数据错误检查

flags |= TF_ACCEPT_FDS;

…

if (err == NO_ERROR) { // 传输数据

err = writeTransactionData(BC_TRANSACTION, flags, handle, code, data, NULL);

}

…

if ((flags & TF_ONE_WAY) == 0) {

if (reply) {

//等待响应

err = waitForResponse(reply);

} else {

Parcel fakeReply;

err = waitForResponse(&fakeReply);

}

} else {

//oneway,则不需要等待reply的场景

err = waitForResponse(NULL, NULL);

}

return err;

}

IPCThreadState进行transact事务处理分3部分:

- errorCheck() //数据错误检查

- writeTransactionData() // 传输数据

- waitForResponse() //等待响应

其中writeTransactionData函数用于传输数据,其中第一个参数BC_TRANSACTION代表向Binder驱动发送命令协议,向Binder设备发送的命令协议都以BC_开头,而Binder驱动返回的命令协议以BR开头。

我们就要看看到底是怎么写进去数据的:

IPCThreadState.writeTransactionData

//frameworks/native/libs/binder/IPCThreadState.cpp

status_t IPCThreadState::writeTransactionData(int32_t cmd, uint32_t binderFlags,

int32_t handle, uint32_t code, const Parcel& data, status_t* statusBuffer)

{

binder_transaction_data tr;

tr.target.ptr = 0;

tr.target.handle = handle; // handle = 0

tr.code = code; // code = ADD_SERVICE_TRANSACTION

tr.flags = binderFlags; // binderFlags = 0

tr.cookie = 0;

tr.sender_pid = 0;

tr.sender_euid = 0;

// data为记录Media服务信息的Parcel对象

const status_t err = data.errorCheck();

if (err == NO_ERROR) {

tr.data_size = data.ipcDataSize(); // mDataSize

tr.data.ptr.buffer = data.ipcData(); //mData

tr.offsets_size = data.ipcObjectsCount()*sizeof(binder_size_t); //mObjectsSize

tr.data.ptr.offsets = data.ipcObjects(); //mObjects

} else if (statusBuffer) {

…

} else {

return (mLastError = err);

}

mOut.writeInt32(cmd); //cmd = BC_TRANSACTION

mOut.write(&tr, sizeof(tr)); //写入binder_transaction_data数据

return NO_ERROR;

}

binder_transaction_data结构体是binder驱动通信的数据结构,该过程最终是把Binder请求码BC_TRANSACTION和binder_transaction_data结构体写入到mOut。其中handle的值用来标识目的端,注册服务过程的目的端为service manager,此处handle=0所对应的是binder_context_mgr_node对象,正是service manager所对应的binder实体对象。

transact方法中执行完writeTransactionData方法后,接下来就会执行waitForResponse()方法

IPCThreadState.waitForResponse

//frameworks/native/libs/binder/IPCThreadState.cpp

status_t IPCThreadState::waitForResponse(Parcel *reply, status_t *acquireResult)

{

uint32_t cmd;

int32_t err;

while (1) {

if ((err=talkWithDriver()) < NO_ERROR) break;//1

err = mIn.errorCheck();

if (err < NO_ERROR) break;

if (mIn.dataAvail() == 0) continue;

cmd = (uint32_t)mIn.readInt32();

switch (cmd) {

case BR_TRANSACTION_COMPLETE:

if (!reply && !acquireResult) goto finish;

break;

case BR_DEAD_REPLY:

err = DEAD_OBJECT;

goto finish;

…

default:

//处理各种命令协议

err = executeCommand(cmd);

if (err != NO_ERROR) goto finish;

break;

}

}

finish:

…

return err;

}

这里开启了一个死循环,然后从talkWithDriver()方法中发送并读取数据。在waitForResponse过程, 首先执行BR_TRANSACTION_COMPLETE;另外,目标进程也就是Server端收到事务后,处理BR_TRANSACTION事务。 然后发送给当前进程也就是Client端,再执行BR_REPLY命令。这是通信的具体流程:

[图片上传中…(image-683419-1599468127794-12)]

Binder协议包含在IPC数据中,分为两类:

BINDER_COMMAND_PROTOCOL:binder请求码,以”BC_“开头,简称BC码,用于从IPC层传递到Binder Driver层;BINDER_RETURN_PROTOCOL:binder响应码,以”BR_“开头,简称BR码,用于从Binder Driver层传递到IPC层;

在这个过程中, 收到以下任一BR_命令,处理后便会退出waitForResponse()的状态:

- BR_TRANSACTION_COMPLETE: binder驱动收到BC_TRANSACTION事件后的应答消息; 对于oneway transaction,当收到该消息,则完成了本次Binder通信;

- BR_DEAD_REPLY: 回复失败,往往是线程或节点为空. 则结束本次通信Binder;

- BR_FAILED_REPLY:回复失败,往往是transaction出错导致. 则结束本次通信Binder;

- BR_REPLY: Binder驱动向Client端发送回应消息; 对于非oneway transaction时,当收到该消息,则完整地完成本次Binder通信;

talkWithDriver()这个方法是真正的向内核发送消息的方法。这是talkWithDriver:

IPCThreadState.talkWithDriver()

//frameworks/native/libs/binder/IPCThreadState.cpp

status_t IPCThreadState::talkWithDriver(bool doReceive)

{

…

//和Binder驱动通信的结构体

binder_write_read bwr;

//mIn是否有可读的数据,接收的数据存储在mIn

const bool needRead = mIn.dataPosition() >= mIn.dataSize();

const size_t outAvail = (!doReceive || needRead) ? mOut.dataSize() : 0;

bwr.write_size = outAvail;

//将要发送给Binder设备的消息填充到与Binder通信的结构体中

bwr.write_buffer = (uintptr_t)mOut.data();

if (doReceive && needRead) {

//接收数据缓冲区信息的填充。如果以后收到数据,就直接填在mIn中了。

bwr.read_size = mIn.dataCapacity();

bwr.read_buffer = (uintptr_t)mIn.data();

} else {

bwr.read_size = 0;

bwr.read_buffer = 0;

}

//当读缓冲和写缓冲都为空,则直接返回

if ((bwr.write_size == 0) && (bwr.read_size == 0)) return NO_ERROR;

bwr.write_consumed = 0;

bwr.read_consumed = 0;

status_t err;

do {

//通过ioctl不停的读写操作,跟Binder Driver进行通信

if (ioctl(mProcess->mDriverFD, BINDER_WRITE_READ, &bwr) >= 0)

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数初中级Android工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则近万的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

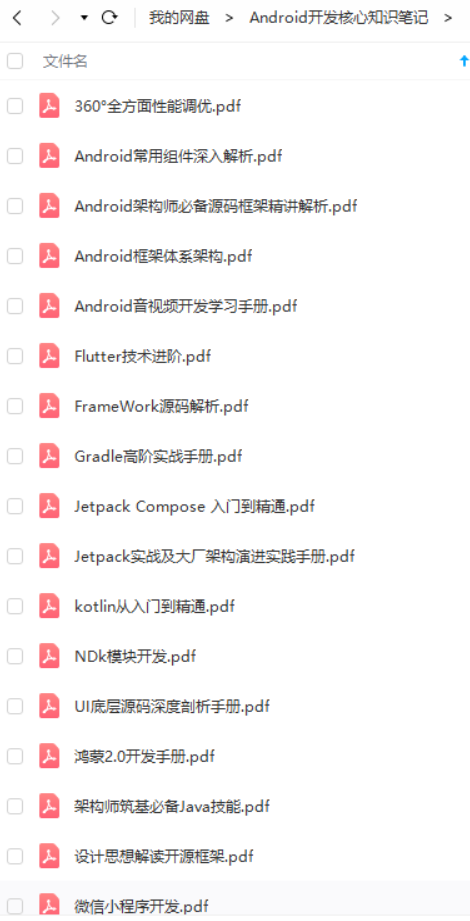

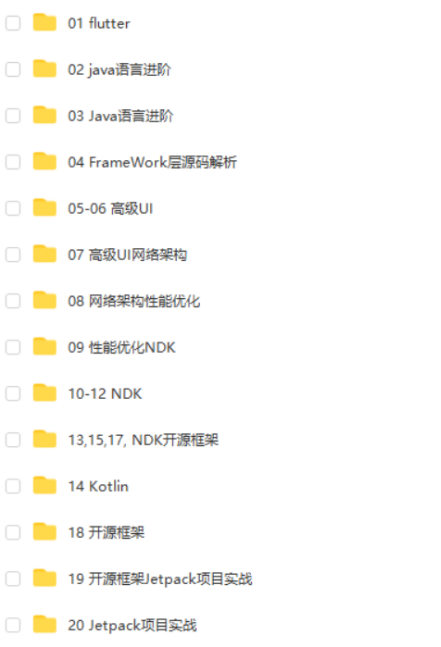

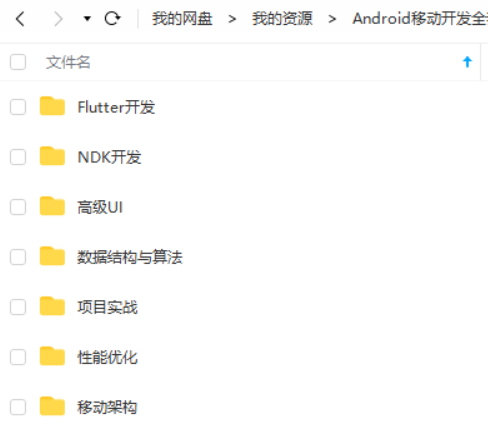

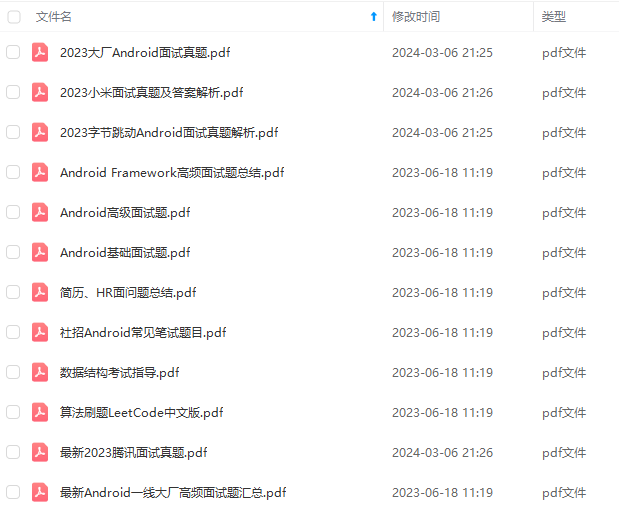

因此收集整理了一份《2024年Android移动开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Android开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

如果你觉得这些内容对你有帮助,可以扫码获取!!(备注:Android)

《设计思想解读开源框架》

第一章、 热修复设计

-

第一节、 AOT/JIT & dexopt 与 dex2oat

-

第二节、 热修复设计之 CLASS_ISPREVERIFIED 问题

-

第三节、热修复设计之热修复原理

-

第四节、Tinker 的集成与使用(自动补丁包生成)

第二章、 插件化框架设计

-

第一节、 Class 文件与 Dex 文件的结构解读

-

第二节、 Android 资源加载机制详解

-

第三节、 四大组件调用原理

-

第四节、 so 文件加载机制

-

第五节、 Android 系统服务实现原理

第三章、 组件化框架设计

-

第一节、阿里巴巴开源路由框——ARouter 原理分析

-

第二节、APT 编译时期自动生成代码&动态类加载

-

第三节、 Java SPI 机制

-

第四节、 AOP&IOC

-

第五节、 手写组件化架构

第四章、图片加载框架

-

第一节、图片加载框架选型

-

第二节、Glide 原理分析

-

第三节、手写图片加载框架实战

第五章、网络访问框架设计

-

第一节、网络通信必备基础

-

第二节、OkHttp 源码解读

-

第三节、Retrofit 源码解析

第六章、 RXJava 响应式编程框架设计

-

第一节、链式调用

-

第二节、 扩展的观察者模式

-

第三节、事件变换设计

-

第四节、Scheduler 线程控制

第七章、 IOC 架构设计

-

第一节、 依赖注入与控制反转

-

第二节、ButterKnife 原理上篇、中篇、下篇

-

第三节、Dagger 架构设计核心解密

第八章、 Android 架构组件 Jetpack

-

第一节、 LiveData 原理

-

第二节、 Navigation 如何解决 tabLayout 问题

-

第三节、 ViewModel 如何感知 View 生命周期及内核原理

-

第四节、 Room 架构方式方法

-

第五节、 dataBinding 为什么能够支持 MVVM

-

第六节、 WorkManager 内核揭秘

-

第七节、 Lifecycles 生命周期

本文包含不同方向的自学编程路线、面试题集合/面经、及系列技术文章等,资源持续更新中…

《互联网大厂面试真题解析、进阶开发核心学习笔记、全套讲解视频、实战项目源码讲义》点击传送门即可获取!

第三节、Dagger 架构设计核心解密**

[外链图片转存中…(img-NWuRSQt5-1713774614135)]

第八章、 Android 架构组件 Jetpack

-

第一节、 LiveData 原理

-

第二节、 Navigation 如何解决 tabLayout 问题

-

第三节、 ViewModel 如何感知 View 生命周期及内核原理

-

第四节、 Room 架构方式方法

-

第五节、 dataBinding 为什么能够支持 MVVM

-

第六节、 WorkManager 内核揭秘

-

第七节、 Lifecycles 生命周期

[外链图片转存中…(img-93y4QJbO-1713774614136)]

本文包含不同方向的自学编程路线、面试题集合/面经、及系列技术文章等,资源持续更新中…

[外链图片转存中…(img-OMNiyevI-1713774614137)]

《互联网大厂面试真题解析、进阶开发核心学习笔记、全套讲解视频、实战项目源码讲义》点击传送门即可获取!

1367

1367

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?