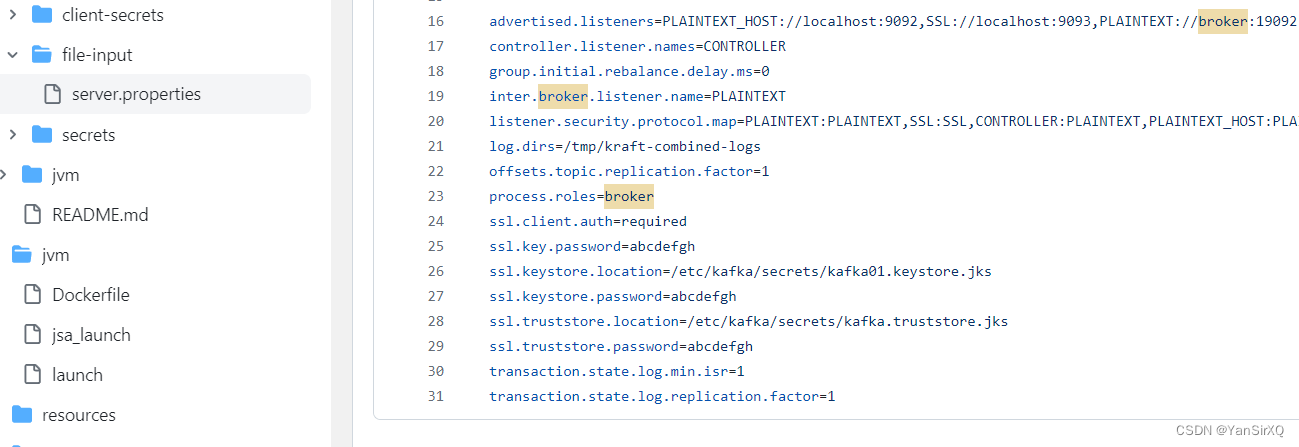

controller.listener.names=CONTROLLER

group.initial.rebalance.delay.ms=0

inter.broker.listener.name=PLAINTEXT

listener.security.protocol.map=PLAINTEXT:PLAINTEXT,SSL:SSL,CONTROLLER:PLAINTEXT,PLAINTEXT_HOST:PLAINTEXT

log.dirs=/tmp/kraft-combined-logs

offsets.topic.replication.factor=1

process.roles=broker

transaction.state.log.min.isr=1

transaction.state.log.replication.factor=1

于是我开始使用这个配置文件 , 挂载到容器中

官方文档就是说将包含配置文件的文件夹挂载到容器中 , 如下

docker run -d --name kafka-server --volume /kafak/config:/mnt/shared/config -p 9092:9092 apache/kafka:3.7.0

但是运行后我发现配置文件并没有生效 , 于是我进入容器查看是否有文件

[root@master config]# docker exec -it kafka-server /bin/bash

113ef4019c21:/$ ls

__cacert_entrypoint.sh dev home lib64 mnt proc run srv tmp var

bin etc lib media opt root sbin sys usr

113ef4019c21:/$ cd mnt/shared/config/

113ef4019c21:/mnt/shared/config$ ls

docker-kafka.yml

113ef4019c21:/mnt/shared/config$ cat docker-kafka.yml

cat: read error: Is a directory

**神奇的是 , 竟然在容器内部生成了一个名称为yml的文件夹 , 并且没有任何内容 , 但是官方提供的配置文件名称的确为server.properties , 如下图**

\*\*想问问有没有大佬知道这个是什么原因 , 感觉是我的使用姿势不对 , 但是我也不知道究竟该怎么弄 , 我用命令尝试过 , 生产者推送消息 , 消费者接收消息是没问题的 \*\*

bin/kafka-console-producer.sh --topic test --bootstrap-server localhost:9092

以及消费者

bin/kafka-console-consumer.sh --bootstrap-server 自己服务器IP:9092 --topic test --from-beginning

**关键就是我用spring-boot无法连接上kafk , 一直报错 127.0.0.1连接不上 , 我查阅资料 是需要暴露主机地址才行 , 如下 , 这也是我想用自定义配置文件的原因**

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Linux运维工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Linux运维全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Linux运维知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加VX:vip1024b (备注Linux运维获取)

为了做好运维面试路上的助攻手,特整理了上百道 【运维技术栈面试题集锦】 ,让你面试不慌心不跳,高薪offer怀里抱!

这次整理的面试题,小到shell、MySQL,大到K8s等云原生技术栈,不仅适合运维新人入行面试需要,还适用于想提升进阶跳槽加薪的运维朋友。

本份面试集锦涵盖了

- 174 道运维工程师面试题

- 128道k8s面试题

- 108道shell脚本面试题

- 200道Linux面试题

- 51道docker面试题

- 35道Jenkis面试题

- 78道MongoDB面试题

- 17道ansible面试题

- 60道dubbo面试题

- 53道kafka面试

- 18道mysql面试题

- 40道nginx面试题

- 77道redis面试题

- 28道zookeeper

总计 1000+ 道面试题, 内容 又全含金量又高

- 174道运维工程师面试题

1、什么是运维?

2、在工作中,运维人员经常需要跟运营人员打交道,请问运营人员是做什么工作的?

3、现在给你三百台服务器,你怎么对他们进行管理?

4、简述raid0 raid1raid5二种工作模式的工作原理及特点

5、LVS、Nginx、HAproxy有什么区别?工作中你怎么选择?

6、Squid、Varinsh和Nginx有什么区别,工作中你怎么选择?

7、Tomcat和Resin有什么区别,工作中你怎么选择?

8、什么是中间件?什么是jdk?

9、讲述一下Tomcat8005、8009、8080三个端口的含义?

10、什么叫CDN?

11、什么叫网站灰度发布?

12、简述DNS进行域名解析的过程?

13、RabbitMQ是什么东西?

14、讲一下Keepalived的工作原理?

15、讲述一下LVS三种模式的工作过程?

16、mysql的innodb如何定位锁问题,mysql如何减少主从复制延迟?

17、如何重置mysql root密码?

一个人可以走的很快,但一群人才能走的更远。不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎扫码加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

一个人可以走的很快,但一群人才能走的更远。不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎扫码加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

[外链图片转存中…(img-bRNMzLo8-1712656375343)]

1844

1844

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?