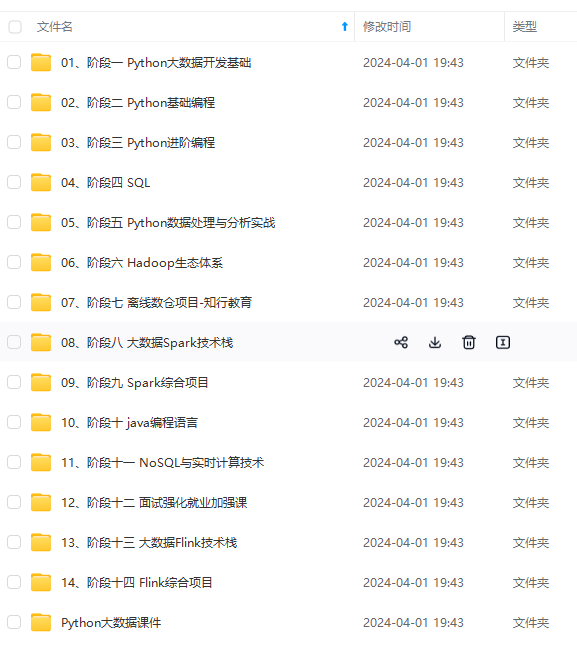

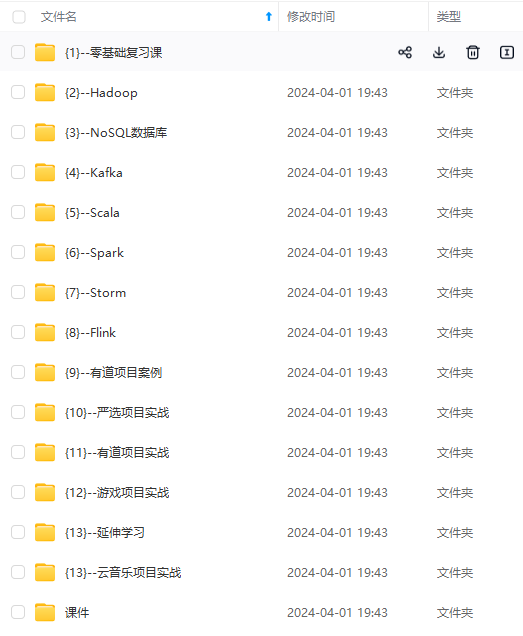

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

⑤ 将 HBase 远程发送到其他集群

[root@node01 servers]$ xsync hbase_1.3.1/

(4)配置 HBase 环境变量

# Apache HBase 1.3.1

export HBASE\_HOME=/export/servers/hbase-1.3.1

export PATH=$HADOOP/sbin:$HADOOP/bin:$HBASE\_HOME/bin:$PATH

刷新环境变量

source /etc/profile

(5)启动 HBase 服务。

进入hbase shell

bin/start-hbase.sh

执行上述操作,执行list命令,如果能显示以下内容,表示安装成功。

hbase(main):002:0> list

TABLE

0 row(s) in 0.1380 seconds

=> []

当然,你也可以通过host:port的方式来访问 HBase 的页面,例如:http://node01:16010/

OK,安装完了 Hbase1.3.1,接着我们开始安装 kylin 。

Kylin安装

(1)下载 Kylin 安装包

(2)解压 apache-kylin-2.6.3-bin-hbase1x.tar.gz 到/export/servers 目录下

tar -zxf /export/softwares/apache-kylin-2.6.3-bin-hbase1x.tar.gz -C /export/servers/

注 意 : 启 动 前 需 检 查 /etc/profile 目 录 中 的 HADOOP_HOME 、 HIVE_HOME 和 HBASE_HOME 是否配置完毕

(3)启动

① 在启动 Kylin 之前,需要先启动 Hadoop(HDFS、YARN、JobHistoryServer)、Zookeeper 和 HBase。需要注意的是,要同时启动 Hadoop 的历史服务器,对 Hadoop 集群配置进行如下修改。

配置 mapred-site.xml 文件。

[root@node01 hadoop]$ vim mapred-site.xml

<property>

<name>mapreduce.jobhistory.address</name>

<value>node01:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node01:19888</value>

</property>

配置 yarn-site.xml 文件。

[root@node01 hadoop]$ vim yarn-site.xml

<!-- 日志聚集功能开启 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 日志保留时间设置为 7 天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

修改配置后,分发配置文件,重启 Hadoop 的 HDFS 和 YARN 的所有进程。

启动 Hadoop 历史服务器。

[root@node01 hadoop-2.6.0-cdh5.14.0]$ sbin/mr-jobhistory-daemon.sh start historyserver

② 启动 Kylin

[root@node01 kylin]$ bin/kylin.sh start

启动之后查看各台节点服务器的进程。

--------------------- node01 ----------------

3360 JobHistoryServer

31425 HMaster

3282 NodeManager

3026 DataNode

53283 Jps

2886 NameNode

44007 RunJar

2728 QuorumPeerMain

31566 HRegionServer

--------------------- node02 ----------------

5040 HMaster

2864 ResourceManager

9729 Jps

2657 QuorumPeerMain

4946 HRegionServer

2979 NodeManager

2727 DataNode

--------------------- node03 ----------------

4688 HRegionServer

2900 NodeManager

9848 Jps

2636 QuorumPeerMain

2700 DataNode

2815 SecondaryNameNode

在浏览器地址栏中输入node01:7070/kylin/login,查看 Web 页面,如图所示:

用户名为 ADMIN,密码为 KYLIN(系统已填)

(4)关闭Kylin

如果我们想要关闭 Kylin,只需要执行下面的命令:

[root@node01 apache-kylin-2.6.3]# bin/kylin.sh stop

Kylin的使用

到了这一步,我们终于将 Kylin 安装好了,下面我们来讲一下 Kylin 的具体使用。

准备测试数据表

为了让最终的演示更具有说明力,同时也为了方便后续的学习,接下来我们需要先准备几张测试数据表。

1、(事实表)dw_sales

| 列名 | 列类型 | 说明 |

|---|---|---|

| id | string | 订单id |

| date1 | string | 订单日期 |

| channelid | string | 订单渠道(商场、京东、天猫) |

| productid | string | 产品id |

| regionid | string | 区域名称 |

| amount | int | 商品下单数量 |

| price | double | 商品金额 |

2、(维度表_渠道方式)dim_channel

| 列名 | 列类型 | 说明 |

|---|---|---|

| channelid | string | 渠道id |

| channelname | string | 渠道名称 |

3、(维度表_产品名称)dim_product

| 列名 | 列类型 | 说明 |

|---|---|---|

| productid | string | 产品id |

| productname | string | 产品名称 |

4、(维度表_区域)dim_region

| 列名 | 列类型 | 说明 |

|---|---|---|

| regionid | string | 区域id |

| regionname | string | 区域名称 |

导入测试数据

准备好了测试数据之后,我们需要将在 Hive 中 建好对应的表,这里我采取的是执行已经写好的脚本hive.sql文件,创建测试表。

对应的数据文件和sql脚本不方便在这里展示,需要的同学可以添加我的微信:zwj_bigdataer 获取

操作步骤:

1、使用 beeline 连接Hive

!connect jdbc:hive2://node1:10000

2、创建并切换到 itcast_dw 数据库

create database itcast_kylin_dw;

use itcast_kylin_dw;

3、执行上面我们提到的hive.sql文件,执行sql、创建测试表

-- 执行sql文件

source hive.sql

-- 查看表是否创建成功

show tables;

4、在home目录创建~/dat_file 文件夹,并将测试数据文件上传到该文件夹中

mkdir ~/dat_file

导入数据到表中

-- 导入数据

LOAD DATA LOCAL INPATH '/root/dat\_file/dw\_sales\_data.txt' OVERWRITE INTO TABLE dw_sales;

LOAD DATA LOCAL INPATH '/root/dat\_file/dim\_channel\_data.txt' OVERWRITE INTO TABLE dim_channel;

LOAD DATA LOCAL INPATH '/root/dat\_file/dim\_product\_data.txt' OVERWRITE INTO TABLE dim_product;

LOAD DATA LOCAL INPATH '/root/dat\_file/dim\_region\_data.txt' OVERWRITE INTO TABLE dim_region;

5、执行一条SQL语句,确认数据是否已经成功导入

指标和维度

在确认完成了上面的数据准备操作之后,我们就可以对 kylin 进行实际操作了。但我们还需要先了解一下,什么是指标和维度?

首先来看下面的 demo

相信各位朋友已经有了自己的想法和答案,这里提供一种思考方式:

红色字体是指标/度量?还是维度?

答案:指标/度量【到底要看什么?获取什么?】蓝色字体是指标/度量?还是维度?

答案:维度【怎么看!怎么获取!】

结论:需求决定哪些是维度,哪些是指标。

好了,明确了什么是维度,什么是指标之后,我们就可以正式开启kylin的使用之旅了~

按照日期统计订单总额/总数量(Kylin方式)

做任何事情都有一个顺序,使用一门新的技术亦是如此。要使用Kylin进行OLAP分析,需要按照以下方式来进行。

1、创建项目(Project)

2、创建数据源(DataSource)

- 指定有哪些数据需要进行数据分析

3、创建模型(Model)

- 指定具体要对哪个事实表、那些维度进行数据分析

4、创建立方体(Cube)

- 指定对哪个数据模型执行数据预处理,生成不同维度的数据

5、执行构建、等待构建完成

6、再执行SQL查询,获取结果

具体步骤:

1、创建 Project

(1)点击 + 图标创建工程,如图所示:

(2)填写工程名称和描述信息,并单击“Submit”按钮提交

2、获取数据源

(1)选择“Data Source”选项卡,如图所示:

(2)单击图中箭头所指的图标,导入 Hive 表。

(3)选中所需数据表,并单击“Sync”按钮,如图所示:

3、创建 Model

(1)选择“Models”选项卡,然后单击“New”按钮,接着单击“NewModel”按钮。

(2)填写Model信息,然后单击“Next”按钮,如图所示

(3)选择事实表

(4)选择事实表中,所有有可能用到的维度,然后点击 Next按钮

(5)选择度量字段,并单击Next按钮

(6)指定事实表分区字段(仅支持时间分区),但是我们这次的演示用不上,所以我们这里直接单击“Save”按钮,然后在弹窗中点击“Yes”,Model 创建完毕!

此时我们就可以在初始界面看到已经创建好的 Model

4、创建 Cube

(1)单击“New Cube”按钮

(2)填写Cube信息,选择Cube所依赖的 Model,并单击“Next”按钮,如图所示:

(3)选择 Cube 所需的维度,如图

(4)选择 Cube 所需的度量值

根据我们SQL的查询需求,对指定的字段设置聚合

点击 Next

(5)Cube自动合并设置。每天Cube需按照日期分区字段进行构建,每次构建的结果会保存到 HBase的一张表中,为提高查询效率,需将每日的 Cube 进行合并,此处可设置合并周期

(6)Kylin的高级配置(优化相关配置),这里我们就暂只修改一下计算引擎,其他配置不动,执行完毕点击Next

(7)Kylin 属性值覆盖相关配置信息,我们不用进行任何操作,直接 Next

(8)此时显示的是Cube的设计信息总览,如图单击Save按钮,Cube创建完成!

保存完毕,我们可以看见一个新的Cube已经创建好了~

(9)构建 Cube(计算),单击对应的Cube的“Action”下拉按钮,选择 “Build” 选项

(10)选择“Monitor”,查看构建进度,可以发现此时进度还在加载

稍等片刻,刷新页面,可以看到 Cube 已经构建完毕

注意看此时 Cube 就已经变成 READY的状态了

5、执行SQL查询

忙碌了好一阵子,终于可以展示 Kylin 的威力了,接下来我们从 Cube 中查询数据

select date1,

sum(price) as total_money,

sum(amount) as total_amount

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

_FFFFFF,t_70)

###### 5、执行SQL查询

忙碌了好一阵子,终于可以展示 Kylin 的威力了,接下来我们从 Cube 中查询数据

select date1,

sum(price) as total_money,

sum(amount) as total_amount

[外链图片转存中…(img-mN7ZLfQH-1714874547054)]

[外链图片转存中…(img-06qy7XfH-1714874547054)]

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

296

296

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?