-

Python 3.8

-

Pycharm

from selenium import webdriver

import csv

安装Python并添加到环境变量,pip安装需要的相关模块即可。

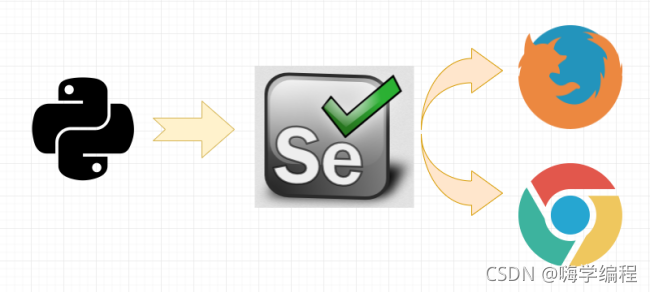

如图所示,通过 Python 来控制 Selenium,然后让 Selenium 控制浏览器,操纵浏览器,这样就实现了使用Python 间接的操控浏览器。

Selenium具体怎么就能操纵浏览器呢?这要归功于 浏览器驱动 ,Selenium可以通过API接口实现和浏览器驱动的交互,进而实现和浏览器的交互。所以要配置浏览器驱动。

本教材使用版本:

火狐驱动:geckodriver 0.23.0 ( 2018-10-04)

火狐驱动下载地址: http://npm.taobao.org/mirrors/geckodriver/

谷歌驱动:ChromeDriver 71.0.3578.33

谷歌驱动下载地址:

https://npm.taobao.org/mirrors/chromedriver/

http://chromedriver.storage.googleapis.com/index.html

配置浏览器驱动:

将下载好的浏览器驱动解压,将解压出的 exe 文件放到Python的安装目录下,也就是和python.exe同目录即可。

from selenium import webdriver

import csv

f = open(‘data.csv’, mode=‘a’, encoding=‘utf-8’, newline=‘’)

csv_writer = csv.DictWriter(f, fieldnames=[

‘标题’,

‘地区’,

‘薪资’,

‘经验’,

‘公司名’,

‘公司领域’,

‘福利’,

‘详情页’,

])

csv_writer.writeheader()

driver = webdriver.Chrome()

driver.get(‘https://www.zhipin.com/job_detail/?query=python&city=100010000&industry=&position=’)

driver.implicitly_wait(10)

def get_job_info():

lis = driver.find_elements_by_css_selector(‘.job-list li’)

for li in lis:

标题

title = li.find_element_by_css_selector(‘.job-name a’).get_attribute(‘title’)

地区

area = li.find_element_by_css_selector(‘.job-area’).text

薪资

money = li.find_element_by_css_selector(‘.job-limit .red’).text

经验

limit = li.find_element_by_css_selector(‘.job-limit p’).text

exp = limit[0].text

company_name = li.find_element_by_css_selector(‘.company-text .name a’).text

company_type = li.find_element_by_css_selector(‘.company-text p a’).text

desc = li.find_element_by_css_selector(‘.info-append .info-desc’).text

href = ‘https://www.zhipin.com/’ + li.find_element_by_css_selector(‘.job-name a’).get_attribute(‘href’)

print(title, area, money, limit, company_name, company_type, desc, sep=‘|’)

dit = {

‘标题’: title,

‘地区’: area,

‘薪资’: money,

‘经验’: limit,

‘公司名’: company_name,

‘公司领域’: company_type,

‘福利’: desc,

‘详情页’: href,

}

csv_writer.writerow(dit)

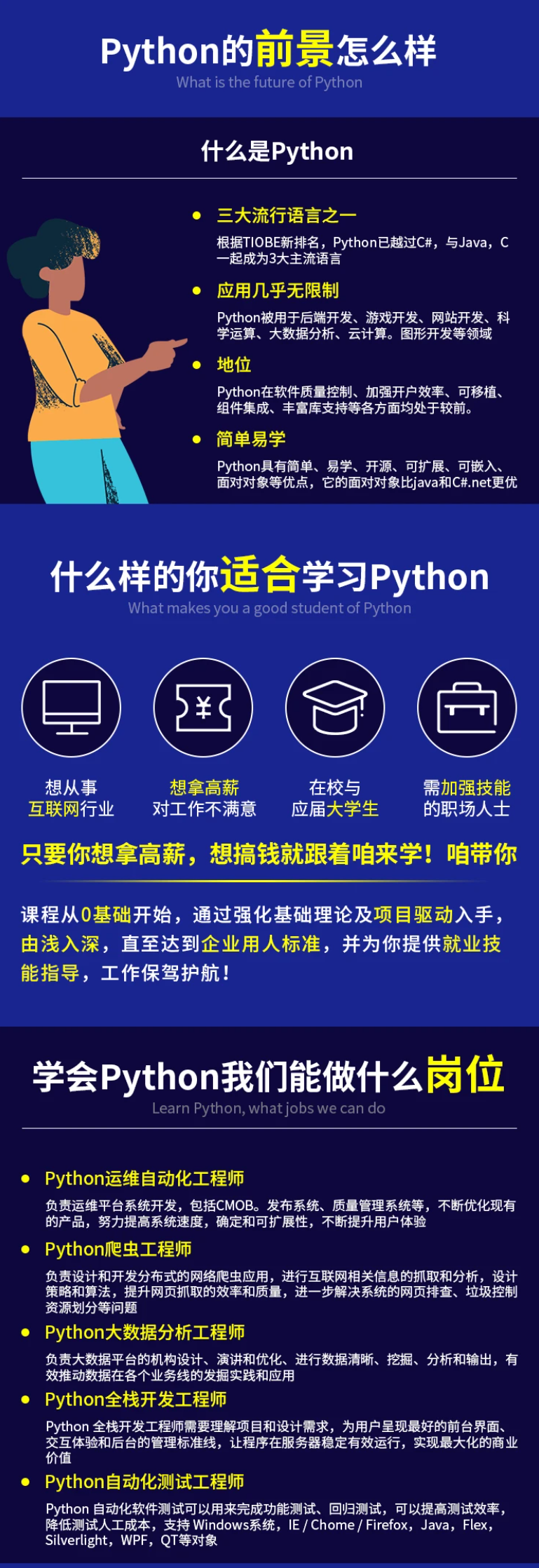

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

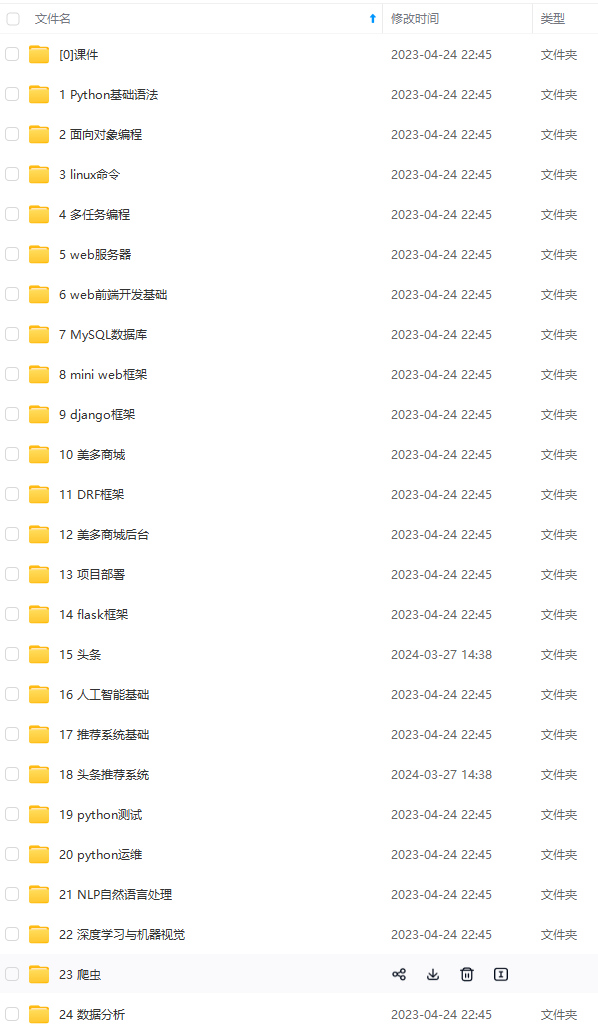

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Python开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加V获取:vip1024c (备注Python)

的进阶课程,基本涵盖了95%以上Python开发知识点,真正体系化!**

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加V获取:vip1024c (备注Python)

[外链图片转存中…(img-Qrdfp5ky-1712710063853)]

7445

7445

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?