写在前面:我是「云祁」,一枚热爱技术、会写诗的大数据开发猿。昵称来源于王安石诗中一句

[ 云之祁祁,或雨于渊 ],甚是喜欢。写博客一方面是对自己学习的一点点总结及记录,另一方面则是希望能够帮助更多对大数据感兴趣的朋友。如果你也对

数据中台、数据建模、数据分析以及Flink/Spark/Hadoop/数仓开发感兴趣,可以关注我的动态 https://blog.csdn.net/BeiisBei ,让我们一起挖掘数据的价值~

哪怕是野火焚烧,哪怕是冰雪覆盖,依然是志向不改,依然是信念不衰。 (ง •_•)ง

文章目录

一、前言

大数据开启了一次重大的时代转型。就像望远镜让我们能感受宇宙,显微镜让我们能够观测微生物一样,成为新发明和新服务的源泉,而更多的改变也正蓄势待发…

《大数据时代:生活、工作与思维的大变革》是被誉为“大数据时代的预言家”的牛津大学教授维克托.迈克-舍恩伯格所写的一本经典大数据书籍,虽然书籍出版于七年前,但其中很多的观点至今看来依然振聋发聩,如果还没读过此书的同学,建议可以读一下。

但毕竟这么多年过去了,大家对大数据也有了一些新的认识, 无论是所谓的大数据带来了思维方式上的变革,还是技术上的革命,或者商业模式或管理模式的改变,但从本质的角度讲,大数据还没有达到所谓的高度,即大数据时代,其与信息时代的计算机、集成电路、光纤通信,互联网相比,目前还无法媲美,衡量大数据成功的标志,是是否推动了国家的人均信息消费水平达到一个新的高度。

但这两年,DT时代到来的呼声愈来愈高,是的,马爸爸说的IT到DT的时代已经到来!目前中国,一年半导体芯片的国际贸易额,超过石油成为第一大进口商品,足以证明我国算力需求增长迅猛,比重惊人。全球电脑服务器的耗电量,也早就超过了钢铁、汽车等传统工业,这一切变化证明,我们正进入DT时代,千真万确。

对于《大数据时代》书中提的很多观点应该用辩证的方法来看待,以下就一些认识上的一些争议我结合傅一平老师的理解做出解答。

二、“不是随机样本,而是全体数据”,实际大多并不是这样

作者表达了一个观点,“当数据处理技术已经发生了翻天覆地的变化时,在大数据时代进行抽样分析就像在汽车时代骑马一样。一切都改变了,我们需要的是所有的数据,“样本=总体””。

这种说法表明了一种新的认知世界的方式,是一种新的趋势,努力达到全量的确可以让我们抓到了更多的细节,让我们摆脱传统统计分析学的束缚,就好比以前预测美国总统大选,采用的是民意抽样统计,而如今已经可以对于社区用户所有言论的判断来更精准的预测。

但是,现实世界很残酷,大多数领域你其实无法拿到全量的数据,或者,如果你要拿到全量的数据,代价极其巨大,因此,大多数时候,我们用的大数据仍是局部的小数据,没有所谓“样本=总体”的条件,传统的以抽样来理解这个世界的方式仍然有效,机器学习与统计学作为一种认知世界的方法也将持续有效,前期的AlphaGo与李世石的人机大战。AlphaGo只能用采样的方式获得有限的棋局进行深度学习就是例证,因为你不可能拿到全部的样本或者甚至是足够的样本,因为这个数量比全宇宙的原子还多。

当然,对于国际象棋和中国象棋上,全量的数据已经使得传统胜负的玄妙缺失了意义,因此,可以这么大胆推测,当某个领域具备“样本=总体”的时候,就是该领域被大数据替换的时刻。

三、“不是精确性,而是混杂性”,没能力但不能否定精确性的价值

作者表达了这样一个观点,执迷于精确性是信息时代和模拟时代的产物。只有5%的数据是结构化且能适用于传统数据库的。如果不接受混乱,剩下95%的非结构化数据都无法被利用,只有接受不精确性,我们才能打开一扇从未涉足的世界的窗户,大数据的简单算法比小数据的复杂算法更有效。

传统数据处理追求“精确度”,这种思维方式适用于掌握“小数据量”的情况,因为需要分析的数据很少,所以我们必须尽可能精准地量化我们的记录。大数据纷繁多样,优劣掺杂,分布广泛。拥有了大数据, 我们不再需要对一个现象刨根究底,只要掌握大体的发展方向即可,适当忽略微观层面上的精确度会让我们在宏观层面拥有更好的洞察力。

这段话说得没错,但我认为大数据的复杂算法对于认识这个世界更为重要,对于精准性的把握始终是我们的目标,只是因为我们现在的算法太弱了,无法驾驭大数据,才提简单的算法。

比如,在工业界一直有个很流行的观点:在大数据条件下,简单的机器学习模型会比复杂模型更加有效。例如,在很多的大数据应用中,最简单的线性模型得到大量使用。而最近深度学习的惊人进展,促使我们也许到了要重新思考这个观点的时候。简而言之,在大数据情况下,也许只有比较复杂的模型,或者说表达能力强的模型,才能充分发掘海量数据中蕴藏的丰富信息。运用更强大的深度模型,也许我们能从大数据中发掘出更多有价值的信息和知识。

为了理解为什么大数据需要深度模型,先举一个例子。语音识别已经是一个大数据的机器学习问题,在其声学建模部分,通常面临的是十亿到千亿级别的训练样本。在Google的一个语音识别实验中,发现训练后的DNN对训练样本和测试样本的预测误差基本相当。这是非常违反常识的,因为通常模型在训练样本上的预测误差会显著小于测试样本。因此,只有一个解释,就是由于大数据里含有丰富的信息维度,即便是DNN这样的高容量复杂模型也是处于欠拟合的状态,更不必说传统的GMM声学模型了。所以从这个例子中我们看出,大数据需要复杂深度学习,毫无疑问AlphGo也必定是欠拟合的。

四、“不是因果关系,而是相关关系”,追求真理是我们永恒的目标

作者提出了这样一个观点,寻找因果关系是人类长久以来的习惯。即使确定因果关系很困难而且用途不大,人类还是习惯性地寻找缘由。在大数据时代,我们无须再紧盯事物之间的因果关系,不再把分析建立在早已设立的假设的基础之上。而应该寻找事物之间的相关关系,让大数据告诉我们“是什么”而不是“为什么”。

一方面,应该承认基于大数据的相关关系是我们认识世界和改造世界的新的方式,从应用科学的角度讲,降低对于因果关系的追求可以让大数据创造更大的价值。

另一方面,当前阶段由于我们对于世界的认知太少,人类在有限的时间内不可能找到“终极真理”,大量的规律通过大数据暴露出了蛛丝马迹,即所谓的相关关系,但其本质上仍是因果关系的体现,因此两者并不冲突。一个解决当前问题,是近,一个解决长期问题,是远,两者相辅相成,无所谓谁替代谁。从社会角度来讲,企业可以致力于大数据相关关系来创造更多的商机,而因果关系仍然是基础研究需要追求的东西,不能说人类物质上满足了,就不去追求更为本原的东西。

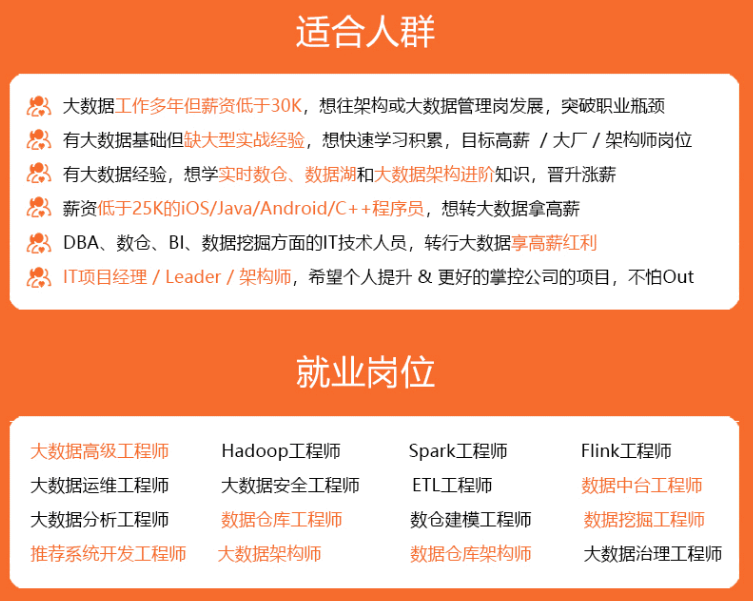

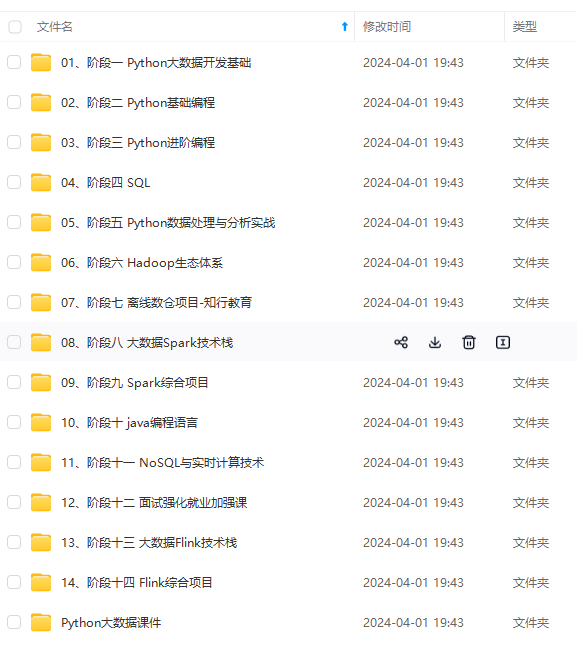

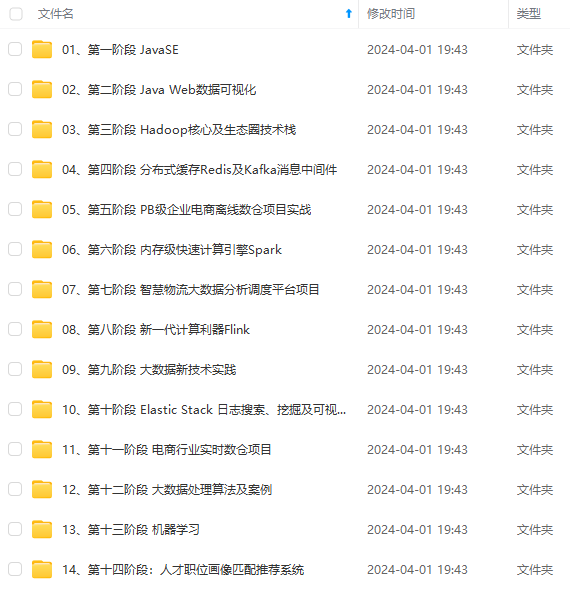

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?