既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上软件测试知识点,真正体系化!

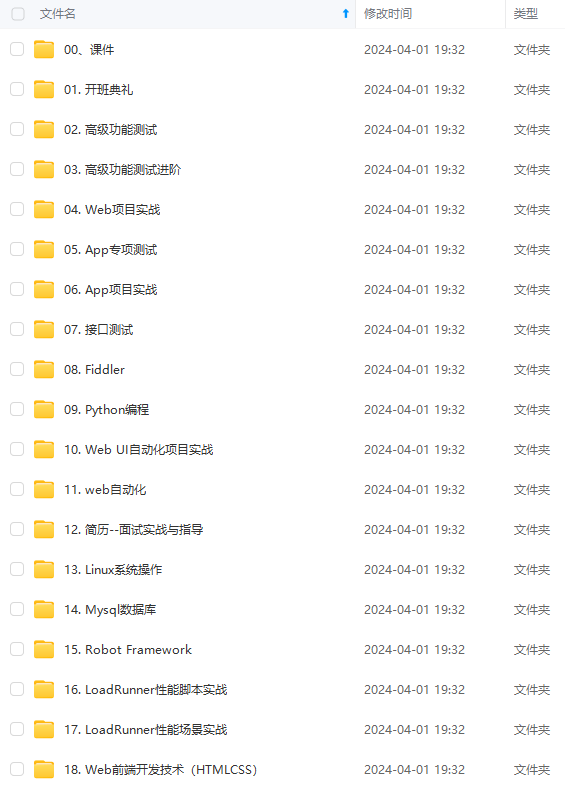

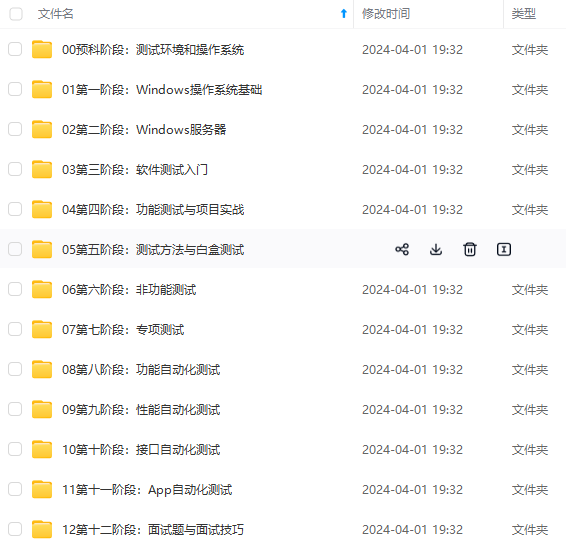

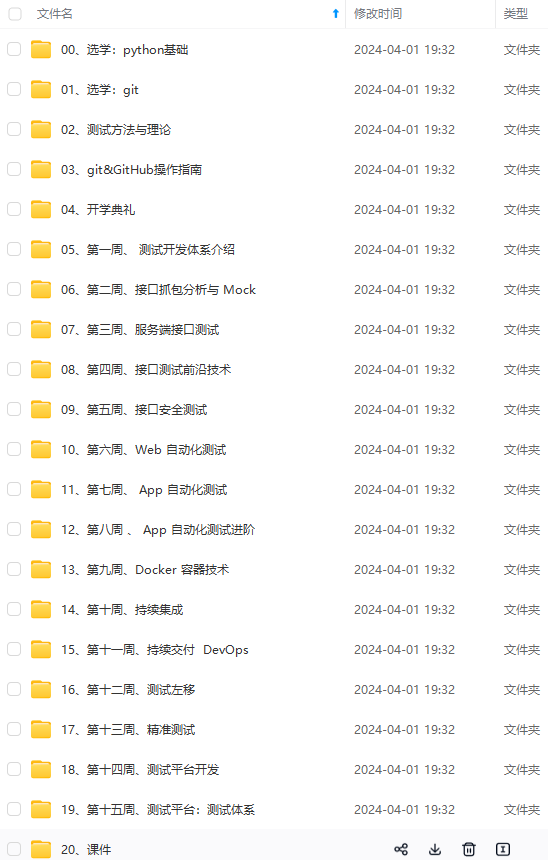

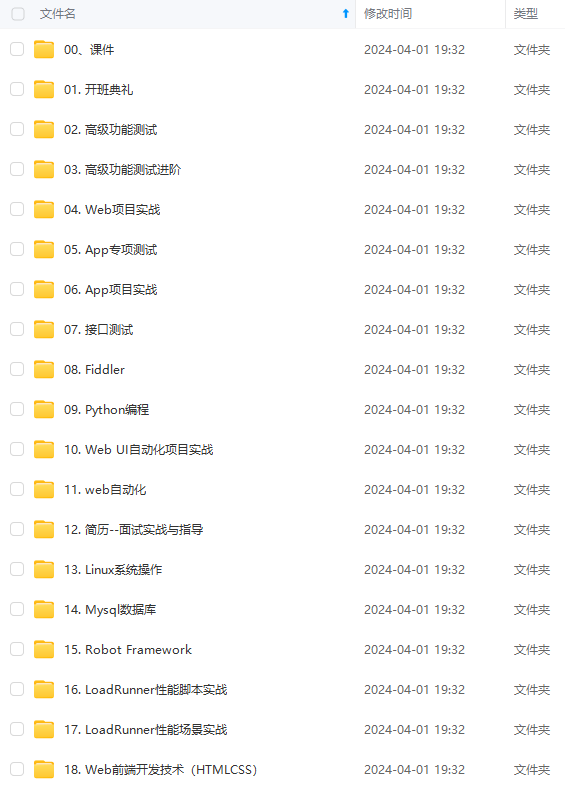

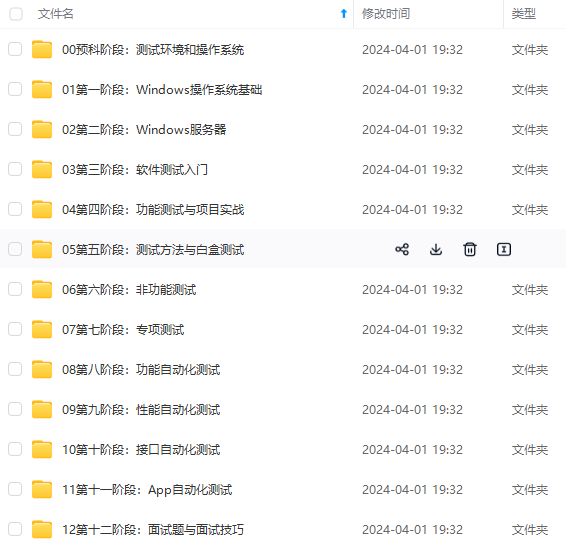

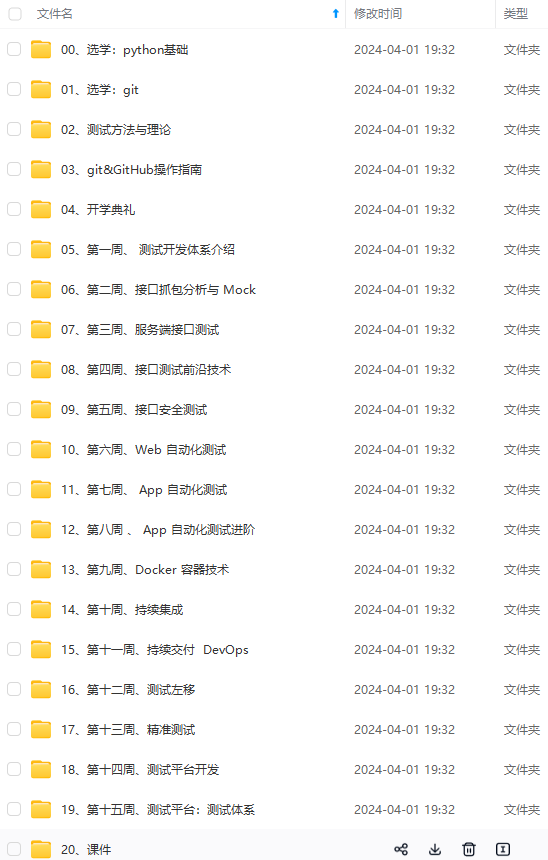

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

{

“analyzer”: “stop”,

“text”: “The 2 QUICK Brown-Foxes jumped over the lazy dog’s bone.”

}

–>[ quick, brown, foxes, jumped, over, lazy, dog, s, bone ]

可选参数:

stopwords

stopwords_path

**keyword 不分词的**

POST _analyze

{

“analyzer”: “keyword”,

“text”: [“The 2 QUICK Brown-Foxes jumped over the lazy dog’s bone.”]

}

得到 “token”: “The 2 QUICK Brown-Foxes jumped over the lazy dog’s bone.” 一条完整的语句

## 第三方analyzer插件—中文分词(ik分词器)

es内置很多分词器,但是对中文分词并不友好,例如使用standard分词器对一句中文话进行分词,会分成一个字一个字的。这时可以使用第三方的Analyzer插件,比如 ik、pinyin等。这里以ik为例

**1,首先安装插件,重启es:**

bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.3.0/elasticsearch-analysis-ik-6.3.0.zip

/etc/init.d/elasticsearch restart

**2,使用示例:**

GET _analyze

{

“analyzer”: “ik_max_word”,

“text”: “你好吗?我有一句话要对你说呀。”

}

参考:https://github.com/medcl/elasticsearch-analysis-ik

**还可以用内置的 character filter, tokenizer, token filter 组装一个analyzer(custom analyzer)**

博客园首页新随笔联系管理订阅订阅随笔- 65 文章- 0 评论- 6

es的分词器analyzer

analyzer

分词器使用的两个情形:

1,Index time analysis. 创建或者更新文档时,会对文档进行分词

2,Search time analysis. 查询时,对查询语句分词

指定查询时使用哪个分词器的方式有:

- 查询时通过analyzer指定分词器

View Code

- 创建index mapping时指定search\_analyzer

View Code

索引时分词是通过配置 Index mapping中的每个字段的参数analyzer指定的

按 Ctrl+C 复制代码

## 不指定分词时,会使用默认的standard

PUT test\_index

{

“mappings”: {

“doc”: {

“properties”: {

“title”:{

“type”: “text”,

“analyzer”: “whitespace” #指定分词器,es内置有多种analyzer

}

}

}}}

按 Ctrl+C 复制代码

注意:

明确字段是否需要分词,不需要分词的字段将type设置为keyword,可以节省空间和提高写性能。

\_analyzer api

按 Ctrl+C 复制代码

GET \_analyze

{

“analyzer”: “standard”,

“text”: “this is a test”

}

## 可以查看text的内容使用standard分词后的结果

按 Ctrl+C 复制代码

View Code

设置analyzer

按 Ctrl+C 复制代码

PUT test

{

“settings”: {

“analysis”: { #自定义分词器

“analyzer”: { # 关键字

“my\_analyzer”:{ # 自定义的分词器

“type”:“standard”, #分词器类型standard

“stopwords”:“*english*” #standard分词器的参数,默认的stopwords是\_none\_

}

}

}

},

“mappings”: {

“doc”:{

“properties”: {

“my\_text”:{

“type”: “text”,

“analyzer”: “standard”, # my\_text字段使用standard分词器

“fields”: {

“english”:{ # my\_text.english字段使用上面自定义得my\_analyzer分词器

“type”: “text”,

“analyzer”: “my\_analyzer”

}}}}}}}

POST test/\_analyze

{

“field”: “my\_text”, # my\_text字段使用的是standard分词器

“text”: [“The test message.”]

}

-------------->[the,test,message]

POST test/\_analyze

{

“field”: “my\_text.english”, #my\_text.english使用的是my\_analyzer分词器

“text”: [“The test message.”]

}

------------>[test,message]

按 Ctrl+C 复制代码

ES内置了很多种analyzer。比如:

standard 由以下组成

tokenizer:Standard Tokenizer

token filter:Standard Token Filter,Lower Case Token Filter,Stop Token Filter

按 Ctrl+C 复制代码

analyzer API测试 :

POST \_analyze

{

“analyzer”: “standard”,

“text”: “The 2 QUICK Brown-Foxes jumped over the lazy dog’s bone.”

}

按 Ctrl+C 复制代码

得到结果:

View Code

whitespace 空格为分隔符

按 Ctrl+C 复制代码

POST \_analyze

{

“analyzer”: “whitespace”,

“text”: “The 2 QUICK Brown-Foxes jumped over the lazy dog’s bone.”

}

–> [ The,2,QUICK,Brown-Foxes,jumped,over,the,lazy,dog’s,bone. ]

按 Ctrl+C 复制代码

simple

按 Ctrl+C 复制代码

POST *analyze

{

“analyzer”: “simple”,

“text”: “The 2 QUICK Brown-Foxes jumped over the lazy dog’s bone.”

}

—> [ the, quick, brown, foxes, jumped, over, the, lazy, dog, s, bone ]

按 Ctrl+C 复制代码

stop 默认stopwords用\_english*

按 Ctrl+C 复制代码

POST \_analyze

{

“analyzer”: “stop”,

“text”: “The 2 QUICK Brown-Foxes jumped over the lazy dog’s bone.”

}

–>[ quick, brown, foxes, jumped, over, lazy, dog, s, bone ]

可选参数:

## stopwords

## stopwords\_path

按 Ctrl+C 复制代码

keyword 不分词的

按 Ctrl+C 复制代码

POST \_analyze

{

“analyzer”: “keyword”,

“text”: [“The 2 QUICK Brown-Foxes jumped over the lazy dog’s bone.”]

}

得到 “token”: “The 2 QUICK Brown-Foxes jumped over the lazy dog’s bone.” 一条完整的语句

按 Ctrl+C 复制代码

第三方analyzer插件—中文分词(ik分词器)

es内置很多分词器,但是对中文分词并不友好,例如使用standard分词器对一句中文话进行分词,会分成一个字一个字的。这时可以使用第三方的Analyzer插件,比如 ik、pinyin等。这里以ik为例

1,首先安装插件,重启es:

按 Ctrl+C 复制代码

## bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.3.0/elasticsearch-analysis-ik-6.3.0.zip

## /etc/init.d/elasticsearch restart

按 Ctrl+C 复制代码

2,使用示例:

按 Ctrl+C 复制代码

GET \_analyze

{

“analyzer”: “ik\_max\_word”,

“text”: “你好吗?我有一句话要对你说呀。”

}

按 Ctrl+C 复制代码

分词结果

参考:https://github.com/medcl/elasticsearch-analysis-ik

**还可以用内置的 character filter, tokenizer, token filter 组装一个analyzer(custom analyzer)**

**custom 定制analyzer,由以下几部分组成**

* 0个或多个e character filters

* 1个tokenizer

* 0个或多个 token filters

## 自定义分词器

自定义分词需要在索引的配置中设定,如下所示 :

PUT test_index

{

“settings”: {

“analysis”: { # 分词设置,可以自定义

“char_filter”: {}, #char_filter 关键字

“tokenizer”: {}, #tokenizer 关键字

“filter”: {}, #filter 关键字

“analyzer”: {} #analyzer 关键字

}

}

}

**character filter 在tokenizer之前对原始文本进行处理,比如增加,删除,替换字符等**

会影响后续tokenizer解析的position和offset信息

* html strip 除去html标签和转换html实体

参数:escaped\_tags不删除的标签

* mapping 映射类型,以下参数必须二选一

mappings 指定一组映射,每个映射格式为 key=>value

mappings\_path 绝对路径或者相对于config路径 key=>value

PUT t_index

{

“settings”: {

“analysis”: {

“analyzer”: { #关键字

“my_analyzer”:{ #自定义分词器

“tokenizer”:“standard”,

“char_filter”:“my_char_filter”

}

},

“char_filter”: { #关键字

“my_char_filter”:{ #自定义char_filter

“type”:“mapping”,

“mappings”:[ #指明映射关系

“:)=>happy”,

“:(=>sad”

]

}}}}}

POST t_index/_analyze

{

“analyzer”: “my_analyzer”,

“text”: [“i am so 😃”]

}

得到 [i,am,so,happy]

**pattern replace**

* pattern参数 正则

* replacement 替换字符串 可以使用$1…$9

* flags 正则标志

## tokenizer 将原始文档按照一定规则切分为单词

**standard**

参数:max\_token\_length,最大token长度,默认是255

**letter 非字母时分成多个terms**

lowcase 跟letter tokenizer一样 ,同时将字母转化成小写

**whitespace 按照空白字符分成多个terms**

参数:max\_token\_length

**keyword 空操作,输出完全相同的文本**

参数:buffer\_size,单词一个term读入缓冲区的长度,默认256

**token filter 针对tokenizer 输出的单词进行增删改等操作**

lowercase 将输出的单词转化成小写

stop 从token流中删除stop words

参数有:

stopwords 要使用的stopwords, 默认_english_

stopwords_path

ignore_case 设置为true则为小写,默认false

remove_trailing

PUT t_index

{

“settings”: {

“analysis”: {

“analyzer”: {

“my_analyzer”:{

“type”:“custom”,

“tokenizer”:“standard”,

“filter”:“my_filter”

}

},

“filter”: {

“my_filter”:{

“type”:“stop”,

“stopwords”:[“and”,“or”,“not”]

}

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上软件测试知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

[“and”,“or”,“not”]

}

[外链图片转存中…(img-LAdNtglY-1715550468382)]

[外链图片转存中…(img-edDhbpW8-1715550468383)]

[外链图片转存中…(img-65zePd8Q-1715550468383)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上软件测试知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

601

601

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?