最后

🍅 硬核资料:关注即可领取PPT模板、简历模板、行业经典书籍PDF。

🍅 技术互助:技术群大佬指点迷津,你的问题可能不是问题,求资源在群里喊一声。

🍅 面试题库:由技术群里的小伙伴们共同投稿,热乎的大厂面试真题,持续更新中。

🍅 知识体系:含编程语言、算法、大数据生态圈组件(Mysql、Hive、Spark、Flink)、数据仓库、Python、前端等等。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

代理IP网站:https://www.xicidaili.com/

详细代码(附上详细注释):

其中发送邮件,创建EXCEL文件代码详情见我的另一篇博客:Python 爬取数据后以Excel格式保存,并自动发送邮件

# encoding=utf8

# @Author : LYG

# @Time : 2019/2/13 11:16

# @Name : CrawlWechat.py

from bs4 import BeautifulSoup

from urllib2 import urlopen

from selenium import webdriver

from datetime import datetime

import urllib2

import CreateExcel

import SendEmail

import time

import random

class items:

"""

定义结构体,包含所需要传送的相关信息

"""

def __init__(self):

self.title = ""

self.link = ""

self.time = ""

self.summary = "" # 摘要

def get_urls():

'''

通过代理IP 随机时间访问减少被封的概率

通过搜狗搜索,获取指定公众号的最新链接

:return:

new_url : 指定公众号的最新链接

'''

# 修改query的参数即可(支持中文修改),也可以直接访问域名带data就好

# type=1 指明是搜索公众号,type=0 指明是搜索文章

# wechat : 公众号的名称

# The proxy address and port:

proxy_info = {'host': '58.54.136.23',

'port': 9999

}

proxy_support = urllib2.ProxyHandler({"https": "https://%(host)s:%(port)d" % proxy_info})

opener = urllib2.build_opener(proxy_support)

urllib2.install_opener(opener)

wechat = ['Linux公社','Linux爱好者','Linux开源社区','马哥Linux运维']

new_urls = []

for i in range(len(wechat)):

url = "https://weixin.sogou.com/weixin?type=1&s_from=input&query=%s&ie=utf8&_sug_=n&_sug_type_="%(wechat[i])

max_num = 10

page = None

for tries in range(max_num):

try:

page = urllib2.urlopen(url)

break

except:

if tries < max_num-1:

continue

else:

print "failed ! "

break

html = page.read()

soup = BeautifulSoup(html,'lxml')

node = soup.select('a[uigs="account_name_0"]')

new_urls.append(node[0]['href'])

# 随机时间去访问,不然访问太快会被封

time.sleep(random.randint(2,4))

return new_urls

def get_content(*keys):

'''

拿到公众号里最新十篇文章的标题与URL,

根据指定关键字进行过滤

:return:

'''

urls = get_urls()

# phantomjs.exe 的绝对路径

driver= webdriver.PhantomJS(executable_path=r"D:\python\venv\Lib\site-packages\selenium\webdriver\phantomjs\phantomjs-2.1.1-windows\phantomjs-2.1.1-windows\bin\phantomjs.exe")

# content 为所有需要传送的信息集合

content = []

for url in urls:

driver.get(url)

html = driver.page_source

soup = BeautifulSoup(html, 'lxml')

titles = soup.select("h4.weui_media_title")

for title in titles:

# & 符号转义 & = &

node_link = "https://mp.weixin.qq.com"+title['hrefs'].replace('&','&')

node_summary = title.find_next('p')

node_time = node_summary.find_next('p')

node_title = title.text.strip()

for key in keys:

if node_title.find(key) != -1: # 包含所输入的关键字

node = items()

node.title = node_title

node.link = node_link

node.summary = node_summary.text

### 最后

Python崛起并且风靡,因为优点多、应用领域广、被大牛们认可。学习 Python 门槛很低,但它的晋级路线很多,通过它你能进入机器学习、数据挖掘、大数据,CS等更加高级的领域。Python可以做网络应用,可以做科学计算,数据分析,可以做网络爬虫,可以做机器学习、自然语言处理、可以写游戏、可以做桌面应用…Python可以做的很多,你需要学好基础,再选择明确的方向。这里给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

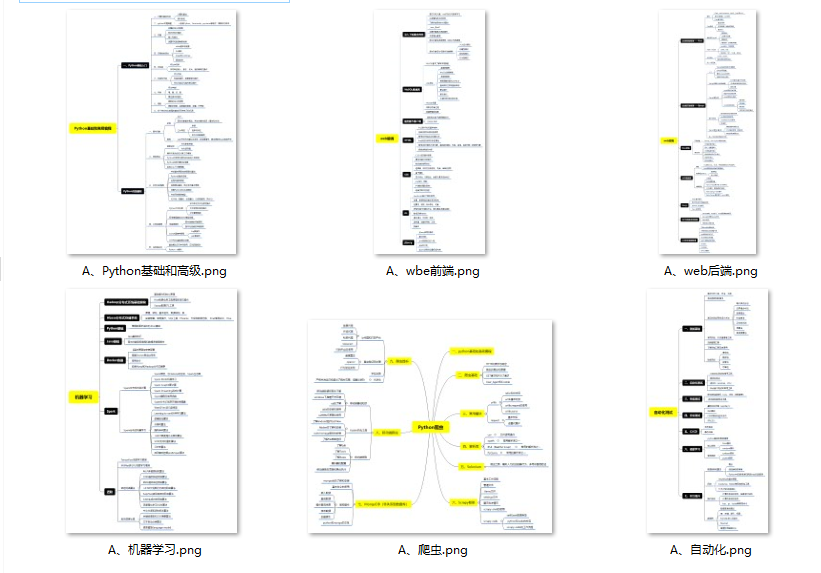

#### 👉Python所有方向的学习路线👈

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

#### 👉Python必备开发工具👈

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

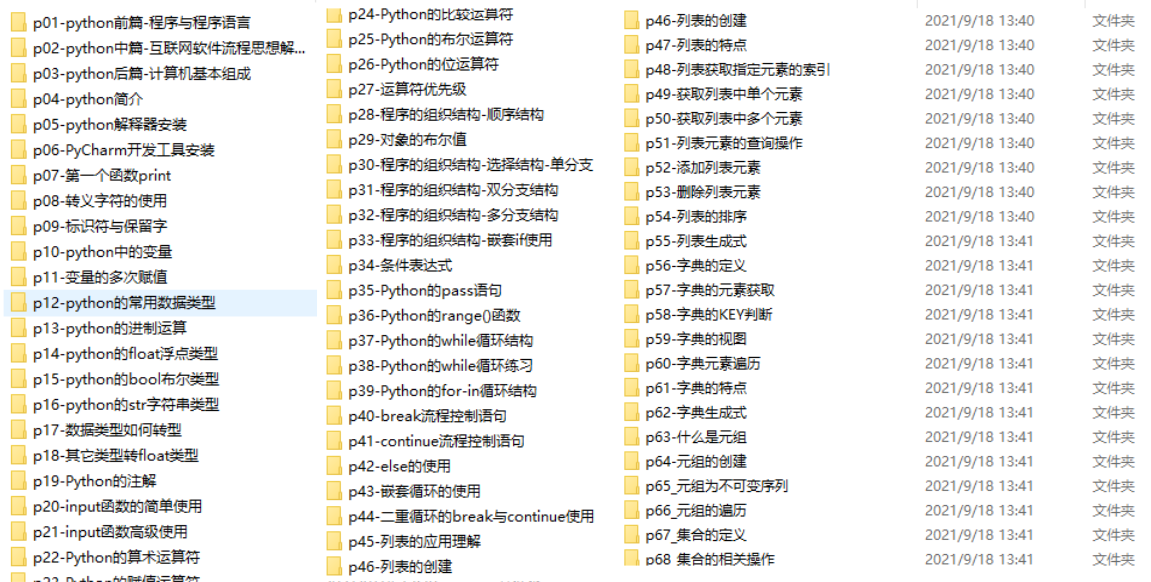

#### 👉Python全套学习视频👈

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

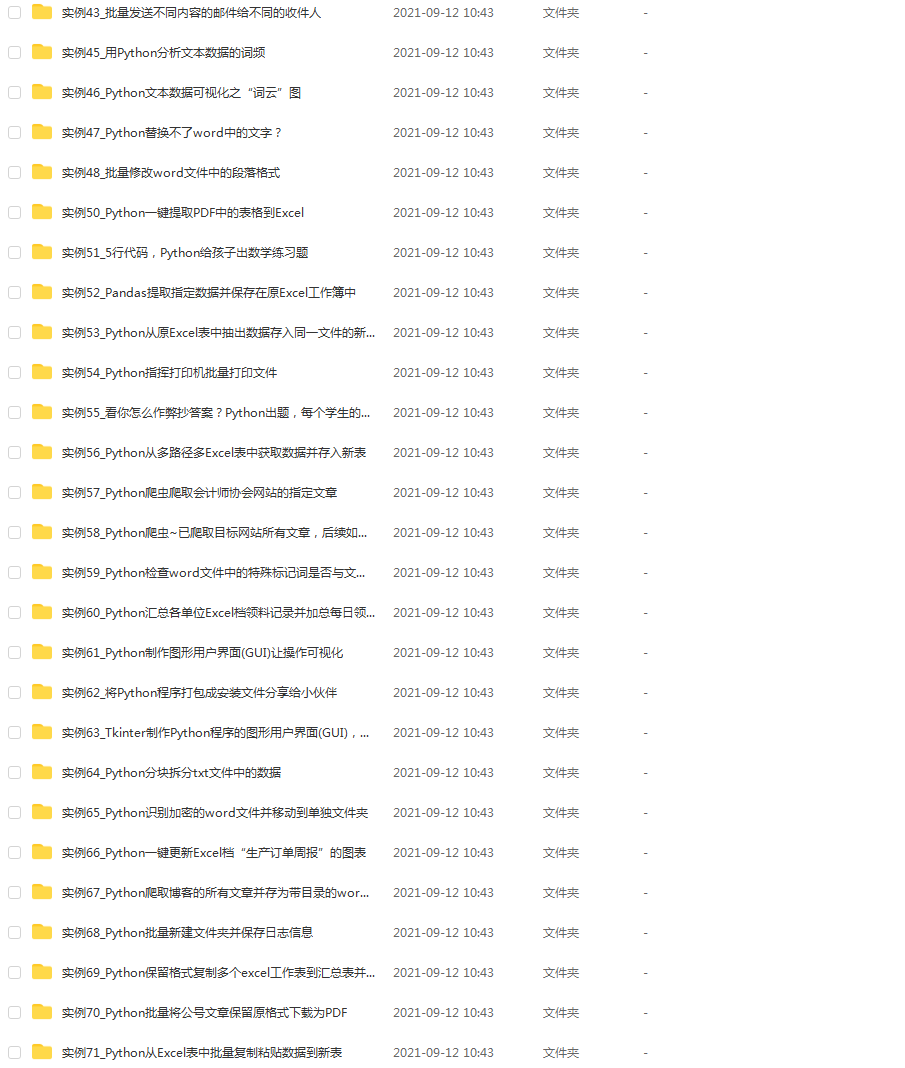

#### 👉实战案例👈

学python就与学数学一样,是不能只看书不做题的,直接看步骤和答案会让人误以为自己全都掌握了,但是碰到生题的时候还是会一筹莫展。

因此在学习python的过程中一定要记得多动手写代码,教程只需要看一两遍即可。

#### 👉大厂面试真题👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

**[需要这份系统化学习资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618317507)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

2160

2160

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?