感谢每一个认真阅读我文章的人,看着粉丝一路的上涨和关注,礼尚往来总是要有的:

① 2000多本Python电子书(主流和经典的书籍应该都有了)

② Python标准库资料(最全中文版)

③ 项目源码(四五十个有趣且经典的练手项目及源码)

④ Python基础入门、爬虫、web开发、大数据分析方面的视频(适合小白学习)

⑤ Python学习路线图(告别不入流的学习)

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

百度文库的接口太难找了,请求头的构造也很麻烦,找了很久也没有很满意。所以在本次爬取中,我们使用的是第二种方法,使用Selenium这样的自动化测试工具。

在这里不多加介绍WebDriver,有兴趣的小伙伴可以自己查一下,我们直接上手使用。

这里我们需要下载ChromeDriver这个插件,当然这里是默认大家使用的是Chrome浏览器,如果是其他的浏览器,firefox,safari等等,直接去网上找到相应Driver就可以了。

这里给出ChromeDriver的下载地址:

http://npm.taobao.org/mirrors/chromedriver/

大家一定要下载和自己Chrome浏览器版本一致的ChromeDriver,不然程序是运行不起来的。

我们先不急着马上开始爬取,我们先来尝试使用一下Selenium调用ChromeDriver。

import requests

from selenium import webdriver

url = 'https://wenku.baidu.com/view/5292b2bc0166f5335a8102d276a20029bd64638c.html?fr=search'

driver = webdriver.Chrome(r'F:\driver\chromedriver.exe')

driver.get(url)

怎么样,是不是浏览器自动打开了?现在我们尝试输出这个driver,就可以看见,网页的正确源代码已经在里面了。

现在我们仔细研究一下源代码就可以看到,我们需要的内容在下面这个位置。

现在正确的源代码也有了,内容的位置也知道了,直接解析,爬取,完事就好了。

想得美,经过这样的爬取之后,对内容进行解析,让我们看看究竟爬到没有。

from lxml import etree

import re

html=etree.HTML(driver.page_source)

links=html.xpath("//div[@class='reader-pic-item']/@style")

part = re.compile(r'url[(](.\*?)[)]')

qa="".join(links)

z=part.findall(qa)

我们可以知道,其实我们只爬到3张PDF,其他的都没有爬到。这是为什么呢?

这是百度文库为了防止大家去爬,专门设置的一个小机关。

返回百度文库,我们仔细看看源代码,其实我们可以发现,随着页面的变化,源代码是不断改变的,每次都只有3张图片的url。并且这个页码数也有一定的规律,如果在第二页,那么图片就是1,2,3,如果在第三页,图片就是2,3,4。

那么我们的疑惑一下就解决了,只需要不断地进行换页的爬取,就可以了。接下来就是如何实现换页的操作了。

这个需要两个步骤,先是点击继续阅读,然后进行页面输入实现换页。先实现点击的操作,代码如下。

button = driver.find_element_by_xpath("//\*[@id='html-reader-go-more']/div[2]/div[1]/span")

button.click()

driver.execute_script("arguments[0].click();", button)

整个操作是通过JS来进行的,大家可以把这个记住,以后需要点击的时候直接用就可以。

然后就是输入页面实现换页,这个其实涉及的比较多,细分的话,步骤分为获取总页数,依次输入页面并点击。

import re

#寻找页面

source = re.compile(r'/(.\*?)')

number = int(source.findall(driver.page_source)[0])

输入页面并点击

driver.find_element_by_class_name("page-input").clear()

driver.find_element_by_class_name("page-input").send_keys('2')

driver.find_element_by_class_name("page-input").send_keys(Keys.ENTER)

如果小伙伴成功实现了上面的操作,其实大体的爬取工作已经差不多了,接下来就是保存我们的PPT和PDF了。

因为爬取PDF和PPT的时候,我们是爬取的图片的源地址,那么我们要获得这张图片并保存下来就必须对这个地址发起请求,然后将返回头以二进制保存下来。

for m in range(3):

pic = requests.get(z[m]).content

#方法一

#file = open(f'./照片/{m+1}.jpg','wb')

#file.write(pic)

#file.close()

#方法二

with open(f'./照片/{m+1}.jpg','wb') as f:

f.write(pic)

f.close()

在这里,提醒大家一下一定要按照对图片用正确顺序进行命名,因为后面保存为PDF的时候,需要排序。

在py文件的目录下,大家就可以看见保存下来的图片了。最后一步,将图片保存为PDF。

from PIL import Image

import os

folderPath = "F:/TEST"

filename = "test"

files = os.listdir(folderPath)

jpgFiles = []

sources = []

for file in files:

if 'jpg' in file:

jpgFiles.append(file)

tep = []

for i in jpgFiles:

ex = i.split('.')

tep.append(int(ex[0]))

tep.sort()

jpgFiles=[folderPath +'/'+ str(i) + '.jpg' for i in tep]

output = Image.open(jpgFiles[0])

jpgFiles.pop(0)

for file in jpgFiles:

img = Image.open(file)

img = img.convert("P")

sources.append(img)

output.save(f"./{filename}.pdf","PDF",save_all=True,append_images=sources)

最终的结果就是生成了咱们的PDF文件。

上述的操作看起来很多,很麻烦,其实并不是的。因为大部分的操作都是固定的,大家只需要记熟就可以了。

完整代码:

import requests

from selenium import webdriver

from lxml import etree

import re

from selenium.webdriver.common.keys import Keys

import time

from PIL import Image

import os

from bs4 import BeautifulSoup

import bs4

from docx import Document

import sys

def getHTMLText(url):

header = {'User-agent': 'Googlebot'}

try:

r = requests.get(url, headers = header, timeout = 30)

r.raise_for_status()

r.encoding = 'gbk'

#r.encoding = r.apparent\_encoding

return r.text

except:

return ''

def parse\_type(content):

return re.findall(r"docType.\*?\:.\*?\'(.\*?)\'\,", content)[0]

def parse\_txt(html):

plist = []

soup = BeautifulSoup(html, "html.parser")

plist.append(soup.title.string)

for div in soup.find_all('div', attrs={"class": "bd doc-reader"}):

plist.extend(div.get_text().split('\n'))

plist = [c.replace(' ', '') for c in plist]

plist = [c.replace('\x0c', '') for c in plist]

return plist

def print\_docx(plist, filename):

file = open(filename + '.txt', 'w',encoding='utf-8')

for str in plist:

file.write(str)

file.write('\n')

file.close()

with open(filename + '.txt', encoding='utf-8') as f:

docu = Document()

docu.add_paragraph(f.read())

docu.save(filename + '.docx')

def parse\_doc(url, folderPath):

driver = webdriver.Chrome(r'./src/chromedriver.exe')

driver.get(url)

#找到‘继续阅读’按钮 定位至还剩35页未读,继续阅读

button = driver.find_element_by_xpath("//\*[@id='html-reader-go-more']/div[2]/div[1]/span")

#按下按钮

driver.execute_script("arguments[0].click();", button)

time.sleep(1)

source = re.compile(r'/(.\*?)')

number = int(source.findall(driver.page_source)[0])

#获取页码数

#number = total[1]

time.sleep(1)

for i in range(2,number):

driver.find_element_by_class_name("page-input").clear()

driver.find_element_by_class_name("page-input").send_keys(f'{i}')

driver.find_element_by_class_name("page-input").send_keys(Keys.ENTER)

time.sleep(1)

html=etree.HTML(driver.page_source)

#找到picture容器

links=html.xpath("//div[@class='reader-pic-item']/@style")

#找到图片对应的url

part = re.compile(r'url[(](.\*?)[)]')

qa="".join(links)

z=part.findall(qa)

if i == 2:

for m in range(3):

pic = requests.get(z[m]).content

with open(f'./照片/{m+1}.jpg','wb') as f:

f.write(pic)

f.close()

else:

pic = requests.get(z[2]).content

with open(f'./照片/{i+1}.jpg','wb') as f:

f.write(pic)

f.close()

time.sleep(1)

driver.quit()

def parse\_other(url, folderPath):

driver = webdriver.Chrome(r'./src/chromedriver.exe')

driver.get(url)

#找到‘继续阅读’按钮 定位至还剩35页未读,继续阅读

button = driver.find_element_by_xpath("//\*[@id='html-reader-go-more']/div[2]/div[1]/span")

#按下按钮

driver.execute_script("arguments[0].click();", button)

time.sleep(1)

source = re.compile(r'/(.\*?)')

number = int(source.findall(driver.page_source)[0])

#获取页码数

#number = total[1]

time.sleep(1)

#获取图片

for i in range(2,number):

driver.find_element_by_class_name("page-input").clear()

driver.find_element_by_class_name("page-input").send_keys(f'{i}')

driver.find_element_by_class_name("page-input").send_keys(Keys.ENTER)

time.sleep(1)

html=etree.HTML(driver.page_source)

#找到picture容器"//div[@class='reader-pic-item']/@style"

z=html.xpath('//div[@class="ppt-image-wrap"]/img/@src')

#print(z)

#保存图片

if i == 2:

for m in range(3):

pic = requests.get(z[m]).content

with open(folderPath + f'/{m + 1}.jpg','wb') as f:

f.write(pic)

f.close()

else:

pic = requests.get(z[i]).content

with open(folderPath + f'/{i + 1}.jpg','wb') as f:

f.write(pic)

f.close()

time.sleep(1)

driver.quit()

def print\_pdf(folderPath, filename):

files = os.listdir(folderPath)

jpgFiles = []

sources = []

for file in files:

if 'jpg' in file:

jpgFiles.append(file)

tep = []

for i in jpgFiles:

ex = i.split('.')

tep.append(int(ex[0]))

tep.sort()

jpgFiles=[folderPath +'/'+ str(i) + '.jpg' for i in tep]

output = Image.open(jpgFiles[0])

jpgFiles.pop(0)

for file in jpgFiles:

img = Image.open(file)

img = img.convert("P")

sources.append(img)

output.save(f"{filename}.pdf","PDF",save_all=True,append_images=sources)

def main(url, istxt):

try:

ticks = time.time() # 获取时间(用于命名文件夹)

filepath = './照片' + str(ticks) # 保存爬取的图片

filename = './爬取结果' + str(ticks) # 爬取生成的文件名

if not os.path.exists(filepath): # 新建文件夹

os.mkdir(filepath)

html = getHTMLText(url) # requests库爬取

type = parse_type(html) # 获取文库文件类型:ppt, pdf, docx

#当你要爬取文档的文本时,打开下列注释

if(istxt == "1"):

type = 'txt'

if type == 'txt' :

plist = parse_txt(html)

print_docx(plist, filename)

elif type == 'doc' or type == 'pdf':

parse_doc(url, filepath)

print_pdf(filepath , filename)

else:

parse_other(url, filepath)

print_pdf(filepath, filename)

print('1')

except:

print('0')

if __name__ == '\_\_main\_\_':

main(sys.argv[1],sys.argv[2])

#url = 'https://wenku.baidu.com/view/5292b2bc0166f5335a8102d276a20029bd64638c.html?fr=search'

#istxt = "0"

#main(url,istxt)

关于破Baidu文库付费限制的代码到这里就结束了。

朋友们如果需要学习Python或者需要更多爬虫脚本实战源代码,可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

关于学习Python的一些资料分享

学好 Python 不论是就业、副业赚钱、还是提升学习、工作效率,都是非常不错的选择,但要学会 Python 还是要有一个学习规划。最后,我整理了一份Python全套学习资料,包含视频、源码、课件,给那些想学习 Python 的小伙伴们一点帮助!

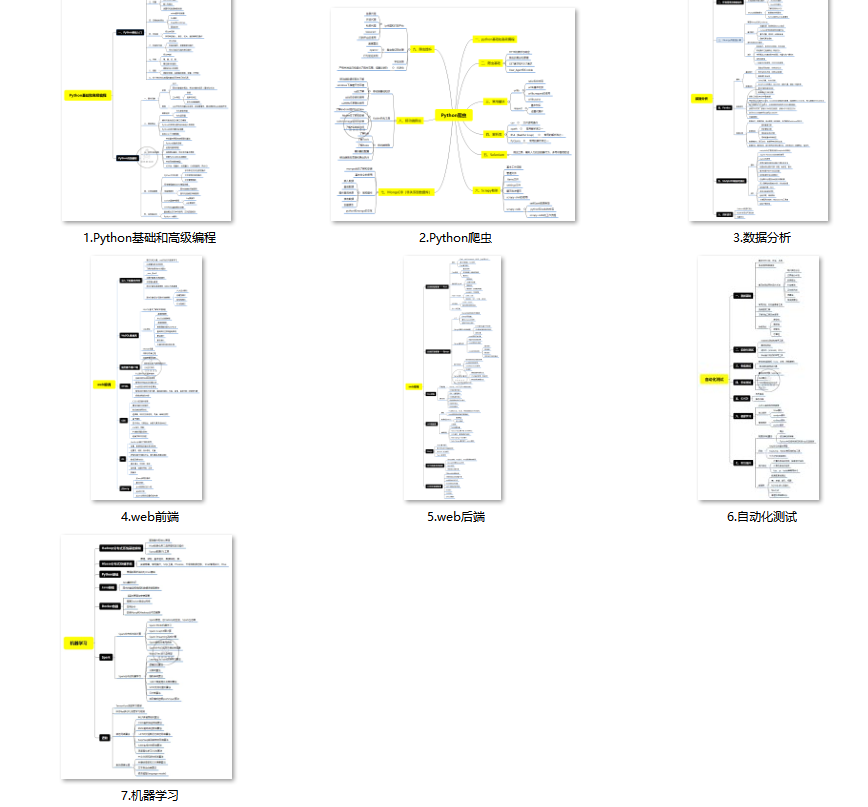

① Python所有方向的学习路线图,清楚各个方向要学什么东西

② 100多节Python课程视频,涵盖必备基础、爬虫和数据分析

③ 100多个Python实战案例,学习不再是只会理论

④ 华为出品独家Python漫画教程,手机也能学习

⑤ 历年互联网企业Python面试真题,复习时非常方便

做了那么多年开发,自学了很多门编程语言,我很明白学习资源对于学一门新语言的重要性,这些年也收藏了不少的Python干货,对我来说这些东西确实已经用不到了,但对于准备自学Python的人来说,或许它就是一个宝藏,可以给你省去很多的时间和精力。

别在网上瞎学了,我最近也做了一些资源的更新,只要你是我的粉丝,这期福利你都可拿走。

我先来介绍一下这些东西怎么用,文末抱走。

(1)Python所有方向的学习路线(新版)

这是我花了几天的时间去把Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

最近我才对这些路线做了一下新的更新,知识体系更全面了。

(2)Python学习视频

包含了Python入门、爬虫、数据分析和web开发的学习视频,总共100多个,虽然没有那么全面,但是对于入门来说是没问题的,学完这些之后,你可以按照我上面的学习路线去网上找其他的知识资源进行进阶。

(3)100多个练手项目

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了,只是里面的项目比较多,水平也是参差不齐,大家可以挑自己能做的项目去练练。

(4)200多本电子书

这些年我也收藏了很多电子书,大概200多本,有时候带实体书不方便的话,我就会去打开电子书看看,书籍可不一定比视频教程差,尤其是权威的技术书籍。

基本上主流的和经典的都有,这里我就不放图了,版权问题,个人看看是没有问题的。

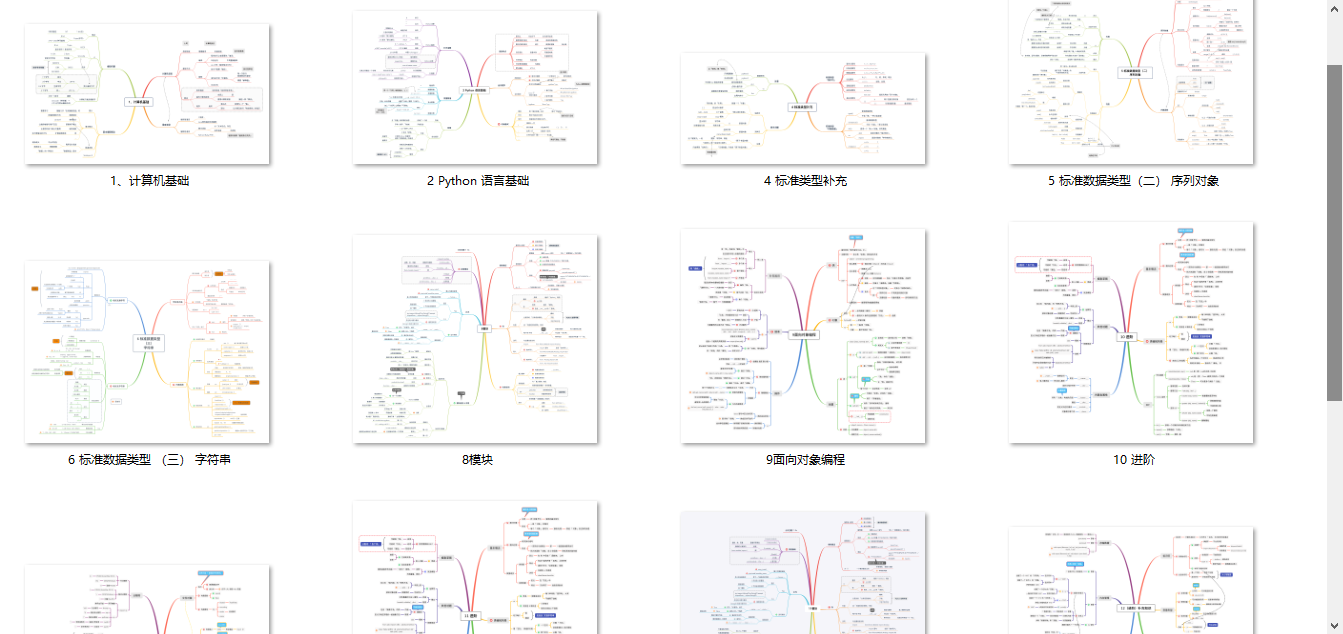

(5)Python知识点汇总

知识点汇总有点像学习路线,但与学习路线不同的点就在于,知识点汇总更为细致,里面包含了对具体知识点的简单说明,而我们的学习路线则更为抽象和简单,只是为了方便大家只是某个领域你应该学习哪些技术栈。

(6)其他资料

还有其他的一些东西,比如说我自己出的Python入门图文类教程,没有电脑的时候用手机也可以学习知识,学会了理论之后再去敲代码实践验证,还有Python中文版的库资料、MySQL和HTML标签大全等等,这些都是可以送给粉丝们的东西。

这些都不是什么非常值钱的东西,但对于没有资源或者资源不是很好的学习者来说确实很不错,你要是用得到的话都可以直接抱走,关注过我的人都知道,这些都是可以拿到的。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?