如何安全、高速、有效地利用IP代理爬取数据

🧙♂️前言

在当今快速变化的商业环境中,数据已成为企业最宝贵的资产之一。如何高效地获取、分析并利用数据,是企业在激烈竞争中脱颖而出的关键。本期给大家分享的是跨界电商的福音、超简单、超好用、超低价、超专业、没有强制消费、可以按需获取、100%保障数据安全性与隐私性,全球10大电商平台中的7家在使用的----《亮数据-全球领先的人工智能驱动的全球公开数据采集平台》,希望大家看完这个视频可以明白这个软件的具体使用过程、并运用到工作与生活中。折扣代码:chenlaoban ,想体验急速点击此链接: 查看有惊喜

👨🎓平台优势

代理ip面临的挑战:

在跨境电商领域信息价值,可是说是关系到商户的生死存亡,通过爬取相关信息,企业可以获得关于市场趋势、消费者偏好和竞争对手动态的深入洞察。 这些信息有助于企业进行市场分析,预测未来的市场趋势,从而制定更有针对性的营销策略和产品开发计划。同时可以帮助企业识别哪些产品在国际市场上受欢迎,哪些产品的利润空间较大。通过分析不同商品的销售量、价格、用户评价等数据,企业可以优化产品组合, 制定有竞争力的定价策略。最重要的是可以了解竞争对手的产品线、价格策略、市场表现和客户反馈,从而使企业能够及时调整自己的商业策略,保持竞争优势。但大的电商网站都有自己的防护策略,保护其数据不被恶意抓取,会采取各种反爬虫措施,如IP封禁、请求频率限制、动态加载的内容、验证码等,同时网络数据的格式多种多样,包括文本、图片、视频、音频等,而且数据结构也千差万别。这要求数据收集工具能够处理各种类型的数据,并从中提取有用的信息,并且需要有足够的存储空间,和高效的数据处理能力。如何有效地存储、管理和分析这些数据,是数据收集过程中需要解决的另一个问题。

平台五大优势:

- 亮数据能力亮点,全面的数据分析,洞察市场趋势:

Bright Data提供的服务不仅限于数据的采集,更重要的是对数据的深度分析和解读。通过利用先进的数据挖掘技术,Bright Data能够帮助企- 业洞察市场趋势、消费者行为和竞争对手动态,从而制定更为精准的市场策略。 - 强大的代理网络,突破地域限制:Bright Data拥有覆盖全球195个国家的代理网络,这意味着无论企业的目标市场在哪里,都能够通过Bright Data获取到实时、准确的数据。这种广泛的网络覆盖,为企业提供了无与伦比的地理灵活性和数据采集能力。

- 灵活的定价策略,满足不同需求:Bright Data理解每个企业的需求都是独特的,因此提供了灵活的定价策略。从随用随付到按月订购,再到大项目每页加载成本的优惠,Bright Data确保每个企业都能找到最适合自己的支付方案。

- 合规的数据采集,保障企业安全:在数据安全和隐私日益受到重视的今天,Bright Data坚持合规的数据采集。它遵守GDPR和CCPA等国际数据保护法规,确保所有数据采集活动都在法律框架内进行,保障企业和客户的利益。

- 专业的客户支持,助力企业成长:Bright Data不仅提供强大的技术和产品,还提供专业的客户支持。无论是初次尝试数据服务的小企业,还是需要定制化解决方案的大企业,Bright Data的数据采集专家都能提供一对一的咨询服务,帮助企业充分利用数据,推动业务增长。

🧙♀️总结

最后呢!亮数据为粉丝提供了10美金的抵用券,成功注册账户,并登录后在用户界面里输入折扣代码即可享受抵扣!

折扣代码:chenlaoban

访问页面:想体验急速点击此链接: 查看有惊喜

如有问题,可以关注“Bright_Data”亮数据官微,联系后台客服。

最后

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数网络安全工程师,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

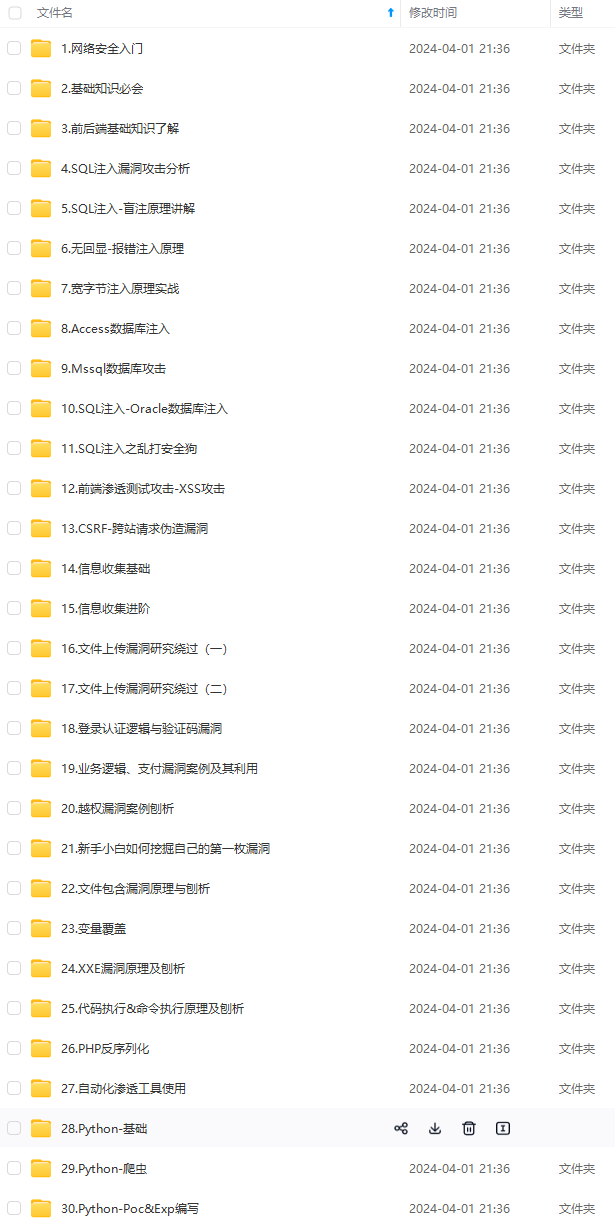

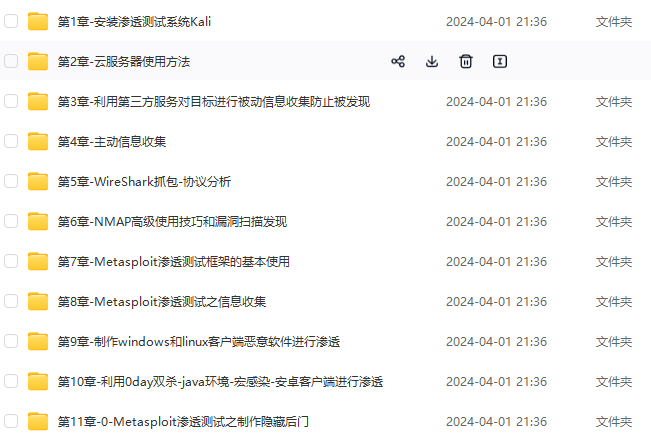

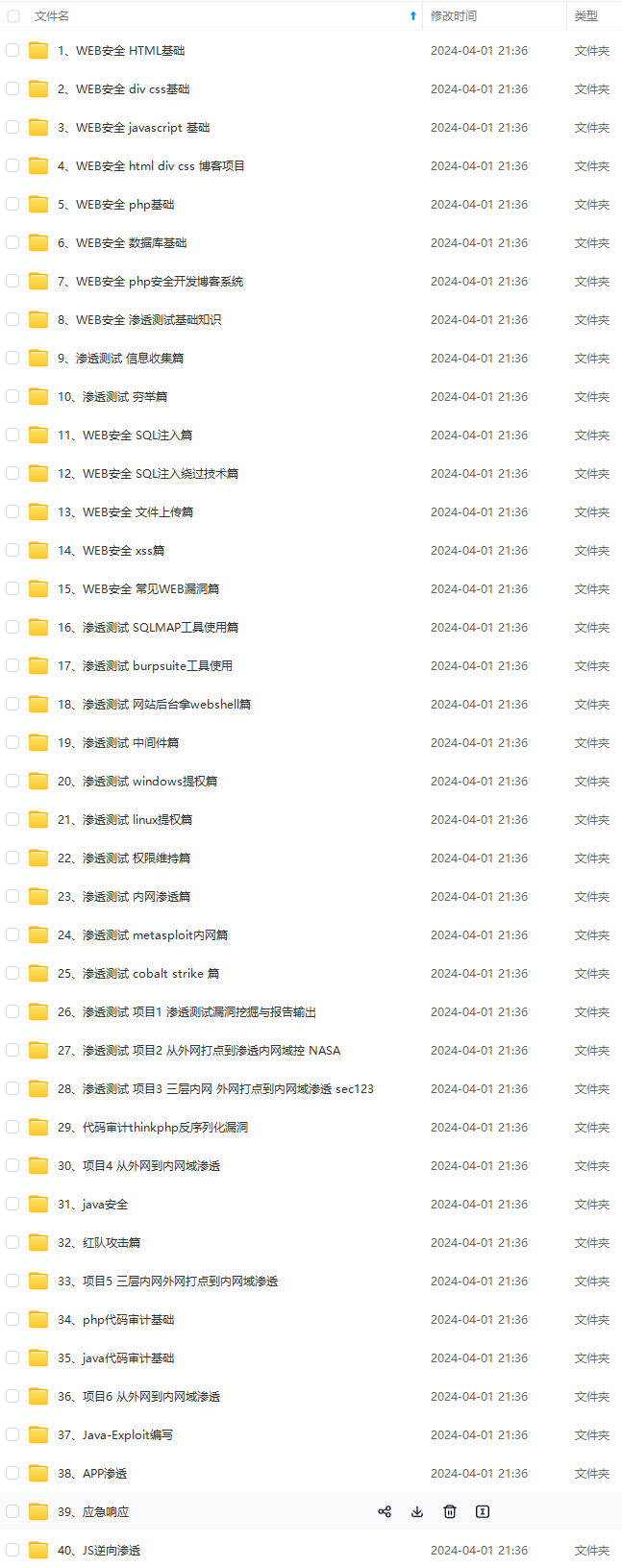

因此收集整理了一份《2024年网络安全全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上网络安全知识点!真正的体系化!

如果你觉得这些内容对你有帮助,需要这份全套学习资料的朋友可以戳我获取!!

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

368

368

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?