首先Midjourney,作为一个非开源的商业应用,训练投喂的数据统一,用户能用到的版本一致,带来的好处就是稳定。

用户A能实现的操作,把方法教给用户B,用户B大概率也能实现。这一点对于生产力来说尤为重要,尤其是规模化生产,能大大提高效率

而且往往少量的prompt,就能输出下限很高的图片。

例如:

通过中心构图和全身视角展示了:上世纪50年代上海的富家太太们穿着传统的旗袍,优雅地摆出姿势,体现了当时的复古氛围和时代风貌。

Shanghai ladies in 1950s, posing elegantly, traditional cheongsams, neat buns, gentle smiles, black and white photo, vintage atmosphere, Shanghai street in 1950s, muted light, full body shot, centered composition,Vintage

MJ的创意性包括输出效果图中包含惊人的细节,这在Stable diffusion里是不可能的

Midjourney的高下限,使得它在创意启发上具备很强的优势。

同时Midjourney最新的V6[ALPHA]版本,又有了重磅更新:

第一,语义理解能力进一步加强,prompt已经可以使用自然语言的长句子,而不再是关键词短语和词汇,并且可以通过上下左右描绘位置了。这意味着Midjourney会逐渐远离Stable diffusion,而靠近ChatGPT。

一幅美丽的中世纪城市图画,位于白雪皑皑的平原上,夜晚星空灿烂,温暖的光线照耀着房屋“,”一座雄伟的宫殿,顶部有神圣的光芒,建筑物笔直“,”哑光绘画,4K,作者:Aaron Limonick,Armada,趋势

A beautiful picture of medieval city,located on a snowy plain,night with starry sky,warm light shone through houses",“one majestic palace, with a sacred light on the top,the buildings are straight”,"matte painting,4K,by Aaron Limonick,Armada,trending on Artstation

一个女孩骑着电动车在路上,两边都是花儿,路上有3D艺术品。泡泡玛特盲盒的风格,皮克斯动画的风格,3D渲染,8K中镜头正视图

A girl rides an electric scooter on the road with flowers on both sides and 3D artwork on the road. Bubble Mart blind box style, Pixar animation style, 3D rendering, 8K medium shot front view

虽然细节上依旧会存在相互串的问题,但相比纯关键词,可控度大大增强了,同时符合自然语言描述习惯的输入也使得效率提升。

第二,已经可以实现比较稳定文字(英文)输出,直出可用度显著增加了。

已经有很多大佬把字母/单词做在了物体表面,我手艺一般就举个牌儿好了:

但相比于Stable diffusion,已经属于有文字概念了。

另外MJ还有一个我很喜欢的功能是融图,也就是/blend。

这个功能可以又简单又快速得把A图的人物风格和B图的环境合而为一。

例如下面两张图:

Blend后得到融合了第一张图的环境+第二张图的人物服装和动作的新图:

不需要写任何一个提示词,单纯的上传两张图就可以。

再比如两张人物图:

Blend后得到了图1服装+图2人物的融合:

但尽管Midjourney已经可以通过自然语言进行一定程度的构图,但以它目前的准确率和细致程度,抽卡的成分仍然不可避免地有些高了。

(当然生成式AI产出内容的本质就是抽卡,这里只是说程度。)

这个时候Stable diffusion的优势就体现出来了。

Stable diffusion在可微调的局部重绘和ControlNet这两大法宝的加持下,对画面的掌控力要比Midjourney高多了。

ControlNet是Stable diffusion在现阶段对比其他AI绘画的杀手锏之一,很多人觉得它复杂,而且这一关确实也拦住了不少人,但其实大多只是未得其法。

比如融合文字,基本上都能学得会

不闲聊太多,再说回来。

还是上面的这张图:

如果我想用Midjourney复刻这张图,哪怕MJ也可以参考性垫图,难度依旧非常高。

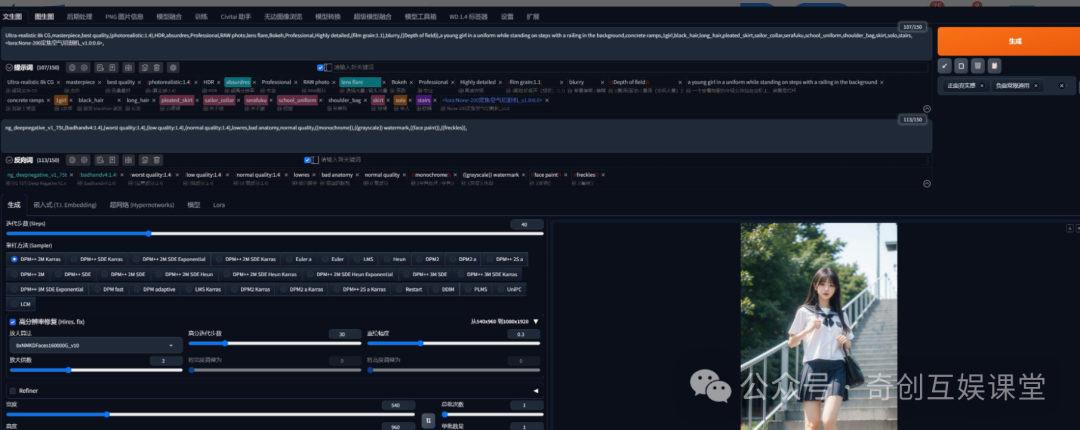

但如果用Stable diffusion,实现起来就不太难:

甚至如果你想的话,通过lora或者其他操作,修改人物,换掉脸,换个发型,换掉衣服,把人的身材定向调一下,把花的颜色定向调一下,都可以实现。

在这一刻,使用Stable diffusion的思路其实更接近于PhotoShop,而Midjourney,哪怕同样是重绘,思路还是更接近于GPT。

另外还有个一个有趣的事情,SD出的图再扔到MJ里blend,效果往往好于直接在MJ里面blend照片。

比如上面用SD复刻的这张图,加上下面这张同样是SD文生图的图片:

输入到MJ里面blend,会得到:

比前面直接blend的环境要跟原图更接近,而且还精细不少。

另外,Stable diffusion可以在原图的基础上,对人物身上的细节或者对环境进行定向重绘。

举例,比如下面一张原图:

我想让她显得更有钱一点,重绘之后,人物保持不变,环境中的物品产生变化:

所以Stable diffusion是可以融入Photoshop的工作流的,很多以往在Photoshop中比较吃力的操作,例如去除人物纹身的同时保持肤色,通过SD都可以提效。

至于Midjourney,AI摄影好像暂时跟它没啥关系。

而且作为开源软件,Stable diffusion可调整的细节远超Midjourney,底模型、采样算法、迭代步数、提示词整体权重以及每个提示词、反向提示词的权重、各种引导加入的时机,都是可以手动控制的。同时网上还可以下载到巨量的插件以及大神制作好的资源,扩展性要比MJ高的多(但反过来就是最开始说的稳定的问题)。

更不要说Stable diffusion最强的一点是可以私炉炼丹。只要妹子给我足够数量的自拍照,我就是她的妙鸭相机plus。Midjourney可做不到这个。

不过你要说谁更强,我觉得也得分情况来看。

Midjourney的好处是不需要本地部署,对配置没要求,出图的下限高,不用太复杂的操作也能出来像模像样的图,而且足够标准化,自然语言理解能力进一步强化之后使用门槛更低,更适合应用在创意生产力。

Stable diffusion好处是开源免费,扩展丰富(ChatGPT插件、自动翻译插件等等让易用性也大幅度提高),定制化极强,可控度更高(如果用ComfyUI还要更更高),适合需要对画面有一定掌控的图片输出,或者是进行后期处理

写在最后

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

若有侵权,请联系删除

若有侵权,请联系删除

968

968

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?