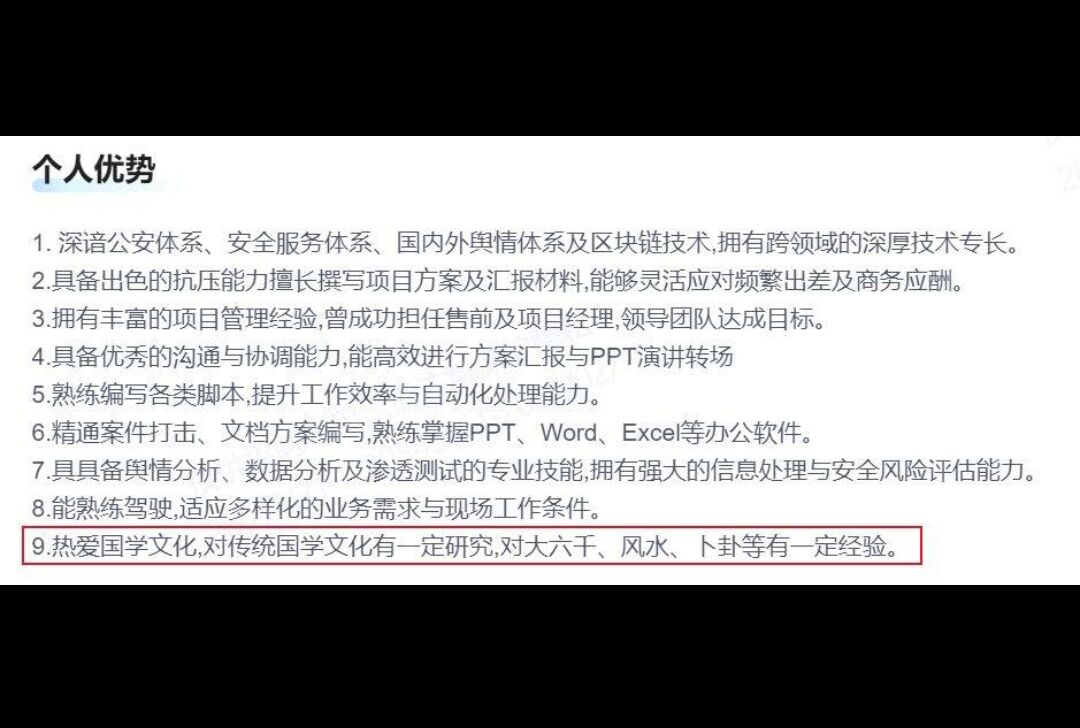

最近在一个信息安全交流频道中,大佬们关于职业发展的讨论热火朝天。其中一张简历截图引发了我的注意,在个人优势部分,赫然写着"热爱国学文化,对传统国学文化有一定研究,对大六壬、风水、卜卦有实践经验"。这个跨界组合让我颇为震惊,原来IT行业的技能树已经延伸到如此多元的领域,不禁感叹行业竞争之激烈。

出于对国学文化的好奇,我尝试在网上搜索相关内容。在浏览过程中,一个"在线测算"类网站引起了我的兴趣。通过观察发现,该网站的URL设计存在规律:输入不同的出生年月日、时辰和性别信息,对应的链接会按照特定规则变化。例如,查询1999年3月6日17-19时出生的男士信息,链接为 http://example.com/fx/1999-03-06/mfsmm-9-1.html ;而相同时间出生的女士,链接则变为 http://example.com/fx/1999-03-06/mfsmm-9-2.html 。

这种规律性的URL结构激发了我的技术探索欲。如果通过编程实现自动化数据获取,会是怎样的体验?带着这个想法,我开始尝试编写Python爬虫程序。

import requests

from datetime import datetime

from bs4 import BeautifulSoup

# 获取用户输入信息

def get_user_input():

year = int(input("请输入出生年份(如1990):"))

month = int(input("请输入出生月份(1-12):"))

day = int(input("请输入出生日期(1-31):"))

time_code = int(input("请输入出生时辰(1-12,每个时辰对应2小时):"))

gender = int(input("请输入性别(1表示男,2表示女):"))

return year, month, day, time_code, gender

# 格式化时辰显示

def format_time_code(time_code):

time_map = {

1: "01:00-03:00", 2: "03:00-05:00", 3: "05:00-07:00",

4: "07:00-09:00", 5: "09:00-11:00", 6: "11:00-13:00",

7: "13:00-15:00", 8: "15:00-17:00", 9: "17:00-19:00",

10: "19:00-21:00", 11: "21:00-23:00", 12: "23:00-01:00"

}

return time_map.get(time_code, "未知时辰")

# 主程序逻辑

def main():

year, month, day, time_code, gender = get_user_input()

# 输入数据有效性验证

if not (1930 <= year <= 2999 and 1 <= month <= 12 and 1 <= day <= 31 and 1 <= time_code <= 12 and gender in [1, 2]):

print("输入无效,请检查输入的年份、月份、日期、时辰和性别是否正确。")

return

date_str = datetime(year, month, day).strftime("%Y-%m-%d")

formatted_date = datetime(year, month, day).strftime("%Y年%m月%d日")

formatted_time = format_time_code(time_code)

gender_str = "男" if gender == 1 else "女"

url = f"http://example.com/fx/{date_str}/szxx-{gender}-2.html?t={time_code}"

try:

response = requests.get(url)

response.raise_for_status()

soup = BeautifulSoup(response.text, "html.parser")

key_points = []

for item in soup.find_all("blockquote", class_="layui-elem-quote"):

key_points.append(item.get_text(strip=True))

for item in soup.find_all("table", class_="layui-table"):

rows = item.find_all("tr")

for row in rows:

cols = row.find_all("td")

if cols:

key_points.append(" | ".join([col.get_text(strip=True) for col in cols]))

print("\n" + "=" * 80)

print(f"查询结果:")

print(f"出生日期:{formatted_date}")

print(f"出生时辰:{formatted_time}")

print(f"性别:{gender_str}")

print("-" * 80)

if key_points:

for point in key_points:

print(point)

else:

print("未找到相关内容。")

print("=" * 80)

backup = input("是否需要将数据备份到文件中?(y/n): ").strip().lower()

if backup == 'y':

file_name = f"{year}{month:02d}{day:02d}_{time_code:02d}_{gender}.txt"

with open(file_name, "w", encoding="utf-8") as f:

f.write(f"查询结果:\n")

f.write(f"出生日期:{formatted_date}\n")

f.write(f"出生时辰:{formatted_time}\n")

f.write(f"性别:{gender_str}\n")

f.write("-" * 80 + "\n")

if key_points:

for point in key_points:

f.write(point + "\n")

else:

f.write("未找到相关内容。\n")

print(f"数据已备份到文件:{file_name}")

except requests.RequestException as e:

print(f"处理 {url} 时出错:{e}")

print("任务已完成。")

if __name__ == "__main__":

main()

通过这个小项目,我不仅实践了Python爬虫的基本开发流程,还加深了对网络数据规律的理解。当然,需要特别强调的是,网络数据爬取必须在合法合规的前提下进行。为避免违规风险,给出以下建议:

1. 明确网站规则:爬取前务必查看网站的 robots.txt 协议,确认哪些内容允许抓取;若网站有明确禁止爬取声明,应立即停止操作。

2. 遵守法律法规:未经授权抓取用户个人信息、商业数据等敏感内容,可能触犯《网络安全法》《个人信息保护法》等,切勿用于商业牟利或恶意用途。

3. 控制抓取频率:避免对目标网站发起高频请求,防止影响其正常服务,可设置延时(如 time.sleep(3) )或使用代理IP分散请求压力。

4. 仅作学习用途:若代码仅为技术练习,建议将数据限制在少量样本,且不公开、不传播爬取内容,确保探索行为的合法性。

这次有趣的经历也让我意识到,生活中的许多现象都蕴含着技术探索的可能。后续我还将分享另一种基于国学文化的趣味技术实践,欢迎持续关注!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?