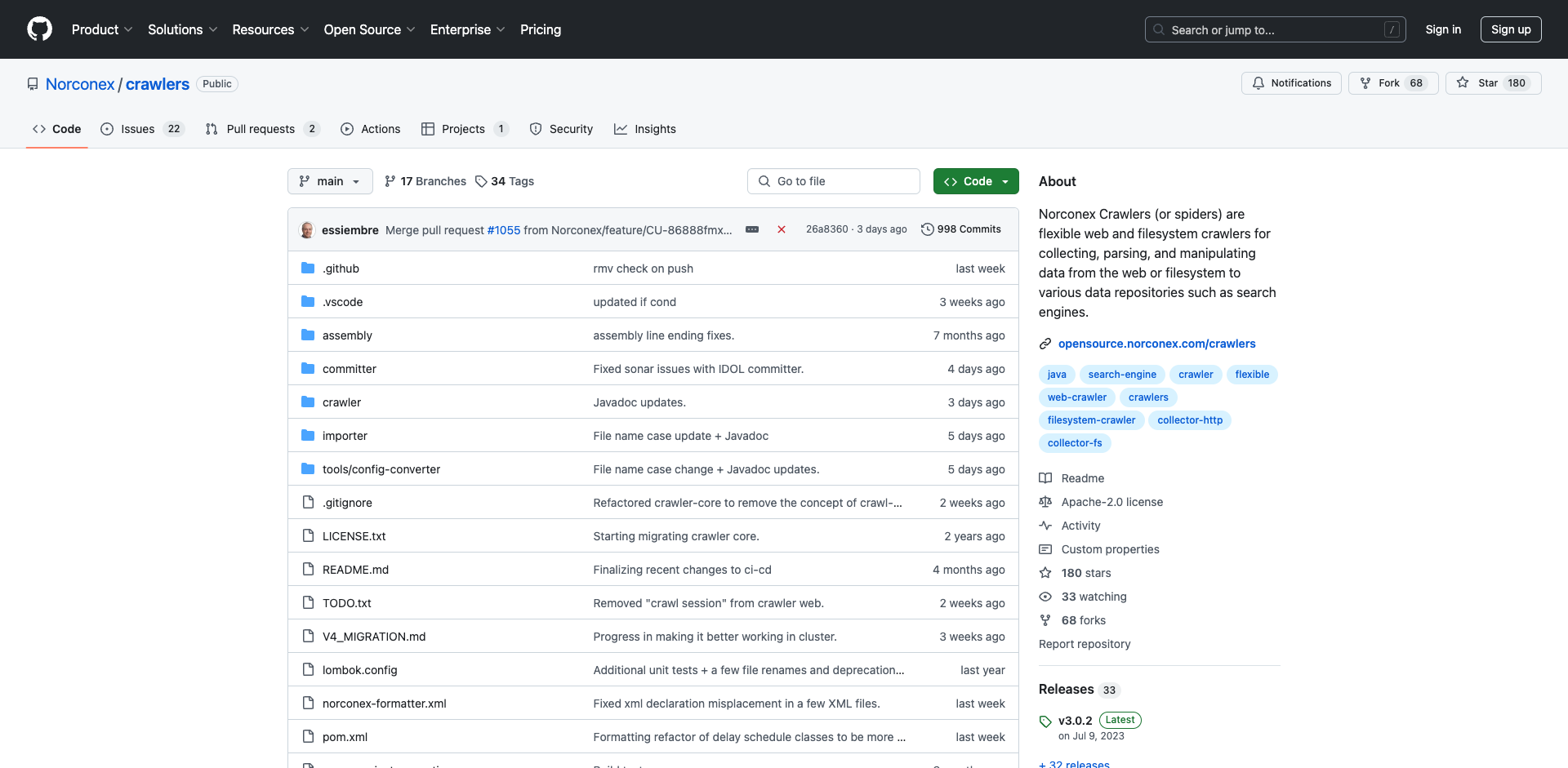

Norconex Crawlers简介

Norconex Crawlers是一套功能强大且灵活的网络和文件系统爬虫工具,专为收集、解析和操作来自网络或文件系统的数据而设计。这套工具可以将收集到的数据存储到用户选择的各种数据仓库中,例如搜索引擎。Norconex Crawlers以其灵活性、强大功能、易于扩展和可移植性而闻名,可以在任何操作系统上通过命令行和基于文件的配置使用,也可以通过文档完善的API嵌入到Java应用程序中。

Norconex Crawlers的主要特点

- 功能全面:支持网络爬虫和文件系统爬虫

- 灵活性高:可以根据用户需求进行定制和配置

- 易于扩展:提供了丰富的API,方便开发者进行二次开发

- 可移植性强:可在各种操作系统上运行

- 使用方便:支持命令行操作和基于文件的配置

- 文档完善:提供详细的使用文档和API文档

Norconex Crawlers的项目结构

Norconex Crawlers是一个包含多个子项目的mono-repo,所有相关的爬虫项目都被整合在一起。这种结构使得项目的管理和发布更加统一和高效。以下是Norconex Crawlers的主要子项目:

- nx-crawler-core:爬虫核心模块

- nx-crawler-fs:文件系统爬虫模块

- nx-crawler-web:网络爬虫模块

- nx-importer:数据导入模块

- nx-committer-*:各种数据提交器模块,如Amazon CloudSearch、Apache Kafka、Azure Cognitive Search等

每个子项目都有其特定的功能和用途,共同构成了Norconex Crawlers的完整生态系统。

Norconex Crawlers的使用方法

1. 安装和配置

要使用Norconex Crawlers,首先需要从官方网站下载最新的稳定版本。目前,最新的稳定版本是3.x版本。您可以通过以下链接获取:

下载完成后,根据您的操作系统和需求进行安装和配置。Norconex Crawlers支持多种运行方式,包括命令行和API调用。

2. 创建爬虫配置

Norconex Crawlers使用基于XML的配置文件来定义爬虫的行为。以下是一个简单的网络爬虫配置示例:

<?xml version="1.0" encoding="UTF-8"?>

<collector id="MyCollector">

<crawlerDefaults>

<startURLs>

<url>https://www.example.com</url>

</startURLs>

</crawlerDefaults>

<crawler id="MyCrawler">

<documentFilters>

<filter class="com.norconex.crawler.core.filter.impl.RegexReferenceFilter"

onMatch="include" caseSensitive="false">

https://www\.example\.com/.*

</filter>

</documentFilters>

</crawler>

</collector>

这个配置文件定义了一个简单的网络爬虫,它从https://www.example.com开始爬取,并只包含匹配指定正则表达式的URL。

3. 运行爬虫

配置完成后,您可以通过命令行运行爬虫。例如:

java -jar norconex-crawler.jar -c /path/to/config.xml

这将启动爬虫,并根据配置文件中的设置开始爬取过程。

4. 数据处理和存储

Norconex Crawlers提供了多种数据处理和存储选项。您可以使用内置的导入器(Importer)来解析和处理爬取到的数据,然后使用各种提交器(Committer)将数据存储到不同的目标系统中,如Elasticsearch、Solr、SQL数据库等。

例如,要将爬取的数据存储到Elasticsearch中,您可以在配置文件中添加以下内容:

<committer class="com.norconex.committer.elasticsearch.ElasticsearchCommitter">

<indexName>my_index</indexName>

<typeName>my_type</typeName>

<elasticsearch>

<nodes>

<node>http://localhost:9200</node>

</nodes>

</elasticsearch>

</committer>

Norconex Crawlers的高级功能

1. 自定义过滤器

Norconex Crawlers允许用户创建自定义过滤器来控制爬取过程。您可以基于URL、内容类型、文档大小等条件来过滤文档。例如:

<documentFilters>

<filter class="com.norconex.crawler.core.filter.impl.ExtensionReferenceFilter"

onMatch="exclude">

pdf,doc,docx

</filter>

</documentFilters>

这个过滤器将排除所有PDF和Word文档。

2. 多线程爬取

为了提高爬取效率,Norconex Crawlers支持多线程爬取。您可以在配置文件中设置线程数:

<crawler id="MyCrawler">

<numThreads>5</numThreads>

</crawler>

3. 爬取延迟和礼貌性设置

为了避免对目标网站造成过大压力,Norconex Crawlers提供了爬取延迟和礼貌性设置:

<crawler id="MyCrawler">

<delay default="5000" />

<robotsTxt ignore="false" />

</crawler>

这个配置设置了5秒的默认爬取延迟,并遵守robots.txt规则。

4. 数据提取和转换

Norconex Crawlers的导入器模块提供了强大的数据提取和转换功能。您可以使用XPath、正则表达式或CSS选择器来提取特定的数据:

<importer>

<postParseHandlers>

<handler class="com.norconex.importer.handler.tagger.impl.XPathTagger">

<xpath expression="//meta[@name='description']/@content" name="meta-description" />

</handler>

</postParseHandlers>

</importer>

这个配置将从HTML文档中提取meta description并将其存储为meta-description字段。

Norconex Crawlers的未来发展

Norconex Crawlers团队正在积极开发第4版,这将带来更多新特性和改进。第4版的开发代码目前存放在main分支中,但尚未正式发布。开发者和用户可以期待以下方面的改进:

- 性能优化:提高爬取和处理速度

- 更好的可扩展性:更容易集成自定义模块

- 增强的数据处理能力:支持更复杂的数据转换和清洗操作

- 改进的用户界面:可能会提供更友好的配置和监控界面

- 更广泛的集成支持:与更多的数据存储和分析平台集成

结论

Norconex Crawlers是一套功能强大、灵活性高的网络和文件系统爬虫工具。它不仅适用于简单的数据收集任务,也能够处理复杂的企业级爬取需求。通过其丰富的配置选项和可扩展的架构,用户可以根据自己的需求定制爬取过程,并将数据无缝集成到各种存储和分析系统中。

无论您是需要进行网站内容索引、数据挖掘还是内容管理,Norconex Crawlers都能为您提供可靠的解决方案。随着第4版的开发和即将发布,我们可以期待这个强大的工具集会变得更加完善和易用。

如果您正在寻找一个功能全面、可定制且易于使用的爬虫解决方案,Norconex Crawlers绝对值得一试。您可以访问Norconex Crawlers的GitHub仓库了解更多信息,或查看官方文档获取详细的使用指南。

无论您是初学者还是经验丰富的开发者,Norconex Crawlers都能为您的数据收集和处理需求提供有力支持。立即开始使用Norconex Crawlers,探索其强大功能,为您的项目增添新的维度!🚀🕷️💻

项目链接:www.dongaigc.com/a/norconex-crawlers-powerful-flexible-web-crawler-tool

https://www.dongaigc.com/a/norconex-crawlers-powerful-flexible-web-crawler-tool

916

916

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?