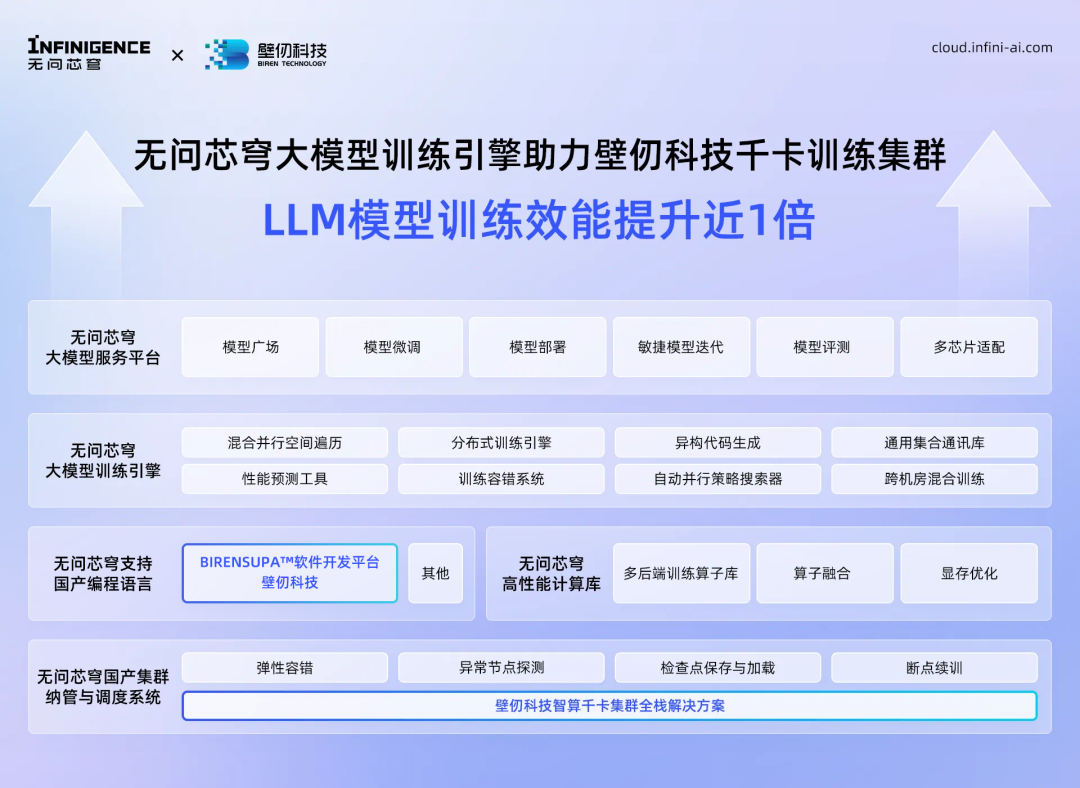

本周,无问芯穹联合壁仞科技在千卡训练集群领域取得技术新突破。基于壁仞科技GPU千卡训练集群,结合无问芯穹大模型训练引擎与壁仞科技BIRENSUPA软件工具链,持续深挖壁仞大算力优势,协力实现了集群训练性能快速优化,成功在壁仞科技GPU集群上,将大语言模型(LLM)训练效能提升近1倍。

无问芯穹大模型训练引擎,面向国产集群大规模并行训练性能优化的场景,以公有云平台训练镜像的方式或私有化部署的模式提供服务,可大幅缩短训练时长、提升集群利用率,该引擎支持主流模型结构,兼容多元硬件集群,具备迁移便利、优化快速等优势。在壁仞GPU千卡集群中,无问芯穹大模型训练引擎助力集群实现性能快速提升,结合壁仞科技BIRENSUPA软件工具链,将LLM模型训练效能提升了近1倍。目前,壁仞科技的千卡规模训练集群已成功在无问芯穹Infini-AI异构云平台(cloud.infini-ai.com)上纳管和调度,实现并完整验证了弹性容错、异常节点探测、检查点保存与加载、断点续训四大功能。

此外,壁仞科技的“壁砺106系列”和“壁砺110系列”GPU产品已完成与无问芯穹Infini-AI异构云平台的全面接入。其中,壁仞科技最新发布的高性能、低功耗壁砺110E推理卡也已在Infini-AI异构云平台的大模型服务平台上线。官方数据显示,在大模型推理服务方面,壁砺110E推理卡具有高性能、低功耗的优秀特性,在同机架高度下,AI算力密度最高可达到市场主流云端PCIE8卡服务器方案的1.3倍以上,能耗节省达70%,可显著降低整体系统的总拥有成本(Total Cost of Ownership, TCO)。

(https://cloud.infini-ai.com/genstudio/experience)

无问芯穹大模型服务平台基于异构推理加速,为大模型应用开发者提供数据处理、微调、推理等快速便捷的模型调用API,现已上架包括CogVideoX 2B、Llama 3.1 70B、Qwen2 72B、GLM4 9B、Stable Diffusion在内的多种大语言模型、文生图及文生视频模型。当前,通过无问芯穹大模型服务平台调用各种开放API的同时,也已可调用壁砺110E推理卡,支持各种大语言模型、多模态模型的云上推理,为商业级用户业务提供充沛的算力支撑。

凭借长期在多元异构算力激活以及软硬件联合优化等方面的专业深耕,无问芯穹打造了连接“M种模型”和“N种芯片”的“MxN”AI基础设施新范式,已实现多种大模型算法在多元芯片上的高效协同部署,在国产算力集群效能提升技术上积累了显著优势。2024年3月,无问芯穹首次发布了能够支持多种模型在多种芯片上高效推理的异构云平台Infini-AI。今年7月,无问芯穹Infini-AI异构云平台又成为了全球首个支持单任务千卡规模异构芯片混合训练的平台,具备万卡扩展性,支持包括AMD、华为昇腾、天数智芯、沐曦、摩尔线程、NVIDIA六种芯片在内的大模型混训,可一键发起700亿参数大模型训练。

此次无问芯穹与壁仞科技在壁仞千卡训练集群上联合攻关,取得了近1倍的效能提升,是国产算力生态共建进程中的一座重要里程碑。未来,无问芯穹将与壁仞科技继续携手,在大规模自主可控智能算力集群优化与运营等方面深化合作,进一步提升面向商业化算力客户场景的联合服务能力。

壁仞科技

作为国内领先的GPU芯片厂商,壁仞科技秉承“担当、卓越、协作、创新、务实、共赢”的价值观,不断提升技术竞争力,并与合作伙伴携手,从实际用户需求出发,致力于打造性能卓越且具有高性价比的国产AI训练集群方案。

无问芯穹

无问芯穹(Infinigence AI)作为国内领先的AI基础设施企业,致力于成为大模型时代首选的算力运营商。依托“多元异构、软硬协同”的核心技术优势,打造了连接“M种模型”和“N种芯片”的“MxN”AI基础设施新范式,实现多种大模型算法在多元芯片上的高效协同部署。无问芯穹Infini-AI异构云平台基于多元芯片算力底座,向大模型开发者提供极致性价比的高性能算力和原生工具链,为大模型从开发到部署的全生命流程降本增效。

无问芯穹以“释放无穹算力,让AGI触手可及”为使命,通过不断的技术创新实现普惠AI,让算力成本实现万倍下降,如同水电煤一般为千行百业注入新质生产力。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?