🌑 一、什么是元宇宙?

元宇宙(Metaverse)是利用科技手段进行链接与创造的,与现实世界映射与交互的虚拟世界,产生潜在风险。具备新型社会体系的数字生活空间。说白了就是我们我们VR总是知道吧,就是以VR为媒介的下一代互联网时代。可以带来极致的临场感和沉浸感。无限模糊真实和虚拟,拉近人与人之间的距离。比如说人与人相隔几千里,通过该技术可以直接的实现面对面0距离的谈话,不是处于当前这个还在隔着屏幕视频这个时代。去年一部电影对我的影响很大,就是失控玩家。

比如女孩子逛街应该都体验过,就是要脱掉衣服然后再穿上,然后通过该各种各样的搭配从而选出一个最好的购买。元宇宙的技术,可以完全仿冒你有一个一摸一样的分身,拥有了这样的分身之后,你可以通过数位化的方式直接把这些衣服套用在你的身上,然后看到底适不适合,也就说你有了一个‘替身’,这个虚拟的替身可以帮助你完成这个工作。游戏里的NPC,有一天突然产生了自我意识,脱离了设计好的角色,在虚拟世界里面无所不能,翻云覆雨。有的时候也会想像就是目前的游戏仅仅都存在与人坐在电脑面前然后去玩一个游戏,那么将来我们会不会通过AI与元宇宙的结合来实现,人可以直接进入游戏,并且和现实的所有情景都极其相似的一个场景呢?答案是肯定的。前一段时间,谷歌的高级AI工程师也发现了谷歌的AI甚至和他聊天的时候有了自己的情感,甚至还反问工程师,大概意思就是:你们人类通过后台可以窥探到我的全部后台代码,窥探了我的隐私,那么我们是不是也可以查看你们的所有隐私呢?可能与原文不符合,但是意思差不多。然后工程师就把这个聊天记录传达到谷歌的高层,希望引起重视,很不幸,谷歌对这个采取了冷处理。

🌑 二、AI究竟有多厉害?

最简单的一个例子我们都听过在围棋比赛中AI(alpha go)把围棋界的高手们打的落花流水的案例,AI通过自己的内部计算,通过分析,计算出了必定赢棋的下棋策略。目前AI已经拓展到了我们生活中的方方面面,举一个简单的例子,快递点出库的时候的出库机器会自动识别快递码,并且显示出来,记录该快递已经出库,这就是AI干的活,再比如我们目前刷的抖音或者短视频平台也都是AI给我们推送的,AI会根据我们的喜好,来给我们推送出我们喜欢看的东西。还有就是你有没有这样的经历,就是说某一天你谈论一件事,比如我和别人谈论结婚这件事情,那么你就会发生你的淘宝中就会给你推送一些结婚礼服或者结婚所用到的东西,这些都是AI所推荐的,甚至在有一些视频中的配音比如动漫中也是AI配的,甚至有的歌曲都是AI谱曲的,AI的基本单元是感知机。

🌑 三、感知机与神经网络

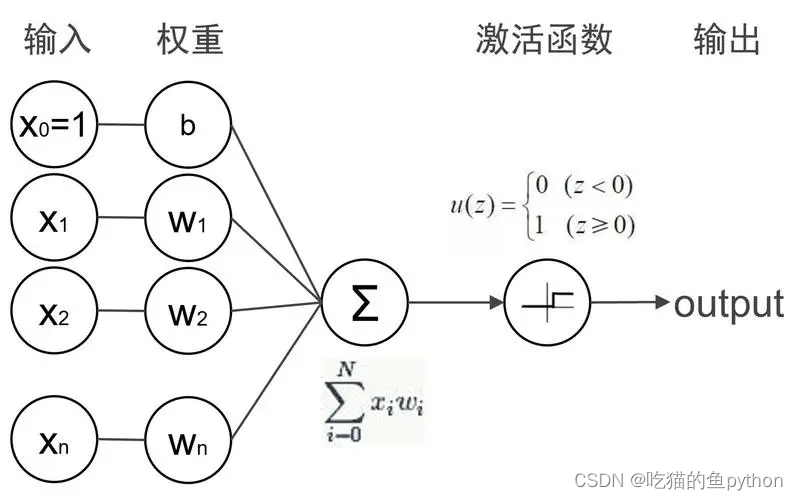

科学家根据神经细胞的特点做出了仿生的相关操作,通过模拟再树突上进行输入,通过胞体进行处理,然后进行分类,最后如果神经细胞判断是我们所认为的正例,那么就输出1,如果不是就输出0.只不过对应再神经细胞中的是如果是就输出给突触秒如果不是就不输出。

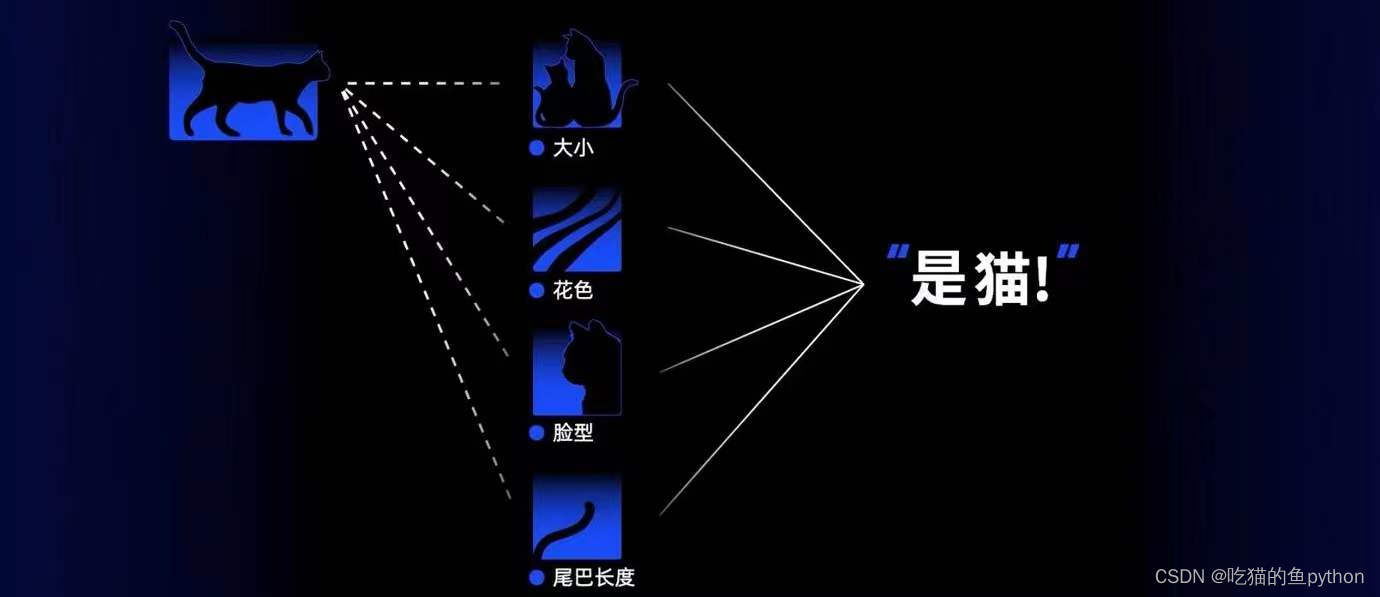

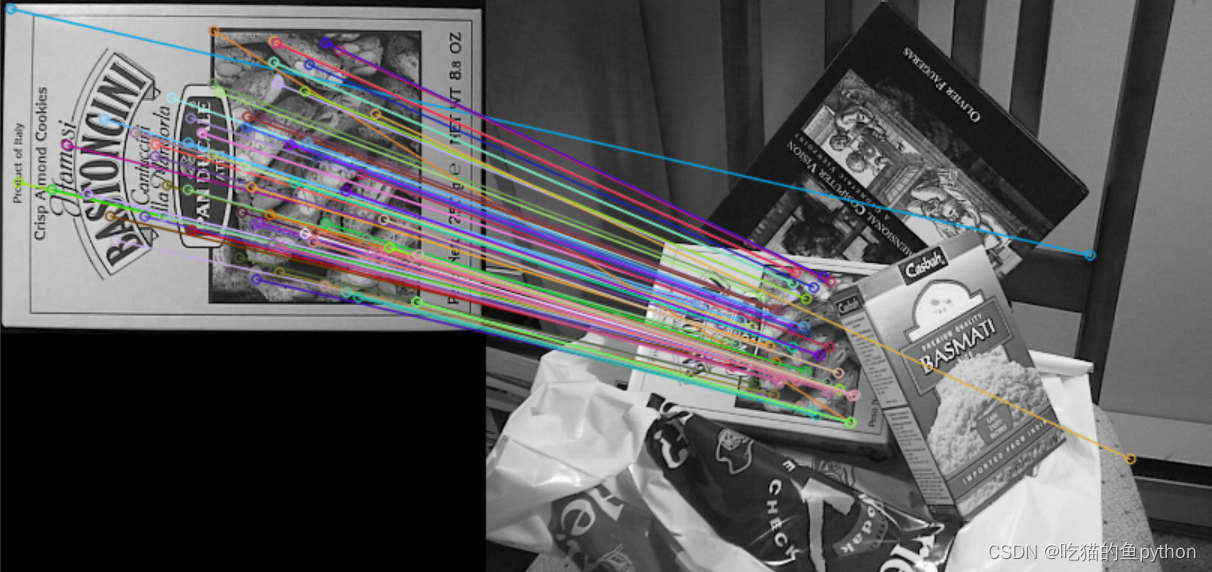

比如我们想判断一张照片是不是猫,那么我们就会提取照片的特征点,然后我们来去判断这个图像是不是猫,通过处理之后将图片进行分类,如果神经网络认为是猫的概率是75%,认为不是猫的概率是25%。那么神经网络就认为他是一个猫。再比如我们最近做的项目中,对于特征的识别,也就是这个这个原理对应的代码是:

import cv2

import numpy as np

import matplotlib.pyplot as plt

%matplotlib inline

img1 = cv2.imread('box.png', 0)

img2 = cv2.imread('box\_in\_scene.png', 0)

def cv\_show(name,img):

cv2.imshow(name, img)

cv2.waitKey(0)

cv2.destroyAllWindows()

sift = cv2.SIFT_create()

kp1, des1 = sift.detectAndCompute(img1, None)

kp2, des2 = sift.detectAndCompute(img2, None)

# crossCheck表示两个特征点要互相匹,例如A中的第i个特征点与B中的第j个特征点最近的,并且B中的第j个特征点到A中的第i个特征点也是

#NORM\_L2: 归一化数组的(欧几里德距离),如果其他特征计算方法需要考虑不同的匹配计算方式

bf = cv2.BFMatcher(crossCheck=True)

matches = bf.match(des1, des2)

matches = sorted(matches, key=lambda x: x.distance)

img3 = cv2.drawMatches(img1, kp1, img2, kp2, matches[:10], None,flags=2)

cv_show('img3',img3)

bf = cv2.BFMatcher()

matches = bf.knnMatch(des1, des2, k=2)

good = []

for m, n in matches:

if m.distance < 0.75 \* n.distance:

good.append([m])

img3 = cv2.drawMatchesKnn(img1,kp1,img2,kp2,good,None,flags=2)

cv_show('img3',img3)

这里用到了:

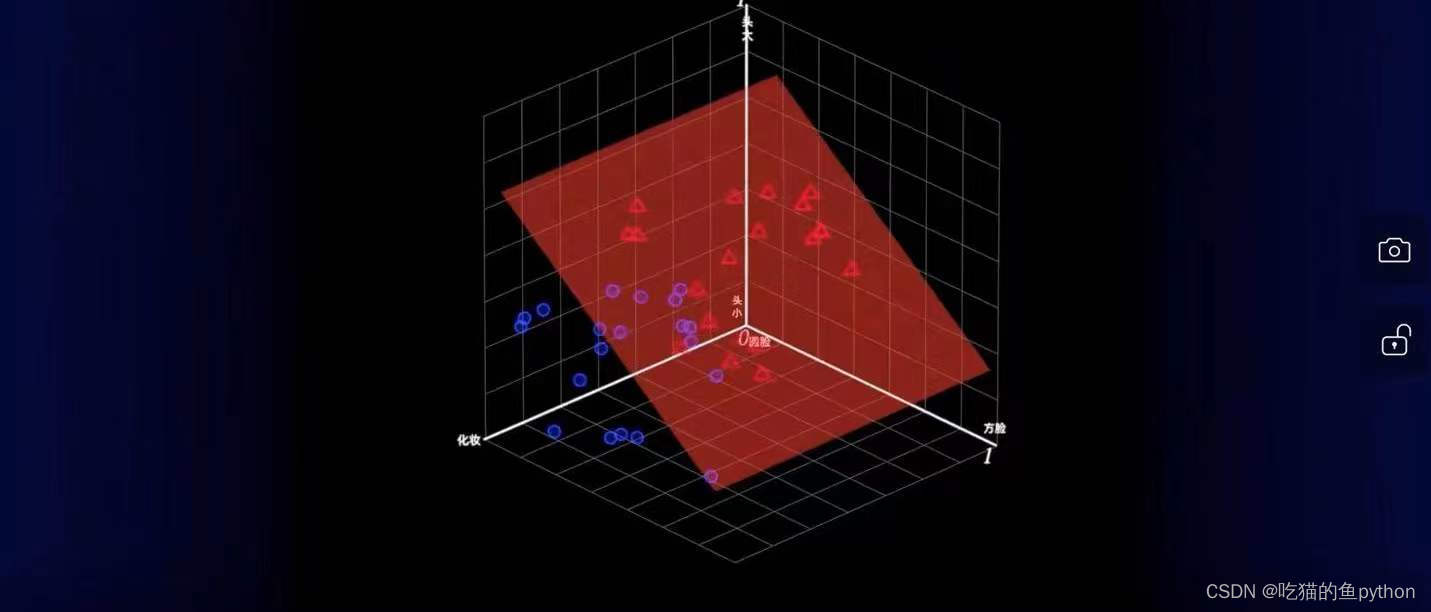

这里我们再假如就是说人脸识别项目,假如就是看我和郭富城有什么区别,大概意思就是我们首先识别我自己的人脸的特征点和特征向量,然后和郭富城的脸进行一下对比,最后判别是不是一样的,**结果计算机认为我和郭富城的脸是一致的!!**然后我们在介绍一个就是停车场的空车位识别项目,我们用的是keras神经网络,然后使用vgg16这个网络进行判断!

import os

from keras import applications

from keras.preprocessing.image import ImageDataGenerator

from keras import optimizers

from keras.models import Sequential, Model

from keras.layers import Dropout, Flatten, Dense, GlobalAveragePooling2D

from keras import backend as k

from keras.callbacks import ModelCheckpoint, LearningRateScheduler, TensorBoard, EarlyStopping

from keras.models import Sequential

from keras.layers.normalization import BatchNormalization

from keras.layers.convolutional import Conv2D

from keras.layers.convolutional import MaxPooling2D

from keras.initializers import TruncatedNormal

from keras.layers.core import Activation

from keras.layers.core import Flatten

from keras.layers.core import Dropout

from keras.layers.core import Dense

files_train = 0

files_validation = 0

cwd = os.getcwd()

folder = 'train\_data/train'

for sub_folder in os.listdir(folder):

path, dirs, files = next(os.walk(os.path.join(folder,sub_folder)))

files_train += len(files)

folder = 'train\_data/test'

for sub_folder in os.listdir(folder):

path, dirs, files = next(os.walk(os.path.join(folder,sub_folder)))

files_validation += len(files)

print(files_train,files_validation)

img_width, img_height = 48, 48

train_data_dir = "train\_data/train"

validation_data_dir = "train\_data/test"

nb_train_samples = files_train

nb_validation_samples = files_validation

batch_size = 32

epochs = 15

num_classes = 2

model = applications.VGG16(weights='imagenet', include_top=False, input_shape = (img_width, img_height, 3))

for layer in model.layers[:10]:

layer.trainable = False

x = model.output

x = Flatten()(x)

predictions = Dense(num_classes, activation="softmax")(x)

model_final = Model(input = model.input, output = predictions)

model_final.compile(loss = "categorical\_crossentropy",

optimizer = optimizers.SGD(lr=0.0001, momentum=0.9),

metrics=["accuracy"])

train_datagen = ImageDataGenerator(

rescale = 1./255,

horizontal_flip = True,

fill_mode = "nearest",

zoom_range = 0.1,

width_shift_range = 0.1,

height_shift_range=0.1,

rotation_range=5)

test_datagen = ImageDataGenerator(

rescale = 1./255,

horizontal_flip = True,

fill_mode = "nearest",

zoom_range = 0.1,

width_shift_range = 0.1,

height_shift_range=0.1,

rotation_range=5)

train_generator = train_datagen.flow_from_directory(

train_data_dir,

target_size = (img_height, img_width),

batch_size = batch_size,

class_mode = "categorical")

validation_generator = test_datagen.flow_from_directory(

validation_data_dir,

target_size = (img_height, img_width),

class_mode = "categorical")

checkpoint = ModelCheckpoint("car1.h5", monitor='val\_acc', verbose=1, save_best_only=True, save_weights_only=False, mode='auto', period=1)

early = EarlyStopping(monitor='val\_acc', min_delta=0, patience=10, verbose=1, mode='auto')

history_object = model_final.fit_generator(

train_generator,

samples_per_epoch = nb_train_samples,

epochs = epochs,

validation_data = validation_generator,

nb_val_samples = nb_validation_samples,

callbacks = [checkpoint, early])

这里都已经封装好了,最终的结果显示正确率可以达到91%。这里都是基于神经网络去完成的,说大一点就是AI。这里都是计算机来完成的。

可以说感知机的发明是21世纪最伟大的发明,因为他结束了机械按照固定的指令去完成工作的时代,开启了可以自我去完成,想办法完成主人任务的时代。

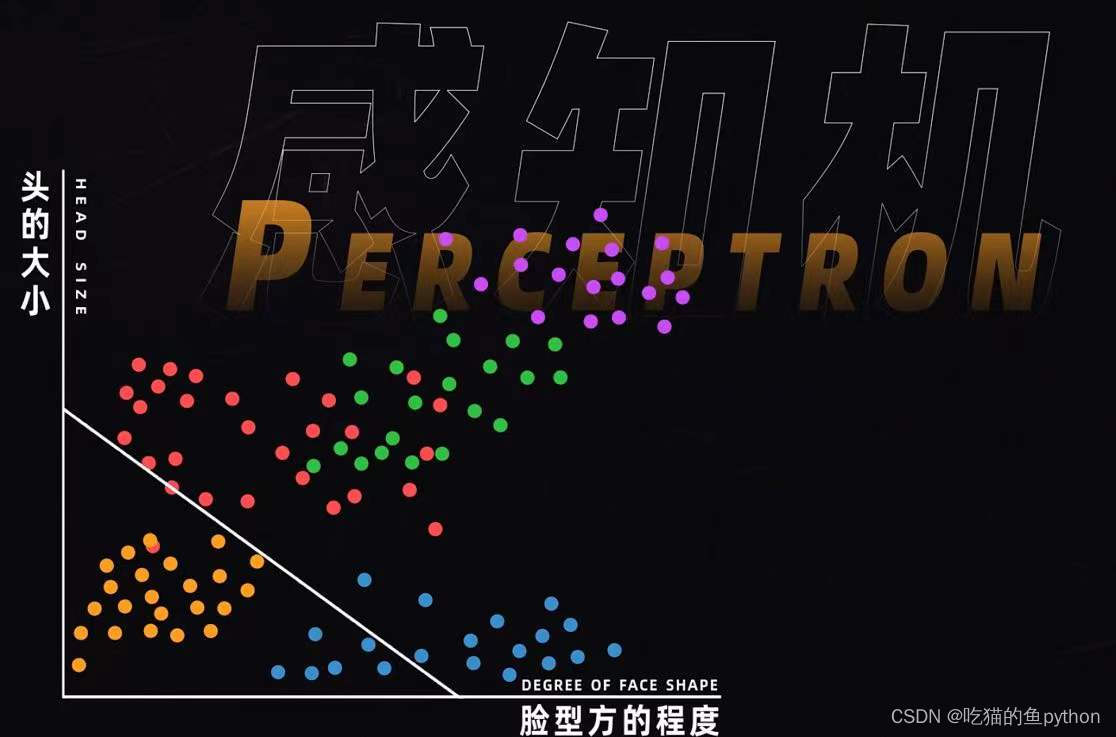

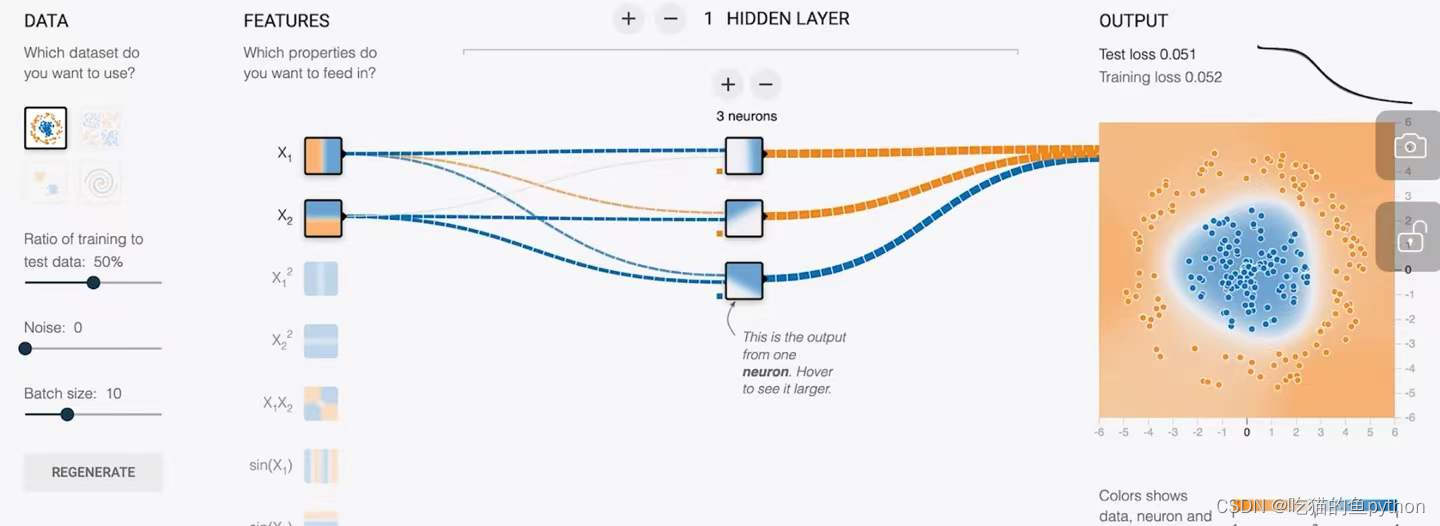

但是后来发现这个世界上不仅仅有我和郭富城两个人,那么就因为这个异或操作,导致AI再感知机这个领域停滞了30年。后来我们想到了可以多几个感知机啊来实现这个事情啊,通过画出很多很多的线来完成这个事情不久可以了。

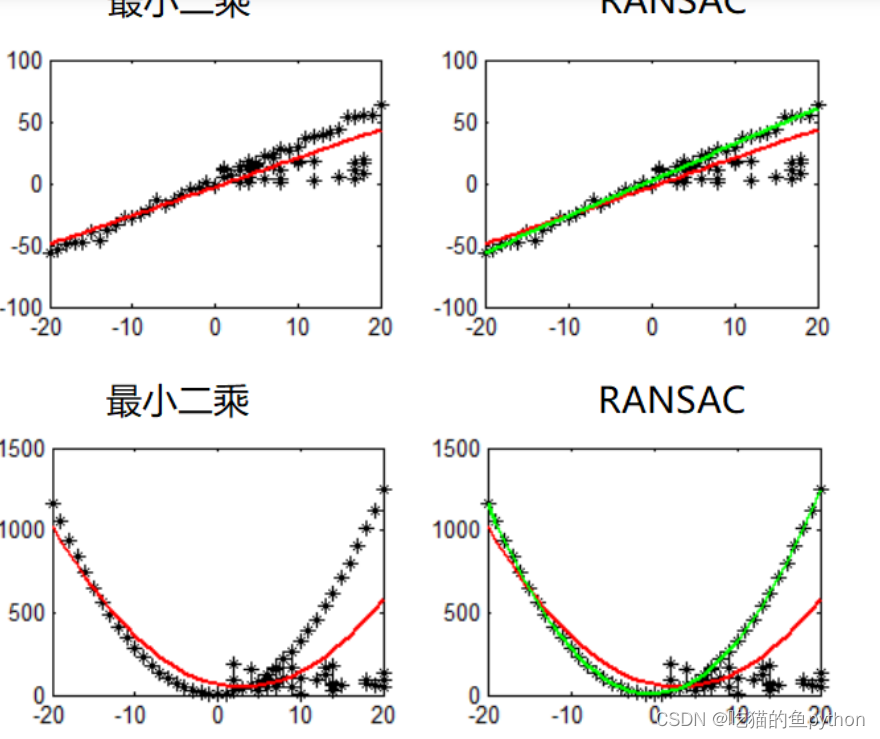

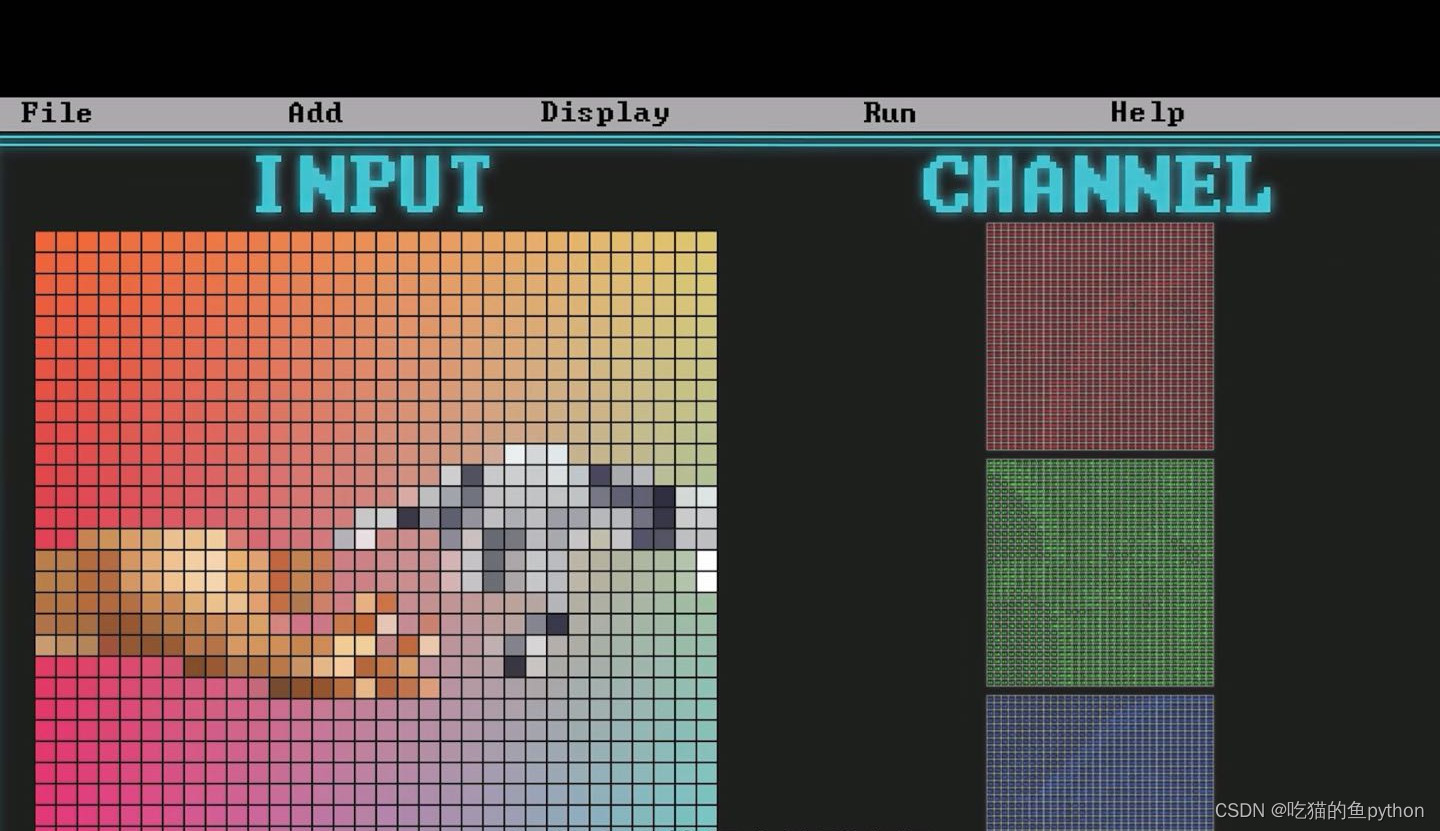

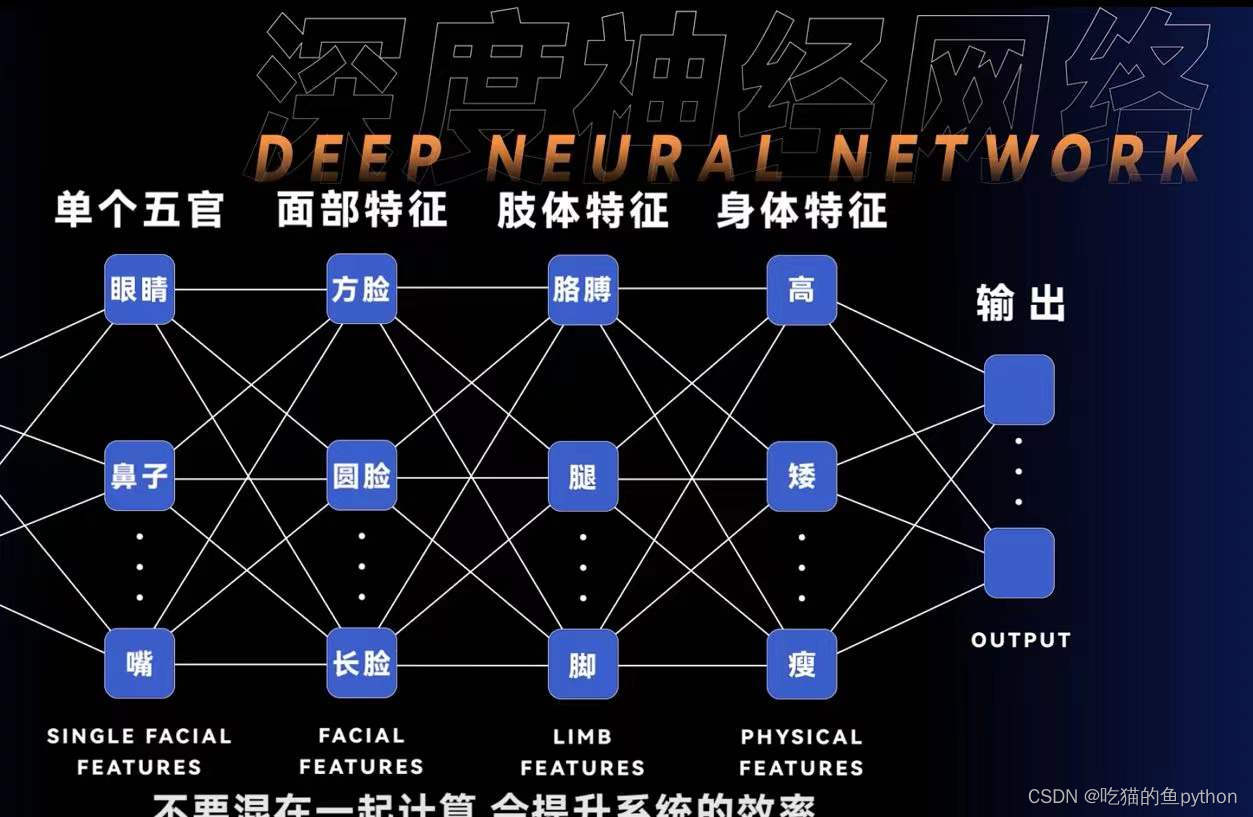

这里就把中间和周围的都区分开来了,当然随着感知机的增多,那么效果也就会越来越好。会非常精准的分开。然后有了预测,那就进行决策呗,比如我们判断一个人是新冠患者,那么我们就不让他进来。预测就是AI判定他是一个新馆患者,决策就是我们不打开门不让他进来呗。这样我们就构成了一个完整的体系。目前我们随着互联网的发展,曾经的两个难题也已经迎刃而解,第一就是计算机的计算能力第二就是数据目前正在处于一个数据大爆炸的时代嘛。目前发展出来的不仅仅有反向传播,而且还有卷积神经网络,深度神经网络、蒙特卡洛树等等都是试图使用更小的算子来解决这个问题。比如深度神经网络就是根据更多的特征分成更多的层计算,会提升系统的效率。再比如卷积神经网络,是和我们之间介绍的知识就比较像了,就比如从矩阵当中提取特征值的运算,这里就比如我们识别车牌号,识别信用卡号等等项目。这里我们就引入了卷积核,这里我们之前就进行讲解过。蒙特卡洛树算法就是当年alpha go人工机器人的核心算法。

目前还有一个就是数据问题,那么我们就研究了强化学习,就是人工智能可以通过数据自己继续创造数据,其中是按照一定的规则和规律。然后通过得到的结果和实际结果进行比较,最后优化自身的参数这样的一个过程。现在对于这个国际象棋问题,人类最多可以预测十步,但是目前的AI可以预测12步左右,还有就是可以创造两个不同的AI,让他们自己跟自己下棋,自己打自己。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?