背景需求:

业务发展越来越庞大,服务器越来越多 各种访问日志、应用日志、错误日志量越来越多,导致运维人员无法很好的去管理日志 开发人员排查问题,需要到服务器上查日志,不方便 运营人员需要一些数据,需要我们运维到服务器上分析日志。

ELK介绍:

ELK是三个开源软件的缩写,分别为:Elasticsearch 、 Logstash以及Kibana , 它们都是开源软件。 目前由于原本的ELK Stack成员中加入了 Beats 工具所以已改名为Elastic Stack。 Beats,它是一个轻量级的日志收集处理工具(Agent),占用资源少,适合于在各个服务器上搜集日志后传输给Logstash,官方也推荐此工具。

搭建步骤:

经过上述描述,大家也应该稍微有点了解了,想要搭建这个平台至少是需要3/4个软件的(可以没有filebeat)。- kibana 用于展示

- elasticsearch 用于检索

- logstash 用于过滤

- filebeat 用于收集日志

本篇文章假定你已经有了docker环境,并且有基本的docker使用经验

拉取镜像(统一版本可以避免很多坑):

docker pull kibana:6.8.2

docker pull elasticsearch:6.8.2

docker pull mobz/elasticsearch-head:5 # es的一个插件

docker pull logstash:6.8.2

docker pull docker.elastic.co/beats/filebeat:6.8.2 # 很慢 可以尝试设置代理或者更改docker镜像源

Docker 设置代理在linux中可以使用ClashX 订阅url,然后docker 连到代理。有桌面的可以直接更改,没有的也可以创建配置文件进行更改 ⇒ 传送门

另外把docker的内存给多一点儿,避免到时候卡顿。

构建ES:

docker run -d -p 9200:9200 -p 9300:9300 --name elasticsearch -e "discovery.type=single-node" elasticsearch:6.8.2

浏览器访问(curl也行):localhost:9200 出现下面的结果则说明启动成功:

若出现错误,请查错误日志。

创建ES-HEAD:

docker run -d -p 9100:9100 docker.io/mobz/elasticsearch-head:5

同样访问localhost:9100,看到下面的结果即为成功:

在es-head连接es可能是连不上的,是因为es没有开启跨域,进入es容器内部 找到config文件下的elasticsearch.yml,在此文件中增加:

http.cors.enabled: true

http.cors.allow-origin: "*"

然后重启es后es-head就可以连接上es。

开启Kibana:

docker run -d -p 5601:5601 --link elasticsearch -e ELASTICSEARCH_URL=http://elasticsearch:9200 kibana:6.8.2

这里就是http://elasticsearch:9200,不要更改,前面使用了–link,会在kibana容器hosts文件中加入elasticsearch ip地址,这样我们就直接通过定义的name来访问es服务了。

容器启动成功后,es-head里面应该就能看到下面的信息:

访问localhost:5601会出现下面的结果:

至此我们的kibana已经成功跑起来了,es也已经跑起来了,接下来就是收集日志的服务了。

构建filebeat 和 logstash:

首先声明,这两兄弟需要点儿配置文件,我们想整个文件夹统一存放这两份配置文件:mkdir elktest # 在主目录下 即:~/elktest 路径

cd elktest

touch filebeat.yml

touch logstash.conf

添加配置文件

vim filebeat.yml

filebeat.prospectors:

- paths:

- /home/elk/logs/user/a.log

multiline:

pattern: ^\d{4}

negate: true

match: after

fields:

doc_type: user

- paths:

- /home/elk/logs/service/a.log

multiline:

pattern: ^\d{4}

negate: true

match: after

fields:

doc_type: service

output.logstash: # 输出地址

hosts: ["logstash:5044"]

vim logstash.conf

input {

beats {

port => "5044"

}

}

filter {

json {

source => "message"

}

}

output {

stdout { codec => rubydebug }

elasticsearch {

hosts => [ "elasticsearch:9200" ]

index => "%{[fields][doc_type]}-%{+YYYY.MM.dd}"

}

}

当前你应该还在elktest目录下,由于我们没有日志来源,所以本片的方式是手动创建日志,建立一个日志文件夹:

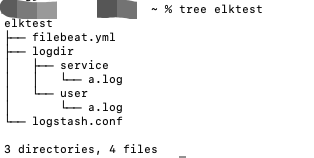

mkdir logdir

自己构建一些日志,随便写什么,文件及文件夹名称不要改动,已经在配置文件中对应好了,构建完成之后你的目录结构应该长这个样子:

创建容器:

docker run -it --name logstash --link elasticsearch -d -p 5044:5044 -v ~/elktest/logstash.conf:/usr/share/logstash/pipeline/logstash.conf logstash:6.8.2

docker run --name filebeat --link logstash -d -v ~/elktest/filebeat.yml:/usr/share/filebeat/filebeat.yml -v ~/elktest/logdir/user/:/home/elk/logs/user/ -v ~/elktest/logdir/service/:/home/elk/logs/service/ docker.elastic.co/beats/filebeat:6.8.2

此时你的es-head应该长这个样子:

如果不是这个样子,可以查看容器是否运行,是否有错误日志,另外也可以到logstash容器中ping elasticsearch,filebeat容器中ping logstash,检查路径是否有问题。

Kibana显示:

创建索引向:

创建完成后去查看,添加自己想要查看的字段,内容在message里(刚好就是我们在a.log中的内容):

到此为止,我们的elk已经搭建完成了,成功搭建的小伙伴晚饭给自己加个鸡腿!!!!

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?