目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

大家好,这里是海浪学长计算机毕设专题,本次分享的课题是

🎯基于卷积神经网络的花卉检测与识别技术

项目背景

随着园艺和农业行业的快速发展,花卉的种植、管理和销售过程对高效的检测和识别技术提出了更高的要求。传统的花卉检测方法往往依赖于人工观察,效率低下且容易出错。深度学习和计算机视觉技术的进步为花卉检测提供了新的解决方案。通过构建基于卷积神经网络(CNN)的花卉检测系统,可以实现对不同种类花卉的自动识别和分类,从而提高管理效率,推动智能农业的发展。

数据集

花卉图像数据集的制作过程主要包括图像采集、数据标注和数据集划分与数据增强三个步骤。在图像采集阶段,可以通过自主拍摄和互联网采集两种方式进行。自主拍摄允许研究者在控制光照、角度和背景的条件下获取真实的花卉图像,以确保样本的多样性和代表性;而互联网采集则可以快速获取大量已有的花卉图像,丰富数据集的多样性。通过这两种方式结合,可以构建一个涵盖多种花卉品种和生长状态的图像数据集。

为了确保模型训练的有效性,使用标注工具(如LabelImg或LabelMe)对收集到的花卉图像进行准确标注。标注过程中,需要为每个图像中的花卉对象指定对应的标签,并确保标注的一致性和准确性。这一过程关系到后续模型的学习效果,因此必须严格把控数据标注的质量,以便让模型能够更好地学习和识别不同种类的花卉。

数据集应划分为训练集、验证集和测试集,其中训练集用于模型训练,验证集用于调参,测试集用于模型评估。同时,数据增强技术(如旋转、缩放、翻转和颜色变换等)可以在训练过程中生成更多样本,增加数据的多样性,帮助模型更好地学习和适应不同场景下的花卉图像,降低过拟合的风险。

设计思路

卷积神经网络(CNN)是一种深度学习架构,旨在高效处理图像数据。CNN的基本结构包括多个卷积层、激活函数、池化层和全连接层。卷积层通过局部感受野提取输入图像的特征,每个卷积层学习不同层次的特征,从简单的边缘和纹理到复杂的形状和模式。激活函数(如ReLU)用于引入非线性,使得网络能够学习复杂的映射关系,而池化层则通过下采样操作减少特征图的尺寸,降低计算复杂度和防止过拟合。通过多层的堆叠,CNN能够自动学习和提取图像的层次化特征,极大地提高了在图像分类和目标检测等任务中的表现。

除了基本的卷积层和池化层,现代CNN模型通常还包含批归一化、残差连接等技术,以提高网络的训练速度和准确性。批归一化在每个小批量的输出上进行规范化,有助于加速训练过程并减少对初始化的敏感性。残差连接则通过引入跳跃连接,解决了深层网络中梯度消失和退化的问题,使得模型训练更加稳定。这些技术的结合使得卷积神经网络在处理复杂视觉任务时更加高效和精确。

FasterNet是一种轻量化的卷积神经网络架构,旨在提升模型的推理速度和计算效率,同时保持高的分类精度。FasterNet通过引入深度可分离卷积(Depthwise Separable Convolution)等技术,减少了模型的参数数量和计算量。深度可分离卷积将标准卷积分解为两个步骤:首先通过深度卷积对每个输入通道独立进行卷积,然后通过1x1卷积进行特征融合。这种结构使得FasterNet在保持较高性能的同时,显著减少了模型的复杂性和内存占用。

FasterNet还采用了通道剪枝和模型压缩等技术,进一步优化了模型的运行效率。通道剪枝通过去除冗余的卷积通道,减少了模型的运算量和内存消耗,而模型压缩则通过量化和稀疏化技术减少模型存储需求。这些优化措施使得FasterNet非常适合在资源受限的设备上进行部署,如移动设备和嵌入式系统,能够在保证实时性的同时实现高效的图像识别。FasterNet的设计理念是将深度学习技术普及到更广泛的应用场景,特别是在需要快速响应和低功耗的场合。通过轻量化的网络架构,FasterNet能够在多个任务中实现实时处理,为边缘计算和智能设备的应用提供了强有力的支持。其灵活性和高效性使得FasterNet在工业、医疗和智能家居等领域展现出广泛的应用前景。

注意力机制是一种模仿人类视觉注意力的机制,在卷积神经网络中引入注意力机制可以显著提升模型的性能。通过动态地调整不同特征通道的重要性,注意力机制能够帮助模型更好地聚焦于与任务相关的信息。具体而言,注意力机制通过计算特征图中各个通道或位置的权重,对信息进行加权,从而突出重要特征,抑制无关特征。这一机制可以有效提高模型在图像分类、目标检测等任务中的准确率,尤其是在存在复杂背景或多种目标的情况下。

引入注意力机制的常见方法包括通道注意力机制和空间注意力机制。通道注意力机制通过对每个通道的特征进行加权,增强重要通道的信息;而空间注意力机制则通过对特征图的空间位置进行加权,突出重要的空间区域。这两种机制可以单独使用,也可以结合使用,以提升模型的整体性能。在多个视觉任务中,结合注意力机制的卷积神经网络表现优于传统模型,特别是在处理复杂场景时,注意力机制的引入显著提升了模型的鲁棒性。

注意力机制的引入不仅提高了模型的性能,还增加了模型的可解释性。通过可视化注意力图,研究者可以更直观地理解模型在做出判断时关注的特征区域,这对于调优和改进模型提供了重要的指导。随着深度学习技术的不断发展,注意力机制逐渐成为现代卷积神经网络中的重要组成部分,推动了计算机视觉领域的进一步研究和应用。

数据准备,包括数据加载、预处理和分割。首先,需要将图像数据加载到内存中,并进行必要的预处理,如归一化和尺寸调整。接着,将数据集划分为训练集、验证集和测试集,以保证模型的训练和评估能够在不同的数据上进行。这一过程对于模型的性能至关重要,因为数据的质量和多样性直接影响到模型的学习效果。

from torchvision import datasets, transforms

# 数据预处理和加载

transform = transforms.Compose([

transforms.Resize((224, 224)), # 调整图像尺寸

transforms.ToTensor(), # 转换为Tensor

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5)) # 归一化

])

train_dataset = datasets.ImageFolder(root='data/train', transform=transform)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=32, shuffle=True)选择基于卷积神经网络(CNN)或FasterNet等结构,结合目标检测任务的特点,设计合适的模型。模型的设计应考虑到输入数据的特征和任务的复杂性,以确保模型能够有效地学习到花卉图像的特征。使用交叉熵损失函数和优化器(如Adam或SGD)来更新模型参数。在训练过程中,通过迭代多个epoch,逐步调整模型权重,以最小化损失函数。同时,可以使用验证集监控模型的性能,防止过拟合。

import torch.nn as nn

class FlowerClassificationModel(nn.Module):

def __init__(self):

super(FlowerClassificationModel, self).__init__()

self.cnn = nn.Sequential(

nn.Conv2d(3, 32, kernel_size=3, stride=1, padding=1),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2),

nn.Conv2d(32, 64, kernel_size=3, stride=1, padding=1),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2),

)

self.fc = nn.Linear(64 * 56 * 56, num_classes) # num_classes为花卉类别数

def forward(self, x):

x = self.cnn(x)

x = x.view(x.size(0), -1) # 展平

x = self.fc(x)

return x使用测试集进行模型评估,通过计算准确率、召回率和F1值等指标,分析模型性能。评估结果可以帮助识别模型在特定类别上的不足之处,并为后续的改进提供指导。

model.eval() # 设置模型为评估模式

total, correct = 0, 0

with torch.no_grad():

for images, labels in test_loader:

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

accuracy = correct / total

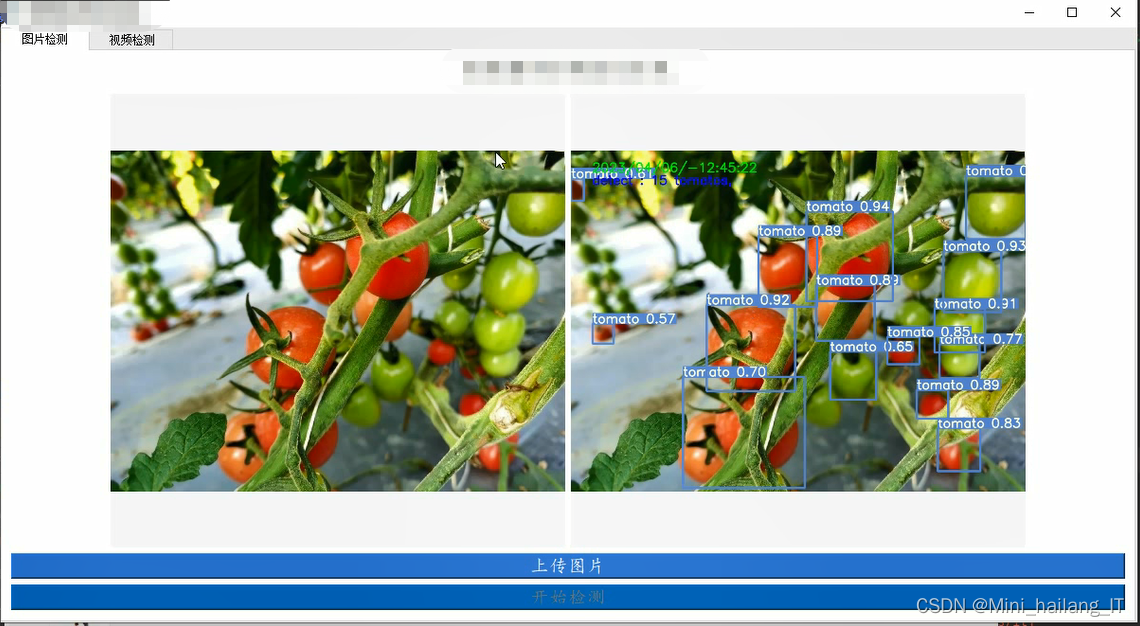

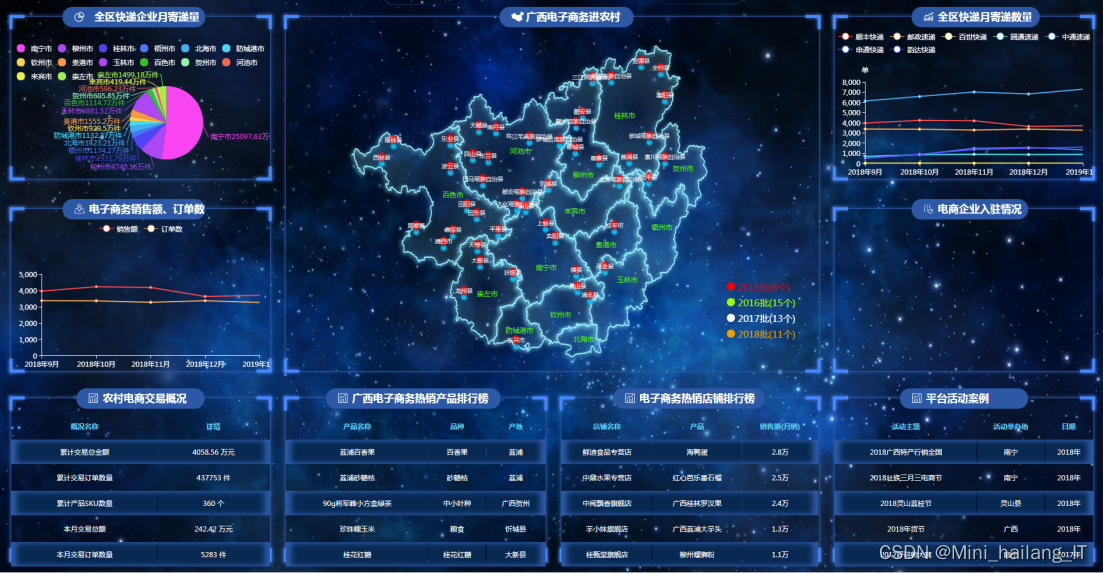

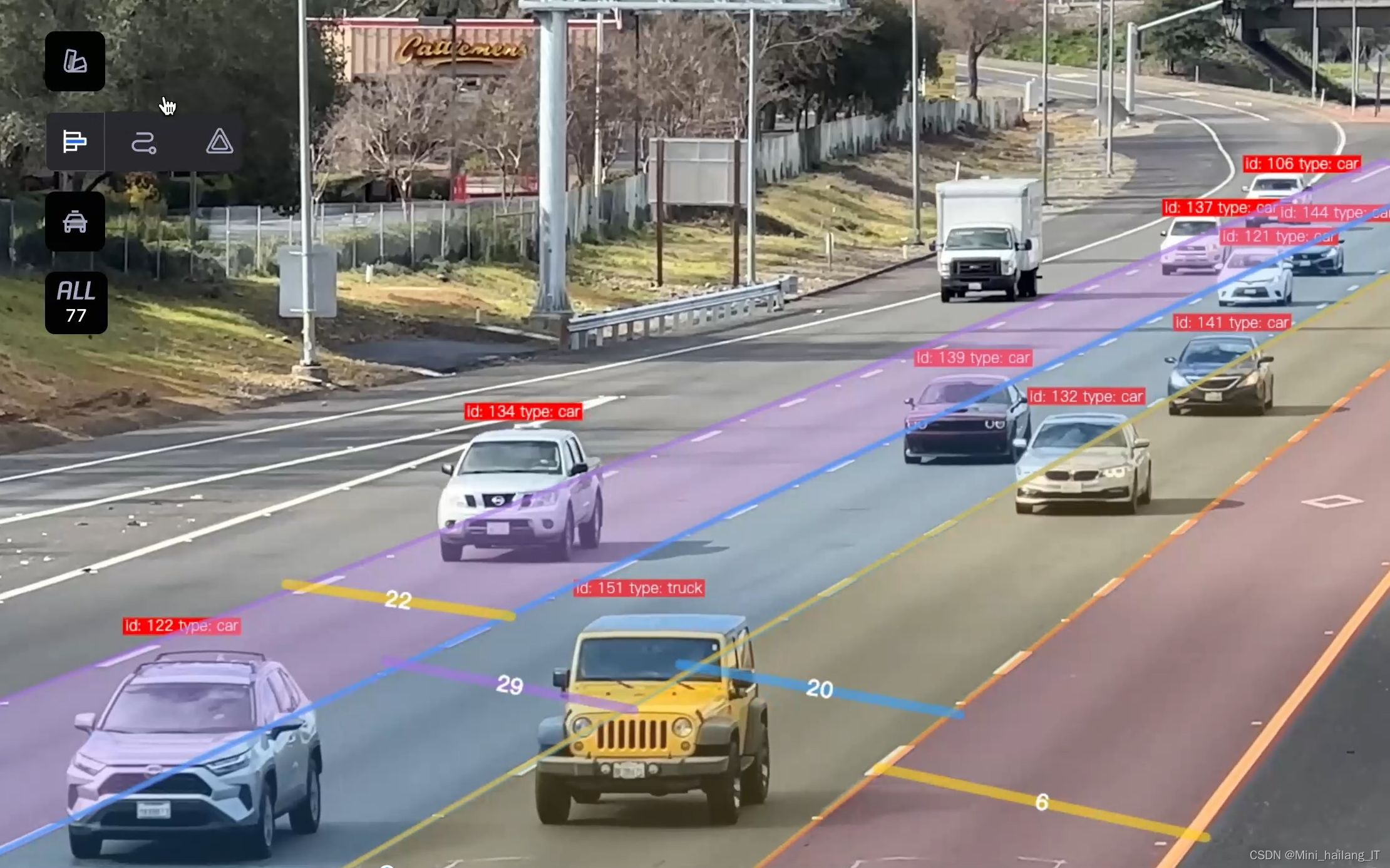

print(f'Accuracy of the model on the test set: {accuracy:.2f}')海浪学长项目示例:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?