概要

本文将包括如下内容:NAS文件系统核心概念、文件系统概念模型与数据组织、文件系统 IO 路径与关键流程等。

NAS服务器提供文件服务,支持NFS协议或SMB协议等挂载。文件系统用于存储文件的数据和元数据,通过计算节点挂载访问。以目录树等形式管理文件的数据和元数据。支持多个计算节点同时访问,进行数据共享和高并发读写。

一、NAS 文件系统核心概念

-

inode:元数据的 “数字档案”

inode 是 Linux/Unix 文件系统的核心数据结构,每个文件对应唯一 inode 节点(通过ls -i命令可查看 inode 编号),存储非文件名的全部元数据。其核心作用包括:

- 数据寻址:记录文件数据块(Block)的物理位置(如 EXT4 文件系统通过间接块支持大文件寻址)。

- 权限控制:存储用户 / 组 ID、读写执行权限(如rwxr-xr-x),实现访问控制。

- 时间管理:维护三类时间戳:

ctime(Change Time):元数据修改时间(如权限变更)。

mtime(Modify Time):文件内容修改时间。

atime(Access Time):文件最后访问时间(可通过noatime挂载选项优化性能)。

典型场景:

当用户执行cp file1 file2时,系统会创建新 inode(复制元数据),但共享数据块(若启用写时复制 COW 技术);删除文件时,仅删除 dentry 链接,当 inode 链接数为 0 且无进程引用时,才释放数据块。

-

dentry:文件名的 “寻址桥梁”

每个文件对应一个dentry(目录项)结构体,用于维护文件路径的层级关系(如父目录、子目录、文件名),并指向对应的 inode。核心作用包括:

- 路径遍历:通过父目录 dentry 找到子节点,构建目录树(如/usr/local/bin路径需逐级解析 dentry)。

- 缓存加速:借助 dcache(目录缓存)存储最近访问的 dentry,减少 inode 查询开销(可通过sync命令刷新缓存)。

- 软硬链接区分:

硬链接:多个 dentry 指向同一 inode(共享元数据,如ln file1 hard_link)。

软链接:独立 inode,dentry 存储目标路径(如ln -s file1 soft_link)。

– dentry与 inode 的协作:

例如用户访问/etc/passwd时,流程为:

根目录 dentry 解析 “etc” 得到子 dentry,关联 etc 目录的 inode。

通过 etc 目录 inode 找到 “passwd” 文件的 dentry,关联其 inode。

最终通过 inode 获取数据块地址,完成 IO 操作。

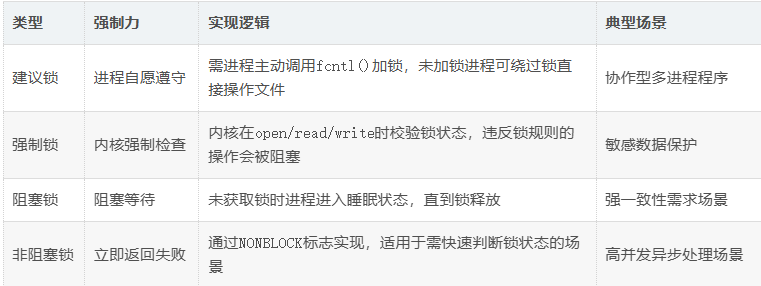

- 文件锁:并发访问的 “交通管制”

- 建议锁性能更高,但存在进程 “作弊” 风险;强制锁安全性强,但增加内核检查开销。

- 分布式场景需配合分布式锁(如 etcd、Redis)实现跨节点互斥,单纯文件锁无法解决跨服务器冲突。

二、文件系统概念模型与数据组织

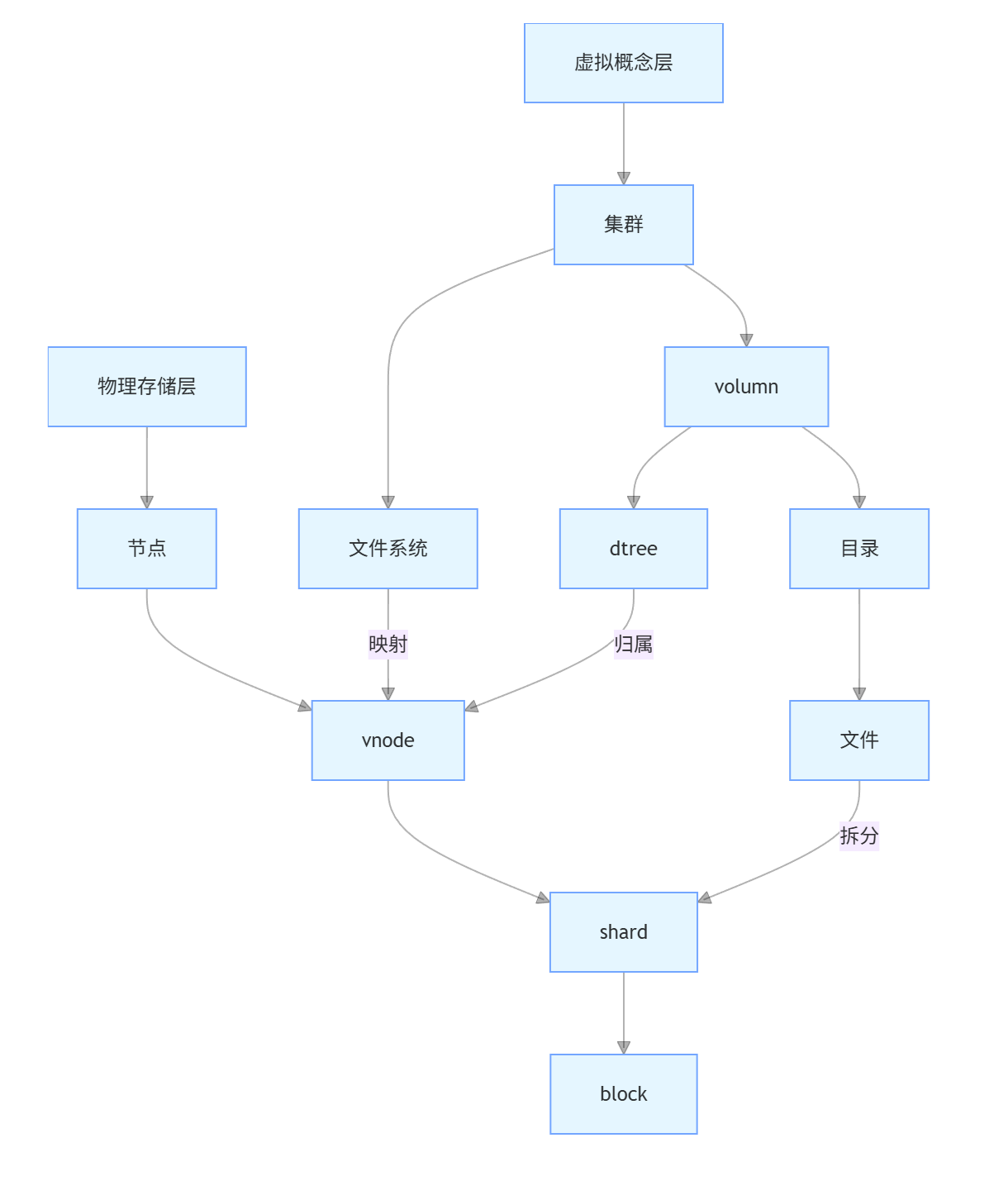

(一)逻辑分层模型

- 虚拟概念层:

- 从宏观到微观依次为 集群 → 文件系统 /volumn → dtree / 目录 → 文件,呈现用户可见的逻辑结构。

- volumn 作为存储资源抽象单元,下挂 dtree 和普通目录,最终指向具体文件。

- 物理存储层:

- 从逻辑到物理依次为 节点 → vnode(虚拟节点) → shard(数据分片) → block(物理块).

- vnode 作为路由节点,关联文件系统和 shard;shard 是数据分片单元,最终映射到物理存储块。

- 关键映射关系:

- 文件系统 /dtree 归属到 vnode,由 vnode 调度至具体存储节点。

- 文件数据拆分为多个 shard,分布在不同节点的 block 中(类似分布式存储的分片机制)。

volumn:逻辑存储单元,抽象物理磁盘空间(支持配额管理、快照等)。

dtree(Directory Tree):特殊目录结构,用于文件分布策略(如按哈希分桶到不同 shard)。

shard:数据分片单元,一个文件可能拆分为多个 shard 存储在不同节点(如 Ceph 的 PG 分区机制)。

vnode:虚拟节点映射,负责 shard 到物理节点的路由(类似 DNS 解析的负载均衡)。

(二)数据分布策略

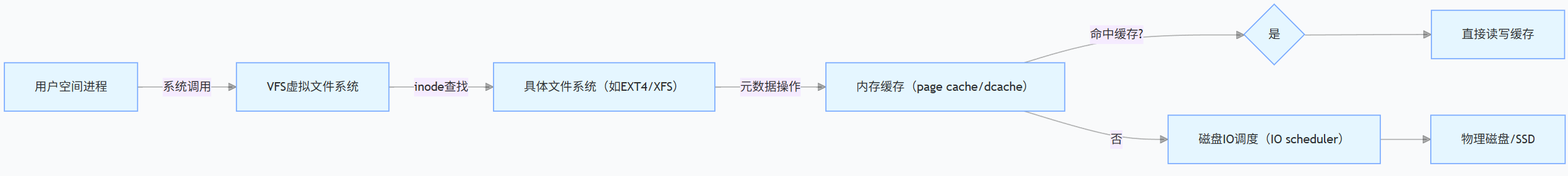

三、文件系统 IO 路径与关键流程

- IO 读写全流程解析

关键结构:

- VFS 层:统一不同文件系统接口(如 ext4、nfs、cifs),实现跨文件系统操作(如cp /ext4/file /nfs/share)。

- 缓存层:

- page cache:缓存文件数据块(读预取、写回机制提升性能)。

- dcache:缓存目录项,加速路径解析(find命令效率依赖 dcache 命中率)。

- 物理层:通过设备驱动(如 SCSI/NVMe)与存储介质交互,支持调度算法优化 IO 顺序。

- 具体关键步骤解析:

-

写数据关键步骤

系统调用与路径解析:用户进程通过write()发起调用,内核通过dcache或路径遍历获取文件inode,检查权限与文件锁。

缓存与元数据更新:数据写入page cache并标记脏页,更新inode的mtime、ctime和文件大小。

刷盘与物理写入:由pdflush或sync触发刷盘,块分配器确定物理块,经 IO 调度后写入磁盘。 -

读数据关键步骤

缓存优先:先查page cache,命中则直接返回数据;未命中则查询inode块映射表获取物理地址。

磁盘读取与缓存更新:从磁盘读取数据加载到page cache,再返回给用户,同时可能触发预取优化。 -

部分技术与优化

分离存储:inode与数据分区域存储,减少磁盘访问竞争。

写时复制(COW):保障数据一致性,避免部分写入问题。

分布式系统的差异:如 CephFS 访问数据时,需先通过 MDS 获取元数据,数据块经 CRUSH 算法分配节点,存在网络开销。 -

性能观测工具

strace:跟踪系统调用,查看用户与内核交互。

perf:分析内核函数耗时,定位性能瓶颈。

blktrace:捕获磁盘 IO 地址与时序,优化存储性能。 -

文件系统具体处理:用户空间传入数据,经过文件系统处理,得到相关信息,通过文件系统的信息,处理后得到在盘上的起始位置和内部偏移,从而读出或者写入数据。

总结

NAS 文件系统通过 inode/dentry 的解耦设计实现高效元数据管理,借助文件锁机制保障并发安全,其概念模型与 IO 路径深度融合分布式存储架构。实际应用中需结合业务场景选择锁策略、缓存配置及数据分布方式,以平衡性能、可靠性与可扩展性。

508

508

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?