ipython 集成 SPARK

Python 数据分析环境安装

python 数据分析环境安装 前面已经单独写过博文,这里不再重复

Spark 环境安装

spark 下载页面,选择最新的 Spark 版本 2.0.0,使用包类型 Pre-built for Hadoop 2.7 and later,开始下载:

wget http://d3kbcqa49mib13.cloudfront.net/spark-2.0.0-bin-hadoop2.7.tgz

安装:

tar xf spark-2.0.0-bin-hadoop2.7.tgz

mv spark-2.0.0-bin-hadoop2.7 /usr/local/spark

启动 pyspark 命令交互模式:

/usr/local/spark/bin/pyspark

就会看到一个类似于 python 命令交互模式的界面

在 /usr/local/spark 下:

- bin 目录是可执行文件,pyspark 是 python 命令行支持,spark-shell 是 scala 命令行支持,sparkR 是 R 语言命令行支持

- sbin 是 Spark 系统脚本

- conf 目录是配置文件

- python 目录是 python 库,如果需要 Python 程序调用 Spark,需要将该目录导入到 Python 库搜索目录中

- R 目录是 R 语言库,与 Python 调用 Spark 类似,R 语言要调用 Spark 也需要将该库放到 R 语言库搜索目录中

- 其它就不再赘述

以上即完成了一个单机版 Spark 环境的搭建

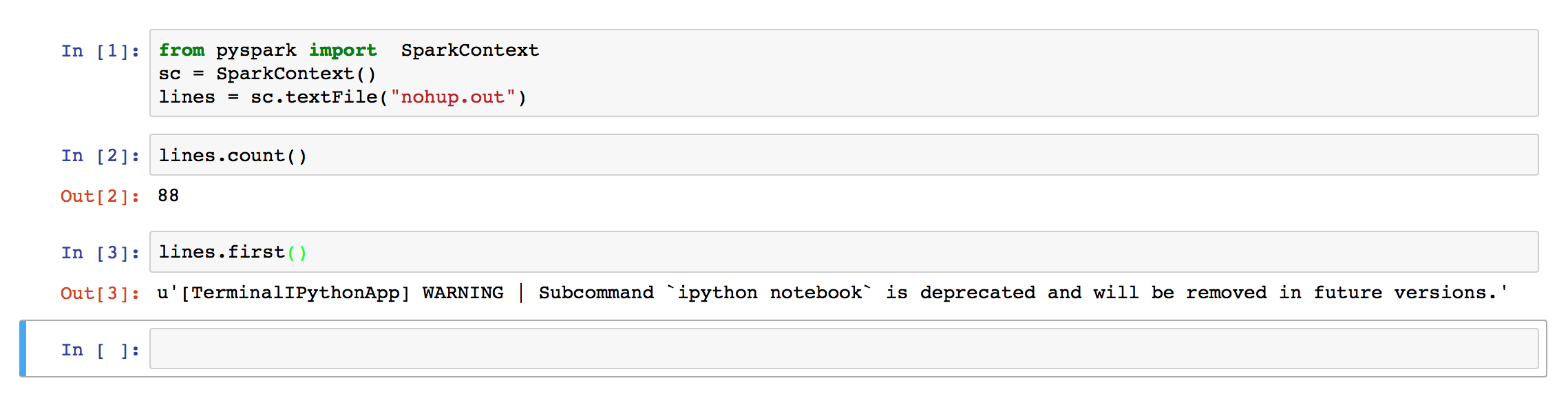

Ipython 使用 Spark

我使用的是 Ipython notebook 的环境,该环境为了系统安全,是启动在一个 notebook 账户下的。Ipython notebook 的配置和启动已经在 python 数据分析环境安装 中介绍,这里重点介绍怎么在 Ipython notebook 中使用 Spark

在 notebook 环境中,添加环境变量:

export PYTHONPATH=/usr/local/spark/python:/usr/local/spark/python/lib

export SPARK_HOME=/usr/local/spark

进入到 spark/python/lib 下,处理相应的依赖库:

cd /usr/local/spark/python/lib/

unzip py4j-0.10.1-src.zip

unzip pyspark.zip

完成以上操作后,在 notebook 账户下重置环境变量并启动 ipython notebook,就可以使用 spark 了

3876

3876

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?