以AI人工智能为代表的新技术正在成为全球商业发展的新动能。淘天集团从去年开始,就已经在AI重点领域,展开和高校的一系列深入合作。

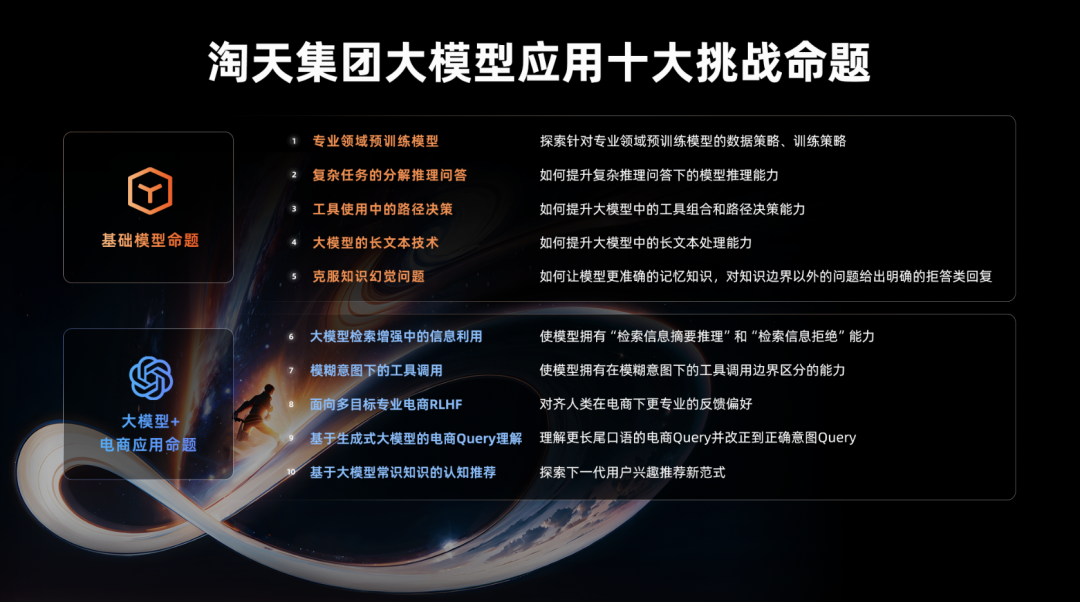

近期,淘天集团集合基础模型和电商应用场景的具体问题,面向高校师生和全社会发布大模型应用十大挑战命题,欢迎大家一起攻克难题。如果您对以下命题感兴趣,请点击参与本次挑战,我们准备了丰厚的奖励。欢迎您参与!

一、基础模型命题

1.1 专业领域预训练模型

✪ 1.1.1 技术背景

不同于普通基于LLM的chatbot一般注重对话流畅等要素,大模型在电商业务中还对回答的专业性提出了更高的要求。模型需要能在电商领域下提供专业、准确、实时性好的答案,而这个能力是主要由通用语料训练的大模型的短板。

对于实时信息的获取,检索增强是一条有效路径,但在获取基本信息以外,模型还需要有专业的信息处理能力和垂直领域下的领域知识。这些能力难以通过sft等下游优化得到显著提高,需要在预训练中对其进行能力建设。

✪ 1.1.2 技术挑战

-

如何获取和构建针对专业领域的训练数据,使模型能够学习到通用数据难以覆盖的专业性知识。

-

专业性数据通常数量有限,如何高效利用专业性数据避免模型遗忘。

-

如何平衡专业性能力和通用能力,不同于面向特定领域的纯专业模型(如codeLLama),我们的目标是一个有很强专业领域能力的通用模型。

✪ 1.1.3 技术诉求

-

建设专业领域下数据收集,处理的pipline。

-

探索针对专业领域下能力建设的数据策略,训练策略。在不降低其他能力的同时,强化模型在特定领域下的专业性。

1.2 复杂任务的分解推理问答

✪ 1.2.1 技术背景

电商业务中,用户的需求需求表达与商品直接信息之间往往存在表达gap,比如,用户表达9月10日送礼礼物,其中隐含了两层逻辑:9月10号是教师节;教师节送礼一般是送老师。因此用户的实际需求的大概率是教师节送老师的礼物。如果用户表达:要一款出租屋冰箱,里面隐含的信息可能是要一款价格便宜,占用空间小的冰箱。

模型如果想要准确理解用户的意图,那就需要有一定的生活消费领域常识,并且利用这些常识对用户的表达进行推理,对齐自然表达与商品的客观表述。

目前,大模型学习特定领域知识一般采用专项语料学习的方式,比如,通过增加教材,题库等语料,可以大幅提高模型的学科能力。但是,生活常识由于过于广泛,难以显式的穷举和总结。通用语料训练模型虽然可以让模型具有一定的常识,但能力边界不可控,也难以进行迭代、提升。

✪ 1.2.2 技术挑战

-

模型需要学习大量的生活消费类常识。这些常识很难用类似三元组/描述语句的方式显式表达,当正常训练的模型能力不足以满足业务需求时,如何提高其能力。

-

模型如果具备基础的常识,能否利用常识进行正确推理。实际问题中,涉及的推理步骤可能不止一步。

-

模型需要自行判断是否需要进行推理,以及推理到何种程度结束,这是和有明确目标的数理推理不同的地方。

✪ 1.2.3 技术诉求

-

一套在预训练、sft等模型训练过程中提高模型常识掌握程度的方法。

-

在对齐过程中,使模型能够利用已掌握的知识,进行分析、理解、推理用户需求的方法。

1.3 大模型的长文本技术

✪ 1.3.1 技术背景

大模型在业务应用中,部分场景会遇到长文本问题,比如:带有检索增强的多轮对话,如果需要保留每一轮对话中使用的检索到的信息,整个对话的上下文长度就会迅速增长;又比如涉及到Tool调用的场景,prompt,工具参数,数据格式,tool结果等都会占用大量的上下文空间。通常,考虑到训练成本等因素,预训练模型的Pretrian阶段不会使用过长的上下文窗口,这就提出了在一个已经预训练完成的模型上,通过小规模续训,插值等手段,使模型具备更长上下文处理窗口的能力的命题。

✪ 1.3.2 技术挑战

-

通过后期处理的长序列模型在效果上相比于原生长序列模型有所下降,如何缩小这个差距。

-

通过稀疏化等方式,可以在预训练阶段就使模型具备长序列处理能力,但可能影响模型效果。如何平衡序列长度,训练开销以及模型效果。

✪ 1.3.3 技术诉求

-

一套在已有预训练模型的基础上,扩展其序列长度的方法。

-

研究预训练中支持长序列的方法,平衡序列长度,训练开销以及模型效果。

1.4 克服知识幻觉问题

✪ 1.4.1 技术背景

大模型拥有强大的记忆能力,能够记住训练预料中出现的知识,然而在实际业务中,我们发现大模型并不能保证输出的内容的准确性。比如,如果询问大模型一款不存在的手机的参数,大模型依旧会给出一个看似很确定的答案。这种知识类幻觉在电商场景下会对业务带来很大的风险。

从信息压缩角度,我们不可能让大模型无损的记住训练语料中的所有信息,克服知识幻觉可以分为两个方向:

-

让模型对见过的知识记得更准 。

-

让模型知道自己“不知道”。

✪ 1.4.2 技术挑战

-

如何让模型记忆知识更加准确,比如,训练语料中存在3C数码产品的参数库,如何让减少模型在被询问相关问题时胡编乱造的概率。

-

如何让模型了解自己的知识边界,对于超出知识边界的问题,应给出明确的拒答类回复。

✪ 1.4.3 技术诉求

-

在预训练中,探索设计训练策略、数据策略使模型能更准确地记忆语料中存在的知识。

-

通过sft,RLHF等手段,使模型能对知识边界以外的问题给出明确的拒答类回复。

1.5 工具使用中的路径决策

✪ 1.5.1 技术背景

大模型通过在预训练的过程中,积累丰富的世界知识,从而能够在复杂的通用交互环境中,拥有强大的推理和决策能力。然而,对于特定领域的任务,例如淘宝电商,需要依赖特定领域知识和决策逻辑,大模型仍然具有一定的局限性。

这些问题需要利用更加专业的工具或者领域知识才可以解决,所以,大模型需要具备调用各种专业化工具的能力,才能为现实的任务提供更加全面准确的支持。例如:通过调用“文生图”工具,大模型通过生成文生图的描述性语言,来扩展其能力边界。通过调用“淘宝商品搜索”工具,为大模型引入更加专业准确、且有时效性的商品知识。

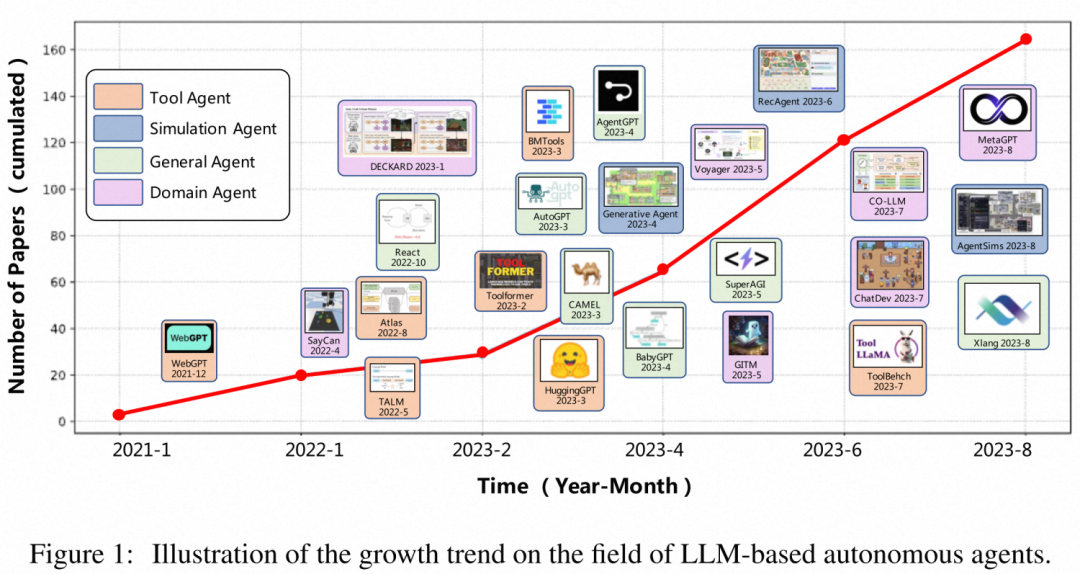

工具学习Agent发展:

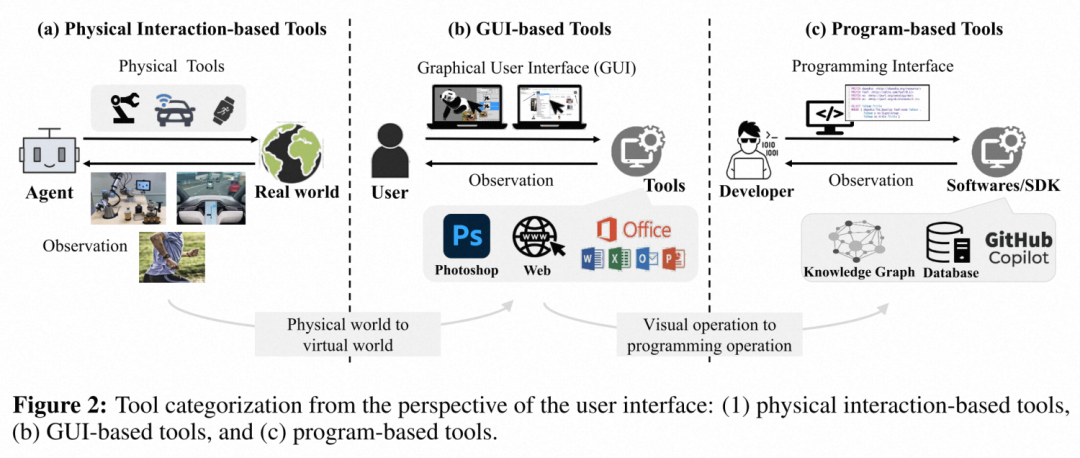

工具的类型:

✪ 1.5.2 技术挑战

如何充分利用模型的意图理解和推理能力,正确的选择工具,并提供可解释的工具调用路径

工具的返回结果可能是文档、表格、结构化数据等、如何让模型充分利用工具的返回知识,并摘要整合成符合需求的回复

✪ 1.5.3 技术诉求

-

优化大模型理解工具、选择工具和调用工具的能力,规划工具调用路径,用最高的调用效率解决问题。

-

研究如何使大模型能够接受并理解不同形式的工具输出,例如文档、表格、人类反馈、甚至图片等,并以此增强大模型的最终结果。

二、大模型电商应用命题

2.1 大模型检索增强中的信息利用

✪ 2.1.1 技术背景

在电商应用中,我们引入了检索增强来解决电商下的知识幻觉问题。例如对于用户问题“2000块钱左右的电脑”,我们通过检索淘宝的商品库,可以拿到实时价格在2000多元的电脑商品,并将相关商品信息输送给模型,从而给用户更加准确的回复。但在引入检索增强的同时,我们也发现了如下的问题:

-

由于数据库组织形式上的不同,在一些情况下,我们可能拿到解决问题所需要的电商信息的同时,也引入了大量无关的信息,导致模型需要从大量的信息中抽取和摘要出解决问题所需要的正确的信息。例如对于实时性问题“李佳琦今晚直播有口红吗”,我们可以通过检索,拿到李佳琦今晚直播的选品清单,但需要模型从清单中判断其中有没有口红。

-

业务的检索知识,也无法保证完全正确。模型需要能够依据检索文本信息和用户输入问题,分辨正确的和错误的知识,从而回答正确的答案。

✪ 2.1.2 技术挑战

-

如何从大量的检索信息中,推理摘要出与问题相关的信息,并利用这些信息,生成合理的回复。

-

如何使模型能够拒绝使用检索到的错误的信息。

✪ 2.1.3 技术诉求

-

检索增强的SFT训练方法,能够使模型同时拥有“检索信息摘要推理”和“检索信息拒绝”能力。

2.2 模糊意图下的工具调用

✪ 2.2.1 技术背景

我们针对不同的用户意图,通过不同的工具调用路径,规划了不同的解决方案来进行承接。

比如用户问“我应该怎么挑选连衣裙”,我们会先通过“决策因子”工具,拿到挑选“连衣裙”应该注意的维度,再让大模型依据这些维度给用户合理的建议。

再比如用户问题“给我推荐200多元的长款连衣裙”,我们会先搜索淘宝商品,再让大模型依据搜索到的商品,给用于推荐。

但是,在某些情况下,比如“推荐一下连衣裙”,我们无法判断是否需要先告诉用户“怎么挑选连衣裙”,或者问题“连衣裙”,我们也无法判断用户真实意图。在这样的模糊意图下,需要大模型通过海量用户行为数据,在模型中学会正确的决策用户问题的解决路径,而不是像固定意图下,固定一个明确的工具调用集合和路径。

✪ 2.2.2 技术挑战

-

有些时候往往用户也不清楚自己在购物时候的真实意图,如何让模型依据海量用户行为数据,学习电商领域下模糊意图的统计意义决策。

✪ 2.2.3 技术诉求

-

通过RLHF、CT等技术,建立模糊意图下的工具学习方法,让大模型理解真实用户模糊意图。

2.3 面向多目标专业电商RLHF

✪ 2.3.1 技术背景

在预训练大模型经过指令微调之后,大模型初步涌现出了解决问题的能力。然而,此时的大模型并没有完全与人类需求和价值观对齐,因此,需要经过基于人工反馈的强化学习(RLHF)来与人对齐。在RLHF中,主要包括两个步骤:

-

训练奖励模型(reward model);

-

使用奖励模型判断当前状态下模型输出结果的质量并依此更新模型参数。

在构造训练奖励模型的数据时,需要对同一个问题的多个回复进行人工排序,目前最常用的方式是对两个回复进行[chosen]/[rejected]判断,从而可以在相同人力的基础上提高问题的覆盖量与多样性。为了不过于依赖人力,针对RLHF中的H,一些研究人员使用AI来代替,即RLAIF,目前最常用的AI是GPT4。

无论是H还是AI,当一个问题是通用领域的问题时,还比较容易判断,但是当面对电商垂直领域的专业问题时,这种排序变的不那么容易。

例如:

-

“索尼的 70200 gm 二代怎么样”,非“3C数码”领域的同学对于这个产品可能都没有听说过,因此无法对两个不同的结果进行排序;

-

“口红色号怎么选”,非“美妆”领域的同学也无法对不同的答案做出正确的判断。

与此同时,电商垂类除“3C数码”、“美妆”外还有非常多的专业的领域,如“服饰”、“运动户外”、“母婴”、“健康”等等,这些专业领域对构建奖励模型训练数据造成了挑战。电商的RLHF需要在专业性、准确性、全面性、深入度上进行整体优化。

✪ 2.3.2 技术挑战

-

电商垂类不同专业领域的百万级的奖励模型训练数据自动构建;

-

电商域的RLHF结果需要面向更多的目标进行优化,例如:专业性、准确度、全面性、深入度。

✪ 2.3.3 技术诉求

-

数据层面:构建电商垂类专业领域奖励模型训练数据的方法论;

-

模型层面:多目标优化的RLHF方法。

2.4 基于生成式大模型的电商Query理解

✪ 2.4.1 技术背景

在电商搜索中,用户输入query,系统通过对query的理解来返回合适的商品。通常来说,用户输入的query和商家录入的商品标题存在着天然的不同,query相对短且语句通顺,而标题则是长且堆砌着关键词,我们需要对query做改写来解决query与标题之间存在的语义鸿沟问题,期望改写query能够带来相对于原query的增量商品。

常规的query改写方法包括基于行为数据的协同过滤和基于语义数据的相似判别方法,存在着对自然语言query的理解能力有限、对长尾query较难匹配到合适结果的问题。而基于大模型的生成式改写,可以借助大模型中的知识增强对query的理解、在长尾query上直接生成合适的改写query。

✪ 2.4.2 技术挑战

-

通常的大模型应用中,系统给用户返回大模型中蕴含的知识作为对提问的回复,而在电商query理解中不仅需要借助这些知识生成与query相关的改写query,还需要改写query能够在搜索系统中带来增量商品;

-

用户在电商搜索系统中输入的query是复杂多变的,如何通过用户输入的多个query,建立对用户需求的完整理解,也存在着挑战。

✪ 2.4.3 技术诉求

-

在电商场景中,建立在搜索系统中深入理解query、能够带来增量商品的query改写技术;

-

通过对用户行为的建模,加深对用户需求的完整理解,建立基于query上下文的个性化query改写技术。

2.5 基于大模型常识知识的认知推荐

✪ 2.5.1 技术背景

在电商推荐场景下,我们希望借助阿里自研大模型,研发下一代基于大模型的用户兴趣推荐新范式,以满足用户多元的购物需求。

传统推荐算法很大程度上依赖用户行为,通过行为找相似品或人,这种方法效率很高,但是容易走入重复。强推短期效率容易导致整体发现性变差,越来越多的用户感受到“为什么我点了这个商品后一直给我推?”“每天都看重复的东西太没有意思了”。因此需要一定的手段打破重复,给到用户“意料之外,情理之中”的结果。

而这正是大模型擅长的地方。我们希望通过大模型引入世界知识和推理能力,构建符合人的认知的推荐,提升结果的发现性,改善现有的数据循环。

✪ 2.5.2 技术挑战

-

以合理的方式表达用户的电商购物需求,对齐自然语言和电商结构的语义空间;

-

对主流的大模型有SFT和RLHF的能力,兼顾效果和性能;

-

在传统推荐的结果之上做出增量,结果需要具备发现性和惊喜性,对于用户要有实际体感。

✪ 2.5.3 技术诉求

-

探索超大规模语言模型,负责大语言模型应用相关的数据建设、微调、对齐等模型优化工作;

-

大语言模型应用在大淘宝推荐场景的落地,包括逻辑推理、智能内容理解、商品创意生成等;

-

建立新一代认知推荐算法体系,结合交互式推荐的产品创新,提升用户体验和首页推荐的长期价值。

参考文献

「工具使用中的路径决策」

[01] Mialon, G., Dessì, R., Lomeli, M., Nalmpantis, C., Pasunuru, R., Raileanu, R., Rozière, B., Schick, T., Dwivedi-Yu, J., Celikyilmaz, A., Grave, E., LeCun, Y., & Scialom, T. (2023). Augmented Language Models: a Survey. 1–33.

[02] Wang, L., Ma, C., Feng, X., Zhang, Z., Yang, H., Zhang, J., Chen, Z., Tang, J., Chen, X., Lin, Y., Zhao, W. X., Wei, Z., & Wen, J.-R. (2023). A Survey on Large Language Model based Autonomous Agents.

[03] Qin, Y., Hu, S., Lin, Y., Chen, W., Ding, N., Cui, G., Zeng, Z., Huang, Y., Xiao, C., Han, C., Fung, Y. R., Su, Y., Wang, H., Qian, C., Tian, R., Zhu, K., Liang, S., Shen, X., Xu, B., … Sun, M. (2023). Tool Learning with Foundation Models. 1–75.

[04] Yao, S., Zhao, J., Yu, D., Du, N., Shafran, I., Narasimhan, K., & Cao, Y. (2022). ReAct: Synergizing Reasoning and Acting in Language Models. 1–33.

[05] Schick, T., Dwivedi-Yu, J., Dessì, R., Raileanu, R., Lomeli, M., Zettlemoyer, L., Cancedda, N., & Scialom, T. (2023). Toolformer: Language Models Can Teach Themselves to Use Tools.

[06] Qin, Y., Liang, S., Ye, Y., Zhu, K., Yan, L., Lu, Y., Lin, Y., Cong, X., Tang, X., Qian, B., Zhao, S., Tian, R., Xie, R., Zhou, J., Gerstein, M., Li, D., Liu, Z., & Sun, M. (2023). ToolLLM: Facilitating Large Language Models to Master 16000+ Real-world APIs. 4, 1–23.

「面向多目标专业电商RLHF」

[01] RLAIF: Scaling Reinforcement Learning from Human Feedback with AI Feedback(2023)

[02] Llama 2: Open Foundation and Fine-Tuned Chat Models (2023)

[03] Training language models to follow instructions with human feedback (2022)

如果您对命题感兴趣,请点击参与本次挑战,我们准备了丰厚的奖励。欢迎您参与!![]() http://请点击参与本次挑战,我们准备了丰厚的奖励。欢迎您参与!

http://请点击参与本次挑战,我们准备了丰厚的奖励。欢迎您参与!

1317

1317

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?