回归是指利用样本(已知数据),产生拟合方程,从而对(未知数据)进行预测。

用途:预测、判别合理性。

困难:①选定变量(多元);②避免多重共线性;③观察拟合方程,避免过度拟合;④检验模型的合理性。

因变量与自变量的关系:①相关关系(非确定性关系,比如物理与化学成绩相关性),使用相关系数衡量线性相关性的强弱;②函数关系(确定性关系)

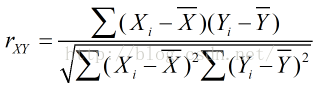

相关系数求解:Pearson样本积矩相关系数

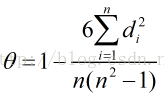

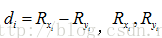

注意,如果样本是两组配对的顺序数据时,则采用Spearman等级相关系数(秩相关或名次相关)

公式中,

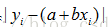

线性回归中最小二乘法的应用

判断直线拟合程度,如果是通过点向直线引垂线,由解析几何点到直线的距离公式可知,涉及到开方,这样不好求极值,所以改为由点向直线引竖直线求长度

线性回归用于预测和模型合理性检验,涉及变量选择、避免过度拟合和多重共线性问题。通过最小二乘法求解回归方程,适用于内插不擅长外推。多元线性回归关注判定系数、回归系数显著性及模型拟合程度。虚拟变量影响截距,逐步回归用于变量筛选。回归诊断包括正态性、离群值、线性合理性、误差假设及多重共线性检测,多重共线性可能导致模型不稳定。

线性回归用于预测和模型合理性检验,涉及变量选择、避免过度拟合和多重共线性问题。通过最小二乘法求解回归方程,适用于内插不擅长外推。多元线性回归关注判定系数、回归系数显著性及模型拟合程度。虚拟变量影响截距,逐步回归用于变量筛选。回归诊断包括正态性、离群值、线性合理性、误差假设及多重共线性检测,多重共线性可能导致模型不稳定。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1526

1526

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?