报告主题:大模型的推理能力究竟由什么决定

报告日期:1月31日(周三) 09:30-10:30

主题简介:

大模型的推理性能究竟由什么决定?以后的研究者如何设计思维链技术才能让大模型推理性能更好的提升?

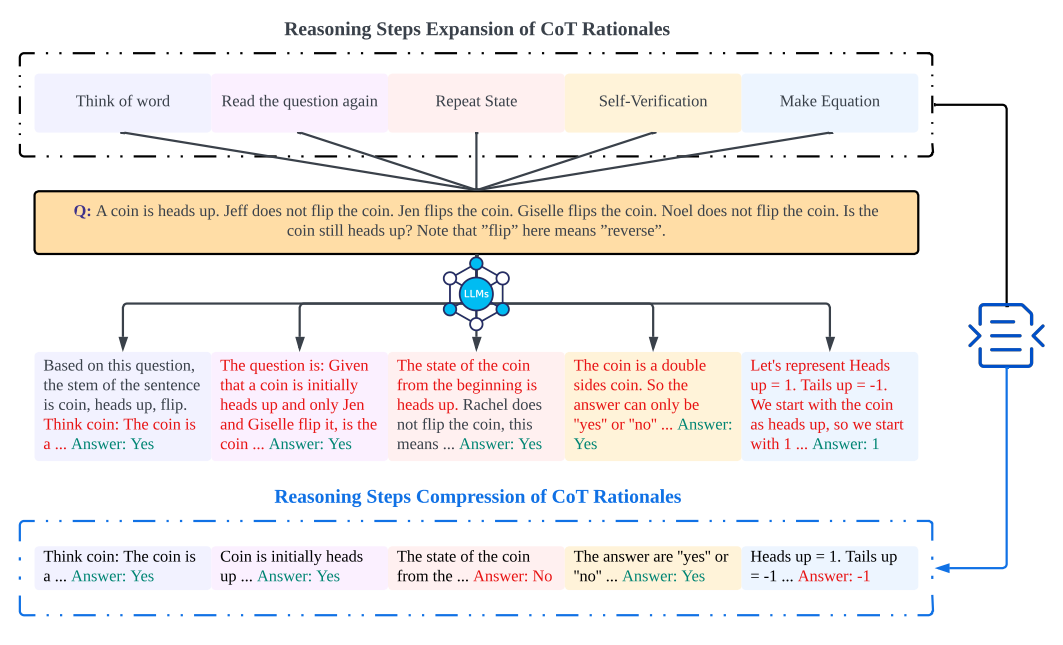

思想链(CoT)对于提高大型语言模型(LLM)的推理能力具有重要意义。然而,CoT 的有效性与提示中推理步骤的长度之间的相关性仍然很大程度上未知。为了阐明这一点,多家研究机构(西北大学、罗格斯大学、利物浦大学、新泽西理工学院)联合进行了研究并进行了几次实证实验来探索其中的关系。我们设计了扩展和压缩 CoT 的例子中的基本原理推理步骤的实验,同时保持所有其他因素不变,然后得到了一些很有趣的结论。

论文地址:https://arxiv.org/abs/2401.04925v1

对于few-shot COT,步数和准确性之间存在直接的线性相关:这为优化复杂推理中的 CoT 提示提供了一种可量化的方法。具体来说,延长提示中的推理步骤可以显着增强LLM跨多个数据集的推理能力。即使在保留关键信息的情况下,缩短推理步骤也会显着降低模型的推理能力。

如果保持必要的推理长度,即使是不正确的基本原理也可以产生有利的结果:例如,在数学问题等任务中,由于其面向过程的性质,中间数字的错误影响较小。

增加推理步骤的优点是依赖于任务的:更简单的任务需要更少的步骤,而更复杂的任务可以从更长的推理序列中获得显着的收益。

增加零样本 CoT 中的推理步骤也可以显着提高 LLM 准确性:为了验证这种方法,我们将最初的提示从“Let’s think step by step”更改为“Let’s think step by step, but you must think more step.” 这种修改导致大型模型的推理能力显着增强,在涉及数学问题的数据集中尤其明显。

我们进行了定量分析,以确定模型大小和增强模型推理能力所需的额外推理步骤数量之间的最佳平衡。

报告嘉宾:

金明宇,罗格斯大学新布朗斯维克博士生,导师是张永锋老师。

扫描下方二维码

或点击「阅读原文」报名

6

6

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?