UCORE实验8

实验目的

通过完成本次实验,希望能达到以下目标:

了解基本的文件系统系统调用的实现方法;

了解一个基于索引节点组织方式的Simple FS文件系统的设计与实现;

了解文件系统抽象层-VFS的设计与实现;

实验内容

实验七完成了在内核中的同步互斥实验。本次实验涉及的是文件系统,通过分析了解ucore文件系统的总体架构设计,完善读写文件操作,从新实现基于文件系统的执行程序机制(即改写do_execve),从而可以完成执行存储在磁盘上的文件和实现文件读写等功能。

练习0:填写已有实验

本实验依赖实验1/2/3/4/5/6/7。请把你做的实验1/2/3/4/5/6/7的代码填入本实验中代码中有“LAB1”/“LAB2”/“LAB3”/“LAB4”/“LAB5”/“LAB6” /“LAB7”的注释相应部分。并确保编译通过。注意:为了能够正确执行lab8的测试应用程序,可能需对已完成的实验1/2/3/4/5/6/7的代码进行进一步改进。

分析

本次实验无需修改代码,直接填写即可。

练习1: 完成读文件操作的实现(需要编码)

首先了解打开文件的处理流程,然后参考本实验后续的文件读写操作的过程分析,编写在sfs_inode.c中sfs_io_nolock读文件中数据的实现代码。

请在实验报告中给出设计实现"UNIX的PIPE机制"的概要设方案,鼓励给出详细设计方案。

分析

1.打开文件的处理流程

(1)ucore的文件系统

ucore的文件系统模型源于Havard的OS161的文件系统和Linux文件系统。但其实这二者都是源于传统的UNIX文件系统设计。UNIX提出了四个文件系统抽象概念:文件(file)、目录项(dentry)、索引节点(inode)和安装点(mount point)。

①文件:UNIX文件中的内容可理解为是一有序字节buffer,文件都有一个方便应用程序识别的文件名称(也称文件路径名)。典型的文件操作有读、写、创建和删除等。

②目录项:目录项不是目录,而是目录的组成部分。在UNIX中目录被看作一种特定的文件,而目录项是文件路径中的一部分。如一个文件路径名是“/test/testfile”,则包含的目录项为:根目录“/”,目录“test”和文件“testfile”,这三个都是目录项。一般而言,目录项包含目录项的名字(文件名或目录名)和目录项的索引节点(见下面的描述)位置。

③索引节点:UNIX将文件的相关元数据信息(如访问控制权限、大小、拥有者、创建时间、数据内容等等信息)存储在一个单独的数据结构中,该结构被称为索引节点。

④安装点:在UNIX中,文件系统被安装在一个特定的文件路径位置,这个位置就是安装点。所有的已安装文件系统都作为根文件系统树中的叶子出现在系统中。

上述抽象概念形成了UNIX文件系统的逻辑数据结构,并需要通过一个具体文件系统的架构设计与实现把上述信息映射并储存到磁盘介质上。一个具体的文件系统需要在磁盘布局也实现上述抽象概念。比如文件元数据信息存储在磁盘块中的索引节点上。当文件被载入内存时,内核需要使用磁盘块中的索引点来构造内存中的索引节点。

ucore模仿了UNIX的文件系统设计,ucore的文件系统架构主要由四部分组成:

①通用文件系统访问接口层:该层提供了一个从用户空间到文件系统的标准访问接口。这一层访问接口让应用程序能够通过一个简单的接口获得ucore内核的文件系统服务。

②文件系统抽象层:向上提供一个一致的接口给内核其他部分(文件系统相关的系统调用实现模块和其他内核功能模块)访问。向下提供一个同样的抽象函数指针列表和数据结构屏蔽不同文件系统的实现细节。

③Simple FS文件系统层:一个基于索引方式的简单文件系统实例。向上通过各种具体函数实现以对应文件系统抽象层提出的抽象函数。向下访问外设接口

④外设接口层:向上提供device访问接口屏蔽不同硬件细节。向下实现访问各种具体设备驱动的接口,比如disk设备接口/串口设备接口/键盘设备接口等。

对照上面的层次我们再大致介绍一下文件系统的访问处理过程,加深对文件系统的总体理解。假如应用程序操作文件(打开/创建/删除/读写),首先需要通过文件系统的通用文件系统访问接口层给用户空间提供的访问接口进入文件系统内部,接着由文件系统抽象层把访问请求转发给某一具体文件系统(比如SFS文件系统),具体文件系统(Simple FS文件系统层)把应用程序的访问请求转化为对磁盘上的block的处理请求,并通过外设接口层交给磁盘驱动例程来完成具体的磁盘操作。结合用户态写文件函数write的整个执行过程,我们可以比较清楚地看出ucore文件系统架构的层次和依赖关系。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-o5tD88I9-1679661130164)(https://objectkuan.gitbooks.io/ucore-docs/content/lab8_figs/image001.png)]

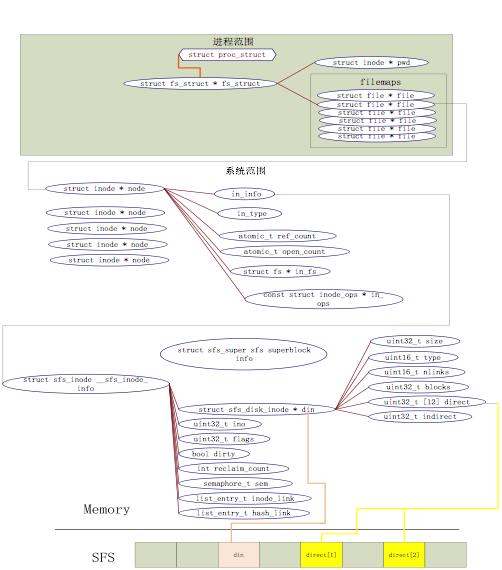

从ucore操作系统不同的角度来看,ucore中的文件系统架构包含四类主要的数据结构, 它们分别是:

①超级块(SuperBlock),它主要从文件系统的全局角度描述特定文件系统的全局信息。它的作用范围是整个OS空间。

②索引节点(inode):它主要从文件系统的单个文件的角度它描述了文件的各种属性和数据所在位置。它的作用范围是整个OS空间。

③目录项(dentry):它主要从文件系统的文件路径的角度描述了文件路径中的特定目录。它的作用范围是整个OS空间。

④文件(file),它主要从进程的角度描述了一个进程在访问文件时需要了解的文件标识,文件读写的位置,文件引用情况等信息。它的作用范围是某一具体进程。

此外,我们还需要某种分配记录的方法,可以采用空闲列表,也可以采用位图,在ucore中采用位图。一种用于数据区域,一种用inode表。S为超级块,i是inode bitmap,d是data bitmap磁盘布局如下:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Jr3OxcGJ-1679661130165)(https://tvax3.sinaimg.cn/large/a081fc05gy1h2zz4ulcl4j20jx04r74t.jpg)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-aT2WWADc-1679661130165)(https://tva1.sinaimg.cn/large/a081fc05gy1h2zz8l2e3fj20l6050755.jpg)]

如果一个用户进程打开了一个文件,那么在ucore中涉及的相关数据结构(其中相关数据结构将在下面各个小节中展开叙述)和关系如下图所示:

(2)打开文件

假定用户进程需要打开的文件已经存在在硬盘上。以user/sfs_filetest1.c为例,首先用户进程会调用在main函数中的如下语句:

int fd1 = safe_open("/test/testfile", O_RDWR | O_TRUNC);

如果ucore能够正常查找到这个文件,就会返回一个代表文件的文件描述符fd1,这样在接下来的读写文件过程中,就直接用这样fd1来代表就可以了。而打开文件的过程如下:

①通用文件访问接口层的处理流程

首先进入通用文件访问接口层的处理流程,即进一步调用如下用户态函数: open->sys_open->syscall,从而引起系统调用进入到内核态。到了内核态后,通过中断处理例程,会调用到sys_open内核函数,并进一步调用sysfile_open内核函数。到了这里,需要把位于用户空间的字符串"/test/testfile"拷贝到内核空间中的字符串path中,并进入到文件系统抽象层的处理流程完成进一步的打开文件操作中。

②文件系统抽象层的处理流程

分配一个空闲的file数据结构变量file在文件系统抽象层的处理中,首先调用的是file_open函数,它要给这个即将打开的文件分配一个file数据结构的变量,这个变量其实是当前进程的打开文件数组current->fs_struct->filemap[]中的一个空闲元素(即还没用于一个打开的文件),而这个元素的索引值就是最终要返回到用户进程并赋值给变量fd1。到了这一步还仅仅是给当前用户进程分配了一个file数据结构的变量,还没有找到对应的文件索引节点。

为此需要进一步调用vfs_open函数来找到path指出的文件所对应的基于inode数据结构的VFS索引节点node。vfs_open函数需要完成两件事情:通过vfs_lookup找到path对应文件的inode;调用vop_open函数打开文件。

找到文件设备的根目录“/”的索引节点需要注意,这里的vfs_lookup函数是一个针对目录的操作函数,它会调用vop_lookup函数来找到SFS文件系统中的“/test”目录下的“testfile”文件。为此,vfs_lookup函数首先调用get_device函数,并进一步调用vfs_get_bootfs函数(其实调用了)来找到根目录“/”对应的inode。这个inode就是位于vfs.c中的inode变量bootfs_node。这个变量在init_main函数(位于kern/process/proc.c)执行时获得了赋值。

找到根目录“/”下的“test”子目录对应的索引节点,在找到根目录对应的inode后,通过调用vop_lookup函数来查找“/”和“test”这两层目录下的文件“testfile”所对应的索引节点,如果找到就返回此索引节点。

把file和node建立联系。完成第3步后,将返回到file_open函数中,通过执行语句“file->node=node;”,就把当前进程的current->fs_struct->filemap[fd](即file所指变量)的成员变量node指针指向了代表“/test/testfile”文件的索引节点node。这时返回fd。经过重重回退,通过系统调用返回,用户态的syscall->sys_open->open->safe_open等用户函数的层层函数返回,最终把把fd赋值给fd1。自此完成了打开文件操作。但这里我们还没有分析第2和第3步是如何进一步调用SFS文件系统提供的函数找位于SFS文件系统上的“/test/testfile”所对应的sfs磁盘inode的过程。下面需要进一步对此进行分析。

③SFS文件系统层的处理流程

这里需要分析文件系统抽象层中没有彻底分析的vop_lookup函数到底做了啥。下面我们来看看。在sfs_inode.c中的sfs_node_dirops变量定义了“.vop_lookup = sfs_lookup”,所以我们重点分析sfs_lookup的实现。

sfs_lookup有三个参数:node,path,node_store。其中node是根目录“/”所对应的inode节点;path是文件“testfile”的绝对路径“/test/testfile”,而node_store是经过查找获得的“testfile”所对应的inode节点。

Sfs_lookup函数以“/”为分割符,从左至右逐一分解path获得各个子目录和最终文件对应的inode节点。在本例中是分解出“test”子目录,并调用sfs_lookup_once函数获得“test”子目录对应的inode节点subnode,然后循环进一步调用sfs_lookup_once查找以“test”子目录下的文件“testfile1”所对应的inode节点。当无法分解path后,就意味着找到了testfile1对应的inode节点,就可顺利返回了。

当然这里讲得还比较简单,sfs_lookup_once将调用sfs_dirent_search_nolock函数来查找与路径名匹配的目录项,如果找到目录项,则根据目录项中记录的inode所处的数据块索引值找到路径名对应的SFS磁盘inode,并读入SFS磁盘inode对的内容,创建SFS内存inode。

2.完成读文件操作的实现

(1)读文件的流程

读文件其实就是读出目录中的目录项,首先假定文件在磁盘上且已经打开。用户进程有如下语句:

read(fd, data, len);

即读取fd对应文件,读取长度为len,存入data中。下面来分析一下读文件的实现:

①通用文件访问接口层的处理流程

先进入通用文件访问接口层的处理流程,即进一步调用如下用户态函数:read->sys_read->syscall,从而引起系统调用进入到内核态。到了内核态以后,通过中断处理例程,会调用到sys_read内核函数,并进一步调用sysfile_read内核函数,进入到文件系统抽象层处理流程完成进一步读文件的操作。

②文件系统抽象层的处理流程

先是检查错误,即检查读取长度是否为0和文件是否可读。

然后分配buffer空间,即调用kmalloc函数分配4096字节的buffer空间。

最后读文件过程如下:

[1] 实际读文件

循环读取文件,每次读取buffer大小。每次循环中,先检查剩余部分大小,若其小于4096字节,则只读取剩余部分的大小。然后调用file_read函数(详细分析见后)将文件内容读取到buffer中,alen为实际大小。调用copy_to_user函数将读到的内容拷贝到用户的内存空间中,调整各变量以进行下一次循环读取,直至指定长度读取完成。最后函数调用层层返回至用户程序,用户程序收到了读到的文件内容。

[2] file_read函数

这个函数是读文件的核心函数。函数有4个参数,fd是文件描述符,base是缓存的基地址,len是要读取的长度,copied_store存放实际读取的长度。函数首先调用fd2file函数找到对应的file结构,并检查是否可读。调用filemap_acquire函数使打开这个文件的计数加1。调用vop_read函数将文件内容读到iob中(详细分析见后)。调整文件指针偏移量pos的值,使其向后移动实际读到的字节数iobuf_used(iob)。最后调用filemap_release函数使打开这个文件的计数减1,若打开计数为0,则释放file。

③SFS文件系统层的处理流程

vop_read函数实际上是对sfs_read的包装。在sfs_inode.c中sfs_node_fileops变量定义了.vop_read = sfs_read,所以下面来分析sfs_read函数的实现。

sfs_read函数调用sfs_io函数。它有三个参数,node是对应文件的inode,iob是缓存,write表示是读还是写的布尔值(0表示读,1表示写),这里是0。函数先找到inode对应sfs和sin,然后调用sfs_io_nolock函数进行读取文件操作,最后调用iobuf_skip函数调整iobuf的指针。

在sfs_io_nolock函数中,先计算一些辅助变量,并处理一些特殊情况(比如越界),然后有sfs_buf_op = sfs_rbuf,sfs_block_op = sfs_rblock,设置读取的函数操作。接着进行实际操作,先处理起始的没有对齐到块的部分,再以块为单位循环处理中间的部分,最后处理末尾剩余的部分。每部分中都调用sfs_bmap_load_nolock函数得到blkno对应的inode编号,并调用sfs_rbuf或sfs_rblock函数读取数据(中间部分调用sfs_rblock,起始和末尾部分调用sfs_rbuf),调整相关变量。完成后如果offset + alen > din->fileinfo.size(写文件时会出现这种情况,读文件时不会出现这种情况,alen为实际读写的长度),则调整文件大小为offset + alen并设置dirty变量。

sfs_bmap_load_nolock函数将对应sfs_inode的第index个索引指向的block的索引值取出存到相应的指针指向的单元(ino_store)。它调用sfs_bmap_get_nolock来完成相应的操作。sfs_rbuf和sfs_rblock函数最终都调用sfs_rwblock_nolock函数完成操作,而sfs_rwblock_nolock函数调用dop_io->disk0_io->disk0_read_blks_nolock->ide_read_secs完成对磁盘的操作。

(2)读文件的实现

由于我们的读操作,都是要对最基础的块进行操作,因此要用到sfs_io_nolock函数。

在sfs_io_nolock函数中,先计算一些辅助变量,并处理一些特殊情况(比如越界),然后有sfs_buf_op = sfs_rbuf,sfs_block_op = sfs_rblock,设置读取的函数操作。接着进行实际操作,先处理起始的没有对齐到块的部分,再以块为单位循环处理中间的部分,最后处理末尾剩余的部分。每部分中都调用sfs_bmap_load_nolock函数得到blkno对应的inode编号,并调用sfs_rbuf或sfs_rblock函数读取数据(中间部分调用sfs_rblock,起始和末尾部分调用sfs_rbuf),调整相关变量。完成后如果offset + alen > din->fileinfo.size(写文件时会出现这种情况,读文件时不会出现这种情况,alen为实际读写的长度),则调整文件大小为offset + alen并设置dirty变量。

/*

* sfs_io_nolock - Rd/Wr a file contentfrom offset position to offset+ length disk blocks<-->buffer (in memroy)

* @sfs: sfs file system

* @sin: sfs inode in memory

* @buf: the buffer Rd/Wr

* @offset: the offset of file

* @alenp: the length need to read (is a pointer). and will RETURN the really Rd/Wr lenght

* @write: BOOL, 0 read, 1 write

*/

static int

sfs_io_nolock(struct sfs_fs *sfs, struct sfs_inode *sin, void *buf, off_t offset, size_t *alenp, bool write) {

// 创建一个磁盘索引节点指向要访问文件的内存索引节点

struct sfs_disk_inode *din = sin->din;

assert(din->type != SFS_TYPE_DIR);

// 确定读取的结束位置

off_t endpos = offset + *alenp, blkoff;

*alenp = 0;

// calculate the Rd/Wr end position;计算缓冲区读取/写入的终止位置,即处理越界等情况

if (offset < 0 || offset >= SFS_MAX_FILE_SIZE || offset > endpos) {

return -E_INVAL;

}

// 如果偏移与终止位置相同,即读取/写入0字节的数据,直接返回

if (offset == endpos) {

return 0;

}

if (endpos > SFS_MAX_FILE_SIZE) {

endpos = SFS_MAX_FILE_SIZE;

}

// 读取数据

if (!write) {

if (offset >= din->size) { // 缓冲区中剩余的数据超出一个硬盘索引节点的数据大小,直接返回0

return 0;

}

if (endpos > din->size) {

endpos = din->size;

}

}

// 根据不同的执行函数,设置对应的函数指针

int (*sfs_buf_op)(struct sfs_fs *sfs, void *buf, size_t len, uint32_t blkno, off_t offset);

int (*sfs_block_op)(struct sfs_fs *sfs, void *buf, uint32_t blkno, uint32_t nblks);

if (write) {

sfs_buf_op = sfs_wbuf, sfs_block_op = sfs_wblock; // 如果是写

}

else {

sfs_buf_op = sfs_rbuf, sfs_block_op = sfs_rblock; // 如果是读

}

int ret = 0;

size_t size, alen = 0;

uint32_t ino;

uint32_t blkno = offset / SFS_BLKSIZE; // The NO. of Rd/Wr begin block;

uint32_t nblks = endpos / SFS_BLKSIZE - blkno; // The size of Rd/Wr blocks

//LAB8:EXERCISE1 202008010404 HINT: call sfs_bmap_load_nolock, sfs_rbuf, sfs_rblock,etc. read different kind of blocks in file

/*

* (1) If offset isn't aligned with the first block, Rd/Wr some content from offset to the end of the first block

* NOTICE: useful function: sfs_bmap_load_nolock, sfs_buf_op

* Rd/Wr size = (nblks != 0) ? (SFS_BLKSIZE - blkoff) : (endpos - offset)

* (2) Rd/Wr aligned blocks

* NOTICE: useful function: sfs_bmap_load_nolock, sfs_block_op

* (3) If end position isn't aligned with the last block, Rd/Wr some content from begin to the (endpos % SFS_BLKSIZE) of the last block

* NOTICE: useful function: sfs_bmap_load_nolock, sfs_buf_op

*/

// 对齐偏移。如果偏移没有对齐第一个基础块,则多读取/写入第一个基础块的末尾数据

if ((blkoff = offset % SFS_BLKSIZE) != 0) { // blkoff为第一块数据块中进行操作的偏移量

size = (nblks != 0) ? (SFS_BLKSIZE - blkoff) : (endpos - offset); // 第一块数据块中进行操作的数据长度

// 获取第一个基础块所对应的block的编号ino

if ((ret = sfs_bmap_load_nolock(sfs, sin, blkno, &ino)) != 0) {

goto out; // 找到内存文件索引对应的 block 的编号 ino

}

// 通过上一步取出的ino,读取/写入一部分第一个基础块的末尾数据

if ((ret = sfs_buf_op(sfs, buf, size, ino, blkoff)) != 0) {

goto out;

}

// 已经完成读写的数据长度

alen += size;

if (nblks == 0) {

goto out;

}

buf += size, blkno ++, nblks --;

}

// 以块为单位循环处理中间的部分,循环读取/写入对齐好的数据

size = SFS_BLKSIZE;

while (nblks != 0) {

// 获取inode对应的基础块编号

if ((ret = sfs_bmap_load_nolock(sfs, sin, blkno, &ino)) != 0) {

goto out;

}

// 单次读取/写入一基础块的数据

if ((ret = sfs_block_op(sfs, buf, ino, 1)) != 0) {

goto out;

}

alen += size, buf += size, blkno ++, nblks --;

}

// 如果末尾位置没有与最后一个基础块对齐,则多读取/写入一点末尾基础块的数据

if ((size = endpos % SFS_BLKSIZE) != 0) {

if ((ret = sfs_bmap_load_nolock(sfs, sin, blkno, &ino)) != 0) {

goto out;

}

if ((ret = sfs_buf_op(sfs, buf, size, ino, 0)) != 0) {

goto out;

}

alen += size;

}

out:

*alenp = alen;

if (offset + alen > sin->din->size) {

sin->din->size = offset + alen;

sin->dirty = 1;

}

return ret;

}

给出设计实现"UNIX的PIPE机制"的概要方案

(1)管道机制

管道是一种最基本的IPC机制,作用于有血缘关系的进程之间,完成数据传递。调用pipe系统函数即可创建一个管道。有如下特质:

①其本质是一个伪文件(实为内核缓冲区)

②由两个文件描述符引用,一个表示读端,一个表示写端。

③规定数据从管道的写端流入管道,从读端流出。

管道的原理: 管道实为内核使用环形队列机制,借助内核缓冲区(4k)实现。

管道的局限性:

①数据自己读不能自己写。

②数据一旦被读走,便不在管道中存在,不可反复读取。

③由于管道采用半双工通信方式。因此,数据只能在一个方向上流动。

④只能在有公共祖先的进程间使用管道。

(2)设计方案

基于以上描述,可以考虑在磁盘上保留一部分空间件来作为pipe机制的缓冲区:

①当某两个进程之间要求建立管道,假定将进程A的标准输出作为进程B的标准输入,那么可以在这两个进程的进程控制块上新增变量来记录进程的这种属性;并且同时生成一个临时的文件,并将其在进程A,B中打开;

②当进程A使用标准输出进行write系统调用的时候,通过PCB中的变量可以知道,需要将这些标准输出的数据输出到先前提高的临时文件中去;

③当进程B使用标准输入的时候进行read系统调用的时候,根据其PCB中的信息可以知道,需要从上述的临时文件中读取数据;

④至此完成了对pipe机制的设计。

事实上,由于在真实的文件系统和用户之间还由一层虚拟文件系统,在磁盘上实现这些操作效率是十分低下的。因此我们可以把数据直接保存在内存中,并根据文件系统规范,在内存中建立虚拟pipe缓冲区域文件来代替磁盘上的缓冲文件,这样便可大大提高通信速率。

练习2: 完成基于文件系统的执行程序机制的实现(需要编码)

改写proc.c中的load_icode函数和其他相关函数,实现基于文件系统的执行程序机制。执行:make qemu。如果能看看到sh用户程序的执行界面,则基本成功了。如果在sh用户界面上可以执行"ls","hello"等其他放置在sfs文件系统中的其他执行程序,则可以认为本实验基本成功。

请在实验报告中给出设计实现基于"UNIX的硬链接和软链接机制"的概要方案,鼓励给出详细设计方案

分析

1.完成基于文件系统的执行程序机制

首先打开proc.c文件,根据注释改写其中一些在之前实验中已经完善了的代码。

alloc_proc这个函数只需要补充一个struct files_struct *filesp的初始化即可:

// alloc_proc - alloc a proc_struct and init all fields of proc_struct

static struct proc_struct *

alloc_proc(void) {

struct proc_struct *proc = kmalloc(sizeof(struct proc_struct));

if (proc != NULL) {

proc->state = PROC_UNINIT;

proc->pid = -1;

proc->runs = 0;

proc->kstack = 0;

proc->need_resched = 0;

proc->parent = NULL;

proc->mm = NULL;

memset(&(proc->context), 0, sizeof(struct context));

proc->tf = NULL;

proc->cr3 = boot_cr3;

proc->flags = 0;

memset(proc->name, 0, PROC_NAME_LEN);

proc->wait_state = 0;

proc->cptr = proc->optr = proc->yptr = NULL;

proc->rq = NULL;

list_init(&(proc->run_link));

proc->time_slice = 0;

proc->lab6_run_pool.left = proc->lab6_run_pool.right = proc->lab6_run_pool.parent = NULL;

proc->lab6_stride = 0;

proc->lab6_priority = 0;

//LAB8:EXERCISE2 202008010404 HINT:need add some code to init fs in proc_struct, ...

proc->filesp = NULL;

}

return proc;

}

fork机制在原先lab7的基础上,多了file_struct结构的复制操作与执行失败时的重置操作。这两部操作分别需要调用copy_files和put_files函数

/* do_fork - parent process for a new child process

* @clone_flags: used to guide how to clone the child process

* @stack: the parent's user stack pointer. if stack==0, It means to fork a kernel thread.

* @tf: the trapframe info, which will be copied to child process's proc->tf

*/

int

do_fork(uint32_t clone_flags, uintptr_t stack, struct trapframe *tf) {

int ret = -E_NO_FREE_PROC;

struct proc_struct *proc;

if (nr_process >= MAX_PROCESS) {

goto fork_out;

}

ret = -E_NO_MEM;

//LAB8:EXERCISE2 202008010404 HINT:how to copy the fs in parent's proc_struct?

if ((proc = alloc_proc()) == NULL) {

goto fork_out;

}

proc->parent = current;

assert(current->wait_state == 0);

if (setup_kstack(proc) != 0) {

goto bad_fork_cleanup_proc;

}

//lab8新增,将当前进程的fs复制到fork出的进程中

if (copy_fs(clone_flags, proc) != 0) { //for LAB8

goto bad_fork_cleanup_kstack;

}

if (copy_mm(clone_flags, proc) != 0) { //for LAB8

goto bad_fork_cleanup_fs;

}

copy_thread(proc, stack, tf);

bool intr_flag;

local_intr_save(intr_flag);

{

proc->pid = get_pid();

hash_proc(proc);

set_links(proc);

}

local_intr_restore(intr_flag);

wakeup_proc(proc);

ret = proc->pid;

fork_out:

return ret;

//如果复制失败,则需要重置原先的操作

bad_fork_cleanup_fs: //for LAB8

put_files(proc);

bad_fork_cleanup_kstack:

put_kstack(proc);

bad_fork_cleanup_proc:

kfree(proc);

goto fork_out;

}

load_icode函数在lab5中出现过,当时要我们=设置正确的trapframe内容,使得在执行中断返回指令“iret”后,能够让CPU转到用户态特权级。彼时,读取可执行文件时是直接读取内存的,但在这里需要使用函数load_icode_read来从文件系统中读取ELF header以及各个段的数据。并且原先的load_icode函数中并没有对execve所执行的程序传入参数,在lab8中需要完善。

// load_icode - called by sys_exec-->do_execve

static int

load_icode(int fd, int argc, char **kargv) {

/* LAB8:EXERCISE2 202008010404 HINT:how to load the file with handler fd in to process's memory? how to setup argc/argv?

* MACROs or Functions:

* mm_create - create a mm

* setup_pgdir - setup pgdir in mm

* load_icode_read - read raw data content of program file

* mm_map - build new vma

* pgdir_alloc_page - allocate new memory for TEXT/DATA/BSS/stack parts

* lcr3 - update Page Directory Addr Register -- CR3

*/

/* (1) create a new mm for current process

* (2) create a new PDT, and mm->pgdir= kernel virtual addr of PDT

* (3) copy TEXT/DATA/BSS parts in binary to memory space of process

* (3.1) read raw data content in file and resolve elfhdr

* (3.2) read raw data content in file and resolve proghdr based on info in elfhdr

* (3.3) call mm_map to build vma related to TEXT/DATA

* (3.4) callpgdir_alloc_page to allocate page for TEXT/DATA, read contents in file

* and copy them into the new allocated pages

* (3.5) callpgdir_alloc_page to allocate pages for BSS, memset zero in these pages

* (4) call mm_map to setup user stack, and put parameters into user stack

* (5) setup current process's mm, cr3, reset pgidr (using lcr3 MARCO)

* (6) setup uargc and uargv in user stacks

* (7) setup trapframe for user environment

* (8) if up steps failed, you should cleanup the env.

*/

assert(argc >= 0 && argc <= EXEC_MAX_ARG_NUM);

if (current->mm != NULL) {

panic("load_icode: current->mm must be empty.\n");

}

int ret = -E_NO_MEM;

struct mm_struct *mm;

if ((mm = mm_create()) == NULL) {

goto bad_mm;

}

if (setup_pgdir(mm) != 0) {

goto bad_pgdir_cleanup_mm;

}

struct Page *page;

// lab8,从文件中读取elf header,而不是从内存中读取

struct elfhdr __elf, *elf = &__elf;

if ((ret = load_icode_read(fd, elf, sizeof(struct elfhdr), 0)) != 0) {

goto bad_elf_cleanup_pgdir;

}

// 根据幻数来判断读入的elf header是否正确

if (elf->e_magic != ELF_MAGIC) {

ret = -E_INVAL_ELF;

goto bad_elf_cleanup_pgdir;

}

struct proghdr __ph, *ph = &__ph;

uint32_t vm_flags, perm, phnum;

for (phnum = 0; phnum < elf->e_phnum; phnum ++) {

// lab8,从文件特定偏移处读取每个段的详细信息(包括大小、基地址等等)

off_t phoff = elf->e_phoff + sizeof(struct proghdr) * phnum;

if ((ret = load_icode_read(fd, ph, sizeof(struct proghdr), phoff)) != 0) {

goto bad_cleanup_mmap;

}

if (ph->p_type != ELF_PT_LOAD) {

continue ;

}

if (ph->p_filesz > ph->p_memsz) {

ret = -E_INVAL_ELF;

goto bad_cleanup_mmap;

}

if (ph->p_filesz == 0) {

continue ;

}

vm_flags = 0, perm = PTE_U;

if (ph->p_flags & ELF_PF_X) vm_flags |= VM_EXEC;

if (ph->p_flags & ELF_PF_W) vm_flags |= VM_WRITE;

if (ph->p_flags & ELF_PF_R) vm_flags |= VM_READ;

if (vm_flags & VM_WRITE) perm |= PTE_W;

if ((ret = mm_map(mm, ph->p_va, ph->p_memsz, vm_flags, NULL)) != 0) {

goto bad_cleanup_mmap;

}

off_t offset = ph->p_offset;

size_t off, size;

uintptr_t start = ph->p_va, end, la = ROUNDDOWN(start, PGSIZE);

ret = -E_NO_MEM;

end = ph->p_va + ph->p_filesz;

while (start < end) {

if ((page = pgdir_alloc_page(mm->pgdir, la, perm)) == NULL) {

ret = -E_NO_MEM;

goto bad_cleanup_mmap;

}

off = start - la, size = PGSIZE - off, la += PGSIZE;

if (end < la) {

size -= la - end;

}

// lab8,读取elf对应段内的数据并写入至该内存中

if ((ret = load_icode_read(fd, page2kva(page) + off, size, offset)) != 0) {

goto bad_cleanup_mmap;

}

start += size, offset += size;

}

end = ph->p_va + ph->p_memsz;

if (start < la) {

/* ph->p_memsz == ph->p_filesz */

if (start == end) {

continue ;

}

off = start + PGSIZE - la, size = PGSIZE - off;

if (end < la) {

size -= la - end;

}

memset(page2kva(page) + off, 0, size);

start += size;

assert((end < la && start == end) || (end >= la && start == la));

}

while (start < end) {

if ((page = pgdir_alloc_page(mm->pgdir, la, perm)) == NULL) {

ret = -E_NO_MEM;

goto bad_cleanup_mmap;

}

off = start - la, size = PGSIZE - off, la += PGSIZE;

if (end < la) {

size -= la - end;

}

memset(page2kva(page) + off, 0, size);

start += size;

}

}

sysfile_close(fd);

vm_flags = VM_READ | VM_WRITE | VM_STACK;

if ((ret = mm_map(mm, USTACKTOP - USTACKSIZE, USTACKSIZE, vm_flags, NULL)) != 0) {

goto bad_cleanup_mmap;

}

assert(pgdir_alloc_page(mm->pgdir, USTACKTOP-PGSIZE , PTE_USER) != NULL);

assert(pgdir_alloc_page(mm->pgdir, USTACKTOP-2*PGSIZE , PTE_USER) != NULL);

assert(pgdir_alloc_page(mm->pgdir, USTACKTOP-3*PGSIZE , PTE_USER) != NULL);

assert(pgdir_alloc_page(mm->pgdir, USTACKTOP-4*PGSIZE , PTE_USER) != NULL);

mm_count_inc(mm);

current->mm = mm;

current->cr3 = PADDR(mm->pgdir);

lcr3(PADDR(mm->pgdir));

//setup argc, argv

//lab8,设置execve所启动的程序参数

uint32_t argv_size=0, i;

for (i = 0; i < argc; i ++) {

argv_size += strnlen(kargv[i],EXEC_MAX_ARG_LEN + 1)+1;

}

uintptr_t stacktop = USTACKTOP - (argv_size/sizeof(long)+1)*sizeof(long);

char** uargv=(char **)(stacktop - argc * sizeof(char *));

argv_size = 0;

for (i = 0; i < argc; i ++) {

uargv[i] = strcpy((char *)(stacktop + argv_size ), kargv[i]);

argv_size += strnlen(kargv[i],EXEC_MAX_ARG_LEN + 1)+1;

}

stacktop = (uintptr_t)uargv - sizeof(int);

*(int *)stacktop = argc;

struct trapframe *tf = current->tf;

memset(tf, 0, sizeof(struct trapframe));

tf->tf_cs = USER_CS;

tf->tf_ds = tf->tf_es = tf->tf_ss = USER_DS;

tf->tf_esp = stacktop;

tf->tf_eip = elf->e_entry;

tf->tf_eflags = FL_IF;

ret = 0;

out:

return ret;

bad_cleanup_mmap:

exit_mmap(mm);

bad_elf_cleanup_pgdir:

put_pgdir(mm);

bad_pgdir_cleanup_mm:

mm_destroy(mm);

bad_mm:

goto out;

}

2.实现基于"UNIX的硬链接和软链接机制"的概要方案

(1)硬链接和软连接

在前文,我们已经大概介绍了文件系统。基于此,我们先来介绍一下硬链接和软链接。

首先,链接简单来说就是一种文件共享的方式,是POSIX中的概念,在共享文件和访问用户的若干目录项之间建立联系,主流文件系统都支持链接文件。

我们查看vfs.h可以看到链接相关的它给出如下定义:

/*

* VFS layer high-level operations on pathnames

* vfs_link - Create a hard link to a file.

* vfs_symlink - Create a symlink PATH containing contents CONTENTS.

* vfs_readlink - Read contents of a symlink into a uio.

* vfs_unlink - Delete a file/directory.

*

*/

int vfs_link(char *old_path, char *new_path); //硬链接

int vfs_symlink(char *old_path, char *new_path); //软链接

int vfs_readlink(char *path, struct iobuf *iob); //读取软链接到一个uio(内核驱动)中

int vfs_unlink(char *path);

硬链接:当创建一个文件或是目录的硬链接时就是在目录里面创建一个新的目录项,目录项的名字和原来被连接的对象名字不同,但是inode结点的值是一样的。硬链接的文件内容与创建时指向的源文件一模一样,把源文件删除,不会影响硬链接文件。

软链接:创建的新的目录项的名字和inode值和原来的对象都不一样。软链接其本身就是一个文件,它存放着另外一个路径的文件,如果把源文件删除,那么软链接就找不到源文件了,也就访问不了了。

(2)硬链接和软连接的实现

硬链接机制的实现:

①创建硬链接时,仍然为new_path建立一个sfs_disk_entry结构,但该结构的内部ino成员指向old_path的磁盘索引结点,并使该磁盘索引节点的nlinks引用计数成员加一即可。

②删除硬链接时,令对应磁盘结点sfs_disk_inode中的nlinks减一,同时删除硬链接的sfs_disk_entry结构即可。

软链接的实现:

①与创建硬链接不同,创建软链接时要多建立一个sfs_disk_inode结构(即建立一个全新的文件)。之后,将old_path写入该文件中,并标注sfs_disk_inode的type为SFS_TYPE_LINK即可。

②删除软链接与删除文件的操作没有区别,直接将对应的sfs_disk_entry和sfs_disk_inode结构删除即可。

实验心得

与实验七相比,实验八增加了文件系统,并因此实现了通过文件系统来加载可执行文件到内存中运行的功能,导致对进程管理相关的实现比较大的调整。首先是kern_init函数,可以发现与lab7相比增加了对fs_init函数的调用。fs_init函数就是文件系统初始化的总控函数,它进一步调用了虚拟文件系统初始化函数vfs_init,与文件相关的设备初始化函数dev_init和Simple FS文件系统的初始化函数sfs_init。这三个初始化函数联合在一起,协同完成了整个虚拟文件系统、SFS文件系统和文件系统对应的设备(键盘、串口、磁盘)的初始化工作。

vfs_init主要建立了一个device list双向链表vdev_list,为后续具体设备(键盘、串口、磁盘)以文件的形式呈现建立查找访问通道。dev_init函数通过进一步调用disk0/stdin/stdout_device_init完成对具体设备的初始化,把它们抽象成一个设备文件,并建立对应的inode数据结构,最后把它们链入到vdev_list中。这样通过虚拟文件系统就可以方便地以文件的形式访问这些设备了。sfs_init是完成对Simple FS的初始化工作,并把此实例文件系统挂在虚拟文件系统中,从而让ucore的其他部分能够通过访问虚拟文件系统的接口来进一步访问到SFS实例文件系统。

1368

1368

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?