作者 | 迪西 编辑 | 自动驾驶之心

原文链接:https://zhuanlan.zhihu.com/p/1640361503

点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

本文只做学术分享,如有侵权,联系删文

研究背景

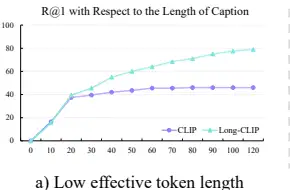

研究问题:这篇文章要解决的问题是CLIP模型在处理长文本输入时的局限性。CLIP模型的文本输入长度被限制在77个标记以内,实际有效长度甚至小于20个标记,这限制了其在处理详细描述时的能力,特别是在图像检索和文本到图像生成任务中。

研究难点:该问题的研究难点包括:简单地微调CLIP会导致其性能显著下降;用支持更长上下文的语言模型替换文本编码器需要大量数据预训练,成本高昂。

相关工作:CLIP模型基于对比学习,广泛应用于零样本分类、文本图像检索和文本到图像生成任务。然而,CLIP缺乏提取细粒度信息的能力,现有工作通过对齐输入文本和图像的完整区域来改进这一点,但仍未能充分捕捉长文本中的细节信息。

研究方法

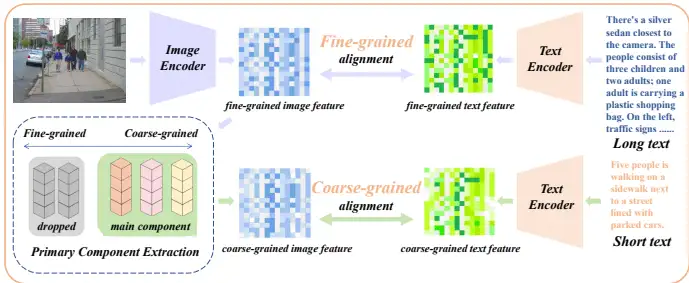

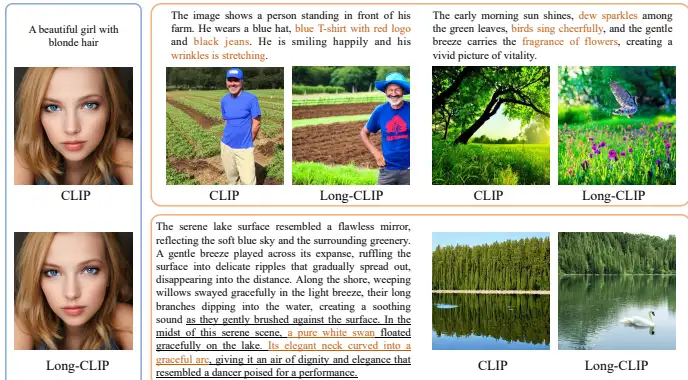

这篇论文提出了Long-CLIP作为CLIP的插件式替代方案,支持长文本输入,保持甚至超越CLIP的零样本泛化能力,并对齐CLIP潜在空间。具体来说,Long-CLIP引入了两种新颖的策略来实现这一目标:知识保留的位置嵌入拉伸和CLIP特征的主要成分匹配。

知识保留的位置嵌入拉伸:

通过对CLIP的实际有效长度进行实证研究,发现其有效长度仅为20个标记。

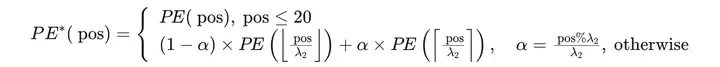

保留前20个训练良好的位置嵌入,并对剩余的57个训练不足的位置嵌入进行更大比例的插值。

插值公式如下:

其中,PE(pos)表示第 posth 位置的位置嵌入,α 是一个0到1之间的比率,决定插值后的位置嵌入是更接近前一个位置还是后一个位置。

主要成分匹配:

在长文本微调过程中,不仅对齐细粒度的图像特征与长详细标题,还从细粒度图像特征中提取粗粒度信息,并与短摘要标题对齐。

设计了三个核心模块:组件分解函数 FF、组件过滤函数 EE 和组件重构函数 F−1F−1。

组件分解函数 FF 将特征分解为多个表示不同属性的向量,并分析每个属性的重要性。

组件过滤函数 EE 基于属性的重要性过滤掉不重要的属性。

组件重构函数 F−1F−1 使用选定的关键属性向量和其重要性重构图像特征。

实验设计

数据集:使用ShareGPT4V数据集作为训练数据,包含约100万个(长文本,图像)对。随机分离出1k个数据作为评估数据集。

评估数据集:在零样本图像分类任务中使用ImageNet-1K、ImageNet-V2、ImageNet-O、CIFAR-10和CIFAR-100数据集。在短文本图像检索任务中使用COCO2017和Flickr30k数据集。在长文本图像检索任务中使用从ShareGPT4V数据集中分离的随机1k个(图像,长文本)对,并手动收集200个描述城市场景的相似图像,使用GPT-4V生成长文本标题。

训练设置:在ShareGPT4V数据集上微调1个epoch,批量大小为2048。

结果与分析

长文本图像检索:在1k ShareGPT4V验证集和Urban-200数据集上,Long-CLIP在长文本图像检索任务中的召回率分别提高了25%和6%。

短文本图像检索:在COCO2017的5k验证集和Flickr30k的整个30k数据集上,Long-CLIP在短文本图像检索任务中的R@1分别提高了6%和7%。

零样本图像分类:在五个验证集上,Long-CLIP的零样本分类准确率没有显著下降。

图像生成:Long-CLIP在Stable Diffusion模型中替换CLIP文本编码器后,能够无缝集成并增强长文本生成能力。

总体结论

这篇论文提出了Long-CLIP,一种具有长文本能力的强大且灵活的CLIP模型。Long-CLIP支持长达248个标记的文本输入,并在检索任务中显著提高了性能。此外,Long-CLIP保持了零样本分类的性能,并可以在图像生成任务中以插件方式替换CLIP编码器。尽管存在输入标记长度的上限,但通过大量数据的利用,模型的扩展潜力巨大。

优点与创新

长文本输入支持:Long-CLIP通过知识保留的位置嵌入拉伸和主要成分匹配策略,实现了对长文本输入的支持,显著提高了长文本图像检索和传统文本图像检索任务的性能。

零样本泛化能力:Long-CLIP在保持CLIP的零样本泛化能力的同时,扩展了其输入长度,显示出其在各种基准测试中的优越性。

无缝替换CLIP:Long-CLIP与CLIP的潜在空间对齐,使得在不进行任何下游框架进一步适应的情况下,可以轻松替换CLIP。

高效微调:通过仅使用额外的一百万对长文本-图像对进行0.25小时的8 GPUs训练,Long-CLIP实现了高效的微调。

增强的图像生成能力:Long-CLIP通过替换CLIP的文本编码器,以即插即用的方式提供了从详细文本描述生成图像的增强能力。

新的评估数据集:提出了用于评估长文本细粒度能力的Urban-200数据集,并进一步扩展到Urban-1k数据集。

『自动驾驶之心知识星球』欢迎加入交流!重磅,自动驾驶之心科研论文辅导来啦,申博、CCF系列、SCI、EI、毕业论文、比赛辅导等多个方向,欢迎联系我们!

① 全网独家视频课程

端到端自动驾驶、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

② 国内首个自动驾驶学习社区

国内外最大最专业,近4000人的交流社区,已得到大多数自动驾驶公司的认可!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(端到端自动驾驶、世界模型、仿真闭环、2D/3D检测、语义分割、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦感知、定位、融合、规控、标定、端到端、仿真、产品经理、自动驾驶开发、自动标注与数据闭环多个方向,目前近60+技术交流群,欢迎加入!扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】全平台矩阵

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?