点击下方卡片,关注“具身智能之心”公众号

作者 | 具身智能之心 编辑 | 具身智能之心

本文只做学术分享,如有侵权,联系删文

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

想象一下,一位经验丰富的登山者行走在蜿蜒的山路上,脚下的草地中混杂着碎石,身旁有大片茂密的灌木丛。或许连他自己都没有意识到,每一步行走时他的大脑都在飞速运转,判断下一个落脚点是否稳固,评估迈出去的步伐会不会失去平衡。对登山者而言,这不是简单的“左脚右脚”重复动作,而是像一场精密的舞蹈,融合了经验、直觉和环境的实时反馈,又稳又快地向前行走。

你是否会好奇,当四足机器人在崎岖不平的地面上以不同姿态行走时,它究竟是如何保持平稳的呢?实际上,它的控制系统就像这位登山者的“智慧大脑”一样,每一秒都在根据地面状况来精确计算每一个机械关节究竟需要“用多大的力”以“多大的速度”运转。这些计算和决策充满挑战,要求它在极短的时间内完成精准的判断,让每一步都踏得稳,跑得快,最终构成我们所看到的机械狗的流畅动作。

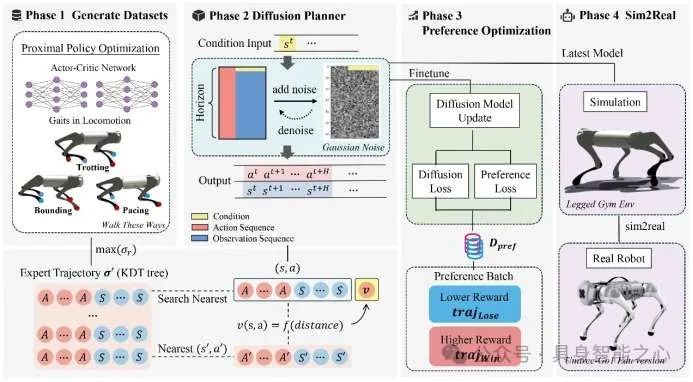

近期,中国电信人工智能研究院(TeleAI)研究科学家白辰甲博士与香港科技大学(广州)朱美新助理教授联合提出了一种名为“偏好对齐扩散规划器”的方法,通过将离线学习和在线偏好优化相结合,对扩散模型(Diffusion Model)驱动的四足机器人控制问题进行了深入研究,提出的两阶段学习框架结合了离线和在线学习的优势。首先,在离线阶段,扩散规划器通过学习状态-动作序列的联合分布,从其他策略收集的离线数据集中进行训练。随后,通过与环境的在线交互和偏好对齐技术,有效缓解了离线数据分布外(OOD)样本对策略影响,提升了控制算法的鲁棒性。这一算法不仅节省了传统在线强化学习的时间成本和运算资源,还显著提高了机器人的稳定性和速度跟踪能力。同时,实现了模拟与现实(sim-to-real)之间的零样本迁移(zero-shot transfer),使得机器人在不同地形下的表现更加出色。香港科技大学(广州)研究生袁欣怡和尚致违是论文的共同第一作者。

论文名称:Preference Aligned Diffusion Planner for Quadrupedal Locomotion Control

论文链接:https://arxiv.org/abs/2410.13586

项目地址:https://shangjaven.github.io/preference-aligned-diffusion-legged/

研究动机

构建具备通用性和高鲁棒性的四足机器人运动控制策略是机器人学中的一个长期挑战。随着扩散模型在大规模数据中表现出强大的生成能力,它在四足机器人控制任务中的应用变得愈发引人关注。扩散模型能够从复杂的状态-动作分布中学习,从而提供灵活的决策策略。然而,仅依赖离线数据训练的策略存在显著局限性,尤其在数据集状态覆盖不足的情况下,模型对样本外状态(OOD Samples)往往表现出较强的敏感性,难以在真实环境中有效应对多样的动态变化。此外,其他则研究通过收集在线轨迹来对原始策略进行更新,但是这类方法依赖于和专家策略进行实时交互或是对奖励进行在线采样,仍需要较高的计算资源。

本研究提出了一种创新的两阶段学习框架,巧妙地结合了离线策略学习与在线偏好优化,以提升四足机器人在不同地形下的稳健表现。在离线学习阶段,扩散规划器从其他专家策略收集的离线数据中学习状态-动作序列的联合分布,而这一过程并不依赖奖励标签。接下来的在线阶段,我们运用偏好对齐技术,来有效缓解样本外数据所带来的不良影响,进而提高策略的鲁棒性。本方法可以有效利用构建的弱偏好标签,以构建不依赖真实奖励信号的偏好数据集,从而在模型的偏好一致性上实现显著提升。最终,在在线优化阶段中,仅需少量的在线交互数据便可在多种步态下实现优异的稳定性和速度跟踪性能,并能在真实的四足机器人测试中展现出稳定性和优异的性能。

内容出自国内首个具身智能全栈学习社区:具身智能之心知识星球,这里包含所有你想要的。

研究方法

本研究首先利用专家PPO策略在多步态策略学习框架“walk-these-ways”构建的仿真环境中收集离线数据集,涵盖了不同步态的状态和动作序列。在获得离线数据集后,通过行为克隆训练离线扩散模型的策略。在给定当前状态的前提下,扩散模型能够生成相应的状态和动作序列,以模仿离线数据集中的专家运动模式。随后,在初步构建的离线扩散规划器上进行偏好对齐,通过弱偏好标签对离线策略进行微调。偏好对齐阶段在不降低整体模型表现的情况下,使得较优轨迹的生成概率增加,以提高模型的稳定性和对分布外样本状态的适应性。通过这种策略微调,模型能够更好地适应真实环境中的变化,并提高任务的鲁棒性。最后,我们将优化后的策略部署到真实的Unitree Go1机器人上,进行真实环境中的测试。

离线策略学习

在第一阶段中,利用离线收集的四足机器人运动专家数据,通过扩散模型学习状态-动作序列的联合分布,形成初步的轨迹生成策略。在此过程中,扩散模型通过反复去噪,重构高维动作序列,从而捕捉机器人运动中的复杂动态特征。通过这种方式,扩散模型能有效建立在不同步态任务下的基础行为模式。

偏好标签构建

提出了一种“弱偏好”(weak preference)的偏好标签生成方法,用于在没有真实奖励信号或人工偏好标签的情况下,对离线扩散模型进行策略优化。首先从离线策略中生成(roll-out)新的数据集,并从中随机采样两个轨迹片段,并基于轨迹的状态-动作对与最优专家轨迹的距离计算来决定偏好,并将与专家轨迹更为接近的轨迹定义为胜出轨迹(winning trajectory)。

在线偏好优化

在偏好对齐阶段,我们使用的损失函数由偏好损失和正则化项两个主要部分构成。偏好损失致力于放大“胜出轨迹”和“失败轨迹”之间的差异。在偏好损失的指引下,策略在生成动作的时候,会更倾向于生成胜出轨迹而不是失败轨迹。优化后的策略能够更好地与得到的偏好标签一致,从而生成更多符合偏好要求的样本。

然而,一味的偏向于胜出轨迹可能会导致整体扩散策略表现的崩塌。因此损失函数中还包含一个正则化项,用于防止新策略与原始策略之间出现显著的偏离。正则化项能够极大程度缓解分布外样本带来的影响,从而确保整体策略的生成能力和鲁棒性。通过偏好损失和正则化项的结合,我们最终能够得到一个与偏好标签更一致、同时更稳定的扩散策略,新的策略能够在复杂多变的现实环境中展现出出色的性能。

实验结果

本研究在多种步态和速度条件下展现出优异的稳定性和速度跟踪能力,相比现有基线离线强化学习方法具有显著优势。研究在模拟器和真实环境中分别测试了三种步态(Trotting、Pacing、Bounding),并在慢速(0.5 m/s)和快速(1.0 m/s)两种速度下评估了模型的稳定性与横向速度控制精度。如下图所示,左图展示了三种步态在模拟器中的表现,右图为它们在真实机器人Unitree GO1上的应用效果。

在实验中,以稳定性和x轴平均速度作为评估指标。针对稳定性的评估,该研究对比了三种基线方法:CQL算法、采用U-Net为主干网络的DDPM算法(标记为DDPM-Unet)以及采用Transformer为主干网络的DDPM算法(标记为DDPM-Transformer)。实验结果如下图所示:

从图中可以看出,CQL算法在所有步态任务中表现不佳,机器人要么停滞不前,要么出现轻微抖动,难以应对复杂的控制任务。相比之下,采用偏好对齐的Diffusion算法,无论是在弱偏好还是强偏好条件下,都在所有步态任务中展现了出色的稳定性和速度跟踪能力。

针对速度追踪的效果,该研究使用x轴平均速度来进行评估,比较了不同Diffusion模型在Slow Bounding任务下速度追踪结果,如下图所示:

论文所提出的基于偏好对齐的Diffusion算法在目标速度的追踪上表现更加精准,而采用U-Net或Transformer架构的DDPM算法均难以准确实现目标速度的追踪。

更进一步的,为了分析方法的有效性,该研究还进行了消融实验,探索了偏好数据集规模、偏好标签质量及正则化对稳定性的影响。下图列出了不同条件下的消融结果:

实验结果表明,随着偏好数据集从1024增加到3072,稳定性显著提高。即便在数据集规模较小时,弱偏好标签的性能也接近于强偏好标签,这验证了弱偏好标注方法的有效性。此外,从图中还可以看出正则化方法在偏好对齐中的作用至关重要。未使用正则化项的实验均告失败,这表明正则化项在解决超出分布状态(OOD)问题时不可或缺。该论文的方法通过正则化增强了对OOD状态的适应能力,从而进一步提高了稳定性和速度控制性能。

最后,该研究在真实机器人Unitree GO1上进行部署,进一步验证了该方法在四足机器人运动控制中的潜力。

研究总结

研究提出了一种结合离线学习与在线偏好对齐优化的两阶段Diffusion规划框架,旨在解决四足机器人运动控制中的复杂动作分布与分布外状态(OOD)问题。离线阶段利用专家数据学习状态-动作序列的分布,无需奖励标签,提升了数据效率;在线阶段通过基于欧氏距离的弱偏好标签进行策略优化,减少对外部反馈的依赖,并通过正则化避免策略漂移,增强了模型的稳定性与泛化能力。实验结果表明,该方法在不同步态与速度场景下的稳定性和速度控制精度显著优于基线算法,并成功实现了从模拟到现实的零样本迁移,为扩散模型驱动的四足机器人在复杂环境中的应用奠定了基础。

【具身智能之心】技术交流群

具身智能之心是国内首个面向具身智能领域的开发者社区,聚焦大模型、视觉语言导航、VLA、机械臂抓取、双足机器人、四足机器人、感知融合、强化学习、模仿学习、规控与端到端、机器人仿真、产品开发、自动标注等多个方向,目前近60+技术交流群,欢迎加入!扫码添加小助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

【具身智能之心】知识星球

具身智能之心知识星球是国内首个具身智能开发者社区,也是最专业最大的交流平台,近1000人。主要关注具身智能相关的数据集、开源项目、具身仿真平台、大模型、视觉语言模型、强化学习、具身智能感知定位、机器臂抓取、姿态估计、策略学习、轮式+机械臂、双足机器人、四足机器人、大模型部署、端到端、规划控制等方向。星球内部为大家汇总了近40+开源项目、近60+具身智能相关数据集、行业主流具身仿真平台、强化学习全栈学习路线、具身智能感知学习路线、具身智能交互学习路线、视觉语言导航学习路线、触觉感知学习路线、多模态大模型学理解学习路线、多模态大模型学生成学习路线、大模型与机器人应用、机械臂抓取位姿估计学习路线、机械臂的策略学习路线、双足与四足机器人开源方案、具身智能与大模型部署等方向,涉及当前具身所有主流方向。

扫码加入星球,享受以下专有服务:

1. 第一时间掌握具身智能相关的学术进展、工业落地应用;

2. 和行业大佬一起交流工作与求职相关的问题;

3. 优良的学习交流环境,能结识更多同行业的伙伴;

4. 具身智能相关工作岗位推荐,第一时间对接企业;

5. 行业机会挖掘,投资与项目对接;

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?