本文停更,新篇发布于:https://www.jianshu.com/u/90c2509fcc3e

开篇序

真实原因是上一篇字数超上限不给写了,虽然我也确实很想重写新的…

目测上半年剩余时间会以更新运筹优化,数值计算以及随机分析的内容为主,等到下半年可能会重归本业做些有趣的事情。

今日凌晨VAE发布了新曲MV《乌鸦》,感觉VAE的创作风格真的是越来越剑走偏锋,与前三张专辑的风格迥异,但是多听几遍总是可以产生共情的。

所以有时候会想人和人的喜怒真的是不相通么?也许只是难以同乐,单论共悲或许要容易得多。

由于诸多的偏差,往往我们多数时候只能看到别人光鲜面,却发现自己大部分时候都是在平淡地活着,甚至是颓唐地活着,因此一旦觉察倒世上也有与我一样的人,难免就会触而生情。

但是我想到了这个年纪,并没有几个人真的可以做到无忧无虑,各式各样的烦恼总是会有。

人到底血肉之躯,脆弱的时候至刚易折,偶然有烛火照亮我,就会下意识地去追求这团微弱的光芒,渴求还能找到春天。

假若有缘,或许时间并不是问题,谁知道呢。确实是很久了,有时候觉得可能还是像这次决绝一点好罢。

宴尔新昏,如兄如弟。宴尔新昏,不我屑矣。品荼苦而故作乐,大约是会有一点这种感觉的罢。

May 2021

05-08

- 午休起来看到W已在801,克制,虽然看到了还是觉得有点遗憾,

定义【可达常数】:若存在常数 m m m,使得 ∀ n ≥ m \forall n\ge m ∀n≥m,图 G G G中任意两个顶点之间都存在一条长度为 n n n的路径,则称 m m m为可达常数。(简单也可以理解为 C n 2 C_n^2 Cn2对顶点之间最短距离的最大值,其实这个定义不是很严谨);

昨晚测试了一下随机生成的强连通图 G = ( V , E ) G=(V,E) G=(V,E),其中 ∣ E ∣ = 2 ∣ V ∣ |E|=2|V| ∣E∣=2∣V∣的一个可达常数(reachability constant)的情况,从 ∣ V ∣ = 2 4 |V|=2^4 ∣V∣=24测试到 ∣ V ∣ = 2 16 |V|=2^{16} ∣V∣=216,发现可达常数刚好是 4 4 4~ 16 16 16,也就是 log 2 ∣ V ∣ \log_2 |V| log2∣V∣的水平,这个确实是一件很巧的事情。

具体的随机生成方法就是每个顶点都有两个出度,然后确保每个顶点都有入度即可。

上面的测试结论虽然还是比较容易接受的(因为如果做BFS可以近似的认为遍历的顶点数会呈 2 n 2^n 2n的速度增长,因此至少这个量级还是比较容易被接受的),但是严格证明起来并不是很容易。

不过我们也不会太关注证明,类推地,可以想到如果每个顶点有 k k k个出度,那么可达常数可以用 log k ∣ V ∣ \log_k|V| logk∣V∣来估计。

一个现实的案例即为六度空间,即世界上任意两个人通过六个人即可联系到,以目前 70 70 70亿人口来计算的话,这大约是假设每个人的出度(即人脉数)为 6 7 × 1 0 9 ≈ 43 ^6\sqrt{7\times 10^9}\approx 43 67×109≈43,还算是合理罢。

05-09

- 真的狼灭啊,三点不睡发邮件,当日还得早起有事。话说这反射弧也太长了,不回也没啥其实,好在这样事件算是正式画上句号,明天最后一课我也不会太尴尬了,如释重负。

- 31℃,4km,17’03",这么好的状态也破不了16’56"的pb,接下来要刷新pb越来越难,下周二周四比较凉快,争取再试一次。

- 被迫参加月底研学代会,其实现在我倒是不太抗拒这些无聊的琐事,就算是我本科四年欠下的经历给补上罢。

机器学习×数值分析,就决定做这个方向了,lh想做迭代算法做那我就一个人搞这个,还是有点意思的,至少我现在看了这么多ACL EMNLP的顶会paper从来没有人用过这些最传统的统计方法,以及对优化算法的底层进行改进,现在想想确实如此,有那么多ill-conditioned的问题,凭什么你会觉得在你找到的训练集上模型的损失函数真的可以被优化算法(如SGD,ADAM)优化得很好。

现在的问题是在DL年代,我们并不关心训练数据长什么样子,反正一股脑儿输进去就完事了,但是我觉得至少输入数据的条件数还是非常有参考意义的(即输入矩阵的最大奇异值除以最小奇异值),尤其是在NLP领域,很多外部知识(如词袋模型,tfidf矩阵,乃至知识图谱?)都是可以转换为矩阵形式输入到模型中去的。只是这里面有个trick,就是现在的输入数据越来越复杂,可能大多数时候已经不是矩阵,而是至少三维的张量,这个条件数以及预条件子矩阵怎么从二维推广到三维确实是个问题,另一个问题是输入的广度也是复杂的,可能有时候需要综合多个不同类型的输入(比如还有其他特征)。我想对于前者可能切片处理,这也许是一个解决方案,给每个切片找个预条件子矩阵,现在不是确实也有人在研究用CNN自动生成预条件子矩阵的事情嘛。对于后者的话,我倾向于建立子模型来处理,我还是挺反对把所有能用的东西全部输入到模型训练,应当将不同的输入分别训练,这可能需要设计更加合理的结构,还得实践才能知道该怎么做。

总之我越来越觉得邓琪的研究方向很有趣,这学期虽然这门课没有怎么听(因为太难听不懂,而且不考试),但是确实是非常有帮助的知识,对我之后的进展大概率会有思路上的开拓,总之人还是不能太局限于代码上的能力,理论知识,无论紧密与否,选择走这条路就得博采众长,包括计量那边的一些研究方法,也是很值得借鉴的,现在毕业真TM难,我可不想被延毕。

05-10

- 《散去的时候》我听到了,一个人比较好,尽力在躲避,行吧,还是这样的歌词比较适合你的风格。

- 再见很早就已经说过,多说还是太过于矫揉造作。最后一课,我是有想说点什么作为告别,毕竟那晚回来后就再也没有见过了,再次看到时总还是会有点在意,实话说我还真是容易被这种假小子的装扮给惊艳到…

- 好在以后不太可能再见了,无声的告别也许确实更好,让一切都淡去吧。总之还是多谢了,各种意义上,前路安好。

- 我发誓这是最后一个颓废的晚上了,以后绝对要足够自律起来了,再不自律真的凉了。

GPR的scipy实现:其实我之前就很奇怪,这种根据一条样本曲线去拟合整个样本空间分布的做法实在是很胃疼,虽然看起来是很有道理,但是有道理的事情一般都不太行得通。

from scipy.optimize import minimize

import numpy as np

from matplotlib import pyplot as plt

class GPR:

def __init__(self, optimize=True):

self.is_fit = False

self.train_X, self.train_y = None, None

self.params = {"l": 0.5, "sigma_f": 0.2}

self.optimize = optimize

def fit(self, X, y):

# store train data

self.train_X = np.asarray(X)

self.train_y = np.asarray(y)

self.is_fit = True

def predict(self, X):

if not self.is_fit:

print("GPR Model not fit yet.")

return

X = np.asarray(X)

Kff = self.kernel(self.train_X, self.train_X) # (N, N)

Kyy = self.kernel(X, X) # (k, k)

Kfy = self.kernel(self.train_X, X) # (N, k)

Kff_inv = np.linalg.inv(Kff + 1e-8 * np.eye(len(self.train_X))) # (N, N)

mu = Kfy.T.dot(Kff_inv).dot(self.train_y)

cov = Kyy - Kfy.T.dot(Kff_inv).dot(Kfy)

return mu, cov

def kernel(self, x1, x2):

dist_matrix = np.sum(x1**2, 1).reshape(-1, 1) + np.sum(x2**2, 1) - 2 * np.dot(x1, x2.T)

return self.params["sigma_f"] ** 2 * np.exp(-0.5 / self.params["l"] ** 2 * dist_matrix)

def y(x, noise_sigma=0.0):

x = np.asarray(x)

y = np.cos(x) + np.random.normal(0, noise_sigma, size=x.shape)

return y.tolist()

train_X = np.array([3, 1, 4, 5, 9]).reshape(-1, 1)

train_y = y(train_X, noise_sigma=1e-4)

test_X = np.arange(0, 10, 0.1).reshape(-1, 1)

gpr = GPR()

gpr.fit(train_X, train_y)

mu, cov = gpr.predict(test_X)

test_y = mu.ravel()

uncertainty = 1.96 * np.sqrt(np.diag(cov))

plt.figure()

plt.title("l=%.2f sigma_f=%.2f" % (gpr.params["l"], gpr.params["sigma_f"]))

plt.fill_between(test_X.ravel(), test_y + uncertainty, test_y - uncertainty, alpha=0.1)

plt.plot(test_X, test_y, label="predict")

plt.scatter(train_X, train_y, label="train", c="red", marker="x")

plt.legend()

plt.show()

05-11

- 还可以,计量终于不会布置作业了,剩下的作业应该就只有随机模型和运筹优化两门课的了。不过一下子就已经跳到考试月,来得还挺突然,只剩四周时间,有两门期末项目要赶,没能抱到lth的大腿,要自己动手,那就跟我来分个高下呗。

- 冒雨冲了五圈,均配3’55",很久没有这样在大雨中狂奔,难得畅快。

- 童安格的干燥花,和折翼蝶还挺搭。本打算晚上下课去一趟511的,可惜gjj拖太久,而且似乎也没什么理由去,作罢。

更新预告:我越来越觉得这块内容很有用了。

-

参考文献 [ 19 ] [19] [19]:对四维卷积核张量的分解研究。如张量秩分解(CPD),可以将四维卷积核直接分解为四个低秩的卷积层。

- 备注:CPD这个词我第一次是在RE2RNN那篇paper里碰到的,在那篇博客里有关于CPD的详细说明,对于三维张量的CPD应该是会分解成三个二维矩阵,但是对于四维张量的话,分解得到的矩阵数量可能会非常多。

05-12

- 好天气,手环到手,计划试跑一次半马。

- 刚跑就出太阳,跑完就下山,真就针对我呗。最终4’40"的配跑了12km,测了一下发现心率基本维持在175左右,很离谱,看到别人4分配以内心率都不会超过170,差距还真是有够大。

- still not so easy,果然还是对自己的适应的水平太高估。

介绍一种SVD训练:

-

对于神经网络而言,这相当于是将权重矩阵 W W W分解为两个连续的层: W 1 = U diag ( s ) W_1=U\text{diag}(\sqrt{s}) W1=Udiag(s)与 W 2 = diag ( s ) V ⊤ W_2=\text{diag}(\sqrt{s})V^\top W2=diag(s)V⊤

-

对于卷积层而言,卷积核 K ∈ R n × c × w × h \mathcal{K}\in\R^{n\times c\times w\times h} K∈Rn×c×w×h可以表示为一个四维张量,其中 n , c , w , h n,c,w,h n,c,w,h分别代表过滤器(filters)的数量,输入管道(channels)的数量,过滤器的宽和高,本文只要使用空间级(spatial-wise,参考文献 [ 15 ] [15] [15])或者管道级(channel-wise,参考文献 [ 39 ] [39] [39])分解的方法来对卷积层进行分解(因为前人用下来效果很好):

-

首先将 K \mathcal{K} K重构(reshape)成二维矩阵 K ^ ∈ R n × c w h \hat K\in\R^{n\times cwh} K^∈Rn×cwh;

-

然后 K ^ \hat K K^通过SVD得到 U ∈ R n × r , V ∈ R c w h × r , s ∈ R r U\in\R^{n\times r},V\in\R^{cwh\times r},s\in\R^r U∈Rn×r,V∈Rcwh×r,s∈Rr,其中 U U U和 V V V是正交矩阵, r = min ( n , c w h ) r=\min(n,cwh) r=min(n,cwh);

-

此时原始的卷积测出那个被分解为两个连续的子卷积层: K 1 ∈ R r × c × w × h \mathcal{K}_1\in\R^{r\times c\times w\times h} K1∈Rr×c×w×h(从 diag ( s ) V ⊤ \text{diag}(\sqrt{s})V^\top diag(s)V⊤重构回)与 K 2 ∈ R n × r × 1 × 1 \mathcal{K}_2\in\R^{n\times r\times1\times1} K2∈Rn×r×1×1(从 U diag ( s ) ) U\text{diag}(\sqrt{s})) Udiag(s))重构回);

-

05-13

- 休整,月头12天跑了3次10km以上,感觉这个状态其实还行,不算糟糕。晚上进场恰好看到了那个叫WXY的大佬,跟三圈实在是跟不住,回来刷keep看到他3’46"的配跑了5公里多,离谱。下半年一定要把5km练进20分钟,跟这种顶尖的业余跑者比还是差得挺远。

- 写proposal时突然感觉邓琪做的事情真的好有趣,我担心wyl指导不了我这方面的东西,我有直觉这些方法是比较可能发paper的。

- 回翻了一下近一个月的日记,每天都能写满至少一页纸,想休假在家两三天才能写满一页。事多有事多的紧凑,事少也有事少的清闲,以前回翻自己初高中的日记,那种狂妄自大的气息扑面而来,不知道多年以后我再回翻自己某些时期的日记还会作何感想,人嘛,总得成长。

-

关于bibtex的使用方法:

- 编写.bib文件(如proposal.bib),内容如下:

@article{2020Convolutional, title={Convolutional neural nets for estimating the run time and energy consumption of the sparse matrix-vector product}, author={ Barreda, M. and Dolz, M. F. and Castao, M. A. }, journal={International Journal of High Performance Computing Applications}, number={1}, year={2020}, } - 编写.tex文件(如proposal.tex):

\documentclass{article} \usepackage[utf8]{inputenc} \usepackage[margin=1in]{geometry} \usepackage{cite} \usepackage{graphicx} \usepackage{caption2} \usepackage{subfigure} \begin{document} \begin{center} \LARGE{\textbf{Proposal}}\\ \vspace{1em} \normalsize\textbf{Hao Li, Yang Cao}\\ \end{center} \begin{normalsize} \section{Research Questions and Objectives} \section{Objectives} \section{Significance/Contributions} \section{Research Plan} \nocite{1} %只加入到参考文献列表中,不在文中引用(显示[id]) \nocite{*} %显示所有文献 \bibliography{proposal.bib} \bibliographystyle{plain} \end{normalsize} \end{document} - 接下来就是先用pdflatex编译,然后bibtex编译,再pdflatex编译即可。上述

\bibliographystyle{plain}是默认的plain,可自定义,但比较麻烦。

- 编写.bib文件(如proposal.bib),内容如下:

05-14

- MD,proposal硬是拖到下午才写完,最近真废,恨铁不成钢,周末得把这周欠下的都给补上,时隔近一年终于可以开始好好写代码了。

- 刚发现明月姐7号发了一篇ACL,组里都给点赞了,就我没点… 关了朋友圈信息就总是特别滞后。博二第一篇顶会paper,我也得加把劲才行,争取要硕士阶段能整点东西。

- 麦当劳有这么好吃么… 如果健身锻炼不是为了畅所欲食,那就毫无意义。

- 晚课lth居然把zsj带过来了,虽然是带的口罩,我还是一眼就认出了,没好意思去打招呼,老妈说我贼没礼貌,害。课下雷暴,怕被雷击,三圈走人,预报上周末闷热带雨,实在是让人很颓败的天气,不过下周一倒是很凉快,计划再试一次半马,弥补寒假未能完成20km的遗憾。

最近要开始写代码了,实话说还有点小兴奋。

关于python中的稀疏矩阵:from scipy import sparse

scipy中封装了七种常用的稀疏矩阵存储结构,最常用的还是coo:

import numpy as np

from scipy.sparse import coo_matrix

_row = np.array([0, 3, 1, 0])

_col = np.array([0, 3, 1, 2])

_data = np.array([4, 5, 7, 9])

coo = coo_matrix((_data, (_row, _col)), shape=(4, 4), dtype=np.int)

coo.todense() # 通过todense方法转化成密集矩阵(numpy.matrix)

coo.toarray() # 通过toarray方法转化成密集矩阵(numpy.ndarray)

其他像csc与csr的存储方式也有用,但是我觉得理解起来相对会比较复杂,至少matlab中默认存储稀疏矩阵的方式仍然是coo。

稀疏矩阵的稀疏存储结构可以大大加快科学计算中矩阵乘法运算的速度,如果能够在特定问题环境下找到合适的预条件子,还能够使得很多迭代求解算法的收敛速度大大提升。

目前在做这方面的工作,很有趣,因为以前没做过,我发现人总是对新事物会很好奇的,但是真正坚持走下去的确实很少。不思进取,人之常情,也不必多虑,虽然我现在也不太喜欢和别人再争什么,但是至少也别让过去的自己瞧不起现在的自己,最终活成自己讨厌的样子。

05-15

- 鬼天气,又热又闷,四圈就给报废了。凡事还是得慢慢来,欲速不达,本来三月份已经可以达到4分配坚持3km的水平了,最近自从认识了那个5km跑进18分半的大佬后,开始对自己的配速特别不满,急躁了。

- 其实pytorch也有稀疏训练的方法,似乎并没有什么人注意到过,值得好好学习一下。

E2006数据集转稀疏矩阵方法:

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import numpy as np

import scipy as sp

from scipy.sparse import coo_matrix, csr_matrix, save_npz, load_npz, hstack, vstack

from scipy.sparse.linalg import cg, gmres

def load_dataset(filepath, format_='csr', add_constant=False, export_path_matrix=None, export_path_vector=None):

format_ = format_.lower()

if format_ == 'coo':

print('coo')

coo_rows = []

coo_columns = []

coo_values = []

vector = []

row = -1

with open(filepath, 'r') as f:

while True:

line = f.readline()

if not line:

break

row += 1

blocks = line.split()

vector.append(blocks[0])

for block in blocks[1:]:

column, value = block.split(':')

coo_rows.append(row)

coo_columns.append(int(column) - 1)

coo_values.append(float(value))

vector_array = np.array(vector, dtype=np.float64)

sparse_matrix = coo_matrix((coo_values, (coo_rows, coo_columns)), dtype=np.float64)

elif format_ == 'csr':

print('csr')

csr_index_pointers = [0]

csr_indices = []

csr_values = []

vector = []

with open(filepath, 'r') as f:

while True:

line = f.readline()

if not line:

break

blocks = line.split()

vector.append(blocks[0])

index_pointer = csr_index_pointers[-1] + len(blocks) - 1

csr_index_pointers.append(index_pointer)

for block in blocks[1:]:

column, value = block.split(':')

csr_indices.append(int(column) - 1)

csr_values.append(float(value))

vector_array = np.array(vector, dtype=np.float64)

sparse_matrix = csr_matrix((csr_values, csr_indices, csr_index_pointers), dtype=np.float64)

else:

raise Exception('Unknown keyword augment `format_`: {}'.format(format_))

if add_constant:

sparse_matrix = hstack([np.ones((sparse_matrix.shape[0], 1)), sparse_matrix])

if export_path_matrix is not None:

print(type(sparse_matrix))

save_npz(open(export_path_matrix, 'wb'), sparse_matrix)

if export_path_vector is not None:

np.save(export_path_vector, vector_array)

return sparse_matrix, vector_array

05-16

- 萎靡了四天,天气确实也不太好,但是明天一定无论如何要试一次半马的了。

scipy.sparse.linalg下若干线性系统求解迭代方法的评测(以E2006数据集为例):(API见https://docs.scipy.org/doc/scipy/reference/sparse.linalg.html#module-scipy.sparse.linalg):

| 求解方法 | 运行时间 | 是否需要计算 A ⊤ A A^\top A A⊤A | 测试集误差 ∥ A x − b ∥ 2 \|Ax-b\|_2 ∥Ax−b∥2 |

|---|---|---|---|

spsolve(稀疏系统求解) | O O M \rm OOM OOM | Y e s \rm Yes Yes | N a N \rm NaN NaN |

bicg(

BiConjugate Gradient

\text{BiConjugate Gradient}

BiConjugate Gradient) | 56min \text{56min} 56min | Y e s \rm Yes Yes | 22.247769608108694 22.247769608108694 22.247769608108694 |

cg(共轭梯度法) | 1min9s \text{1min9s} 1min9s | Y e s \rm Yes Yes | 22.498612313964742 22.498612313964742 22.498612313964742 |

gmres(广义最小残差法) | 54s \text{54s} 54s | Y e s \rm Yes Yes | 21.30442357345542 21.30442357345542 21.30442357345542 |

minres(最小残差法) | 44 s 44\rm s 44s | Y e s \rm Yes Yes | 21.526024247327364 21.526024247327364 21.526024247327364 |

gcrotmk(

G

C

R

O

T

(

m

,

k

)

{\rm GCROT}(m,k)

GCROT(m,k)方法) | 1min26s \text{1min26s} 1min26s | Y e s \rm Yes Yes | 29.943797879916882 29.943797879916882 29.943797879916882 |

lsqr(求稀疏最小二乘的函数) | 45.8 s 45.8\rm s 45.8s | N o \rm No No | 26.741176979699944 26.741176979699944 26.741176979699944 |

lsmr(求稀疏最小二乘的迭代方法) | 7.31 s \rm 7.31s 7.31s | N o \rm No No | 21.30442357345681 21.30442357345681 21.30442357345681 |

总结:lsmr永远的神,真就又快又好。

05-17

- 时隔近四个月,我终于完成了年前未能跑完20km的夙愿,配速4’45",用时1小时35分,继续下去有望半马进100分钟。昨晚补糖早睡,今早早起继续补糖,就怕自己中途体力不支,结果16km处还是力竭休息了两三分钟。还有必须吐槽坑爹的天气预报,说好早上小雨,结果八点就来这种太阳,还不如抛硬币来得靠谱。

- 偶然看到又不吃午饭就去图书馆的人,罢了。累,回去睡午觉。

- 下午起来感觉无恙,进场看有没有认识的大佬在跑,准备跟两三圈练练速度,结果打开keep发现sxy在跑,但是并不能找到,也许只是我根本认不出来…

搞了一天稀疏矩阵和稀疏张量的处理,目前几个坑点记录一下:

pytorch更新到1.6.0后开始出现torch.sparse模块,可惜这个模块做得太垃圾了,且不说只有COO格式的存储(不支持CSR格式的存储),导致无法做稀疏张量切片,而且也不能直接用torch.nn.utils.DataLoader去包装(原因很简单,dataloader是可以做批生成的,但是本来这个稀疏矩阵就不能切片,怎么做批生成?),但是我测试下来直接把整个稀疏张量拿进去训练是可行的,但是显然这个代价相比于批训练要大得多。如果放弃稀疏存储而用.to_dense()方法转为普通的张量,显存就直接炸了。scipy中coo稀疏格式和csr稀疏格式的转换的时间代价很小,即便矩阵很大(本质上运行时间只和非零元nnz的数量有关,所以很快),因此无需存下来多个不同格式的稀疏矩阵,一般存csr格式的就行了,这个是最常用的,转成其他格式的也快。- 巨型坑点:

torch中稀疏矩阵乘法问题- 目前这个坑在于不同版本的

torch稀疏矩阵乘法是有不同结论的,笔者目前用的是1.7.0gpu版本,torch已经更新到1.8.0,不知是否有更新,目前的情况似乎是支持稀疏乘稀疏,支持稀疏乘普通,但是不支持普通乘稀疏,这就很tricky了,所以很多时候如果要普通乘稀疏,还得反过来写然后再转置,真的是蠢到不行…

- 目前这个坑在于不同版本的

- 总之要用稀疏矩阵做训练,估计得自己改写底层代码了,建议直接手写DNN

05-18

- keep的路线主任从3月2日做到4月5日,然后驾崩(四月中途零碎了做了十天左右),现在从5月4日一直做到现在,这个时间点还真是够敏感的,显然这并不是什么巧合,很直观的因果关系…

- 双腿严重残废,我早在5月1日刷新10km pb后就做好残废的准备了,没想到这个月还能跑4次10km+的里程,最后完成半马,血赚,只是我那路线主任的位置…

收到CSDN定制的nova7的手机壳,看起来还不错,反正我也从来不会买这玩意儿,都是用烂原装的之后就开始“裸机”。

关于稀疏矩阵求奇异值的问题:

-

问题来源于求解矩阵条件数(最大奇异值/最小奇异值),常规做法源自于

numpy.linalg中的svd与eig方法,这两种方法是精确求解的方法,算法应该是通过求解线性系统得出所有奇异值和特征值,以及对应的奇异向量与特征向量,缺点是慢。 -

注意到

scipy.sparse.linalg中提供了svds和eigs两种方法,都是迭代方法,所以会非常快,这里值得注意的是svds方法的调用(https://docs.scipy.org/doc/scipy/reference/generated/scipy.sparse.linalg.svds.html#scipy.sparse.linalg.svds):- 注意到参数

which,取值为'LM'(求最大奇异值)或'SM'(求最小奇异值); - 另外还有一个

k指找出最大的几个奇异值; - 有兴趣的朋友可以去看看求 k > 1 k>1 k>1的情况下迭代算法是如何运行的,因为 k = 1 k=1 k=1时(即只找到一个)的算法是比较浅显的,我记得找多个其实就是初始化时找若干线性不相关的初始向量去迭代,好像还可能涉及需要QR分解的内容

- 但是我实际想说的是这个迭代算法求最大特征值确实非常快(实测100k维的稀疏矩阵只需要不到1秒钟就能找到最大奇异值,而且相当精准),但是找最小奇异值算法是很难迭代收敛(一小时无法收敛),某次测试花了93分钟后报错:

这意味着矩阵奇异得厉害,最小奇异值非常小,导致条件数很大,即矩阵是ill-conditionedArpackNoConvergence: ARPACK error -1: No convergence (33081 iterations, 0/1 eigenvectors converged)

- 这里想做的事情是去找预条件子矩阵 M − 1 M^{-1} M−1来修复 A A A,使得 M − 1 A M^{-1}A M−1A的条件数变小,要求是 M M M也是一个稀疏矩阵,其实如果盲目地去寻找是非常困难的,所以可能还是偏向于物理降维… 不过还是得试试的,万一运气好找到一个预条件子那不血赚。

- 注意到参数

05-19

- wyl又找了好活,这次的明显靠谱得多,还是跟科大讯飞合作的,大约是问答这块的东西。虽然最近忙得离谱,但是我还是跟wyl说了一句“多少事我都能做”。怎么说呢,多点事儿好,省得我瞎TM乱想别的东西,五月以来一直没有好好做事,该给我点颜色看看了。

- 吃苦耐劳能致富,emmm…

- 昨晚熬夜搞掉gjj的作业,下午复习完算法,准备开始正事。饭后冒中雨干了3km,很明显感觉跑姿越来越自然,很畅快地跑,有迫切去参加一次半马的渴望。

今日痛点:LaTeX参考文献.bib文件编译失败的一个原因

有些期刊名称里包含特殊字符,比如&,关键是好多paper提供的BibTex里都不注意这些小问题,然后编译的时候就会出问题。比如下面这个:

\bibitem{2009A}

T.~Strohmer and R.~Vershynin.

\newblock A randomized kaczmarz algorithm with exponential convergence.

\newblock {\em Journal of Fourier Analysis & Applications}, 15(2):262, 2009.

解决方案要么加反斜杠\&,要么直接把&换成and拉倒。

还有一个问题,就是你按照pdflatex

→

\rightarrow

→bibtex

→

\rightarrow

→pdflatex的顺序编译后如果发现引用部分(\cite{...})显示出来的还是[?],那就紧接着再用pdflatex编译一次,实话说这玩意儿很玄学,有时候三步走能好,有时候就得四步。这年头LaTeX还是硬技能,只是这玩意儿老是犯病,有时候还就很难找到问题在哪。

05-20

- 520果然还是图书馆更适合单身狗。这年头还有人热心地在食堂门口放一束应急玫瑰,唉,需要的人不缺,不需要的人有了也没用…

- 今年11月21日,杨浦新江湾国际半程马拉松,目标首马破100分钟。

牛顿法小结:

-

本质上就是在该点附近根据一阶导,二阶导来用一个二次函数近似,然后将二次函数的最低点作为下一个迭代点

-

δ x n t = − ∇ 2 f ( x ) − 1 ∇ f ( x ) \delta x_{\rm nt}=-\nabla^2f(x)^{-1}\nabla f(x) δxnt=−∇2f(x)−1∇f(x)

-

推论:

-

x

+

δ

x

n

t

x+\delta x_{\rm nt}

x+δxnt最小化(二次近似速度):

f ^ ( x + v ) = f ( x ) + ∇ f ( x ) ⊤ v + 1 2 v ⊤ ∇ 2 f ( x ) v \hat f(x+v)=f(x)+\nabla f(x)^\top v+\frac12v^\top\nabla^2f(x)v f^(x+v)=f(x)+∇f(x)⊤v+21v⊤∇2f(x)v

-

x

+

δ

x

n

t

x+\delta x_{\rm nt}

x+δxnt最小化(二次近似速度):

05-21

- 520看《情书》,属实雅兴,终于拉黑,解脱…

- 好天气,可惜睡晚了,加上几天不午睡,状态不算很好。膝盖偶尔还是有点刺痛的,还真以为自己练成钢铁膝盖了,休息一两天回口血,事情也比较多暂时。有空也去科技园一趟,这年头汉堡真有这么好吃?

- ITCS来了些玩飞盘的访问学者,准备陪他们耍耍,看起来还挺好玩的,主要是跑步、跳跃与投掷,权当锻炼身体,培养一些额外的兴趣~

关于连续时间马尔科夫链的转移概率矩阵的计算(实例中的技巧):

-

我们知道可以用下面的ODE来解 P ( t ) P(t) P(t)矩阵的表达式:

{ P ˙ ( t ) = d P ( t ) d t = P ( t ) ⋅ Q P ( 0 ) = I (3.1) \left\{\begin{aligned} &\dot P(t)=\frac{\text{d}P(t)}{\text{d}t}=P(t)\cdot Q\\ &P(0)=I \end{aligned}\right.\tag{3.1} ⎩⎨⎧P˙(t)=dtdP(t)=P(t)⋅QP(0)=I(3.1)

具体解为:

P ( t ) = e t Q = ∑ i = 0 + ∞ 1 i ! t i Q i = I + t Q + 1 2 ! t 2 Q 2 + 1 3 ! t 3 Q 3 + . . . (3.2) P(t)=e^{tQ}=\sum_{i=0}^{+\infty}\frac{1}{i!}t^iQ^i=I+tQ+\frac1{2!}t^2Q^2+\frac1{3!}t^3Q^3+...\tag{3.2} P(t)=etQ=i=0∑+∞i!1tiQi=I+tQ+2!1t2Q2+3!1t3Q3+...(3.2)

这个无穷级数很多时候在 Q Q Q没有特殊形式时是很难求解的,不过有一种更简洁的表达:设对称矩阵 Q Q Q具有正交对角化的形式 Q = S D S ⊤ Q=SDS^\top Q=SDS⊤,则有 P ( t ) = S e t D S ⊤ P(t)=Se^{tD}S^\top P(t)=SetDS⊤

e t D e^{tD} etD非常好求(直接对角元求指数即可),因此只要能给出 Q Q Q对角化的形式,即可直接求出结果。

问题在于很多时候我们甚至连 S S S都给不出显示表达,比如下面这个 Q Q Q矩阵:

Q = [ 1 − m 1 1 . . . 1 1 1 − m 1 . . . 1 1 1 1 − m . . . 1 . . . . . . . . . . . . . . . 1 1 1 . . . 1 − m ] m × m (3.3) Q=\left[\begin{matrix}1-m&1&1&...&1\\1&1-m&1&...&1\\1&1&1-m&...&1\\...&...&...&...&...\\1&1&1&...&1-m\end{matrix}\right]_{m\times m}\tag{3.3} Q=⎣⎢⎢⎢⎢⎡1−m11...111−m1...1111−m...1...............111...1−m⎦⎥⎥⎥⎥⎤m×m(3.3)

虽然通过观察容易发现特征值,但是特征向量并不好求。

因此这里需要一些别的技巧。通过观察可以发现 P ( t ) P(t) P(t)一定是对角元取同一个值,非对角元取另一个值所以我们立刻给出ODE的具体表达:

P ( t ) = [ f ′ ( t ) g ′ ( t ) . . . g ′ ( t ) g ′ ( t ) f ′ ( t ) . . . g ′ ( t ) . . . . . . . . . . . . g ′ ( t ) g ′ ( t ) . . . f ′ ( t ) ] = [ f ( t ) g ( t ) . . . g ( t ) g ( t ) f ( t ) . . . g ( t ) . . . . . . . . . . . . g ( t ) g ( t ) . . . f ( t ) ] [ 1 − m 1 . . . 1 1 1 − m . . . 1 . . . . . . . . . . . . 1 1 . . . 1 − m ] = P ( t ) ⋅ Q P(t)=\left[\begin{matrix}f'(t)&g'(t)&...&g'(t)\\g'(t)&f'(t)&...&g'(t)\\...&...&...&...\\g'(t)&g'(t)&...&f'(t)\end{matrix}\right]=\left[\begin{matrix}f(t)&g(t)&...&g(t)\\g(t)&f(t)&...&g(t)\\...&...&...&...\\g(t)&g(t)&...&f(t)\end{matrix}\right]\left[\begin{matrix}1-m&1&...&1\\1&1-m&...&1\\...&...&...&...\\1&1&...&1-m\end{matrix}\right]=P(t)\cdot Q P(t)=⎣⎢⎢⎡f′(t)g′(t)...g′(t)g′(t)f′(t)...g′(t)............g′(t)g′(t)...f′(t)⎦⎥⎥⎤=⎣⎢⎢⎡f(t)g(t)...g(t)g(t)f(t)...g(t)............g(t)g(t)...f(t)⎦⎥⎥⎤⎣⎢⎢⎡1−m1...111−m...1............11...1−m⎦⎥⎥⎤=P(t)⋅Q

即:

{ f ′ ( t ) = ( 1 − m ) f ( t ) + ( m − 1 ) g ( t ) g ′ ( t ) = f ( t ) + ( 1 − m ) g ( t ) + ( m − 2 ) g ( t ) = f ( t ) − g ( t ) (3.6) \left\{\begin{aligned} &f'(t)=(1-m)f(t)+(m-1)g(t)\\ &g'(t)=f(t)+(1-m)g(t)+(m-2)g(t)=f(t)-g(t) \end{aligned}\right.\tag{3.6} {f′(t)=(1−m)f(t)+(m−1)g(t)g′(t)=f(t)+(1−m)g(t)+(m−2)g(t)=f(t)−g(t)(3.6)

这个ODE很好解,结论是:

P i j ( t ) = { 1 m + m − 1 m e − m t ( i = j ) 1 m − 1 m e − m t ( i ≠ j ) (3.11) P_{ij}(t)=\left\{\begin{aligned} &\frac1m+\frac{m-1}me^{-mt}\quad&(i=j)\\ &\frac1m-\frac1me^{-mt}\quad&(i\neq j) \end{aligned}\right.\tag{3.11} Pij(t)=⎩⎪⎨⎪⎧m1+mm−1e−mtm1−m1e−mt(i=j)(i=j)(3.11)

我看别人多是死磕无穷级数,这个方法似乎并没有太多人想到。

05-22

- 好天气,可惜身体还没有完全回满,中长跑到不了一个月前的水平,周一之后都还是2-4公里的量在恢复,四分配不是那么容易练到的,明天倒很凉快,看状态。

- hdm的期末pre致命了,不到两周,还跟组里事情的节点重叠,Eviews还是半吊子水平,接下来半个月怕要拼命了,聒噪得很,到底得先应付掉后天的考试。

- 感觉s每天都在吃麦当劳,建议撤了二教旁边的缤纷谷,直接把店开在那儿,百分百创收[笑]…

最近一些没搞清楚的混淆点(优化理论):

-

牛顿法的下降方向到底是 − f ( x ) / f ′ ( x ) -f(x)/f'(x) −f(x)/f′(x),还是 − ∇ 2 f ( x ) − 1 ∇ f ( x ) -\nabla^2 f(x)^{-1} \nabla f(x) −∇2f(x)−1∇f(x)

-

拟牛顿法的初始海森矩阵究竟是取初始点的海森矩阵,还是用单位矩阵,还是随机取一个正定矩阵就行了?

-

回溯线搜索(backtracking line search)的算法终止条件,到底是 f ( x ( k ) − α ∇ f ( x ( k ) ) ) > f ( x ( k ) ) − c 1 α k ∥ ∇ f ( x ( k ) ) ∥ 2 2 f(x^{(k)}-\alpha \nabla f(x^{(k)}))\gt f(x^{(k)})-c_1\alpha_k\|\nabla f(x^{(k)})\|_2^2 f(x(k)−α∇f(x(k)))>f(x(k))−c1αk∥∇f(x(k))∥22还是 f ( x ( k ) + α k Δ x k ) > f ( x ( k ) ) + α ∇ f ( x ( k ) ) ⊤ Δ x k f(x^{(k)}+\alpha_k\Delta x_k)\gt f(x^{(k)})+\alpha\nabla f(x^{(k)})^{\top} \Delta x_k f(x(k)+αkΔxk)>f(x(k))+α∇f(x(k))⊤Δxk,感觉两种都可以

-

为什么steepest descent method有的说法是在方向上取下降最多的那个步长: t = argmin t f ( x + t Δ x ) t = \text{argmin}_t f(x+t\Delta x) t=argmintf(x+tΔx),还有一种说法则是针对下降方向: Δ x = argmin v : ∥ v ∥ = 1 ∇ f ( x ) ⊤ v \Delta x = \text{argmin}_{v:\|v\|=1}\nabla f(x)^\top v Δx=argminv:∥v∥=1∇f(x)⊤v

注意这里的 ∥ v ∥ \|v\| ∥v∥如果是二模则等价于梯度下降法,但是这里有多种不同模的选择,比如可以选一模,还能选二次模: ∥ x ∥ P = x ⊤ P x \|x\|_P=\sqrt{x^\top Px} ∥x∥P=x⊤Px,其中 P P P是一个正定矩阵,结果就完全不同了。

这里很迷的就是前一个steepest descent method是用来确定步长,后一个steepest descent method其实是用来确定下降方向的。[黑人问号脸]

05-23

- 状态好偏逢连夜雨,难受。晚饭后小雨17’20“跑了10圈,说起来已经很久不跑4km这个距离了。想到甘肃越野21个精英跑者丧生,所以真的别太高估自己的身体素质,人是有极限的。现在我淋雨跑完(虽然现在是很享受雨中跑步的快感)第一件事就是洗澡,就怕闷长得伤寒,在这种持续一天一夜的越野中低温淋湿,真的是会丢了小命的。

- 花了半个下午终于找到了一篇数据源全部accessible的paper,看起来可实现性比较高。离谱的是问sxy给我搞了一批百八十页的英文paper,上午硬着头皮看完了一篇实证的introduction,然后彻底放弃。这也太看得起我了,我本专的paper都没看过这么长的…

SVDtraining的模型与损失函数定义:

-

这是个最平凡的测试demo,因为我遇到一个很头疼的问题,就是torch好像不能给网络层命名(首先像

torch.nn.Linear这些函数的参数里就没有name,然后即便你初始化好之后手动修改,比如self.orthogonal_linear1.name = 'ABC',在输出模型参数时的name也还是它原先的默认名称),所以我只好给变量命名的时候就带上前缀orthogonal_和diag_,然后才好在损失函数里确定正则项对应的张量(是不是很蠢?到底有没有不蠢的办法?) -

这事情确实挺恶心,明明

torch里的张量都是可以命名的,但是好像就不能命名网络层,还是我没找到怎么改名字的方法?

# -*- coding: utf-8- *-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import torch as th

class DotProduct(th.nn.Module):

def __init__(self, in_features, bias=False):

super(DotProduct, self).__init__()

self.bias_flag = bias

self.weight = th.nn.Parameter(th.rand(in_features, ))

if bias:

self.bias = th.nn.Parameter(th.rand(in_features, ))

def forward(self, x):

x = self.weight * x

if self.bias_flag:

x = x + self.bias

return x

class SVDNet(th.nn.Module):

def __init__(self, input_dim, output_dim):

super(SVDNet, self).__init__()

self.orthogonal_linear1 = th.nn.Linear(input_dim, output_dim, bias=False)

self.diag_dotproduct1 = DotProduct(output_dim, bias=False)

self.orthogonal_linear2 = th.nn.Linear(output_dim, output_dim, bias=False)

def forward(self, x):

x = self.orthogonal_linear1(x)

x = self.diag_dotproduct1(x)

x = self.orthogonal_linear2(x)

return x

class SVDLoss(th.nn.Module):

def __init__(self) -> None:

super(MRRLoss, self).__init__()

def forward(self, y_pred, y_true, model, regularizer_weights=[1, 1]) -> th.FloatTensor:

regularizer = 0

for name, param in model.named_parameters():

if name.startswith('orthogonal_'):

regularizer += self.singular_vectors_orthogonality_regularizer(param) * regularizer_weights[0]

if name.startswith('diag_'):

regularizer += self.singular_values_sparsity_inducing_regularizer(param) * regularizer_weights[1]

error = y_pred - y_true

loss = error * error + regularizer

return loss

def singular_vectors_orthogonality_regularizer(self, x):

return th.norm(th.mm(x.t(), x) - th.eye(x.shape[1]), p='fro') / x.shape[1] / x.shape[1]

def singular_values_sparsity_inducing_regularizer(self, x):

# return th.norm(x, 1)

return th.norm(x, 1) / th.norm(x, 2)

然后我还有一个问题,就是我想写一个函数把任意模型重构成SVD形式的模型,但是我发现这必须先定义一个函数,返回值是一个class,这事情还真从来没做过,突然就触及到经验盲区了,直觉上是可行的。

05-24

- 中午莫名其妙又吃不下饭,实话说这个月胃口还没坏过。一直暗示自己要开心些,却不那么容易,只有跑步时才能让大脑进入暂时的空白。

- 下午算法考试写完第一个交掉,其实以我的性格是不会去提前交卷的,一定是严谨地检查到最后一秒。但就是有那么幼稚,就是想在最后的最后在某人面前装一次B。

- 这次写得很顺,四道大题全部想出来,有高中考数学竞赛的那种感觉,其实也是想秀一下lth,让他知道我也宝刀不老,不是看我数分考了60几分就以为我真的是菜了,数竞人的血统是不会这么快衰败的,你是如此,我也不会逊色于你,术业有专攻罢了,四年后鹿死谁手尚未知。

- 考完试一改颓势,状态振奋,顶着烈日跑了五圈,对我来说这是个可以接受的状态。接下来真的真的别让我再遇见你哪怕一次了,逃避虽然可耻,但是对忘记过去来说也许确实是有效的。

昨晚小熬夜把中国统计图鉴和中国金融图鉴(from中国知网)的爬虫给做了,有空水一篇blog,数据暂时得到保障,虽然我大概率还是复现不了全部[菜B]。但愿下午考试别翻车,真是一生之敌了。

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import re

import requests

from bs4 import BeautifulSoup

def download_chinese_statistical_yearbook(ybcode='N2020100004', is_initial=True):

headers = {'User-Agent': 'User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:82.0) Gecko/20100101 Firefox/82.0'}

query_url = 'https://data.cnki.net/Yearbook/PartialGetCatalogResult'

excel_url = 'https://data.cnki.net/{}'.format

caj_url = 'https://data.cnki.net/download/GetCajUrl'

regex = r'<[^>]+>'

compiler = re.compile(regex, re.S)

formdata = {

'ybcode': ybcode,

'entrycode': '',

'page': '1',

'pagerow': '20'

}

response = requests.post(query_url, data=formdata, headers=headers)

html = response.text

soup = BeautifulSoup(html, 'lxml')

span = soup.find('span', class_='s_p_listl')

for link in span.find_all('a'):

page = str(link.string)

print('第{}页..'.format(page))

if not page == '1':

formdata = {

'ybcode': ybcode,

'entrycode': '',

'page': page,

'pagerow': '20'

}

response = requests.post(query_url, data=formdata, headers=headers)

html = response.text

soup = BeautifulSoup(html, 'lxml')

table = soup.find('table')

for tr in table.find_all('tr'):

tds = tr.find_all('td')

assert len(tds) == 3

title = compiler.sub('', str(tds[0])).replace('\n', '').replace('\t', '').replace(' ', '')

page_range = compiler.sub('', str(tds[1])).replace('\n', '').replace('\t', '').replace(' ', '')

for _link in tds[2].find_all('a'):

href = _link.attrs['href']

if href.startswith('/download/excel'): # excel

filecode = href[href.find('=')+1:]

response = requests.get(excel_url(href), headers=headers)

with open('{}.xls'.format(filecode), 'wb') as f:

f.write(response.content)

with open('log.txt', 'a') as f:

f.write('{}\t{}\t{}.xls\n'.format(title, page_range, filecode))

else: # caj

filecode = _link.attrs['fn']

pagerange = _link.attrs['pg']

disk = _link.attrs['disk']

_formdata = {

'filecode': filecode,

'pagerange': pagerange,

'disk': disk,

}

response = requests.post(caj_url, headers=headers, data=_formdata)

resource_url = response.json()['url']

print(resource_url)

input()

response = requests.get(resource_url, headers=headers)

with open('{}.caj'.format(filecode), 'wb') as f:

f.write(response.content)

with open('log.txt', 'a') as f:

f.write('{}\t{}\t{}.xls\n'.format(title, page_range, filecode))

# Find urls of year

if is_initial is True:

url = 'https://data.cnki.net/trade/Yearbook/Single/{}?z=Z016'.format(ybcode)

response = requests.get(url, headers=headers)

html = response.text

soup = BeautifulSoup(html, 'lxml')

div = soup.find('div', class_='s_year clearfix')

links = []

ybcodes = []

for link in div.find_all('a'):

class_ = link.attrs.get('class')

if class_ is not None: # not current

href = link.attrs.get('href')

ybcode = href.split('/')[-1].split('?')[0]

links.append(href)

ybcodes.append(href)

for ybcode in ybcodes:

download_chinese_statistical_yearbook(ybcode=ybcode, is_initial=False)

if __name__ == '__main__':

download_chinese_statistical_yearbook()

05-25

- 组会开始前十分钟wyl问今天要不让我来讲,好在我早有准备。讲得还不错,就像是聊天一样,轻松且享受,如果与别人聊天也能这么简单就好了。

- 晚饭后直接进场五圈,状态挺不错,果然睡好比啥都强,明天下雨凉快,计划再试一次10k+的距离,没什么明确的目标,一切看状态。

- 晚上课上突然发现自己wx也被删了好友,我最近可真的是什么事都没做,结果也这么绝么。不过这下一点儿痕迹都无了,已经所有社交平台都被拉黑,然而可笑的是三教806窗外一瞥就发现20号楼正对着。彼时彼刻,恰如此时此刻,唉,宁可她真的是从未来过,可是为什么还这么容易地能看得到呢,就不该在自己这么多课的一个学期动这种心思,到头来落得一事无成的下场。

最近在看自动解题,认知推理这方面的东西,限于时间并没有给每篇paper做详细的笔注,只做了速读的笔注,推荐下面这篇很有帮助:

论文标题:Differentiable Learning of Logic Rules for Knowledge Base Reasoning

中文标题:基于知识推理的逻辑规则可微学习

下载链接:arxiv@1702.08367

项目地址:GitHub@ProPPR

上面这篇是基于外部知识的推理,下面这篇则是单纯的模板方法解决代数问题,不过也用到了概率模型,方法值得借鉴:

论文标题:Learning to Automatically Solve Algebra Word Problems

中文标题:学习自动求解代数语言问题

下载链接:Citeseer

项目地址:wordsprobs

目前我只看了后面这篇,也是今天汇报掉的,虽然任务相对简单,不过方法很值得借鉴。

05-26

- 七点已经在下雨,进不了场,索性回笼觉,似乎将是要下一天的雨[胃疼]。

- 下午趁雨小了一些进场10圈,可惜越跑下得越大,10圈悻悻而归。

我最近发现一种自动更新爬虫cookie的方法,需要更新cookie的时候直接用selenium去请求一下,再提取driver.get_cookies()即可,返回的值是一个字典的列表,然后只需要取每个字典中的name和value字段,按照'{}={}; '.format(name, value)的格式将它们拼接起来即可。

其实据我所知,cookiejar还有一些别的包或许也可以来存储cookie,不过我记得以前用过不是很好用,最近发现的这个办法可以快速更新cookie,避免爬虫失效。

05-27

- 《致陌生的你》,河图少有的现代歌,旋律好,演唱难度也很低。只是一直以为歌词是一首写挚友的歌曲,今天重新再听,又不是那样,似乎怎么理解都合理,只是我的心境不同罢了。

- 毒热的太阳,起了10km的状态,最终只跑出5km历史最好成绩21’09"。实际上并没有专门测过自己5km,从6km的最好成绩来看,之前的5km pb大约是21’40"上下,这次算是相当高的提升,不过即便是6km也是2个多月之前跑的了,算意料之中。最终目标是5km破20分。

- sxy的麦当劳探店连续剧已经升级成自带下集预告的版本了… 自由自在的吃也是一种不错的生活方式,也不该把自己逼太紧。不过从定位上来看感觉是要吃遍五角场附近所有的连锁店么…

现在关于最速梯度下降就更迷了,下课我问了一次郭加熠,得到的答复和江波截然不同,郭认为最速梯度下降就是在找方向,所谓在方向上找下降最多的步长那是Exact line search,不叫最速梯度下降,然后郭还说江的slide上是把最速梯度下降的标题给写错了,但是我也学了好多遍最速梯度下降了,都没有听说过郭这种说法,网上搜下来也都是与Exact line search一样的定义,但是Boyd的教材上还真是这种跟郭说的一样,到底谁是对的…

计划再CIFAR-10上面做SVD training的测试,过几天给些结果。torch自己给了一个直接下载CIFAR10数据集的接口,不过也可以自己到http://www.cs.toronto.edu/~kriz/cifar.html自取:

import torchvision as tv #里面含有许多数据集

import torch

import torchvision.transforms as transforms #实现图片变换处理的包

from torchvision.transforms import ToPILImage

#使用torchvision加载并预处理CIFAR10数据集

show = ToPILImage() #可以把Tensor转成Image,方便进行可视化

transform = transforms.Compose([transforms.ToTensor(),transforms.Normalize(mean = (0.5,0.5,0.5),std = (0.5,0.5,0.5))])#把数据变为tensor并且归一化range [0, 255] -> [0.0,1.0]

trainset = tv.datasets.CIFAR10(root='data1/',train = True,download=True,transform=transform)

trainloader = torch.utils.data.DataLoader(trainset,batch_size=4,shuffle=True,num_workers=0)

testset = tv.datasets.CIFAR10('data1/',train=False,download=True,transform=transform)

testloader = torch.utils.data.DataLoader(testset,batch_size=4,shuffle=True,num_workers=0)

classes = ('plane','car','bird','cat','deer','dog','frog','horse','ship','truck')

(data,label) = trainset[100]

print(classes[label])#输出ship

show((data+1)/2).resize((100,100))

dataiter = iter(trainloader)

images, labels = dataiter.next()

print(' '.join('%11s'%classes[labels[j]] for j in range(4)))

show(tv.utils.make_grid((images+1)/2)).resize((400,100))#make_grid的作用是将若干幅图像拼成一幅图像

05-28

- 似乎有人总是半夜一两点来这儿,劝你们早点睡觉,年纪大了有你们后悔的。

- wyl并不打算放过我,即便我还有五门专业课要上到16周,外加两个期末项目和三四次专业作业。

- 最近状态非常不错,吃得好睡得好,可惜今天太闷,晚饭后试了两圈就脱力了,等晚课下再去试试。

- 哈哈哈,晚课提前溜去跑步,居然在电梯里遇到方慧和史钞老师,听sc说也要去跑步,于是偷偷跟着去偷拍了几张他做准备活动和跑步的雅照。感觉抄男神似乎也是那种不太会跟女老师聊天的人。不过yysy,钞男神的腿真的是一绝,看了男默女泪…

眼下在实现卷积层的分解,重拾一下卷积层,发现把卷积层转为全连接层还是有点意思的,计划会有一篇不错的博客,预告下一篇博客SVD训练的实现,相信我这会是个很有趣的东西。

事实上在E:\Anaconda3\Lib\site-packages\torchvision\models下面有不少流行模型的开源代码,随着torchvision的升级会不断更新新的研究结果进来,包括老牌的alexnet,resnet,imagenet,以及现在一些新的googlenet等,而且这些代码可以其实直接复制过来就能用,都不需要做什么修改,然后就可以在巨人肩膀上试着去重构模型了。

05-29

- 呆在520半天,反锁大门,感觉可以把520当成自己的工位用了,没人来,门也不锁,一个人一个教室岂不美哉。

- 晚上状态极好,进场看到WXY和两个认识的大爷,热身跟了他们一两圈,本来还是奔着10km去的,可惜第5个1000米起快了,第6个1000米减不下来只得提速冲刺,最后成功把6km的pb突破到26’10",非常不错(这次应该是被WXY注意到了,他肯定很惊讶学校里除了他还有这么能跑的哈哈),尘封两个多月的6km个人最好被刷新了(其实只是很久不跑6km了… 感觉现在认真跑6km有机会跑进26分,可惜好状态不常有唉)。

全连接层转卷积层很简单(FCN即可),反过来呢?

卷积层的分解已经写完了,再凑点内容准备水博客了(假如王英林不来烦我的话)。

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import torch

from torch import nn

# 将给定的二维卷积层转换为线性层

def conv2d_to_linear(conv2d, input_height, input_width):

# 卷积层输出维度的计算公式:$O=\frac{W-K+2P}{S}+1$

def _clac_output_size(_input_size, _kernel_size, _stride_size, _padding_size=0):

_output_size = (_input_size - _kernel_size + _padding_size * 2) / _stride_size + 1

return int(_output_size) # 一般来说,padding的目的是使得

# 将三维索引转成一维索引

def _index3d_to_index1d(_channel, _height, _width, _height_dim, _width_dim):

return _channel * _height_dim * _width_dim + _height * _width_dim + _width

# 将一维索引转回三维索引

def _index1d_to_index3d(_index, _height_dim, _width_dim):

_size = _height_dim * _width_dim

_channel = _index // _size

_height = (_index - _channel * _size) // _width_dim

_width = _index - _channel * _size - _height * _width_dim

return _channel, _height, _width

conv_weight = conv2d.weight # 卷积层的权重矩阵

out_channels, in_channels, kernel_height, kernel_width = conv_weight.shape # 卷积层权重张量的形状:[输出管道数,输入管道数,卷积核高度,卷积核宽度]

stride_height, stride_width = conv2d.stride # 高度与宽度方向上卷积核每次移动的步长

padding_height, padding_width = conv2d.padding # 高度与宽度方向上输入矩阵

output_height = _clac_output_size(input_height, kernel_height, stride_height, padding_height) # 每个管道上的输出高度

output_width = _clac_output_size(input_width, kernel_width, stride_width, padding_width) # 每个管道上的输出宽度

input_dim = in_channels * input_height * input_width # 输入的总维度数(将输入张量拉平为向量)

output_dim = out_channels * output_height * output_width # 输出的总维度数(将输入张量拉平为向量)

linear_weight = torch.zeros((output_dim, input_dim)) # 初始化线性层的权重矩阵全零

for output_index in range(output_dim): # 遍历每一个输出维度(一维索引)

_output_channel, _output_height, _output_width = _index1d_to_index3d(output_index,

output_height,

output_width) # 将对应的一维索引转回成三维索引

# 因为有stride的存在,输出点对应的起始坐标未必和输入点对应的起始坐标一致

start_height = _output_height * stride_height # 对应_output_height的输入高度方向的起始坐标

start_width = _output_width * stride_width # 对应_output_width的输入宽度方向的起始坐标

for _input_height in range(start_height, start_height + kernel_height): # 遍历此时卷积核对应的所有输入高度方向上的坐标

for _input_width in range(start_width, start_width + kernel_width): # 遍历此时卷积核对应的所有输入宽度方向上的坐标

for in_channel in range(in_channels): # 遍历所有的管道

input_index = _index3d_to_index1d(in_channel,

_input_height,

_input_width,

input_height,

input_width) # 找到对应的输出维度上的一维索引

linear_weight[output_index, input_index] = conv_weight[_output_channel,

in_channel,

_input_height - start_height,

_input_width - start_width] # 修正线性层的权重矩阵

return linear_weight

if __name__ == '__main__':

conv2d = nn.Conv2d(in_channels=2, out_channels=3, kernel_size=2, stride=1)

image_height = 5

image_width = 5

linear = conv2d_to_linear(conv2d, image_height, image_width)

print(conv2d.weight)

print(linear)

print(linear.shape)

05-30

- 凌晨熬夜把之前看的一篇paper实现完,水了一篇以SVD的分解形式进行深度神经网络的训练,算是一次热身吧,可能是一个月熬得最晚的一次。人一到很晚就会想些乱七八糟的东西,文章结束写了几行废话,深夜还是适合睡觉。

- 最后两天,能否有机会10km破44分?感觉这个月的水平有显著提升,这两日状态OK,可惜前天弄丢了跑步用的三分裤,有点心疼…

- 傍晚4.05km用时17’14",逼近4km的pb(16’56"),没有尽全力。至此,4~6km全部恢复到巅峰水平,等一个好天气,准备冲新的10km pb。

信用规模是不是就是负债规模???我要疯了。

二维卷积层转全连接层的实现(卷积核–>权重矩阵):

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import torch

from torch import nn

# 将给定的二维卷积层转换为线性层

def conv2d_to_linear(conv2d, input_height, input_width):

# 卷积层输出维度的计算公式:$O=\frac{W-K+2P}{S}+1$

def _clac_output_size(_input_size, _kernel_size, _stride_size, _padding_size=0):

_output_size = (_input_size - _kernel_size + _padding_size * 2) / _stride_size + 1

return int(_output_size) # 一般来说,padding的目的是使得

# 将三维索引转成一维索引

def _index3d_to_index1d(_channel, _height, _width, _height_dim, _width_dim):

return _channel * _height_dim * _width_dim + _height * _width_dim + _width

# 将一维索引转回三维索引

def _index1d_to_index3d(_index, _height_dim, _width_dim):

_size = _height_dim * _width_dim

_channel = _index // _size

_height = (_index - _channel * _size) // _width_dim

_width = _index - _channel * _size - _height * _width_dim

return _channel, _height, _width

conv_weight = conv2d.weight # 卷积层的权重矩阵

out_channels, in_channels, kernel_height, kernel_width = conv_weight.shape # 卷积层权重张量的形状:[输出管道数,输入管道数,卷积核高度,卷积核宽度]

stride_height, stride_width = conv2d.stride # 高度与宽度方向上卷积核每次移动的步长

padding_height, padding_width = conv2d.padding # 高度与宽度方向上输入矩阵

output_height = _clac_output_size(input_height, kernel_height, stride_height, padding_height) # 每个管道上的输出高度

output_width = _clac_output_size(input_width, kernel_width, stride_width, padding_width) # 每个管道上的输出宽度

input_dim = in_channels * input_height * input_width # 输入的总维度数(将输入张量拉平为向量)

output_dim = out_channels * output_height * output_width # 输出的总维度数(将输入张量拉平为向量)

linear_weight = torch.zeros((output_dim, input_dim)) # 初始化线性层的权重矩阵全零

for output_index in range(output_dim): # 遍历每一个输出维度(一维索引)

_output_channel, _output_height, _output_width = _index1d_to_index3d(output_index,

output_height,

output_width) # 将对应的一维索引转回成三维索引

# 因为有stride的存在,输出点对应的起始坐标未必和输入点对应的起始坐标一致

start_height = _output_height * stride_height # 对应_output_height的输入高度方向的起始坐标

start_width = _output_width * stride_width # 对应_output_width的输入宽度方向的起始坐标

for _input_height in range(start_height, start_height + kernel_height): # 遍历此时卷积核对应的所有输入高度方向上的坐标

for _input_width in range(start_width, start_width + kernel_width): # 遍历此时卷积核对应的所有输入宽度方向上的坐标

for in_channel in range(in_channels): # 遍历所有的管道

input_index = _index3d_to_index1d(in_channel,

_input_height,

_input_width,

input_height,

input_width) # 找到对应的输出维度上的一维索引

linear_weight[output_index, input_index] = conv_weight[_output_channel,

in_channel,

_input_height - start_height,

_input_width - start_width] # 修正线性层的权重矩阵

return linear_weight

05-31

- 偶然发现研代会群里有认识的人。

- 午饭后即兴测了一次400米,果然在短跑上还是个fw,75秒都跑不进。

- 晚上lh临时通知我ITCS要玩飞盘,于是取消了今天冲10km pb的计划,我的天,来了四五个清华北大,还有姚班的学生,剩下的都是交大浙大计算机的同好,那个北大飞盘协会的会长听lh说我能跑半马,全程盯着我一个人防,玩了一个多小时,差点没把我的心肺跑炸掉。临走时我看到WXY在跑,似乎已经跑了很久了,于是我顶着爆炸的心肺跟了他五圈,他是4’09"的配速,显然不是他最好的状态(他5km能跑进18分半),我猜可能是在跑20km,五圈后我实在是心肺承受不了了,只得退场,下次看到他一定加个wx,每天跟他练练速度。

带正交正则项与稀疏正则项的交叉熵损失:

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import torch

from torch.nn import functional as F

class CrossEntropyLossSVD(torch.nn.CrossEntropyLoss):

def __init__(self, weight=None, size_average=None, ignore_index=-100, reduce=None, reduction='mean'):

super(CrossEntropyLossSVD, self).__init__(

weight=weight,

size_average=size_average,

ignore_index=ignore_index,

reduce=reduce,

reduction=reduction,

)

def forward(self, input, target, model=None, regularizer_weights=[1, 1], orthogonal_suffix='svd_weight_matrix', sparse_suffix='svd_weight_vector', mode='lh') -> torch.FloatTensor:

cross_entropy_loss = F.cross_entropy(input, target, weight=self.weight, ignore_index=self.ignore_index, reduction=self.reduction)

if model is None:

return cross_entropy_loss

# 正交正则器

def _orthogonality_regularizer(x): # x应当是一个2D张量(矩阵)且高大于宽

return torch.norm(torch.mm(x.t(), x) - torch.eye(x.shape[1]).cuda(), p='fro') / x.shape[1] / x.shape[1]

# 稀疏导出正则器

def _sparsity_inducing_regularizer(x, mode='lh'): # x应当是一个1D张量(向量)

mode = mode.lower()

if mode == 'lh':

return torch.norm(x, 1) / torch.norm(x, 2)

elif model == 'l1':

return torch.norm(x, 1)

raise Exception(f'Unknown mode: {mode}')

regularizer = torch.zeros(1, ).cuda()

for name, parameter in model.named_parameters():

lastname = name.split('.')[-1]

if lastname.startswith(orthogonal_suffix): # 奇异向量矩阵参数:添加正交正则项

regularizer += _orthogonality_regularizer(parameter) * regularizer_weights[0]

elif lastname.startswith(sparse_suffix): # 奇异值向量参数:添加稀疏导出正则项

regularizer += _sparsity_inducing_regularizer(parameter, mode) * regularizer_weights[1]

return cross_entropy_loss + regularizer

June 2021

06-01

- 早起腰酸背痛,都快挺不起来了,上半身锻炼太少… 昨天手环测下来一共跑了11km多,刨去本来就跑了6圈,玩飞盘差不多跑了有9km,有两只脚趾的关节处磨破,很久脚上不受伤了。不过实话对抗性强一点的极限飞盘还是确实很有意思,多接触点人也开心些,玩爽了就只得熬夜写了一晚上作业…

- 有很不好的感觉,我好像又被人拉黑了…

- 晚上试跑了四圈,从躯干疼到大腿到脚尖,全身上下除了脑袋,全部都酸胀得厉害,昨天就不该在那么累得情况下还跟WXY跑五圈,怕真伤到了。

M / M / ∞ M/M/∞ M/M/∞排队系统性质:

-

设 Δ t \Delta t Δt是一个充分小的正数,对于每台服务器(server),若在时刻 t t t观察到该服务器处于繁忙,则定义如下两个事件:

- 事件 A A A:在该条件下,接下来 Δ t \Delta t Δt时间内该服务器仍然保持繁忙状态。

- 事件 B B B:在该条件下,接下来 Δ t \Delta t Δt时间内该服务器服务终止。

则根据指数分布的无记忆性,可得:

Pr ( A ) = Pr ( Z ≥ t + Δ t ∣ Z ≥ t ) = Pr ( Z ≥ Δ t ) = e − μ Δ t ≈ 1 − μ Δ t + o ( Δ t ) Pr ( B ) = Pr ( Z ≤ t + Δ t ∣ Z ≥ t ) = Pr ( Z ≥ Δ t ) = 1 − e − μ Δ t ≈ μ Δ t + o ( Δ t ) (1.1) \Pr(A)=\Pr\left(Z\ge t+\Delta t|Z\ge t\right)=\Pr\left(Z\ge\Delta t\right)=e^{-\mu\Delta t}\approx1-\mu\Delta t+o(\Delta t)\\ \Pr(B)=\Pr\left(Z\le t+\Delta t|Z\ge t\right)=\Pr\left(Z\ge\Delta t\right)=1-e^{-\mu\Delta t}\approx\mu\Delta t+o(\Delta t)\tag{1.1} Pr(A)=Pr(Z≥t+Δt∣Z≥t)=Pr(Z≥Δt)=e−μΔt≈1−μΔt+o(Δt)Pr(B)=Pr(Z≤t+Δt∣Z≥t)=Pr(Z≥Δt)=1−e−μΔt≈μΔt+o(Δt)(1.1)

设 N ( t ) N(t) N(t)是直到时刻 t t t时所有来访客户的总数,根据泊松过程的性质,可得:

Pr ( N ( t + Δ t ) − N ( t ) = 0 ) = 1 − λ Δ t + o ( Δ t ) Pr ( N ( t + Δ t ) − N ( t ) = 1 ) = 1 − e − λ Δ t = λ Δ t + o ( Δ t ) Pr ( N ( t + Δ t ) − N ( t ) ≥ 2 ) = o ( Δ t ) (1.2) \begin{aligned} \Pr(N(t+\Delta t)-N(t)=0)&=1-\lambda\Delta t+o(\Delta t)\\ \Pr(N(t+\Delta t)-N(t)=1)&=1-e^{-\lambda\Delta t}=\lambda\Delta t+o(\Delta t)\\ \Pr(N(t+\Delta t)-N(t)\ge2)&=o(\Delta t) \end{aligned}\tag{1.2} Pr(N(t+Δt)−N(t)=0)Pr(N(t+Δt)−N(t)=1)Pr(N(t+Δt)−N(t)≥2)=1−λΔt+o(Δt)=1−e−λΔt=λΔt+o(Δt)=o(Δt)(1.2)

根据式 ( 1.1 ) (1.1) (1.1)与式 ( 1.2 ) (1.2) (1.2)的结论,可知在 Δ t \Delta t Δt时间内同时有不低于 2 2 2个服务器服务终止或不低于 2 2 2个客户到来的概率都是 o ( Δ t ) o(\Delta t) o(Δt),则有:

Pr ( X ( t + Δ t ) = i + 1 ∣ X ( t ) = i ) = ∑ k = 0 i [ Pr ( Exactly k services are finished , N ( t + Δ t ) − N ( t ) = k + 1 ∣ X ( t = i ) ) ] = Pr ( No service is finished , N ( t + Δ t ) − N ( t ) = 1 ∣ X ( t ) = i ) + o ( Δ t ) = Pr ( No service is finished ∣ X ( t ) = i ) ⋅ Pr ( N ( t + Δ t ) − N ( t ) = 1 ) + o ( Δ t ) = [ Pr ( A ) ] i ⋅ ( λ Δ t + o ( Δ t ) ) + o ( Δ t ) = ( 1 − μ Δ t + o ( Δ t ) ) i ( λ Δ t + o ( Δ t ) ) + o ( Δ t ) = ( 1 − i μ Δ t + o ( Δ t ) ) ( λ Δ t + o ( Δ t ) ) + o ( Δ t ) = λ Δ t + o ( Δ t ) ( i = 0 , 1 , 2 , . . . ) (1.3) \begin{aligned} \Pr\left(X(t+\Delta t)=i+1|X(t)=i\right)&=\sum_{k=0}^i\left[\Pr\left(\text{Exactly }k\text{ services are finished},N(t+\Delta t)-N(t)=k+1|X(t=i)\right)\right]\\ &=\Pr(\text{No service is finished},N(t+\Delta t)-N(t)=1|X(t)=i)+o(\Delta t)\\ &=\Pr(\text{No service is finished}|X(t)=i)\cdot\Pr(N(t+\Delta t)-N(t)=1)+o(\Delta t)\\ &=\left[\Pr(A)\right]^i\cdot(\lambda\Delta t+o(\Delta t))+o(\Delta t)\\ &=(1-\mu\Delta t+o(\Delta t))^i(\lambda\Delta t+o(\Delta t))+o(\Delta t)\\ &=(1-i\mu\Delta t+o(\Delta t))(\lambda\Delta t+o(\Delta t))+o(\Delta t)\\ &=\lambda \Delta t+o(\Delta t)\quad(i=0,1,2,...) \end{aligned}\tag{1.3} Pr(X(t+Δt)=i+1∣X(t)=i)=k=0∑i[Pr(Exactly k services are finished,N(t+Δt)−N(t)=k+1∣X(t=i))]=Pr(No service is finished,N(t+Δt)−N(t)=1∣X(t)=i)+o(Δt)=Pr(No service is finished∣X(t)=i)⋅Pr(N(t+Δt)−N(t)=1)+o(Δt)=[Pr(A)]i⋅(λΔt+o(Δt))+o(Δt)=(1−μΔt+o(Δt))i(λΔt+o(Δt))+o(Δt)=(1−iμΔt+o(Δt))(λΔt+o(Δt))+o(Δt)=λΔt+o(Δt)(i=0,1,2,...)(1.3)Pr ( X ( t + Δ t ) = i − 1 ∣ X ( t ) = i ) = ∑ k = 1 i [ Pr ( Exactly k services are finished , N ( t + Δ t ) − N ( t ) = k − 1 ∣ X ( t = i ) ) ] = Pr ( Exactly 1 service is finished , N ( t + Δ t ) − N ( t ) = 0 ∣ X ( t ) = i ) + o ( Δ t ) = Pr ( Exactly 1 service is finished ∣ X ( t ) = i ) ⋅ Pr ( N ( t + Δ t ) − N ( t ) = 0 ) + o ( Δ t ) = i ⋅ [ Pr ( A ) ] i − 1 ⋅ Pr ( B ) ⋅ ( 1 − λ Δ t + o ( Δ t ) ) + o ( Δ t ) = i ⋅ ( 1 − μ Δ t + o ( Δ t ) ) i − 1 ⋅ ( μ Δ t + o ( Δ t ) ) ⋅ ( 1 − λ Δ t + o ( Δ t ) ) + o ( Δ t ) = i ⋅ ( 1 − ( i − 1 ) μ Δ t + o ( Δ t ) ) ⋅ ( μ Δ t + o ( Δ t ) ) ⋅ ( 1 − λ Δ t + o ( Δ t ) ) + o ( Δ t ) = i μ Δ t + o ( Δ t ) ( i = 1 , 2 , 3 , . . . ) (1.4) \begin{aligned} \Pr\left(X(t+\Delta t)=i-1|X(t)=i\right)&=\sum_{k=1}^i\left[\Pr\left(\text{Exactly }k\text{ services are finished},N(t+\Delta t)-N(t)=k-1|X(t=i)\right)\right]\\ &=\Pr(\text{Exactly 1 service is finished},N(t+\Delta t)-N(t)=0|X(t)=i)+o(\Delta t)\\ &=\Pr(\text{Exactly 1 service is finished}|X(t)=i)\cdot\Pr(N(t+\Delta t)-N(t)=0)+o(\Delta t)\\ &=i\cdot\left[\Pr(A)\right]^{i-1}\cdot\Pr(B)\cdot(1-\lambda\Delta t+o(\Delta t))+o(\Delta t)\\ &=i\cdot(1-\mu\Delta t+o(\Delta t))^{i-1}\cdot(\mu\Delta t+o(\Delta t))\cdot(1-\lambda\Delta t+o(\Delta t))+o(\Delta t)\\ &=i\cdot(1-(i-1)\mu\Delta t+o(\Delta t))\cdot(\mu\Delta t+o(\Delta t))\cdot(1-\lambda\Delta t+o(\Delta t))+o(\Delta t)\\ &=i\mu\Delta t+o(\Delta t)\quad(i=1,2,3,...) \end{aligned}\tag{1.4} Pr(X(t+Δt)=i−1∣X(t)=i)=k=1∑i[Pr(Exactly k services are finished,N(t+Δt)−N(t)=k−1∣X(t=i))]=Pr(Exactly 1 service is finished,N(t+Δt)−N(t)=0∣X(t)=i)+o(Δt)=Pr(Exactly 1 service is finished∣X(t)=i)⋅Pr(N(t+Δt)−N(t)=0)+o(Δt)=i⋅[Pr(A)]i−1⋅Pr(B)⋅(1−λΔt+o(Δt))+o(Δt)=i⋅(1−μΔt+o(Δt))i−1⋅(μΔt+o(Δt))⋅(1−λΔt+o(Δt))+o(Δt)=i⋅(1−(i−1)μΔt+o(Δt))⋅(μΔt+o(Δt))⋅(1−λΔt+o(Δt))+o(Δt)=iμΔt+o(Δt)(i=1,2,3,...)(1.4)

Pr ( X ( t + Δ t ) = i ∣ X ( t ) = i ) = ∑ k = 0 i [ Pr ( Exactly k services are finished , N ( t + Δ t ) − N ( t ) = k ∣ X ( t = i ) ) ] = Pr ( No service is finished , N ( t + Δ t ) − N ( t ) = 0 ∣ X ( t ) = i ) + Pr ( Exactly 1 service is finished , N ( t + Δ t ) − N ( t ) = 1 ∣ X ( t ) = i ) + o ( Δ t ) = Pr ( No service is finished ∣ X ( t ) = i ) ⋅ Pr ( N ( t + Δ t ) − N ( t ) = 0 ) + Pr ( Exactly 1 service is finished ∣ X ( t ) = i ) ⋅ Pr ( N ( t + Δ t ) − N ( t ) = 1 ) + o ( Δ t ) = [ Pr ( A ) ] i ⋅ ( 1 − λ Δ t + o ( Δ t ) ) + i ⋅ [ Pr ( A ) ] i − 1 ⋅ Pr ( B ) ⋅ ( λ Δ t + o ( Δ t ) ) + o ( Δ t ) = ( 1 − μ Δ t + o ( Δ t ) ) i ( 1 − λ Δ t + o ( Δ t ) ) + i ( 1 − μ Δ t + o ( Δ t ) ) i − 1 ( μ Δ t + o ( Δ t ) ) ( λ Δ t + o ( Δ t ) ) + o ( Δ t ) = 1 − i μ Δ t − λ Δ t + o ( Δ t ) = 1 − ( i μ + λ ) Δ t + o ( Δ t ) ( i = 0 , 1 , 2 , . . . ) (1.5) \begin{aligned} \Pr\left(X(t+\Delta t)=i|X(t)=i\right)&=\sum_{k=0}^i\left[\Pr\left(\text{Exactly }k\text{ services are finished},N(t+\Delta t)-N(t)=k|X(t=i)\right)\right]\\ &=\Pr(\text{No service is finished},N(t+\Delta t)-N(t)=0|X(t)=i)\\ &\quad+\Pr(\text{Exactly 1 service is finished},N(t+\Delta t)-N(t)=1|X(t)=i)+o(\Delta t)\\ &=\Pr(\text{No service is finished}|X(t)=i)\cdot\Pr(N(t+\Delta t)-N(t)=0)\\ &\quad+\Pr(\text{Exactly 1 service is finished}|X(t)=i)\cdot\Pr(N(t+\Delta t)-N(t)=1)+o(\Delta t)\\ &=\left[\Pr(A)\right]^i\cdot(1-\lambda\Delta t+o(\Delta t))+i\cdot\left[\Pr(A)\right]^{i-1}\cdot\Pr(B)\cdot(\lambda\Delta t+o(\Delta t))+o(\Delta t)\\ &=(1-\mu\Delta t+o(\Delta t))^i(1-\lambda\Delta t+o(\Delta t))\\ &\quad+i(1-\mu\Delta t+o(\Delta t))^{i-1}(\mu\Delta t+o(\Delta t))(\lambda\Delta t+o(\Delta t))+o(\Delta t)\\ &=1-i\mu\Delta t-\lambda\Delta t+o(\Delta t)\\ &=1-(i\mu+\lambda)\Delta t+o(\Delta t)\quad(i=0,1,2,...) \end{aligned}\tag{1.5} Pr(X(t+Δt)=i∣X(t)=i)=k=0∑i[Pr(Exactly k services are finished,N(t+Δt)−N(t)=k∣X(t=i))]=Pr(No service is finished,N(t+Δt)−N(t)=0∣X(t)=i)+Pr(Exactly 1 service is finished,N(t+Δt)−N(t)=1∣X(t)=i)+o(Δt)=Pr(No service is finished∣X(t)=i)⋅Pr(N(t+Δt)−N(t)=0)+Pr(Exactly 1 service is finished∣X(t)=i)⋅Pr(N(t+Δt)−N(t)=1)+o(Δt)=[Pr(A)]i⋅(1−λΔt+o(Δt))+i⋅[Pr(A)]i−1⋅Pr(B)⋅(λΔt+o(Δt))+o(Δt)=(1−μΔt+o(Δt))i(1−λΔt+o(Δt))+i(1−μΔt+o(Δt))i−1(μΔt+o(Δt))(λΔt+o(Δt))+o(Δt)=1−iμΔt−λΔt+o(Δt)=1−(iμ+λ)Δt+o(Δt)(i=0,1,2,...)(1.5)

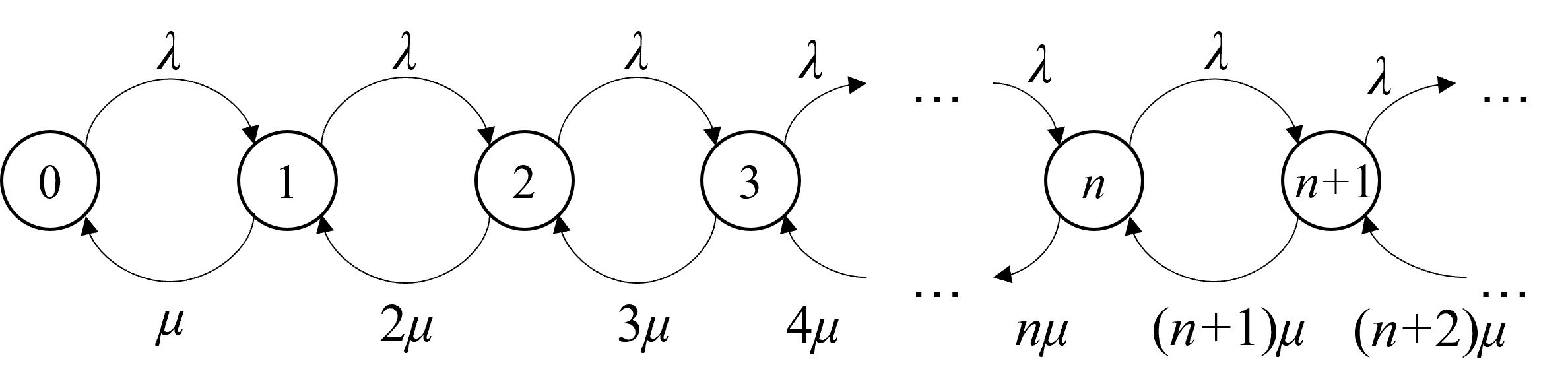

知 M / M / ∞ M/M/\infty M/M/∞排队系统对应生灭过程的状态空间为 X = N = { 0 , 1 , 2 , . . . } \mathcal{X}=\N=\{0,1,2,...\} X=N={0,1,2,...}

根据式 ( 1.3 ) ( 1.4 ) ( 1.5 ) (1.3)(1.4)(1.5) (1.3)(1.4)(1.5),状态转移率矩阵 Q = { q i j } Q=\{q_{ij}\} Q={qij}具有如下的显式表达:

q i j = { 0 if j > i + 1 or j < i − 1 λ if j = i + 1 i μ if j = i − 1 − λ − i μ if j = i (1.6) q_{ij}=\left\{\begin{aligned} &0&&\text{if }j>i+1\text{ or }j<i-1\\ &\lambda&&\text{if }j=i+1\\ &i\mu&&\text{if }j=i-1\\ &-\lambda-i\mu&&\text{if }j=i \end{aligned}\right.\tag{1.6} qij=⎩⎪⎪⎪⎪⎨⎪⎪⎪⎪⎧0λiμ−λ−iμif j>i+1 or j<i−1if j=i+1if j=i−1if j=i(1.6)

对应的状态转移率示意图如下所示(省略状态转移到自身的负转移率):

综上所述,式 ( 1.6 ) (1.6) (1.6)与上图即为所求。 ■ \blacksquare ■

-

根据 Slide \text{Slide} Slide中的对应内容,可得一般形式下生灭过程的稳定状态概率(steady state probability)为:

{ π 0 = [ 1 + ∑ n = 1 ∞ ( ∏ k = 0 n − 1 λ k ∏ k = 1 n μ k ) ] − 1 π t = ( ∏ k = 0 t − 1 λ k ∏ k = 1 t μ k ) π 0 ( t = 1 , 2 , . . . ) (1.7) \left\{\begin{aligned} &\pi_0=\left[{1+\sum_{n=1}^\infty\left(\frac{\prod_{k=0}^{n-1}\lambda_k}{\prod_{k=1}^n\mu_k}\right)}\right]^{-1}\\ &\pi_t=\left(\frac{\prod_{k=0}^{t-1}\lambda_k}{\prod_{k=1}^t\mu_k}\right)\pi_0\quad(t=1,2,...) \end{aligned}\right.\tag{1.7} ⎩⎪⎪⎪⎪⎪⎨⎪⎪⎪⎪⎪⎧π0=[1+n=1∑∞(∏k=1nμk∏k=0n−1λk)]−1πt=(∏k=1tμk∏k=0t−1λk)π0(t=1,2,...)(1.7)

其中对应本题的生灭过程,可得具体的 λ i \lambda_i λi与 μ i \mu_i μi的表达式:

{ λ i = λ i = 0 , 1 , 2 , . . . μ i = i μ i = 1 , 2 , 3 , . . . (1.8) \left\{\begin{aligned} &\lambda_i=\lambda&&i=0,1,2,...\\ &\mu_i=i\mu&&i=1,2,3,... \end{aligned}\right.\tag{1.8} {λi=λμi=iμi=0,1,2,...i=1,2,3,...(1.8)

将式 ( 1.8 ) (1.8) (1.8)代入式 ( 1.7 ) (1.7) (1.7)即可得到 M / M / ∞ M/M/\infty M/M/∞排队系统对应生灭过程的稳定状态概率(steady state probability),设 ρ = λ μ \rho=\frac\lambda\mu ρ=μλ:

{ π 0 = [ 1 + ∑ n = 1 ∞ 1 n ! ( λ μ ) n ] − 1 = e − ρ π i = 1 i ! ( λ μ ) i π 0 = 1 i ! ρ i e − ρ i = 1 , 2 , 3 , . . . (1.9) \left\{\begin{aligned} &\pi_0=\left[1+\sum_{n=1}^\infty\frac1{n!}\left(\frac{\lambda}{\mu}\right)^n\right]^{-1}&&=e^{-\rho}&\\ &\pi_i=\frac1{i!}\left(\frac\lambda\mu\right)^i\pi_0&&=\frac1{i!}\rho^ie^{-\rho}&&i=1,2,3,... \end{aligned}\right.\tag{1.9} ⎩⎪⎪⎪⎪⎨⎪⎪⎪⎪⎧π0=[1+n=1∑∞n!1(μλ)n]−1πi=i!1(μλ)iπ0=e−ρ=i!1ρie−ρi=1,2,3,...(1.9)

综上所述,式 ( 1.9 ) (1.9) (1.9)即为所求。 ■ \blacksquare ■ -

效用(utilization)为处于繁忙状态的服务器的期望数量,在 M / M / ∞ M/M/\infty M/M/∞的排队系统中即平均队长(average queue length):

Utilization = ∑ i = 1 ∞ i π i = e − ρ ∑ i = 1 ∞ 1 ( i − 1 ) ! ρ i = ρ e − ρ ∑ t = 0 ∞ 1 t ! ρ t = ρ e − ρ ⋅ e ρ = ρ (1.10) \text{Utilization}=\sum_{i=1}^\infty i\pi_i=e^{-\rho}\sum_{i=1}^\infty \frac1{(i-1)!}\rho^i=\rho e^{-\rho}\sum_{t=0}^\infty \frac1{t!}\rho^{t}=\rho e^{-\rho}\cdot e^\rho=\rho\tag{1.10} Utilization=i=1∑∞iπi=e−ρi=1∑∞(i−1)!1ρi=ρe−ρt=0∑∞t!1ρt=ρe−ρ⋅eρ=ρ(1.10)

吞吐量(throughput)为客户离开排队系统的速率,根据式 ( 1.9 ) (1.9) (1.9),可得:

Throughput = ∑ i = 1 ∞ i μ ⋅ π i = μ ∑ i = 1 ∞ i π i = μ ⋅ Utilization = μ ρ (1.11) \text{Throughput}=\sum_{i=1}^\infty i\mu\cdot\pi_i=\mu\sum_{i=1}^{\infty}i\pi_i=\mu\cdot\text{Utilization}=\mu\rho\tag{1.11} Throughput=i=1∑∞iμ⋅πi=μi=1∑∞iπi=μ⋅Utilization=μρ(1.11)

综上所述,式 ( 1.10 ) (1.10) (1.10)与式 ( 1.11 ) (1.11) (1.11)即为所求。 ■ \blacksquare ■ -

平均队长(average queue length)可以根据式 ( 1.9 ) (1.9) (1.9)计算得出:

E [ X ] = ∑ i = 1 ∞ i π i = e − ρ ∑ i = 1 ∞ 1 ( i − 1 ) ! ρ i = ρ e − ρ ∑ t = 0 ∞ 1 t ! ρ t = ρ e − ρ ⋅ e ρ = ρ (1.12) E[X]=\sum_{i=1}^\infty i\pi_i=e^{-\rho}\sum_{i=1}^\infty \frac1{(i-1)!}\rho^i=\rho e^{-\rho}\sum_{t=0}^\infty \frac1{t!}\rho^{t}=\rho e^{-\rho}\cdot e^\rho=\rho\tag{1.12} E[X]=i=1∑∞iπi=e−ρi=1∑∞(i−1)!1ρi=ρe−ρt=0∑∞t!1ρt=ρe−ρ⋅eρ=ρ(1.12)

平均系统时间(average system time),在 M / M / ∞ M/M/\infty M/M/∞的排队系统中即为每台服务器的平均服务时间:

E [ S ] = 1 μ (1.13) E[S]=\frac1\mu\tag{1.13} E[S]=μ1(1.13)

综上所述,式 ( 1.12 ) (1.12) (1.12)与式 ( 1.13 ) (1.13) (1.13)即为所求。 ■ \blacksquare ■

06-02

- 三天两夜,准备创造一个奇迹(感觉已经被ddl逼上绝路)。今天身体更疼,又要错过一个凉快的天气了,唉。

- 但是晚上还是不甘心浪费这么好的天气,强行起跑,结果5圈就报销。右膝疼,左脚踝也疼,感觉腰还有点扭了,肩膀也不行,整就一废人。五圈之后练了三组400米间歇,基本上还是在1分30左右的水平,状态差就只能跑间歇练速耐了,至于10km,有的是机会去破。权且休整数日罢。

06-03

- 最终我决定靠想象力凑齐数据,要我看500多张excel表一个个找,那是不可能的。

- 研代会还要正装,烦,不想去了都,搞这么复杂。

- 本来晚饭后去热了两圈身,步伐很沉,完全提不起状态。晚课下之后看确实很凉快,觉得浪费这么好的天气也很可惜,轻装上阵,结果35分18秒跑完8.02km,平均配速4’23"!其实我还是本着44分10km去跑的,可惜第8个1000米提速太早,最后200米我感觉心脏都要跳出来了,整个人都要变形了。至此,近半年历史最佳成绩汇总(基本上都是近两个月内):

| 里程 | 平均配速 | 总用时 | 日期 |

|---|---|---|---|

| 1 k m \rm 1km 1km | 3 ′ 3 4 ′ ′ 3'34'' 3′34′′ | 3 ′ 3 4 ′ ′ 3'34'' 3′34′′ | 2021 / 5 / 3 2021/5/3 2021/5/3 |

| 2 k m \rm 2km 2km | 3 ′ 5 4 ′ ′ 3'54'' 3′54′′ | 7 ′ 4 9 ′ ′ 7'49'' 7′49′′ | 2021 / 5 / 7 2021/5/7 2021/5/7 |

| 3 k m \rm 3km 3km | 4 ′ 0 2 ′ ′ 4'02'' 4′02′′ | 1 2 ′ 0 7 ′ ′ 12'07'' 12′07′′ | 2021 / 4 / 18 2021/4/18 2021/4/18 |

| 4 k m \rm 4km 4km | 4 ′ 1 3 ′ ′ 4'13'' 4′13′′ | 1 6 ′ 5 5 ′ ′ 16'55'' 16′55′′ | 2021 / 4 / 22 2021/4/22 2021/4/22 |

| 5 k m \rm 5km 5km | 4 ′ 1 3 ′ ′ 4'13'' 4′13′′ | 2 1 ′ 0 8 ′ ′ 21'08'' 21′08′′ | 2021 / 5 / 27 2021/5/27 2021/5/27 |

| 6 k m \rm 6km 6km | 4 ′ 2 1 ′ ′ 4'21'' 4′21′′ | 2 6 ′ 0 9 ′ ′ 26'09'' 26′09′′ | 2021 / 5 / 29 2021/5/29 2021/5/29 |

| 8 k m \rm 8km 8km | 4 ′ 2 3 ′ ′ 4'23'' 4′23′′ | 3 5 ′ 1 0 ′ ′ 35'10'' 35′10′′ | 2021 / 6 / 3 2021/6/3 2021/6/3 |

| 10 k m \rm 10km 10km | 4 ′ 2 5 ′ ′ 4'25'' 4′25′′ | 4 4 ′ 0 8 ′ ′ 44'08'' 44′08′′ | 2021 / 5 / 1 2021/5/1 2021/5/1 |

| 12 k m \rm 12km 12km | 4 ′ 4 0 ′ ′ 4'40'' 4′40′′ | 5 6 ′ 0 9 ′ ′ 56'09'' 56′09′′ | 2021 / 5 / 12 2021/5/12 2021/5/12 |

| 15 k m \rm 15km 15km | 4 ′ 4 4 ′ ′ 4'44'' 4′44′′ | 7 1 ′ 0 5 ′ ′ 71'05'' 71′05′′ | 2020 / 12 / 31 2020/12/31 2020/12/31 |

| 20 k m \rm 20km 20km | 4 ′ 4 5 ′ ′ 4'45'' 4′45′′ | 9 5 ′ 0 8 ′ ′ 95'08'' 95′08′′ | 2021 / 5 / 17 2021/5/17 2021/5/17 |

06-04

- 我能理解hdm的不满的心情,因为我也是只用了一周不到糊了一篇汇报出来。但是你指望我们这些到了16周还有五门专业课要上,三门专业课还在布置纸面作业,一学期上了六门专业课外带一两门选修的硕博和博士花一两个月乃至一学期时间做一个以后永远用不到的实证分析研究,这太难了。

- 整整五年没有这种被老师训话的经历了,还是当着全班近40个硕博和博士。本来计划晚上讲8组,结果只讲了四组,其中三组全被hdm劝退。能理解hdm也是好心,可惜院里这些老一辈做的研究真的跟不上年轻一辈的节奏了,现在院里的主流还是OR,OM和ML这块。不过跟hdm也算是有些情分,我尽力而为,下周汇报不会让她太尴尬。

- 研路难,且自勉以共进。周末休养生息,吃些好的。研代会可以跟yy见面,等他去阿里总部就没机会了,运气好兴许还能碰到熟人,不过也无碍了。

排队网络(QN)的仿真代码,其实我发现这类随机问题的仿真还挺难,内存耗用特别大,尤其如果你把时间间隔划得非常小(1e-6)左右的水平,16G内存的PC机都很容易卡死。这可能需要在代码上做一些内存占用的优化,比较费脑子,害。其实有一种思想就是时间间隔划大一些,然后做二阶近似(即单位时间间隔内会发生两次转移事件),这样倒也行,就是也有点费脑子。

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import random

import numpy as np

from multiprocessing import Process, Pool, Manager

def simulate_queue_network(r, p, mu, T=100, delta=1e-4):

timestamps = np.linspace(0, T, int(T/delta) + 1)

system_state_series = {

'link_states': [], # 链接上的packet数量记录(dict)

'packet_states': [], # 每个packet的正在位于的link记录

}

nodes = list(range(len(r)))

node_state = [[] for _ in range(len(nodes))] # 记录每个节点的packet到来情况

current_link_state = {} # 当前的链接状态:每个链接上存在的所有packets

current_packet_state = {} # 当前每个packet所处的链接位置:(None表示已经离开系统)

current_packet_time = {} # 当前每个packet已经在系统中停留的时间

num_packets = 0 # packet计数值

for i in range(len(p)): # 初始化current_link_state:每个链接上都没有packet

for j in range(len(p[i])):

if p[i][j] > 0 and i != j:

current_link_state[(i,j)] = []

for timestamp in timestamps:

# 0 期初更新所有时间序列

system_state_series['link_states'].append(current_link_state.copy())

system_state_series['packet_states'].append(current_packet_state.copy())

# 外部输入情况

for i in range(len(nodes)): # 遍历每个节点

if random.random() <= r[i] * delta: # 到来一个packet

packet_id = num_packets # 给packet编号

current_packet_time[packet_id] = 0

node_state[i].append(packet_id) # 将packet记录到node_state中

num_packets += 1 # packet计数值+1

# 遍历每个链接:将链接上的东西传到节点中

for (i, j) in current_link_state.keys():

if random.random() <= mu[i][j] * delta and current_link_state[(i, j)]:

packet_id = current_link_state[(i, j)].pop(0) # 这个要求当前链接上有packet,且触发了转移

node_state[j].append(packet_id) # 将这个packet添加到节点中记录

# 遍历每个节点,将其中所有的packet输送到各个link上,总之期末的时候node中一定不存在任何packet

for i in range(len(nodes)): # 遍历每个节点

for packet_id in node_state[i][:]: # 遍历每个节点上的packet

j = np.random.choice(a=nodes, size=1, p=p[i])[0]

if j == i: # 离开系统

current_packet_state[packet_id] = None # 将该packet的状态置为None

else:

current_packet_state[packet_id] = (i, j) # 更新packet状态

current_link_state[(i, j)].append(packet_id) # 更新link状态

node_state[i].pop(0)

# 更新每个packet的停留时间

for packet_id in current_packet_state:

if current_packet_state[packet_id] is not None:

current_packet_time[packet_id] += 1

print('共计: {}个packet'.format(num_packets))

# 计算packet的平均停留时间

print(delta * np.mean(list(current_packet_time.values())))

# 计算link的效用

link_busy_time = {link: 0 for link in current_link_state}

for packet_state in system_state_series['packet_states']:

for packet_id in packet_state:

if packet_state[packet_id] is not None:

link_busy_time[packet_state[packet_id]] += 1

for link in link_busy_time:

print(link, link_busy_time[link], link_busy_time[link] / len(timestamps))

if __name__ == '__main__':

r = [1, 3, 0, 0, 0] # 各个节点外部输入的速率

p = [

[.0, .5, .0, .5, .0],

[.0, .0, .6, .2, .2],

[.0, .0, .5, .0, .5],

[.0, .0, .0, .5, .5],

[.0, .0, .0, .0, 1.],

] # 节点转移概率矩阵(节点转移到自身的概率为其离开排队网络的速率)

mu = [

[0., 6., 0., 6., 0.],

[0., 0., 6., 6., 6.],

[0., 0., 0., 0., 6.],

[0., 0., 0., 0., 6.],

[0., 0., 0., 0., 0.],

]

simulate_queue_network(r, p, mu, T=100, delta=1e-4)

06-05

- 凌晨肝到近三点秒了所有作业,这是我第几遍自学内点法和整数规划了?后悔不好好听课…

- 大补了一顿甲鱼,外加午睡两小时,满血满蓝复活。可能还是书包太重一路走回学校太疲劳了,晚八点半一回校就马不停蹄地开始按4分配跑圈,5圈过后明显感觉坚持不到3km,休息了一会儿跑了三组90秒的400间歇,总之追求4分配以内必须练间歇跑了,虽然间歇跑真的太吃力了。

我最近遇到一个很棘手的问题,就是从中国统计年鉴以及中国金融年鉴上下载得到的excel表是受保护的,但是其实可以打开,只是不能编辑,在excel中的审阅里点击取消保护是需要输入密码的。但是如果我用xlrd库去读取或者pandas的read_excel去读取都会报错:

xlrd.biffh.XLRDError: Workbook is encrypted

即连读取都做不到,显示工作表被加密,但是其实正常还是可以打开的。

然后我发现这种受保护的工作表依然可以导出成csv(这个其实可以写个按键精灵的脚本去一个个手动导出),这样就可以读取了,但是很蠢,而且费时费力,目前有几种可能的处理方案,一个是使用openpyxl库来读取,这个库似乎要比xlrd更高级一些,另一个方案是from win32com.client import DispatchEx,然后excel = DispatchEx('Excel.Application'),我记得以前批量把word转成pdf的脚本也是用到这个底层库,希望能行得通吧,要不然真的要人工看遍500多张excel表了。

06-06

- 晚上看到sxy,感觉印象和记忆种的很不同了,人总是在变。最后唱国际歌还在低头忙事情,实习真的是太忙了。临走让颜烨认识了一下,便是如此。

- 跟颜烨确实有段时间不见了,他已经入职阿里,明晚就要去杭州了,日薪400想必并不会轻松,祝他好运罢,希望多年后彼此都成家立业后还能亦如此。听他说杉数的同事很多都跳到阿里美团字节。杉数确实不是长久之计,但确然也是个不错的跳板,人生浮沉哪。

- 总的来说我们院还是莫得牌面,代表人数跟数院人文一个规模,我们好歹本科也是大院。颜烨最后只吃到了52票,半数都没过,亏我就只给他投了一票。

昨天的问题解决,用DispatchEx可解,附关于python处理Excel的若干方法:

- 使用

xlrd:data = xlrd.open_workbook() - 使用

openpyxl:data = openpyxl.load_workbook() - 使用

pandas:data = pd.read_excel() - 使用

win32com:

from win32com.client import DispatchEx

excel = DispatchEx('Excel.Application')

demo = excel.Workbooks.Open(os.path.join(target_path, xls_filename))

sheet = demo.WorkSheets(1)

print(sheet.Cells(1,1).Value)

demo.Close(True)

06-07

- 最近关注了钞男神微博,才发现到他原来已经35岁,仍单身。从去年11月份就失恋,到今年5月还是郁郁寡欢,怪不得今年随机模型课上的没有去年金融工程那种激情了。想想同龄的常诚都已经是两个孩子的母亲了。北大数学博士也不得志,猛然意识到自己和史钞有好多共通点,跑步、怀旧、古风、民乐、关键都喜欢钻牛角尖,总感觉自己十年后也会是这幅光景… 害怕。

- 晚饭后4分配跑了5圈,然后开始跟ITCS那边玩飞盘。中途看到WXY来了,于是跟跑了一会儿,只跟了600米,配速3’45",本来自己就已经有点疲乏,完全跟不住。隔了10分钟又跟了他800米,刚好是他的冲刺圈,速度太快。很难想象昨天那么热,他居然用3’57"的配速跑了10km,人和人的体质果然不能一概而论,长距离配速上跟他有将近30秒的差距,争取转博前能练到他这种有氧水平。

磁链解析python脚本:利用aria2解析(不要问我是用来做什么的,我只是好奇而已,关于aria2的配置使用,在我上半年的log里有提到)

from http.client import HTTPConnection

import json

SAVE_PATH = "torrents"

STOP_TIMEOUT = 60

MAX_CONCURRENT = 16

MAX_MAGNETS = 256

ARIA2RPC_ADDR = "127.0.0.1"

ARIA2RPC_PORT = 6800

def exec_rpc(magnet):

"""

使用 rpc,减少线程资源占用,关于这部分的详细信息科参考

https://aria2.github.io/manual/en/html/aria2c.html?highlight=enable%20rpc#aria2.addUri

"""

conn = HTTPConnection(ARIA2RPC_ADDR, ARIA2RPC_PORT)

req = {

"jsonrpc": "2.0",

"id": "magnet",

"method": "aria2.addUri",

"params": [

[magnet],

{

"bt-stop-timeout": str(STOP_TIMEOUT),

"max-concurrent-downloads": str(MAX_CONCURRENT),

"listen-port": "6881",

"dir": SAVE_PATH,

},

],

}

conn.request(

"POST", "/jsonrpc", json.dumps(req), {"Content-Type": "application/json"}

)

res = json.loads(conn.getresponse().read())

if "error" in res:

print("Aria2c replied with an error:", res["error"])

exec_rpc('magnet:?xt=urn:btih:F6F7A767CFC964D24E05A0F50B04559B45021941')

06-08

- good,身体完全没有疼,第二次飞盘就完全适应强度了。昨晚回来之后忙里偷闲水了一篇爬虫,好久不做爬虫了,偶尔搞点老本行也挺好。

- 早上yy突然发消息来提wyy学术论文写作的pre做得稀碎,被老师怼得很惨。与我无瓜,无能为力,另外真的不能再提了,饶了我吧。

- 看得出来每个人期末都不是很好过,想不到经院也要学运筹和随机模型,早上高级计量结课的我一下子就平衡了哈哈。

我醉了,脑子里只有浆糊,肚子里只有酒水,一点墨水也倒不出来了。

06-09

- 昨晚课下,颜烨突然跟我提快要分手了,差不多才两个多月,这已经是他第四任了。本来自己状态很好,计划下课要去冲10km pb,临时应邀去陪颜烨喝酒。赌牌,畅饮,诉心肠,直至飘飘然,二人同饮,无需大醉,点到为止,甚是快哉。颜烨今早七点启程去杭州阿里总部,作为践行,昨晚回来十一点绕校跑了4km(均配4’27"),没有尽兴,还能接着跑,一来醒酒,二来且为友人践行。作业,pre,跟纵欲一场又能算得了什么呢?男人的快乐,约莫这么一回事吧。

- 结果酒精上头,三点多都睡不着,早上八点就起来,强行写作业到下午三点多,整个人都快散架了,太伤。

几何布朗运动(Geometrical Brownish Motion,GBM)仿真代码:

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import time

import numpy as np

from scipy.stats import norm

from multiprocessing import Pool, Manager

from matplotlib import pyplot as plt

# 求解标准正态分布的累计密度函数值

def norm_dist(x, loc=0, scale=1):

return norm.cdf(x, loc=loc, scale=scale)

# 计算几何布朗运动的期望(理论值)

def calc_theoritical_expectation_for_geometrical_brownian_motion(t, mu, sigma, s0):

return s0 * np.exp(mu * t)

# 计算几何布朗运动的方差(理论值)

def calc_theoritical_variance_for_geometrical_brownian_motion(t, mu, sigma, s0):

return s0 * s0 * np.exp(2 * mu * t) * (np.exp(sigma * sigma * t) - 1)

# 计算几何布朗运动的期望(仿真值)

def calc_simulated_expectation_for_geometrical_brownian_motion(sample_paths):

return np.mean(sample_paths, axis=0)

# 计算几何布朗运动的方差(仿真值)

def calc_simulated_variance_for_geometrical_brownian_motion(sample_paths):

std = np.std(sample_paths, axis=0)

return std * std

# 生成一条标准布朗运动的样本路径

def generate_sample_path_for_standard_brownian_motion(T, delta=1e-6, timestamps=None):

if timestamps is None:

timestamps = np.linspace(0, T, int(T / delta) + 1)

current_state = 0

sample_path = []

for timestamp in timestamps:

sample_path.append(current_state)

current_state += np.random.normal(0, np.sqrt(delta))

return np.array(sample_path, dtype=np.float64)

# 根据标准布朗运动生成几何布朗运动

def geometrical_brownian_motion(t, mu, sigma, s0, bm):

return s0 * np.exp((mu - 0.5 * sigma * sigma) * t + sigma * bm)

# 仿真模拟几何布朗运动

def simulate_geometrical_brownian_motion(mu, sigma, r, k, s0, T, sample_capacity, delta=1e-6):

sample_paths = []

timestamps = np.linspace(0, T, int(T / delta) + 1)

for _ in range(sample_capacity):

print(_)

standard_brownian_motion_sample_path = generate_sample_path_for_standard_brownian_motion(T, delta, timestamps)

sample_path = geometrical_brownian_motion(timestamps, mu, sigma, s0, standard_brownian_motion_sample_path)

sample_paths.append(sample_path)

return np.array(sample_paths, dtype=np.float64)

# 仿真模拟几何布朗运动(多进程目标函数)

def f(sample_paths, mu, sigma, r, k, s0, T, delta=1e-6):

timestamps = np.linspace(0, T, int(T / delta) + 1)

standard_brownian_motion_sample_path = generate_sample_path_for_standard_brownian_motion(T, delta, timestamps)

sample_path = geometrical_brownian_motion(timestamps, mu, sigma, s0, standard_brownian_motion_sample_path)

sample_paths.append(sample_path)

if __name__ == '__main__':

mu, sigma, r, k, s0, T, sample_capacity, delta = .12, .12, .005, 105, 100, 1, 5000, 1e-4

use_multiprocess = False

_timestamps = np.linspace(0, T, int(T / delta) + 1)

theoritical_expectation = calc_theoritical_expectation_for_geometrical_brownian_motion(_timestamps, mu, sigma, s0)

theoritical_variance = calc_theoritical_variance_for_geometrical_brownian_motion(_timestamps, mu, sigma, s0)

print(f'Theoritical expectation: {theoritical_expectation.shape}')

print(f'Theoritical variance: {theoritical_variance.shape}')

if use_multiprocess:

manager = Manager()

sample_paths = manager.list()

params = {

'sample_paths' : sample_paths,

'mu' : mu,

'sigma' : sigma,

'r' : r,

'k' : k,

's0' : s0,

'T' : T,

'delta' : delta,

}

start_time = time.time()

pool = Pool(processes=16)

for i in range(sample_capacity):

pool.apply(f, kwds=params)

pool.close()

pool.join()

sample_paths = np.array(sample_paths, dtype=np.float64)

end_time = time.time()

print(f' - Time consumption: {end_time - start_time}')

else:

sample_paths = simulate_geometrical_brownian_motion(mu, sigma, r, k, s0, T, sample_capacity, delta)

simulated_expectation = calc_simulated_expectation_for_geometrical_brownian_motion(sample_paths)

simulated_variance = calc_simulated_variance_for_geometrical_brownian_motion(sample_paths)

print(f'Simulated expectation: {simulated_expectation.shape}')

print(f'Simulated variance: {simulated_variance.shape}')

plt.plot(_timestamps, theoritical_expectation)

plt.plot(_timestamps, simulated_expectation)

plt.title('Expectation')

plt.xlabel('$t$')

plt.ylabel('$E[S(t)]$')

plt.legend(['Theoritical', 'Simulated'])

plt.savefig('expectation.png')

plt.close()

plt.plot(_timestamps, theoritical_variance)

plt.plot(_timestamps, simulated_variance)

plt.title('Variance')

plt.xlabel('$t$')

plt.ylabel('$Var[S(t)]$')

plt.legend(['Theoritical', 'Simulated'])

plt.savefig('variance.png')

plt.close()

print(np.sum(sample_paths[:, -1] > k) / sample_capacity)

06-10

- 昨晚11时金言突然来电说周五要来沪,两年不见了,每次来办签证都还记得找我。可惜我跟朱光耀真的是有五年不见了,这次时间比较紧也不能叫朱光耀从交大赶来,不过可以考虑叫上刘天浩。“金(言)—(曹)阳—(朱)光(耀)”同寝三年,从开始走到结束,只可惜我太拉胯,财大还是不能跟科大交大相提并论。想我们高三(1)班以天招班自居,如今随便提几个人都是直博硕博在读,在北京的第一梯队只会更加恐怖。估摸着有一半人都会读到博士,以后真有聚会怕真是会很没面子…

- 入梅,持续一个月,沉闷至极,很不快,只能在中长距离上的速耐练习,这种天强行10km以上真的会脱水到休克。

- 端午王凯重回杨浦,也是很期待与他会面,一周内与三个最好的挚友约见,对我来说实在是太奢侈了。

关于Black-Scholez模型期权定价的仿真代码:

这里其实有点问题,就是本质上我只能对一条价格曲线做仿真,如果真的先仿真出多个S(t)的样本路径后,计算对应价格曲线的均值,这个仿真量就太大了,但是题目中是说要仿真5000条样本路径,我就不是很能搞得明白。

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import time

import numpy as np

from scipy.stats import norm

from multiprocessing import Pool, Manager

from matplotlib import pyplot as plt

# 生成一条标准布朗运动的样本路径

def generate_sample_path_for_standard_brownian_motion(T, delta=1e-6, timestamps=None):

if timestamps is None:

timestamps = np.linspace(0, T, int(T / delta) + 1)

current_state = 0

sample_path = []

for timestamp in timestamps:

sample_path.append(current_state)

current_state += np.random.normal(0, np.sqrt(delta))

return np.array(sample_path, dtype=np.float64)

# 根据标准布朗运动生成几何布朗运动

def geometrical_brownian_motion(t, sigma, r, s0, bm):

return s0 * np.exp((r - 0.5 * sigma * sigma) * t + sigma * bm)

# 随机生成计算某个瞬时几何布朗运动的状态值(根据当前状态s_t与时刻t)

def generate_final_state_of_gbm(t, sigma, r, s_t, T):

tau = T - t

return s_t * np.exp((r - 0.5 * sigma * sigma) * tau + sigma * np.random.normal(0, np.sqrt(tau)))

# 期权价格的理论值

def theoritical_price(t, s_t, sigma, r, k, T):

tau = T - t

d_1 = (np.log(s_t / k) + (r + sigma * sigma / 2) * tau) / (sigma * np.sqrt(tau))

d_2 = d_1 - sigma * np.sqrt(tau)

return s_t * norm.cdf(d_1) - k * np.exp(-r * tau) * norm.cdf(d_2)

# 期权价格的仿真值

def simulate_price(t, s_t, sigma, r, k, T, n_sample=100):

tau = T - t

ST_minus_K = [max(generate_final_state_of_gbm(t, sigma, r, s_t, T) - k, 0) for _ in range(n_sample)]

return np.exp(-r * tau) * np.mean(ST_minus_K)

# 仿真代码

def simulate_black_scholes(sigma, r, k, s0, T, delta, sample_capacity):

timestamps = np.linspace(0, T, int(T / delta) + 1)

standard_brownian_motion_sample_path = generate_sample_path_for_standard_brownian_motion(T, delta, timestamps)

geometrical_brownian_motion_sample_path = geometrical_brownian_motion(timestamps, sigma, r, s0, standard_brownian_motion_sample_path)

theoritical_price_sample_path = theoritical_price(timestamps, geometrical_brownian_motion_sample_path, sigma, r, k, T)

# simulated_price_paths = []

# for _ in range(sample_capacity):

# print(_)

# standard_brownian_motion_sample_path = generate_sample_path_for_standard_brownian_motion(T, delta, timestamps)

# geometrical_brownian_motion_sample_path = geometrical_brownian_motion(timestamps, sigma, r, s0, standard_brownian_motion_sample_path)

# simulated_price_path = []

# for timestamp, state in zip(timestamps, geometrical_brownian_motion_sample_path):

# simulated_price = simulate_price(timestamp, state, sigma, r, k, T)

# simulated_price_path.append(simulated_price)

# simulated_price_paths.append(simulated_price_path)

# expected_simulated_price_path = np.mean(simulated_price_paths, axis=0)

expected_simulated_price_path = []

for timestamp, state in zip(timestamps, geometrical_brownian_motion_sample_path):

simulated_price = simulate_price(timestamp, state, sigma, r, k, T, sample_capacity)

expected_simulated_price_path.append(simulated_price)

plt.plot(timestamps, expected_simulated_price_path)

plt.plot(timestamps, theoritical_price_sample_path)

plt.xlabel('t')

plt.ylabel('price')

plt.legend(['Simulated', 'Theoritical'])

plt.savefig('price.png')

plt.close()

if __name__ == '__main__':

sigma, r, k, s0, T, sample_capacity, delta = .12, .005, 105, 100, 1, 5000, 1e-4

simulate_black_scholes(sigma, r, k, s0, T, delta, sample_capacity)

06-11

- 金言居然早上七点半点就到了,还好我醒得早。老言子最近小日子过得很滋润,国内国外两头拿津贴,直接月入过万,整个人都发福了,比上次重了10kg,我刚好是瘦了10kg,然而我还是比他重一点哈哈。

- 跟老言子交流就会发现自己真的是弱小得很,他已经有一篇一作,还有一篇挂名,都是SCI一区的paper,与我这种菜B已经不可同日而语了。

- 到了这个年纪,老言子似乎也有点急,看上了小师妹可惜自己要出国,眼看着身边少年班的天才21岁就和女友拍了婚纱照,自己却还是孑然一身远赴他国,前途未卜,受身边环境的影响的了,人之常情,本来“浓厚的学术氛围”,一下子变成了单身狗座谈会,朱光耀跟管思思很早也分了,我们仨还是我们仨,唉。

几何布朗运动的期望方差计算(很离谱,我看到现在只有百度百科里有结论,就没一个人具体讲讲GBM的推导,关于 E [ X 2 ( t ) ] \mathbb{E}[X^2(t)] E[X2(t)]的值使用的是矩母函数的结论):

-

( 2 a ) (\rm 2a) (2a) 即已知 G B M \rm GBM GBM的表达式为:

{ d S ( t ) = μ S ( t ) d t + σ S ( t ) d W ( t ) S ( 0 ) = s 0 ⟹ S ( t ) = s 0 exp { ( μ − 1 2 σ 2 ) t + σ W ( t ) } (2.1) \left\{\begin{aligned} &\text{d}S(t)=\mu S(t)\text{d}t+\sigma S(t)\text{d}W(t)\\ &S(0)=s_0 \end{aligned}\right.\\ \Longrightarrow S(t)=s_0\exp\left\{\left(\mu-\frac12\sigma^2\right)t+\sigma W(t)\right\}\tag{2.1} {dS(t)=μS(t)dt+σS(t)dW(t)S(0)=s0⟹S(t)=s0exp{(μ−21σ2)t+σW(t)}(2.1)

其中 W ( t ) W(t) W(t)是布朗运动, μ \mu μ表示漂移率, σ \sigma σ表示波动率。设 X ( t ) = exp { ( μ − 1 2 σ 2 ) t + σ W ( t ) } X(t)=\exp\left\{\left(\mu-\frac12\sigma^2\right)t+\sigma W(t)\right\} X(t)=exp{(μ−21σ2)t+σW(t)},根据 S l i d e \rm Slide Slide中定理 7.1 7.1 7.1,可知 X ( t ) X(t) X(t)是鞅,则可得:

E [ X ( t ) ] = E [ X ( 0 ) ] = 1 Var [ X ( t ) ] = E [ X 2 ( t ) ] − ( E [ X ( t ) ] ) 2 = e σ 2 t − 1 (2.2) \begin{aligned} &\mathbb{E}[X(t)]=\mathbb{E}[X(0)]=1\\ &\text{Var}[X(t)]=\mathbb{E}\left[X^2(t)\right]-(\mathbb{E}[X(t)])^2=e^{\sigma^2t}-1 \end{aligned}\tag{2.2} E[X(t)]=E[X(0)]=1Var[X(t)]=E[X2(t)]−(E[X(t)])2=eσ2t−1(2.2)

利用 X ( t ) X(t) X(t),可以将 S ( t ) S(t) S(t)改写为:

S ( t ) = s 0 e μ t X ( t ) (2.3) S(t)=s_0e^{\mu t}X(t)\tag{2.3} S(t)=s0eμtX(t)(2.3)

根据式 ( 2.2 ) (2.2) (2.2),可以计算 S ( t ) S(t) S(t)的期望与方差:

E [ S ( t ) ] = E [ s 0 exp { ( μ − 1 2 σ 2 ) t + σ W ( t ) } ] = s 0 e μ t E [ X ( t ) ] = s 0 e μ t Var [ S ( t ) ] = E [ S 2 ( t ) ] − ( E [ S ( t ) ] ) 2 = E [ s 0 2 exp { 2 ( μ − 1 2 σ 2 ) t + 2 σ W ( t ) } ] − s 0 2 e 2 μ t = s 0 2 e 2 μ t E [ X 2 ( t ) ] − s 0 2 e 2 μ t = s 0 2 e 2 μ t ( Var [ X ( t ) ] + ( E [ X ( t ) ] ) 2 − 1 ) = s 0 2 e 2 μ t ( e σ 2 t − 1 ) (2.4) \begin{aligned} \mathbb{E}[S(t)]&=\mathbb{E}\left[s_0\exp\left\{\left(\mu-\frac12\sigma^2\right)t+\sigma W(t)\right\}\right]\\ &=s_0e^{\mu t}\mathbb{E}\left[X(t)\right]\\ &=s_0e^{\mu t}\\ \text{Var}[S(t)]&=\mathbb{E}[S^2(t)]-\left(\mathbb{E}[S(t)]\right)^2\\ &=\mathbb{E}\left[s_0^2\exp\left\{2\left(\mu-\frac12\sigma^2\right)t+2\sigma W(t)\right\}\right]-s_0^2e^{2\mu t}\\ &=s_0^2e^{2\mu t}\mathbb{E}\left[X^2(t)\right]-s_0^2e^{2\mu t}\\ &=s_0^2e^{2\mu t}\left(\text{Var}\left[X(t)\right]+\left(\mathbb{E}[X(t)]\right)^2-1\right)\\ &=s_0^2e^{2\mu t}\left(e^{\sigma^2t}-1\right) \end{aligned}\tag{2.4} E[S(t)]Var[S(t)]=E[s0exp{(μ−21σ2)t+σW(t)}]=s0eμtE[X(t)]=s0eμt=E[S2(t)]−(E[S(t)])2=E[s02exp{2(μ−21σ2)t+2σW(t)}]−s02e2μt=s02e2μtE[X2(t)]−s02e2μt=s02e2μt(Var[X(t)]+(E[X(t)])2−1)=s02e2μt(eσ2t−1)(2.4)

综上所述,式 ( 2.4 ) (2.4) (2.4)即为所求。 ■ \blacksquare ■

06-12

- 现在让我们来看看hdm昨晚到底有多离谱,课前5分钟提示今晚考试,还要把剩下10各组的pre做完。时间显然很紧,于是她给出了70分钟讲10个组,90分钟考试的计划,也就是到8点40能下课。用脚趾头都能想出来怎么可能一个组7分钟,还组里每个人都必须讲。结果大部分组都讲到了双倍时间,直到八点才结束。本以为她放弃考试了,结果强行起考,还问我们谁不想考就举手(被自愿),然后考试形式也是离谱到家——论文精读,我被分到一篇40页的英文paper,只给两个小时看,然后按章节写提纲,最后还要总结论文的创新、优点和不足,花半小时过了一遍,剩下90分钟拼死拼活勉强写完。我就想知道碳基生物能想得出这种活?真就从头离谱到尾呗。

- 本来昨天见金言还没睡午觉又累又困,下课后我一肚子怒气无处泄,4’21"的配速出门随意乱跑,3km多莫名奇妙跑进了大学路,稍微平复了一些,可惜还要被人虐一条街,真的是艹了。

- 时隔半年,CSDN又开始征水文了,恰好可以把昨天跟老言子的事情拿来说说《纸短情长叹朝夕》。

DOS(常用汇总)

cmd命令大全(第一部分)

winver---------检查Windows版本

wmimgmt.msc----打开windows管理体系结构(WMI)

wupdmgr--------windows更新程序

wscript--------windows脚本宿主设置

write----------写字板

winmsd---------系统信息

wiaacmgr-------扫描仪和照相机向导

winchat--------XP自带局域网聊天

2

cmd命令大全(第二部分)

mem.exe--------显示内存使用情况

Msconfig.exe---系统配置实用程序

mplayer2-------简易widnows media player

mspaint--------画图板

mstsc----------远程桌面连接

mplayer2-------媒体播放机

magnify--------放大镜实用程序

mmc------------打开控制台

mobsync--------同步命令

3

cmd命令大全(第三部分)

dxdiag---------检查DirectX信息

drwtsn32------ 系统医生

devmgmt.msc--- 设备管理器

dfrg.msc-------磁盘碎片整理程序

diskmgmt.msc---磁盘管理实用程序

dcomcnfg-------打开系统组件服务

ddeshare-------打开DDE共享设置

dvdplay--------DVD播放器

4

cmd命令大全(第四部分)

net stop messenger-----停止信使服务

net start messenger----开始信使服务

notepad--------打开记事本

nslookup-------网络管理的工具向导

ntbackup-------系统备份和还原

narrator-------屏幕“讲述人”

ntmsmgr.msc----移动存储管理器

ntmsoprq.msc---移动存储管理员操作请求

netstat -an----(TC)命令检查接口

5

cmd命令大全(第五部分)

syncapp--------创建一个公文包

sysedit--------系统配置编辑器

sigverif-------文件签名验证程序

sndrec32-------录音机

shrpubw--------创建共享文件夹

secpol.m转载自电脑十万个为什么http://www.qq880.com,请保留此标记sc-----本地安全策略

syskey---------系统加密,一旦加密就不能解开,保护windows xp系统的双重密码

services.msc---本地服务设置

Sndvol32-------音量控制程序

sfc.exe--------系统文件检查器

sfc /scannow---windows文件保护

6

cmd命令大全(第六部分)

tsshutdn-------60秒倒计时关机命令

tourstart------xp简介(安装完成后出现的漫游xp程序)

taskmgr--------任务管理器

eventvwr-------事件查看器

eudcedit-------造字程序

explorer-------打开资源管理器

packager-------对象包装程序

perfmon.msc----计算机性能监测程序

progman--------程序管理器

regedit.exe----注册表

rsop.msc-------组策略结果集

regedt32-------注册表编辑器

rononce -p ----15秒关机

regsvr32 /u *.dll----停止dll文件运行

regsvr32 /u zipfldr.dll------取消ZIP支持

7

cmd命令大全(第七部分)

cmd.exe--------CMD命令提示符

chkdsk.exe-----Chkdsk磁盘检查

certmgr.msc----证书管理实用程序

calc-----------启动计算器

charmap--------启动字符映射表

cliconfg-------SQL SERVER 客户端网络实用程序

Clipbrd--------剪贴板查看器

conf-----------启动netmeeting

compmgmt.msc---计算机管理

cleanmgr-------垃圾整理

ciadv.msc------索引服务程序

osk------------打开屏幕键盘

odbcad32-------ODBC数据源管理器

oobe/msoobe /a----检查XP是否激活

lusrmgr.msc----本机用户和组

logoff---------注销命令

iexpress-------木马捆绑工具,系统自带

Nslookup-------IP地址侦测器

fsmgmt.msc-----共享文件夹管理器

utilman--------辅助工具管理器

gpedit.msc-----组策略

06-13

- 感冒加重了,隐隐还有点发烧,特别糟糕的情况。山楂树?

- 怎么还能碰得到?而且,时隔一阵子,怎么又取消拉黑我了呢?胃疼,矛盾,无厘头。

- 从5月1日开始没有断过的跑步,被迫要停一天了,状态掉落到冰点,咳嗽带着头也开始疼,感觉学校里有不少人感冒,可能是有流感了。

- 晚上看到那个体育生在光着上身在裸奔,我跟了1km实在是状态太差,感觉自己有快两年没感冒发烧过了,真是倒大霉了。

- 明天王凯来沪,吃个饭正好晚上一起去外滩看个点灯,这么多年我还一次没去看过。

抓取PDF中图片的小脚本:

# -*- coding: UTF-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import cv2

import numpy

from PyPDF2 import PdfFileReader, PdfFileWriter

def parse_pdf_images(import_path: str) -> None:

with open(import_path, 'rb') as pdf:

reader = PdfFileReader(pdf)

for number in range(reader.getNumPages()):

page = reader.getPage(number)

print('Page {}:'.format(number))

x_object = page['/Resources'].get('/XObject')

if x_object is None:

continue

for key in x_object:

if x_object[key]['/Subtype'] == '/Image':

size = (x_object[key]['/Width'], x_object[key]['/Height'])

data = x_object[key].getData()

if x_object[key]['/ColorSpace'] == '/DeviceRGB':

mode = 'RGB'

else:

mode = 'P'

image = numpy.frombuffer(data, numpy.uint8)

print(x_object[key]['/Filter'])

if x_object[key]['/Filter'] == '/FlateDecode':

print(size)

print(image.shape)

image = image.reshape(size[1], size[0], 3)

cv2.imwrite('page' + '%05ui' % number + 'key' + key[1:] + '.png', image)

elif x_object[key]['/Filter'] == '/DCTDecode':

cv2.imwrite(key[1:] + '.jpg', image)

elif xObject[obj]['/Filter'] == '/JPXDecode':

cv2.imwrite(key[1:] + '.jpg', image)

06-14

- 想做就去做呗,反正某人现在不也没课没考试了,想谈恋爱又嫌麻烦。现在我觉得所有的胡思乱想都可以归结于太闲(虽然我现在也没资格这么评判别人)。

- 星巴克约了下午茶后,晚上请王凯去悦荟吃了个烤肉(其实就是我自己想吃了,我都好久没出去吃了),顺道去外滩看了个亮灯。颜烨,金言,王凯三人的处事风格相异甚远,但是都已经取得了阶段性的成功(入职阿里,赴美留学,考取复旦),事实上我与他们任何一人的处事风格都不相同,所以我又能走到哪里呢?

- 中午找到了救命的头孢克肟,不然我可能真的是要不行了。一天走了将近两万步,晚归疲累到极致,但还是进场跑了五圈,4’34"的配速,近一年多以来可能是最差的状态了。等感冒痊愈,再从头开始练罢。

gpytorch的一个小demo(原谅我最近啥有意义的事情也没做,周末赶完hdm8000字的paper,今天又出去晃了半天,只能拿以前的存货来顶了)

import os

import math

from matplotlib import pyplot as plt

import torch

import gpytorch

from gpytorch import kernels, means, models, mlls, settings

from gpytorch import distributions as distr

from IPython.display import Markdown, display

def printmd(string):

display(Markdown(string))

train_x = torch.linspace(0, 1, 100)

train_y = torch.sin(train_x * (2 * math.pi)) + torch.randn(train_x.size()) * 0.2

# We will use the simplest form of GP model, exact inference

class ExactGPModel(gpytorch.models.ExactGP):

def __init__(self, train_x, train_y, likelihood):

super(ExactGPModel, self).__init__(train_x, train_y, likelihood)

self.mean_module = gpytorch.means.ConstantMean()

self.covar_module = gpytorch.kernels.ScaleKernel(gpytorch.kernels.RBFKernel())

def forward(self, x):

mean_x = self.mean_module(x)

covar_x = self.covar_module(x)

return gpytorch.distributions.MultivariateNormal(mean_x, covar_x)