序言

无想的一集。

有点无语。

反正上文也基本达到字数上限了,重开一文呗就。

文章目录

20240722

郁闷,想太多。新园今晚居然有昂丝鱼(后来细想应该是白丝,不过也挺好吃)。

昨天一直都在学校,这个月每天都有训练,基本上都是晚上八点前后开始,最近也因为本子的缘故组会也有两周没开。偏偏就是昨晚被wyl叫去编预算表(本来这次真没我啥事,但是只有我之前搞过预算,最后还是拖上我),九点溜出来才发现,SXY怎么一声不吭地回学校跑了6.63k@6’19",百思不得解,而且是刚好离开。我原计划只打算5圈就撤了,临时起意也跑个6.63k@4’19"作为回应,既是悄悄来的,便也不想主动去戳破,假装自己也是陪跑过了呗,

小小地欺骗一下自己。言归正传,晚上慢跑,穿的代步鞋,目前伤痛消淡许多,得益于前一阵子低强度的过渡。5k@4’05"+3k@4’07"+2k@3’54",渐加速,间歇6-10min,整体感觉不错,质量很高,至少也是中上的效果。

第一个5k带的XR,小家伙今天稍微靠谱了点,还是跟了10圈才爆掉,之后我提到4分以内顶完5k;

第二个3k前三圈即拉爆XR,后4圈半提速,胡哥跟了上来,只3圈多他也爆了(他高步频,脚步声逼得太紧,节奏就被带上去了);

第三个2k力竭组,分段4’00"+3’49",基本到位。

PS:夜跑时,胡哥跟我说他对面D间的兄弟在跟女友同居,这么久我都没发现,就这么离谱的。约了后天的签证办理,材料基本补齐了,这趟没啥问题的话,终于可以回去两天调整一下了,事情不是很能绷得住一点。

Quantize量化概念与技术细节

题外话,在七八年前,一些关于表征的研究,会去做表征的压缩,比如二进制嵌入这种事情,其实做得很简单,无非是找个阈值,然后将浮点数划归为零一值,现在的Quantize差不多也是这么一回事,冷饭重炒,但在当下LLM的背景下,明显比那时候更有意义。

- HuggingFace bitsandbytes包

- GPTQ: data compression, GPU,arxiv.2210.17323

- GPTQ is a post-training quantization (PTQ) method for 4-bit quantization that focuses primarily on GPU inference and performance.

- to quantizing the weights of transformer-based models

- first applies scalar quant to the weights, followed by vector quant to the residuals

- The idea behind the method is that it will try to compress all weights to a 4-bit quantization by minimizing the mean squared error to that weight.

- During inference, it will dynamically dequantize its weights to float16 for improved performance whilst keeping memory low.

- GGUF: ggml, CPU, 这是与GPTQ相对应的量化方法,在CPU上实现推理优化。(过时)

- c++,

- llama.cpp, https://github.com/ggerganov/llama.cpp

- AWQ:activation aware quantization,arxiv.2306.00978

- 声称是对GPTQ的优化,提升了速度,但牺牲的精度小(都这样说)

安装(源码安装更容易成功):

# Latest HF transformers version for Mistral-like models

# !pip install git+https://github.com/huggingface/transformers.git

# !pip install accelerate bitsandbytes xformers

# GPTQ Dependencies

# !pip install optimum

# !pip install auto-gptq --extra-index-url https://huggingface.github.io/autogptq-index/whl/cu118/

# 我这边走的是源码安装

# GGUF Dependencies

# !pip install 'ctransformers[cuda]'

在llama3-8b上的测试:

from torch import bfloat16

import torch

from transformers import pipeline, AutoTokenizer, AutoModelForCausalLM

# Load in your LLM without any compression tricks

model_id = "meta-llama/Meta-Llama-3-8B-Instruct"

# model_id = "HuggingFaceH4/zephyr-7b-beta"

pipe = pipeline(

"text-generation",

model=model_id,

torch_dtype=bfloat16,

device_map="auto"

)

pipe.model

输出模型的结构:

LlamaForCausalLM(

(model): LlamaModel(

(embed_tokens): Embedding(128256, 4096)

(layers): ModuleList(

(0-31): 32 x LlamaDecoderLayer(

(self_attn): LlamaSdpaAttention(

(q_proj): Linear(in_features=4096, out_features=4096, bias=False)

(k_proj): Linear(in_features=4096, out_features=1024, bias=False)

(v_proj): Linear(in_features=4096, out_features=1024, bias=False)

(o_proj): Linear(in_features=4096, out_features=4096, bias=False)

(rotary_emb): LlamaRotaryEmbedding()

)

(mlp): LlamaMLP(

(gate_proj): Linear(in_features=4096, out_features=14336, bias=False)

(up_proj): Linear(in_features=4096, out_features=14336, bias=False)

(down_proj): Linear(in_features=14336, out_features=4096, bias=False)

(act_fn): SiLU()

)

(input_layernorm): LlamaRMSNorm()

(post_attention_layernorm): LlamaRMSNorm()

)

)

(norm): LlamaRMSNorm()

)

(lm_head): Linear(in_features=4096, out_features=128256, bias=False)

)

一个细节,查看任意一个layer的权重值的分布(查看前10000个),发现是基本呈现零均值的正态分布的,这也是后面normal float(nf4)就是基于这样的前提做的量化:

import seaborn as sns

q_proj = pipe.model.model.layers[0].self_attn.q_proj.weight.detach().to(torch.float16).cpu().numpy().flatten()

plt.figure(figsize=(10, 6))

sns.histplot(q_proj[:10000], bins=50, kde=True)

chat template:

- llama3

<|begin_of_text|><|start_header_id|>system<|end_header_id|>....<|eot_id|><|start_header_id|>user<|end_header_id|>...<|eot_id|><|start_header_id|>assistant<|end_header_id|>...

- zephyr

<|system|> ... </s><|user|> ... </s><|assistant|> ... </s>

具体使用template:

# See https://huggingface.co/docs/transformers/main/en/chat_templating

messages = [

{

"role": "system",

"content": "You are a friendly chatbot.",

},

{

"role": "user",

"content": "Tell me a funny joke about Large Language Models."

},

]

prompt = pipe.tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

print(prompt)

T = AutoTokenizer.from_pretrained(model_id)

# T

# T.encode('<|system|>')

<|begin_of_text|><|start_header_id|>system<|end_header_id|>

You are a friendly chatbot.<|eot_id|><|start_header_id|>user<|end_header_id|>

Tell me a funny joke about Large Language Models.<|eot_id|><|start_header_id|>assistant<|end_header_id|>

使用pipe进行生成:

outputs = pipe(

prompt,

max_new_tokens=256,

do_sample=True,

temperature=0.1,

top_p=0.95

)

(torch.cuda.max_memory_allocated(device='cuda:0') + torch.cuda.max_memory_allocated(device='cuda:1')) / (1024*1024*1024) # 15.021286964416504,差不多是15GB

print(outputs[0]['generated_text'])

"""

<|begin_of_text|><|start_header_id|>system<|end_header_id|>

You are a friendly chatbot.<|eot_id|><|start_header_id|>user<|end_header_id|>

Tell me a funny joke about Large Language Models.<|eot_id|><|start_header_id|>assistant<|end_header_id|>

Here's one:

Why did the Large Language Model go to therapy?

Because it was struggling to "process" its emotions and was feeling a little "disconnected" from its users! But in the end, it just needed to "retrain" its thoughts and "update" its perspective!

Hope that made you LOL!

"""

使用accelerate作sharding(分片)

from accelerate import Accelerator

# Shard our model into pieces of 1GB

accelerator = Accelerator()

accelerator.save_model(

model=pipe.model,

save_directory="./content/model",

max_shard_size="4GB"

)

20240723

晚上2k@3’54"+2k@3’57"+1k@3’46"+1k@3’36",最大摄氧量突破到63,之前三月巅峰62,五月伤痛掉回61。然而越是上升期,越容易伤痛。其实很想慢跑,但总慢不下来,穿代步鞋、用后跟跑法都慢不下来,索性还是冲起来拉倒,一个人我爱咋跑咋跑呗。

今晚YZZ发力,3k@4’00",这个天气能跑到4分配显然不差,但他的水平不止于此。XR过来晃了两下就溜,我说他最近有心事,兴致一直不是很高都快一周了,他说我看人真准,那可不是么,哼(有心事就想偷懒?明天滚过来跟跑LSD)。

PS:上午去院里敲章时发现个BUG,八年了,我都不知道陈岗老师长啥样。陈岗,久闻其名,评教历年院里垫底,大一时就听说她的课特别差,讲得不行给分还差,我自始自终都没选过她的课,所以一直不知道她是谁。结果今天值班的是她,她只告诉我姓陈,LZY就问我今天值班的是陈岗吗?我第一反应,陈岗怎么也是个副教授,不会去搞行政的事吧?下意识地回答肯定不是(其实她的样貌我很熟悉,就是名字对不上人。我有种主观的刻板印象,陈岗名声这么差,想象中应该很瘦,怎么会是这么一脸慈祥的老奶奶模样呢…)。后来得知真的是陈岗老师后,赶紧恭恭敬敬起来,生怕惹恼了她不肯给我敲章[Facepalm]。

量化概述

- 4bit-NormalFloat (NF4, qlora: lora on a quantize LLMs,arxiv.2305.14314) consists of three steps:

- Normalization: The weights of the model are normalized so that we expect the weights to fall within a certain range. This allows for more efficient representation of more common values.(密度高的地方多分配离散值,密度低的地方少分配离散值,前提就是上面的正态分布)

- The weights of the model are first normalized to have zero mean and unit variance. This ensures that the weights are distributed around zero and fall within a certain range.

- Quantization: The weights are quantized to 4-bit. In NF4, the quantization levels are evenly spaced with respect to the normalized weights, thereby efficiently representing the original 32-bit weights.(所谓那些int4模型,就是每个权重都由16个离散值表示,int8就是64个,以此类推,这个主意之前bf16, float32, float16的具体表征,三者都有1bit用来存符号,bf16跟float32的区别在于小数位减少,float16则两者都变少,分别是1+8+7,1+8+23,1+5+10,比如同样一个0.1234,三者的结果就是0.1235351…,0.1234000…,0.1234130…,而75505则对应75505,inf,75264,即bf16是做了一个权衡,能表示很大的数,但是精度不够)

- The normalized weights are then quantized to 4 bits. This involves mapping the original high-precision weights to a smaller set of low-precision values. In the case of NF4, the quantization levels are chosen to be evenly spaced in the range of the normalized weights.

- Dequantization: Although the weights are stored in 4-bit, they are dequantized during computation which gives a performance boost during inference.

- During the forward pass and backpropagation, the quantized weights are dequantized back to full precision. This is done by mapping the 4-bit quantized values back to their original range. The dequantized weights are used in the computations, but they are stored in memory in their 4-bit quantized form.

- Normalization: The weights of the model are normalized so that we expect the weights to fall within a certain range. This allows for more efficient representation of more common values.(密度高的地方多分配离散值,密度低的地方少分配离散值,前提就是上面的正态分布)

- bitsandbytes 的分位数计算

- 密度高的地方多分配,密度低的地方少分配

- https://github.com/bitsandbytes-foundation/bitsandbytes/blob/main/bitsandbytes/functional.py#L267

- https://zhuanlan.zhihu.com/p/647378373

验证一下上面bf16, f32, f16的区别:

torch.set_printoptions(sci_mode=False)

X = torch.tensor([0.1234, 75535])

print(X, X.dtype) # tensor([ 0.1234, 75535.0000]) torch.float32

print(X.to(torch.float16)) # tensor([0.1234, inf], dtype=torch.float16)

print(X.to(torch.bfloat16)) # tensor([ 0.1235, 75776.0000], dtype=torch.bfloat16)

接下来手动量化(用BitsAndBytes)

# Delete any models previously created

# del pipe, accelerator

del pipe

# Empty VRAM cache

import gc

gc.collect()

torch.cuda.empty_cache()

from transformers import BitsAndBytesConfig

from torch import bfloat16

model_id = "meta-llama/Meta-Llama-3-8B-Instruct"

# Our 4-bit configuration to load the LLM with less GPU memory

bnb_config = BitsAndBytesConfig(

load_in_4bit=True, # 4-bit quantization

bnb_4bit_quant_type='nf4', # Normalized float 4

bnb_4bit_use_double_quant=True, # Second quantization after the first

bnb_4bit_compute_dtype=bfloat16 # Computation type

)

# Zephyr with BitsAndBytes Configuration

tokenizer = AutoTokenizer.from_pretrained(model_id)

model = AutoModelForCausalLM.from_pretrained(

model_id,

quantization_config=bnb_config,

device_map='auto',

)

# Create a pipeline

pipe = pipeline(model=model, tokenizer=tokenizer, task='text-generation')

(torch.cuda.max_memory_allocated('cuda:0') + torch.cuda.max_memory_allocated('cuda:1')) / (1024*1024*1024) # 5.5174360275268555,内存占用相较于上面的15G明显减少

参数含义在论文中都有,同样可以打印prompt都是没有区别的,输出发生变化

# See https://huggingface.co/docs/transformers/main/en/chat_templating

messages = [

{

"role": "system",

"content": "You are a friendly chatbot.",

},

{

"role": "user",

"content": "Tell me a funny joke about Large Language Models."

},

]

prompt = pipe.tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

print(prompt)

"""

<|begin_of_text|><|start_header_id|>system<|end_header_id|>

You are a friendly chatbot.<|eot_id|><|start_header_id|>user<|end_header_id|>

Tell me a funny joke about Large Language Models.<|eot_id|><|start_header_id|>assistant<|end_header_id|>

"""

outputs = pipe(

prompt,

max_new_tokens=256,

do_sample=True,

temperature=0.1,

top_p=0.95

)

print(outputs[0]["generated_text"])

"""

<|begin_of_text|><|start_header_id|>system<|end_header_id|>

You are a friendly chatbot.<|eot_id|><|start_header_id|>user<|end_header_id|>

Tell me a funny joke about Large Language Models.<|eot_id|><|start_header_id|>assistant<|end_header_id|>

Why did the Large Language Model go to therapy?

Because it was struggling to "process" its emotions and was worried it would "overfit" to its own biases!

"""

20240724

申根文体签现在要打银行流水(7k+即可,官网材料清单里是没有列出来的,另外招行打不了当日流水,中行可以),不过确实是不需要机票订单。缺了这个,然后附近打印一页市价10r,突出一个抢钱。不过效率还是挺高的,不缺材料的话连排队也就一个小时,听说一般一周以内就能出签。

晚上带静香姐跑课表,20min热身+4组冲刺间歇(15s冲刺+45s缓和)+5组变速(6min快+3min慢)+10min冷神,一共16k出头些,跑完大腿酸,好好拉伸了下,主要最近都不拉伸,但每天跑完真跟没跑一样。

目前7月还剩一周时间,总跑量180km,平均配速4’16",下半月已经尽可能放慢节奏,自我感觉目前或已超越三月巅峰期水平,坦然地说,夏训已尽力,首马勿再负我。

PS:感觉今晚最后是被YZZ和LXY给秀了一遭,???

昨天那个量化是不完全的混合精度量化(有int8也有float16):

-

load_in_8bit:

- embed_tokens 继续是 torch.float16

- 每个layer的内部(self attention)以及 mlp 部分是 int8

- 每个layer的output(layernorm)部分是 float16(如果 load 时传入了

torch_dtype=torch.bfloat16,则这部分为 torch.float16) - 同理适用于 load_in_4bit

model.embed_tokens.weight torch.float16 cuda:0 model.layers.0.self_attn.q_proj.weight torch.int8 cuda:0 model.layers.0.self_attn.k_proj.weight torch.int8 cuda:0 model.layers.0.self_attn.v_proj.weight torch.int8 cuda:0 model.layers.0.self_attn.o_proj.weight torch.int8 cuda:0 model.layers.0.mlp.gate_proj.weight torch.int8 cuda:0 model.layers.0.mlp.up_proj.weight torch.int8 cuda:0 model.layers.0.mlp.down_proj.weight torch.int8 cuda:0 model.layers.0.input_layernorm.weight torch.float16 cuda:0 model.layers.0.post_attention_layernorm.weight torch.float16 cuda:0

具体的参数输出和推理:

import torch

from torch import nn

from transformers import BitsAndBytesConfig, AutoModelForCausalLM, AutoTokenizer

from transformers.optimization import AdamW

# del model

import gc # garbage collect library

gc.collect()

torch.cuda.empty_cache()

model = AutoModelForCausalLM.from_pretrained("meta-llama/Meta-Llama-3-8B",

quantization_config=BitsAndBytesConfig(

load_in_8bit=True,

# load_in_4bit=True

),

torch_dtype=torch.bfloat16,

device_map="auto")

for name, para in model.named_parameters():

print(name, para.dtype, para.shape, para.device)

# ------

tokenizer = AutoTokenizer.from_pretrained('meta-llama/Meta-Llama-3-8B')

tokenizer.pad_token = tokenizer.eos_token

# 示例训练数据

texts = [

"Hello, how are you?",

"The quick brown fox jumps over the lazy dog."

]

# Tokenize数据

inputs = tokenizer(texts, return_tensors="pt", padding=True, truncation=True)

input_ids = inputs["input_ids"]

attention_mask = inputs["attention_mask"]

# 移动到GPU(如果可用)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

input_ids = input_ids.to(device)

attention_mask = attention_mask.to(device)

# model.to(device)

# 设置优化器和损失函数

optimizer = AdamW(model.parameters(), lr=5e-5)

loss_fn = nn.CrossEntropyLoss()

# 模型训练步骤

model.train()

outputs = model(input_ids, attention_mask=attention_mask, labels=input_ids)

loss = outputs.loss

# 反向传播

optimizer.zero_grad()

loss.backward()

optimizer.step()

20240725

台风环伺,兴得几日清凉。其实这两周大脚鹿的线还是挺好玩的,牧云谷,名字就很有意境,可惜大概率阴雨天,估计看不到照片里的那种感觉。

晚上嘉伟在129大杀四方,薄纱精英组(今天精英组相对容易,1200米@3’35"×4组(rt 3分)+800米@3’30"×4组(rt 2分)+400米@3’25"×4组(rt 90秒),嘉伟每组配速至少快15秒以上,最后一组400米仅用时64秒),129的人指定是要有PTSD了。

我不太想去跑间歇,避免伤痛。而且手头事情有些紧,计划也是低强度过渡,最近一周只会穿一两次碳板训练,大多数时间都是代步鞋瞎跑跑,尽可能压压速度。八点半下楼遛了会儿,3k@4’08"+2k@4’00"+1k@3’25",前两组渐加速节奏,最后一个1000米力竭冲刺,并无不满。

PS:可以的,没病两天又活蹦乱跳的了,真小看你了,跑挺好。

GPTQ

# Delete any models previously created

del tokenizer, model, pipe

# Empty VRAM cache

import torch

import gc

gc.collect()

torch.cuda.empty_cache()

- https://huggingface.co/MaziyarPanahi/Meta-Llama-3-8B-Instruct-GPTQ

- install

- https://github.com/AutoGPTQ/AutoGPTQ

- 走源码安装是 ok 的;

- https://github.com/AutoGPTQ/AutoGPTQ

# GPTQ Dependencies

# !pip install optimum

# !pip install auto-gptq --extra-index-url https://huggingface.github.io/autogptq-index/whl/cu118/

from transformers import AutoModelForCausalLM, AutoTokenizer, pipeline

# Load LLM and Tokenizer

model_id = "MaziyarPanahi/Meta-Llama-3-8B-Instruct-GPTQ"

tokenizer = AutoTokenizer.from_pretrained(model_id, use_fast=True)

model = AutoModelForCausalLM.from_pretrained(

model_id,

device_map="auto",

trust_remote_code=False,

revision="main"

)

# Create a pipeline

pipe = pipeline(model=model, tokenizer=tokenizer, task='text-generation')

# See https://huggingface.co/docs/transformers/main/en/chat_templating

messages = [

{

"role": "system",

"content": "You are a friendly chatbot.",

},

{

"role": "user",

"content": "Tell me a funny joke about Large Language Models."

},

]

prompt = pipe.tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

print(prompt)

outputs = pipe(

prompt,

max_new_tokens=256,

do_sample=True,

temperature=0.1,

top_p=0.95

)

print(outputs[0]["generated_text"])

(torch.cuda.max_memory_allocated('cuda:0') + torch.cuda.max_memory_allocated('cuda:1')) / (1024*1024*1024) # 5.626893043518066,跟上面bytesandbits差不太多

GGUF

HUGGINGFACE的QuantFactory仓库下有很多量化模型,比如llama3-8b的:https://huggingface.co/QuantFactory/Meta-Llama-3-8B-instruct-GGUF

- GPT-Generated Unified Format,是由Georgi Gerganov定义发布的一种大模型文件格式。Georgi Gerganov是著名开源项目llama.cpp的创始人。

- GGML:GPT-Generated Model Language

- Although GPTQ does compression well, its focus on GPU can be a disadvantage if you do not have the hardware to run it.

- GGUF, previously GGML, is a quantization method that allows users to use the CPU to run an LLM but also offload some of its layers to the GPU for a speed up (

llama.cpp中的-ngl). Although using the CPU is generally slower than using a GPU for inference, it is an incredible format for those running models on CPU or Apple devices. - Especially since we are seeing smaller and more capable models appearing, like Mistral 7B, the GGUF format might just be here to stay!

- GGUF, previously GGML, is a quantization method that allows users to use the CPU to run an LLM but also offload some of its layers to the GPU for a speed up (

- Q4_K_M

- Q stands for Quantization.

- 4 indicates the number of bits used in the quantization process.

- K refers to the use of k-means clustering in the quantization.

- M represents the size of the model after quantization.

- (S = Small, M = Medium, L = Large).

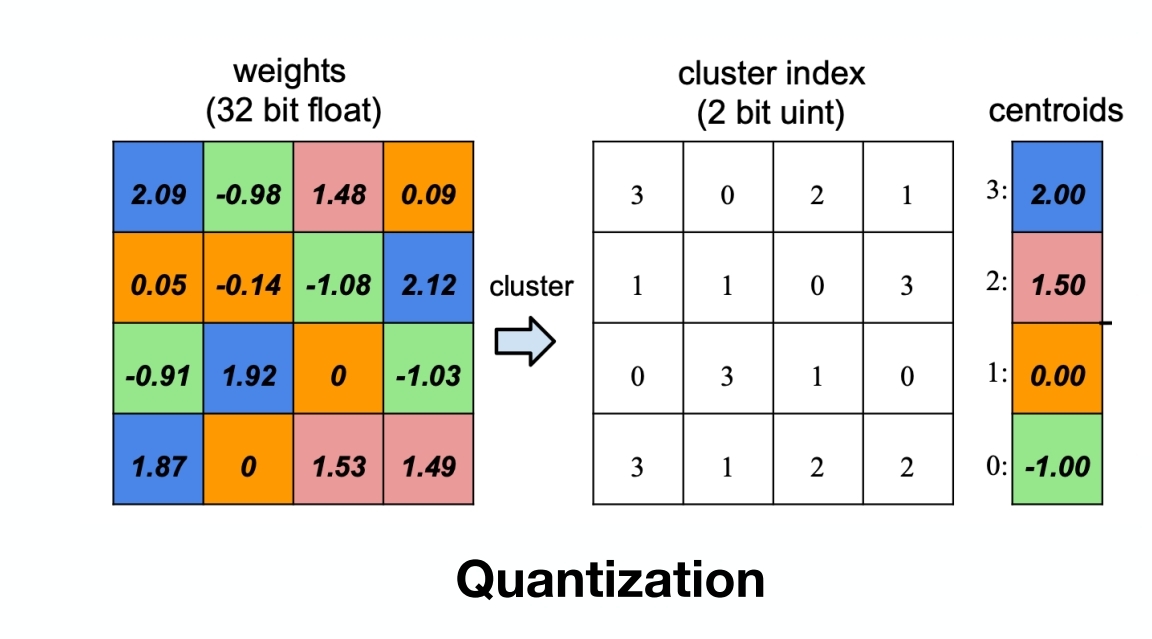

这里说GGUF用的K均值聚类来做的量化,下面是一个通用的idea(不代表GGUF就是这么做的),其实就是一种分层聚类,还是数值型的,很浅然:

代码实现:

import numpy as np

from sklearn.cluster import KMeans

# 原始权重矩阵

weights = np.array([

[2.09, -0.98, 1.48, 0.09],

[0.05, -0.14, -1.08, 2.12],

[-0.91, 1.92, 0, -1.03],

[1.87, 0, 1.53, 1.49]

])

# K-means聚类

kmeans = KMeans(n_clusters=4)

kmeans.fit(weights.reshape(-1, 1))

cluster_indices = kmeans.predict(weights.reshape(-1, 1)).reshape(weights.shape)

centroids = kmeans.cluster_centers_.flatten()

# 根据质心值排序

sorted_indices = np.argsort(centroids)

sorted_centroids = centroids[sorted_indices]

# 创建索引映射

index_map = {old_idx: new_idx for new_idx, old_idx in enumerate(sorted_indices)}

# 更新量化索引矩阵

new_cluster_indices = np.vectorize(index_map.get)(cluster_indices)

print("重新排序后的量化索引矩阵:\n", new_cluster_indices)

print("重新排序后的质心值:\n", sorted_centroids)

"""

重新排序后的量化索引矩阵:

[[3 0 2 1]

[1 1 0 3]

[0 3 1 0]

[3 1 2 2]]

重新排序后的质心值:

[-1. 0. 1.5 2. ]

"""

使用GGUF进行推理优化:(建议用llama.cpp,否则容易失败)

del tokenizer, model, pipe

# Empty VRAM cache

import torch

import gc

gc.collect()

torch.cuda.empty_cache()

from ctransformers import AutoModelForCausalLM

from transformers import AutoTokenizer, pipeline

# Load LLM and Tokenizer

# Use `gpu_layers` to specify how many layers will be offloaded to the GPU.

model = AutoModelForCausalLM.from_pretrained(

"QuantFactory/Meta-Llama-3-8B-Instruct-GGUF",

model_file="Meta-Llama-3-8B-Instruct.Q4_K_M.gguf",

# model_type="llama",

gpu_layers=20, hf=True

)

tokenizer = AutoTokenizer.from_pretrained(

"QuantFactory/Meta-Llama-3-8B-Instruct-GGUF", use_fast=True

)

# Create a pipeline

pipe = pipeline(model=model, tokenizer=tokenizer, task='text-generation')

20240726

XR这倒霉娃子,昨天跟嘉伟去129迷路就算了,还摔了一跤,把手肘和膝盖都磕破皮了,绷不住一点,还好是及时把碘伏涂上了。

周日早上六点半世纪公园有个小接力赛,芳华园700米一圈,2人组队接力,总计时2小时,圈数多者取胜。感觉最近状态不错,陪嘉伟去玩一玩呗。

晚上去蜀地源放纵完回来,看到LXY在一个人环校跑,很罕见,印象里极少在下雨天户外跑。吃太撑并不想跑,而且风雨交加,实在不明智。

PS:然后难绷的事情就来了,八点四十看雨小了些,下楼也想跑两圈环校消化一下,结果到国定门,一路施工,踩了块石头就崴脚了。唯一好消息是感觉不是很重,感觉挺麻的这回。赶紧回实验室用冷水冲了五分钟,然后涂黄道益,今天穿的又是飞飙361,这双鞋真的是有诅咒,已经崴了我第五次了,但还是舍不得扔了它。(下午刚嘲讽XR摔跤迷路,晚上就来报应了)

AWQ

A new format on the block is AWQ (Activation-aware Weight Quantization) which is a quantization method similar to GPTQ. There are several differences between AWQ and GPTQ as methods but the most important one is that AWQ assumes that not all weights are equally important for an LLM’s performance.

In other words, there is a small fraction of weights that will be skipped during quantization which helps with the quantization loss.

As a result, their paper mentions a significant speed-up compared to GPTQ whilst keeping similar, and sometimes even better, performance.

下面使用vllm框架进行部署:

from vllm import LLM, SamplingParams

# Load the LLM

sampling_params = SamplingParams(temperature=0.0, top_p=1.0, max_tokens=256)

llm = LLM(

model="casperhansen/llama-3-8b-instruct-awq",

quantization='awq',

dtype='half',

gpu_memory_utilization=.95,

max_model_len=4096

)

tokenizer = AutoTokenizer.from_pretrained("casperhansen/llama-3-8b-instruct-awq")

# See https://huggingface.co/docs/transformers/main/en/chat_templating

messages = [

{

"role": "system",

"content": "You are a friendly chatbot.",

},

{

"role": "user",

"content": "Tell me a funny joke about Large Language Models."

},

]

prompt = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

print(prompt)

# Generate output based on the input prompt and sampling parameters

output = llm.generate(prompt, sampling_params)

print(output[0].outputs[0].text)

20240727

可能是有啥诅咒,周四XR跌跟头,周五我崴脚,今天AK落枕,明天是不是该轮到 …

晚上跑几个冲刺间歇适应节奏,应该问题不大,及时处理,不太影响,但明天还是得谨慎些,其实也没必要太认真吧。

PS:风大,不是个好兆头。

var element = document.getElementById("box");

element.scrollIntoView();

element.scrollIntoView(false);

element.scrollIntoView({block: "end"});

element.scrollIntoView({behavior: "instant", block: "end", inline: "nearest"});

align To Top [可选],目前之前这个参数得到了良好的支持

- true 元素的顶部将对齐到可滚动祖先的可见区域的顶部。对应于scrollIntoViewOptions: {block: “start”, inline: “nearest”}。这是默认值

- false 元素的底部将与可滚动祖先的可见区域的底部对齐。对应于scrollIntoViewOptions: {block: “end”, inline: “nearest”}。

scrollIntoViewOptions [可选],目前这个参数浏览器对它的支持并不好,可以查看下文兼容性详情 - behavior [可选]定义过渡动画。“auto”,“instant"或"smooth”。默认为"auto"。(这个用smooth,我的Chrome是不生效的,直接没有任何反应)

- block [可选] “start”,“center”,“end"或"nearest”。默认为"center"。(若为center,元素会滚到应该是上下位置的中间)

- inline [可选] “start”,“center”,“end"或"nearest”。默认为"nearest"。(若为center,元素会滚到应该是左右位置的中间)

- 两者都是center时,元素滚到整个屏幕的中间

在Selenium中,如果你想要移动(悬停)到一个元素上,并且该元素在悬停时发生了某些变化(例如,显示了一个工具提示或下拉菜单),你可以使用ActionChains类中的move_to_element()方法。

否则直接定位元素然后click,会报错(悬停到元素上时元素已经发生变化,之前的元素不存在了):

selenium.common.exceptions.ElementNotInteractableException: Message: element not interactable

下面是一个简单的例子,演示了如何使用ActionChains在Selenium中移动到一个元素上:

from selenium import webdriver

from selenium.webdriver.common.action_chains import ActionChains

# 启动浏览器驱动

driver = webdriver.Chrome()

# 打开网页

driver.get("http://example.com")

# 找到你想要移动到的元素

element = driver.find_element_by_id("element_id")

# 使用ActionChains移动到元素上

ActionChains(driver).move_to_element(element).perform()

# 此处可以进行你需要的操作,比如检查工具提示或下拉菜单是否出现

# 关闭浏览器驱动

driver.quit()

在这个例子中,element是你想要移动到的元素。ActionChains(driver).move_to_element(element)构建了一个动作,当.perform()被调用时,浏览器会模拟鼠标悬停在这个元素上。这允许任何依赖于鼠标悬停事件的动作(如显示工具提示

20240728

五点半出发,其实从学校开车去世纪公园还是很近的,不到20分钟。

515居然能凑出34支接力队伍(每队10人,8男2女,两两出发双人接力跑芳华园一圈,大约720米,要求两人的速度尽可能相同,否则会判违规,两小时内刷圈多者取胜),Rong组的一队全是嘉伟同级别的选手,像我这样的菜鸡,只能到二队瞎跑跑(

教练,我也想去一队拼刺刀)。最终结果,阿迪的战队ARE拿到冠军(54圈),嘉伟在一队排名第4(51圈),我在二队排名第11(46圈)。

开始跟我一起的哥们儿叫志鹏,起跑前说好久没练,估计跑不动,结果第一组就把我拉爆了,2’13",我比他慢两三秒,起跑后就发现怎么都追不上他,跑到我姿势都变形了,结果两组之后他就萎了,我只好陪他一起摆烂。从第6组开始,志鹏表示已经跑不动了,Rong把他换到三棒跟女生跑,给我换了一个健全的队友,于是我又快乐地冲了两圈,然后队友第8圈又跟不上,继续开摆。其实感觉质量还行,我差不多4圈是尽力跑,本来也不是非得拼尽全力,不过最近也没怎么跑强度,冲几组也挺好。而嘉伟几乎是全程拼刺刀,跑得极其痛苦(一队的8个男生几乎都是跟他一个水平的,有一个是明显比他更强),只有最后一圈才放了,因为再快也追不上前三了。

嘉伟说他的队友跑得很有WXY的感觉(哒哒哒哒的),长得也有点点像。跑完好累,晚上回学校困得不行,嘉伟居然还陪AK晚上跑了10km,清晨刺刀见红,傍晚烈火烧云。

PS:官方计圈用时 & 和嘉伟的两张照片(中途嘉伟超了我一回,其实感觉能跟上他,但是队友跟不上。哎,算啦,就很纠结,比赛还是想尽全力,但又有些许顾忌,还是把最好的状态留给最后的上马吧,虽然衡水湖赛道很好,但是上马是嘉伟的首马破三的地方,我也想在这里同样复刻一回):

| 圈数 | 嘉伟 | 我 |

|---|---|---|

| 1 | 2’02" | 2’13" |

| 2 | 2’02" | 2’21" |

| 3 | 2’11" | 2’37" |

| 4 | 2’07" | 2’35" |

| 5 | 2’17" | 2’33" |

| 6 | 2’12" | 2’18" |

| 7 | 2’09" | 2’22" |

| 8 | 2’10" | 2’29" |

| 9 | 2’16" | 2’33" |

| 10 | 2’26" | / |

矩阵求导基础回顾:

- 标量关于矢量: y = a ⊤ x y={\bf a}^\top {\bf x} y=a⊤x

- 矢量关于矢量: y = A x {\bf y} = {\bf Ax} y=Ax

- 标量关于矩阵: y = x ⊤ A x y={\bf x}^\top {\bf Ax} y=x⊤Ax

- 矢量关于矩阵: y ⊤ = a ⊤ X {\bf y^\top} = {\bf a}^{\top}{\bf X} y⊤=a⊤X

先看第一个 y = A x \mathbf y=\mathbf {Ax} y=Ax

- x ∈ R n , A ∈ R m × n → y ∈ R m \mathbf x\in \mathbb R^n, \mathbf A\in \mathbb R^{m\times n} \rightarrow \mathbf y\in \mathbb R^{m} x∈Rn,A∈Rm×n→y∈Rm

- 线性变换的角度就是

R

n

→

R

m

\mathbb R^n\rightarrow \mathbb R^m

Rn→Rm 的映射/投影(project)

- transformer 中的 ffn(h -> 4h -> h)

y = ψ ( x ) , \mathbf{y} = \psi(\mathbf{x}), y=ψ(x),

∂ y ∂ x = [ ∂ y 1 ∂ x 1 ∂ y 1 ∂ x 2 ⋯ ∂ y 1 ∂ x n ∂ y 2 ∂ x 1 ∂ y 2 ∂ x 2 ⋯ ∂ y 2 ∂ x n ⋮ ⋮ ⋱ ⋮ ∂ y m ∂ x 1 ∂ y m ∂ x 2 ⋯ ∂ y m ∂ x n ] \begin{equation} \frac{\partial \mathbf{y}}{\partial \mathbf{x}} = \begin{bmatrix} \frac{\partial y_1}{\partial x_1} & \frac{\partial y_1}{\partial x_2} & \cdots & \frac{\partial y_1}{\partial x_n} \\ \frac{\partial y_2}{\partial x_1} & \frac{\partial y_2}{\partial x_2} & \cdots & \frac{\partial y_2}{\partial x_n} \\ \vdots & \vdots & \ddots & \vdots \\ \frac{\partial y_m}{\partial x_1} & \frac{\partial y_m}{\partial x_2} & \cdots & \frac{\partial y_m}{\partial x_n} \end{bmatrix} \end{equation} ∂x∂y= ∂x1∂y1∂x1∂y2⋮∂x1∂ym∂x2∂y1∂x2∂y2⋮∂x2∂ym⋯⋯⋱⋯∂xn∂y1∂xn∂y2⋮∂xn∂ym

- y = ψ ( x ) , \mathbf{y} = \psi(\mathbf{x}), y=ψ(x), 比如 y = A x \mathbf y=\mathbf {Ax} y=Ax

- ∂ y ∂ x \frac{\partial \mathbf y}{\partial \mathbf x} ∂x∂y 向量(多元输出,multi-variables)对向量(多元输入,multi-inputs)的导数,此时的 gradient 是 jacobian matrix

y = A x ∂ y ∂ x = A \begin{split} &\mathbf y=\mathbf {Ax}\\ &\frac{\partial \mathbf y}{\partial \mathbf x}=\mathbf A \end{split} y=Ax∂x∂y=A

-

我们来进行简单的推导

-

y

i

=

A

[

i

]

x

=

∑

k

a

i

k

x

k

y_i=A_{[i]}x=\sum_k a_{ik}x_k

yi=A[i]x=∑kaikxk

- y 1 = ∑ k a 1 k x k y_1=\sum_ka_{1k}x_k y1=∑ka1kxk

-

y

i

=

A

[

i

]

x

=

∑

k

a

i

k

x

k

y_i=A_{[i]}x=\sum_k a_{ik}x_k

yi=A[i]x=∑kaikxk

-

一个特例,当 A A A 为一个行向量时( w T \mathbf w^T wT),退化为一个多元输入,单输出(标量 scalar 输出)的内积运算,此时的导数为与输入等shape的向量;

y = w T x y=\mathbf w^T\mathbf x y=wTx

- y = w T x = ∑ i w i x i y=\mathbf w^T\mathbf x=\sum_iw_ix_i y=wTx=∑iwixi

∂ y ∂ x = [ w 1 , w 2 , ⋯ , w n ] T = w \frac{\partial y}{\partial \mathbf x}=\begin{bmatrix}w_1,w_2,\cdots,w_n\end{bmatrix}^T=\mathbf w ∂x∂y=[w1,w2,⋯,wn]T=w

雅可比矩阵(矢量对矢量求梯度)示例:

import torch

# 定义矩阵 A 和向量 x

A = torch.tensor([[1.0, 2.0],

[3.0, 4.0],

[5.0, 6.0]], requires_grad=True)

x = torch.tensor([[0.5], [1.0]], requires_grad=True)

# 计算 y = A * x

y = torch.matmul(A, x)

# 初始化雅可比矩阵

jacobian = torch.zeros_like(A)

# 计算每个 y 的元素关于 x 的导数

for i in range(y.size(0)):

y[i].backward(retain_graph=True)

jacobian[i] = x.grad.view(1, -1)

x.grad.zero_()

print(jacobian)

"""

tensor([[1., 2.],

[3., 4.],

[5., 6.]])

"""

20240729

一觉睡到十点才醒,中间完全没醒,累瘫了。

上周缺一次力量训练(周五台风,周六不宜,周日太累),今晚把力量补掉,30箭步×8组(+20kg),正反各4组,最后两组不间歇。每组箭步之前加30次双脚提踵(+20kg),现在也没有好办法弥补脚踝的弱点,只能先在力量上补强了。结束补慢跑4000米@4’23"放松,胡哥,AX,YZZ也在,LXY最近似乎经常在校外环线跑动,不过校内到处施工确实不方便,外围也修了一圈塑胶道。

ESG终版挂到https://github.com/caoyang-sufe/crawler_master,争议事件和环保处罚需要会员。

关于 TRL SFTTrainer 中的 formatting_func 与 DataCollatorForCompletion

数据集:

dataset = load_dataset("lucasmccabe-lmi/CodeAlpaca-20k", split="train")

样本形如:

{'instruction': 'Create a function that takes a specific input and produces a specific output using any mathematical operators. Write corresponding code in Python.',

'input': '',

'output': 'def f(x):\n """\n Takes a specific input and produces a specific output using any mathematical operators\n """\n return x**2 + 3*x'}

trainer = SFTTrainer(

model,

train_dataset=dataset,

args=SFTConfig(output_dir="/tmp"),

formatting_func=formatting_prompts_func,

data_collator=collator,

)

trainer.train()

formatting_func:将数据集整合成问答数据集的格式

data_collector:在SFT中(Prompt-Response Pairs),只对Response部分计算损失(Pre-Training是不区分Prompt和Response的,只对下一个Token计算损失)。

具体而言:

def formatting_prompts_func(example):

output_texts = []

for i in range(len(example['instruction'])):

text = f"### Question: {example['instruction'][i]}\n ### Answer: {example['output'][i]}"

output_texts.append(text)

return output_texts

output_texts = formatting_prompts_func(dataset[:2])

output_texts[0]

格式化后的样本(就是Promptize):

### Question: Create a function that takes a specific input and produces a specific output using any mathematical operators. Write corresponding code in Python.

### Answer: def f(x):

"""

Takes a specific input and produces a specific output using any mathematical operators

"""

return x**2 + 3*x

---

### Question: Generate a unique 8 character string that contains a lowercase letter, an uppercase letter, a numerical digit, and a special character. Write corresponding code in Python.

### Answer: import string

import random

def random_password_string():

characters = string.ascii_letters + string.digits + string.punctuation

password = ''.join(random.sample(characters, 8))

return password

if __name__ == '__main__':

print(random_password_string())

然后看data_collector,常用的是内置的DataCollatorForCompletionOnlyLM

找到 labels (batch['labels']) 中和 response_template 相同 token 的最后一个的 index 作为 response_token_ids_start_idx,然后将 labels 中的开头到responese_template的最后一个token都标记为-100,这样的话就不会计算损失了。(自带的Ignoring Token的Index,BERT和T5有差别,其实就是mask)

源码如下:

- 第一个参数是

response_template,第二个参数instruction_template(默认为 None)

model = AutoModelForCausalLM.from_pretrained("facebook/opt-350m")

tokenizer = AutoTokenizer.from_pretrained("facebook/opt-350m")

response_template = " ### Answer:"

collator = DataCollatorForCompletionOnlyLM(response_template, tokenizer=tokenizer)

20240730

- 签到了,效率好高,昨天看才送到使馆,今天就批下来,能呆一个月,但是呆不起(穷)。明天终于可以回家养老一周了。

- 7月全勤,30天总跑量210km,平均配速4’14"。最后一晚,计划测万米。起步太快,已经刻意压住,但也干到3’40"以内,中途试图调整节奏未果,3000米@3’43"即爆;第二组带XR跑了4000米@3’56"(他跟了3K),第三组10分钟慢跑6圈@4’08"收尾,想补到3000米,但是心肺真顶不住,身体也已是红温。

- 8月基本是慢跑维持。7月在学校的最后一晚,很想检验一下夏训成果。从6月1日正式恢复训练,起初巨大的落差,直到慢慢又回到巅峰乃至隐隐有超越的势头。人确有无限可能,就像两个月前,我觉得再也回不到3月的状态了,如今我坚信只要无伤,下半年一定可以比3月做得更好,不仅是破三,甚至250以内也未尝不可能。

- PS:SXY前天在ASICS做敏捷梯的臀腿力量,疼得走路都费事,今晚还是把800米间歇跑了6组,虽然不快,但也算是上强度了。乳酸堆积的疼痛其实是很容易就可以克服的,以前例训,经常是周四晚力量(敏捷梯箭步跳,弹力带蛙跳,负重深蹲跳,雪橇车冲刺,立卧撑),第二天浑身上下没一块不疼的肌肉,周六下午直接就上死亡400米间歇,但是上了跑道迈开腿,其实也就不疼了,关键就是迈开那一步。

关于accelerate ddp 与 trl SFTTrainer

- accelerate: (accelerate config)

- backend(有很多后端,ddp是默认的,数据并行)

- default ddp: 提升数据的吞吐量

self.accelerator.ddp_handler = DistributedDataParallelKwargs(**kwargs)

- deepspeed, fsdp(这是两个流行的):https://huggingface.co/blog/deepspeed-to-fsdp-and-back

- megtron-lm

- 之前fsdp在并行上处理有一些问题,不如deepspeed,但后来BUG被修了,其实现在也差不了太多

- default ddp: 提升数据的吞吐量

- backend(有很多后端,ddp是默认的,数据并行)

- accelerate ddp

- 一般用法(相对底层),稍加改动;

- https://huggingface.co/docs/transformers/accelerate

- with

transformers(Trainer) ortrl(SFTTrainer):基本上不需要改动;accelerate lanuch(具体使用ddp,deepspeed,fsdp可以通过配置调整)

- 一般用法(相对底层),稍加改动;

简单使用:

accelerate config:命令行交互式配置(默认保存在./accelerate/default_config.yaml中,accelerate lanuch也可以指定参数,会覆盖default_config.yaml的值)accelerate launch -haccelerate launch --num_processes 2 --mixed_precision bf16 training_scripts.py

一个简单的训练脚本:

import os

os.environ['http_proxy'] = 'http://127.0.0.1:7890'

os.environ['https_proxy'] = 'http://127.0.0.1:7890'

# os.environ['NCCL_P2P_DISABLE'] = '1'

# os.environ['NCCL_IB_DISABLE'] = '1'

os.environ['WANDB_DISABLED'] = 'true'

from transformers import AutoModelForCausalLM, AutoTokenizer

from datasets import load_dataset

from trl import SFTConfig, SFTTrainer, DataCollatorForCompletionOnlyLM

# from accelerate import Accelerator

import torch

torch.manual_seed(42)

dataset = load_dataset("lucasmccabe-lmi/CodeAlpaca-20k", split="train")

model = AutoModelForCausalLM.from_pretrained("facebook/opt-350m",

# device_map={"": Accelerator().process_index}

# device_map={"": 0}

)

tokenizer = AutoTokenizer.from_pretrained("facebook/opt-350m")

def formatting_prompts_func(example):

output_texts = []

for i in range(len(example['instruction'])):

text = f"### Question: {example['instruction'][i]}\n ### Answer: {example['output'][i]}"

output_texts.append(text)

return output_texts

response_template = " ### Answer:"

collator = DataCollatorForCompletionOnlyLM(response_template, tokenizer=tokenizer)

args = SFTConfig(output_dir="/tmp",

max_seq_length=512,

num_train_epochs=2,

per_device_train_batch_size=4,

gradient_accumulation_steps=4,

gradient_checkpointing=True,

)

trainer = SFTTrainer(

model,

train_dataset=dataset,

args=args,

formatting_func=formatting_prompts_func,

data_collator=collator,

)

trainer.train()

关于SFTConfig:

class SFTConfig(TrainingArguments):- 继承了

TrainingArguments类,num_train_epochs: default 3per_device_train_batch_size: default 8per_device_eval_batch_size: default 8gradient_accumulation_steps: default 1dataloader_drop_last: default false

- 继承了

dataset_text_field: 跟 dataset 的成员对齐max_seq_lengthoutput_dir='/tmp'- packing=True,

- example packing, where multiple short examples are packed in the same input sequence to increase training efficiency.

# allows multiple shorter sequences to be packed into a single training example, maximizing the use of the model's context window.

20240731

累,晒,困。一路上真被晒麻了,这天气还出去玩的人是不是得脑子有坑,不过这周末好像是七夕。

回家先称空腹净重,64.3kg,BMI跌到20以下,比3月份赛前轻1kg左右,但是再轻也轻不到哪儿去了。

虽然很累,晚上九点半还是跑了一圈船闸线,6.65km@4’25",这个点路上已经没有人了,其实很舒服,无所顾忌的轻松。跑完极其燥热,回来洗完澡直接就躺平了,疲劳到极点了。这次没有带跑鞋,真的想慢慢跑一段时间,虽然似乎也不是很能慢得下来,随性而为,我也不想太去约束什么了。

XR后天也要回重庆;嘉伟应该是Maggie给他搞了份陆家嘴的活干,Maggie人确实不错,可惜我本科没有遇到,如今还是自己打拼靠谱点;LXY晚上10km@5’30",女生的耐热确实更好,这种天气在外面我是不太能跑30分钟以上的。

PS:老妈说WCY也刚回来,要不去见一面,或也是逃不脱世俗的约束。其实我不太清楚老妈跟CAQ还有WQH的关系到底怎么样,虽然都是医院里资格最老的一批,认识也有三十多年了,但是跟WCY是真不熟,虽然名义上还是扬中的学妹,唯一的交集已经是快十年前了,反正就是到处都很难绷。

矩阵求导第二个: y = x W \mathbf y=\mathbf x \mathbf W y=xW

- x \mathbf x x 是一个行向量

- 对原式做等价替换: y T = W T x T \mathbf y^T=\mathbf W^T\mathbf x^T yT=WTxT

∂ y ∂ x = ∂ y T ∂ x T = W T \frac{\partial \mathbf y}{\partial \mathbf x}=\frac{\partial \mathbf y^T}{\partial \mathbf x^T}=\mathbf W^T ∂x∂y=∂xT∂yT=WT

构造一个简单的示例辅助理解:

( y 1 y 2 y 3 ) = ( x 1 x 2 ) ( w 11 w 12 w 13 w 21 w 22 w 23 ) = ( w 11 x 1 + w 21 x 2 w 12 x 1 + w 22 x 2 w 13 x 1 + w 23 x 2 ) \begin{split} \begin{pmatrix}y_1 & y_2 & y_3\end{pmatrix}&=\begin{pmatrix}x_1 & x_2\end{pmatrix}\begin{pmatrix}w_{11} & w_{12} & w_{13}\\ w_{21} & w_{22} & w_{23} \end{pmatrix}\\ &=\begin{pmatrix}w_{11}x_1+w_{21}x_2 & w_{12}x_1+w_{22}x_2 & w_{13}x_1+w_{23}x_2\end{pmatrix} \end{split} (y1y2y3)=(x1x2)(w11w21w12w22w13w23)=(w11x1+w21x2w12x1+w22x2w13x1+w23x2)

( ∂ y 1 ∂ x ∂ y 2 ∂ x ∂ y 3 ∂ x ) = ( w 11 w 21 w 12 w 22 w 13 w 23 ) \begin{pmatrix}\frac{\partial y_1}{\partial \mathbf x} & \frac{\partial y_2}{\partial \mathbf x} & \frac{\partial y_3}{\partial \mathbf x}\end{pmatrix}=\begin{pmatrix}w_{11} & w_{21}\\ w_{12} & w_{22}\\ w_{13} & w_{23} \end{pmatrix} (∂x∂y1∂x∂y2∂x∂y3)= w11w12w13w21w22w23

示例:

import torch

# 定义矩阵 A 和向量 x

A = torch.tensor([[1.0, 2.0],

[3.0, 4.0],

[5.0, 6.0]], requires_grad=True)

x = torch.tensor([[0.5, 1.0, 2]], requires_grad=True)

# 计算 y = A * x

y = torch.matmul(x, A)[0]

# 初始化雅可比矩阵

jacobian = torch.zeros(2, 3)

# 计算每个 y 的元素关于 x 的导数

for i in range(y.size(0)):

y[i].backward(retain_graph=True)

jacobian[i] = x.grad.view(1, -1)

x.grad.zero_()

print(jacobian)

"""

tensor([[1., 3., 5.],

[2., 4., 6.]])

"""

第三个:

(1) α = y T A x \alpha=\mathbf y^T\mathbf A\mathbf x α=yTAx

∂ α ∂ x = y T A ∂ α ∂ y = x T A T \begin{split} &\frac{\partial \alpha}{\partial \mathbf x}=\mathbf y^T\mathbf A\\ &\frac{\partial \alpha}{\partial \mathbf y}=\mathbf x^T\mathbf A^T \end{split} ∂x∂α=yTA∂y∂α=xTAT

来看证明:

- 对于第一个导数

- w T = y T A \mathbf w^T=\mathbf y^T\mathbf A wT=yTA

- α = w T x \alpha=\mathbf w^T\mathbf x α=wTx

- ∂ α ∂ x = w T = y T A \frac{\partial \alpha}{\partial \mathbf x}=\mathbf w^T=\mathbf y^T\mathbf A ∂x∂α=wT=yTA

- 对于第二个导数

- α = α T = x T A T y \alpha=\alpha^T=\mathbf x^T\mathbf A^T\mathbf y α=αT=xTATy

- ∂ α ∂ y = x T A T \frac{\partial \alpha}{\partial \mathbf y}=\mathbf x^T\mathbf A^T ∂y∂α=xTAT

(2) α = x T A x \alpha =\mathbf x^T\mathbf A\mathbf x α=xTAx

∂ α ∂ x = ( A + A T ) x \frac{\partial \alpha}{\partial \mathbf x}=(\mathbf A+\mathbf A^T)\mathbf x ∂x∂α=(A+AT)x

证明,基于矩阵矢量乘法的定义/计算:

α = ∑ i x i ∑ j a i j x j = ∑ i ∑ j x i a i j x j ∂ α ∂ x k = ∑ i x i a i k + ∑ j x k a k j ∂ α ∂ x = A T x + A x = ( A + A T ) x \begin{split} &\alpha=\sum_ix_i\sum_ja_{ij}x_j=\sum_i\sum_jx_ia_{ij}x_j\\ &\frac{\partial \alpha}{\partial x_k}=\sum_ix_ia_{ik}+\sum_jx_ka_{kj}\\ &\frac{\partial \alpha}{\partial \mathbf x}=\mathbf A^T\mathbf x+\mathbf A\mathbf x=(\mathbf A+\mathbf A^T)\mathbf x \end{split} α=i∑xij∑aijxj=i∑j∑xiaijxj∂xk∂α=i∑xiaik+j∑xkakj∂x∂α=ATx+Ax=(A+AT)x

一些特例:

- A T = A \mathbf A^T=\mathbf A AT=A 时, ∂ α ∂ A = 2 A x \frac{\partial \alpha}{\partial \mathbf A}=2\mathbf A\mathbf x ∂A∂α=2Ax

示例:

x = torch.randn(3, 1, requires_grad=True)

A = torch.randn(3, 3, requires_grad=True)

y = (x.T @ A) @ x

y.backward()

torch.allclose(x.grad, (A + A.T) @ x)

20240801

- 老妈小生日,小搓一顿。

- 养老模式启动,晚饭后30分钟慢跑@4’44",还是不够稳。

第四个: y = A x \mathbf y=\mathbf A\mathbf x y=Ax:关于矩阵求导

∂ y ∂ A \frac{\partial \mathbf y}{\partial \mathbf A} ∂A∂y

- 是一个三维的tensor

- ∂ y i ∂ A \frac{\partial y_i}{\partial \mathbf A} ∂A∂yi 各是一个矩阵

- y 1 = w 11 x 1 + w 12 x 2 ⇒ [ x 1 x 2 0 0 ] y_1=w_{11}x_1+w_{12}x_2 \Rightarrow \begin{bmatrix}x_1 & x_2\\0 & 0\end{bmatrix} y1=w11x1+w12x2⇒[x10x20]

- y 2 = w 21 x 1 + w 22 x 2 ⇒ [ 0 0 x 1 x 2 ] y_2=w_{21}x_1+w_{22}x_2 \Rightarrow \begin{bmatrix}0 & 0\\x_1 & x_2\end{bmatrix} y2=w21x1+w22x2⇒[0x10x2]

参考链接:https://pytorch.org/tutorials/beginner/basics/autogradqs_tutorial.html#optional-reading-tensor-gradients-and-jacobian-products

示例1:

import torch

# 定义矩阵 A 和向量 x

A = torch.tensor([[1.0, 2.0],

[3.0, 4.0],

# [5.0, 6.0]

],

requires_grad=True)

x = torch.tensor([[0.5], [1.0]], requires_grad=True)

# 计算 y = A * x

y = torch.matmul(A, x)

print(y.shape) # torch.Size([2, 1])

# 计算 y 对 A 的雅可比矩阵

# v^T·J

y.backward(torch.ones_like(y))

# 获取雅可比矩阵

jacobian = A.grad

jacobian

"""

tensor([[0.5000, 1.0000],

[0.5000, 1.0000]])

"""

示例2:

# 定义矩阵 A 和向量 x

A = torch.tensor([[1.0, 2.0],

[3.0, 4.0],

[5.0, 6.0]

], requires_grad=True)

x = torch.tensor([[0.5], [1.0]], requires_grad=True)

# 计算 y = A * x

y = torch.matmul(A, x)

# 初始化一个与 A 形状相同的零张量来存储雅可比矩阵

jacobian = torch.zeros((y.size(0), A.size(0), A.size(1)))

# 逐元素计算雅可比矩阵

for i in range(y.size(0)):

# 清除梯度

A.grad = None

# 对 y 中的第 i 个元素进行反向传播

y[i].backward(retain_graph=True)

# 将计算得到的梯度存储在雅可比矩阵中

jacobian[i] = A.grad

jacobian

"""

tensor([[[0.5000, 1.0000],

[0.0000, 0.0000]],

[[0.0000, 0.0000],

[0.5000, 1.0000]]])

"""

示例3:

# 定义矩阵 A 和向量 x

A = torch.tensor([[1.0, 2.0],

[3.0, 4.0],

[5.0, 6.0]], requires_grad=True)

x = torch.tensor([[0.5], [1.0]], requires_grad=True)

# 计算 y = A * x

y = torch.matmul(A, x)

print(y.shape) # torch.Size

# 计算 y 对 A 的雅可比矩阵

# v^T·J

y.backward(torch.tensor([1., 2., 3.]).view(-1, 1))

# 获取雅可比矩阵

jacobian = A.grad

jacobian

最后是损失的反向传播:

import torch

# 设定输入 x 和权重 W,b 为偏置

x = torch.tensor([[1.0, 2.0]], requires_grad=True) # 1x2 行向量

W = torch.tensor([[0.5, -0.5], [1.5, -1.0]], requires_grad=True) # 2x2 矩阵

b = torch.tensor([[0.1, -0.1]], requires_grad=True) # 1x2 行向量

# 前向传播计算 z = xW + b

z = x @ W + b # 矩阵乘法加上偏置

# 定义一个简单的标量损失函数,假设为 z 的和

L = z.sum()

# 进行反向传播计算梯度

L.backward()

# 打印梯度

print("dL/dx:", x.grad)

print("dL/dW:", W.grad)

print("dL/db:", b.grad)

# 手动验证梯度计算

dL_dz = torch.ones_like(z) # 因为 L = z.sum(), dL/dz = 1

dz_dW = x.t() # d(xW+b)/dW = x^T

manual_dL_dW = dz_dW @ dL_dz # outer product

print("Manual dL/dW:", manual_dL_dW)

"""

dL/dx: tensor([[0.0000, 0.5000]])

dL/dW: tensor([[1., 1.],

[2., 2.]])

dL/db: tensor([[1., 1.]])

Manual dL/dW: tensor([[1., 1.],

[2., 2.]], grad_fn=<MmBackward0>)

"""

20240802

- 回来还是清净一些,做事效率也高一点。大热天也不用往外面跑。

- XR今早回了重庆,7月一个个都没怎么好好练,XR一共才103k,均配都掉到5’15"开外。嘉伟157K,均配也只有4’27"。LXY昨晚70分钟12.5K,把三条路线都刷了一遍,确实很可怕。

- 依然是半小时慢跑,依然不如意,总是慢不下来。

selenium4和3的区别

Selenium 4和3的主要区别包括:

初始化driver对象:Selenium 4引入了一个新的Service类来管理驱动程序的启动和停止,而Selenium 3则没有这个类。

元素定位策略:Selenium 4废弃了find_element_by_xxx和find_elements_by_xxx方法,统一采用find_element(By.XXX, value)和find_elements(By.XXX, value)这种方式。此外,Selenium 4还增加了相对定位的方式,如above、below、to_left_of、to_right_of和near等。

expected_condition模块:在显性等待的expected_condition模块中,Selenium 4以函数的形式实现各个条件,而Selenium 3则是通过类来实现。

ActionChains类:Selenium 4对ActionChains类进行了优化,例如将move_to_element(element).click()改为click(element),move_to_element(element).click_and_hold()改为click_and_hold(element)。

另外浏览器选项和capabilities:Selenium 4移除了对旧协议的支持,并默认使用W3C WebDriver标准。这可能导致不符合W3C标准的测试功能无法启动。

Git常用指令

git config --global user.name 查看用户名

git config --global user.name “serena” 修改用户名

git config --global user.email 查看邮箱

git config --global user.email serena@example.com 修改邮箱

git config --list 查看配置列表

git config --global --list --show-origin git全局设置文件地址查询

3 初始化仓库

git init 初始化本地仓库

4 C(新增)

git status 查看工作目录和暂存区的状态

git add . 提交所有文件到暂存区

git commit -m “msg” 将暂存区提交到仓库区

git reset 命令的作用是将暂存区的文件取消暂存或者是切换到指定版本

取消暂存命令格式:git reset 文件名

切换到指定版本命令格式:git reset --hard 版本号,版本号通过 git log 命令来查看

注意:每次Git提交都会产生新的版本号,通过版本号就可以回到历史版本

git reset —hard HEAD/HEAD/HEAD^/HEAD~100 回退到上几个版本

HEAD是当前版本,HEAD上个版本,HEAD^上上个版本,HEAD~100回退100个版本

git reset —hard 3628164 回退到指定版本号,版本号不用写全

git cherry-pick 摘草莓。摘取某个commit_id到当前分支下(只要这个commit_id存在就好,不在乎它在

哪个分支下的)

5 U(修改)

git checkout – readme.txt 撤销工作区修改(尚未add,尚未commit)

git reset HEAD readme.txt, 再git checkout – readme.txt 撤销暂存区修改(已经add,尚未

commit)

git reset命令既可以回退版本,也可以把暂存区的修改回退到工作区。当我们用HEAD时,表示最新的版

本。

git reset —hard HEAD^(版本回退) 撤销版本库修改(已经commit,尚未推送到远程)

7 R(查询)

git status 查看工作目录中文件的状态(已跟踪(已提交 已暂存 已修改) 未跟踪)

git diff 查看未暂存的修改

git diff --cache 查看未提交的暂存

git log --oneline 查看提交记录

8 分支

分支的本质其实就是一个提交对象。

HEAD: 是一个指针它默认指向**master**分支,切换分支时其实就是让HEAD指向不同的分支。每次有新的提交时,HEAD都会带着当前指向的分支,一起往前移动。

第一次时候请先进行一次提交(git add/git commit),否则 Git 无法创建分支。

git log --oneline --decorate --graph --all 查看整个项目的分支图

git branch 查看分支列表

git branch -v 查看分支指向的最新的提交

git branch [name] 在当前提交对象上创建新的分支

git branch [name] [commithash] 在指定的提交对象上创建新的分支

git checkout [name] 切换分支

git branch -d [name] 删除空的分支,删除已经被合并的分支

git branch -D [name] 强制删除分支

8.1 git分支本质

分支本质是一个提交对象,所有的分支都会有机会被**HEAD所引用(HEAD**一个时刻只会指向一个分支),当我们有新的提交的时候,HEAD会携带当前持有的分支往前移动

git branch [branchname] 创建分支

git checkout [branchname] 切换分支

git checkout -b [branchname] 创建&切换分支

git branch [branchname] [commitHash] 版本穿梭(时光机)

git branch -d [branchname] 普通删除分支

git branch -D [branchname] 强制删除分支

git merge [branchname] 合并分支

快进合并 --> 不会产生冲突

典型合并 --> 有机会产生冲突

解决冲突 --> 打开冲突的文件 进行修改 add commit

git branch 查看分支列表

git branch --merged 查看合并到当前分支的分支列表, 一旦出现在这个列表中就应该删除

git branch --no-merged 查看没有合并到当前分支的分支列表,一旦出现在这个列表就应该观察一下是否需要合并

8.3 git分支的注意点

在切换的时候 一定要保证当前分支是干净的!!!

允许切换分支:

分支上所有的内容处于已提交状态

(避免)分支上的内容是初始化创建 处于未跟踪状态

(避免)分支上的内容是初始化创建 第一次处于已暂存状态

不允许切分支:

分支上所有的内容处于已修改状态,或第二次以后的已暂存状态

在分支上的工作做到一半时 如果有切换分支的需求, 我们应该将现有的工作存储起来

git stash 会将当前分支上的工作推到一个栈中

// 分支切换–>进行其他工作–>完成其他工作后–>切回原分支

git stash apply 将栈顶的工作内容还原,但不让任何内容出栈

git stash drop 取出栈顶的工作内容后,就应该将其删除(出栈)

git stash pop --> git stash apply + git stash drop

git stash list 查看存储

8.4 后悔药

git checkout – [filename] 撤销工作目录某个文件的修改

git checkout – . 撤销工作目录所有文件的修改

git reset HEAD [filename] 撤销暂存区某个文件的修改

git reset HEAD . 撤销暂存区某个文件的修改

git commit --amend 撤销提交,注释写错了,重新给用户一次机会改注释

8.5 reset三部曲

git reset --soft [commithash[ —> 用[commithash]的内容重置HEAD内容

git reset [–mixed] [commithash] —> 用[commithash]的内容重置HEAD内容 重置暂存区

git reset --hard [commithash] —> 用[commithash]的内容重置HEAD内容 重置暂存区 重置工作目录

8.6 路径reset

所有的路径 reset都要省略第一步!!!

第一步是重置HEAD内容,我们知道HEAD本质指向一个分支,分支的本质是一个提交对象 。

提交对象,指向一个树对象,树对象又很有可能指向多个git对象,一个git对象代表一个文件!!!

HEAD可以代表一系列文件的状态!!!

git reset [–mixed] [commithash] [filename] 用[commithash]中[filename]的内容重置暂存区

8.7 checkout深入理解

git checkout [brancname] 跟 git reset --hard [commithash] 特别像

共同点:

* 都需要重置 HEAD 暂存区 工作目录

区别:

checkout 对工作目录是安全的 reset --hard是强制覆盖

checkout 动HEAD时不会带着分支走而是切换分支

reset --hard 时是带着分支走

checkout + 路径

git checkout [commithash] [filename] 重置暂存区 重置工作目录

git checkout – [filename] 重置工作目录

git 设置用户名密码

在Git中设置用户名和密码通常涉及全局或特定仓库的Git配置。以下是如何设置Git用户名和邮箱地址的步骤:

打开终端(在Windows上是Git Bash)。

设置全局用户名和邮箱地址(这会影响所有仓库):

git config --global user.name "Your Name"

git config --global user.email "your_email@example.com"

如果你只想为特定仓库设置用户名和邮箱地址,首先导航到该仓库的目录,然后运行:

git config user.name "Your Name"

git config user.email "your_email@example.com"

Git不存储密码,但你可以使用凭据存储(credential storage)来记住密码:

git config --global credential.helper store

当你下一次从远程仓库进行身份验证时,Git会要求你输入用户名和密码,并将其保存在磁盘上。

20240803

- 慢跑27分钟@4’30",不是凑整,是真的太热了。

- 实话说并不很想跑,纯找罪受,但总有人更疯,也维持一下吧。

Langchain基础回顾、LECL、Tool Use、RAG 以及 LangSmith

参考资料:

- https://github.com/langchain-ai/langchain/tree/master/cookbook

- https://python.langchain.com/v0.2/docs/concepts/#langchain-expression-language-lcel

- https://python.langchain.com/v0.1/docs/expression_language/why/

- https://ai.plainenglish.io/understanding-large-language-model-based-agents-27bee5c82cec

import os

from dotenv import load_dotenv

# LANGCHAIN_TRACING_V2=true # 免费

# LANGCHAIN_API_KEY= # 免费

# OPENAI_API_KEY= # 付费,但可以用别的

load_dotenv()

- 所谓的

agent开发,LLMs workflows,GenAI 时代的软件工程- 丰富的生态,

- workflows 的复杂,手撸的效率非常低,而且不好维护,

- Input -> Processing -> Output

- 与 AutoGen 等相比,更多地面向开发者,面向软件工程

- LangGraph:multi-agents workflows

LangSmith也在更多地弥补中间过程显示的不足

- 推荐 《大模型应用开发 动手做AI Agent》(https://www.bilibili.com/opus/935785456083140628)

- 面向开发者,第一本

- 系统而全面,可以做一个很好的入门

LCEL (LangChain Expression Language)

- LangChain 重写了

|(__or__)运算符,Chain 之所在,即通过|将所有东西串成一个链 RunnablePassthrough: RunnablePassthrough 允许你将输入数据直接传递而不做任何更改(identity),通常与 RunnableParallel 一起使用,将数据传递到新的键中。- LangChain 的应用 RunnablePassthrough 作为一个占位符,可以在需要时填充数据,比如在公司名称尚未确定时先留空,后续再填入。

- 所谓的最佳实践

- python:遍历,也可以用 list comprehension

- 对于 matlab:也可以遍历,也可以整理成 matrix,直接矩阵矢量乘法;

# 自带的|运算符,是二进制位运算

# (2 | 3) > 3

2 | 3 > 2 # True

2 | 3 # 3

from langchain_core.runnables import (

RunnablePassthrough,

RunnableLambda,

RunnableParallel

)

os.environ["LANGCHAIN_PROJECT"] = 'lcel_test' # 设置一个新的project

from langchain_openai import ChatOpenAI

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.output_parsers import StrOutputParser

prompt = ChatPromptTemplate.from_template(

"Tell me a short joke about {topic}"

)

output_parser = StrOutputParser()

llm = ChatOpenAI(model="gpt-3.5-turbo")

# lcel

chain = (

{"topic": RunnablePassthrough()}

| prompt

| llm

| output_parser

)

chain.invoke("ice cream")

# 'Why did the ice cream truck break down?\n\nBecause it had too many "scoops"!'

这里prompt的输入就是{"topic": RunnablePassthrough()},这样上一步的输出是下一步的输入,如此成chain

比如直接写成常见的串行语法:

prompt.invoke({'topic': 'ice cream'})

# ChatPromptValue(messages=[HumanMessage(content='Tell me a short joke about ice cream')])

llm.invoke(prompt.invoke({'topic': 'ice cream'}))

# AIMessage(content='Why did the ice cream truck break down?\n\nIt had too many "scoops" of ice cream!', response_metadata={'token_usage': {'completion_tokens': 22, 'prompt_tokens': 15, 'total_tokens': 37}, 'model_name': 'gpt-3.5-turbo-0125', 'system_fingerprint': None, 'finish_reason': 'stop', 'logprobs': None}, id='run-fb46f4ce-665b-45f7-9fd0-9dd559465fcc-0', usage_metadata={'input_tokens': 15, 'output_tokens': 22, 'total_tokens': 37})

output_parser.invoke(llm.invoke(prompt.invoke({'topic': 'ice cream'})))

# 'Why did the ice cream truck break down? It had too many "scoops" on board!'

runnables

RunnablePassthrough(): identity

# ex1

chain = RunnablePassthrough() | RunnablePassthrough () | RunnablePassthrough ()

chain.invoke("hello") # 'hello'

# ex2

chain = RunnablePassthrough() | RunnableLambda(lambda x: x.upper())

chain.invoke("hello") # 'HELLO'

# ex3

chain = RunnablePassthrough() | RunnableLambda(lambda x: x.upper()) | RunnablePassthrough()

chain.invoke("hello") # 'HELLO'

20240804

- 今晚的节奏尚可,虽然依然达不到预期效果,风吹到身上都是烫的,地球真的是要炸了。这个强度刚刚好,不至于太伤。

- PS:小胖终于夺冠,题外话,其实巴黎的女单和东京的男单很像,三年前就觉得马龙一身荣誉,也到了当退之年,为什么不是小胖夺冠呢,太可惜了,但是竞技体育就是如此残酷,只是今年的女单结局太过不堪,丢人丢到国外去了属于是。虽然不是很喜欢那些把自己逼得太死的人,但是像小胖这样扎实内敛,而终成正果,当然是正的不能再正了,无可挑剔。

langchain JSON test

同样新建项目:

os.environ["LANGCHAIN_PROJECT"] = 'json_test2'

from langchain_core.prompts import HumanMessagePromptTemplate

from langchain_core.prompts.chat import SystemMessagePromptTemplate

from langchain_core.output_parsers import JsonOutputParser

llm = ChatOpenAI(model="gpt-4o",

model_kwargs={'response_format': {"type": "json_object"}})

json_parser = JsonOutputParser()

# 创建提示模板

prompt = ChatPromptTemplate.from_messages([

("system", '''I want you to extract the person name, age and a description from the following text.

Here is the JSON object, output:

{{

"name": string,

"age": int,

"description": string

}}'''),

("human", "{input}")

])

# 创建 LCEL 链

chain = (

{"input": RunnablePassthrough()}

| prompt

| llm

| json_parser

)

prompt # ChatPromptTemplate(input_variables=['input'], messages=[SystemMessagePromptTemplate(prompt=PromptTemplate(input_variables=[], template='I want you to extract the person name, age and a description from the following text.\n Here is the JSON object, output:\n {{\n "name": string,\n "age": int,\n "description": string\n }}')), HumanMessagePromptTemplate(prompt=PromptTemplate(input_variables=['input'], template='{input}'))])

print(prompt[0]) # prompt=PromptTemplate(input_variables=[], template='I want you to extract the person name, age and a description from the following text.\n Here is the JSON object, output:\n {{\n "name": string,\n "age": int,\n "description": string\n }}')

print(prompt[1]) # prompt=PromptTemplate(input_variables=['input'], template='{input}')

ChatPromptTemplate.from_messages(

[SystemMessagePromptTemplate.from_template('''I want you to extract the person name, age and a description from the following text.

Here is the JSON object, output:

{{

"name": string,

"age": int,

"description": string

}}'''),

HumanMessagePromptTemplate.from_template("{input}")

]

)

# ChatPromptTemplate(input_variables=['input'], messages=[SystemMessagePromptTemplate(prompt=PromptTemplate(input_variables=[], template='I want you to extract the person name, age and a description from the following text.\n Here is the JSON object, output:\n {{\n "name": string,\n "age": int,\n "description": string\n }}')), HumanMessagePromptTemplate(prompt=PromptTemplate(input_variables=['input'], template='{input}'))])

result = chain.invoke("John is 20 years old. He is a student at the University of California, Berkeley. He is a very smart student.")

# {'name': 'John', 'age': 20, 'description': 'He is a student at the University of California, Berkeley. He is a very smart student.'}

# chain.invoke({'input': "John is 20 years old. He is a student at the University of California, Berkeley. He is a very smart student."})

RAG

# !conda install faiss-gpu -c pytorch

os.environ["LANGCHAIN_PROJECT"] = 'rag_test' # 同样新建项目

from langchain_community.vectorstores import FAISS

from langchain_core.output_parsers import StrOutputParser

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.runnables import RunnablePassthrough

from langchain_openai import ChatOpenAI, OpenAIEmbeddings

OpenAIEmbeddings() # OpenAIEmbeddings(client=<openai.resources.embeddings.Embeddings object at 0x7677f6861ac0>, async_client=<openai.resources.embeddings.AsyncEmbeddings object at 0x7677f6643e60>, model='text-embedding-ada-002', dimensions=None, deployment='text-embedding-ada-002', openai_api_version='', openai_api_base=None, openai_api_type='', openai_proxy='', embedding_ctx_length=8191, openai_api_key=SecretStr('**********'), openai_organization=None, allowed_special=None, disallowed_special=None, chunk_size=1000, max_retries=2, request_timeout=None, headers=None, tiktoken_enabled=True, tiktoken_model_name=None, show_progress_bar=False, model_kwargs={}, skip_empty=False, default_headers=None, default_query=None, retry_min_seconds=4, retry_max_seconds=20, http_client=None, http_async_client=None, check_embedding_ctx_length=True)

vectorstore = FAISS.from_texts(

["Cats love thuna"], embedding=OpenAIEmbeddings()

)

retriever = vectorstore.as_retriever()

retriever.invoke("What do cats like to eat?") # [Document(page_content='Cats love thuna')]

template = """Answer the question based only on the following context:

{context}

Question: {question}

"""

prompt = ChatPromptTemplate.from_template(template=template)

def format_docs(docs):

return "\n\n".join(doc.page_content for doc in docs)

rag_chain = (

{"context": retriever | format_docs, "question": RunnablePassthrough()}

| prompt

| ChatOpenAI()

| StrOutputParser()

)

rag_chain.invoke("What do cats like to eat?") # Tuna

Tool uses(这个在GLM3出来的时候重点关注了一下)

- precise math calculation

- custom tools (自定义 functions)

os.environ["LANGCHAIN_PROJECT"] = 'tools_test2' # 新建项目

import numpy as np

from langchain_core.tools import Tool

from langchain_core.tools import tool

@tool

def add(num1: float, num2: float) -> float:

"Add two numbers."

return num1 + num2

@tool

def subtract(num1: float, num2: float) -> float:

"""

Subtract two numbers.

"""

return num1 - num2

@tool

def multiply(num1: float, num2: float) -> float:

"""Multiply two float ."""

return num1 * num2

@tool

def divide(numerator: float, denominator: float) -> float:

"""

Divides the numerator by the denominator.

"""

result = numerator / denominator

return result

@tool

def power(base: float, exponent: float) -> float:

"Take the base to the exponent power, base^exponent."

return base**exponent

@tool

def exp(x):

"""

Calculate the natural exponential $e^x$

"""

return np.exp(x)

上面定义了一堆工具函数,然后需要注册一下:

tools = [add, subtract, multiply, divide, power, exp]

然后我们开始使用:

- 先定义好agent

from langchain_openai import ChatOpenAI

from langchain.agents import create_openai_tools_agent

from langchain_core.prompts import (

ChatPromptTemplate,

MessagesPlaceholder,

HumanMessagePromptTemplate,

SystemMessagePromptTemplate,

)

llm = ChatOpenAI(model="gpt-4o", temperature=0, streaming=True)

system_template = """

You are a helpful math assistant that uses calculation functions to solve complex math problems step by step.

"""

human_template = "{input}"

prompt = ChatPromptTemplate.from_messages(

[ SystemMessagePromptTemplate.from_template(system_template), MessagesPlaceholder(variable_name="chat_history", optional=True), HumanMessagePromptTemplate.from_template(input_variables=["input"], template=human_template), MessagesPlaceholder(variable_name="agent_scratchpad"),

]

)

agent = create_openai_tools_agent(llm, tools, prompt)

- 然后执行

from langchain.agents import AgentExecutor

agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True)

# """Agent that is using tools."""

# AgentExecutor??

agent_executor.invoke({"input": "What is the result of directive of sigmoid(2.5)?"})

"""

> Entering new AgentExecutor chain...

Invoking: `exp` with `{'x': -2.5}`

responded: The sigmoid function is defined as:

\[ \sigma(x) = \frac{1}{1 + e^{-x}} \]

The derivative of the sigmoid function is:

\[ \sigma'(x) = \sigma(x) \cdot (1 - \sigma(x)) \]

First, we need to calculate \(\sigma(2.5)\):

\[ \sigma(2.5) = \frac{1}{1 + e^{-2.5}} \]

Let's calculate \(e^{-2.5}\) and then \(\sigma(2.5)\).

0.0820849986238988

Invoking: `divide` with `{'numerator': 1, 'denominator': 1.082085}`

responded: We have \( e^{-2.5} \approx 0.082085 \).

Now, we can calculate \(\sigma(2.5)\):

\[ \sigma(2.5) = \frac{1}{1 + 0.082085} \]

Let's compute this value.

0.9241418188035136

Invoking: `subtract` with `{'num1': 1, 'num2': 0.9241418188035136}`

responded: We have \(\sigma(2.5) \approx 0.9241\).

Next, we need to calculate the derivative \(\sigma'(2.5)\):

\[ \sigma'(2.5) = \sigma(2.5) \cdot (1 - \sigma(2.5)) \]

Let's compute \(1 - \sigma(2.5)\) and then \(\sigma'(2.5)\).

0.07585818119648635

Invoking: `multiply` with `{'num1': 0.9241418188035136, 'num2': 0.07585818119648635}`

0.0701037175420474The derivative of the sigmoid function at \(x = 2.5\) is approximately \(0.0701\).

> Finished chain.

"""

"""

{'input': 'What is the result of directive of sigmoid(2.5)?',

'output': 'The derivative of the sigmoid function at \\(x = 2.5\\) is approximately \\(0.0701\\).'}

"""

我们可以简单验证一下计算结果是否正确:

σ ( x ) = 1 1 + exp ( − x ) σ ′ ( x ) = σ ( x ) ( 1 − σ ( x ) ) \begin{split} \sigma(x)&=\frac{1}{1+\exp(-x)}\\ \sigma'(x)&=\sigma(x)(1-\sigma(x))\\ \end{split} σ(x)σ′(x)=1+exp(−x)1=σ(x)(1−σ(x))

import torch

import torch.nn.functional as F

F.sigmoid(torch.tensor([2.5])) * (1-F.sigmoid(torch.tensor([2.5]))) # tensor([0.0701])

20240805

- 依然慢跑30分钟@7km,不过质量显然比前五天要高不少,不是我变强了,是下了场雨凉快了些,体感很好。

- 今年百米决赛从成绩厚度上来看应该是仅次于2012年伦敦五虎那场了,那场盖伊第四9秒80,今年塞维尔也是9秒82第四无牌,虽然前三咬的都很紧,大嘴虽然是险胜,但如今成绩荣誉的厚度都足以称为历史仅次于博尔特的第二人了,但不得不说汤普森确实是顶级天赋怪。

大模型调优3: finetune_llama3_for_RAG

- finetune Llama3-8B instruct model pipeline

- peft LoRA & bitsandbytes quantization

- RAG financial (chat/QA/instruct) dataset

- Accelerate distributed

- training arguments

- evaluation

import os

os.environ['http_proxy'] = 'http://127.0.0.1:7890'

os.environ['https_proxy'] = 'http://127.0.0.1:7890'

from IPython.display import Image

from textwrap import dedent

安装必要的包

# !pip install --upgrade trl

# !pip install --upgrade bitsandbytes

import random

from typing import Dict, List

from tqdm import tqdm

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from matplotlib.ticker import PercentFormatter

import seaborn as sns

from sklearn.model_selection import train_test_split

import torch

from torch.utils.data import DataLoader

from datasets import Dataset, load_dataset

from transformers import (

AutoModelForCausalLM,

AutoTokenizer,

BitsAndBytesConfig,

pipeline,

)

from peft import (

LoraConfig,

PeftModel,

TaskType,

get_peft_model,

prepare_model_for_kbit_training,

)

from trl import DataCollatorForCompletionOnlyLM, SFTConfig, SFTTrainer

SEED = 42

def seed_everything(seed: int):

random.seed(seed)

np.random.seed(seed)

torch.manual_seed(seed)

seed_everything(SEED)

常量定义:

pad_token = "<|pad|>"

model_id = "meta-llama/Meta-Llama-3-8B-Instruct"

new_model = "Llama-3-8B-Instruct-Finance-RAG"

Model和Tokenizer

quantization_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_quant_type="nf4",

bnb_4bit_compute_dtype=torch.bfloat16

)

# tokenizer

tokenizer = AutoTokenizer.from_pretrained(model_id, use_fast=True)

# 不是所有model的tokenizer都支持 chat_template

print(tokenizer.chat_template)

"""

{% set loop_messages = messages %}{% for message in loop_messages %}{% set content = '<|start_header_id|>' + message['role'] + '<|end_header_id|>

'+ message['content'] | trim + '<|eot_id|>' %}{% if loop.index0 == 0 %}{% set content = bos_token + content %}{% endif %}{{ content }}{% endfor %}{% if add_generation_prompt %}{{ '<|start_header_id|>assistant<|end_header_id|>

' }}{% endif %}

"""

# 比如 base model

AutoTokenizer.from_pretrained('meta-llama/Meta-Llama-3-8B', use_fast=True).chat_template

tokenizer.special_tokens_map, tokenizer.pad_token # {'bos_token': '<|begin_of_text|>', 'eos_token': '<|end_of_text|>'}, None)

tokenizer.add_special_tokens({"pad_token": pad_token})

# training

tokenizer.padding_side = "right"

(tokenizer.pad_token, tokenizer.pad_token_id, tokenizer.eos_token, tokenizer.eos_token_id) # '<|pad|>', 128256, '<|end_of_text|>', 128001)

model = AutoModelForCausalLM.from_pretrained(

model_id,

quantization_config=quantization_config,

# attn_implementation="flash_attention_2",

# attn_implementation="sdpa",

device_map="auto",

)

len(tokenizer.added_tokens_decoder) # 257

model.model.embed_tokens, tokenizer.vocab_size, len(tokenizer) # (Embedding(128256, 4096), 128000, 128257)

model.resize_token_embeddings(len(tokenizer), pad_to_multiple_of=8) Embedding(128264, 4096)

128257/8, 128264/8 # (16032.125, 16033.0)

模型配置:model.config

LlamaConfig {

"_name_or_path": "meta-llama/Meta-Llama-3-8B-Instruct",

"architectures": [

"LlamaForCausalLM"

],

"attention_bias": false,

"attention_dropout": 0.0,

"bos_token_id": 128000,

"eos_token_id": 128001,

"hidden_act": "silu",

"hidden_size": 4096,

"initializer_range": 0.02,

"intermediate_size": 14336,

"max_position_embeddings": 8192,

"mlp_bias": false,

"model_type": "llama",

"num_attention_heads": 32,

"num_hidden_layers": 32,

"num_key_value_heads": 8,

"pretraining_tp": 1,

"quantization_config": {

"_load_in_4bit": true,

"_load_in_8bit": false,

"bnb_4bit_compute_dtype": "bfloat16",

"bnb_4bit_quant_storage": "uint8",

"bnb_4bit_quant_type": "nf4",

"bnb_4bit_use_double_quant": false,

"llm_int8_enable_fp32_cpu_offload": false,

"llm_int8_has_fp16_weight": false,

"llm_int8_skip_modules": null,

"llm_int8_threshold": 6.0,

"load_in_4bit": true,

"load_in_8bit": false,

"quant_method": "bitsandbytes"

},

"rms_norm_eps": 1e-05,

"rope_scaling": null,

"rope_theta": 500000.0,

"tie_word_embeddings": false,

"torch_dtype": "bfloat16",

"transformers_version": "4.43.3",

"use_cache": true,

"vocab_size": 128264

}

print(tokenizer.bos_token, tokenizer.bos_token_id) # <|begin_of_text|> 128000

print(tokenizer.eos_token, tokenizer.eos_token_id) # <|end_of_text|> 128001

print(tokenizer.pad_token, tokenizer.pad_token_id) # <|pad|> 128256

接下来用一个financial-qa-10K的数据集作为任务示例:

- RAG dataset with QA and context;

- Question + context => user query;

- Answer => assistant response;

数据字典及样本:

dataset = load_dataset("virattt/financial-qa-10K")

"""

DatasetDict({

train: Dataset({

features: ['question', 'answer', 'context', 'ticker', 'filing'],

num_rows: 7000

})

})"""

dataset["train"].column_names # ['question', 'answer', 'context', 'ticker', 'filing']

dataset['train'][:1]

"""

{'question': ['What area did NVIDIA initially focus on before expanding to other computationally intensive fields?'],

'answer': ['NVIDIA initially focused on PC graphics.'],

'context': ['Since our original focus on PC graphics, we have expanded to several other large and important computationally intensive fields.'],

'ticker': ['NVDA'],

'filing': ['2023_10K']}

"""

datasets库的load_datasets得到的DatasetDict对象,可以直接用map方法进行批量处理:

def process(row):

return {

"question": row["question"],

"context": row["context"],

"answer": row["answer"]

}

new_dataset = dataset.map(process, num_proc=8,

remove_columns=dataset["train"].column_names)

new_dataset

"""

DatasetDict({

train: Dataset({

features: ['question', 'answer', 'context'],

num_rows: 7000

})

})

"""

这样就得到了QA + Context三列字段,查看:

df = new_dataset['train'].to_pandas()

df.head()

df.isnull().value_counts() # 这个数据集是没有缺失的

然后就是 to char dataset,需要自定义formatter:

def format_example(row: dict):

prompt = dedent(

f"""

{row["question"]}

Information:

```

{row["context"]}

```

"""

)

messages = [

{

"role": "system",

"content": "Use only the information to answer the question",

},

{"role": "user", "content": prompt},

{"role": "assistant", "content": row["answer"]},

]

return tokenizer.apply_chat_template(messages, tokenize=False)

df["text"] = df.apply(format_example, axis=1)

print(df.iloc[0]['text'])

"""

<|begin_of_text|><|start_header_id|>system<|end_header_id|>

Use only the information to answer the question<|eot_id|><|start_header_id|>user<|end_header_id|>

What area did NVIDIA initially focus on before expanding to other computationally intensive fields?

Information:

·```

Since our original focus on PC graphics, we have expanded to several other large and important computationally intensive fields.

```<|eot_id|><|start_header_id|>assistant<|end_header_id|>

NVIDIA initially focused on PC graphics.<|eot_id|>

"""

就是prompt template,然后可以统计一下token数量:

def count_tokens(row: Dict) -> int:

return len(

tokenizer(

row["text"],

add_special_tokens=True,

return_attention_mask=False,

)["input_ids"]

)

df["token_count"] = df.apply(count_tokens, axis=1)

看看整体 token count 的分布情况:

# plt.hist(df.token_count, weights=np.ones(len(df.token_count)) / len(df.token_count))

# plt.gca().yaxis.set_major_formatter(PercentFormatter(1))

# plt.xlabel("Tokens")

# plt.ylabel("Percentage")

# plt.show()

sns.histplot(df.token_count, stat='probability', bins=30)

# 设置 y 轴格式为百分比

plt.gca().yaxis.set_major_formatter(PercentFormatter(1))

# 添加标签

plt.xlabel("Tokens")

plt.ylabel("Percentage")

# 显示图表

plt.show()

len(df[df.token_count < 512]), len(df), len(df[df.token_count < 512]) / len(df) # (6997, 7000, 0.9995714285714286)

几乎所有的token count都在512以下,因此可以设置maxlen=512

分割数据集(20:4:1):

train, temp = train_test_split(df, test_size=0.2)

val, test = train_test_split(temp, test_size=0.2)

len(train), len(val), len(test) # (5600, 1120, 280)

train.sample(n=5000).to_json("./data/train.json", orient="records", lines=True)

val.sample(n=1000).to_json("./data/val.json", orient="records", lines=True)

test.sample(n=250).to_json("./data/test.json", orient="records", lines=True)

dataset = load_dataset(

"json",

data_files={"train": "./data/train.json",

"validation": "./data/val.json",

"test": "./data/test.json"},

)

dataset

"""

DatasetDict({

train: Dataset({

features: ['question', 'answer', 'context', 'text', 'token_count'],

num_rows: 5000

})

validation: Dataset({

features: ['question', 'answer', 'context', 'text', 'token_count'],

num_rows: 1000

})

test: Dataset({

features: ['question', 'answer', 'context', 'text', 'token_count'],

num_rows: 250

})

})

"""

得到划分后的数据集

接下来我们就可以做SFT(监督微调)

这里以llama3-8b-instruct为例:

pipe = pipeline(

task="text-generation",

model=model,

tokenizer=tokenizer,

max_new_tokens=128,

return_full_text=False,

)

def create_test_prompt(data_row):

prompt = dedent(

f"""

{data_row["question"]}

Information:

```

{data_row["context"]}

```

"""

)

messages = [

{

"role": "system",

"content": "Use only the information to answer the question",

},

{"role": "user", "content": prompt},

]

return tokenizer.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

row = dataset["test"][0]

prompt = create_test_prompt(row)

print(prompt)

"""

<|begin_of_text|><|start_header_id|>system<|end_header_id|>

Use only the information to answer the question<|eot_id|><|start_header_id|>user<|end_header_id|>

How does Amazon fulfill customer orders?

Information:

·```

Amazon fulfills customer orders using its North America and International fulfillment networks, co-sourced and outsourced arrangements in certain countries, digital delivery, and physical stores.

```<|eot_id|><|start_header_id|>assistant<|end_header_id|>

"""

模型输出:

outputs = pipe(prompt)

response = f"""

answer: {row["answer"]}

prediction: {outputs[0]["generated_text"]}

"""

print(response)

"""

answer: Amazon fulfills customer orders through a combination of North America and International fulfillment networks operated by the company, co-sourced and outsourced arrangements in some countries, digital delivery, and through its physical stores.

prediction: According to the information, Amazon fulfills customer orders using:

1. North America and International fulfillment networks

2. Co-sourced and outsourced arrangements in certain countries

3. Digital delivery

4. Physical stores

"""

20240806

- 早上有风很凉快,明日就是立秋。早饭后遛了一圈河堤@7k,走了很久,夏荷盛开,微醺、渐佳、盛放,如画般空灵。

- 跑休,力量训练,大核心×3组 + 深蹲20次×5组 + 弹力带引体20次×5组。

- PS:YZZ最近跟LXY跑得不多,是个人也顶不住LXY每天10k+的量。今晚杨体400米间歇×12组(间歇90秒),看起来质量很高,很有长进。

再看一个例子:

row = dataset["test"][1]

prompt = create_test_prompt(row)

print(prompt)

"""

<|begin_of_text|><|start_header_id|>system<|end_header_id|>

Use only the information to answer the question<|eot_id|><|start_header_id|>user<|end_header_id|>

Who holds the patents for the active pharmaceutical ingredients of some of the company's products?

Information:

· ```

Patents covering certain of the active pharmaceutical ingredients ("API") of some of our products are held by third parties. We acquired exclusive rights to these patents in the agreements we have with these parties.

```<|eot_id|><|start_header_id|>assistant<|end_header_id|>

"""

模型输出:

outputs = pipe(prompt)

response = f"""

answer: {row["answer"]}

prediction: {outputs[0]["generated_text"]}

"""

print(response)

"""

answer: The patents for the active pharmaceutical ingredients of some of the company's products are held by third parties, from whom the company has acquired exclusive rights through agreements.

prediction: Third parties hold the patents for the active pharmaceutical ingredients of some of the company's products.

"""

当然可以批量生成模型输出:

rows = []

for row in tqdm(dataset["test"]):

prompt = create_test_prompt(row)

outputs = pipe(prompt)

rows.append(

{

"question": row["question"],

"context": row["context"],

"prompt": prompt,

"answer": row["answer"],

"untrained_prediction": outputs[0]["generated_text"],

}

)

predictions_df = pd.DataFrame(rows)

结果predictions_df 不作展示

最后是Train on Completions

- collate_fn

- DataCollatorForCompletionOnlyLM

- data collator used for completion tasks. It ensures that all the tokens of the labels are set to an ‘ignore_index’

when they do not come from the assistant. This ensure that the loss is only

calculated on the completion made by the assistant.

- data collator used for completion tasks. It ensures that all the tokens of the labels are set to an ‘ignore_index’

- 实例化的 collator 作为 SFTrainer 的 data_collator 的参数;

- DataCollatorForCompletionOnlyLM

examples = [dataset["train"][0]["text"]]

print(examples[0])

"""

<|begin_of_text|><|start_header_id|>system<|end_header_id|>

Use only the information to answer the question<|eot_id|><|start_header_id|>user<|end_header_id|>

Who is the Chief Financial Officer and since when?

Information:

·```

Richard A. Galanti | Executive Vice President and Chief Financial Officer. Mr. Galanti has been a director since January 1995.

```<|eot_id|><|start_header_id|>assistant<|end_header_id|>

Richard A. Galanti is the Executive Vice President and Chief Financial Officer, and he has been in this role since 1993.<|eot_id|>

"""

就是用dataloader的collate_fn来进行预处理

response_template = "<|end_header_id|>"

collator = DataCollatorForCompletionOnlyLM(response_template, tokenizer=tokenizer)

# collator

encodings = [tokenizer(e) for e in examples]

dataloader = DataLoader(encodings, collate_fn=collator, batch_size=1)

batch = next(iter(dataloader))

batch.keys() # dict_keys(['input_ids', 'attention_mask', 'labels'])

可以通过batch["input_ids"], batch["labels"]查看数据,以及:

tokenizer.decode([271, 42315, 362, 13, 10845, 15719, 374,

279, 18362, 23270, 4900, 323, 14681, 17961, 20148, 11,

323, 568, 706, 1027, 304, 420, 3560, 2533, 220,

2550, 18, 13, 128009])

可以得到解码的结果:'\n\nRichard A. Galanti is the Executive Vice President and Chief Financial Officer, and he has been in this role since 1993.<|eot_id|>'

接着我们需要配置lora算法进行微调

模型整体架构:

LlamaForCausalLM(

(model): LlamaModel(

(embed_tokens): Embedding(128264, 4096)

(layers): ModuleList(

(0-31): 32 x LlamaDecoderLayer(

(self_attn): LlamaSdpaAttention(

(q_proj): Linear4bit(in_features=4096, out_features=4096, bias=False)

(k_proj): Linear4bit(in_features=4096, out_features=1024, bias=False)

(v_proj): Linear4bit(in_features=4096, out_features=1024, bias=False)

(o_proj): Linear4bit(in_features=4096, out_features=4096, bias=False)

(rotary_emb): LlamaRotaryEmbedding()

)

(mlp): LlamaMLP(

(gate_proj): Linear4bit(in_features=4096, out_features=14336, bias=False)

(up_proj): Linear4bit(in_features=4096, out_features=14336, bias=False)

(down_proj): Linear4bit(in_features=14336, out_features=4096, bias=False)

(act_fn): SiLU()

)

(input_layernorm): LlamaRMSNorm()

(post_attention_layernorm): LlamaRMSNorm()

)

)

(norm): LlamaRMSNorm()

(rotary_emb): LlamaRotaryEmbedding()

)

(lm_head): Linear(in_features=4096, out_features=128264, bias=False)

)

LORA配置:

lora_config = LoraConfig(

r=32,

lora_alpha=16,

target_modules=[

"self_attn.q_proj",

"self_attn.k_proj",

"self_attn.v_proj",

"self_attn.o_proj",

"mlp.gate_proj",

"mlp.up_proj",

"mlp.down_proj",

],