一、导包安装

材料:JDK包、Hadoop包、Centos服务器(虚拟机也行)

1.安装jdk

导包:准备好JDK安装包与Hadoop安装包,建议安放到/opt下,可以先mkdir两个文件夹installs,modules。modules用来存放安装包,installs是安装空间。

使用命令安装JDK

tar -zxvf jdk-8u171-linux-x64.tar.gz -C /opt/installs/如果觉得解压后包名不容易辨认,可以改个名

1、进入文件夹 cd /opt/installs

2、进行重命名 mv jdk1.8.0_171 jdk解压完成就可以修改系统配置了

1、进入配置文件 vi /etc/profile

2、添加PATH,将下面两行代码添加到文件最后,不要动别的地方

export JAVA_HOME=/opt/installs/jdk

export PATH=$PATH:$JAVA_HOME/bin

:wq 保存退出刷新配置文件,使配置生效

source /etc/profile验证JDK是否安装成功,看到版本号就是成功了

java -version

2、安装Hadoop

输入命令解压

tar -zxvf hadoop-3.3.1.tar.gz -C /opt/installs/

依旧觉得不不方便可以改名

进入安装文件夹 cd /opt/installs/

改名 mv hadoop-3.3.1 hadoop进入配置文件,配置环境变量

1、进入配置文件 vi /etc/profile

2、添加PATH

export HADOOP_HOME=/opt/installs/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

:wq 保存退出刷新配置文件,验证是否生效

刷新配置 source /etc/profile

验证是否生效 hadoop version看到版本号就证明成功了

二、伪分布模式部署

1、关闭防火墙、伪分布式部署前提需要关闭centos防火墙

1、查看防火墙状态

systemctl status firewalld

2、关闭防火墙

systemctl stop firewalld

(3、开启防火墙,这里用不到

systemctl start firewalld)

2、主机自身免密登录

利用ssh命令免密登录自身

第一步、需要在主机上生成公钥和私钥

ssh-keygen -t rsa查看生成的私钥与公钥是否成功

cd /root/.ssh/id_rsa

接下来需要将公钥传递给想要免密登录的主机,我的主机名bigdata01

ssh-copy-id bigdata01补充:**主机命名**

进入配置文件 vi /etc/hosts

添加IP对应的主机名,可以把需要的主机先写上,以后克隆可以直接用

192.168.211.128 bigdata01 #本机的IP与主机名

**补充结束**

免密登录本机测试,记得登录后退出exit,搞混容易出事

3.修改Linux安全机制

关闭防火墙,本机免密登录后,就接着来修改Linux登录机制

vi /etc/selinux/config修改:SELINUX=disabled

保存退出

4.配置host映射

查看host文件 cd /opt/installs/hadoop/etc/hadoop

第一个搞 core-site.xml

<configuration>

<!-- 设置namenode节点 -->

<!-- 注意: hadoop1.x时代默认端⼝9000 hadoop2.x时代默认端⼝8020 hadoop3.x时 代默认端⼝ 9820 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://bigdata01:9820</value>

</property>

<!-- hdfs的基础路径,被其他属性所依赖的⼀个基础路径 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/installs/hadoop/tmp</value>

</property>

</configuration>

*****粘贴就可以,不过注意<configuration>别重复了******第二个搞hdfs-site.xml

<configuration>

<property>

<!--备份数量-->

<name>dfs.replication</name>

<value>1</value>

</property>

<!--secondarynamenode守护进程的http地址:主机名和端⼝号。参考守护进程布局 -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>bigdata01:9868</value>

</property>

<!-- namenode守护进程的http地址:主机名和端⼝号。参考守护进程布局 -->

<property>

<name>dfs.namenode.http-address</name>

<value>bigdata01:9870</value>

</property>

</configuration>第三个搞hadoop-env.sh

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

export JAVA_HOME=/opt/installs/jdk第四个搞 workers

vi workers

修改里面的内容为: bigdata01 保存

***就是主机名***5.主机格式化

危险操作,谨慎驾驶

hdfs namenode -format6.原神启动hdfs

start-dfs.sh7.验证

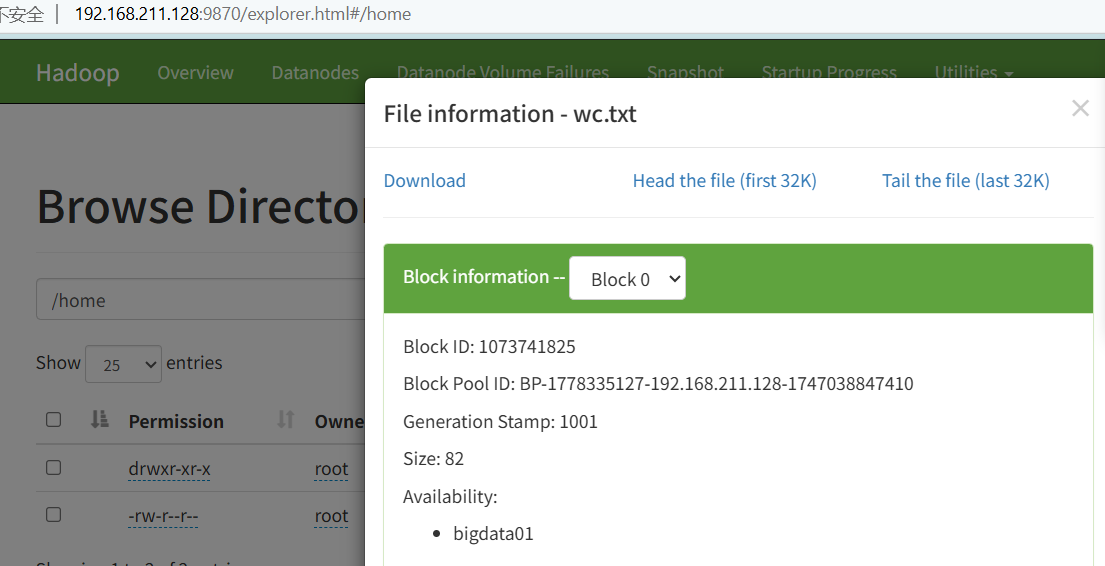

浏览器输入自己主机地址,我的192.168.211.128:9870端口9870

进入就成功!

![]()

You win!

375

375

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?