1,环境:

本人原本使用的是win 10(CPUi5,内存8G)的环境,但自己想搭建一个分布式的爬虫,于是自己想到了虚拟机,虚拟机的环境为Ubuntu14.04,但是由于各种原因,虚拟机中的python环境(python环境要求为python3.5+)已经被我弄乱了,我在网上看到说Ubuntu16.04中有默认的python3.5+,于是果断地用了Ubuntu16.04

2,当环境切换为Ubuntu16.04时:

也是几经波折,才知道怎么来搭建,下面我总结一下在Ubuntu16.04中使用的命令来搭建一个分布式的scrapy框架。

sudo update-alternatives --install/usr/bin/python python /usr/bin/python2 100

sudo update-alternatives --install/usr/bin/python python /usr/bin/python3 150#利用alternatives切换为python3.5.2

sudo apt-get install python3-pip #安装pip3 这里一定是安装python3-pip,而不是python-pip

sudo pip3 install scrapy #安装scrapy 框架

sudo pip3 install scrapy_redis

sudo pip3 install pymongo #安装mongodb的python库

sudo pip3 install mongodb #安装mongodb数据库

还要安装redis数据库,可到http://redis.io处下载

3,当我配置好的时候

一个主机,主要是利用redis的set进行去重,所用的从机都是从主机这里拿到url

从机,主要是数据的爬取和存储

我发现我电脑根本带不起来啊,一个字就是卡,然后我本来想着要用AWS的,但是它这个注册太麻烦了,所以选择了阿里云的学生机,网址,https://promotion.aliyun.com/ntms/campus2017.html?spm=5176.8142029.20160203.2.sWCty0

4,目前阿里云上面的还没有搭好。

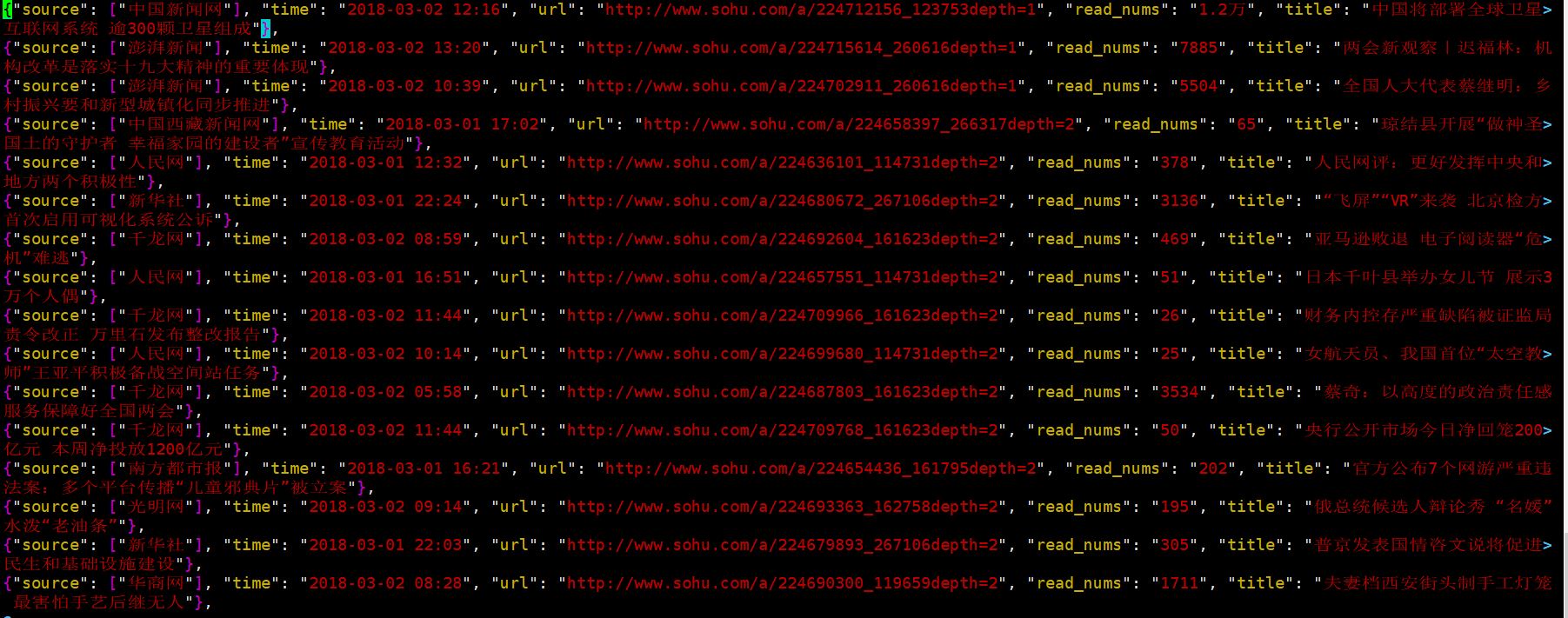

虽然分布式爬虫的还没有搭建好,但是一个节点已经搭建好了,大家请看爬取的数据:

有一个工具Xsell推荐给大家,用于跟云主机进行文件传输,但是我还没有找到可以传文件夹的方式

使用rz 命令会弹出一个打开文件框,打开相应的文件就行了。

使用sz 文件 会让你选择文件的存放文字。

这是这一周以来自己爬虫的成果,希望自己再接再厉,欢迎大家来交流。

2629

2629

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?