摘要:

在使用 Docker Compose 部署容器化应用程序时,优化日志输出对于提升效率和管理便利性至关重要。本文将介绍如何优化 Docker Compose 日志输出,以加速容器化应用的轻松部署过程。

优化操作

当我们使用 Docker Compose 部署容器化应用程序时,日志输出可能成为一个挑战,导致等待时间过长或难以处理。然而,通过优化 Docker Compose 日志输出,我们可以加速容器化应用的轻松部署过程,提升效率和管理便利性。以下是几种方法,帮助你实现这一目标:

-

后台模式运行容器:轻松快速部署

在使用

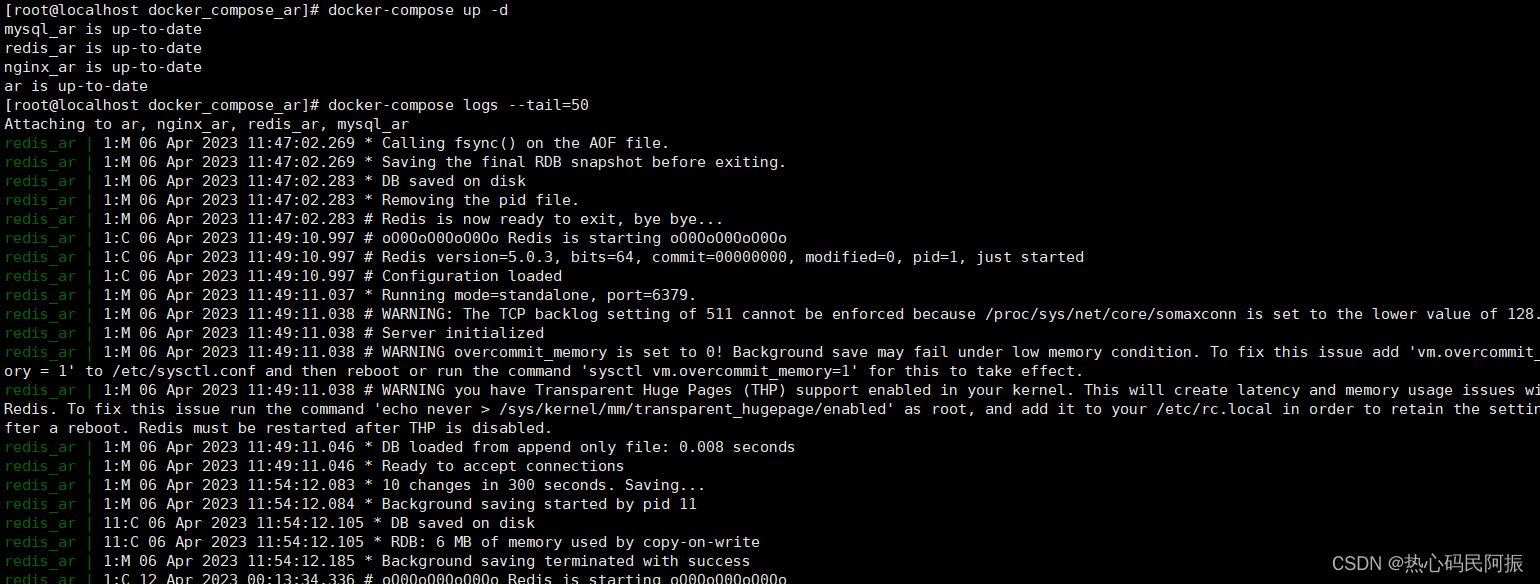

docker-compose up命令启动容器时,通过在命令中添加-d或--detach参数,将容器以后台模式运行。这样做可以避免实时输出日志信息,减少等待时间,让你的部署过程更加轻松快速。例如:docker-compose up -d注意:此命令将容器以后台模式启动,不会在终端输出日志信息。 -

限制日志输出量:精简而有效

虽然

docker-compose up命令本身不支持--tail参数,但我们可以通过其他方式实现类似的效果。在容器以后台模式运行后,可以使用docker-compose logs命令来查看容器的日志输出,并通过指定--tail=50参数,限制日志输出的行数。这种精简而有效的方法,使你能够更好地处理和阅读日志信息。例如:docker-compose up -d docker-compose logs --tail=50

-

日志驱动程序配置:定制化日志管理

通过配置日志驱动程序,你可以更灵活地处理容器的日志输出。选择适当的日志驱动程序,将日志输出重定向到文件或远程日志服务器,从而减少等待时间并且更方便地管理日志。在

docker-compose.yml文件中,使用logging选项配置日志驱动程序,设置每个日志文件的最大大小和保留的文件数。以下是示例配置:services: your_service: # 其他配置 logging: driver: "json-file" options: max-size: "10m" max-file: "3"通过以上定制化的日志管理,你可以更好地管理和维护容器的日志输出。

分析拓展

通过这些优化方法,你可以更好地管理 Docker Compose 的日志输出,加速容器化应用的轻松部署过程。优化日志输出不仅提高了部署效率,还使日志管理更加便利,从而提升了开发人员和运维团队的工作效率。

除了上述方法,还有其他策略可以进一步增强日志管理的吸引力:

-

使用日志聚合工具:提升可视化和分析能力

考虑使用专门的日志聚合工具,如ELK Stack(Elasticsearch、Logstash、Kibana)或Splunk等。这些工具能够集中收集、分析和可视化容器的日志输出。通过将日志集中存储在一个地方,并利用强大的搜索、过滤和分析功能,你可以更方便地监控和管理容器的日志信息。

-

实施日志轮转策略:优化存储空间利用

对于长时间运行的容器,可以设置日志轮转策略,定期压缩或删除旧的日志文件。这样可以避免日志文件过多占用存储空间,同时确保较早的日志信息仍然可用。

-

针对特定容器设置日志级别:聚焦关键信息

如果只关注特定容器的日志输出,可以在容器级别设置日志级别。通过设置适当的日志级别,可以过滤掉不需要的日志信息,减少输出量,使关键信息更加突出。

总结

通过采用这些优化策略,你可以实现更加高效和便捷的 Docker Compose 日志管理。无论是在开发、测试还是生产环境中,优化日志输出都能提高部署效率、简化日志处理,并为容器化应用的运维工作提供更好的支持。

为了确保日志管理的可靠性,确保选择适当的日志驱动程序和配置参数,并在实施前进行充分测试和验证。不同的应用场景可能需要不同的日志管理策略,因此请根据具体需求选择最合适的优化方法。

通过优化 Docker Compose 日志输出,你可以轻松应对容器化应用的部署和管理,提高开发和运维效率,同时改善故障排查和性能分析的可行性。让日志成为你提升容器化应用质量的得力助手!

3296

3296

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?