深度学习5 RNN

1. RNN

(1)用途

现实生活中的数据存在序列化结构,我们需要建立一种更优秀的序列数据模型。例如:文本:字母和词汇的序列,语音:音节的序列,视频:图像帧的序列,时态数据:气象观测数据,股票交易数据、房价数据等。

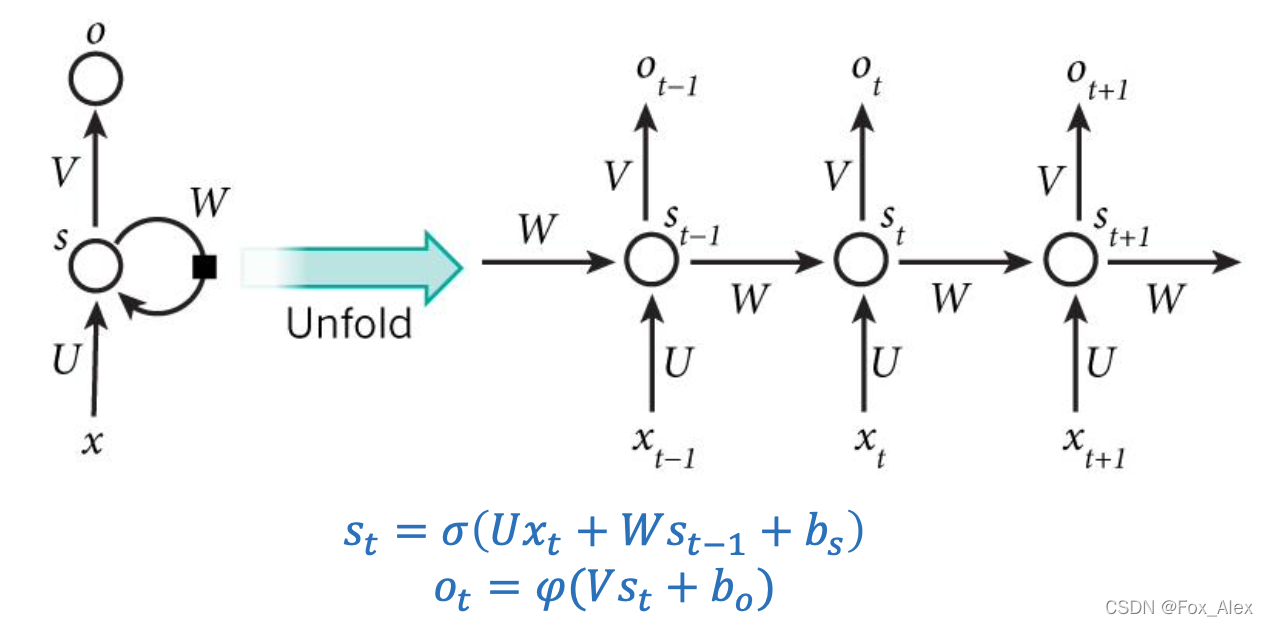

(2)结构

循环神经网络是一种人工神经网络,它的节点间的连接形成一个遵循时间序列的有向图,它的核心思想是,样本间存在顺序关系,每个样本和它之前的样本存在关联。通过神经网络在时序上的展开,我们能够找到样本之间的序列相关性。

2. 长短时记忆网络

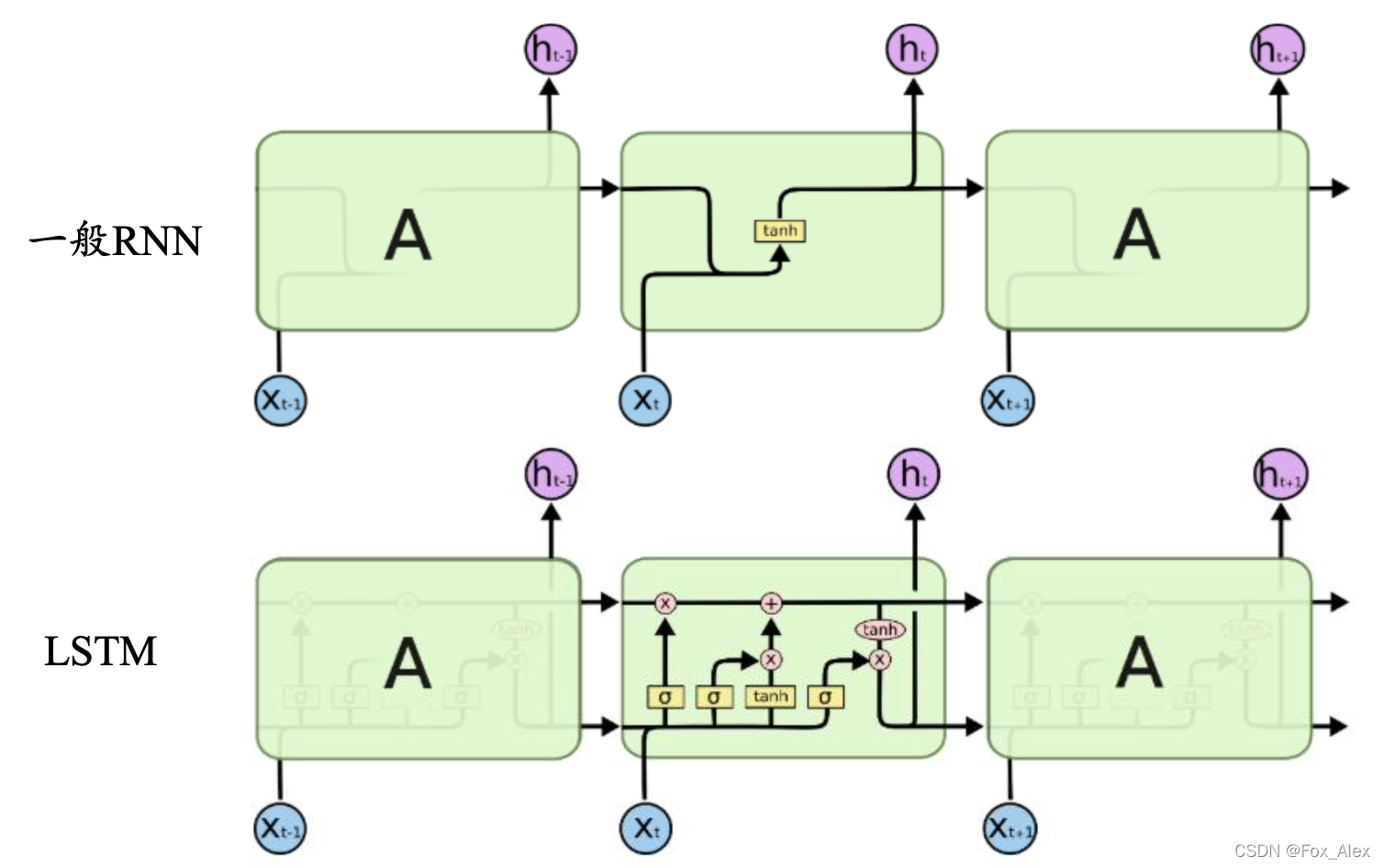

在RNN中,存在一个很重要的问题,就是梯度消失问题,一开始我们不能有效的解决长时依赖问题,其中梯度消失的原因有两个:BPTT算法和激活函数Tanh。有两种解决方案,分别是ReLU函数和门控RNN(LSTM)。LSTM,即长短时记忆网络,于1997年被Sepp Hochreiter 和Jürgen Schmidhuber提出来,LSTM是一种用于深度学习领域的人工循环神经网络(RNN)结构。一个LSTM单元由输入门、输出门和遗忘门组成,三个门控制信息进出单元。

LSTM依靠贯穿隐藏层的细胞状态实现隐藏单元之间的信息传递,其中只有少量的线性操作;LSTM引入了“门”机制对细胞状态信息进行添加或删除,由此实现长程记忆;“门”机制由一个Sigmoid激活函数层和一个向量点乘操作组成,Sigmoid层的输出控制了信息传递的比例

3. GRU

Gated Recurrent Unit (GRU),是在2014年提出的,可认为是LSTM 的变种,它的细胞状态与隐状态合并,在计算当前时刻新信息的方法和LSTM有 所不同;GRU只包含重置门和更新门;在音乐建模与语音信号建模领域与LSTM具有相似的性能,但是参数更少,只有两个门控。

本文介绍了循环神经网络(RNN)及其在序列数据建模中的应用,如文本、语音和时态数据。RNN在处理长时依赖时存在梯度消失问题,为了解决这一问题,文章提到了长短时记忆网络(LSTM)和门控循环单元(GRU)。LSTM通过门控机制有效解决了长程记忆,而GRU则简化了LSTM,具有较少的参数,但在某些任务上表现接近。

本文介绍了循环神经网络(RNN)及其在序列数据建模中的应用,如文本、语音和时态数据。RNN在处理长时依赖时存在梯度消失问题,为了解决这一问题,文章提到了长短时记忆网络(LSTM)和门控循环单元(GRU)。LSTM通过门控机制有效解决了长程记忆,而GRU则简化了LSTM,具有较少的参数,但在某些任务上表现接近。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?