统计学习方法笔记

当正负样本极度不均衡时存在问题!比如,正样本有99%时,分类器只要将所有样本划分为正样本就可以达到99%的准确率。但显然这个分类器是存在问题的。当正负样本不均衡时,常用的评价指标为ROC曲线和PR曲线。

概率模型:决策树、bayes、HMM、CRF、概率潜在语义分析、潜在狄利克雷分析lda、高斯混合模型(一定可以表示为联合概率分布的形式,)概率模型的代表是概率图模型,即联合概率分布由有向图或者无向图表示的模型,而联合概率可以根据图的结构分解为因子乘积的形式。Bayes,CRF,HMM都是概率图模型。

非概率模型:SVM、感知机、k近邻、k均值、潜在语义分析、NN、Adaboost,LR两者都有。

生成模型:HMM、navie bayes,可以还原出联合概率分布,收敛更快,存在隐变量依然可以用生成方法学习,

判别模型:k近邻、感知机、决策树、LR、最大熵、svm、CRF。往往学习准确率更高,可以进行各种成都上 的抽象,定义特征并使用特征,简化学习问题。

bayes估计:利用bayes定理,计算给定数据条件下的条件概率,即后验概率,取后验概率最大!

极大似然估计:频率学派,取能使概率最大的参数。

损失函数和风险函数:损失函数(代价函数)一次度量模型一次预测的好坏,风险函数度量平均意义下模型预测的好坏。

损失函数:0-1,平方损失,绝对损失,对数(似然)损失

损失函数的期望就是理论上模型关于联合分布的平均意义下的损失,即风险函数,或期望损失。学习的目标就是选择期望风险最小的模型。

经验风险:关于数据集的平均风险

期望风险:模型关于联合分布的期望损失。

经验风险最小化:极大似然估计,当模型是条件概率分布,损失函数为对数损失,经验风险最小化等价于极大似然估计。当样本容量小,会产生过拟合

结构风险最小化:防止过拟合提出,等价于正则化,加入了正则化项。如bayes估计中的最大后验概率估计。

过拟合:模型参数过多,学习到了噪音,对训练数据预测很好,对位置数据很差,导致模型拟合能力下降。

欠拟合:模型过于简单,未学习到数据的较多特征,都很差。

决策树:表示给定特征条件下类的条件概率分布,包含特征选择,决策树生成,剪枝

熵:随机变量不确定性的度量。

条件商:已知随机变量X的条件下随机变量Y的不确定性,定义X条件下Y的条件概率分布的熵对X的数学期望。

信息增益(互信息):得知特征X的信息而使得y信息不确定性减少的程度。即:经验熵H(D)与H(D/A)之差。

信息增益比:其信息增益g(D,A)与训练集D关于特征A的值的熵HA(D)之比。

剪枝:通过优化函数考虑了减小模型复杂度,损失函数的极小化等价于正则化的极大似然估计。

ID 3 :选择信息增益最大的特征建立子节点,再递归调用上述方法,直至所有特征小于某阈值或没有,极大似然法。

C 4.5: 选择信息增益比最大的特征建立子节点,再递归调用上述方法,直至所有特征小于某阈值或没有,极大似然法。

CART :Gini 指数最小化准则(经A=a分割后的不确定性)。平方误差损失,启发式,最小二乘回归树。二分类gini = 2p(1-p)

最大熵模型:熵最大的模型是最好的模型,在约束条件下,在没有更多信息情况下,那些不确定部分是等可能的,极大似然估计,LR和最大熵都归结为以似然函数为目标的最优化问题,它是光滑的凸函数,保证能找到全局最优解。

SVM:二分类模型,定义在特征空间上的间隔最大的分类器。学习策略就是间隔最大化,求解二次凸优化问题,等价于正则的合页损失函数的最小化问题,可分为线性可分,线性支持,非线性支持。不可分可用和技巧。

函数间隔:分类预测的正确性及确信度,除以范数变为几何间隔,

SVM学习的基本思路是求解能够正确划分训练集并且使几何间隔最大的分离超平面。在决定分离超平面时,只有SV起作用,,引入对偶问题往往更容易求解,其次可以推广到非线性分类问题。

线性不可分时,即不能满足函数间隔大于等于1,可引入松弛变量,软间隔最大,

引入核函数,将原空间变换映射到新空间,多项式,高斯核,

SMO:序列最小最优化算法。针对2个变量构建一个二次规划问题,不断分解为子问题并对子问题求解,包括求解2个变量二次规划问题及选择变量的启发式方法。选择第1个变量的过程是外层循环,寻找违反KKt条件最严重的点,第2个变量是内层循环,标准是能使这个变量有较大变化。每一次只学习基函数及系数。

Adaboost:提高被前一轮分类器错误分类样本的权值,降低正确分类的权值,加法模型,损失函数为指数函数,不用知道下界,采用前向分布算法。

提升树:平方损失(求导后,拟合残差了),指数损失,一般损失(不好优化计算)->

梯度提升树:最速下降法拟合残差的近似值,计算负梯度,拟合一个回归树。

EM:用于求解含有隐变量的概率模型参数的极大似然估计,或积大后验概率估计。Jenson不等式,求中点再log更大!

HMM:可用于标注问题的统计学习模型,描述由隐藏的马尔可夫链随机生成不可观测的状态随机序列,

再由各个状态生成一个观测从而产生观测随机序列的过程,属于生成模型,是关于时序的概率模型。由初始概率分布,状态转移概率分布,观测概率分布决定,状态转移概率矩阵和初始的概率向量确定了隐藏的morkv连,生成不可观测的状态序列,观测矩阵确定了如何从状态生成观测,与状态序列综合确定了如何产生观测序列。

作了两个假设:1齐次马尔可夫假设:隐层的马尔可夫链在任意时刻只依赖与其前一时刻的状态,与其他时刻的状态无关,也与t时刻无关。2观测独立性假设:任意时刻的观测只依赖于该时刻的morkov链的状态,与其他观测及状态无关。

HMM3个基本问题:

1.概率计算问题:给定模型和观测序列,求在模型下观测序列O出现的概率。直接计算1求状态序列概率,2求对固定的状态序列下观测的概率,3求状态序列和观测序列同时出现的联合概率,4对所有可能的状态序列求和。O(TN^T)掷出1,6,8的概率。

前向与后向算法:减小计算量的原因在于每一次计算直接引用前一个时刻的计算结果,避免重复计算。高效的关键是局部计算前向概率,利用路径结构将前向概率递推到全局。

2.学习问题:给定观测序列,估计模型参数,使得该模型下观测序列概率最大,即用极大似然概率方法估计参数。EM求隐变量。哪种筛子掷出的概率最大

3.预测问题(解码问题):已知模型和观测序列,求对给定观测序列条件概率P(I/O)最大的状态序列I。即给定观测序列,求最有可能的对应的状态序列。近似算法与维特比算法。反推出每种骰子是什么。

维特比:DP解HMM预测问题,基用动态规划求概率最大路径问题(最优路径),一条路径对应着一个状态序列。

CRF:给定一组输入随机变量条件下另一组输出随机变量的条件概率分布模型,其特点是假设输出随机变量构成morkov随机场(概率无向图模型),由输入到输出的判别模型,形式为对数线性模型。学习方法通常是极大似然估计或正则化的极大似然估计。直接求条件概率分布的模型故为判别,使用特征函数更加抽象表达特征f(X,i,yi,yi-1)

成对morkov性:随机变量组条件下,随机变量Yu和Yv是独立的。

局部morkov:

全局morkov:

如果满足3个性质,即为概率无向图模型。

将概率无向图的联合概率分布表示为其最大团上的随机变量的函数的乘机形式的操作即为因子分解。

CRF预测问题:求非规划化概率最大的最有路径问题,不求和只需记录Max值和位置,根据最后节点向前回溯选取最佳路径。中途只保留最短路径。

CRF可看成是序列化的LR,都是判别式,LR不是用分类条件估计w,而是用了sum(wixi)近似估计,若将ak替换成f,则与crf一样!

如何从CRF到HMM?对于每个转移概率p(ti/ti-1),定义f(x,i,yi,yi-1)=1,yi=ti,yi-1=ti-1,权重为logp(ti=yi/ti-1=yi-1),对于每个f,同样操作就可以得到HMM!

闵可夫斯基距离:p=2欧式,p=1曼哈顿,p=无穷切比雪夫,

马哈拉诺比斯距离:距离越大,相似越小,

皮尔逊相关系数与余弦距离,修正后的余弦距离。皮与修在于中心化方式不同。

奇异值分解SVD:mxn=m阶正交矩阵、由降序排列的对角元素组成的mxn矩形对角矩阵、n阶正交矩阵。矩阵的奇异值分解一定存在,但不唯一,几何解释是可分解为三个简单的变换:一个坐标系的旋转或反射VT、一个坐标轴的缩放sum、另一个坐标系的旋转或反射U。可看作是矩阵压缩的一种方法。即用因子分解近似表示原始矩阵,是在平方损失意义下的最优U近似。正交矩阵同转置相乘为单位矩阵。紧奇异值分解为无损压缩,截断奇异值分解为有损压缩。U的列为左奇异,V的列为右奇异向量。

PCA:利用正交变换把线性相关变量表示的 观测数据转换为少数几个线性无关变量表示的数据,线性无关的变量为主成分,属于降维方法。

LSA潜在语义分析:无监督学习,通过矩阵分解发现文本与单词之间基于话题的语义关系。传统方法以单词向量表示文本语义内容,以单词向量空间度量表示文本之间的相似度。LSA采用了非概率的话题分析模型,将文本集合表示为单词-文本矩阵,对单词-文本矩阵进行SVD分解,从而得到划题空间,以及文本在话题向量空间的表示。

NMF非负矩阵分解:分解的矩阵非负,也用于话题分析。

PLSA:概率潜在语义分析:

LDA潜在狄利克雷分配:作为bayes学习的话题模型,是LSA,PLSA的扩展。lda的预测一个文档是输出的主题-文档的概率向量,就是说这个文档属于各个主题的概率向量。每个主题的含义是由你训练过程中得到的主题-词分布决定。比如预测一个文档的输出是(0.25,0.75),就是说这个文档中的内容25%属于第一个主题,75%属于第二个主题。每一个主题的具体含义就看主题-词分布中概率排的靠前的一些词语,大致是这样,预测过程是认为训练得到的主题-词分布不变,这个输出其实就是新文档对应于各个主题的采样概率。用最大似然计算出来的。输出的数字就是新样本在该主题分布下的概率,比如第一个主题数字为0.5,那么新样本内容在该主题下的概率就是百分之50。

AdaBoosting

总之,AdaBoost的主要思想就是在不改变训练数据的情况下,通过在迭代训练弱学习器中,不断提升被错分类样本的权重(也就是使被错分的样本在下一轮训练时得到更多的重视),不断减少正确分类样本的权重。最后通过加权线性组合M个弱分类器得到最终的分类器,正确率越高的弱分类器的投票权数越高,正确率低的弱分类器自然投票权数就低。集成学习,(就我目前所学习到的)主要可以分为三大类,Boosting, Bagging, Stacking。Boosting的代表有AdaBoost, gbdt, xgboost。而Bagging的代表则是随机森林 (Random Forest)。Stacking 的话,好像还没有著名的代表,可以视其为一种集成的套路。

Boosting

首先,Boosting是一个迭代提升的过程,所以它肯定是串行的算法(尽管xgboost可以在节点分裂属性选择上做并行计算)。基于训练集,先训练弱学习器,然后根据前一个弱学习器分错的样本,改变样本的概率分布构成新的训练集,从而可以训练出一个更强的学习器。这样反复迭代提升,就能得到一系列分类器。最后,将这些分类器组合起来,就能构成一个很强的学习器。

AdaBoost

给定一个二分类的训练数据集

T={(x1,y1),…,(xN,yN)}

其中,x_i 是n维的, 类标y_i={-1,+1}

AdaBoost算法的步骤:

(1) 初始化训练数据的权值分布:D1=(w11,…,wi1,…,w1N),w1i=1/N,i=1,2,…,N(即初始时,每个样本视为一样的)

(2) 对m=1,2,…,M

(2a) 对具有权值分布Dm的训练数据集学习,得到一个基本分类器Gm(x)

(2b) 计算Gm(x)在训练数据集上的分类错误率:em=P(Gm(xi)!=yi)

(2c) 根据分类错误率计算Gm(x)的加权系数:am

(2d) 根据加权系数更新训练数据集的权值分布Dm+1

(3)以上学到了M个“弱”学习器,将这M个弱学习器加权求和:f(x)=sum(am*Gm(x)),最终的分类器为G(x)=sign(f(x))

总之,AdaBoost的主要思想就是在不改变训练数据的情况下,通过在迭代训练弱学习器中,不断提升被错分类样本的权重(也就是使被错分的样本在下一轮训练时得到更多的重视),不断减少正确分类样本的权重。最后通过加权线性组合M个弱分类器得到最终的分类器,正确率越高的弱分类器的投票权数越高,正确率低的弱分类器自然投票权数就低。

GBDT

GBDT的基本原理是boosting里面的 boosting tree(提升树),并使用gradient boost。GBDT中的树都是回归树,不是分类树 ,因为gradient boost 需要按照损失函数的梯度近似的拟合残差,这样拟合的是连续数值,因此只有回归树。Gradient Boosting是一种Boosting的方法,其与传统的Boosting的区别是,每一次的计算是为了减少上一次的残差(residual),而为了消除残差,可以在残差减少的梯度(Gradient)方向上建立一个新的模型。所以说,在Gradient Boosting中,每个新的模型的建立是为了使得之前模型的残差往梯度方向减少,与传统Boosting对正确、错误样本进行加权有着很大的区别。这个梯度代表上一轮学习器损失函数对预测值求导。与Boosting Tree的区别:Boosting Tree的适合于损失函数为平方损失或者指数损失。而Gradient Boosting适合各类损失函数(损失函数为:平方损失则相当于Boosting Tree拟合残差、损失函数为:使用指数损失则可以近似于Adaboost,但树是回归树)

下面是完整的GBDT介绍。

GBDT(Gradient Boosting Decision Tree) 又叫 MART(Multiple Additive Regression Tree),是一种迭代的决策树算法,该算法由多棵决策树组成,所有树的结论累加起来做最终答案。它在被提出之初就和SVM一起被认为是泛化能力较强的算法。**GBDT中的树是回归树(不是分类树),GBDT用来做回归预测,调整后也可以用于分类。**GBDT的思想使其具有天然优势可以发现多种有区分性的特征以及特征组合。

REGRESSION DECISION TREE:回归树

回归树总体流程类似于分类树,区别在于,回归树的每一个节点都会得一个预测值,以年龄为例,该预测值等于属于这个节点的所有人年龄的平均值。分枝时穷举每一个feature的每个阈值找最好的分割点,但衡量最好的标准不再是最大熵,而是最小化平方误差。也就是被预测出错的人数越多,错的越离谱,平方误差就越大,通过最小化平方误差能够找到最可靠的分枝依据。分枝直到每个叶子节点上人的年龄都唯一或者达到预设的终止条件(如叶子个数上限),若最终叶子节点上人的年龄不唯一,则以该节点上所有人的平均年龄做为该叶子节点的预测年龄。

回归树算法如下图(截图来自《统计学习方法》5.5.1 CART生成):

请注意上图中的下标和上标,xixi表示第i个样本,x(j)x(j)表示该样本的第j个feature。所以上图中的遍历划分变量j的意思是遍历feature和相应的s,找出使平方误差和最小的(j,s)。

BOOSTING DECISION TREE:提升树算法

提升树是迭代多棵回归树来共同决策。当采用平方误差损失函数时,每一棵回归树学习的是之前所有树的结论和残差,拟合得到一个当前的残差回归树,残差的意义如公式:残差 = 真实值 - 预测值 。提升树即是整个迭代过程生成的回归树的累加。

举个例子,参考自一篇博客(参考文献 4),该博客举出的例子较直观地展现出多棵决策树线性求和过程以及残差的意义。

训练一个提升树模型来预测年龄:

训练集是4个人,A,B,C,D年龄分别是14,16,24,26。样本中有购物金额、上网时长、经常到百度知道提问等特征。提升树的过程如下:

该例子很直观的能看到,预测值等于所有树值得累加,如A的预测值 = 树1左节点 值 15 + 树2左节点 -1 = 14。

因此,给定当前模型 fm-1(x),只需要简单的拟合当前模型的残差。现将回归问题的提升树算法叙述如下:

GRADIENT BOOSTING DECISION TREE:梯度提升决策树

提升树利用加法模型和前向分步算法实现学习的优化过程。当损失函数是平方损失和指数损失函数时,每一步的优化很简单,如平方损失函数学习残差回归树。

但对于一般的损失函数,往往每一步优化没那么容易,如上图中的绝对值损失函数和Huber损失函数。针对这一问题,Freidman提出了梯度提升算法:利用最速下降的近似方法,即利用损失函数的负梯度在当前模型的值,作为回归问题中提升树算法的残差的近似值,拟合一个回归树。(注:鄙人私以为,与其说负梯度作为残差的近似值,不如说残差是负梯度的一种特例)算法如下(截图来自《The Elements of Statistical Learning》):

xgboost

xgboost类似于gbdt,但是很多地方经过了Tianqi Chen大牛的优化,因此不论是精度还是效率上都有了提升。与gbdt相比,具体的优点有:

1.损失函数是用泰勒展式二项逼近,而不是像gbdt里就是一阶导数

2.对树的结构进行了正则化约束,防止模型过度复杂,降低了过拟合的可能性

3.节点分裂的方式不同,gbdt是用的gini系数,xgboost是经过优化推导后的

xgboost是GB算法的高效实现,xgboost中的基学习器除了可以是CART(gbtree)也可以是线性分类器(gblinear)。下面所有的内容来自原始paper,包括公式。

(1) xgboost在目标函数中显示的**加上了正则化项,**基学习器为CART时,正则化项与树的叶子节点的数量T和叶子节点的值有关。

(2) GB中使用Loss Function对f(x)的一阶导数计算出伪残差用于学习生成fm(x),xgboost不仅使用到了一阶导数,还使用二阶导数。第t次的loss:

对上式做二阶泰勒展开:

(3) 上面提到CART回归树中寻找最佳分割点的衡量标准是最小化均方差,xgboost寻找分割点的标准是最大化Lsplit

xgboost算法的步骤和GB基本相同,都是首先初始化为一个常数,gb是根据一阶导数ri,xgboost是根据一阶导数gi和二阶导数hi,迭代生成基学习器,相加更新学习器。

xgboost与gdbt除了上述三点的不同,xgboost在实现时还做了许多优化:

- 在寻找最佳分割点时,考虑传统的枚举每个特征的所有可能分割点的贪心法效率太低,xgboost实现了一种近似的算法。大致的思想是根据百分位法列举几个可能成为分割点的候选者,然后从候选者中根据上面求分割点的公式计算找出最佳的分割点。

- xgboost考虑了训练数据为稀疏值的情况,可**以为缺失值或者指定的值指定分支的默认方向,**这能大大提升算法的效率,paper提到50倍。

- xgboost借鉴了随机森林中的列(特征)采样技术,即在某个节点分裂时,不是在当前节点中所有属性中选取最佳分裂属性,**而是在当前属性集合中的某些属性中来选择最优分裂属性。**这种方法降低了过拟合的可能性。

- 特征列排序后以块的形式存储在内存中,在迭代中可以重复使用;虽然boosting算法迭代必须串行,但是在处理每个特征列时可以做到并行。

- 按照特征列方式存储能优化寻找最佳的分割点,但是当以行计算梯度数据时会导致内存的不连续访问,严重时会导致cache miss,降低算法效率。paper中提到,可先将数据收集到线程内部的buffer,然后再计算,提高算法的效率。

- xgboost还考虑了当数据量比较大,内存不够时怎么有效的使用磁盘,主要是结合多线程、数据压缩、分片的方法,尽可能的提高算法的效率。

知乎上关于xgboost/gbdt讨论的经典问答

【问】xgboost/gbdt在调参时为什么树的深度很少就能达到很高的精度?

用xgboost/gbdt在在调参的时候把树的最大深度调成6就有很高的精度了。但是用DecisionTree/RandomForest的时候需要把树的深度调到15或更高。用RandomForest所需要的树的深度和DecisionTree一样我能理解,因为它是用bagging的方法把DecisionTree组合在一起,相当于做了多次DecisionTree一样。但是xgboost/gbdt仅仅用梯度上升法就能用6个节点的深度达到很高的预测精度,使我惊讶到怀疑它是黑科技了。请问下xgboost/gbdt是怎么做到的?它的节点和一般的DecisionTree不同吗?

【答】

这是一个非常好的问题,题主对各算法的学习非常细致透彻,问的问题也关系到这两个算法的本质。这个问题其实并不是一个很简单的问题,我尝试用我浅薄的机器学习知识对这个问题进行回答。

一句话的解释,来自周志华老师的机器学习教科书( 机器学习-周志华):Boosting主要关注降低偏差,因此Boosting能基于泛化性能相当弱的学习器构建出很强的集成;Bagging主要关注降低方差,因此它在不剪枝的决策树、神经网络等学习器上效用更为明显。

随机森林(random forest)和GBDT都是属于集成学习(ensemble learning)的范畴。集成学习下有两个重要的策略Bagging和Boosting。

Bagging算法是这样做的:**每个分类器都随机从原样本中做有放回的采样,然后分别在这些采样后的样本上训练分类器,然后再把这些分类器组合起来。****简单的多数投票一般就可以。**其代表算法是随机森林。Boosting的意思是这样,他通过迭代地训练一系列的分类器,**每个分类器采用的样本分布都和上一轮的学习结果有关。**其代表算法是AdaBoost, GBDT。

其实就机器学习算法来说,其泛化误差可以分解为两部分,偏差(bias)和方差(variance)。这个可由下图的式子导出(这里用到了概率论公式D(X)=E(X2)-[E(X)]2)。偏差指的是算法的期望预测与真实预测之间的偏差程度,反应了模型本身的拟合能力;方差度量了同等大小的训练集的变动导致学习性能的变化,刻画了数据扰动所导致的影响。这个有点儿绕,不过你一定知道过拟合。

如下图所示,当模型越复杂时,拟合的程度就越高,模型的训练偏差就越小。但此时如果换一组数据可能模型的变化就会很大,即模型的方差很大。所以模型过于复杂的时候会导致过拟合。

当模型越简单时,即使我们再换一组数据,最后得出的学习器和之前的学习器的差别就不那么大,模型的方差很小。还是因为模型简单,所以偏差会很大。

也就是说,当我们训练一个模型时,偏差和方差都得照顾到,漏掉一个都不行。

对于Bagging算法来说,由于我们会并行地训练很多不同的分类器的目的就是降低这个方差(variance) ,因为采用了相互独立的基分类器多了以后,h的值自然就会靠近.所以对于每个基分类器来说,目标就是如何降低这个偏差(bias),所以我们会采用深度很深甚至不剪枝的决策树。

对于Boosting来说,每一步我们都会在上一轮的基础上更加拟合原数据,所以可以保证偏差(bias),所以对于每个基分类器来说,问题就在于如何选择variance更小的分类器,即更简单的分类器,所以我们选择了深度很浅的决策树。

【问】机器学习算法中GBDT和XGBOOST的区别有哪些?

【答】

传统GBDT以CART作为基分类器,xgboost还支持线性分类器,这个时候xgboost相当于带L1和L2正则化项的逻辑斯蒂回归(分类问题)或者线性回归(回归问题)。

传统GBDT在优化时只用到一阶导数信息,xgboost则对代价函数进行了二阶泰勒展开,同时用到了一阶和二阶导数。顺便提一下,xgboost工具支持自定义代价函数,只要函数可一阶和二阶求导。

xgboost在代价函数里加入了正则项,用于控制模型的复杂度。正则项里包含了树的叶子节点个数、每个叶子节点上输出的score的L2模的平方和。从Bias-variance tradeoff角度来讲,正则项降低了模型的variance,使学习出来的模型更加简单,防止过拟合,这也是xgboost优于传统GBDT的一个特性。

Shrinkage(缩减),相当于学习速率(xgboost中的eta)。xgboost在进行完一次迭代后,会将叶子节点的权重乘上该系数,主要是为了削弱每棵树的影响,让后面有更大的学习空间。实际应用中,一般把eta设置得小一点,然后迭代次数设置得大一点。(补充:传统GBDT的实现也有学习速率)

列抽样(column subsampling)即特征抽样。xgboost借鉴了随机森林的做法,支持列抽样,不仅能降低过拟合,还能减少计算,这也是xgboost异于传统gbdt的一个特性。

对缺失值的处理。对于特征的值有缺失的样本,xgboost可以自动学习出它的分裂方向。

xgboost工具支持并行。boosting不是一种串行的结构吗?怎么并行的?注意xgboost的并行不是tree粒度的并行,xgboost也是一次迭代完才能进行下一次迭代的(第t次迭代的代价函数里包含了前面t-1次迭代的预测值)。xgboost的并行是在特征粒度上的。我们知道,决策树的学习最耗时的一个步骤就是对特征的值进行排序(因为要确定最佳分割点),xgboost在训练之前,预先对数据进行了排序,然后保存为block结构,后面的迭代中重复地使用这个结构,大大减小计算量。这个block结构也使得并行成为了可能,在进行节点的分裂时,需要计算每个特征的增益,最终选增益最大的那个特征去做分裂,那么各个特征的增益计算就可以开多线程进行。

可并行的近似直方图算法。树节点在进行分裂时,我们需要计算每个特征的每个分割点对应的增益,即用贪心法枚举所有可能的分割点。当数据无法一次载入内存或者在分布式情况下,贪心算法效率就会变得很低,所以xgboost还提出了一种可并行的近似直方图算法,用于高效地生成候选的分割点。

多种语言封装支持。

【问】为什么基于 tree-ensemble 的机器学习方法,在实际的 kaggle 比赛中效果非常好?

【答】

通常,解释一个机器学习模型的表现是一件很复杂事情,而这篇文章尽可能用最直观的方式来解释这一问题。我主要从三个方面来回答楼主这个问题。

- 理论模型 (站在 vc-dimension 的角度)

- 实际数据

- 系统的实现 (主要基于 xgboost)

通常决定一个机器学习模型能不能取得好的效果,以上三个方面的因素缺一不可。

(1)站在理论模型的角度统计机器学习里经典的 vc-dimension 理论告诉我们:一个机器学习模型想要取得好的效果,这个模型需要满足以下两个条件:

- 模型在我们的训练数据上的表现要不错,也就是 trainning error 要足够小。

- 模型的 vc-dimension 要低。换句话说,就是模型的自由度不能太大,以防overfit.当然,这是我用大白话描述出来的,真正的 vc-dimension 理论需要经过复杂的数学推导,推出 vc-bound. vc-dimension 理论其实是从另一个角度刻画了一个我们所熟知的概念,那就是 bias variance trade-off.

好,现在开始让我们想象一个机器学习任务。对于这个任务,一定会有一个 “上帝函数” 可以完美的拟合所有数据(包括训练数据,以及未知的测试数据)。很可惜,这个函数我们肯定是不知道的 (不然就不需要机器学习了)。我们只可能选择一个 “假想函数” 来 逼近 这个 “上帝函数”,我们通常把这个 “假想函数” 叫做 hypothesis.

在这些 hypothesis 里,我们可以选择 svm, 也可以选择 logistic regression. 可以选择单棵决策树,也可以选择 tree-ensemble (gbdt, random forest). 现在的问题就是,为什么 tree-ensemble 在实际中的效果很好呢?

区别就在于 “模型的可控性”。

先说结论,tree-ensemble 这样的模型的可控性是好的,而像 LR 这样的模型的可控性是不够好的(或者说,可控性是没有 tree-ensemble 好的)。为什么会这样?别急,听我慢慢道来。

我们之前说,当我们选择一个 hypothsis 后,就需要在训练数据上进行训练,从而逼近我们的 “上帝函数”。我们都知道,对于 LR 这样的模型。如果 underfit,我们可以通过加 feature,或者通过高次的特征转换来使得我们的模型在训练数据上取得足够高的正确率。而对于 tree-enseble 来说,我们解决这一问题的方法是通过训练更多的 “弱弱” 的 tree. 所以,这两类模型都可以把 training error 做的足够低,也就是说模型的表达能力都是足够的。但是这样就完事了吗?没有,我们还需要让我们的模型的 vc-dimension 低一些。而这里,重点来了。在 tree-ensemble 模型中,通过加 tree 的方式,对于模型的 vc-dimension 的改变是比较小的。而在 LR 中,初始的维数设定,或者说特征的高次转换对于 vc-dimension 的影响都是更大的。换句话说,tree-ensemble 总是用一些 “弱弱” 的树联合起来去逼近 “上帝函数”,一次一小步,总能拟合的比较好。而对于 LR 这样的模型,我们很难去猜到这个“上帝函数”到底长什么样子(到底是2次函数还是3次函数?上帝函数如果是介于2次和3次之间怎么办呢?)。所以,一不小心我们设定的多项式维数高了,模型就 “刹不住车了”。俗话说的好,步子大了,总会扯着蛋。这也就是我们之前说的,tree-ensemble 模型的可控性更好,也即更不容易 overfit.

(2)站在数据的角度

除了理论模型之外, 实际的数据也对我们的算法最终能取得好的效果息息相关。kaggle 比赛选择的都是真实世界中的问题。所以数据多多少少都是有噪音的。而基于树的算法通常抗噪能力更强。比如在树模型中,我们很容易对缺失值进行处理。除此之外,基于树的模型对于 categorical feature 也更加友好。

除了数据噪音之外,feature 的多样性也是 tree-ensemble 模型能够取得更好效果的原因之一。通常在一个kaggle任务中,我们可能有年龄特征,收入特征,性别特征等等从不同 channel 获得的特征。而特征的多样性也正是为什么工业界很少去使用 svm 的一个重要原因之一,因为 svm 本质上是属于一个几何模型,这个模型需要去定义 instance 之间的 kernel 或者 similarity (对于linear svm 来说,这个similarity 就是内积)。这其实和我们在之前说过的问题是相似的,我们无法预先设定一个很好的similarity。这样的数学模型使得 svm 更适合去处理 “同性质”的特征,例如图像特征提取中的 lbp 。而从不同 channel 中来的 feature 则更适合 tree-based model, 这些模型对数据的 distributation 通常并不敏感。

(3)站在系统实现的角度

除了有合适的模型和数据,一个良好的机器学习系统实现往往也是算法最终能否取得好的效果的关键。一个好的机器学习系统实现应该具备以下特征:

- 正确高效的实现某种模型。我真的见过有些机器学习的库实现某种算法是错误的。而高效的实现意味着可以快速验证不同的模型和参数。

- 系统具有灵活、深度的定制功能。

- 系统简单易用。

- 系统具有可扩展性, 可以从容处理更大的数据。

到目前为止,xgboost 是我发现的唯一一个能够很好的满足上述所有要求的 machine learning package. 在此感谢青年才俊 陈天奇。

在效率方面,xgboost 高效的 c++ 实现能够通常能够比其它机器学习库更快的完成训练任务。

在灵活性方面,xgboost 可以深度定制每一个子分类器,并且可以灵活的选择 loss function(logistic,linear,softmax 等等)。除此之外,xgboost还提供了一系列在机器学习比赛中十分有用的功能,例如 early-stop, cv 等等在易用性方面,xgboost 提供了各种语言的封装,使得不同语言的用户都可以使用这个优秀的系统。

最后,在可扩展性方面,xgboost 提供了分布式训练(底层采用 rabit 接口),并且其分布式版本可以跑在各种平台之上,例如 mpi, yarn, spark 等等。

有了这么多优秀的特性,自然这个系统会吸引更多的人去使用它来参加 kaggle 比赛。

综上所述,理论模型,实际的数据,良好的系统实现,都是使得 tree-ensemble 在实际的 kaggle 比赛中“屡战屡胜”的原因。

Bagging

Bagging的代表算法是随机森林,简单说下随机森林的步骤:

(1) 对训练样本进行bootstrap自助法采样,即有放回的采样,获得M个采样集合;

(2) 在这M个采样集合上训练处M个弱决策树。注意到,在决策树生成中还用到了列采样的技巧,原本决策树中节点分裂时,是选择当前节点中所有属性的最优属性进行划分的,但是列采样的技巧是在所有属性中的子集中选最优属性进行划分。这样做可以进一步降低过拟合的可能性;

(3) 对这M个训练出来的弱决策树进行集成。

Stacking

Stacking还没有代表性的算法,我姑且把它理解成一个集成的思想吧。具体做法是:

(1) 先将训练集D拆成k个大小相似但互不相交的子集D1,D2,…,Dk;

(2) 令Dj’= D - Dj,在Dj’上训练一个弱学习器Lj。将Dj作为测试集,获得Lj在Dj上的输出Dj’’;

(3) 步骤2可以得到k个弱学习器以及k个相应的输出Dj’’,这个k个输出加上原本的类标构成新的训练集Dn;

(4) 在Dn训练次学习器L,L即为最后的学习器。

以上Stacking只做了一层,据kaggle上的大神反馈,Stacking可以做好多层,会有神奇的效果。

下面给出kaggle中一个Stacking的实例,就是入门级的titanic那道题单层stacking的源码(只给出了stacking 的过程,前面特征工程处理的代码被省略掉了)。Stacking后的xgboost(得分:0.77990)比我之前只用xgboost时(得分:0.77512)提高了一点,排名上升了396…… 源码戳这

Log on 2017-6-22: Stacking了两次之后,得分从单次stacking的0.77990上升到了0.79904

Log on 2017-6-22: Stacking了三次之后,得分从两次stacking的0.77990降低到了0.78469。所以,Stacking并不是越多层越好,反而会变坏。

一个良好的自我介绍究竟如何准备呢。

其实,好的自我介绍和一个吸引人的演讲是一样的,需要关注的永远是听众更想听什么,然后把你想说的东西用听众喜欢的方式表达出来。那么对于面试的自我介绍而言,我们需要关注的就应当是面试官想要招一个什么样的员工,然后对应的去组织自己的语言。所以,一般一个好的自我介绍的核心内容往往就是三段式:

1.首先,面试官招聘的很有可能以后就是他的同事,所以他一定希望面试者是一个有趣的人。毕竟谁愿意整天面对着一个面瘫脸工作呢,因此自我介绍里面一定要有能体现自己性格开朗,沟通能力等软实力方面的内容。但是严防出现大段这类话的形况,防止喧宾夺主,毕竟人家招的还是技术岗,技术最重要。

2.和其他行业不同,IT届的技术岗非常重视你的技术实力,因此自我介绍中用简V

3.计算机技术日新月异,迭代的速度完全不是其他任何行业可以比拟的。因此工作的时候需要不断地学习新知识,否则根本无法适应不断提升地业务需要。所以面试官希望的面试者还是一个对于技术、新鲜事物有强烈好奇心的骚年。

但需要这三段,并不是说只要包含这三个内容就足够了。表达的方法也很重要,不能像第二种类型一样,只是干瘪的介绍。每一个论述都需要有论点的支撑,最好的方法就是每个你想介绍的方面都选取你的经历中最典型的,能表现这一方面的用几句话概括起来,然后加上所以我觉得沟通能力还不错之类的总结。这样才能让自我介绍更加丰满,让面试官感觉好像听故事一样。

同时,自我介绍的时候语气也非常重要!!首先全程一定要用中气十足的语气,让人觉得你很有自信,千万千万不要蔫儿蔫儿的。对于不同的内容,要注意情绪的转换,比如说自己幽默、性格开朗的时候,你就需要用一种积极向上的,话里都带着笑得语气表达出来**,千万不要像白开水水一样让人感觉你在背书**。否则,你的内容准备得再好也没有半毛钱用处。

简历应该是怎么样的

简历虽然只是求职的第一步,但如果连第一步都跨不过去,那么更别谈什么面试的技巧。面试不同的岗位都影响简历的撰写,像我这样面试技术岗的,简历还是需要简洁一点,可以走性冷淡风,不要太多的废话。面试技术岗简历上所有的文字都是应该体现你在这个岗位之间的优势,其他所有东西都不能提高你面试的成功率,哪怕你获得的是全国劳动模范。

如果是找实习岗位的话,简历应该以项目经历为主,选择三个最能体现自己能力的项目即可。每一个项目都应该写明项目的过程,自己参与的工作,以及从中的收获。对于不利于自己求职但又不得不写上去的信息,应该尽可能地使他不那么显眼,比如跨专业工作,原来的专业名字不要那么显眼。

另外简历项目可以写多,但是每个项目中的具体到技术的模块不要写多,只写几个自己最熟悉的,比如自己到那几个算法,就不要把所有的算法都写上去,人家首先问的就是你简历上的东西。

面试应该如何准备呢

首先我先声明,面试绝对是要准备的,不管是面试实习还是面试校招社招岗位,面试都是需要至少好几天的准备。如果你想裸面,除非你真的很牛逼,不然肯定会尝到痛苦的,以为找个实习就可以裸面,能学到东西越多的岗位,进这个岗位实习的难度就越大。

面试前至少你要保证,简历上的每一个你都知道他的全部内容,同时要针对简历上的每一个点刷大量的面试题,有时候面试就是这样。感觉面试官聊到自己擅长的地方了,但是一问问题都不会,感觉全会,一问全不会,这就要求一定要去刷面试题。比如在简历上写了SVM,那就要知道svm的原理,svm的各个参数,svm用来解决什么问题,svm有什么优缺点,用svm做过什么东西等等。简历上的东西真的不是写写上去就好了,简历写的多随意,面试就有多难堪。个人认为简历上的每一个点的相对应的知识都应该打印好几张纸,在面试之前好好看好好背诵。

关于项目经历,刚才说到项目经历,每一个写在简历上的项目经历都应该了然于心。有几个要求:

1.必须流畅地讲述出整个项目的过程,项目过程中的每一个环节都应该仔细地去回顾

2.在项目进行的过程中,遇到了哪些困难,又是怎么解决的,每一个项目都应该提前想好

写文章以自勉,在背后越努力,才能在人前表现地越轻松,我觉得面试也是这样的,暂时就先写到这里了,下次更多的面试经历再补充。

优质的岗位:适合自己的才是优质的岗位

招聘企业信息:企业的官方微信、官网,或者在领英上问一下

岗位如何鉴定含金量:还是适合自己的还是最重要,给钱多的不一定含金量高,但含金量高的钱一定不会少,小公司是否有试错的机会,大公司是否有完善的培养机制,要么干的更久,要么干的稀缺性,要么能提升你的能力。

岗位怎么样:可以上看准网,应届生,职业圈、职友集。

工作经验太少,简历不会写:工作经历是直观证明能力的证据,但能力的证明并不止实习经历。找证明自己能力的经历,做过什么项目,学术经历,项目经历。

比如行业分析师,平时多写行业报告,可以在网上放上去,然后简历上附上链接

怎么匹配自己的岗位:兴趣,性格、能力(胜任不胜任)、价值观

了解行业世界:行业、职能、企业、地域

做决策:决策平衡单、决策模式(元认知&自我觉察)

了解企业:前生,历史发展、主营业务、竞争对手、组织框架、用波特五例分析以下

专业不对口怎么办:专业对口率本来就很低,只要不说xx优先,那就是有硬性要求。

数据分析:jd差的特别远,数据库、会R语言、会python,岗位对技术的能力要求是不一样的

如果是凭兴趣找工作,入职当天就是离职倒计时

双非院校怎么提升竞争力,我比的是和自己差不多的人,只要比身边的人强一点。旁边的人都在海投,那我就不海投,求职目标比别人明确,对公司的了解和对行业的了解都比别人深刻,笔试多比别人准备,能力不够动机来凑。表现的很喜欢这家公司,这个行业。

社招没有好岗位,如果想正儿八经的工作,老老实实参加校招。

聪明的学生是不参加校招的,早就在秋招前找好工作了。

面试:需要看到大家的思维的质量,过往经历是什么,面试的岗位和过往经历的关系,主动去说大学期间做了什么,比如卖盆的故事,我做过的事情是有分析的,我知道怎么把事情做好。

思维质量,事情如何去分析,如何去选。

我的优势是什么,我的劣势是什么

未来的规划一定要清楚,我要实现什么,我要通过如何去实现自己的目标,我的目标是非常清晰的,我是有行动计划的,一定是切实可行的,太遥远的不必要说。

项目介绍

那对于一个项目该如何进行面试前的准备呢?同样,对于这个问题,仍旧需要先站在面试官的角度,思考面试官想要从和你交流项目的过程中知道什么。还是那句话,面试官需要招聘的是基础知识扎实、有能力解决问题的、富有创造性的、同时又有一定沟通能力的人。因此,接下来的准备过程中,都需要处处以能展现这几点为目的。面试官问项目的时候也往往遵循着一个套路:简单整体介绍项目,你的创新点是什么?项目中用到的某个网络或者某个技术你了解吗?这个项目你遇到了哪些困难、你是如何解决的?这个项目的评价标准是什么?最终达到什么样的性能?咋一看似乎这些问题不是很有规律可言,但其实就像拔萝卜的过程一样:

-

从宏观上认识萝卜。也就是你首先要用简短的语言,几句话将你的萝卜整体展现给面试官。一般这几句话我们往往会依照STAR法则去组织语言,即在什么背景(Situation)下,为了解决什么问题(Target),采取了什么方法(Action),最后达到了什么效果(Result).

-

把主体***。一般面试官会让你介绍你项目中所用到的网络,此时作为面试者就可以按照:为什么用这个网络,网络结构和特点是什么,训练和测试的差别等进行回答。例如我其中的一个项目用到了一个检测网络SSD,那我就会从速度要求引出one_stage和two_stage的区别,因此使用较快的SSD。然后介绍其网络结构和其全卷积、先验框、多尺度的特点,最后解释测试时NMS的处理等等。

-

把细小末梢一点点抽出来。只准备到能够将主体***的水平仍然不够,你需要做到的是对于其有可能会牵引出来的一切问题都尽可能准备的足够充分。例如,第二点所提到的目标检测,训练过程中如何区分正样本?既然提到了two stage,那么two stage 网络中的ROI-pooling 又是怎么回事?为了让准备的过程中更有逻辑性且考虑更加全面,可以画一棵树,树的主干是此项目所用的主要方法,分出的枝干是所有细节的技术,叶子又是细节技术所牵引出来的其他技术知识。一般也就是准备到两级问题就没基本可以了。如果面试官问到三级、四级。。。那这个面试官真是毫无人性啊,怼他!

-

对于拔萝卜的评价。评价问题就非常好准备了,主要为两类评价:

对方法的性能的评价,一般会问你用的评价指标是什么,达到什么水平。例如我的一个项目用到了灵敏度、特异性、AUC,基本所有面试官都问了我这些指标的含义,如何计算,以及的方法达到了什么程度。

在拔萝卜过程中的创新点有哪些,和现有的方法好在哪些方面。在这个过程中遇到了哪些困难,你是如何解决的。(此问题尤为重要!)

基本按着这四点进行准备,项目经历这一块就没什么问题了。当然,还需要重复的一点语气!语气!语气!重要的问题说三遍!同样的话,被不同人,用不同的语气说出来,说服力也完全不一样,哪怕你觉得你的项目就是个渣渣,其实没有任何创新型可言,效果也贼烂,但你在与面试官的交流过程中也一定要底气十足。你需要不停的催眠自己,我做的东西就是最棒的!这一点非常重要!

基础知识

算法面试过程中,还有的非常看重的一点就是对于基础知识的掌握。这些基础知识有可能是在项目经历的交流过程中在第二级问题的时候问,也可能在项目之外单独问,但这些问题其实说来说去也就那么点,无非是如何处理过拟合问题,BN是怎么回事?怎么去理解SVM和逻辑斯蒂回归的区别等等。这些只要花时间认真准备,对每一个问题准备的尽可能充分就妥妥的了。

那么。。。问题来了,想把这些问题都准备地很充分这得多久,时间来得及吗?答,还是挺费时的,对于一个问题如果仅仅简单的概述式的介绍给面试官,那基本是凉了的,那到底怎么样才算是准备的足够高充分了呢?简单举个栗子,面试官问你知道Batch Normalization吗?你需要这么回答:

BN的背景是什么(即为什么会提出这种方法)

BN的基本原理是什么,以理解的方式介绍大概步骤

训练和测试时的方差和均值选取的差别

BN的多卡同步又是怎么回事?

甚至,你可以进一步了解下,BN所针对的激活函数一般是sigmoid,可以将参数拉离饱和区,那么如果换成Relu的话,BN是否还有效呢?再进一步的话还可以了解下主流的规范化方法有哪些?(这种程度的问题就知道个名字就好了,不知道也没问题)。

如果你能对一个问题理解到这种程度,基本面试官只要不是压根看你不爽,基本都会觉得你很棒棒了。But! 这么准备下来,一个问题都得准备好久,岂不是根本来不及了?因此!要懂得借用集体的智慧,比如我就组织了我们实验室的五个小伙伴建立一个讨论小组,每天轮流三个人每个人准备一个问题,把问题准备到上面的那个地步,将自己组织好的问题答案共享到腾讯文档,然后每天晚上八点半大家一起讨论。这样还有一个好处就是一个人去理解一个问题的时候往往很容易陷入牛角尖,理解的也很容易片面,但大家一起讨论之后,基本就能很快豁然开朗了。这么准备起来,每天其实只要花很少的时间就可以在相对较短的时间内把这个环节准备的非常充分了。以下是我们讨论小组准备的材料部分预览,我们5个花了大约一个月的时间,共讨论了约70+的问题,约四万五千字的文档使我在面试过程中,基本没有遇到过没讨论过的问题。这些问题可以自己觉得重要的,或者去牛客网上找面经中的问题,同时也非常推荐《百面机器学习》这本书,我们的很多问题也是直接在这本书上找的。**Situation(情景)**对于酒店来说,顾客的在线评论非常重要,但目前酒店面对的一个主要问题就是网络上各渠道的点评过多,导致每天要来花费大量的时间来人工搜集并处理这些评论。而对于一些自差评或投诉,如果酒店无法及时看到并处理,那么这些评论将会在网络上形成非常不利的影响。说实话,酒店每天机械式的处理网络点评效果并不好,除了增加人工成本、无法实时关注信息外,还会导致错误概率的加大。

目前酒店都比较重视顾客点评管理和舆情监控这一块,因为现在的顾客都习惯在订酒店之前先查看点道评情况,就像网络购物一样查看商品的好评和差评。所以有很多酒店都很重视回复管理顾客点评,对网络舆情进行监控,一旦出现差评,及时回复处理,如果差评处理的越慢越晚,其内传播的面也越广,维护处理的成本就越高,对酒店的在线口碑伤害也就越大。

Task(任务):

Action(行动):训练:用了比较多的技巧:包括截断补齐,正则,数据增强10%,earl_stop,归一化,与之微调,40%的dorpout,动态学习率,

小技巧:mask英文一起遮挡,数字只需判断是num,或者扣掉,

Result(结果):auc93%

另外一件事:mean_max_pooling,一句话的数学表达,平均响应和最大响应,ebemding*2,映射成一个之进行sigmoid激活。

前景预测

在1998年微软亚洲研究院成立之初,NLP就被确定为最重要的研究领域之一。历经二十载春华秋实,在历届院长支持下,微软亚洲研究院在促进NLP的普及与发展以及人才培养方面取得了非凡的成就。共计发表了100余篇ACL大会文章,出版了《机器翻译》和《智能问答》两部著作,培养了500名实习生、20名博士和20名博士后。我们开发的NLP技术琳琅满目,包括输入法、分词、句法/语义分析、文摘、情感分析、问答、跨语言检索、机器翻译、知识图谱、聊天机器人、用户画像和推荐等,已经广泛应用于Windows、Office、Bing、微软认知服务、小冰、小娜等微软产品中。我们与创新技术组合作研发的微软对联和必应词典,已经为成千上万的用户提供服务。

过去二十年, NLP利用统计机器学习方法,基于大规模的带标注的数据进行端对端的学习,取得了长足的进步。尤其是过去三年来,深度学习给NLP带来了新的进步。其中在单句翻译、抽取式阅读理解、语法检查等任务上,更是达到了可比拟人类的水平。

基于如下的判断,我们认为未来十年是NLP发展的黄金档:

- 来自各个行业的文本大数据将会更好地采集、加工、入库。

- 来自搜索引擎、客服、商业智能、语音助手、翻译、教育、法律、金融等领域对NLP的需求会大幅度上升,对NLP质量也提出更高要求。

- 文本数据和语音、图像数据的多模态融合成为未来机器人的刚需。这些因素都会进一步促进对NLP的投资力度,吸引更多人士加入到NLP的研发中来。因此我们需要审时度势、抓住重点、及时规划,面向更大的突破。

因此,NLP研究将会向如下几个方面倾斜:

- 将知识和常识引入目前基于数据的学习系统中。

- 低资源的NLP任务的学习方法。

- 上下文建模、多轮语义理解。

- 基于语义分析、知识和常识的可解释NLP。

NLP的技术进展

自然语言处理,有时候也称作自然语言理解,旨在利用计算机分析自然语言语句和文本,抽取重要信息,进行检索、问答、自动翻译和文本生成。人工智能的目的是使得电脑能听、会说、理解语言、会思考、解决问题,甚至会创造。它包括运算智能、感知智能、认知智能和创造智能几个层次的技术。计算机在运算智能即记忆和计算的能力方面已远超人类。而感知智能则是电脑感知环境的能力,包括听觉、视觉和触觉等等,相当于人类的耳朵、眼睛和手。目前感知智能技术已取得飞跃性的进步;而认知智能包括自然语言理解、知识和推理,目前还待深入研究;创造智能目前尚无多少研究。比尔·盖茨曾说过, “自然语言理解是人工智能皇冠上的明珠”。NLP的进步将会推动人工智能整体进展。

NLP在深度学习的推动下,在很多领域都取得了很大进步。下面,我们就来一起简单看看NLP的重要技术进展。

神经机器翻译

神经机器翻译就是模拟人脑的翻译过程。

翻译任务就是把源语言句子转换成语义相同的目标语言句子。人脑在进行翻译的时候,首先是尝试理解这句话,然后在脑海里形成对这句话的语义表示,最后再把这个语义表示转化到另一种语言。神经机器翻译就是模拟人脑的翻译过程,它包含了两个模块:一个是编码器,负责将源语言句子压缩为语义空间中的一个向量表示,期望该向量包含源语言句子的主要语义信息;另一个是解码器,它基于编码器提供的语义向量,生成在语义上等价的目标语言句子。

神经机器翻译模型的优势在于三方面:一是端到端的训练,不再像统计机器翻译方法那样由多个子模型叠加而成,从而造成错误的传播;二是采用分布式的信息表示,能够自动学习多维度的翻译知识,避免人工特征的片面性;三是能够充分利用全局上下文信息来完成翻译,不再是局限于局部的短语信息。基于循环神经网络模型的机器翻译模型已经成为一种重要的基线系统,在此方法的基础上,从网络模型结构到模型训练方法等方面,都涌现出很多改进。

神经机器翻译系统的翻译质量在不断取得进步,人们一直在探索如何使得机器翻译达到人类的翻译水平。2018年,微软亚洲研究院与微软翻译产品团队合作开发的中英机器翻译系统,在WMT2017新闻领域测试数据集上的翻译质量达到了与人类专业翻译质量相媲美的水平(Hassan et al., 2018)。该系统融合了微软亚洲研究院提出的四种先进技术,其中包括可以高效利用大规模单语数据的联合训练和对偶学习技术,以及解决曝光偏差问题的一致性正则化技术和推敲网络技术。

智能人机交互

智能人机交互包括利用自然语言实现人与机器的自然交流。其中一个重要的概念是“对话即平台”。

“对话即平台(CaaP,Conversation as a Platform)是微软首席执行官萨提亚·纳德拉2016年提出的概念,他认为图形界面的下一代就是对话,并会给整个人工智能、计算机设备带来一场新的革命。

萨提亚之所以提出这个概念是因为:首先,源于大家都已经习惯用社交手段,如微信、Facebook与他人聊天的过程。我们希望将这种交流过程呈现在当今的人机交互中。其次,大家现在面对的设备有的屏幕很小(比如手机),有的甚至没有屏幕(比如有些物联网设备),语音交互更加自然和直观。对话式人机交互可调用Bot来完成一些具体的功能,比如订咖啡,买车票等等。许多公司开放了CAAP平台,让全世界的开发者都能开发出自己喜欢的 Bot以便形成一个生态。

面向任务的对话系统比如微软的小娜通过手机和智能设备让人与电脑进行交流,由人发布命令,小娜理解并完成任务。同时,小娜理解你的习惯,可主动给你一些贴心提示。而聊天机器人,比如微软的小冰负责聊天。无论是小娜这种注重任务执行的技术,还是小冰这种聊天系统,其实背后单元处理引擎无外乎三层技术:第一层,通用聊天机器人;第二层,搜索和问答(Infobot);第三层,面向特定任务对话系统(Bot)。

聊天系统的架构

机器阅读理解

自然语言理解的一个重要研究课题是阅读理解。

阅读理解就是让电脑看一遍文章,针对这些文章问一些问题,看电脑能不能回答出来。机器阅读理解技术有着广阔的应用前景。例如,在搜索引擎中,机器阅读理解技术可以用来为用户的搜索(尤其是问题型的查询)提供更为智能的答案。我们通过对整个互联网的文档进行阅读理解,从而直接为用户提供精确的答案。同时,这在移动场景的个人助理,如微软小娜(Cortana)里也有直接的应用:智能客服中可使用机器阅读文本文档(如用户手册、商品描述等)来自动或辅助客服来回答用户的问题;在办公领域可使用机器阅读理解技术处理个人的邮件或者文档,然后用自然语言查询获取相关的信息;在教育领域用来可以用来辅助出题;在法律领域可用来理解法律条款,辅助律师或者法官判案;在金融领域里从非结构化的文本(比如新闻中)抽取金融相关的信息等。机器阅读理解技术可形成一个通用能力,第三方可以基于它构建更多的应用。

斯坦福大学在2016年7月发布了一个大规模的用于评测阅读理解技术的数据集(SQuAD),包含10万个由人工标注的问题和答案。SQuAD数据集中,文章片段(passage)来自维基百科的文章,每个文章片段(passage)由众包方式,标注人员提5 个问题,并且要求问题的答案是passage中的一个子片段。标注的数据被分成训练集和测试集。训练集公开发布用来训练阅读理解系统,而测试集不公开。参赛者需要把开发的算法和模型提交到斯坦福由其运行后把结果报在网站上。

一开始,以 100 分为例,人的水平是 82.3 左右,机器的水平只有 74 分,机器相差甚远。后来通过不断改进,机器阅读理解性能得以逐步地提高。2018年1月,微软亚洲研究院提交的R-Net系统首次在SQuAD数据集上以82.65的精准匹配的成绩首次超越人类在这一指标上的成绩。随后阿里巴巴、科大讯飞和哈工大的系统也在这一指标上超越人类水平。标志着阅读理解技术进入了一个新的阶段。最近微软亚洲研究院的NL-Net和谷歌的BERT系统又先后在模糊匹配指标上突破人类水平。对于阅读理解技术的推动,除了SQuAD数据集起到了关键作用之外,还有如下三个方的因素:首先,是端到端的深度神经网络。其次,是预训练的神经网络;最后,是系统和网络结构上的不断创新。

机器创作

机器可以做很多理性的东西,也可以做出一些创造性的东西。

早在2005年,微软亚洲研究院在时任院长沈向洋的提议和支持下成功研发了《微软对联》系统。用户出上联,电脑对出下联和横批,语句非常工整。

在此基础上,我们又先后开发了格律诗和猜字谜的智能系统。在字谜游戏里,用户给出谜面,让系统猜出字,或系统给出谜面让用户猜出字。2017年微软研究院开发了电脑写自由体诗系统、作词谱曲系统。中央电视台《机智过人》节目就曾播放过微软的电脑作词谱曲与人类选手进行词曲创作比拼的内容。这件事说明如果有大数据,那么深度学习就可以模拟人类的创造智能,也可以帮助专家产生更好的想法。

就作词来说,写一首歌词首先要决定主题。比如想写一首与“秋”、“岁月”、“沧桑”、“感叹”相关的歌,利用词向量表示技术,可知“秋风”、“流年”、“岁月”、“变迁”等词语比较相关,通过扩展主题可以约束生成的结果偏向人们想要的歌词,接着在主题模型的约束下用序列到序列的神经网络,用歌词的上一句去生成下一句,如果是第一句,则用一个特殊的序列作为输入去生成第一句歌词,这样循环生成歌词的每一句。

下面也简介一下谱曲。为一首词谱曲不单要考虑旋律是否好听,也要考虑曲与词是否对应。这类似于一个翻译过程。不过这个翻译中的对应关系比自然语言翻译更为严格。它需严格规定每一个音符对应到歌词中的每一个字。例如每一句有N个字,那么就需要将这句话对应的曲切分成N个部分,然后顺序完成对应关系。这样在“翻译”过程中要“翻译”出合理的曲谱,还要给出曲与词之间的对应关系。我们利用了一个改进的序列到序列的神经网络模型,完成从歌词“翻译”到曲谱的生成过程。

值得关注的NLP技术

从最近的NLP研究中,我们认为有一些技术发展趋势值得关注,这里总结了五个方面:

热点一,预训练神经网络

如何学习更好的预训练的表示,在一段时间内继续成为研究的热点。

通过类似于语言模型的方式来学习词的表示,其用于具体任务的范式得到了广泛应用。这几乎成为自然语言处理的标配。这个范式的一个不足是词表示缺少上下文,对上下文进行建模依然完全依赖于有限的标注数据进行学习。实际上,基于深度神经网络的语言模型已经对文本序列进行了学习。如果把语言模型关于历史的那部分参数也拿出来应用,那么就能得到一个预训练的上下文相关的表示。这就是Matthew Peters等人在2018年NAACL上的论文“Deep Contextualized Word Representations”的工作,他们在大量文本上训练了一个基于LSTM的语言模型。最近Jacob Delvin等人又取得了新的进展,他们基于多层Transformer机制,利用所谓“MASKED”模型预测句子中被掩盖的词的损失函数和预测下一个句子的损失函数所预训练得到的模型“BERT”,在多个自然语言处理任务上取得了当前最好的水平。以上提到的所有的预训练的模型,在应用到具体任务时,先用这个语言模型的LSTM对输入文本得到一个上下文相关的表示,然后再基于这个表示进行具体任务相关的建模学习。结果表明,这种方法在语法分析、阅读理解、文本分类等任务都取得了显著的提升。最近一段时间,这种预训练模型的研究成为了一个研究热点。

如何学习更好的预训练的表示在一段时间内将继续成为研究的热点。在什么粒度(word,sub-word,character)上进行预训练,用什么结构的语言模型(LSTM,Transformer等)训练,在什么样的数据上(不同体裁的文本)进行训练,以及如何将预训练的模型应用到具体任务,都是需要继续研究的问题。现在的预训练大都基于语言模型,这样的预训练模型最适合序列标注的任务,对于问答一类任务依赖于问题和答案两个序列的匹配的任务,需要探索是否有更好的预训练模型的数据和方法。将来很可能会出现多种不同结构、基于不同数据训练得到的预训练模型。针对一个具体任务,如何快速找到合适的预训练模型,自动选择最优的应用方法,也是一个可能的研究课题。

热点二,迁移学习和多任务学习

对于那些本身缺乏充足训练数据的自然语言处理任务,迁移学习有着非常重要和实际的意义。多任务学习则用于保证模型能够学到不同任务间共享的知识和信息。

不同的NLP任务虽然采用各自不同类型的数据进行模型训练,但在编码器(Encoder)端往往是同构的。例如,给定一个自然语言句子who is the Microsoft founder,机器翻译模型、复述模型和问答模型都会将其转化为对应的向量表示序列,然后再使用各自的解码器完成后续翻译、改写和答案生成(或检索)任务。因此,可以将不同任务训练得到的编码器看作是不同任务对应的一种向量表示,并通过迁移学习(Transfer Learning)的方式将这类信息迁移到目前关注的目标任务上来。对于那些本身缺乏充足训练数据的自然语言处理任务,迁移学习有着非常重要和实际的意义。

多任务学习(Multi-task Learning)可通过端到端的方式,直接在主任务中引入其他辅助任务的监督信息,用于保证模型能够学到不同任务间共享的知识和信息。Collobert和Weston早在2008年就最早提出了使用多任务学习在深度学习框架下处理NLP任务的模型。最近Salesforce的McCann等提出了利用问答框架使用多任务学习训练十项自然语言任务。每项任务的训练数据虽然有限,但是多个任务共享一个网络结构,提升对来自不同任务的训练数据的综合利用能力。多任务学习可以设计为对诸任务可共建和共享网络的核心层次,而在输出层对不同任务设计特定的网络结构。

热点三,知识和常识的引入

如何在自然语言理解模块中更好地使用知识和常识,已经成为目前自然语言处理领域中一个重要的研究课题。

随着人们对人机交互(例如智能问答和多轮对话)要求的不断提高,如何在自然语言理解模块中更好地使用领域知识,已经成为目前自然语言处理领域中一个重要的研究课题。这是由于人机交互系统通常需要具备相关的领域知识,才能更加准确地完成用户查询理解、对话管理和回复生成等任务。

最常见的领域知识包括维基百科和知识图谱两大类。机器阅读理解是基于维基百科进行自然语言理解的一个典型任务。给定一段维基百科文本和一个自然语言问题,机器阅读理解任务的目的是从该文本中找到输入问题对应的答案短语片段。语义分析是基于知识图谱进行自然语言理解的另一个典型任务。给定一个知识图谱(例如Freebase)和一个自然语言问题,语义分析任务的目的是将该问题转化为机器能够理解和执行的语义表示。目前,机器阅读理解和语义分析可以说是最热门的自然语言理解任务,它们受到了来自全世界研究者的广泛关注和深入探索。

常识指绝大多数人都了解并接受的客观事实,例如海水是咸的、人渴了就想喝水、白糖是甜的等。常识对机器深入理解自然语言非常重要,在很多情况下,只有具备了一定程度的常识,机器才有可能对字面上的含义做出更深一层次的理解。然而获取常识却是一个巨大的挑战,一旦有所突破将是影响人工智能进程的大事情。另外,在NLP系统中如何应用常识尚无深入的研究,不过出现了一些值得关注的工作。

热点四,低资源的NLP任务

引入领域知识(词典、规则)可以增强数据能力、基于主动学习的方法增加更多的人工标注数据等,以解决数据资源贫乏的问题。

面对标注数据资源贫乏的问题,譬如小语种的机器翻译、特定领域对话系统、客服系统、多轮问答系统等,NLP尚无良策。这类问题统称为低资源的NLP问题。对这类问题,除了设法引入领域知识(词典、规则)以增强数据能力之外,还可以基于主动学习的方法来增加更多的人工标注数据,以及采用无监督和半监督的方法来利用未标注数据,或者采用多任务学习的方法来使用其他任务甚至其他语言的信息,还可以使用迁移学习的方法来利用其他的模型。

以机器翻译为例,对于稀缺资源的小语种翻译任务,在没有常规双语训练数据的情况下,首先通过一个小规模的双语词典(例如仅包含2000左右的词对),使用跨语言词向量的方法将源语言和目标语言词映射到同一个隐含空间。在该隐含空间中, 意义相近的源语言和目标语言词具有相近的词向量表示。基于该语义空间中词向量的相似程度构建词到词的翻译概率表,并结合语言模型,便可以构建基于词的机器翻译模型。使用基于词的翻译模型将源语言和目标语言单语语料进行翻译,构建出伪双语数据。于是,数据稀缺的问题通过无监督的学习方法产生伪标注数据,就转化成了一个有监督的学习问题。接下来,利用伪双语数据训练源语言到目标语言以及目标语言到源语言的翻译模型,随后再使用联合训练的方法结合源语言和目标语言的单语数据,可以进一步提高两个翻译系统的质量。

为了提高小语种语言的翻译质量,我们提出了利用通用语言之间大规模的双语数据,来联合训练四个翻译模型的期望最大化训练方法(Ren et al., 2018)。该方法将小语种Z(例如希伯来语)作为有着丰富语料的语种X(例如中文)和Y(例如英语)之间的一个隐含状态,并使用通用的期望最大化训练方法来迭代地更新X到Z、Z到X、Y到Z和Z到Y之间的四个翻译模型,直至收敛。

热点五,多模态学习

视觉问答作为一种典型的多模态学习任务,在近年来受到计算机视觉和自然语言处理两个领域研究人员的重点关注。

婴儿在掌握语言功能前,首先通过视觉、听觉和触觉等感官去认识并了解外部世界。可见,语言并不是人类在幼年时期与外界进行沟通的首要手段。因此,构建通用人工智能也应该充分地考虑自然语言和其他模态之间的互动,并从中进行学习,这就是多模态学习。

视觉问答作为一种典型的多模态学习任务,在近年来受到计算机视觉和自然语言处理两个领域研究人员的重点关注。给定一张图片和用户提出的一个自然语言问题,视觉问答系统需要在理解图片和自然语言问题的基础上,进一步输入该问题对应的答案,这需要视觉问答方法在建模中能够对图像和语言之间的信息进行充分地理解和交互。

我们在今年的CVPR和KDD大会上分别提出了基于问题生成的视觉问答方法(Li et al., 2018)以及基于场景图生成的视觉问答方法(Lu et al., 2018),这两种方法均在视觉问答任务上取得了非常好的结果,实现了state-of-the-art的效果。除视觉问答外,视频问答是另一种最近广受关注的多模态任务。该任务除了包括带有时序的视频信息外,还包括了音频信息。目前,视频问答作为一种新型的问答功能,已经出现在搜索引擎的场景中。可以预见,该任务在接下来一定还会受到更多的关注。

未来展望:理想的NLP框架和发展前景

我们认为,未来理想状态下的NLP系统架构可能是如下一个通用的自然语言处理框架:

首先,对给定自然语言输入进行基本处理,包括分词、词性标注、依存分析、命名实体识别、意图/关系分类等。

其次,使用编码器对输入进行编码将其转化为对应的语义表示。在这个过程中,一方面使用预训练好的词嵌入和实体嵌入对输入中的单词和实体名称进行信息扩充,另一方面,可使用预训练好的多个任务编码器对输入句子进行编码并通过迁移学习对不同编码进行融合。

接下来,基于编码器输出的语义表示,使用任务相关的解码器生成对应的输出。还可引入多任务学习将其他相关任务作为辅助任务引入到对主任务的模型训练中来。如果需要多轮建模,则需要在数据库中记录当前轮的输出结果的重要信息,并应用于在后续的理解和推理中。

显然,为了实现这个理想的NLP框架需要做很多工作:

- 需要构建大规模常识数据库并且清晰通过有意义的评测推动相关研究;

- 研究更加有效的词、短语、句子的编码方式,以及构建更加强大的预训练的神经网络模型;

- 推进无监督学习和半监督学习,需要考虑利用少量人类知识加强学习能力以及构建跨语言的embedding的新方法;

- 需要更加有效地体现多任务学习和迁移学习在NLP任务中的效能,提升强化学习在NLP任务的作用,比如在自动客服的多轮对话中的应用;

- 有效的篇章级建模或者多轮会话建模和多轮语义分析;

- 要在系统设计中考虑用户的因素,实现用户建模和个性化的输出;

- 构建综合利用推理系统、任务求解和对话系统,基于领域知识和常识知识的新一代的专家系统;

- 利用语义分析和知识系统提升NLP系统的可解释能力。

未来十年,NLP将会进入爆发式的发展阶段。从NLP基础技术到核心技术,再到NLP+的应用,都会取得巨大的进步。比尔·盖茨曾经说过人们总是高估在一年或者两年中能够做到的事情,而低估十年中能够做到的事情。

我们不妨进一步想象十年之后NLP的进步会给人类生活带来哪些改变?

- 十年后,机器翻译系统可以对上下文建模,具备新词处理能力。那时候的讲座、开会都可以用语音进行自动翻译。除了机器翻译普及,其他技术的进步也令人耳目一新。家里的老人和小孩可以跟机器人聊天解闷。

- 机器个人助理能够理解你的自然语言指令,完成点餐、送花、购物等下单任务。你已习惯于客服机器人来回答你的关于产品维修的问题。

- 你登临泰山发思古之幽情,或每逢佳节倍思亲,拿出手机说出感想或者上传一幅照片,一首情景交融、图文并茂的诗歌便跃然于手机屏幕上,并且可以选择格律诗词或者自由体的表示形式,亦可配上曲谱,发出大作引来点赞。

- 可能你每天看到的体育新闻、财经新闻报道是机器人写的。

- 你用手机跟机器人老师学英语,老师教你口语,纠正发音,跟你亲切对话,帮你修改论文。

- 机器人定期自动分析浩如烟海的文献,给企业提供分析报表、辅助决策并做出预测。搜索引擎的智能程度大幅度提高。很多情况下,可以直接给出答案,并且可以自动生成细致的报告。

- 利用推荐系统,你关心的新闻、书籍、课程、会议、论文、商品等可直接推送给你。

- 机器人帮助律师找出判据,挖掘相似案例,寻找合同疏漏,撰写法律报告。

- ……

未来,NLP将跟其他人工智能技术一道深刻地改变人类的生活。当然前途光明、道路曲折是亘古不变的道理,为了实现这个美好的未来,我们需要大胆创新、严谨求实、扎实进取。讲求研究和应用并举,普及与提高同步。我们期待着与业界同仁一道努力,共同走进NLP下一个辉煌的十年。

NLP面试题

1.为什么要进行预训练?

深度学习时代,为了充分训练深层模型参数并防止过拟合,通常需要更多标注数据喂养。在NLP领域,标注数据更是一个昂贵资源。PTMs从大量无标注数据中进行预训练使许多NLP任务获得显著的性能提升。总的来看,预训练模型PTMs的优势包括:

- 在庞大的无标注数据上进行预训练可以获取更通用的语言表示,并有利于下游任务;

- 为模型提供了一个更好的初始化参数,在目标任务上具备更好的泛化性能、并加速收敛;

- 是一种有效的正则化手段,避免在小数据集上过拟合(一个随机初始化的深层模型容易对小数据集过拟合);

2. 什么是词嵌入和分布式表示?PTMs与分布式表示的关系?

词嵌入是自然语言处理(NLP)中语言模型与表征学习技术的统称。概念上而言,它是指把一个维数为所有词的数量的高维空间嵌入到一个维数低得多的连续向量空间中,每个单词或词组被映射为实数域上的向量,这也是分布式表示:向量的每一维度都没有实际意义,而整体代表一个具体概念。

分布式表示相较于传统的独热编码(one-hot)表示具备更强的表示能力,而独热编码存在维度灾难和语义鸿沟(不能进行相似度计算)等问题。传统的分布式表示方法,如矩阵分解(SVD/LSA)、LDA等均是根据全局语料进行训练,是机器学习时代的产物。预训练模型(Pre-trained Models,PTMs),PTMs也属于分布式表示的范畴,本文的PTMs主要介绍深度学习时代、自NNLM[2]以来的 “modern” 词嵌入。

3. PTMs有哪两大范式?对比不同的预训练编码器?

PTMs的发展经历从浅层的词嵌入到深层编码两个阶段,按照这两个主要的发展阶段,我们归纳出PTMs两大范式:「浅层词嵌入」和「预训练编码器」。

1、浅层词嵌入( Non-Contextual Embeddings**)**

浅层词嵌入,这一类PTMs范式是我们通常所说的“词向量”,其主要特点是学习到的是上下文独立的静态词嵌入,其主要代表为NNLM[2]、word2vec(CBOW[3]、Skip-Gram[3])、Glove[4]等。这一类词嵌入通常采取浅层网络进行训练,而应用于下游任务时,整个模型的其余部分仍需要从头开始学习。因此,对于这一范式的PTMs没有必要采取深层神经网络进行训练,采取浅层网络加速训练也可以产生好的词嵌入[3]。

浅层词嵌入的主要缺陷为:

- 词嵌入与上下文无关,每个单词的嵌入向量始终是相同,因此不能解决一词多义的问题。

- 通常会出现OOV(Out-of-vocabulary问题,为了解决这个问题,相关文献提出了字符级表示或sub-word表示,如CharCNN[5] 、FastText[6] 和 Byte-Pair Encoding [7]。

图1: 常见的3种浅层词嵌入对比:NNLM、word2vec、Glove

图1给出了三种常见的浅层词嵌入之间的对比,Glove可以被看作是更换了目标函数和权重函数的全局word2vec。此外,相关文献也提出了句子和文档级别的嵌入方式,如 Skip-thought[8] 、Context2Vec[9] 等。

2、预训练编码器(Contextual Embeddings)

第二类PTMs范式为预训练编码器,主要目的是通过一个预训练的编码器能够输出上下文相关的词向量,解决一词多义的问题。这一类预训练编码器输出的向量称之为「上下文相关的词嵌入」。

图2: NLP编码器对比

图2: NLP编码器对比

图2给出了NLP各种编码器间的对比。PTMs中预训练编码器通常采用LSTM和Transformer(Transformer-XL),其中Transformer又依据其attention-mask方式分为Transformer-Encoder和Transformer-Decoder两部分。此外,Transformer也可看作是一种图神经网络GNN[10]。

这一类「预训练编码器」范式的PTMs主要代表有ELMO[11]、GPT-1[12]、BERT[13]、XLNet[14]等。

4. PTMs按照任务类型如何分类?

PTMs按照任务类型可分为2大类:监督学习 和 无监督学习/自监督学习。

监督学习在NLP-PTMs中的主要代表就是CoVe[15],CoVe作为机器翻译的encoder部分可以应用于多种NLP下游任务。除了CoVe外,NLP中的绝大多数PTMs属于自监督学习。

自监督学习是无监督学习的一种方法[16],自监督学习[17]主要是利用辅助任务从大规模的无监督数据中挖掘自身的监督信息,通过这种构造的监督信息对网络进行训练,从而可以学习到对下游任务有价值的表征。因此,从“构造监督信息”这个角度来看,自监督也可看作是监督学习和无监督学习的一种融合[1]。严格地讲,从是否由人工标注来看,自监督学习属于无监督学习的范畴。

综合各种自监督学习的分类方式,笔者将NLP-PTMs在自监督学习中分为两种类型[16][17]:基于上下文(Context Based)和基于对比(Contrastive Based)。

1、基于上下文(Context Based)

基于上下文的PTMs,主要基于数据本身的上下文信息构造辅助任务,在NLP中我们通常引入语言模型作为训练目标。PTMs中的语言模型主要分为三大类:

图3: 三类语言模型之间的对比

图3: 三类语言模型之间的对比

第一类:自回归语言模型(LM)

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png)

-

优点:

-

- 语言模型(language model,LM)联合概率的无偏估计,即为传统的语言模型,考虑被预测单词之间的相关性,天然适合处理自然生成任务;

-

缺点:

-

- 联合概率按照文本序列顺序拆解(从左至右分解),无法获取双向上下文信息表征;

第二类:自编码语言模型(DAE)

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png)

-

优点:

-

- 本质为降噪自编码(DAE)特征表示,通过引入噪声[MASK]构建MLM(Masked language model),获取双向上下文信息表征(本文将自编码语言模型统一称为DAE,旨在采用部分损坏的输入,旨在恢复原始的未失真输入);如果当前token被预测,则

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 否则

否则 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) ,

, ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 为原始文本被替换后的输入。

为原始文本被替换后的输入。

- 本质为降噪自编码(DAE)特征表示,通过引入噪声[MASK]构建MLM(Masked language model),获取双向上下文信息表征(本文将自编码语言模型统一称为DAE,旨在采用部分损坏的输入,旨在恢复原始的未失真输入);如果当前token被预测,则

-

缺点:

-

- 引入独立性假设,为语言模型联合概率的有偏估计,没有考虑预测token之间的相关性;

- 预训练时的「MASK」噪声在finetune阶段不会出现,造成两阶段不匹配问题;为解决这一问题,在15%被预测的token中,80%被替换为「MASK」,10%被随机替换,10%被替换为原词。

-

代表模型:BERT、MASS [21]、T5[22]、RoBERTa[23]、UniLM[24]、XLM[25]、SpanBERT[26]、ERNIE-Baidu[27][28]、E-BERT[29]、ERNIE-THU[30]、BART[31]。

BERT[13]是自编码语言模型的一个典型代表,但其采用的MLM策略和Transformer-Encoder结构,导致其不适合直接处理生成任务。为了解决这一问题,也可采用基于Seq2Seq MLM方法:encoder部分采取masked策略,而decoder部分以自回归的方式预测encoder部分被mask的token。此外,还有很多基于自编码语言模型的PTMs提出了不同的MLM增强策略,称之为 Enhanced Masked Language Modeling (E-MLM) [1]。

上述DAE具体的PTMs方法见图4。

第三类:排列语言模型(PLM)

排列语言模型(Permuted Language Model,PLM)综合了LM和DAE-LM两者的优点。严格来讲,PLM和LM是标准的自回归语言模型(注:PLM是一种广义的自回归方法[14]),而MLM不是一个标准的语言模型,其引入独立性假设,隐式地学习预测token(mask部分本身的强相关性)之间的关系。如果衡量序列中被建模的依赖关系的数量,标准的自回归语言模型可以达到上界,不依赖于任何独立假设。LM和PLM能够通过自回归方式来显式地学习预测token之间的关系。然而,LM无法对双向上下文进行表征,借鉴 NADE[32]的思想,PLM将这种传统的自回归语言模型(LM)进行推广,将顺序拆解变为随机拆解(从左至右分解),产生上下文相关的双向特征表示。

PLM最为典型的代表就是XLNet[14],这是对标准语言模型的一个复兴[33]:提出一个框架来连接标准语言模型建模方法和预训练方法。

一个关键问题:为什么PLM可以实现双向上下文的建模?**PLM的本质就是语言模型联合概率的多种分解机制的体现,其将LM的顺序拆解推广到随机拆解。**PLM没有改变原始文本序列的自然位置,只是定义了token预测的顺序。PLM只是针对语言模型建模不同排列下的因式分解排列,并不是词的位置信息的重新排列。

最后,我们对基于上述三类语言模型的PTMs进行总结:

图4: 基于上下文(Context Based)的3种语言模型PTMs总结

2、基于对比(Contrastive Based)

基于对比(Contrastive Based),不同于Context Based主要基于数据本身的上下文信息构造辅助任利用,Contrastive Based主要利用样本间的约束信息构造辅助任务,这类方法也是 Contrastive learning[34](CTL)。CTL假设观察到的文本对(正样本)在语义上比随机采样的文本(负样本)更相似。CTL 背后的原理是「在对比中学习」。相较于语言建模,CTL 的计算复杂度更低,因而在预训练中是理想的替代训练标准。

CTL通过构建正样本(positive)和负样本(negative),然后度量正负样本的距离来实现自监督学习[17]:可以使用点积的方式构造距离函数,然后构造一个 softmax 分类器,以正确分类正样本和负样本。鼓励相似性度量函数将较大的值分配给正例,将较小的值分配给负例:

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png)

相似性度量函数通常可采取两种方式: ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 或

或![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png)

第一类: Deep InfoMax (DIM)

DIM 方法来源于CV领域,对于全局的特征(编码器最终的输出)和局部特征(编码器中间层的特征),DIM需要判断全局特征和局部特征是否来自同一图像[17]。

InfoWord [35]将DIM引入到NLP中,用Mutual Information的一个下界InfoNCE来重新解释BERT和XLNET的objective,并提出一个新的DIM objective以最大化一个句子的global representation和其中一个ngram的local representation之间的Mutual Information。

第二类:Replaced Token Detection (RTD)

噪声对比估计(Noise-Contrastive Estimation,NCE)[36]通过训练一个二元分类器来区分真实样本和假样本,可以很好的训练词嵌入。RTD于与 NCE 相同,根据上下文语境来预测token是否替换 。

- word2vec[3]中的negative sampling可看作是RTD,负样本从词表中进行带权采样。

- ELECTRA[37]提出了一种新的预训练任务框架,构建生成器-判别器,生成器通过MLM任务对被mask的token进行预测,迭代器判断原始句子中的每个token是否被replace过。生成器相当于对输入进行了筛选,使判别器的任务更难,从而学习到更好的表示。生成器-判别器共享embedding,生成器部分采用small-bert,判别器部分对每一个token采用sigmoid计算loss。finetune阶段只采用判别器部分。RTD也被看作解决MLM中「MASK」在预训练和finetune间差异的一种手段。

- WKLM[38]在实体level进行替换,替换为具有相同实体类型的实体名称。

第三类:Next Sentence Prediction (NSP)

NSP 区分两个输入句子是否为训练语料库中的连续片段,第二个句子50%为第一句子实际的连续片段,50%从其他语料随机选择。NSP可以引导模型理解两个输入句子之间的关系,从而使对此信息敏感的下游任务受益,如QA任务。而RoBERTa[23]表明:NSP在对单个文档中的文本块进行训练时,去除NSP任务或在下游任务上可以稍微提高性能。

第四类:Sentence Order Prediction (SOP)

SOP 使用同一文档中的两个连续片段作为正样本,而相同的两个连续片段互换顺序作为负样本。NSP融合了主题预测和相关性预测,主题预测更容易,这使得模型进行预测时仅依赖于主题学习。与NSP不同,SOP使用同一文档中的两个连续段作为正样本,但顺序互换为负样本。采取SOP任务的PTMs有ALBERT[39]、StructBERT[40]、BERTje[41]。

图5对上述基于对比(Contrastive Based)的四类PTMs进行了总结:

图5: 基于对比(Contrastive Based)的PTMs总结

图5: 基于对比(Contrastive Based)的PTMs总结

5. PTMs有哪些拓展?

1、引入知识

PTMs通常从通用大型文本语料库中学习通用语言表示,但是缺少特定领域的知识。PTMs中设计一些辅助的预训练任务,将外部知识库中的领域知识整合到PTMs中被证明是有效的[1]。

- ERNIE-THU[30]将在知识图谱中预先训练的实体嵌入与文本中相应的实体提及相结合,以增强文本表示。由于语言表征的预训练过程和知识表征过程有很大的不同,会产生两个独立的向量空间。为解决上述问题,在有实体输入的位置,将实体向量和文本表示通过非线性变换进行融合,以融合词汇、句法和知识信息。

- LIBERT[42](语言知识的BERT)通过附加的语言约束任务整合了语言知识。

- SentiLR[43]集成了每个单词的情感极性,以将MLM扩展到标签感知MLM(LA-MLM),ABSA任务上都达到SOTA。

- SenseBERT[44] 不仅能够预测被mask的token,还能预测它们在给定语境下的实际含义。使用英语词汇数据库 WordNet 作为标注参照系统,预测单词在语境中的实际含义,显著提升词汇消歧能力。

- KnowBERT[45] 与实体链接模型以端到端的方式合并实体表示。

- KG-BERT[46]显示输入三元组形式,采取两种方式进行预测:构建三元组识别和关系分类,共同优化知识嵌入和语言建模目标。这些工作通过实体嵌入注入知识图的结构信息。

- K-BERT[47]将从KG提取的相关三元组显式地注入句子中,以获得BERT的扩展树形输入。

- K-Adapter[48]通过针对不同的预训练任务独立地训练不同的适配器来注入多种知识,从而可以不断地注入知识,以解决注入多种知识时可能会出现灾难性遗忘问题。

- 此外,这类PTMs还有WKLM[38]、KEPLER[49]和[50]等。

2、模型压缩

由于预训练的语言模型通常包含至少数亿个参数,因此很难将它们部署在现实应用程序中的在线服务和资源受限的设备上。模型压缩是减小模型尺寸并提高计算效率的有效方法。

5种PTMs的压缩方法为:

-

pruning(剪枝):将模型中影响较小的部分舍弃。

-

quantization(量化):将高精度模型用低精度来表示;

-

parameter sharing (参数共享):相似模型单元间的参数共享;

-

- ALBERT[39]主要是通过矩阵分解和跨层参数共享来做到对参数量的减少。

-

module replacing(模块替换):

-

- BERT-of-Theseus[55]根据伯努利分布进行采样,决定使用原始的大模型模块还是小模型,只使用task loss。

-

knowledge distillation (知识蒸馏):通过一些优化目标从大型、知识丰富、fixed的teacher模型学习一个小型的student模型。蒸馏机制主要分为3种类型:

图6: 不同的知识蒸馏PTMs

图6: 不同的知识蒸馏PTMs

3、多模态

随着PTMs在NLP领域的成功,许多研究者开始关注多模态领域的PTMs,主要为通用的视觉和语言特征编码表示而设计。多模态的PTMs在一些庞大的跨模式数据语料库(带有文字的语音、视频、图像)上进行了预训练,如带有文字的语音、视频、图像等,主要有 VideoBERT[63]、CBT[64] 、UniViLM[65]、 ViL-BERT[66] 、 LXMERT[67]、 VisualBERT [68]、 B2T2[69] 、Unicoder-VL[70] 、UNITER [71]、 VL-BERT[72] 、 SpeechBERT[73]。

4、领域预训练

大多数PTM都在诸如Wikipedia的通用语料中训练,而在领域化的特定场景会收到限制。如基于生物医学文本的BioBERT[74],基于科学文本的SciBERT[75],基于临床文本的Clinical-BERT[76]。一些工作还尝试将PTMs适应目标领域的应用,如医疗实体标准化[77]、专利分类PatentBERT [78]、情感分析SentiLR[79]关键词提取[80]。

5、多语言和特定语言

学习跨语言共享的多语言文本表示形式对于许多跨语言的NLP任务起着重要的作用。

- Multilingual-BERT[81]在104种 Wikipedia文本上进行MLM训练(共享词表),每个训练样本都是单语言文档,没有专门设计的跨语言目标,也没有任何跨语言数据,M-BERT也可以很好的执行跨语言任务。

- XLM[25]通过融合跨语言任务(翻译语言模型)改进了M-BERT,该任务通过拼接平行语料句子对进行MLM训练。

- Unicoder[82]提出了3种跨语言预训练任务:1)cross-lingual word recovery;2) cross-lingual paraphrase classification;3) cross-lingual masked language model.

虽然多语言的PTMs在跨语言上任务表现良好,但用单一语言训练的PTMs明显好于多语言的PTMs。此外一些单语言的PTMs被提出:BERT-wwm[83], ZEN[84], NEZHA[85] , ERNIE-Baidu[27][28], BERTje[86], CamemBERT[87], FlauBERT [88], RobBERT [89]。

6. 如何对PTMs进行迁移学习?

PTMs从大型语料库中获取通用语言知识,如何有效地将其知识适应下游任务是一个关键问题。迁移学习的方式主要有归纳迁移(顺序迁移学习、多任务学习)、领域自适应(转导迁移)、跨语言学习等。NLP中PTMs的迁移方式是顺序迁移学习。

1、如何迁移?

1)选择合适的预训练任务:语言模型是PTM是最为流行的预训练任务;同的预训练任务有其自身的偏置,并且对不同的任务会产生不同的效果。例如,NSP任务可以使诸如问答(QA)和自然语言推论(NLI)之类的下游任务受益。

2)选择合适的模型架构:例如BERT采用的MLM策略和Transformer-Encoder结构,导致其不适合直接处理生成任务。

3)选择合适的数据:下游任务的数据应该近似于PTMs的预训练任务,现在已有有很多现成的PTMs可以方便地用于各种特定领域或特定语言的下游任务。

4)选择合适的layers进行transfer:主要包括Embedding迁移、top layer迁移和all layer迁移。如word2vec和Glove可采用Embedding迁移,BERT可采用top layer迁移,Elmo可采用all layer迁移。

5)特征集成还是fine-tune?对于特征集成预训练参数是freeze的,而fine-tune是unfreeze的。特征集成方式却需要特定任务的体系结构,fine-tune方法通常比特征提取方法更为通用和方便。

**2、fine-tune策略:**通过更好的微调策略进一步激发PTMs性能

- 两阶段fine-tune策略:如第一阶段对中间任务或语料进行finetune,第二阶段再对目标任务fine-tune。第一阶段通常可根据特定任务的数据继续进行fine-tune预训练。

- 多任务fine-tune:MTDNN[90]在多任务学习框架下对BERT进行了fine-tune,这表明多任务学习和预训练是互补的技术。

- 采取额外的适配器:fine-tune的主要缺点是其参数效率低,每个下游任务都有自己的fine-tune参数。因此,更好的解决方案是在固定原始参数的同时,将一些可fine-tune的适配器注入PTMs。

- 逐层阶段:逐渐冻结而不是同时对所有层进行fine-tune,也是一种有效的fine-tune策略。

7. PTMs还有哪些问题需要解决?

(本部分来自[91],有删减和修正)

虽然 PTMs已经在很多 NLP 任务中显示出了他们强大的能力,然而由于语言的复杂性,仍存在诸多挑战。综述论文给出了五个未来 PTMs发展方向的建议。

1、PTMs的上限

目前,PTMs并没有达到其上限。大多数的PTMs可通过使用更长训练步长和更大数据集来提升其性能。目前NLP中的SOTA也可通过加深模型层数来更进一步提升。这将导致更加高昂的训练成本。因此,一个更加务实的方向是在现有的软硬件基础上,设计出更高效的模型结构、自监督预训练任务、优化器和训练技巧等。例如, ELECTRA [37]就是此方向上很好的一个解决方案。

2、面向任务的预训练和模型压缩

在实践中,不同的目标任务需要 PTMs拥有不同功能。而 PTMs与下游目标任务间的差异通常在于两方面:模型架构与数据分布。尽管较大的PTMs通常情况下会带来更好的性能表现,但在低计算资源下如何使用是一个实际问题。例如,对于 NLP 的 PTM 来说,对于模型压缩的研究只是个开始,Transformer 的全连接架构也使得模型压缩具有挑战性。

3、PTMs的架构设计

对于PTMs,Transformer 已经被证实是一个高效的架构。然而 Transformer 最大的局限在于其计算复杂度(输入序列长度的平方倍)。受限于 GPU 显存大小,目前大多数 PTM 无法处理超过 512 个 token 的序列长度。打破这一限制需要改进 Transformer 的结构设计,例如 Transformer-XL[92]。

4、finetune中的知识迁移

finetune是目前将 PTM 的知识转移至下游任务的主要方法,但效率却很低,每个下游任务都需要有特定的finetune参数。一个可以改进的解决方案是固定PTMs的原始参数,并为特定任务添加小型的finetune适配器,这样就可以使用共享的PTMs 服务于多个下游任务。

5、PTMs 的解释性与可靠性

PTMs 的可解释性与可靠性仍然需要从各个方面去探索,它能够帮助我们理解 PTM 的工作机制,为更好的使用及性能改进提供指引。

写在最后:本文总结 与 原综述论文[1]的一些不同之处:

- 本文定义了PTMs两大范式:浅层词嵌入和预训练编码器。不同于原文,XLNet在原综述论文中被归为Transformer-Encoder,本文认为将其归为Transformer-XL更合适。

- 本文PTMs按照自监督学习的分类不同于原文。本文按照 基于上下文(Context Based)和基于对比(Contrastive Based)两种方式归类;将原文的LM、MLM、DAE、PLM归为Context Based;

- 本文将原文MLM和DAE统一为DAE;

- 其他:1)在3.1.2的E-MLM段落中,可以将StructBERT拿出来,只放在SOP;2)3.1.5对ELECTRA的描述,应采取ELECTRA原文中的主要方法(参数共享),两阶段的方法只是一种实验尝试;3)在puring部分可以补充LayerDrop;4)应将UniLM归为MLM;、

参考:

- 1(https://zhuanlan.zhihu.com/p/115014536#ref_1_0)bcdePre-trained Models for Natural Language Processing: A Survey https://arxiv.org/abs/2003.08271v2

- 2(https://zhuanlan.zhihu.com/p/115014536#ref_2_0)bA neural probabilistic language model.

- 3(https://zhuanlan.zhihu.com/p/115014536#ref_3_0)bcd Distributed representations of words and phrases and their compositionality.

- ^GloVe: Global vectors for word representation

- ^Character-aware neural language models.

- ^Enriching word vectors with subword information.

- ^Neural machine translation of rare words with subword units.

- ^Skip-thought vectors

- ^Context2Vec: Learning generic context embedding with bidirec- tional LSTM.

- ^https://zhuanlan.zhihu.com/p/110805093

- ^Deep contextualized word representations.

- ^Improving language understanding by generative pre-training.

- 4(https://zhuanlan.zhihu.com/p/115014536#ref_13_0)bBERT: pre-training of deep bidirectional trans- formers for language understanding

- 5(https://zhuanlan.zhihu.com/p/115014536#ref_14_0)bcXLnet: Generalized Autoregressive Pretraining for Language Understanding

- ^Learned in translation: Contextualized word vectors.

- 6(https://zhuanlan.zhihu.com/p/115014536#ref_16_0)bSelf-supervised Visual Feature Learning with Deep Neural Networks: A Survey

- 7(https://zhuanlan.zhihu.com/p/115014536#ref_17_0)bcdSelf-supervised Learning 再次入门 https://zhuanlan.zhihu.com/p/108906502

- ^ Language models are unsuper- vised multitask learners

- ^ULMFiT:Universal Language Model Fine-tuning)

- ^SiATL:An Embarrassingly Simple Approach for Transfer Learning from Pretrained Language Models

- ^MASS: masked sequence to sequence pre-training for language generation.

- ^Exploring the limits of transfer learning with a uni- fied text-to-text transformer

- 8(https://zhuanlan.zhihu.com/p/115014536#ref_23_0)bRoBERTa: A ro- bustly optimized BERT pretraining approach

- ^Unified language model pre-training for natural language un- derstanding and generation.

- 9(https://zhuanlan.zhihu.com/p/115014536#ref_25_0)bCross-lingual lan- guage model pretraining.

- ^SpanBERT: Improving pre- training by representing and predicting spans.

- 10(https://zhuanlan.zhihu.com/p/115014536#ref_27_0)bERNIE: enhanced representation through knowledge integration

- 11(https://zhuanlan.zhihu.com/p/115014536#ref_28_0)bERNIE 2.0: A continual pre-training framework for language understanding

- ^BERT is not a knowledge base (yet): Factual knowledge vs. name-based reasoning in unsupervised QA

- 12(https://zhuanlan.zhihu.com/p/115014536#ref_30_0)bERNIE: enhanced language representation with informative entities

- ^BART: denoising sequence-to- sequence pre-training for natural language generation, transla- tion, and comprehension.

- ^Neural autoregressive distribution estimation

- ^他们创造了横扫NLP的XLNet:专访CMU博士杨植麟

- ^A theoretical analysis of contrastive unsupervised representation learning.

- ^A mutual information maximization perspective of language representation learning

- ^Noise-contrastive estimation: A new estimation principle for unnormalized sta- tistical models.

- 13(https://zhuanlan.zhihu.com/p/115014536#ref_37_0)bELECTRA: Pre-training text encoders as discriminators rather than generators

- 14(https://zhuanlan.zhihu.com/p/115014536#ref_38_0)bPretrained encyclopedia: Weakly supervised knowledge-pretrained language model

- 15(https://zhuanlan.zhihu.com/p/115014536#ref_39_0)bALBERT: A lite BERT for self-supervised learning of language representations.

- ^StructBERT: Incorporating language struc- tures into pre-training for deep language understanding

- ^BERTje: A dutch BERT model

- ^Informing unsupervised pre- training with external linguistic knowledge

- ^Sentilr: Linguistic knowledge enhanced lan- guage representation for sentiment analysis

- ^SenseBERT: Driving some sense into BERT

- ^Knowledge enhanced contextual word representations

- ^KG-BERT: BERT for Knowledge Graph Completion

- ^K-BERT: Enabling lan- guage representation with knowledge graph

- ^K-adapter: Infusing knowledge into pre-trained models with adapters

- ^KEPLER: A unified model for knowledge embedding and pre-trained language representation

- ^Enhancing pre-trained language representations with rich knowledge for machine reading comprehension.

- ^Compressing BERT: Studying the effects of weight pruning on transfer learning

- ^REDUCING TRANSFORMER DEPTH ON DEMAND WITH STRUCTURED DROPOUT

- ^Q- BERT: Hessian based ultra low precision quantization of BERT.

- ^Q8BERT: Quantized 8bit BERT.

- ^BERT-of-Theseus: Compressing BERT by pro- gressive module replacing

- ^DistilBERT, a distilled version of BERT: smaller, faster, cheaper and lighter.

- ^MT-DNN:Improving Multi-Task Deep Neural Networks via Knowledge Distillation for Natural Language Understanding

- ^TinyBERT: Distilling BERT for natural language understanding

- ^MobileBERT: Task-agnostic com- pression of BERT by progressive knowledge transfer

- ^MiniLM: Deep self-attention distillation for task-agnostic compression of pre-trained transformers.

- ^Extreme language model compression with optimal subwords and shared projections

- ^Distilling task-specific knowledge from BERT into simple neural networks

- ^VideoBERT: A joint model for video and language representation learning

- ^Contrastive bidirectional transformer for temporal representation learning

- ^Univilm: A unified video and language pre-training model for multimodal under- standing and generation.

- ^ViL- BERT: Pretraining task-agnostic visiolinguistic representa- tions for vision-and-language tasks.

- ^LXMERT: learning cross- modality encoder representations from transformers.

- ^VisualBERT: A simple and performant base- line for vision and language.

- ^Fusion of detected objects in text for visual question answering.

- ^Unicoder-vl: A universal encoder for vision and language by cross-modal pre-training

- ^UNITER: learning universal image-text representations.

- ^VL-BERT: pre-training of generic visual- linguistic representations

- ^SpeechBERT: Cross-modal pre-trained language model for end-to-end spoken question answering.

- ^BioBERT: a pre-trained biomedical language representation model for biomedical text mining.

- ^SciBERT: A pre- trained language model for scientific text

- ^Clin- icalBERT: Modeling clinical notes and predicting hospital readmission.

- ^BERT-based rank- ing for biomedical entity normalization.

- ^PatentBERT: Patent clas- sification with fine-tuning a pre-trained BERT model.

- ^SentiLR: Linguistic knowledge enhanced lan- guage representation for sentiment analysis.

- ^Progress notes clas- sification and keyword extraction using attention-based deep learning models with BERT.

- ^ https://github.com/google-research/bert/blob/master/multilingual.md

- ^Unicoder: A universal language encoder by pre-training with multiple cross-lingual tasks.

- ^Pre-training with whole word masking for chinese BERT

- ^ZEN: pre-training chinese text encoder enhanced by n-gram representations.

- ^NEZHA: Neural contextualized representa- tion for chinese language understanding

- ^BERTje: A dutch BERT model.

- ^ CamemBERT: a tasty french language model

- ^FlauBERT: Unsupervised language model pre-training for french

- ^Rob-BERT: a dutch RoBERTa-based language model.

- ^Multi-task deep neural networks for natural language understanding.

- ^https://zhuanlan.zhihu.com/p/114785639

- ^Transformer-XL: Atten- tive language models beyond a fixed-length context.

8. 文本表示和各词向量间的对比?

1、文本表示哪些方法?

下面对文本表示进行一个归纳,也就是对于一篇文本可以如何用数学语言表示呢?

- 基于one-hot、tf-idf、textrank等的bag-of-words;

- 主题模型:LSA(SVD)、pLSA、LDA;

- 基于词向量的固定表征:word2vec、fastText、glove

- 基于词向量的动态表征:elmo、GPT、bert

2、怎么从语言模型理解词向量?怎么理解分布式假设?

上面给出的4个类型也是nlp领域最为常用的文本表示了,文本是由每个单词构成的,而谈起词向量,one-hot是可认为是最为简单的词向量,但存在维度灾难和语义鸿沟等问题;通过构建共现矩阵并利用SVD求解构建词向量,则计算复杂度高;而早期词向量的研究通常来源于语言模型,比如NNLM和RNNLM,其主要目的是语言模型,而词向量只是一个副产物。

NNLM

NNLM

所谓分布式假设,用一句话可以表达:相同上下文语境的词有似含义。而由此引申出了word2vec、fastText,在此类词向量中,虽然其本质仍然是语言模型,但是它的目标并不是语言模型本身,而是词向量,其所作的一系列优化,都是为了更快更好的得到词向量。glove则是基于全局语料库、并结合上下文语境构建词向量,结合了LSA和word2vec的优点。

3、传统的词向量有什么问题?怎么解决?各种词向量的特点是什么?

上述方法得到的词向量是固定表征的,无法解决一词多义等问题,如“川普”。为此引入基于语言模型的动态表征方法:elmo、GPT、bert。

各种词向量的特点:

(1)One-hot 表示 :维度灾难、语义鸿沟;

(2)分布式表示 (distributed representation) :

- 矩阵分解(LSA):利用全局语料特征,但SVD求解计算复杂度大;

- 基于NNLM/RNNLM的词向量:词向量为副产物,存在效率不高等问题;

- word2vec、fastText:优化效率高,但是基于局部语料;

- glove:基于全局预料,结合了LSA和word2vec的优点;

- elmo、GPT、bert:动态特征;

4、word2vec和NNLM对比有什么区别?(word2vec vs NNLM)

1)其本质都可以看作是语言模型;

2)词向量只不过NNLM一个产物,word2vec虽然其本质也是语言模型,但是其专注于词向量本身,因此做了许多优化来提高计算效率:

- 与NNLM相比,词向量直接sum,不再拼接,并舍弃隐层;

- 考虑到sofmax归一化需要遍历整个词汇表,采用hierarchical softmax 和negative sampling进行优化,hierarchical softmax 实质上生成一颗带权路径最小的哈夫曼树,让高频词搜索路劲变小;negative sampling更为直接,实质上对每一个样本中每一个词都进行负例采样;

5、word2vec和fastText对比有什么区别?(word2vec vs fastText)

1)都可以无监督学习词向量, fastText训练词向量时会考虑subword;

2) fastText还可以进行有监督学习进行文本分类,其主要特点:

- 结构与CBOW类似,但学习目标是人工标注的分类结果;

- 采用hierarchical softmax对输出的分类标签建立哈夫曼树,样本中标签多的类别被分配短的搜寻路径;

- 引入N-gram,考虑词序特征;

- 引入subword来处理长词,处理未登陆词问题;

6、glove和word2vec、 LSA对比有什么区别?(word2vec vs glove vs LSA)

1)glove vs LSA

- LSA(Latent Semantic Analysis潜在语义分析)可以基于co-occurance matrix构建词向量,实质上是基于全局语料采用SVD进行矩阵分解,然而SVD计算复杂度高;

- glove可看作是对LSA一种优化的高效矩阵分解算法,采用Adagrad对最小平方损失进行优化;

2)word2vec vs glove

- word2vec是局部语料库训练的,其特征提取是基于滑窗的;而glove的滑窗是为了构建co-occurance matrix,是基于全局语料的,可见glove需要事先统计共现概率;因此,word2vec可以进行在线学习,glove则需要统计固定语料信息。

- word2vec是无监督学习,同样由于不需要人工标注;glove通常被认为是无监督学习,但实际上glove还是有label的,即共现次数

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 。

。 - word2vec损失函数实质上是**带权重的交叉熵,**权重固定;glove的损失函数是最小平方损失函数,权重可以做映射变换。

- 总体来看,glove可以被看作是更换了目标函数和权重函数的全局word2vec。

elmo vs GPT vs bert

elmo vs GPT vs bert

7、 elmo、GPT、bert三者之间有什么区别?(elmo vs GPT vs bert)

之前介绍词向量均是静态的词向量,无法解决一次多义等问题。下面介绍三种elmo、GPT、bert词向量,它们都是基于语言模型的动态词向量。下面从几个方面对这三者进行对比:

(1)特征提取器:elmo采用LSTM进行提取,GPT和bert则采用Transformer进行提取。很多任务表明Transformer特征提取能力强于LSTM,elmo采用1层静态向量+2层LSTM,多层提取能力有限,而GPT和bert中的Transformer可采用多层,并行计算能力强。

(2)单/双向语言模型:

- GPT采用单向语言模型,elmo和bert采用双向语言模型。但是elmo实际上是两个单向语言模型(方向相反)的拼接,这种融合特征的能力比bert一体化融合特征方式弱。

- GPT和bert都采用Transformer,Transformer是encoder-decoder结构,GPT的单向语言模型采用decoder部分,decoder的部分见到的都是不完整的句子;bert的双向语言模型则采用encoder部分,采用了完整句子。

9. 深入解剖word2vec

1、word2vec的两种模型分别是什么?

word2Vec 有两种模型:CBOW 和 Skip-Gram:

- CBOW 在已知

context(w)的情况下,预测w; - Skip-Gram在已知

w的情况下预测context(w);

word2vec

word2vec

与NNLM相比,word2vec的主要目的是生成词向量而不是语言模型,在CBOW中,投射层将词向量直接相加而不是拼接起来,并舍弃了隐层,这些牺牲都是为了减少计算量,使训练更佳

2、word2vec的两种优化方法是什么?它们的目标函数怎样确定的?训练过程又是怎样的?

不经过优化的CBOW和Skip-gram中 ,在每个样本中每个词的训练过程都要遍历整个词汇表,也就是都需要经过softmax归一化,计算误差向量和梯度以更新两个词向量矩阵(这两个词向量矩阵实际上就是最终的词向量,可认为初始化不一样),当语料库规模变大、词汇表增长时,训练变得不切实际。为了解决这个问题,word2vec支持两种优化方法:hierarchical softmax 和negative sampling。此部分仅做关键介绍,数学推导请仔细阅读《word2vec 中的数学原理详解》。

(1)基于hierarchical softmax 的 CBOW 和 Skip-gram

基于hierarchical softmax 的 CBOW 和 Skip-gram

基于hierarchical softmax 的 CBOW 和 Skip-gram

hierarchical softmax 使用一颗二叉树表示词汇表中的单词,每个单词都作为二叉树的叶子节点。对于一个大小为V的词汇表,其对应的二叉树包含V-1非叶子节点。假如每个非叶子节点向左转标记为1,向右转标记为0,那么每个单词都具有唯一的从根节点到达该叶子节点的由{0 1}组成的代号(实际上为哈夫曼编码,为哈夫曼树,是带权路径长度最短的树,哈夫曼树保证了词频高的单词的路径短,词频相对低的单词的路径长,这种编码方式很大程度减少了计算量)。

CBOW中的目标函数是使条件概率 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 最大化,其等价于:

最大化,其等价于:

Skip-gram中的目标函数是使条件概率 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 最大化,其等价于:

最大化,其等价于:

(2)基于negative sampling的 CBOW 和 Skip-gram

negative sampling是一种不同于hierarchical softmax的优化策略,相比于hierarchical softmax,negative sampling的想法更直接——为每个训练实例都提供负例。

对于CBOW,其目标函数是最大化:

对于Skip-gram,同样也可以得到其目标函数是最大化:

负采样算法实际上就是一个带权采样过程,负例的选择机制是和单词词频联系起来的。

具体做法是以 N+1 个点对区间 [0,1] 做非等距切分,并引入的一个在区间 [0,1] 上的 M 等距切分,其中 M >> N。源码中取 M = 10^8。然后对两个切分做投影,得到映射关系:采样时,每次生成一个 [1, M-1] 之间的整数 i,则 Table(i) 就对应一个样本;当采样到正例时,跳过(拒绝采样)。

Negative Sampling · 负采样

在训练神经网络时,每当接受一个训练样本,然后调整所有神经单元权重参数,来使神经网络预测更加准确。换句话说,每个训练样本都将会调整所有神经网络中的参数。

我们词汇表的大小决定了我们skip-gram 神经网络将会有一个非常大的权重参数,并且所有的权重参数会随着数十亿训练样本不断调整。

negative sampling 每次让一个训练样本仅仅更新一小部分的权重参数,从而降低梯度下降过程中的计算量。

如果 vocabulary 大小为1万时, 当输入样本 ( “fox”, “quick”) 到神经网络时, “ fox” 经过 one-hot 编码,在输出层我们期望对应 “quick” 单词的那个神经元结点输出 1,其余 9999 个都应该输出 0。在这里,这9999个我们期望输出为0的神经元结点所对应的单词我们为 negative word. negative sampling 的想法也很直接 ,将随机选择一小部分的 negative words,比如选 10个 negative words 来更新对应的权重参数。

在论文中作者指出对于小规模数据集,建议选择 5-20 个 negative words,对于大规模数据集选择 2-5个 negative words.

如果使用了 negative sampling 仅仅去更新positive word- “quick” 和选择的其他 10 个negative words 的结点对应的权重,共计 11 个输出神经元,相当于每次只更新 300 x 11 = 3300 个权重参数。对于 3百万 的权重来说,相当于只计算了千分之一的权重,这样计算效率就大幅度提高。

Selecting Negative Samples

使用 一元模型分布 (unigram distribution) 来选择 negative words,一个单词被选作 negative sample 的概率跟它出现的频次有关,出现频次越高的单词越容易被选作negative words,经验公式为:

f(w) 代表 每个单词被赋予的一个权重,即 它单词出现的词频,分母 代表所有单词的权重和。公式中3/4完全是基于经验的,论文中提到这个公式的效果要比其它公式更加出色。

10.深入解剖Glove详解

GloVe的全称叫Global Vectors for Word Representation,它是一个基于全局词频统计(count-based & overall statistics)的词表征(word representation)工具。

1、GloVe构建过程是怎样的?

(1)根据语料库构建一个共现矩阵,矩阵中的每一个元素 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 代表单词

代表单词 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 和上下文单词

和上下文单词 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 在特定大小的上下文窗口内共同出现的次数。

在特定大小的上下文窗口内共同出现的次数。

(2)构建词向量(Word Vector)和共现矩阵之间的近似关系,其目标函数为: ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png)

这个loss function的基本形式就是最简单的mean square loss,只不过在此基础上加了一个权重函数 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) :

:

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png)

根据实验发现 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 的值对结果的影响并不是很大,原作者采用了

的值对结果的影响并不是很大,原作者采用了 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 。而

。而 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 时的结果要比

时的结果要比 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 时要更好。下面是

时要更好。下面是 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 时

时 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 的函数图象,可以看出对于较小的

的函数图象,可以看出对于较小的 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) ,权值也较小。这个函数图像如下所示:

,权值也较小。这个函数图像如下所示:

2、GloVe的训练过程是怎样的?

- 实质上还是监督学习:虽然glove不需要人工标注为无监督学习,但实质还是有label就是

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 。

。 - 向量

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 和

和 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 为学习参数,本质上与监督学习的训练方法一样,采用了AdaGrad的梯度下降算法,对矩阵

为学习参数,本质上与监督学习的训练方法一样,采用了AdaGrad的梯度下降算法,对矩阵 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 中的所有非零元素进行随机采样,学习曲率(learning rate)设为0.05,在vector size小于300的情况下迭代了50次,其他大小的vectors上迭代了100次,直至收敛。

中的所有非零元素进行随机采样,学习曲率(learning rate)设为0.05,在vector size小于300的情况下迭代了50次,其他大小的vectors上迭代了100次,直至收敛。 - 最终学习得到的是两个词向量是

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 和

和 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) ,因为

,因为 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 是对称的(symmetric),所以从原理上讲

是对称的(symmetric),所以从原理上讲![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 和

和 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) ,是也是对称的,他们唯一的区别是初始化的值不一样,而导致最终的值不一样。所以这两者其实是等价的,都可以当成最终的结果来使用。但是为了提高鲁棒性,我们最终会选择两者之和

,是也是对称的,他们唯一的区别是初始化的值不一样,而导致最终的值不一样。所以这两者其实是等价的,都可以当成最终的结果来使用。但是为了提高鲁棒性,我们最终会选择两者之和 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 作为最终的vector(两者的初始化不同相当于加了不同的随机噪声,所以能提高鲁棒性)。

作为最终的vector(两者的初始化不同相当于加了不同的随机噪声,所以能提高鲁棒性)。

3、Glove损失函数是如何确定的?(来自GloVe详解)

11. 深入解剖bert(与elmo和GPT比较)

bert的全称是Bidirectional Encoder Representation from Transformers,bert的核心是双向Transformer Encoder,提出以下问题并进行解答:[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ota8BlrJ-1602121779817)(C:\Users\VULCAN\AppData\Roaming\Typora\typora-user-images\image-20200520192431888.png)]

也可以把词抠出来,进行训练,loss,这样能更好捕捉词与词的关联,

1、为什么bert采取的是双向Transformer Encoder,而不叫decoder?

BERT Transformer 使用双向self-attention,而GPT Transformer 使用受限制的self-attention,其中每个token只能处理其左侧的上下文。双向 Transformer 通常被称为“Transformer encoder”,而左侧上下文被称为“Transformer decoder”,decoder是不能获取要预测的信息的。

2、elmo、GPT和bert在单双向语言模型处理上的不同之处?

在上述3个模型中,只有bert共同依赖于左右上下文。那elmo不是双向吗?实际上elmo使用的是经过独立训练的从左到右和从右到左LSTM的串联拼接起来的。而GPT使用从左到右的Transformer,实际就是“Transformer decoder”。

3、bert构建双向语言模型不是很简单吗?不也可以直接像elmo拼接Transformer decoder吗?

BERT 的作者认为,这种拼接式的bi-directional 仍然不能完整地理解整个语句的语义。更好的办法是用上下文全向来预测[mask],也就是用 “能/实现/语言/表征/…/的/模型”,来预测[mask]。BERT 作者把上下文全向的预测方法,称之为 deep bi-directional。

4、bert为什么要采取Marked LM,而不直接应用Transformer Encoder?

我们知道向Transformer这样深度越深,学习效果会越好。可是为什么不直接应用双向模型呢?因为随着网络深度增加会导致标签泄露。如下图:

双向编码与网络深度的冲突

双向编码与网络深度的冲突

深度双向模型比left-to-right 模型或left-to-right and right-to-left模型的浅层连接更强大。遗憾的是,标准条件语言模型只能从左到右或从右到左进行训练,因为双向条件作用将允许每个单词在多层上下文中间接地“see itself”。

为了训练一个深度双向表示(deep bidirectional representation),研究团队采用了一种简单的方法,即随机屏蔽(masking)部分输入token,然后只预测那些被屏蔽的token。论文将这个过程称为“masked LM”(MLM)。

5、bert为什么并不总是用实际的[MASK]token替换被“masked”的词汇?

NLP必读 | 十分钟读懂谷歌BERT模型: 虽然这确实能让团队获得双向预训练模型,但这种方法有两个缺点。首先,预训练和finetuning之间不匹配,因为在finetuning期间从未看到[MASK]token。为了解决这个问题,团队并不总是用实际的[MASK]token替换被“masked”的词汇。相反,训练数据生成器随机选择15%的token。例如在这个句子“my dog is hairy”中,它选择的token是“hairy”。然后,执行以下过程:

数据生成器将执行以下操作,而不是始终用[MASK]替换所选单词:

80%的时间:用[MASK]标记替换单词,例如,my dog is hairy → my dog is [MASK]

10%的时间:用一个随机的单词替换该单词,例如,my dog is hairy → my dog is apple

10%的时间:保持单词不变,例如,my dog is hairy → my dog is hairy. 这样做的目的是将表示偏向于实际观察到的单词。

Transformer encoder不知道它将被要求预测哪些单词或哪些单词已被随机单词替换,因此它被迫保持每个输入token的分布式上下文表示。此外,因为随机替换只发生在所有token的1.5%(即15%的10%),这似乎不会损害模型的语言理解能力。

使用MLM的第二个缺点是每个batch只预测了15%的token,这表明模型可能需要更多的预训练步骤才能收敛。团队证明MLM的收敛速度略慢于 left-to-right的模型(预测每个token),但MLM模型在实验上获得的提升远远超过增加的训练成本。

bert模型的主要创新点都在pre-train方法上,即用了Masked LM和Next Sentence Prediction两种方法分别捕捉词语和句子级别的representation。

下面给出了Transformer Encoder模型的整体结构:

Transformer Encoder

Transformer Encoder

multi-head attention

multi-head attention

Reference

- word2vec 中的数学原理详解

- GloVe详解

- 从Word Embedding到Bert模型—自然语言处理中的预训练技术发展史

- NLP必读 | 十分钟读懂谷歌BERT模型

- 谷歌BERT解析----2小时上手最强NLP训练模型

12. 神经网络基础

1、神经网络中的激活函数:对比ReLU与Sigmoid、Tanh的优缺点?ReLU有哪些变种?

优点:

- 从计算的角度上,Sigmoid和Tanh激活函数均需要计算指数,复杂度高,而ReLU只需要一个阈值即可得到激活值;

- ReLU的非饱和性可以有效地解决梯度消失的问题,提供相对宽的激活边界。

- ReLU的单侧抑制提供了网络的稀疏表达能力。

修正线性单元(Rectified Linear Unit,ReLU):ReLU函数被认为有生物上的解释性,比如单侧抑制、宽兴奋边界(即兴奋程度 也可以非常高)。在生物神经网络中,同时处于兴奋状态的神经元非常稀疏。人 脑中在同一时刻大概只有1 ∼ 4%的神经元处于活跃状态。Sigmoid型激活函数会导致一个非稀疏的神经网络,而ReLU却具有很好的稀疏性,大约50%的神 经元会处于激活状态。

缺点:

- ReLU和Sigmoid一样,它们的输出是非零中心化的,给后一层的神经网络引入偏置偏移, 会影响梯度下降的效率。

- ReLU的局限性在于其训练过程中会导致神经元死亡的问题。

在训练时,如果参数在一次不恰当的更新后,第一个隐藏层中的某个ReLU神经元在所有的训练数据上都不能被激活。那么,这个神经元自身参数的梯度永远都会是 0,在以后的训练过程中永远不能被激活。这种现象称为死亡 ReLU 问题 (Dying ReLU Problem),并且也有可能会发生在其它隐藏层。

ReLU的变种

在实际使用中,为了避免上述情况,有几种ReLU的变种也会被广泛使用:Leaky ReLU、ELU以及softplus函数

ReLU、Leaky ReLU、ELU以及softplus函数

ReLU、Leaky ReLU、ELU以及softplus函数

2、神经网络结构哪几种?各自都有什么特点?

- 前馈网络:整个网络中的信息是朝一个方向传播,没有反向的信息传播,可以用一个有向无环路图表示。前馈网络包括全连接前馈网络和卷积神经网络等。

- 反馈网络:反馈网络中神经元不但可以接收其它神经元的信号,也可以接收自己的反馈信号。和前馈网络相比,反馈网络中的神经元具有记忆功能,在不同的时刻具有不同的状态。馈神经网络中的信息传播可以是单向或双向传递,因此可用一个有向循环图或无向图来表示。反馈网络包括循环神经网络、Hopfield 网络、玻尔兹曼机等。

- 图网络:图网络是定义在图结构数据上的神经网络。图中每个节点都一个或一组神经元构成。节点之间的连接可以是有向的,也可以是无向的。每个 节点可以收到来自相邻节点或自身的信息。 图网络是前馈网络和记忆网络的泛化,包含很多不同的实现方式,比如图卷积网络、消息传递网络等。

前馈网络、反馈网络和图网络

前馈网络、反馈网络和图网络

3、前馈神经网络叫做多层感知机是否合适?

前馈神经网络也经常称为多层感知器(Multi-Layer Perceptron,MLP)。但多层感知器的叫法并不是十分合理,因为前馈神经网络其实是由多层的logistic 回归模型(连续的非线性函数)组成,而不是由多层的感知器(不连续的非线性函数)组成。

4、前馈神经网络怎么划分层?

在前馈神经网络中,各神经元分别属于不同的层。每一层的神经元可以接受前一层神经元的信号,并产生信号输出到下一层。第0层叫输入层,最后一层叫输出层,其它中间层叫做隐藏层。整个网络中无反馈,信号从输入层向输 出层单向传播,可用一个有向无环图表示。

5、如何理解通用近似定理?

通用近似定理《神经网络与深度学习》

通用近似定理《神经网络与深度学习》

通用近似定理:对于具有线性输出层和至少一个使用“挤压”性质的激活函数的隐藏层组成的前馈神经网络,只要其隐藏层神经元的数量足够,它可以以任意的精度来近似任何从一个定义在实数空间中的有界闭集函数。说明:

- 所谓“挤压”性质的函数是指像 sigmoid 函数的有界函数,但神经网络的通用近似性质也被证明对于其 它类型的激活函数,比如ReLU,也都是适用的。

- 通用近似定理只是说明了**神经网络的计算能力可以去近似一个给定的连续函数,但并没有给出如何找到这样一个网络,以及是否是最优的。**此外,当应用到机器学习时,真实的映射函数并不知道,一般是通过经验风险最小化和正则化来进行参数学习。因为神经网络的强大能力,反而容易在训练集上过拟合。

6、怎么理解前馈神经网络中的反向传播?具体计算流程是怎样的?

上式中,误差项 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 来表示第

来表示第 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 层的神经元对最终误差的影响,也反映了最终的输出对第

层的神经元对最终误差的影响,也反映了最终的输出对第 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 层的神经元对最终误差的敏感程度。

层的神经元对最终误差的敏感程度。

前馈神经网络中反向传播的实质就是误差的反向传播: 第 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 层的误差项可以通过第

层的误差项可以通过第 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 层的误差项计算得到,这就是误差的反向传播。

层的误差项计算得到,这就是误差的反向传播。

误差反向传播算法的具体含义是:第 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 层的一个神经元的误差项(或敏感性)是所有与该神经元相连的第

层的一个神经元的误差项(或敏感性)是所有与该神经元相连的第 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 层的神经元的误差项的权重和,然后再乘上该神经元激活函数的梯度。

层的神经元的误差项的权重和,然后再乘上该神经元激活函数的梯度。

出使用随机梯度下降的误差反向传播算法的具体训练过程:

7、卷积神经网络哪些部分构成?各部分作用分别是什么?

如果用全连接前馈网络来处理图像时,会存在以下两个问题:

- 参数太多;

- 局部不变性特征:全连接前馈网络很难提取局部不变特征,一般需要进行数据增强来提高性能。

卷积神经网络一般是由卷积层、汇聚层和全连接层交叉堆叠而成的前馈神经网络,使用反向传播算法进行训练。卷积神经网络有三个结构上的特性:局部连接,权重共享以及子采样。

- 卷积层的作用:局部连接,权重共享;

- 池化层(pooling layer)也叫子采样层(subsampling layer)的作用:进行特征选择,降低特征数量,并从而减少参数数

全连接和局部连接

全连接和局部连接

8、在深度学习中,网络层数增多会伴随哪些问题,怎么解决?为什么要采取残差网络ResNet?

CNN之三大经典网络LeNet-AlexNet-VGG。在VGG中,卷积网络达到了19层,在GoogLeNet中,网络史无前例的达到了22层。那么,网络的精度会随着网络的层数增多而增多吗?随着网络层数的增加,网络发生了退化(degradation)的现象:随着网络层数的增多,训练集loss逐渐下降,然后趋于饱和,当你再增加网络深度的话,训练集loss反而会增大。注意这并不是过拟合,因为在过拟合中训练loss是一直减小的。

(1)在深度学习中,网络层数增多会伴随哪些问题,怎么解决?

- 1 计算资源的消耗(GPU)

- 2 模型容易过拟合(Dropout)

- 3 梯度消失/梯度爆炸问题的产生(批量归一化BN):BN层能对各层的输出做归一化,这样梯度在反向层层传递后仍能保持大小稳定,不会出现过小或过大的情况。

- 4 degradation退化问题:随着网络层数的增多,训练集loss逐渐下降,然后趋于饱和,当你再增加网络深度的话,训练集loss反而会增大。注意这并不是过拟合,因为在过拟合中训练loss是一直减小的。(残差网络ResNet?)

(2)为什么要采取残差网络ResNet?

残差网络ResNet

残差网络ResNet

残差块可以表示为:(参考自详解残差网络)

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png)

对于一个更深的层 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) ,其与

,其与 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 层的关系可以表示为

层的关系可以表示为

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png)

这个公式反应了残差网络的两个属性:

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 层可以表示为任意一个比它浅的l层和他们之间的残差部分之和;

层可以表示为任意一个比它浅的l层和他们之间的残差部分之和;![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) ,

, ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 是各个残差块特征的单位累和,而MLP是特征矩阵的累积。

是各个残差块特征的单位累和,而MLP是特征矩阵的累积。

根据BP中使用的导数的链式法则,损失函数 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 关于

关于 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 的梯度可以表示为

的梯度可以表示为

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png)

上面公式反映了残差网络的两个属性:

- 在整个训练过程中,

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 不可能一直为

不可能一直为 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) ,也就是说在残差网络中不会出现梯度消失的问题。

,也就是说在残差网络中不会出现梯度消失的问题。 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 表示

表示 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 层的梯度可以直接传递到任何一个比它浅的

层的梯度可以直接传递到任何一个比它浅的 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 层。

层。

13. 循环神经网络

1、什么是循环神经网络?循环神经网络的基本结构是怎样的?

循环神经网络(Recurrent Neural Network,RNN)是一类具有短期记忆能力的神经网络。在循环神经网络中,神经元不但可以接受其它神经元的信息,也可以接受自身的信息,形成具有环路的网络结构。和前馈神经网络相比,循环神经网络更加符合生物神经网络的结构。循环神经网络已经被广泛应用在语音识别、语言模型以及自然语言生成等任务上。循环神经网络的参数学习可以通过随时间反向传播算法来学习。随时间反向传播算法即按照时间的逆序将错误信息一步步地往前传递。当输入序列比较长时,会存在梯度爆炸和消失问题,也称为长期依赖问题。为了解决这个问题,人们对循环神经网络,进行了很多的改进,其中最有效的改进方式引入门控机制。此外,循环神经网络可以很容易地扩展到两种更广义的记忆网络模型:递归神经网络和图网络。——《神经网络与深度学习》

循环神经网络

循环神经网络

2、循环神经网络RNN常见的几种设计模式是怎样的?

- 序列到类别模式

- 同步序列到序列模式

- 异步的序列到序列模式

序列到类别模式

序列到类别模式

同步序列到序列模式

同步序列到序列模式

异步的序列到序列模式

异步的序列到序列模式

3、循环神经网络RNN怎样进行参数学习?

随时间反向传播(Backpropagation Through Time,BPTT)算法的主要思想是通过类似前馈神经网络的错误反向传播算法来进行计算梯度。BPTT算法将循环神经网络看作是一个展开的多层前馈网络,其中“每一层”对应循环网络中的“每个时刻”。这样,循环神经网络就可以按按照前馈网络中的反向传播算法进行计算参数梯度。**在“展开”的前馈网络中,所有层的参数是共享的。**因此参数的真实梯度是将所有“展开层”的参数梯度之和。

随时间反向传播BPTT算法示例

随时间反向传播BPTT算法示例

定义 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 为第t 时刻的损失对第k 时刻隐藏神经层的净输入

为第t 时刻的损失对第k 时刻隐藏神经层的净输入 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 的导数,同样对U、W求导时则可得到到随时间反向传播的公式:

的导数,同样对U、W求导时则可得到到随时间反向传播的公式:

4、循环神经网络RNN长期依赖问题产生的原因是怎样的?

RNN产生长期依赖的原因与参数学习BPTT过程有关,实质就是参数U 的更新主要靠当前时刻k 的几个相邻状态 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 来更新,长距离的状态对U 没有影响。将

来更新,长距离的状态对U 没有影响。将 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 展开可得到:

展开可得到:

![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png)

如果令 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) ,则可得到:

,则可得到:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-kc5UQhKi-1602121779849)(https://www.zhihu.com/equation?tex=%5Cdelta_%7Bt%2Ck%7D%3D%5Cgamma%5E%7Bt-k%7D%5Cdelta_%7Bt%2Ct%7D)]

若 [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-s8CAHxVr-1602121779850)(https://www.zhihu.com/equation?tex=%5Cgamma%3E1+)],当 [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-DPoiyaKJ-1602121779851)(https://www.zhihu.com/equation?tex=t%E2%88%92k%5Crightarrow%5Cinfty)] 时,造成系统不稳定,称为梯度爆炸问题(Gradient Exploding Problem);相反,若 [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-TvPLRsvc-1602121779853)(https://www.zhihu.com/equation?tex=%5Cgamma%3C1+)],当 [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-GQjQdLKP-1602121779853)(https://www.zhihu.com/equation?tex=t%E2%88%92k%5Crightarrow%5Cinfty)] 时会出现和深度前馈神经网络类似的梯度消失问题(gradient vanishing problem)。

在循环神经网络中的梯度消失不是说 [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-d1cE8kEn-1602121779853)(https://www.zhihu.com/equation?tex=%5Cfrac%7B%5Calpha+L%7D%7B%5Calpha+U%7D)] 的梯度消失了,而是 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 的梯度消失了当

的梯度消失了当 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 。也就是说,参数U 的更新主要靠当前时刻k 的几个相邻状态

。也就是说,参数U 的更新主要靠当前时刻k 的几个相邻状态 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 来更新,长距离的状态对U 没有影响。

来更新,长距离的状态对U 没有影响。

5、RNN中为什么要采用tanh而不是ReLu作为激活函数?为什么普通的前馈网络或 CNN 中采取ReLU不会出现问题?

由 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 可以得到,当使用ReLU作为激活函数时,

可以得到,当使用ReLU作为激活函数时, ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) ,只要

,只要 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 不是单位矩阵,梯度还是会出现消失或者爆炸的现象。

不是单位矩阵,梯度还是会出现消失或者爆炸的现象。

当采用ReLU作为循环神经网络中隐含层的激活函数时,**只有当 ![[公式]](https://i-blog.csdnimg.cn/blog_migrate/cb56e2aedc07e11d727c0c14713b7e1b.png) 的取值在单位矩阵附近时才能取得比较好的效果,因此需要将 [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-IHxjx6W3-1602121779862)(https://www.zhihu.com/equation?tex=U)] 初始化为单位矩阵。**实验证明,初始化W为单位矩阵并使用ReLU激活函数在一些应用中取得了与长短期记忆模型相似的结果,并且学习速度比长短期记忆模型更快,是一个值得尝试的小技巧。

的取值在单位矩阵附近时才能取得比较好的效果,因此需要将 [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-IHxjx6W3-1602121779862)(https://www.zhihu.com/equation?tex=U)] 初始化为单位矩阵。**实验证明,初始化W为单位矩阵并使用ReLU激活函数在一些应用中取得了与长短期记忆模型相似的结果,并且学习速度比长短期记忆模型更快,是一个值得尝试的小技巧。

那么为什么普通的前馈网络或 CNN 中采取ReLU不会出现梯度消失或梯度爆炸的问题呢?

类似前馈神经网络中的误差反向传播:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-FUPRZfBV-1602121779862)(https://pic4.zhimg.com/80/v2-6e664bccf536e3bca81c60d649f889db_720w.jpg)]

因为他们每一层的 W 不同,且在初始化时是独立同分布的,因此可以在一定程度相互抵消。即使多层之后一般也不会出现数值问题。

6、循环神经网络RNN怎么解决长期依赖问题?LSTM的结构是怎样的?LSTM又有哪些变种的?

RNN中的长期依赖问题,也就是梯度消失或梯度爆炸可以采取如下方法解决:

-

RNN梯度爆炸的解决方法:梯度截断

-

RNN梯度消失的解决方法;残差结构、门控机制(LSTM、GRU)

为了RNN中的长期依赖问题,一种非常好的解决方案是引入门控Hochreiter and Schmidhuber 来控制信息的累积速度,包括有选择地加入新的信息,并有选择地遗忘之前累积的信息。这一类网络可以称为基于门控的循环神经网络(Gated RNN)。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-aTiD6vou-1602121779862)(https://pic1.zhimg.com/80/v2-5c3b956dff7a2a7235387d562db7e918_720w.jpg)]

长短期记忆(LSTM)结构

长短期记忆(LSTM)网络和门控循环单元(GRU)网络是两种主要的基于门控的循环神经

网络。LSTM的结构如上图所示,LSTM三个门的作用是:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-knwlbevR-1602121779864)(https://pic4.zhimg.com/80/v2-93d4c22c5245fe149a34695a850afe6b_720w.jpg)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-6DLAQORE-1602121779864)(https://pic3.zhimg.com/80/v2-0d8a13831d598a7ffc62f2ccf752c8d2_720w.jpg)]

7、怎么理解“长短时记忆单元”?RNN中的隐状态 [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-V9xLu29E-1602121779865)(https://www.zhihu.com/equation?tex=h_t)] 与LSTM中的记忆状态 [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-J9eoOpPu-1602121779865)(https://www.zhihu.com/equation?tex=C_t)] 有什么区别?

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-5otMfwbt-1602121779866)(https://www.zhihu.com/equation?tex=h_t)] 为短期记忆, [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-UVAsGNwW-1602121779866)(https://www.zhihu.com/equation?tex=C_t)] 记忆能力由于[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-21r6EUHH-1602121779867)(https://www.zhihu.com/equation?tex=h_t)] ,但又远远短于长期记忆,因此被称为长的短时记忆。

记忆循环神经网络中的隐状态h存储了历史信息,可以看作是一种记忆(memory)。在简单循环网络中,隐状态每个时刻都会被重写,因此可以看作是一种短期记忆(short-term memory)。在神经网络中,长期记忆(long-term memory)可以看作是网络参数,隐含了从训练数据中学到的经验,并更新周期要远远慢于短期记忆。而在LSTM网络中,记忆单元c 可以在某个时刻捕捉到某个关键信息,并有能力将此关键信息保存一定的时间间隔。记忆单元c 中保存信息的生命周期要长于短期记忆h,但又远远短于长期记忆,因此称为长的短期记忆(long short-term memory)。

8、LSTM与GRU关系是怎样的?

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-a9Lbj5q8-1602121779867)(https://pic3.zhimg.com/80/v2-34c93e858b69c4129f9ff604288beab2_720w.jpg)]GRU结构

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-QF2H16Wz-1602121779867)(https://pic4.zhimg.com/80/v2-3ec711bb9f1b74a1391c362553df870b_720w.jpg)]

- GRU 把遗忘门和输入门合并为更新门(update)

z,并使用重置门(reset)r代替输出门; - 合并了记忆状态

C和隐藏状态h

14. 神经网络的训练技巧及优化问题

神经网络主要的问题集中在优化问题和正则化问题。

(1)优化问题:神经网络模型是一个非凸函数,再加上在深度网络中的梯度消失问题,很难进行优化;另外,深层神经网络模型一般参数比较多,训练数据也比较大,会导致训练的效率比较低。

(2)泛化问题:因为神经网络的拟合能力强,反而容易在训练集上产生过拟合。因此,在训练深层神经网络时,同时也需要通过一定的正则化方法来改进网络的泛化能力。

对应的优化问题有:

- 1)如何初始化参数;

- 2)预处理数据;

- 3)如何避免陷入局部最优?(学习率衰减+梯度方向优化)

具体展开讨论如下:

1、神经网络优化的难点体现在哪里?

深层神经网络是一个高度非线性的模型,其风险函数是一个非凸函数,因此风险最小化是一个非凸优化问题,会存在很多局部最优点。在高维空间中,非凸优化的难点并不在于如何逃离局部最优点,而是如何逃离鞍点。

2、神经网络数据预处理方法有哪些?神经网络怎样进行参数初始化?参数初始化为0、过大、过小会怎样?

(1)神经网络数据预处理方法有哪些?

- 缩放归一化:通过缩放将每一个特征的取值范围归一到[0, 1] 或[−1, 1] 之间

- 标准归一化:将每一个维特征都处理为符合标准正态分布(均值为0,标准差为1)。

- 白化(Whitening):是一种重要的预处理方法,用来降低输入数据特征之间的冗余性。输入数据经过白化处理后,特征之间相关性较低,并且所有特征具有相同的方差。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-M8o19uov-1602121779868)(https://pic3.zhimg.com/80/v2-ad87adc0906a9254633eb25e68444f6a_720w.jpg)]

(2)参数初始化为0、过大、过小会怎样?

- 参数为0:在第一遍前向计算时,所有的隐层神经元的激活值都相同。这样会导致深层神经元没有区分性。这种现象也称为对称权重现象。

- 参数过大或过小:参数过小还会使得sigmoid型激活函数丢失非线性的能力,这样多层神经网络的优势也就不存在了。如果参数取得太大,会导致输入状态过大。对于sigmoid 型激活函数来说,激活值变得饱和,从而导致梯度接近于0。

(3)经常使用的初始化方法有以下几种:

- Gaussian 分布初始化:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-gKRolHPk-1602121779869)(https://pic4.zhimg.com/80/v2-2d167be29b476ba0b13a97385b48fba7_720w.jpg)]

- Xavier均匀分布初始化:参数可以在[−r, r] 内采用均匀分布进行初始化

对于sigmoid 型激活函数:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-JNapX84e-1602121779870)(https://pic2.zhimg.com/80/v2-85ea5086dac1f5d11a03094c771c8ef1_720w.jpg)]

对于tanh函数:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-20LQVAYV-1602121779870)(https://pic3.zhimg.com/80/v2-19d992d087999588abc9c320c54bd9a2_720w.jpg)]

3、神经网络优化方法有哪些?

几种优化方法大体上可以分为两类:一是调整学习率,使得优化更稳定;二是调整梯度方向,优化训练速度。如图所示:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ULY03AuJ-1602121779870)(https://pic3.zhimg.com/80/v2-db5d3eceb2a13b3aec51f9a8879da3fe_720w.jpg)]

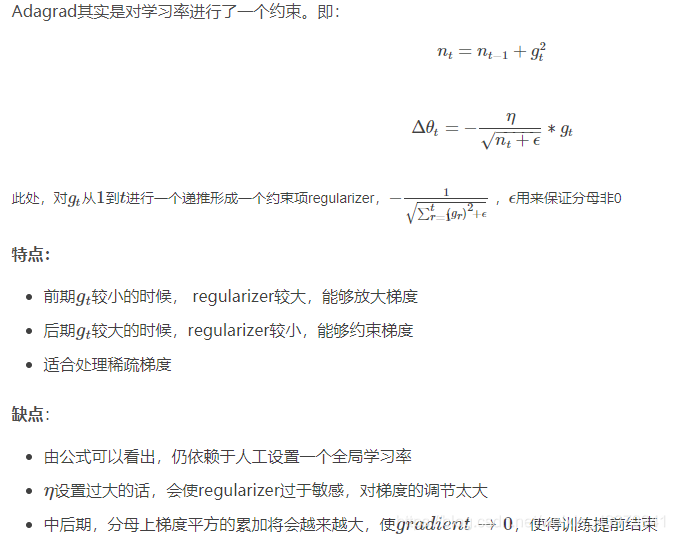

- AdaGrad:Adagrad 算法的缺点是在经过一定次数的迭代依然没有找到最优点时,由于这时的学习率已经非常小,很难再继续找到最优点。在第t 迭代时,计算每个参数梯度平方的累计值:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-m7Hq84wd-1602121779871)(https://pic2.zhimg.com/80/v2-9c8a88bd2709c66b7a251455ac27c195_720w.jpg)]

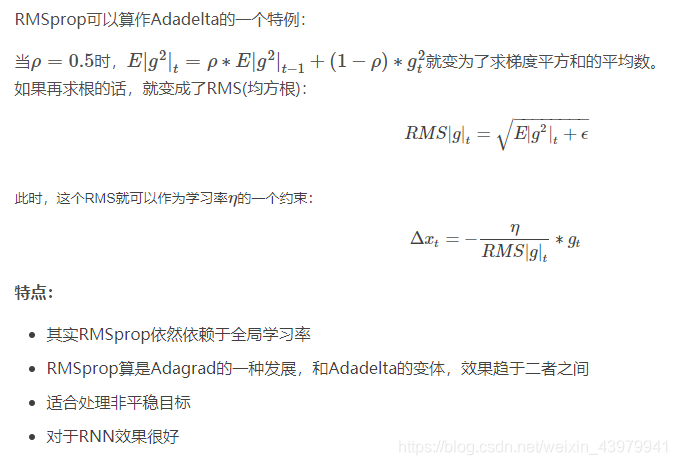

- RMSprop:计算每次迭代梯度gt 平方的指数衰减移动平均:

- 动量法:用梯度的移动平均来代替每次的实际梯度:

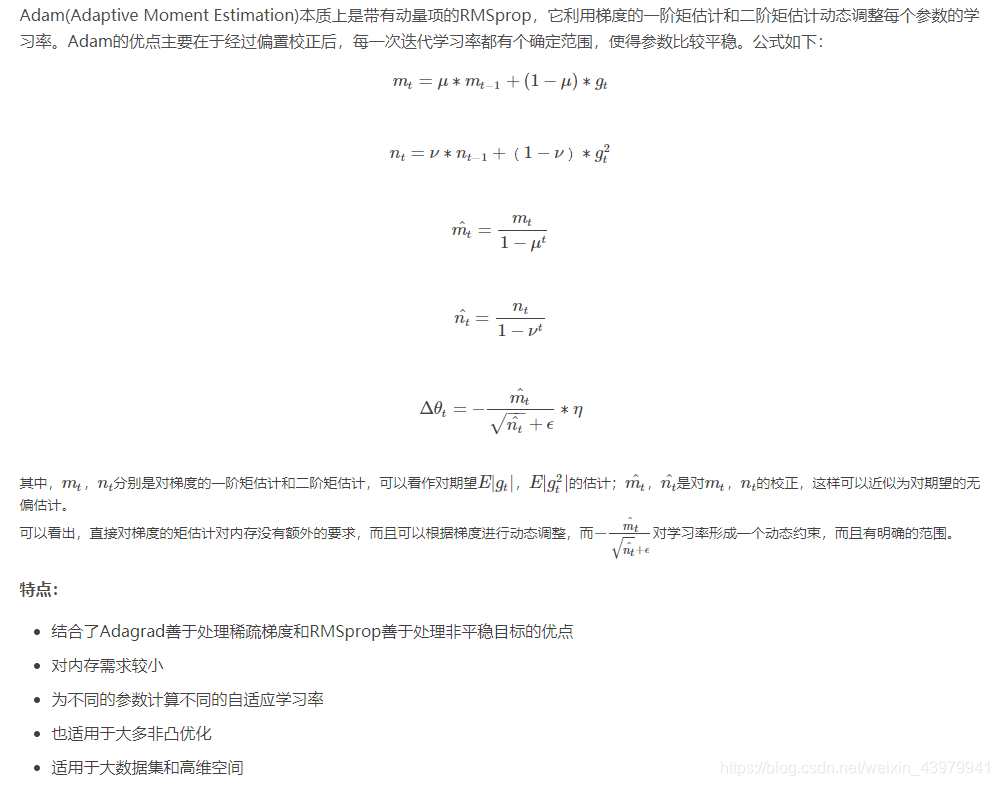

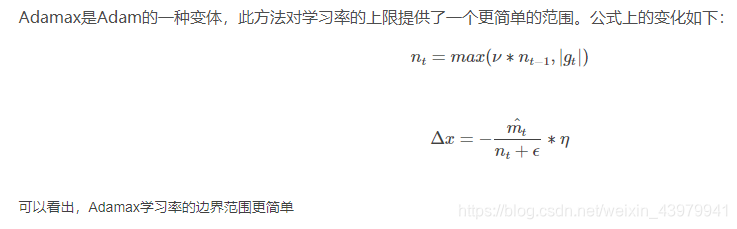

- Adam:Adam 算法一方面计算梯度平方的指数加权平均(和RMSprop 类似),另一方面计算梯度gt 的指数加权平均(和动量法类似)

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-qQUCN5v2-1602121779872)(https://pic3.zhimg.com/80/v2-95682f5a103283db3c23ec24e95c4c32_720w.jpg)]

4、请介绍逐层归一化(Batch Normalization和Layer Normalization)?

(1)为什么要进行逐层归一化?什么是内部协变量偏移?

在深层神经网络中,中间某一层的输入是其之前的神经层的输出。因此,其之前的神经层的参数变化会导致其输入的分布发生较大的差异。在使用随机梯度下降来训练网络时,每次参数更新都会导致网络中间每一层的输入的分布发生改变。越深的层,其输入的分布会改变得越明显。就像一栋高楼,低楼层发生一个较小的偏移,都会导致高楼层较大的偏移。

协变量偏移:协变量是一个统计学概念,是可能影响预测结果的统计变量。 在机器学习中,协变量可以看作是输入。一般的机器学习算法都要求输 入在训练集和测试集上的分布是相似的。如果不满足这个要求,这些学 习算法在测试集的表现会比较差。

从机器学习角度来看,如果某个神经层的输入分布发生了改变,那么其参数需要重新学习,这种现象叫做内部协变量偏移。

内部协变量偏移会导致什么问题?

简而言之,每个神经元的输入数据不再是“独立同分布”。

- 上层参数需要不断适应新的输入数据分布,降低学习速度。

- 下层输入的变化可能趋向于变大或者变小,导致上层落入饱和区,使得学习过早停止。

- 每层的更新都会影响到其它层,因此每层的参数更新策略需要尽可能的谨慎。

为了解决内部协变量偏移问题,就要使得每一个神经层的输入的分布在训练过程中要保持一致。最简单直接的方法就是对每一个神经层都进行归一化操作,使其分布保存稳定。下面介绍几种比较常用的逐层归一化方法:批量归一化、层归一化。层归一化和批量归一化整体上是十分类似的,差别在于归一化的方法不同。

动机

- 训练的本质是学习数据分布。如果训练数据与测试数据的分布不同会降低模型的泛化能力。因此,应该在开始训练前对所有输入数据做归一化处理。

- 而在神经网络中,因为每个隐层的参数不同,会使下一层的输入发生变化,从而导致每一批数据的分布也发生改变;致使网络在每次迭代中都需要拟合不同的数据分布,增大了网络的训练难度与过拟合的风险。

(2)批量归一化(Batch Normalization,BN)的主要作用是什么?主要原理是什么?

BN 是一种正则化方法(减少泛化误差),主要作用有:

- 加速网络的训练(缓解梯度消失,支持更大的学习率)

- **防止过拟合:**BN 可以看作在各层之间加入了一个新的计算层,对数据分布进行额外的约束,从而增强模型的泛化能力;

- 降低了参数初始化的要求。

基本原理

- BN 方法会针对每一批数据,在网络的每一层输入之前增加归一化处理,使输入的均值为

0,标准差为1。目的是将数据限制在统一的分布下。 - 具体来说,针对每层的第

k个神经元,计算这一批数据在第k个神经元的均值与标准差,然后将归一化后的值作为该神经元的激活值。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-BE7dPO7z-1602121779874)(https://pic2.zhimg.com/80/v2-b9a1fcbeead480142688e0cbe182da61_720w.jpg)]

- BN 可以看作在各层之间加入了一个新的计算层,对数据分布进行额外的约束,从而增强模型的泛化能力;

- 但同时 BN 也降低了模型的拟合能力,破坏了之前学到的特征分布;为了恢复数据的原始分布,BN 引入了一个重构变换来还原最优的输入数据分布

其中 γ 和 β 为可训练参数。

(3)BN 在训练和测试时分别是怎么做的?

- 训练时每次会传入一批数据,做法如前述;训练时不采用移动平均,使用 BN 的目的就是为了保证每批数据的分布稳定,使用全局统计量反而违背了这个初衷;

- 当测试或预测时,每次可能只会传入单个数据,此时模型会使用全局统计量代替批统计量(移动平均(moving averages))

5、神经网络正则化的方法有哪些?

- L1 和L2 正则化:L1 和L2 正则化是机器学习中最常用的正则化方法,通过约束参数的L1 和L2 范数来减小模型在训练数据集上的过拟合现象

- Batch Normalization(同上)

- 提前停止: 当验证集上的错误率不再下降,就停止迭代。

- Dropout:集成学习的解释:每做一次丢弃,相当于从原始的网络中采样得到一个子网络。每次迭代都相当于训练一个不同的子网络,这些子网络都共享原始网络的参数。那么,最终的网络可以近似看作是集成了指数级个不同网络的组合模型。当在循环神经网络上应用丢弃法,不能直接对每个时刻的隐状态进行随机丢弃,这样会损害循环网络在时间维度上记忆能力。一种简单的方法是对非时间维度的连接(即非循环连接)进行随机丢失:

虚线边表示进行随机丢弃,不同的颜色表示不同的丢弃掩码

虚线边表示进行随机丢弃,不同的颜色表示不同的丢弃掩码

- 数据增强: 增加数据量,提高模型鲁棒性,避免过拟合。目前,数据增强还主要应用在图像数据上,在文本等其它类型的数据还没有太好的方法。

- 标签平滑:在输出标签中添加噪声来避免模型过拟合。

6、神经网络怎么解决梯度消失问题?

- 选择合适的激活函数:前馈神经网络:ReLU 循环神经网络:tanh

- Batch Normalization

- 采取残差网络ResNet

15-1.详解BiLSTM及代码实现

一、介绍

1.1 文章组织