Spark集群搭建

一、搭建Spark的准备环境

1、在实验中我使用的系统是Ubuntu14.04,是在虚拟机上远程访问服务器,是安装在服务器上的(因为自己电脑的配置没有服务器的高)。至于下载地址,可以在Ubuntu官网上自行下载。

2、因为Spark的运行需要在HDFS分布式系统上运行,这样就不可避免的需要搭建Hadoop集群,并且需要yarn的支持。所以需要先搭建hadoop,因为之前我已经搭建好了hadoop集群。实验中使用的是hadoop2.7.1版本。

3、需要安装Scala,因为后边会用到它来编写程序,并且Spark的源代码也是用Scala编写的。(搭建hadoop集群的时候已经安装过了Scala,所以这里不再介绍)

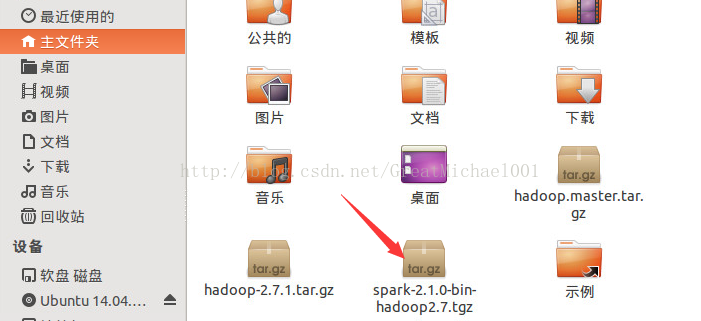

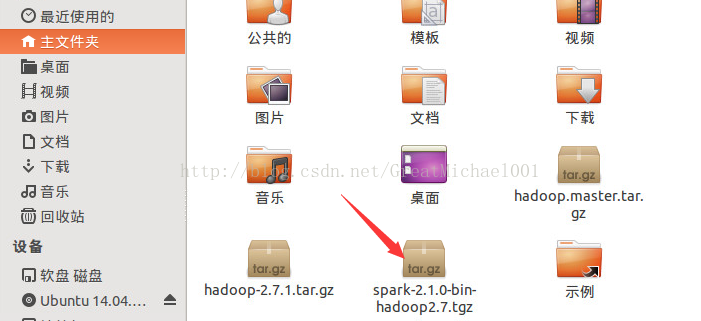

4、下载Spark,实验中我使用的是Spark2.1.0的最新版本。(spark-2.1.0-bin-hadoop2.7.1.tgz)下载地址:

http://mirror.bit.edu.cn/apache/spark/

二、安装spark

1、先说一下,Master和Slave们的IP地址

|

59.67.77.12

|

Master

|

|

59.67.77.15

|

Slave1

|

|

59.67.77.16

|

Slave2

|

|

59.67.77.17

|

Slave3

|

2、在Master上搭建spark

将下载好的spark解压,解压到 /usr/local/文件夹(刚才下载好的spark是在之文件夹中的)如图所示:

$ sudo tar -zxf spsrk-2.1.0-bin-hadoop2.7.tgz -C /usr/local

本文详细介绍了如何在Ubuntu14.04虚拟机上搭建Spark2.1.0集群,包括准备环境(Ubuntu、Hadoop2.7.1、Scala)、安装Spark、配置环境变量、修改相关配置文件、分发到Slave节点以及启动和测试Spark集群的过程。

本文详细介绍了如何在Ubuntu14.04虚拟机上搭建Spark2.1.0集群,包括准备环境(Ubuntu、Hadoop2.7.1、Scala)、安装Spark、配置环境变量、修改相关配置文件、分发到Slave节点以及启动和测试Spark集群的过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1473

1473

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?