Platt Scaling 的相关问题详解 | 模型校准中的隐患分析

在机器学习模型中,模型预测的“置信度”并不一定等于真实的概率。为了提高模型预测结果的可解释性和实用性,我们通常会使用一种后处理的概率校准方法——Platt Scaling(普拉托变换)。

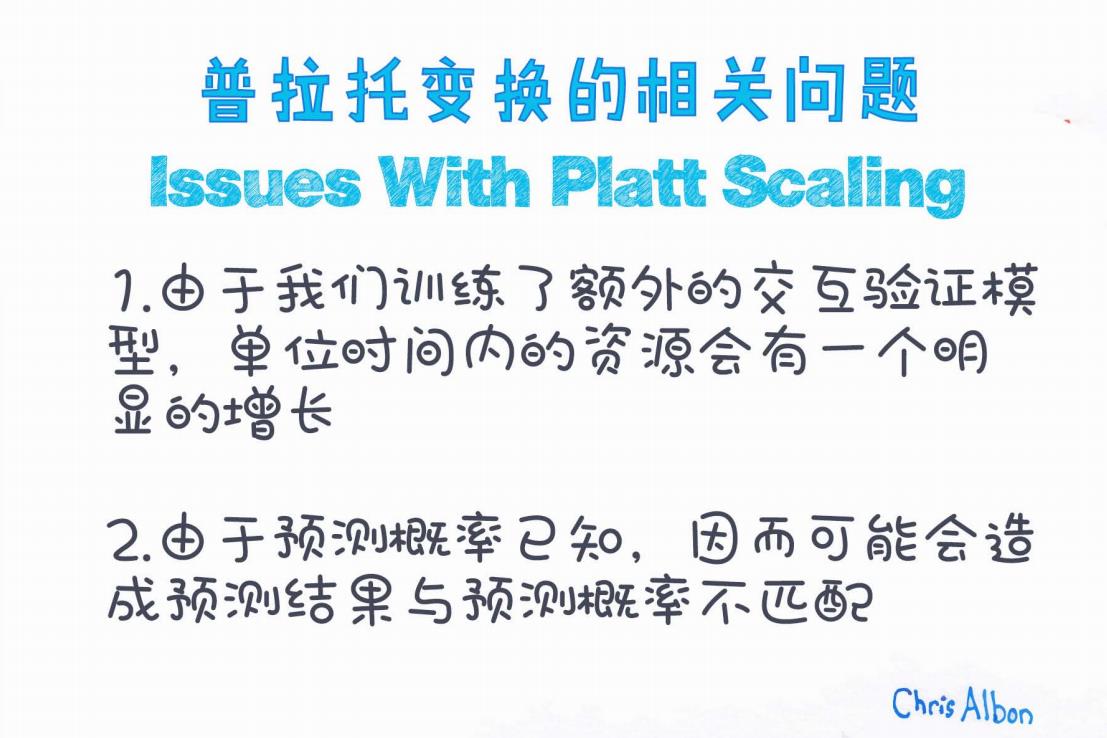

然而,Platt Scaling 虽然常用,也并非万能。在实践中,它可能会带来一些潜在的问题。本文将结合下图,详细分析使用 Platt Scaling 时常见的两个关键问题。

一、Platt Scaling 简介

Platt Scaling 是一种基于逻辑回归的概率校准方法。它的核心思想是:

在模型已经输出一个打分(如 SVM 的输出距离)之后,再训练一个逻辑回归模型来将这些分数映射为概率。

数学形式为:

其中,ff 是原模型输出的打分,AA、BB 是通过最小化负对数似然(NLL)训练得到的参数。

二、问题一:资源消耗显著增加

“由于我们训练了额外的交叉验证模型,单位时间内的资源会有一个明显的增长。”

解读:

Platt Scaling 在实际应用时,为了避免过拟合,通常会采用交叉验证(如 3-fold、5-fold)来训练概率校准模型。也就是说,在原有模型训练之外,还需要构建若干个额外模型用于拟合 Platt Scaling 的 A 和 B 参数。

影响:

-

训练资源消耗:需要更多的计算资源(如 CPU/GPU、内存);

-

训练时间延长:模型训练周期变长,尤其在大规模数据集上;

-

部署复杂性增加:多模型串联带来的管理复杂性。

建议:

-

如果资源有限,可考虑使用更轻量的校准方法,如 Isotonic Regression;

-

对模型部署进行优化,比如提前离线训练好校准模型,仅保存参数 A 和 B。

三、问题二:预测概率已知可能导致失真

“由于预测概率已知,因此可能会造成预测结果与预测概率不匹配。”

解读:

Platt Scaling 的目标是将模型输出映射为概率。但因为训练过程中,目标是最小化负对数似然损失(NLL),这可能导致模型更关注概率拟合而非最终分类正确性。

此外,在某些数据分布不平衡的情况下,Platt Scaling 会受到过拟合干扰。例如,极端样本过多时,预测概率会被“压缩”或“放大”,与实际预测结果不一致。

举例说明:

假设原始模型对某个样本打分是 2.5,意味着分类器非常自信。但经过 Platt Scaling 后,映射的概率可能只有 0.6。这会影响到后续使用这些概率的任务,比如排序、风险评估等。

建议:

-

对不平衡数据进行重采样或加权训练;

-

考虑使用温度缩放(Temperature Scaling),对预测概率进行平滑调整;

-

对比不同校准方法在验证集上的表现,再决定是否采用 Platt Scaling。

四、结语

Platt Scaling 是一种经典且有效的概率校准方法,但它并非完美。在使用时,我们应充分了解其带来的代价和潜在失配问题,合理评估其适用性。

优点:

-

简单易实现;

-

理论基础扎实;

-

通常对 SVM 等 margin-based 模型效果较好。

缺点:

-

增加训练资源需求;

-

对小样本、偏态分布不鲁棒;

-

在某些场景下可能失真模型原始置信度。

延伸阅读

-

Guo et al. (2017): On Calibration of Modern Neural Networks

-

sklearn.calibration — CalibratedClassifierCV 文档

如果你在实际工作中也遇到过模型置信度不准的问题,欢迎留言分享你的解决思路与经验!

如需转载请注明出处,图片版权归 Chris Albon 所有。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?