论文笔记:基于条件生成对抗网络的遥感图像灵活参考不敏感时空融合模型。

一:摘要

针对遥感图像时空分辨率的权衡问题,提出了一种基于时空融合模型的高时空影像序列合成方法。目前,时空融合模型通常采用在预测日期获取的一张粗分辨率图像和至少另一对接近预测时间的粗-细分辨率图像作为参考来导出预测日期的细分辨率图像。经过多年的发展,模型精度得到了一定的提高,但几乎所有模型都需要至少3个图像输入,并且必须对参考点施加严格的时间约束以保证融合精度。然而,在实际应用中,由于恶劣的天气条件或粗-细分辨率数据源之间的时间不一致,很难收集到足够的数据对进行精细分辨率图像序列模拟,这给实际应用带来了一定的困难。

本文将条件生成对抗网络(CGAN)和可切换归一化技术引入到时空融合问题中,提出了一种灵活的深度网络——基于条件生成对抗网络的时空融合模型(GAN-STFM),以减少模型输入的数量,打破参考图像选择的时间限制。GAN-STFM只需要预测日期的粗分辨率图像和同一区域任意时间的细分辨率参考图像作为模型输入。据我们所知,这是第一个只需要两幅图像作为模型输入,并且对参考点的获取时间没有限制的时空融合模型。即便如此,GAN-STFM在实验中的表现与其他经典聚变模型相当或更好。

这使得时空融合的数据准备工作比以前容易得多,在实际应用中具有广阔的前景。

索引术语-条件生成对抗网络(CGAN),卷积神经网络(CNN),数据融合,深度学习,基于生成对抗网络(GAN)的时空融合模型(GAN- stfm),遥感,时空。

二:介绍

基于深度学习技术的融合模型可以在现代计算硬件加速下,从海量归档数据集中学习隐含的复杂规则和关系,大大提高了计算机建模的效率和准确性[23]。将深度卷积神经网络(deep convolutional neural network, CNN)引入到遥感图像融合问题中,可以显著提高模型的精度,显示出很有前景的研究方向[8],[10],[21],[22]。然而,许多时空融合模型被训练成对理想数据集进行预测,而忽略了某些研究领域难以收集到令人满意的数据。目前,几乎所有的模型都需要至少三张输入图像,并且为了保证融合精度,必须对参考图像的选择施加严格的约束。

然而,在实践中,由于天气条件恶劣、研究区域数据缺失、粗-细分辨率数据源时间不一致等原因,想要在连续一段时间内收集到足够的数据对并不容易[24]。因此,需要减轻参考图像在时空融合问题中的强烈时间依赖性。为此,本文利用生成对抗网络(GAN)的思想和归一化技术来改善上述问题。本文提出了一种基于gan的时空融合模型(GAN-STFM),并与现有的时空融合模型进行了比较,验证了其有效性。这篇文章的贡献是双重的。

首先,将GAN架构引入时空融合域,对模型输出进行细化;其次,与现有的时空融合模型不同,消除了对参考图像获取时间的限制;使用GAN-STFM,为融合模型准备输入数据可以减少工作量。我们认为,参考不敏感的融合方法可以为未来的研究提供参考,并具有很好的实际应用前景。

本文的其余部分组织如下。第二节介绍了GAN的基础知识和GAN- stfm的详细架构。第三节详细介绍了模型结果的分析和比较。

第四部分总结了结论和未来的工作。

三:材料和方法

A:生成对抗网络

GAN最早由Goodfellow等人提出[25],随后基于GAN的应用出现爆炸式增长,如图像生成[26]、超分辨率[27]、去噪[28]、喷漆[29]、图像到图像翻译[30]等,显示出其强大的建模能力。GAN,顾名思义,是一种生成模型。它是在生成器和判别器的竞争过程中训练的,其中判别器被设计用来区分训练样本之间生成器的输出,同时生成器根据判别器的反馈努力生成与真实样本分布相似的假数据。通过这种反复的竞争性训练,它们都变得更强,最终整个系统达到一种平衡状态。

最后,生成器可以产生与真实样本几乎相同的假输出,而鉴别器无法区分真实和假样本。从本质上讲,GAN可以被视为一个两人的零和游戏。

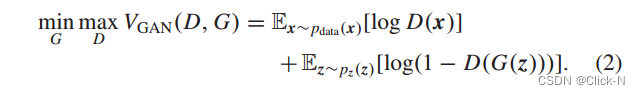

在数学上,生成器G将一些有噪声的数据z作为输入,在真实的训练样本x上学习一个复杂的映射函数,并尝试将有噪声数据pz(z)的分布映射到真实数据Pdata(x)的分布。同时,判别器D作为二值分类器来区分生成的假数据G(z)和真实样本x。也就是说,生成器的目标是最小化G(z)和x之间的分布距离,而判别器的目标是最大化它们之间的分布。因此,香草GAN采用极小极大损失函数,公式为(2),同时训练生成器和鉴别器[25]

香草GAN损失函数通过引子下的Jensen-Shannon (JS)散度测量分布距离。由于没有对解空间的额外约束,在实践中,香草GAN的模型训练稳定性较弱[31]。随后,许多研究致力于探索对香草GAN施加限制以提高其性能的可能解决方案。例如,条件GAN (conditional GAN, CGAN)[32]向生成器和鉴别器同时输入一个额外的数据y作为条件标签,驱动网络沿预期方向搜索最优解,解决了普通GAN无法控制生成的数据模式的问题。CGAN的损失函数记为(3)。最小二乘GAN (LSGAN)[33]是另一种GAN变体,对损失函数进行了较小的修改,以提高GAN的稳定性。实践表明,与vanilla GAN相比,LSGAN可以产生更高质量的结果,特别是对于图像相关的任务[33],[34]。因此,在GAN-STFM训练中,我们采用了它来代替原来的Minimax损失。LSGAN损失函数表达式为(4),其中a、b、c为常数,满足b−c = 1和b−a = 2的条件[33]

B: GAN-STFM的架构

(1))模型设计:理论上,图像可以分解为粗近似和精细细节。在时空融合问题中,预测日期上的粗分辨率图像可以作为近似部分,而预测日期上的地面细节需要从细分辨率参考图像中进行推测。参考不敏感模型的主要思想是利用深度模型从细分辨率参考图像中提取共同的高通特征,然后得到预期的融合结果。在研究区参考时段和预测时段地物形态变化不大的假设下,结合对预测日期的逼近和任意精细分辨率参考影像的共同细节。基于这一思想,本文将CGAN和归一化技术引入到遥感时空融合问题中,提出了一种具有较大灵活性的GAN-STFM模型,以缓解现有融合模型中参考图像和预测图像之间较强的时间依赖性。图2从概念上展示了参考不敏感的时空融合方法。数学上,参考不敏感模型可表示为(5),其中Ft和Ct分别表示预测日期时间t的合成精细分辨率图像和观测粗分辨率图像,Ft表示时间t (t = t)的任意精细分辨率图像作为参考,函数f表示学习到的输入与输出之间的映射关系。通过与(1)的比较可以看出,GAN-STFM模型比传统的时空融合方法在形式上要简单得多。

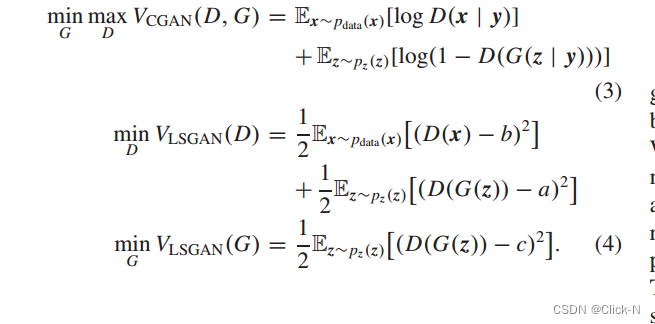

当然,所提出的GAN-STFM网络需要一个生成器和鉴别器,如图3所示,它们都是基于ResNet[35]构建块构建的。

在ResNet中,输入(s)和输出(s)之间的关系不是直接建立的,而是通过跳过连接来学习输入(s)和输出(s)之间的残差。由于残差结构的存在,极大地缓解了深度网络中梯度消失和爆炸的问题。

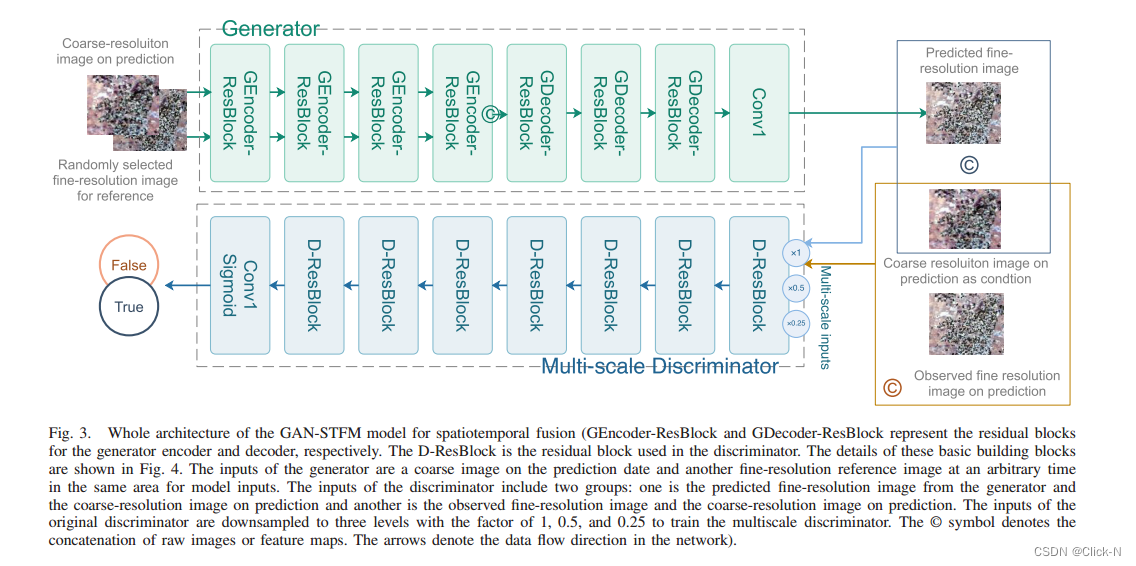

用于构成GAN模型的基本ResNet块如图4所示。生成器中涉及两个不同的构建块,因为从概念上讲,生成器可以分为编码器和解码器。编码器采用主分支提取共同高通特征,然后将共同高通特征加入到侧向分支的图像特定近似中生成中间精细特征。图4(a)显示了这一过程(GEncoder-ResBlock),即将任意供参考的精细分辨率图像输入主分支,而预测日期的粗分辨率图像则通过侧分支。

将粗逼近特征分别发送到下一个相邻块中。这种分离的目的是在前向传播中尽可能地保持粗谱信息。在编码器的最后,在抽象的高级空间中提取调整后的精细特征和粗糙特征,然后将其连接并传递给解码器。在解码器中,连接的特征同时经过主分支和侧分支。添加中间特征,然后发送到下一个残差块。生成器解码器采用的构建块(GDecoder-ResBlock)如图4(b)所示,与原始ResNet架构中使用的构建块相同。

生成器由堆叠的剩余块构成,如图3所示。生成器中的前四个块使用gencode - resblocks组成编码器,其余四个块使用GDecoderResBlocks组成解码器。生成编码器和解码器架构之间的另一个区别在于可切换的规范化,

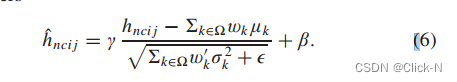

如图4所示。在生成编码器中使用它来强制模型过滤掉特定于样本的信息,只提取常见的高通细节。可切换归一化是一种由任务和数据驱动的可学习的归一化方法,记为(6)[36],其中hnci j和nhci j分别为归一化前后坐标为(n, c,i, j)的特征值;表示用不同归一化方式估计的一类统计量,包括批归一化[37]、层归一化[38]和实例归一化[39];μ和σ分别为均值和标准差;β和γ分别为位移和尺度参数;wk和w k是可学习的权值,可以用不同的方法对统计量进行估计。由(6)可以看出,可切换归一化统一了现有的三种特征归一化方法,适用于期望提取共同特征的情况。

归一化层后的激活是漏整流线性单元(LeakyReLU)函数[40],该函数在CNN模型中被广泛使用。主分支中的Conv3层,如图4所示,表示核大小为3 × 3的普通卷积操作。侧向分支中使用的Conv1是在不引入太多参数的情况下,调整特征映射的通道以匹配侧向分支的输出。

鉴别器是由几个d - resblock组成的普通二值分类器。在每个残差块中使用批归一化,如图4(c)所示,以泛化模型。

StridedConv3表示内核大小为3×3,步长为2的卷积操作,以减小特征大小。

鉴别器的独特结构是在GAN训练中使用谱归一化来稳定对抗过程。将谱归一化应用于卷积操作的权重,而不是中间特征映射,以保证学习到的隐函数的Lipschitz连续性[41]。鉴别器的输入是预测日期的粗分辨率图像和预测图像的细分辨率地面真值。预测日期上的粗分辨率图像作为指导训练过程的条件。对于最后一个s形激活,鉴别器将输入图像映射到假组和真组的概率。除此之外,GAN-STFM中还采用了[42]中引入的多尺度鉴别器来增强输出图像的古色古香。将鉴别器的条件输入下采样到因子为0.5和0.25的两个不同尺度,用于在不同尺度上训练三个具有相同架构的鉴别器,如图3所示。

Loss function:

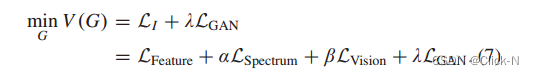

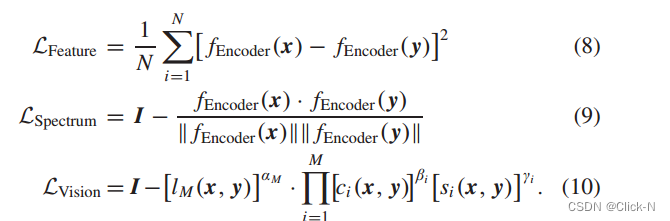

损失函数:在GAN-STFM模型中选择性地使用LSGAN损失函数,并对图像内容进行附加约束。鉴别器的损耗计算与LSGAN中的相应部分相同,而发生器的损耗是由相应的LSGAN部分(LGAN)和对图像本身的约束(LI)复合而成的。图像本身的损失包括特征损失(LFeature)、光谱角度损失(LSpectrum)以及视觉损失(LVision)[10]。因此,总损失为发生器可表示为(7),其中α、β、β为权重系数

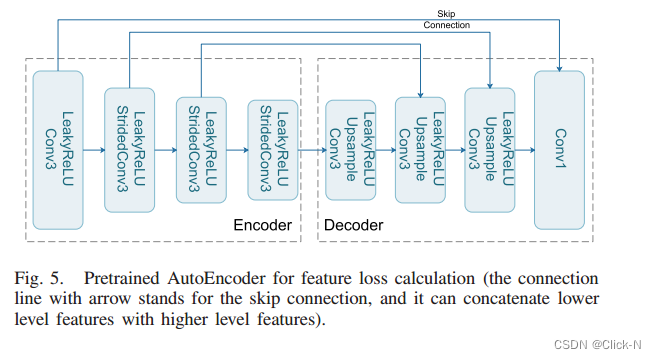

利用特征损失捕获感知差异,生成高质量图像。它可以借助相关的自动编码器进行计算,减少了抽象高特征级的差异。预训练的AutoEncoder也由一个编码器和一个解码器组成,它被构造为一个具有跳跃连接的全卷积网络,形成一个经典的“沙漏”结构,如图5所示。编码器中stride为2的StridedConv3层用于将特征大小缩小一半,而解码器中的Conv3层以及随后的Upsample层用于将特征大小扩展两倍。最后一层Conv1用于将特征映射恢复到原始图像。自动编码器的输入和输出是相同的高分辨率图像。编码器将原始图像映射到高维特征空间,解码器将这些抽象特征恢复到原始图像空间。基于编码器的输出特征,使用均方误差(MSE)函数计算GAN-STFM中的特征损失,如图(8)所示,其中x和y分别表示基本真实值和预测值,fEncoder(x)和fEncoder(y)是预训练编码器的输出。为了减小和控制不同波段间的频谱失真,本文提出了利用预测与地真值特征之间的余弦相似度来减小和控制谱角损失。根据式(9)计算,其中I表示1的张量。从计算机视觉的角度来看,视觉损失用于保留更详细的地面纹理。可以使用多尺度结构相似度(MS-SSIM)[43]来计算,以保证满意的视觉效果,记为(10),其中li(x, y)、li(x, y)和li(x, y)分别是第i尺度下图像对的量化亮度、对比度和结构,αi、βi和γi是对应的权重系数

四:实验与结果

A:研究领域和数据集

下面的实验使用了来自Coleambally灌区(CIA)1和Lower Gwydir集水区(LGC)2研究区的两个开源数据集[44]。中央情报局的研究区位于澳大利亚新南威尔士州南部,那里有现代化的灌溉系统。众所周知,在一个生长季节,作物物候学具有显著的时间动态。从2001年到2002年,CIA研究区域有17对无云MODIS-Landsat数据对。每张图像由六个光谱带组成。MODIS和Landsat图像都被插值到2040×1720的大小,分辨率为25米。LGC研究区位于澳大利亚新南威尔士州北部,收集2004 - 2005年14对无云数据,插值图像尺寸为2720 ×3200进行时空融合。由于洪水事件,这个区域也可以被认为是暂时动态的。所有数据均经过标准的预处理处理,可直接用于后续的融合模型

B:实验设置

在接下来的实验中,期望实现三个目标。首先,通过去除GAN-STFM结构中的一些结构组件来进行烧蚀实验,以深入了解其效果。其次,通过与现有时空融合模型的比较,对GAN-STFM的融合精度进行了评价。第三,通过使用不同的参考图像对特定日期进行预测,证明了GAN-STFM对参考图像的不敏感性。将GAN-STFM与STARM、FSDAF和EDCSTFN融合算法进行比较。STARFM算法是一种经典的基于加权重构的融合模型。FSDAF是一种基于非混合的重构融合模型。

EDCSTFN是一个基于深度学习的融合模型。所有三种模型都至少需要预测日期的粗分辨率图像和一对粗-细分辨率图像作为参考。相比之下,GAN-STFM只需要预测日期的粗分辨率图像和任意细分辨率参考图像。为了训练EDCSTFN模型,每个MODIS-Landsat数据对需要与另一个数据对分组,并且数据采集日期在一组中应该足够接近。即在所有分组数据对中,参考图像的采集时间最接近预测日期。数据组规则也适用于STARM和FSDAF模型。对于GAN-STFM模型,预测数据和参考数据对不需要分组,因为精细分辨率参考数据是随机从特定研究区域的Landsat数据集中选择的。这意味着特定预测日期的参考图像在每次训练迭代中都是不一样的,GAN-STFM模型可以通过这种方式训练来学习参考不敏感的高通特征。对所有数据集进行分组后,选取了10个数据用于CIA研究区域,并使用2001年的5个组进行准确性验证。验证数据未涉及培训过程。LGC研究区选取2004年的8组数据进行模型训练,2005年选取4组数据进行模型验证。

基于深度学习的模型都是使用Python编程语言使用PyTorch深度学习框架实现的[45]。为了对地球科学社区做出贡献,源代码在GitHub3平台上公布,可供公众测试和使用。在进行模型训练时,考虑到大量的计算机内存消耗,每个图像被细分为小块(256×256)以馈送到网络中。在实例化的生成器中有8个基本构建块,如图3所示,每个块的输出通道设置为16、32、64、128、64、32、16和6。最后一层的输出通道数等于图像频带数。对于鉴别器,需要对应于256 × 256图像补丁大小的8个构建块。每个块的输出通道经验地设置为12、32、32、64、64、128、128、256和256。第一层的输入通道应该是光谱带数的两倍,因为预测或地面真实的精细分辨率图像和预测日期的条件粗分辨率图像被叠加馈送到鉴别器中。对于GAN-STFM,初始训练学习率设置为2×10−4,对于EDCSTFN设置为1×10−3。每个epoch的批大小设置为32个patch,步幅大小分别为200和500 epoch,在实验中运行。(7)中的系数设为:α = β = 1, β = 0.01。模型的超参数可以根据实际情况(如硬件规格和实验数据)进行调整。我们的实验环境如表1所示。

C:训练模型

基于深度学习的模型在图形处理器(gpu)的加速下进行训练。根据上述设置,模型参数和运行时间如表2所示。令人惊讶的是,具有更少参数的EDCSTFN只比具有更复杂结构的GAN-STFM花费更少的时间。

这是因为将数据组从磁盘加载到GPU内存非常耗时,而GAN-STFM与EDCSTFN相比只需要三分之二的输入图像,当GPU的计算性能在模型训练中不是系统瓶颈时,可以节省一些时间。深度模型在验证数据集上训练时的MSE变化如图6所示。EDCSTFN的收敛速度比GAN-STFM更快,这并不奇怪。

这是因为EDCSTFN模型需要三张输入图像,并且参考日期和预测日期的时间非常接近,因此在短时间内会出现一些显著的葫芦变化。与GAN-STFM相比,输入和输出之间的关系相对没有那么复杂。GAN-STFM模型被设计为只接受两幅输入图像,并且在训练中随机选择精细分辨率的参考图像。在这种情况下,输入和输出之间的关系比EDCSTFN模型相对复杂,因为GAN-STFM算法需要从大量的精细分辨率参考中提取共同的高通特征,而不是特定于样本的特征。

图6中EDCSTFN模型在CIA和LGC研究区域的训练误差都小于GAN-STFM模型,而验证误差则相反。

这证实了EDCSTFN模型比GAN-STFM模型更容易训练,而且GAN-STFM模型具有更高的泛化能力。

为了客观评价不同融合模型的性能,我们选择了几个定量指标进行比较,包括平均绝对误差(MAE)、均方根误差(RMSE)、光谱角映射器(SAM)[46]和结构相似性指数(SSIM)[47]。

MAE和RMSE常用于量化融合误差,值越小表示融合精度越好。SAM根据光谱失真对融合模型进行评价,值越小表示光谱匹配越高。SSIM反映了合成图像的质量,理想的融合图像通常具有较高的价值。下面是对应于上述三个目标的三个角度的实验结果。

1)消融研究:与现有基于深度学习的融合模型相比,首先利用可切换归一化减少融合过程中对精细参考图像的依赖性。然后,在GAN-STFM中采用基于gan的结构来提高生成的图像质量。因此,有选择地删除这两个组件,以了解本节中对整个融合模型的贡献。分别训练了无鉴别器的普通老式CNN模型、生成器中无可切换归一化的基于gan的模型和GAN-STFM模型。图7显示了消融研究训练过程中的误差变化。一般来说,GAN-STFM在训练和验证数据集上两个研究领域的误差都最低。没有可切换归一化的模型误差最高,并且在训练过程中误差在验证数据集上波动,显示了可切换归一化在参考不敏感模型中的有效性。普通的CNN模型比没有可切换归一化的模型表现得更稳定,但仍然不如基于gan的模型。表III和表IV列出了三种体系结构对验证数据集的定量评价结果。粗体数字突出了最好的结果。这再次证实了GAN架构和可切换归一化在GAN- stfm融合模型中起重要作用的事实。

2)模型精度比较:对CIA地区2001年的5个数据组和LGC地区2005年的4个数据组进行了测试,以评估模型的精度。

定量比较如表5和表6所示。总体而言,基于深度学习的模型明显优于传统的融合方法。EDCSTFN和GAN-STFM是均匀匹配的。具体来说,一种方法在某些数据组中根据某些指标执行得更好,而另一种方法在其他数据组中根据其他指标产生更好的结果。考虑到GAN-STFM只需要两张输入图像,并且可以在较少的约束条件下选择参考图像,GAN-STFM模型显示更多

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?