1、一致性hash介绍

因此,引入了一致性哈希算法:

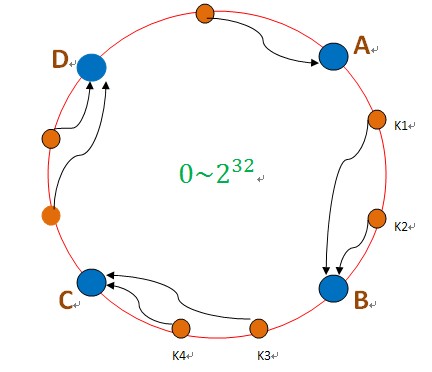

把数据用hash函数(如MD5),映射到一个很大的空间里,如图所示。数据的存储时,先得到一个hash值,对应到这个环中的每个位置,如k1对应到了图中所示的位置,然后沿顺时针找到一个机器节点B,将k1存储到B这个节点中。

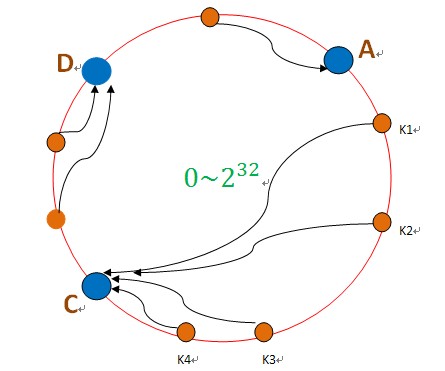

如果B节点宕机了,则B上的数据就会落到C节点上,如下图所示:

这样,只会影响C节点,对其他的节点A,D的数据不会造成影响。然而,这又会造成一个“雪崩”的情况,即C节点由于承担了B节点的数据,所以C节点的负载会变高,C节点很容易也宕机,这样依次下去,这样造成整个集群都挂了。

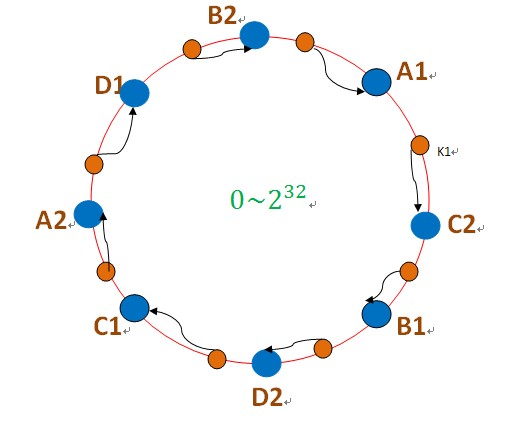

为此,引入了“虚拟节点”的概念:即把想象在这个环上有很多“虚拟节点”,数据的存储是沿着环的顺时针方向找一个虚拟节点,每个虚拟节点都会关联到一个真实节点,如下图所使用:

图中的A1、A2、B1、B2、C1、C2、D1、D2都是虚拟节点,机器A负载存储A1、A2的数据,机器B负载存储B1、B2的数据,机器C负载存储C1、C2的数据。由于这些虚拟节点数量很多,均匀分布,因此不会造成“雪崩”现象。

2、实现原理

web架构中,分布式是个常见的架构设计。尤其是大家比较熟悉的Memcached,或者其他cache产品常常被设计成分布式集群。分布式往往采用hash(key)%n 的方式,但这种算法比较简单,便于实现和理解。但弊端是不能动态增删节点。比较合理的方法改用一致性哈希(consistent hashing)分布。一致性哈希,简单的说在移除 / 添加一个 cache 时,它能够尽可能小的改变已存在 key 映射关系,尽可能的满足单调性的要求。原理不再赘述,google和度娘都能得到答案。重点说一下最常见的实现方式。

Java中采用md5散列的方式,计算hash值,这样基本上能保证key散列出啦的hash不会重复。

- private static long md5HashingAlg(String key) {

- MessageDigest md5 = MD5.get();

- md5.reset();

- md5.update(key.getBytes());

- byte[] bKey = md5.digest();

- long res = ((long) (bKey[3] & 0xFF) << 24) | ((long) (bKey[2] & 0xFF) << 16) | ((long) (bKey[1] & 0xFF) << 8)| (long) (bKey[0] & 0xFF);

- return res;

- }

在对server节点初始化的时候,为了避免节点过少数据分布不均匀,都会初始化一些虚拟节点。具体方法上面计算hash值的方式类同,一把采用根据权重虚拟出来一些key,具体不过多介绍。

一致性哈希算法中,把哈希值想象成一个环状。有关一致性哈希算法,介绍里面说0~2^32-1的数据,不要误以为哈希环要保存2^32个数据。他只是说,哈希环存的key的哈希值范围是0~2^32-1,并不是key的哈希值要覆盖0~2^32-1所有数据。

既要保存hash值,又要保存对应的节点地址,貌似最简单的就是map,在Java中没有什么map可以满足是个环状。那就找一个排序的,0开头,2^32-1做尾。查找时查到尾没有结果,再返回头找这样可以理解为是个环状了。

在初始化的时候,把节点的hash和节点地址保存在TreeMap里,client查找时,根据key的hash值去treeMap得到自己应该查询的节点,往下查找比自己hash值大的,如果有则得到结果返回。如果没有,则回到treeMap的头,取第一个返回结果。

如图中所示:根据key计算出hash,去treeMap查找比key哈希大的那部分,取出第一个值就是结果。如果没有别key哈希大的部分,则取treeMap的第一个值。

代码的实现:

- private final Long findPointFor(Long hv) {

- SortedMap<Long, String> tmap = this.consistentBuckets.tailMap(hv);

- return (tmap.isEmpty()) ? this.consistentBuckets.firstKey() : tmap.firstKey();

- }

3、代码实现

这几天看了几遍一致性哈希的文章,但是都没有比较完整的实现,因此试着实现了一下,这里我就不讲一致性哈希的原理了,网上很多,以一致性哈希用在负载均衡的实例来说,一致性哈希就是先把主机ip从小大到全部放到一个环内,然后客户端ip来连接的时候,把客户端ip连接到大小最接近客户端ip且大于客户端ip的主机。当然,这里的ip一般都是要先hash一下的。我的程序运行结果如下:

- 添加客户端,一开始有4个主机,分别为s1,s2,s3,s4,每个主机有100个虚拟主机:

- 101客户端(hash:-3872430075274208315)连接到主机->s2-192.168.1.2

- 102客户端(hash:-6461488502093916753)连接到主机->s1-192.168.1.1

- 103客户端(hash:-3272337528088901176)连接到主机->s3-192.168.1.3

- 104客户端(hash:7274050343425899995)连接到主机->s2-192.168.1.2

- 105客户端(hash:6218187750346216421)连接到主机->s1-192.168.1.1

- 106客户端(hash:-8497989778066313989)连接到主机->s2-192.168.1.2

- 107客户端(hash:2219601794372203979)连接到主机->s3-192.168.1.3

- 108客户端(hash:1903054837754071260)连接到主机->s3-192.168.1.3

- 109客户端(hash:-2425484502654523425)连接到主机->s1-192.168.1.1

- 删除主机s2-192.168.1.2的变化:

- hash(-8497989778066313989)改变到->s4-192.168.1.4

- hash(7274050343425899995)改变到->s2-192.168.1.2

- hash(-3872430075274208315)改变到->s4-192.168.1.4

- hash(7274050343425899995)改变到->s1-192.168.1.1

- 增加主机s5-192.168.1.5的变化:

- hash(1903054837754071260)改变到->s5-192.168.1.5

- hash(1903054837754071260)改变到->s5-192.168.1.5

- hash(-3272337528088901176)改变到->s5-192.168.1.5

- 最后的客户端到主机的映射为:

- hash(-8497989778066313989)连接到主机->s4-192.168.1.4

- hash(-6461488502093916753)连接到主机->s1-192.168.1.1

- hash(-3872430075274208315)连接到主机->s4-192.168.1.4

- hash(-3272337528088901176)连接到主机->s5-192.168.1.5

- hash(-2425484502654523425)连接到主机->s1-192.168.1.1

- hash(1903054837754071260)连接到主机->s5-192.168.1.5

- hash(2219601794372203979)连接到主机->s3-192.168.1.3

- hash(6218187750346216421)连接到主机->s1-192.168.1.1

- hash(7274050343425899995)连接到主机->s1-192.168.1.1

看结果可知:一开始添加到9个客户端,连接到主机s1,s2,s3,s4的客户端分别有3,3,3,0个,经过删除主机s2,添加主机s5,最后9个客户端分别连接到主机s1,s2,s3,s4,s5的个数为4,0,1,2,2.这里要说明一下删除主机s2的情况,hash尾号为9995的客户端先连接到s2,再连接到s1,为什么会出现这种情况呢?因为每一个真实主机有n个虚拟主机,删除s2却打印“hash(7274050343425899995)改变到->s2-192.168.1.2”是因为删除了s2的其中一个虚拟主机,跳转到另一个虚拟主机,但还是在s2上,当然,这里是打印中间情况,以便了解,真实的环境是删除了s2后,所有他的虚拟节点都会马上被删除,虚拟节点上的连接也会重新连接到另一个主机的虚拟节点,不会存在这种中间情况。

以下给出所有的实现代码,大家共同学习:

- public class Shard<Node> { // S类封装了机器节点的信息 ,如name、password、ip、port等

- static private TreeMap<Long, Node> nodes; // 虚拟节点到真实节点的映射

- static private TreeMap<Long,Node> treeKey; //key到真实节点的映射

- static private List<Node> shards = new ArrayList<Node>(); // 真实机器节点

- private final int NODE_NUM = 100; // 每个机器节点关联的虚拟节点个数

- boolean flag = false;

- public Shard(List<Node> shards) {

- super();

- this.shards = shards;

- init();

- }

- public static void main(String[] args) {

- // System.out.println(hash("w222o1d"));

- // System.out.println(Long.MIN_VALUE);

- // System.out.println(Long.MAX_VALUE);

- Node s1 = new Node("s1", "192.168.1.1");

- Node s2 = new Node("s2", "192.168.1.2");

- Node s3 = new Node("s3", "192.168.1.3");

- Node s4 = new Node("s4", "192.168.1.4");

- Node s5 = new Node("s5","192.168.1.5");

- shards.add(s1);

- shards.add(s2);

- shards.add(s3);

- shards.add(s4);

- Shard<Node> sh = new Shard<Shard.Node>(shards);

- System.out.println("添加客户端,一开始有4个主机,分别为s1,s2,s3,s4,每个主机有100个虚拟主机:");

- sh.keyToNode("101客户端");

- sh.keyToNode("102客户端");

- sh.keyToNode("103客户端");

- sh.keyToNode("104客户端");

- sh.keyToNode("105客户端");

- sh.keyToNode("106客户端");

- sh.keyToNode("107客户端");

- sh.keyToNode("108客户端");

- sh.keyToNode("109客户端");

- sh.deleteS(s2);

- sh.addS(s5);

- System.out.println("最后的客户端到主机的映射为:");

- printKeyTree();

- }

- public static void printKeyTree(){

- for(Iterator<Long> it = treeKey.keySet().iterator();it.hasNext();){

- Long lo = it.next();

- System.out.println("hash("+lo+")连接到主机->"+treeKey.get(lo));

- }

- }

- private void init() { // 初始化一致性hash环

- nodes = new TreeMap<Long, Node>();

- treeKey = new TreeMap<Long, Node>();

- for (int i = 0; i != shards.size(); ++i) { // 每个真实机器节点都需要关联虚拟节点

- final Node shardInfo = shards.get(i);

- for (int n = 0; n < NODE_NUM; n++)

- // 一个真实机器节点关联NODE_NUM个虚拟节点

- nodes.put(hash("SHARD-" + shardInfo.name + "-NODE-" + n), shardInfo);

- }

- }

- //增加一个主机

- private void addS(Node s) {

- System.out.println("增加主机"+s+"的变化:");

- for (int n = 0; n < NODE_NUM; n++)

- addS(hash("SHARD-" + s.name + "-NODE-" + n), s);

- }

- //添加一个虚拟节点进环形结构,lg为虚拟节点的hash值

- public void addS(Long lg,Node s){

- SortedMap<Long, Node> tail = nodes.tailMap(lg);

- SortedMap<Long,Node> head = nodes.headMap(lg);

- Long begin = 0L;

- Long end = 0L;

- SortedMap<Long, Node> between;

- if(head.size()==0){

- between = treeKey.tailMap(nodes.lastKey());

- flag = true;

- }else{

- begin = head.lastKey();

- between = treeKey.subMap(begin, lg);

- flag = false;

- }

- nodes.put(lg, s);

- for(Iterator<Long> it=between.keySet().iterator();it.hasNext();){

- Long lo = it.next();

- if(flag){

- treeKey.put(lo, nodes.get(lg));

- System.out.println("hash("+lo+")改变到->"+tail.get(tail.firstKey()));

- }else{

- treeKey.put(lo, nodes.get(lg));

- System.out.println("hash("+lo+")改变到->"+tail.get(tail.firstKey()));

- }

- }

- }

- //删除真实节点是s

- public void deleteS(Node s){

- if(s==null){

- return;

- }

- System.out.println("删除主机"+s+"的变化:");

- for(int i=0;i<NODE_NUM;i++){

- //定位s节点的第i的虚拟节点的位置

- SortedMap<Long, Node> tail = nodes.tailMap(hash("SHARD-" + s.name + "-NODE-" + i));

- SortedMap<Long,Node> head = nodes.headMap(hash("SHARD-" + s.name + "-NODE-" + i));

- Long begin = 0L;

- Long end = 0L;

- SortedMap<Long, Node> between;

- if(head.size()==0){

- between = treeKey.tailMap(nodes.lastKey());

- end = tail.firstKey();

- tail.remove(tail.firstKey());

- nodes.remove(tail.firstKey());//从nodes中删除s节点的第i个虚拟节点

- flag = true;

- }else{

- begin = head.lastKey();

- end = tail.firstKey();

- tail.remove(tail.firstKey());

- between = treeKey.subMap(begin, end);//在s节点的第i个虚拟节点的所有key的集合

- flag = false;

- }

- for(Iterator<Long> it = between.keySet().iterator();it.hasNext();){

- Long lo = it.next();

- if(flag){

- treeKey.put(lo, tail.get(tail.firstKey()));

- System.out.println("hash("+lo+")改变到->"+tail.get(tail.firstKey()));

- }else{

- treeKey.put(lo, tail.get(tail.firstKey()));

- System.out.println("hash("+lo+")改变到->"+tail.get(tail.firstKey()));

- }

- }

- }

- }

- //映射key到真实节点

- public void keyToNode(String key){

- SortedMap<Long, Node> tail = nodes.tailMap(hash(key)); // 沿环的顺时针找到一个虚拟节点

- if (tail.size() == 0) {

- return;

- }

- treeKey.put(hash(key), tail.get(tail.firstKey()));

- System.out.println(key+"(hash:"+hash(key)+")连接到主机->"+tail.get(tail.firstKey()));

- }

- /**

- * MurMurHash算法,是非加密HASH算法,性能很高,

- * 比传统的CRC32,MD5,SHA-1(这两个算法都是加密HASH算法,复杂度本身就很高,带来的性能上的损害也不可避免)

- * 等HASH算法要快很多,而且据说这个算法的碰撞率很低.

- * http://murmurhash.googlepages.com/

- */

- private static Long hash(String key) {

- ByteBuffer buf = ByteBuffer.wrap(key.getBytes());

- int seed = 0x1234ABCD;

- ByteOrder byteOrder = buf.order();

- buf.order(ByteOrder.LITTLE_ENDIAN);

- long m = 0xc6a4a7935bd1e995L;

- int r = 47;

- long h = seed ^ (buf.remaining() * m);

- long k;

- while (buf.remaining() >= 8) {

- k = buf.getLong();

- k *= m;

- k ^= k >>> r;

- k *= m;

- h ^= k;

- h *= m;

- }

- if (buf.remaining() > 0) {

- ByteBuffer finish = ByteBuffer.allocate(8).order(

- ByteOrder.LITTLE_ENDIAN);

- // for big-endian version, do this first:

- // finish.position(8-buf.remaining());

- finish.put(buf).rewind();

- h ^= finish.getLong();

- h *= m;

- }

- h ^= h >>> r;

- h *= m;

- h ^= h >>> r;

- buf.order(byteOrder);

- return h;

- }

- static class Node{

- String name;

- String ip;

- public Node(String name,String ip) {

- this.name = name;

- this.ip = ip;

- }

- @Override

- public String toString() {

- return this.name+"-"+this.ip;

- }

- }

- }

4、关于treeMap的一些方法的介绍

4.1 tailMap()

tailMap(K fromKey) 方法用于返回此映射,其键大于或等于fromKey的部分视图。返回的映射受此映射支持,因此改变返回映射反映在此映射中,反之亦然。

以下是java.util.TreeMap.tailMap()方法的声明。

public SortedMap<K,V> tailMap(K fromKey)参数

fromKey--返回映射中键的低端点(包括)

返回值

该方法调用返回此映射,其键大于或等于fromKey的部分视图。

例子:

下面的示例演示java.util.TreeMap.tailMap()方法的使用

package com.yiibai; import java.util.*; public class TreeMapDemo { public static void main(String[] args) { // creating maps TreeMap<Integer, String> treemap = new TreeMap<Integer, String>(); SortedMap<Integer, String> treemapincl = new TreeMap<Integer, String>(); // populating tree map treemap.put(2, "two"); treemap.put(1, "one"); treemap.put(3, "three"); treemap.put(6, "six"); treemap.put(5, "five"); System.out.println("Getting tail map"); treemapincl=treemap.tailMap(3); System.out.println("Tail map values: "+treemapincl); } }

现在编译和运行上面的代码示例,将产生以下结果。

Getting tail map Tail map values: {3=three, 5=five, 6=six}

4.2 headMap()

4.3 java.util.TreeMap类

TreeMap类保证该映射将是升序键顺序。

该映射是按照自然排序方法的关键类,或者根据创建映射时提供的比较器,这将取决于其构造函数中使用排序。

361

361

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?