kafka的介绍、搭建和基本使用

kafka的基本介绍

消息队列的介绍

常用的消息队列工具:

消息队列包括两种模式,点对点模式(point to point, queue)和发布/订阅模式(publish/subscribe,topic)

点对点模式:

点对点模式下包括三个角色:

消息队列

发送者 (生产者)

接收者(消费者)

消息发送者生产消息发送到queue中,然后消息接收者从queue中取出并且消费消息。消息被消费以后,queue中不再有存储,所以消息接收者不可能消费到已经被消费的消息。

点对点模式特点:

每个消息只有一个接收者(Consumer)(即一旦被消费,消息就不再在消息队列中);

发送者和接收者间没有依赖性,发送者发送消息之后,不管有没有接收者在运行,都不会影响到发送者下次发送消息;

接收者在成功接收消息之后需向队列应答成功,以便消息队列删除当前接收的消息;

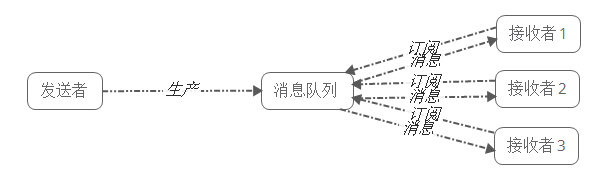

发布/订阅模式

发布/订阅模式下包括三个角色:

角色主题(Topic)

发布者(Publisher)

订阅者(Subscriber)

发布者将消息发送到Topic,系统将这些消息传递给多个订阅者。

发布/订阅模式特点:

每个消息可以有多个订阅者;

发布者和订阅者之间有时间上的依赖性。针对某个主题(Topic)的订阅者,它必须创建一个订阅者之后,才能消费发布者的消息。

为了消费消息,订阅者需要提前订阅该角色主题,并保持在线运行;

kafka介绍

官网:http://kafka.apache.org/

kafka是最初由linkedin公司开发的,使用scala语言编写,kafka是一个分布式,分区的,多副本的,多订阅者的日志系统(分布式MQ系统),可以用于搜索日志,监控日志,访问日志等

Kafka is a distributed,partitioned,replicated commit logservice。它提供了类似于JMS的特性,但是在设计实现上完全不同,此外它并不是JMS规范的实现。kafka对消息保存时根据Topic进行归类,发送消息者成为Producer,消息接受者成为Consumer,此外kafka集群有多个kafka实例组成,每个实例(server)成为broker。无论是kafka集群,还是producer和consumer都依赖于zookeeper来保证系统可用性集群保存一些meta信息

kafka的好处

可靠性:分布式的,分区,复制和容错的。

可扩展性:kafka消息传递系统轻松缩放,无需停机。

耐用性:kafka使用分布式提交日志,这意味着消息会尽可能快速的保存在磁盘上,因此它是持久的。

性能:kafka对于发布和定于消息都具有高吞吐量。即使存储了许多TB的消息,他也爆出稳定的性能。

kafka非常快:保证零停机和零数据丢失。

kafka速度快的原因:

第一个原因:使用pageCache 页缓存技术

第二个原因:顺序的读写磁盘,顺序的读写磁盘的速度比操作内存更快

kafka的框架图如下:

生产者:producer主要负责生产数据到 topic里面去。

topic:虚拟的概念,某一类消息的主题,某一类消息都是存放在某一个topic当中。

partition:一个topic里面有多个partition,一个partition里面有多个segment段,每个segment默认1GB。

一个segment: 一个.index文件 + 一个.log文件。

.log:存放用户真实的产生的数据

.index:索引文件,存放的是.log文件的索引数据

消费者:consumer 主要就是消费topic里面的数据

conusmer消费到哪一条数据需要进行记录:利用offset来进行记录 数据的偏移量 每条数据都有唯一的offset

kafka应用场景:

流式处理:实时处理 数据从出现到产生,在一秒钟以内能够处理完成

流式计算:程序一旦启动,就会一直运行下去,一旦有数据,就能够马上被处理掉

生产者生产数据到kafka里面去 ,然后通过一些实时处理的框架例如storm或者sparkStreaming或者flink等等

一些实时处理的框架去处理kafka里面的数据

分布式:肯定是多节点,多台服务器,组织到一起形成一个集群

kafka的搭建和安装

首先保证zk服务已经启动:

cd /export/servers/zookeeper-3.4.5-cdh5.14.0/

bin/zKserver.sh start

下载安装包并上传解压:

通过以下地址进行下载安装包

node01执行以下命令,下载并解压

cd /export/softwares

wget http://archive.apache.org/dist/kafka/1.0.0/kafka_2.11-1.0.0.tgz

tar –zxvf kafka_2.11-1.0.0.tgz -C /export/servers/

node01服务器修改kafka配置文件

node01执行以下命令进入到kafka的配置文件目录,修改配置文件

node01执行以下命令创建数据文件存放目录

mkdir -p /export/servers/kafka_2.11-1.0.0/logs

cd /export/servers/kafka_2.11-1.0.0/config

vim server.properties

broker.id=0

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

log.dirs=/export/servers/kafka_2.11-1.0.0/logs

num.partitions=2

num.recovery.threads.per.data.dir=1

offsets.topic.replication.factor=1

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

log.flush.interval.messages=10000

log.flush.interval.ms=1000

log.retention.hours=168

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

zookeeper.connect=node01:2181,node02:2181,node03:2181

zookeeper.connection.timeout.ms=6000

group.initial.rebalance.delay.ms=0

delete.topic.enable=true

host.name=node01

安装包分发到其他服务器上面去

node01执行以下命令,将node01服务器的kafka安装包发送到node02和node03服务器上面去

cd /export/servers/

scp -r kafka_2.11-1.0.0/ node02:$PWD

scp -r kafka_2.11-1.0.0/ node03:$PWD

node02与node03服务器修改配置文件

node02与node03服务器修改kafka配置文件

node02使用以下命令修改kafka配置文件:

cd /export/servers/kafka_2.11-1.0.0/config

vim server.properties

broker.id=1

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

log.dirs=/export/servers/kafka_2.11-1.0.0/logs

num.partitions=2

num.recovery.threads.per.data.dir=1

offsets.topic.replication.factor=1

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

log.flush.interval.messages=10000

log.flush.interval.ms=1000

log.retention.hours=168

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

zookeeper.connect=node01:2181,node02:2181,node03:2181

zookeeper.connection.timeout.ms=6000

group.initial.rebalance.delay.ms=0

delete.topic.enable=true

host.name=node02

node03使用以下命令修改kafka配置文件

cd /export/servers/kafka_2.11-1.0.0/config

vim server.properties

broker.id=2

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

log.dirs=/export/servers/kafka_2.11-1.0.0/logs

num.partitions=2

num.recovery.threads.per.data.dir=1

offsets.topic.replication.factor=1

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

log.flush.interval.messages=10000

log.flush.interval.ms=1000

log.retention.hours=168

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

zookeeper.connect=node01:2181,node02:2181,node03:2181

zookeeper.connection.timeout.ms=6000

group.initial.rebalance.delay.ms=0

delete.topic.enable=true

host.name=node03

kafka集群启动与停止

注意事项:在kafka启动前,一定要让zookeeper启动起来。

node01执行以下命令将kafka进程启动在后台

cd /export/servers/kafka_2.11-1.0.0

nohup bin/kafka-server-start.sh config/server.properties 2>&1 &

node02执行以下命令将kafka进程启动在后台

cd /export/servers/kafka_2.11-1.0.0

nohup bin/kafka-server-start.sh config/server.properties 2>&1 &

node03执行以下命令将kafka进程启动在后台

cd /export/servers/kafka_2.11-1.0.0

nohup bin/kafka-server-start.sh config/server.properties 2>&1 &

三台机器也可以执行以下命令停止kafka集群

cd /export/servers/kafka_2.11-1.0.0

bin/kafka-server-stop.sh

kafka的集群操作

创建topic

创建一个名字为test的主题, 有三个分区,有两个副本

node01执行以下命令来创建topic

cd /export/servers/kafka_2.11-1.0.0

bin/kafka-topics.sh --create --zookeeper node01:2181 --replication-factor 2 --partitions 3 --topic test

查看主题命令

查看kafka当中存在的主题

node01使用以下命令来查看kafka当中存在的topic主题

cd /export/servers/kafka_2.11-1.0.0

bin/kafka-topics.sh --list --zookeeper node01:2181,node02:2181,node03:2181

生产者生产数据

模拟生产者来生产数据

node01服务器执行以下命令来模拟生产者进行生产数据

cd /export/servers/kafka_2.11-1.0.0

bin/kafka-console-producer.sh --broker-list node01:9092,node02:9092,node03:9092 --topic test

消费者消费数据

node02服务器执行以下命令来模拟消费者进行消费数据

cd /export/servers/kafka_2.11-1.0.0

bin/ kafka-console-consumer.sh --from-beginning --topic test --zookeeper node01:2181,node02:2181,node03:2181

运行describe topics命令

node01执行以下命令运行describe查看topic的相关信息

cd /export/servers/kafka_2.11-1.0.0

bin/kafka-topics.sh --describe --zookeeper node01:2181 --topic test

增加topic分区数

任意kafka服务器执行以下命令可以增加topic分区数

`bash

cd /export/servers/kafka_2.11-1.0.0

bin/kafka-topics.sh --zookeeper zkhost:port --alter --topic topicName --partitions 8

增加配置

动态修改kakfa的配置

任意kafka服务器执行以下命令可以增加topic分区数

````bash

cd /export/servers/kafka_2.11-1.0.0

bin/kafka-topics.sh --zookeeper node01:2181 --alter --topic test --config flush.messages=1

删除配置

动态删除kafka集群配置

cd /export/servers/kafka_2.11-1.0.0

bin/kafka-topics.sh --zookeeper node01:2181 --alter --topic test --delete-config flush.messages

删除topic

目前删除topic在默认情况下知识打上一个删除的标记,在重新启动kafka后才删除。如果需要立即删除,则需要在

server.properties中配置:

delete.topic.enable=true

然后执行以下命令进行删除topic

bin/kafka-topics.sh --zookeeper zkhost:port --delete --topic topicName

2583

2583

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?