目前市面上的通用大模型很多,如OpenAI的GPT-4o,Google DeepMind开发的Gemini 1.5 Pro,Meta AI的LLaMA系列,DeepSeek-R1 , 阿里的Qwen2.5等,企业根据自身技术栈等原因会有不同的选择。作为一个数据驱动的综合物联网平台,Insights Hub保持了充分的开放性,客户可以轻松接入自己的大模型,利用Insights Hub提供的时序数据及工业语料丰富自己的大模型能力,同时自建智能助理(AI Agent)提升生产智能化水平。

本文作为前篇“一文详解|西门子Insights Hub基于大模型的智能生产助理” 的继续,展开介绍前文中提到的场景“Insights Hub Custom Production AI Agent基于本地大模型的生产智能助手(以DeepSeek为例)”的详细实现步骤。这里我们探讨了一种可落地的方案,帮助客户将自有大模型与企业工业物联网平台相结合,在确保高可用性与安全性能的基础上,推动企业智能化工厂新时代的实现。

场景设计与成果展示

场景选择SMT产线,以Heller回流炉设备维修保养为例实现智能生产助理MVP(最小可用产品)。通过闭环式解决方案,帮助用户在Heller回流炉设备的运维保养过程中高效发现设备问题、寻找合适的解决方案,并最终通过设备运维工程师的操作进行问题处理。

Insights Hub对生产设备进行管理,实时采集数据并持续监控工厂内的设备运行状态。当设备出现异常,平台将实时推送报警故障代码及相关报警信息, 提高设备维护的响应速度,确保设备持续高效运转,并优化整体运维流程。如下是实现效果截图,图中可以看到,在Insights Hub Monitor中我们嵌入了智能助理的聊天窗口及交互能力,下文将就技术细节展开介绍。

开发环境信息:

1. 工具:

-

LLM 本地模型:Deepseek-R1 7B

-

Dify

-

Mendix 应用集成

-

Insights Hub 西门子数据驱动智能制造平台

2. 其他资源:

-

Cuda版本:12.8

-

cuDnn版本:8.9.7.29

-

GPU:NVIDIA Gefore RTX 3080 Ti 12GB显存

-

CPU:11th Gen Intel(R) Core(TM) i9-11900K @ 3.50GHz 3.50 GHz

-

RAM:32.0 GB

-

Docker版本:27.4.0

-

Java环境:JDK11

-

Mendix Studio Pro:10.18.3

方案与架构设计

这是一个通过Mendix开发的生产智能助理APP,基于Mendix应用模版库中的Insights Hub monitor样例开发。应用最终在Insights Hub平台上完成注册并发布在Insights Hub主页面上。

智能助理利用LLM推理模型,通过对话式交互进行运维支持;由于资源限制,选择了Deepseek-R1 7B 作为模型,模型通过Ollama进行本地(私有化)部署。Ollama提供了私有化大模型的部署基础环境,并负责大模型的版本管理,确保模型的持续更新和优化。

架构分两部分考虑:LLM管理与知识库层以及应用层。

1. LLM管理与知识库层

Dify作为AI应用工作站,具备强大的大模型接入与管理能力,支持向量知识库的构建,并提供工作流管理功能。这里,RAG构建、LLM应用开发及LLMOps都通过Dify来完成。

在Dify帮助下,Heller回流炉设备维修保养的资料上传形成向量知识库。从文件选择、预处理、索引模式选择到检索设置 ,Dify旨在构建一个高效、智能的知识检索系统(类似能力也选用RAGflow替代)。

Dify还支持向外部应用提供API接口及嵌入式页面,方便快速集成私有化LLM及本地知识库。

2. 应用层

Insights Hub:作为企业级工业物联网平台,提供了强大的功能集。本次探索主要集成了以下功能:

-

设备管理

-

设备时序数据监控

-

事件管理

-

规则管理

这些功能是应用场景演示的基础,确保数据的流通和管理的高效性。

Mendix低代码开发平台:通过Mendix平台,我们可以快速集成LLM管理与知识库层 的服务以及 Insights Hub的功能。借助低代码开发工具,能够高效构建个性化的场景业务应用。

应用注册:开发完成后,应用会注册到Insights Hub平台,实现通过Insights Hub Launch Pad界面直接访问这些应用,便于终端用户使用并实现业务自动化。

下图简单勾画了架构逻辑,供参考。

(系统架构图)

整体架构将LLM模型管理和应用层功能 有效结合,通过平台集成,形成了一个智能、高效的运维和管理解决方案。

实现步骤

一、按照步骤搭建环境

1. 安装NVIDIA Studio

Download The Official NVIDIA Drivers | NVIDIA

2. 根据自己GPU型号安装正确版本的Cuda

版本查看NVIDIA官方链接:

Support Matrix — NVIDIA cuDNN Backend

3. 下载cuDnn解压并整合到Cuda文件路径

4. 测试CUDA 安装成功

5. 安装Ollama下载LLM

Ollama安装链接:

LLM推理模型选择非常丰富,这里使用了Deepseek-r1, 大家可以根据自己情况合理选择。

LLM下载指令:

ollama run deepseek-r1:7b

6. 安装Docker

Docker安装链接:

Docker: Accelerated Container Application Development

7. 安装Dify

项目是开源的,github地址:

Docker: Accelerated Container Application Development

通过Git方式下载或直接下载Zip文件并部署到Docker

8. 安装JDK11

JDK11下载链接:

9. 安装Mendix

Mendix安装地址:

https://marketplace.mendix.com/link/studiopro

这里Mendix尽量选择MTS版本进行安装

二、LLMs管理与知识库层实现

1. 知识库实现

导入文件

选择索引方式,本次尝试过嵌入式模型,但因为电脑资源问题选择了经济类型

保存后等待状态显示可用后即可完成构建

2. 运行Ollama

执行指令ollama serve

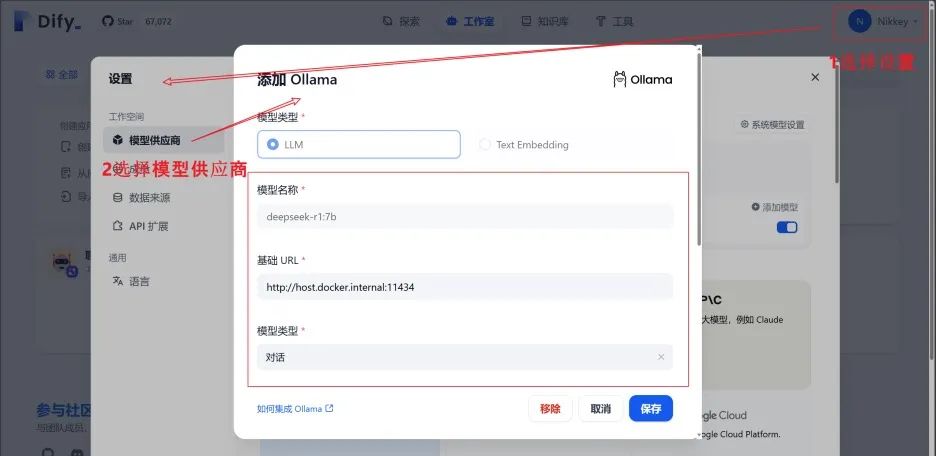

3. 在Dify引用本地部署的LLM模型

注意:模型名称要与Ollama list展示的保持一致

填写URL:http://host.docker.internal:11434

4. 在Dify创建对话应用

选择模型,并在上下文选择新生成的知识库,即可开始对话测试

三、应用层实现

3.1 Mendix集成开发

访问西门子低代码开发Mendix官方应用商店可获取丰富的参考资料,这里集成开发、调试及上线到Insights Hub过程由于内容较多部分,细节部分此处省略。

3.2 Mendix平台集成:

使用Mendix低代码开发平台,开发者可以快速构建并集成Dify API,实现LLM的调用与数据查询。

通过Mendix平台,构建了基于业务需求的定制化应用界面,例如运维工程师可以通过界面查询设备状态、查看历史故障记录、以及与 Deepseek-R1 7B语言模型交互获取解决方案。

Mendix还简化了与Insights Hub的集成,确保数据与功能在整个应用中无缝流转。

四、最终应用的部署与访问

应用发布:

-

开发完成后的应用会注册到Insights Hub 平台,并通过Launch Pad界面进行访问。用户可以通过该平台查看实时数据、查看设备状况、以及获得大语言模型推理的运维方案。

API调用与嵌入式页面:

-

Dify提供的API被嵌入到Mendix开发的应用中,支持用户在应用内直接进行与大语言模型的交互。

-

用户可以通过输入设备故障描述或查询问题,获得Deepseek-R1 7B模型的推理结果,提升问题诊断和解决效率。

五、自动化与智能化运维

自动化运维方案生成:

基于平台的设备监控和故障报警数据,结合大语言模型的推理能力,当设备出现问题时,运维工程师不仅可以查看报警信息,还能获得大语言模型提供的智能运维建议。

例如,当检测到回流炉温度异常时,系统会自动推送报警并提供解决方案(如调整温度设定、检查加热元件等),并根据历史数据预测潜在故障,进一步提高设备的可靠性。

六、系统优化与反馈机制

我们将基于此MVP,通过积累的设备运行数据与故障案例,不断优化Deepseek-R1:7B模型,提升其对设备运维问题的响应精度。同时系统将根据实际反馈对模型进行调整,使其能够逐步适应工厂特定设备的运维需求。

结语:通过这个MVP,我们将LLM管理、设备数据监控 和 智能运维应用相结合,实现了从设备故障预警到智能诊断再到解决方案推送的全流程闭环。通过 Insights Hub和LLM技术的快速集成,客户可以有效利用数字化基础建设阶段通过工业物联网的部署和应用积累的时序数据及工业语料,丰富了自有大语言模型的能力,提高了设备运维的效率和精准度。同时,企业制造数字化与智能化又多了一个最佳实践。

补充说明:本文所述Mendix项目包已同步上传Mendix开发者论坛,请移步获取并联系我们加入迭代。

本文所述DeepSeek集成场景仅为客户本地化部署的技术说明,不构成Insights Hub与DeepSeek的官方合作承诺。客户部署产品后,可根据产品开放性接口规范,通过标准化API与自有大模型集成。此功能为产品预置扩展能力,不涉及我方立场或政策合规范畴。

如果有工业物联网需求请联系刘老师:红猪-Mendix开发者论坛

1202

1202

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?