前言

hihi,朋友们,时隔半年(24年11月),终于能腾出时间唠一唠SD了🤣,真怕再不唠一唠,就轮不到SD了,技术更新换实是在是太快!

~朋友们,最近(24年2月)是真的没时间整理笔记,每天都在疯狂的学习Stable Diffusion和WebUI & ComfyUI,工作实在有点忙,实践期间在飞书上记了一些学习笔记,后面看有时间我再回来补齐吧!~

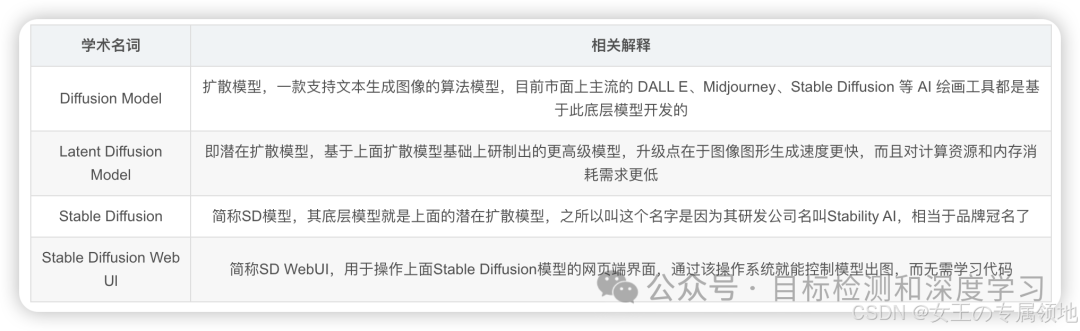

基本概念

开始前我们先熟悉几个概念,这些内容在之前的文章里面也有专门介绍过:

-

关于AIGC文生图:一文读懂AIGC文生图系列发展近况

-

关于扩散模型: 一文读懂「Diffusion Model,DM」扩散模型

-

关于Midjourney:深入浅出剖析典型文生图产品Midjourney

所有的AI设计工具,安装包、模型和插件,都已经整理好了,👇获取~

SD介绍

Stable Diffusion是一种基于深度学习的图像扩散生成模型,利用文本描述生成图像。该模型由CompVis、Stability AI和LAION合作开发,具有高稳定性和生成质量。

产品介绍

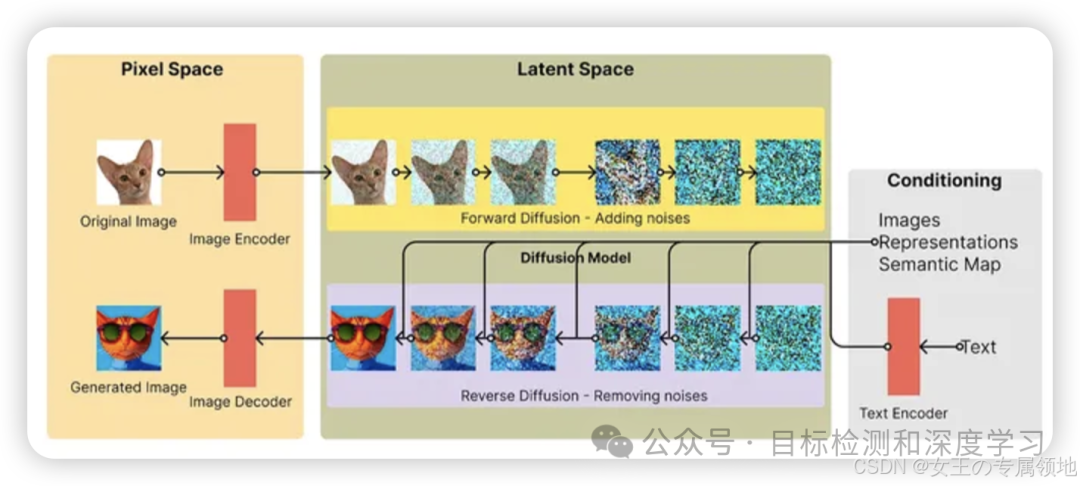

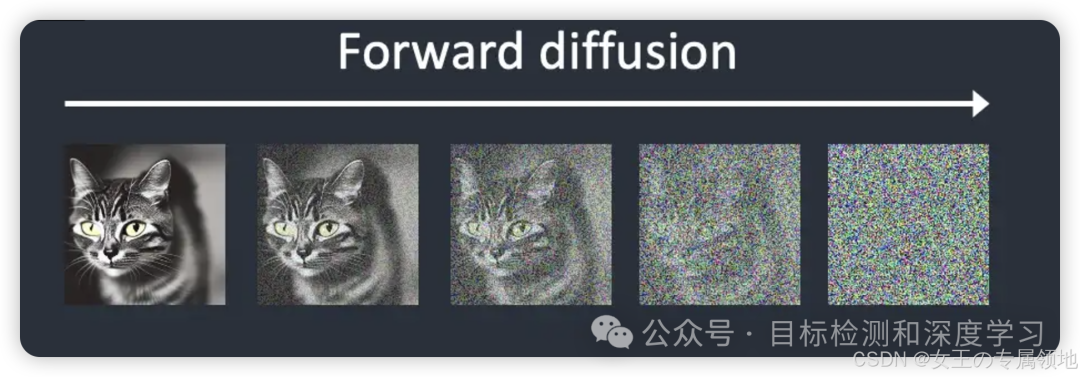

Stable Diffusion直译为稳定扩散,理解稳定扩散之前先通过两张图片介绍一下什么是前向扩散和逆向扩散。所谓前向扩散(forward diffusion)过程就是向训练图像中不断地添加噪声,从而使其逐渐变为一张毫无意义的纯噪声图。经过前向扩散猫的图像变成了随机噪声。反过来,逆向扩散(Reverse Diffusion)过程是从一个随机噪声图像开始恢复出猫图像的过程。

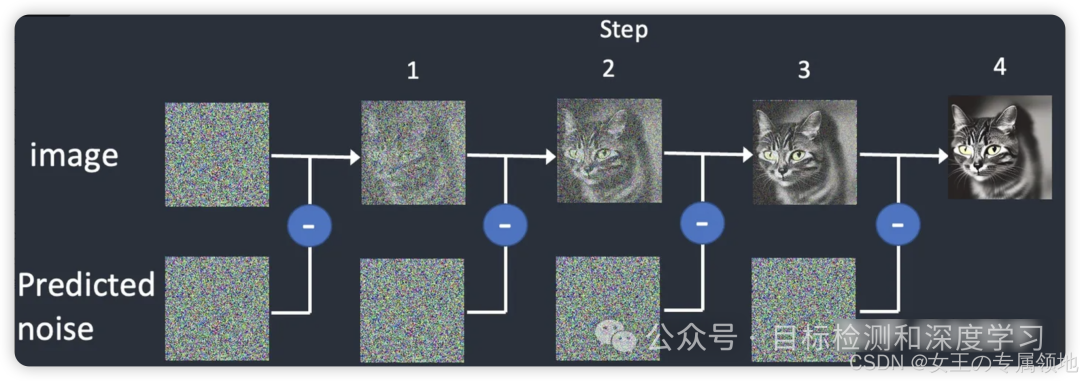

因此,Stable Diffusion可以理解为从一张完全高斯噪音开始,根据用户输入的要求,逐步剔除噪音,直到产生出用户所要图片的过程。

它的核心是如何降噪(降噪模型),而降噪模型的核心是噪声预测器(根据用户文本输入,预测噪声),即高斯图片->逐步减去噪声->得到用户所需图片。

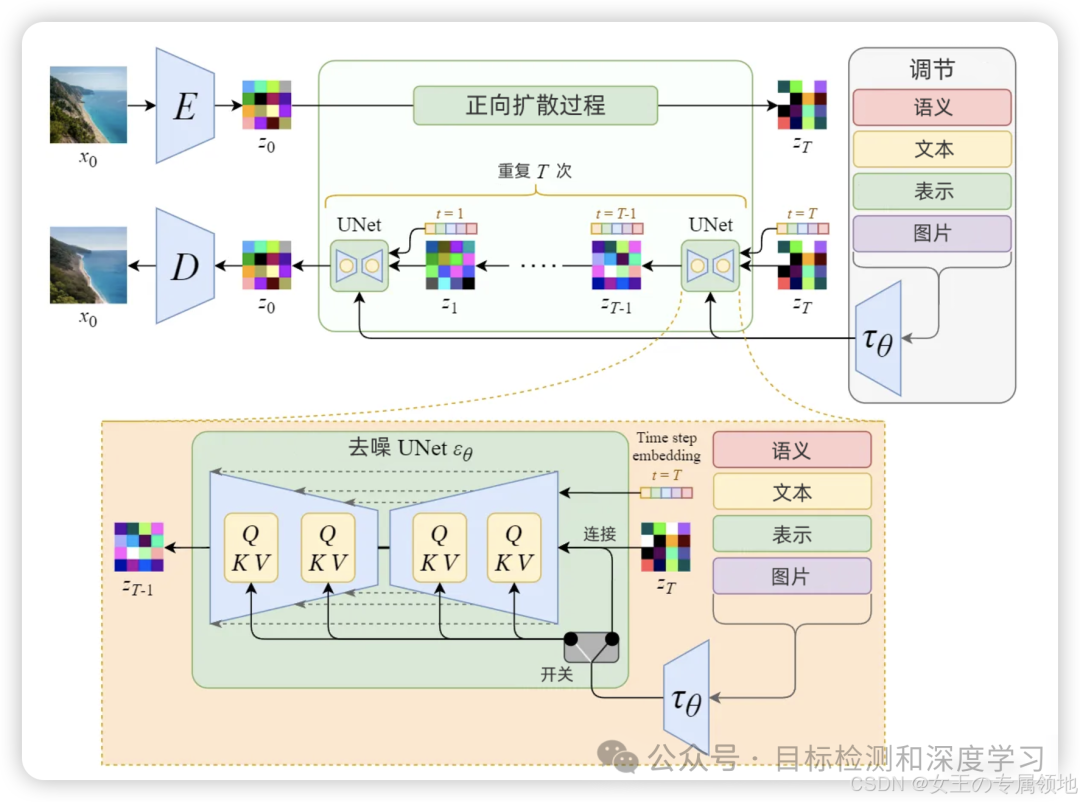

这个过程里面一共用到了图像编码器、文本编码器、扩散模型、图像解码器四个神经网络模型。

发展路线

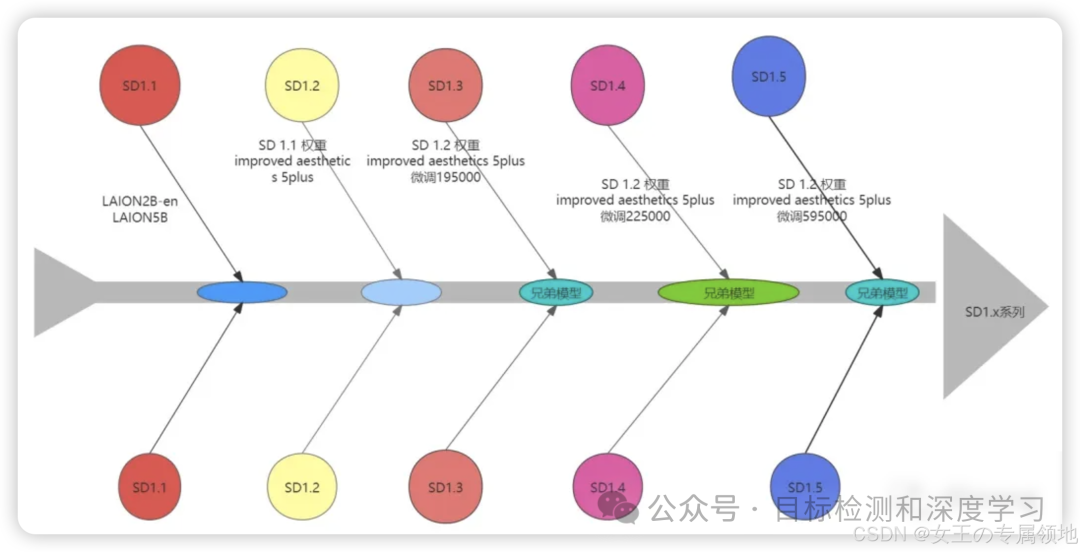

SD 1.1:首个版本,提出improved aesthetics,优化图像质量,使用4plus模型配置。

SD 1.2:引入大数据集LAION-2B进行训练,提高了图像质量,使用5plus模型配置。

SD 1.3:过渡版本

SD 1.4:在图像生成效果上有较大提升,训练迭代次数增加到195000步。

SD 1.5:继续改进美学效果,使用5plus模型,训练达到225000步,可以生成更高质量图片。

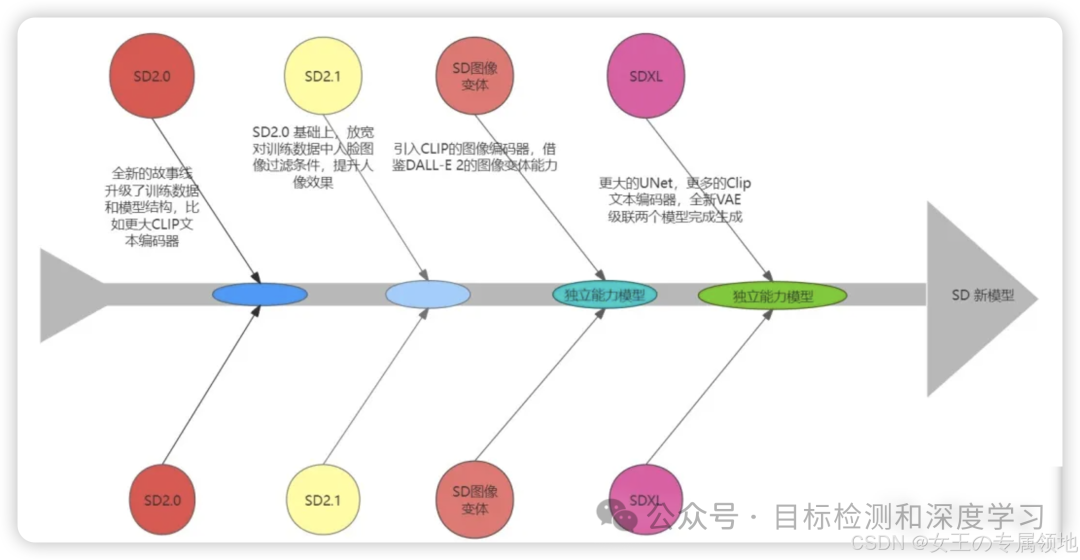

SD2.0:这是Stable Diffusion的一个主要版本。它在之前版本的基础上实现了显著的改进,特别是在图像的美学质量和生成模型的细节上。

SD2.1:这个版本进一步优化了之前版本的特性。强调了更有效的文本编码器,使用了更先进的CLIP版本,生成的图像与文本提示的一致性和相关性有所提升。

SD变种:这可能是Stable Diffusion的一个变体版本,具有特殊的属性或针对特定应用场景的优化。

SDXL:这是Stable Diffusion的一个扩展版本。演化更大的模型(比如使用了更大的UNet),或者训练了更广泛的数据集。强调了CLIP文本编码器和VAE的改进,提供了更准确的文本到图像的转换能力。

Stable Diffusion 2.x系列:

SD 2.0:基于CompVis模型,提升细节生成能力。

SD 2.1:引入Hypernetwork,支持无限分辨率生成。

SD 的演化过程中,最主要的变化就是模型结构和训练数据的变化。SD1.x 系列,大多数是在 SD1.2 的基础上继续微调得到的,包括我们使用最多的 SD1.4 和 SD1.5 模型;SD2.x 系列则是新开的故事线,使用了全新的模型结构。

功能介绍

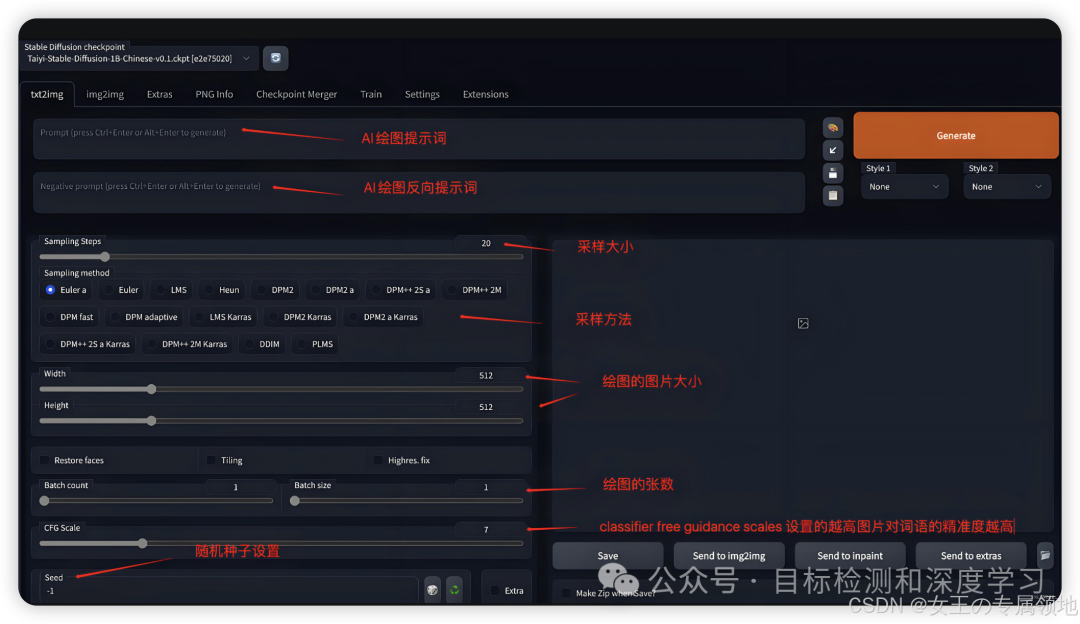

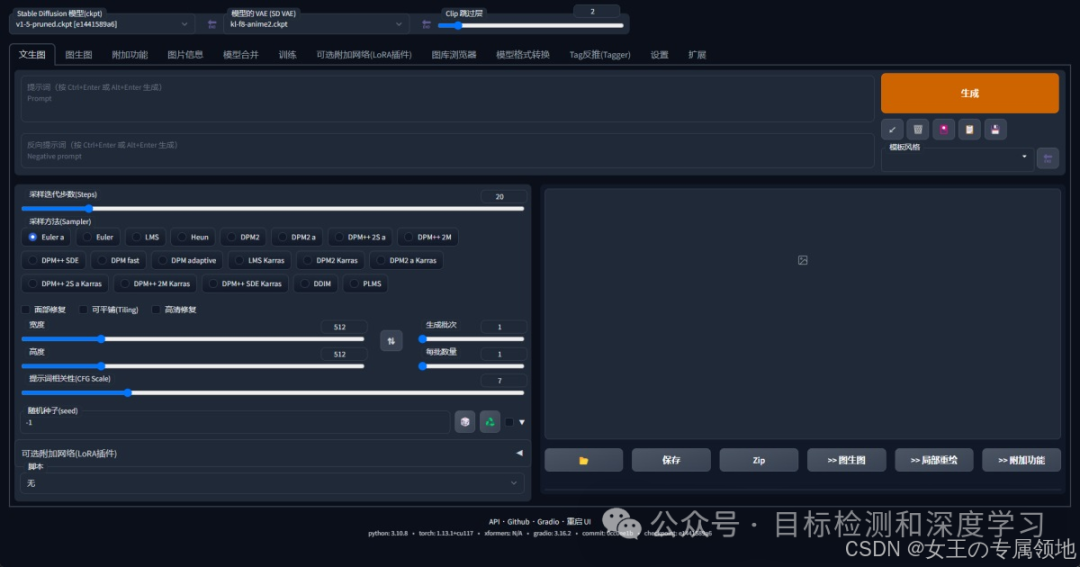

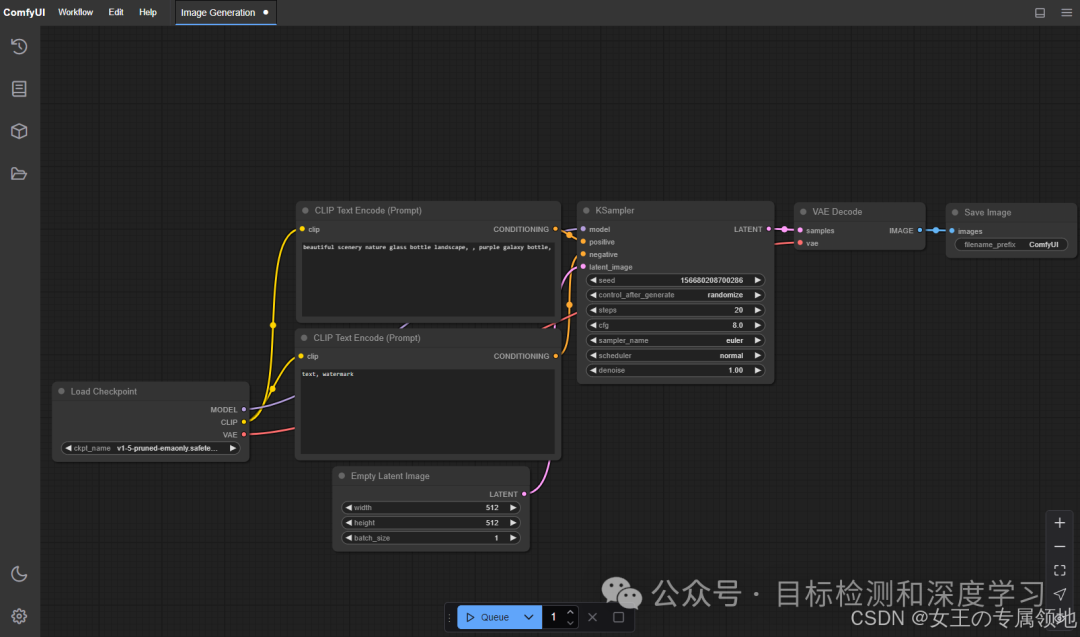

关于界面使用,SD有两种方式一种是webUI,另外一种是comfyUI,comfyUI是一种更灵活的工作流式的操作方式。

webUI

全程讲操作流程还是太费时间了,建议大家跟着教程走一遍基本就了然于胸了!我不在这里赘述,给大家一个比较强全面的讲解:

-

超详细!外婆都能看懂的Stable Diffusion入门教程

-

常用的模型网站 - C站:https://civitai.com/

comfyUI

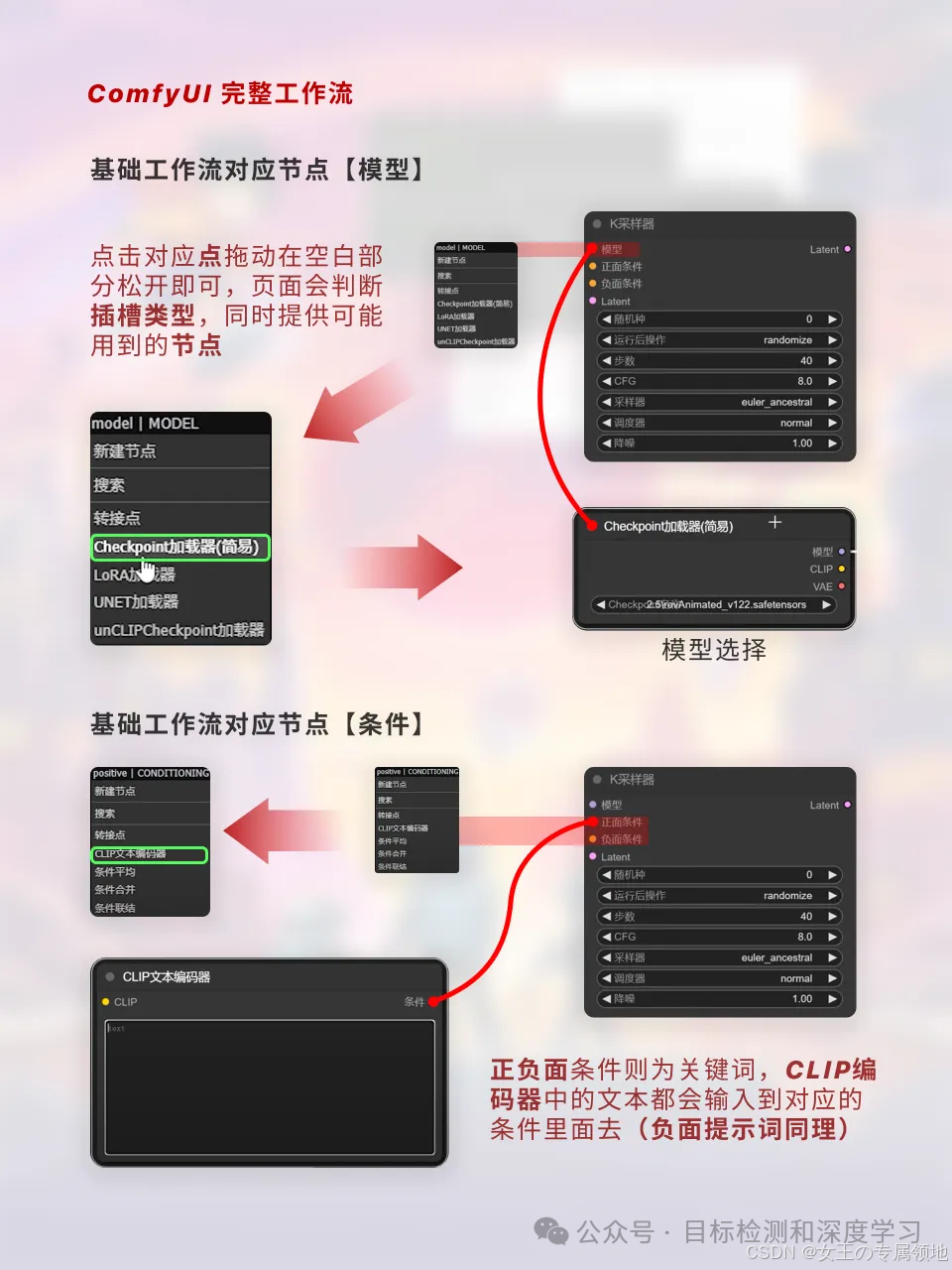

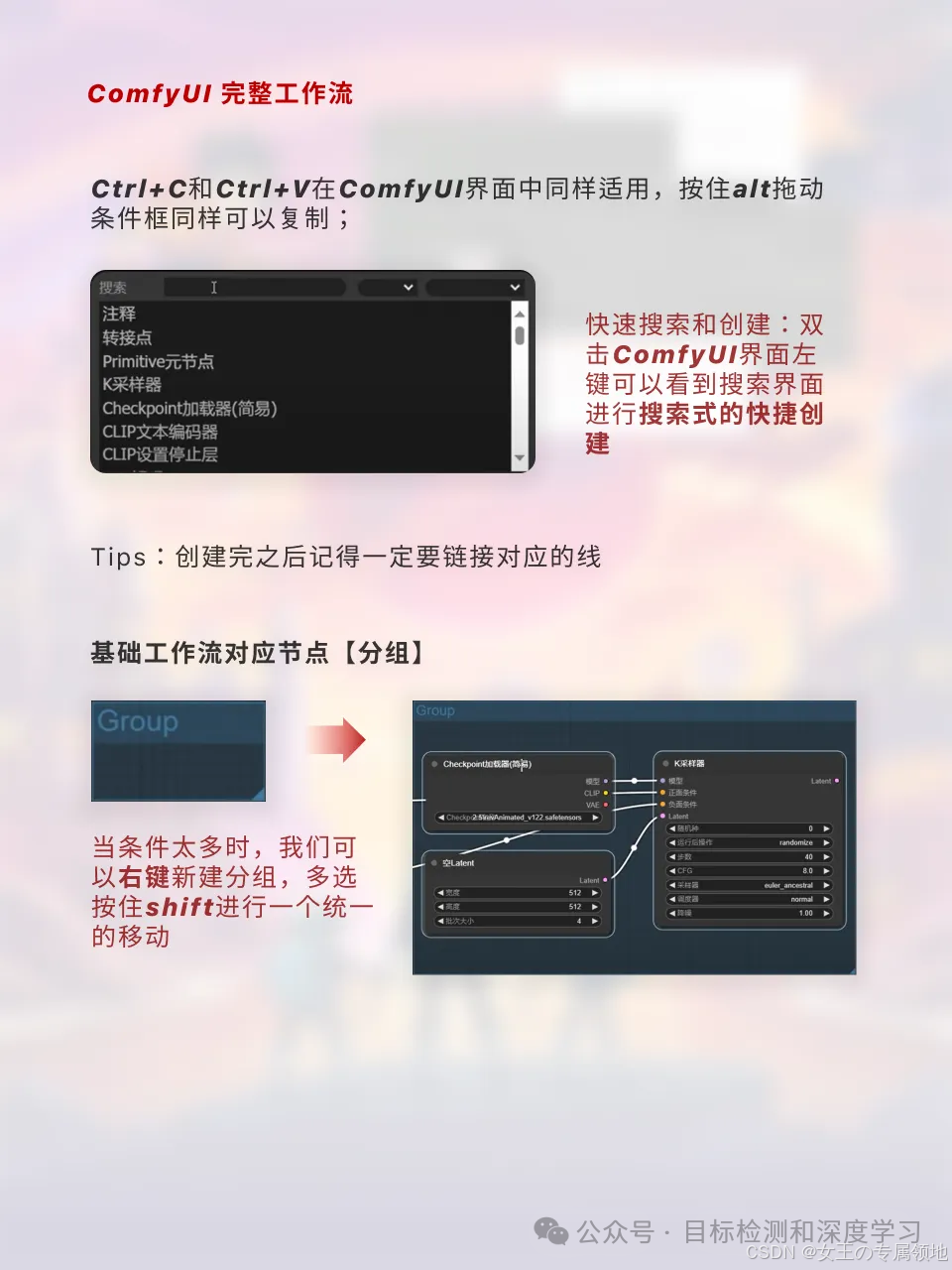

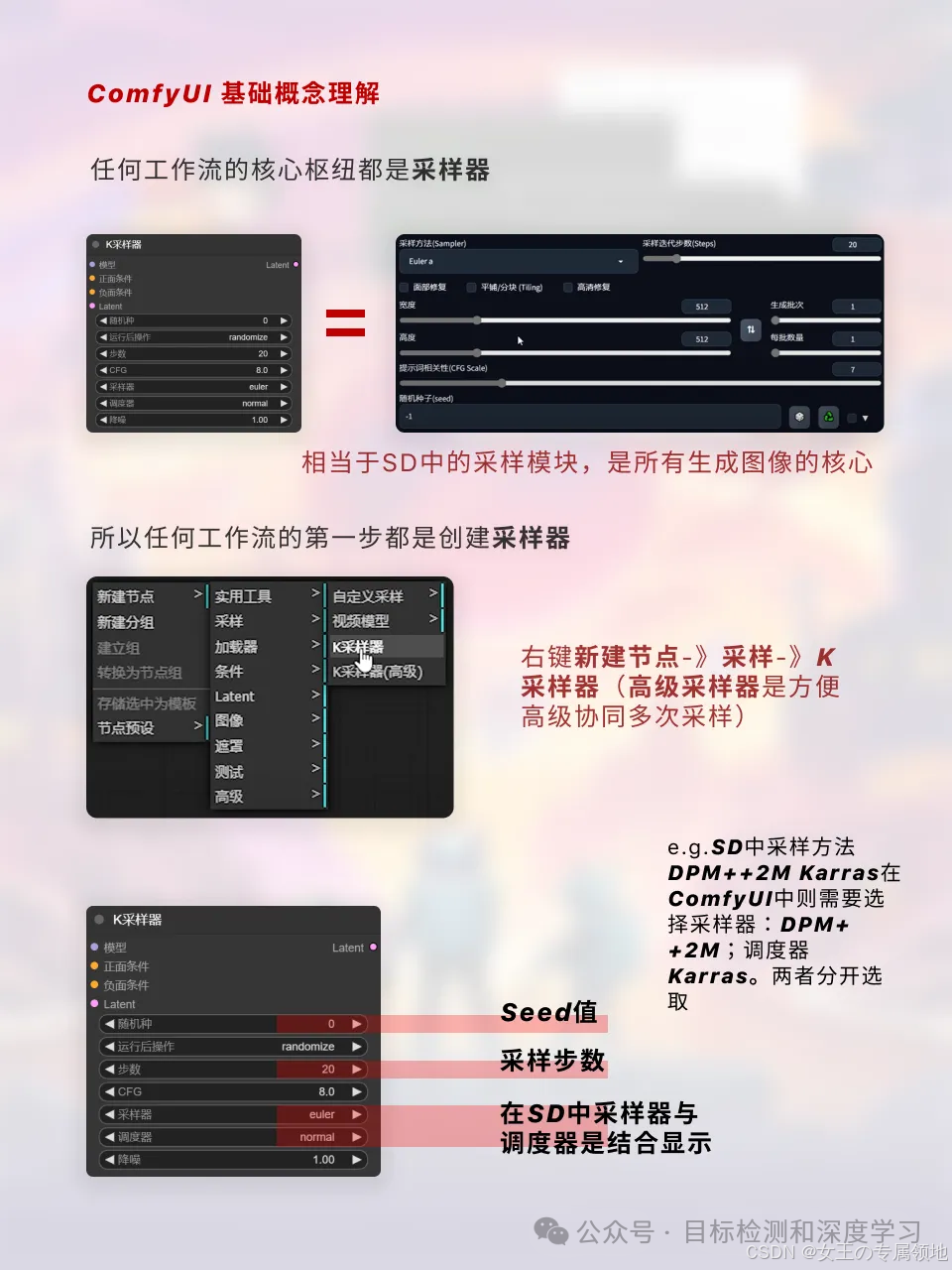

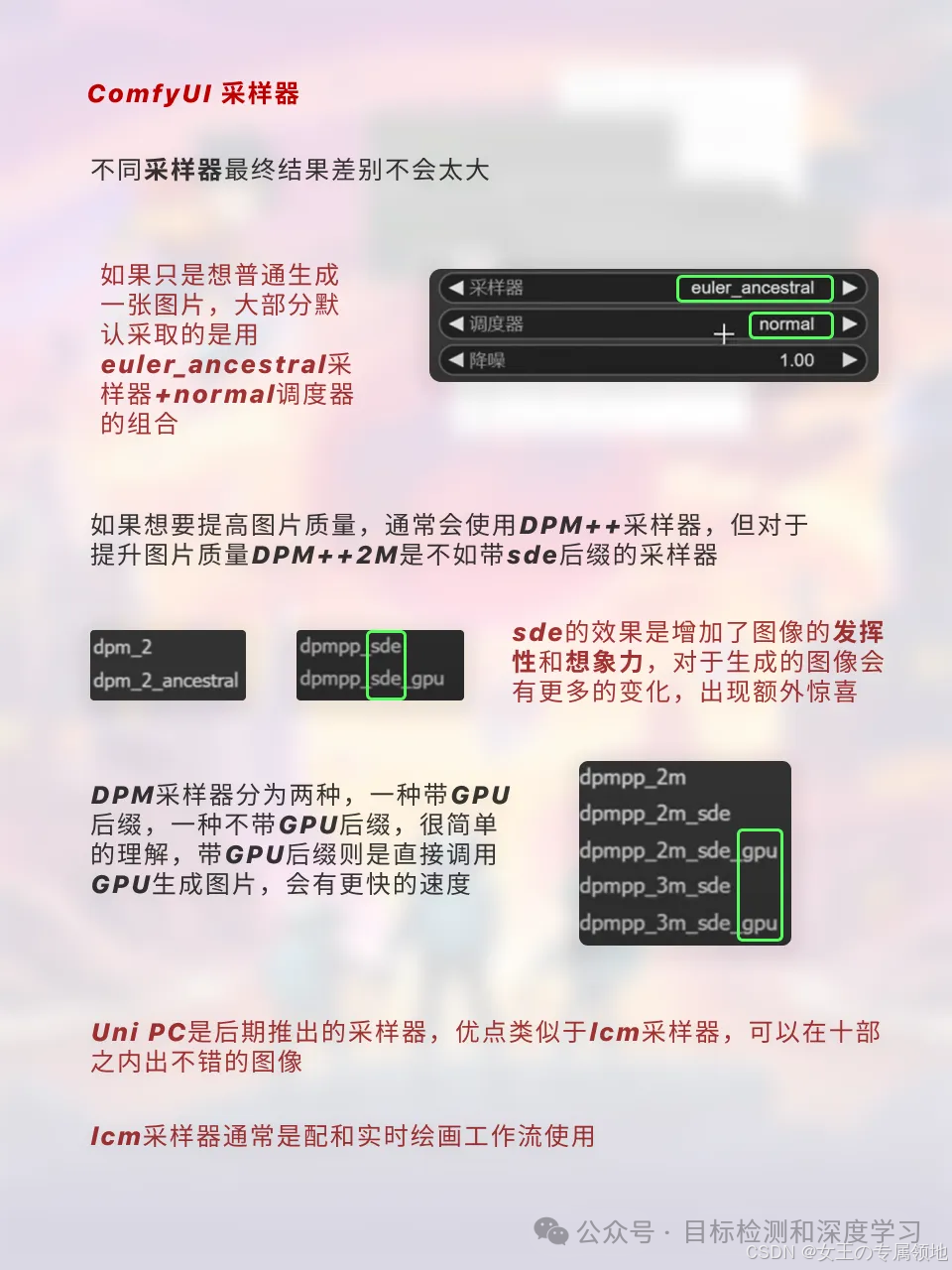

ComfyUI是一个为Stable Diffusion专门设计的基于节点的图形用户界面(GUI)。使用户能够通过链接不同的节点来构建复杂的图像生成工作流程。这些节点可以包括各种任务,如加载检查点模型、输入提示、指定采样器等。它实际上就是一个比较专业的Stable Diffusion运行界面,只不过是节点式的。这种节点式界面其实广泛的存在于各种专业的生产力工具中,例如 Blender、虚幻引擎、达芬奇等。

如果大家已经开始用coze这种工作流搭建平台的话,就不难理解了。在这里重点需要了解的一个是工作流怎么搭建,另外一个就是工作流节点的含义。这部分需要强调一下,有的同学是直接在本地进行部署,我电脑数据盘不允许,在AutoDL搭了一个可以参考这个,解决了贫穷的问题!!!:

-

[手把手教你在云环境炼丹(部署Stable Diffusion WebUI)]

-

官方介绍:https://github.com/comfyanonymous/ComfyUI?tab=readme-ov-file

-

🔥🔥强👍🏻 :ComfyUI工作流节点/底层逻辑详解

ComfyUI提供了极高的自由度和灵活性,支持高度的定制化和工作流复用,同时对系统配置的要求较低,并且能够加快原始图像的生成速度。然而,由于它拥有众多的插件节点,以及较为复杂的操作流程,学习起来相对困难。

另一方面,WebUI特点是拥有固定的操作界面,使得其易于学习和快速上手。经过一年多的发展,它已经建立了一个成熟且稳定的开源生态系统。但相比ComfyUI,在性能方面可能稍逊一筹,且在工作流程复制方面存在局限性,用户需在每次操作时手动进行设置。

因此,建议初学者从WebUI开始入手,熟悉后再考虑转ComfyUI,以充分利用AI工作流程,实现效率的最大化。

拓展知识

提示词引导系数(CFG Scale):

-

应用场景: 主要用于图像生成模型(如 DALL·E 或其他基于扩散模型的生成器)。

-

功能: CFG Scale 控制模型生成图像时对提示词的依赖程度。较高的 CFG Scale 值意味着模型更严格地遵循提示词,生成的图像与提示词更接近,而较低的值则允许模型有更多的创造性自由,生成的图像可能会更具创意,但与提示词的相关性较弱。

-

机制: 通过平衡提示词引导和无条件生成的过程来控制输出结果。

温度(Temperature):

-

应用场景: 主要用于文本生成模型(如 ChatGPT)。

-

功能: 温度控制模型生成文本时的随机性和多样性。较高的温度值(如 0.8-1.0)使模型生成的文本更具创意和多样性,输出的结果可能更不确定和富有变化;较低的温度值(如 0.2-0.5)使模型生成的文本更为保守、确定性更强,倾向于选择概率较高的词语或句子进行输出。

-

机制: 通过调整模型生成时的概率分布,控制输出文本的随机性。

总结: CFG Scale 和 Temperature 都用于调节生成内容的严格性和多样性。CFG Scale 更侧重于图像生成中对提示词的依赖性调整,而 Temperature 则用于文本生成中对输出随机性和创造性的控制。两者都在各自的生成任务中通过调整模型的行为来影响最终的输出结果。

技术原理

Stable diffusion是一种潜在扩散模型(latent diffusion model),扩散模型是在训练图像上逐渐添加噪声,最后变成完全随机噪声图。这个过程就像是一滴墨水滴在一杯清水里,会慢慢扩散最终均匀分布在清水里一样,扩散这个名字就是那么来的,参考下图:

这是一个前向扩散的过程,因为让一张图片越来越模糊没什么技术含量。而扩散模型就是通过训练让上述过程获得逆向从随机噪声图生成清晰图像的过程。实现下图的过程,而训练的重点就是下图中的**噪声预测器(noise predictor)**可以通过训练得出每次需要减掉的噪声,每次需要减多少噪声是预测出来的,这就是一个叫U-net的模型,从而实现还原清晰图片的目的。

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

零基础AI绘画学习资源介绍

👉stable diffusion新手0基础入门PDF👈

👉AI绘画必备工具👈

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉AI绘画基础+速成+进阶使用教程👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉12000+AI关键词大合集👈

这份完整版的AI绘画全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?