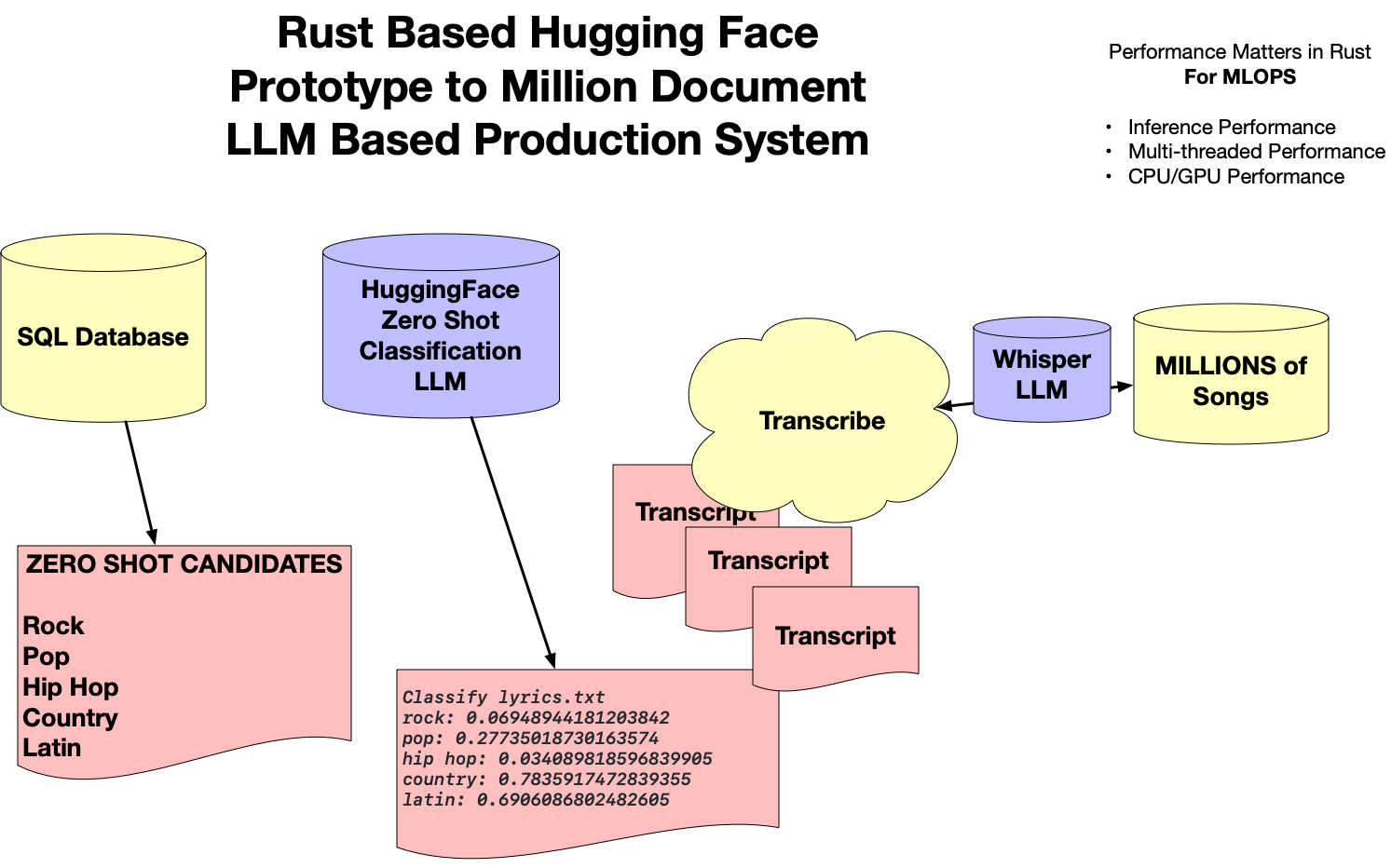

Rust MLOps模板:构建高效可靠的机器学习运维系统

在当今的人工智能和机器学习领域,MLOps (Machine Learning Operations) 已成为确保模型从开发到部署全生命周期高效运行的关键。而Rust作为一种安全、高性能的系统编程语言,正在MLOps领域展现出巨大的潜力。本文将深入探讨一个基于Rust的MLOps模板项目,介绍如何利用Rust构建高效可靠的机器学习运维系统。

项目动机

传统的MLOps工具链通常依赖于Python生态系统,如Jupyter、Conda、Pandas、NumPy和Scikit-learn等。然而,这些工具在某些方面存在局限性:

- 性能效率较低

- 缺乏编译时类型检查

- 包管理复杂

- 计算速度相对较慢

- 难以同时满足系统级编程和通用脚本编写需求

Rust MLOps模板项目旨在探索一种全新的MLOps方案,以解决上述问题。该项目的主要目标包括:

- 寻找更高性能的数据处理库,如Polars

- 利用Rust的编译器进行严格的类型检查

- 简化包管理和依赖处理

- 提供接近C语言的高性能计算能力

- 支持从Linux内核编程到通用脚本编写的广泛应用场景

- 提高能源效率,Rust是最环保的编程语言之一

项目概述

Rust MLOps模板项目提供了一系列工具和示例,涵盖了MLOps全流程的各个环节。主要特性包括:

- 命令行工具开发

- Web微服务构建

- 数据处理和分析

- 模型训练和部署

- 云平台集成

- 并行计算优化

项目采用模块化设计,每个子项目都专注于MLOps的特定方面,使用户可以根据需求选择性地使用或扩展。

核心功能展示

1. 命令行工具

项目提供了多个命令行工具示例,展示了如何使用Rust构建高效的MLOps CLI应用。

示例:文件去重工具

use std::collections::HashMap;

use md5;

pub fn checksum(files: Vec<String>) -> Result<HashMap<String, Vec<String>>, Box<dyn Error>> {

let mut checksums = HashMap::new();

for file in files {

let checksum = md5::compute(std::fs::read(&file)?);

let checksum = format!("{:x}", checksum);

checksums

.entry(checksum)

.or_insert_with(Vec::new)

.push(file);

}

Ok(checksums)

}

这个简单的示例展示了如何使用Rust高效地处理文件去重问题,利用HashMap存储文件校验和,实现快速查找和去重。

2. Web微服务

项目使用Actix Web框架构建了一个简单的计算器微服务,展示了Rust在Web开发领域的应用。

use actix_web::{get, web, App, HttpResponse, HttpServer, Responder};

#[get("/add/{a}/{b}")]

async fn add(info: web::Path<(i32, i32)>) -> impl Responder {

let result = calc::add(info.0, info.1);

HttpResponse::Ok().body(result.to_string())

}

#[actix_web::main]

async fn main() -> std::io::Result<()> {

HttpServer::new(|| {

App::new()

.service(index)

.service(add)

.service(subtract)

.service(multiply)

.service(divide)

})

.bind(("127.0.0.1", 8080))?

.run()

.await

}

这个微服务示例展示了如何使用Actix Web框架快速构建RESTful API,为MLOps提供了一个可扩展的Web服务基础。

3. 数据处理

项目集成了Polars库,展示了Rust在大规模数据处理方面的优势。

use polars::prelude::*;

pub fn sort_dataframe(df: &mut DataFrame, column: &str, descending: bool) -> Result<(), PolarsError> {

df.sort(column, descending)?;

Ok(())

}

这个简单的函数展示了如何使用Polars库对DataFrame进行排序操作,为MLOps中的数据预处理提供了高性能解决方案。

4. 机器学习集成

项目展示了如何在Rust中集成主流的机器学习库,如使用tch-rs与PyTorch进行交互。

use tch::{nn, Device, Tensor};

pub fn train_model(x: &Tensor, y: &Tensor) -> Result<nn::Linear, Box<dyn Error>> {

let vs = nn::VarStore::new(Device::Cpu);

let linear = nn::linear(&vs.root(), 1, 1, Default::default());

let mut opt = nn::Adam::default().build(&vs, 1e-3)?;

for _ in 1..100 {

let loss = linear.forward(x).mse_loss(y, tch::Reduction::Mean);

opt.backward_step(&loss);

}

Ok(linear)

}

这个示例展示了如何使用tch-rs在Rust中训练一个简单的线性回归模型,为MLOps提供了模型训练的基础实现。

5. 云平台集成

项目提供了与主流云平台(如AWS)集成的示例,展示了Rust在云原生MLOps中的应用。

use rusoto_core::Region;

use rusoto_s3::{S3Client, S3};

pub async fn list_buckets() -> Result<Vec<String>, Box<dyn Error>> {

let client = S3Client::new(Region::UsEast1);

let result = client.list_buckets().await?;

let bucket_names = result.buckets.unwrap_or_default()

.into_iter()

.filter_map(|bucket| bucket.name)

.collect();

Ok(bucket_names)

}

这个函数展示了如何使用Rusoto库与AWS S3服务交互,为MLOps提供了云存储访问能力。

6. 并行计算

项目利用Rust的并发特性,展示了如何实现高效的并行计算。

use rayon::prelude::*;

pub fn parallel_checksum(files: Vec<String>) -> Result<HashMap<String, Vec<String>>, Box<dyn Error>> {

let checksums = std::sync::Mutex::new(HashMap::new());

files.par_iter().for_each(|file| {

let checksum = md5::compute(std::fs::read(file).unwrap());

let checksum = format!("{:x}", checksum);

checksums

.lock()

.unwrap()

.entry(checksum)

.or_insert_with(Vec::new)

.push(file.to_string());

});

Ok(checksums.into_inner().unwrap())

}

这个并行版本的文件校验和计算函数展示了如何使用Rayon库实现简单高效的并行处理,大幅提升了处理大量文件时的性能。

项目亮点

- 高性能:Rust的零成本抽象和编译优化确保了MLOps工具链的高效运行。

- 安全可靠:Rust的所有权系统和严格的类型检查大大减少了运行时错误。

- 易于扩展:模块化设计使得用户可以轻松地扩展和定制MLOps工具链。

- 跨平台支持:Rust的跨平台特性确保了MLOps工具可以在不同环境中一致运行。

- 生态系统整合:项目展示了如何将Rust与现有的MLOps生态系统(如PyTorch、AWS等)无缝集成。

使用指南

-

克隆项目仓库:

git clone https://github.com/nogibjj/rust-mlops-template.git -

进入项目目录:

cd rust-mlops-template -

构建项目:

cargo build --release -

运行示例:

cargo run --bin <example_name>

未来展望

Rust MLOps模板项目仍在不断发展中,未来计划包括:

- 集成更多主流机器学习框架

- 开发更多云原生MLOps工具

- 优化大规模数据处理性能

- 提供更多端到端MLOps流程示例

- 加强与容器化和编排技术的集成

结语

Rust MLOps模板项目为机器学习从业者提供了一个全新的视角,展示了如何利用Rust语言的优势构建高效、可靠的MLOps系统。随着项目的不断发展和完善,它有潜力成为MLOps领域的重要工具,推动机器学习工程实践向更高效、更可靠的方向发展。

无论您是MLOps专家还是Rust爱好者,这个项目都值得深入研究和尝试。它不仅能够提升您的MLOps工作流效率,还能帮助您掌握Rust在系统编程和机器学习领域的应用技巧。我们期待看到更多基于Rust的创新MLOps解决方案涌现,共同推动人工智能技术的进步。

通过深入学习和实践Rust MLOps模板项目,您将能够:

- 掌握使用Rust构建高性能MLOps工具的技能

- 了解如何将Rust与主流机器学习框架和云平台集成

- 提高MLOps流程的效率和可靠性

- 探索Rust在数据科学和机器学习领域的潜力

我们鼓励您积极参与项目的开发和讨论,为Rust MLOps生态系统的繁荣贡献自己的力量。让我们一起开创MLOps的美好未来!

相关项目

查看

查看

查看

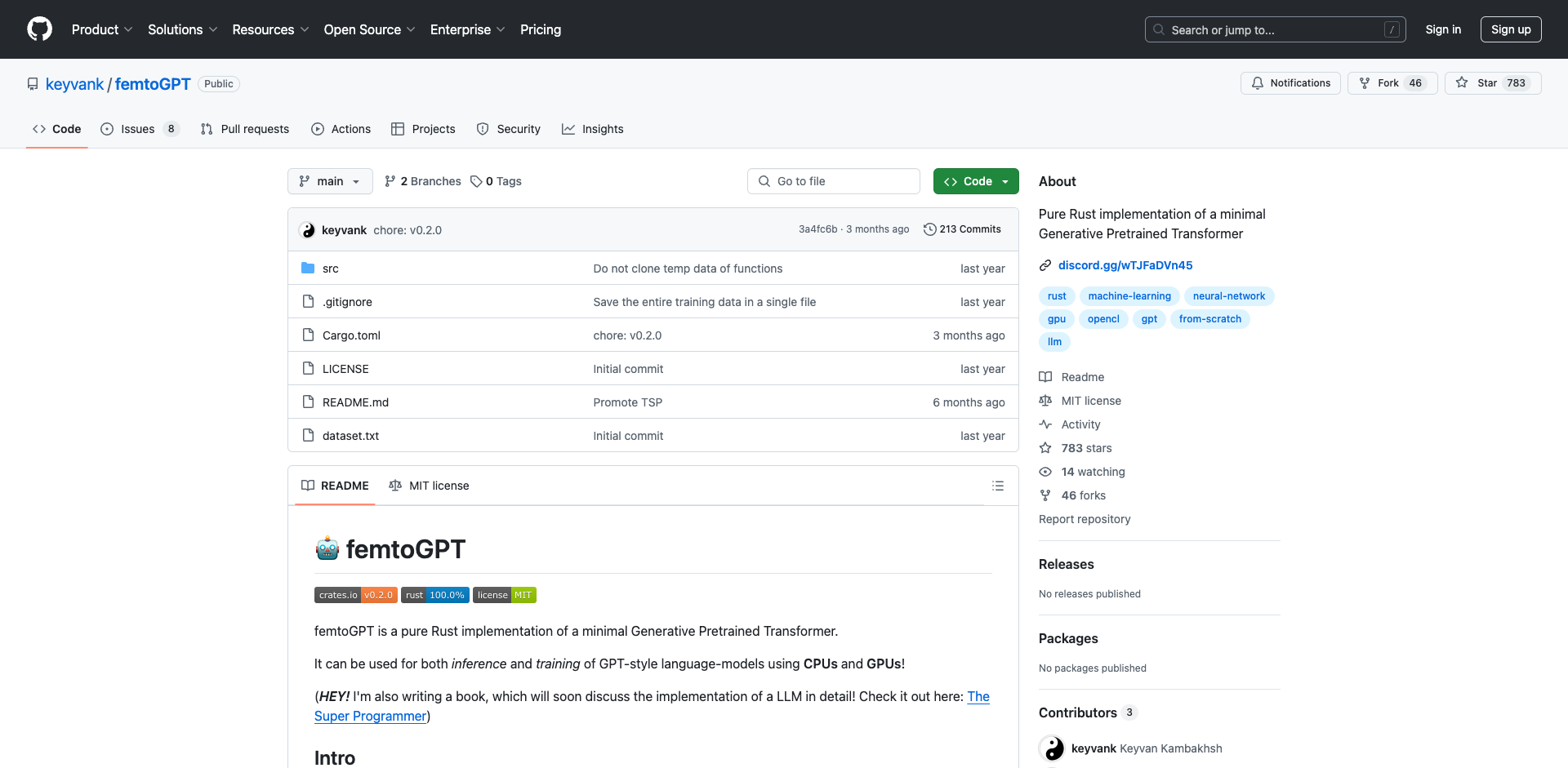

该项目因时间和资源不足已归档,建议使用其他高质量的Rust推理库,如Ratchet、Candle和llama.cpp等。项目原README包含当前状态、支持的模型及使用方法等详细信息。

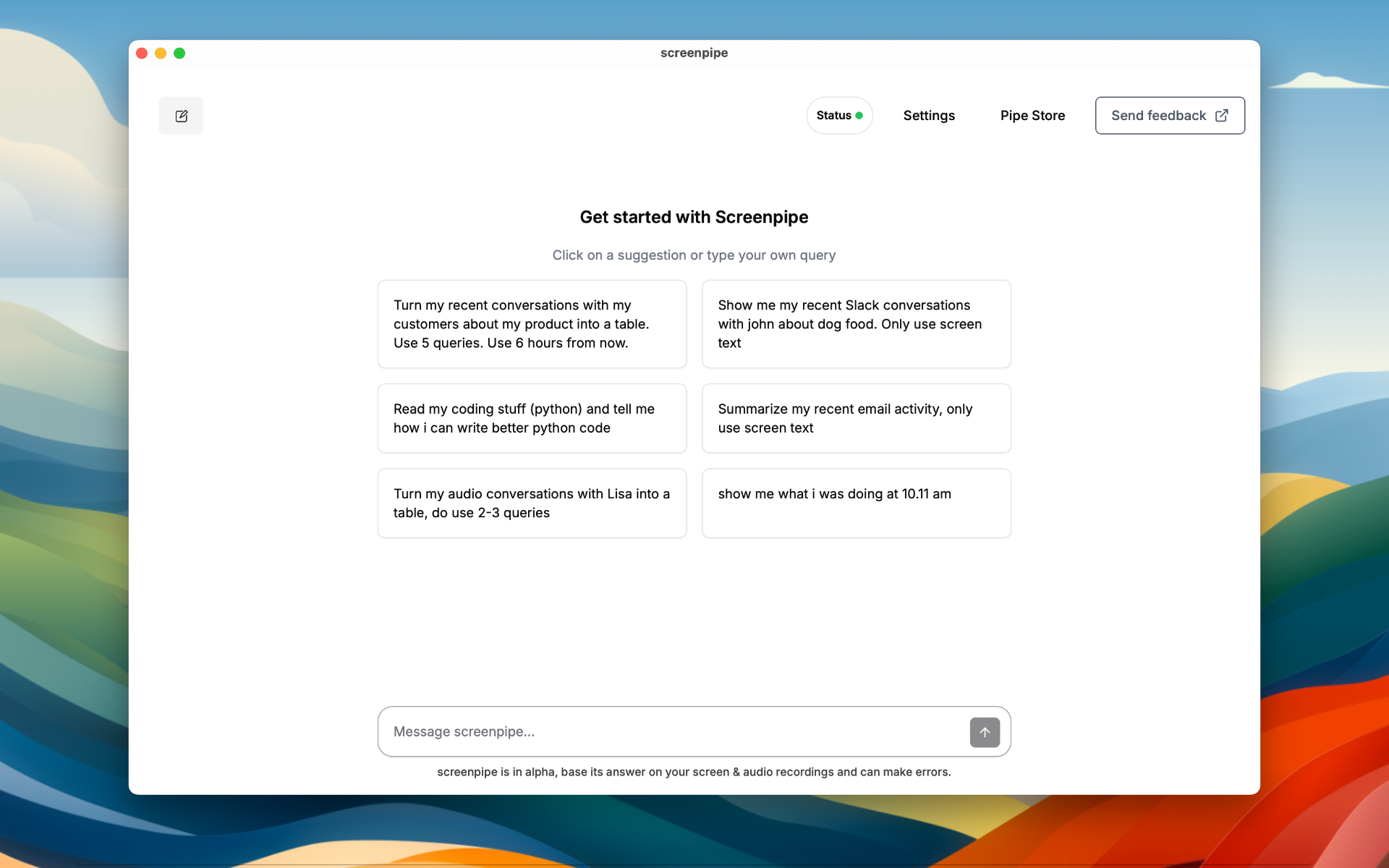

查看

相关文章

tch-rs: Rust绑定PyTorch C++ API的强大工具

femtoGPT: 纯Rust实现的极简生成式预训练Transformer

Ollama Grid Search: 一款强大的LLM模型评估和比较工具

项目链接:www.dongaigc.com/a/rust-mlops-template-machine-learning-ops

https://www.dongaigc.com/a/rust-mlops-template-machine-learning-ops

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?