官网 Kubernetes

前言

本模块主要针对使用kadm工具安装部署k8s集群,步骤大致可以分为三块,安装kadm,安装容器运行时,使用kadm集群安装k8s;

其中前期准备项,以及操作前提都需要注意,这些细节可能会影响到k8s的稳定部署。

kubeadm安装(master、Node)

准备开始:

- 一台兼容的 Linux 主机。Kubernetes 项目为基于 Debian 和 Red Hat 的 Linux 发行版以及一些不提供包管理器的发行版提供通用的指令。

- 每台机器 2 GB 或更多的 RAM(如果少于这个数字将会影响你应用的运行内存)。

- CPU 2 核心及以上。

- 集群中的所有机器的网络彼此均能相互连接(公网和内网都可以)。

- 节点之中不可以有重复的主机名、MAC 地址或 product_uuid。请参见这里了解更多详细信息。

- 开启机器上的某些端口。请参见这里了解更多详细信息。

6379/tcp 26379/tcp 10250/tcp 443/tcp 30000-32767/tcp 9000/tcp 9001/tcp 10255/tcp 8472/udp 80/tcp 10262/tcp

- 禁用交换分区。为了保证 kubelet 正常工作,你必须禁用交换分区

- 禁用SELinux

vim /etc/sysconfig/selinux将SELINUX=enforcing修改为SELINUX=disabled

禁用原因

你似乎来到了没有知识存在的荒原 - 知乎

确保每个节点上 MAC 地址和 product_uuid 的唯一性

- 你可以使用命令

ip link或ifconfig -a来获取网络接口的 MAC 地址 - 可以使用

sudo cat /sys/class/dmi/id/product_uuid命令对 product_uuid 校验

检查网络适配器

如果你有一个以上的网络适配器,同时你的 Kubernetes 组件通过默认路由不可达,我们建议你预先添加 IP 路由规则, 这样 Kubernetes 集群就可以通过对应的适配器完成连接。

检查所需端口

启用这些必要的端口后才能使 Kubernetes 的各组件相互通信。 可以使用 netcat 之类的工具来检查端口是否启用

安装容器运行时(CRIO)

为了在 Pod 中运行容器,Kubernetes 使用 容器运行时(Container Runtime)。

默认情况下,Kubernetes 使用 容器运行时接口(Container Runtime Interface,CRI) 来与你所选择的容器运行时交互。

如果你不指定运行时,kubeadm 会自动尝试通过扫描已知的端点列表来检测已安装的容器运行时。

如果检测到有多个或者没有容器运行时,kubeadm 将抛出一个错误并要求你指定一个想要使用的运行时。

安装 kubeadm、kubelet 和 kubectl

基于RedHat

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-\$basearch

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

# 将 SELinux 设置为 permissive 模式(相当于将其禁用)

sudo setenforce 0

sudo sed -i 's/^SELINUX=enforcing$/SELINUX=permissive/' /etc/selinux/config

sudo yum install -y kubelet kubeadm kubectl --disableexcludes=kubernetes

sudo systemctl enable --now kubelet💡

在安装过程中失败,操作如下:

yum clean

yum makecache

执行完命令后,再按照上面步骤重新安装

请注意:

通过运行命令setenforce 0和sed ...将 SELinux 设置为 permissive 模式可以有效地将其禁用。 这是允许容器访问主机文件系统所必需的,而这些操作是为了例如 Pod 网络工作正常。

你必须这么做,直到 kubelet 做出对 SELinux 的支持进行升级为止。

如果你知道如何配置 SELinux 则可以将其保持启用状态,但可能需要设定 kubeadm 不支持的部分配置

如果由于该 Red Hat 的发行版无法解析basearch导致获取baseurl失败,请将\$basearch替换为你计算机的架构。 输入uname -m以查看该值。 例如,x86_64的baseurlURL 可以是: https://packages.cloud.google.com/yum/repos/kubernetes-el7-x86_64。

安装完成调用kubelet

kubelet

3.容器运行时(节点)

说明: 自 1.24 版起,Dockershim 已从 Kubernetes 项目中移除。阅读 Dockershim 移除的常见问题 了解更多详情。

你需要在集群内每个节点上安装一个 容器运行时 以使 Pod 可以运行在上面。本文概述了所涉及的内容并描述了与节点设置相关的任务。

Kubernetes 1.25 要求你使用符合容器运行时接口(CRI)的运行时。

有关详细信息,请参阅 CRI 版本支持。 本页简要介绍在 Kubernetes 中几个常见的容器运行时的用法。

说明:

v1.24 之前的 Kubernetes 版本直接集成了 Docker Engine 的一个组件,名为 dockershim。 这种特殊的直接整合不再是 Kubernetes 的一部分 (这次删除被作为 v1.20 发行版本的一部分 宣布)。

你可以阅读 检查 Dockershim 移除是否会影响你以了解此删除可能会如何影响你。 要了解如何使用 dockershim 进行迁移, 请参阅 从 dockershim 迁移。

如果你正在运行 v1.25 以外的 Kubernetes 版本,查看对应版本的文档。

安装和配置前提条件

以下步骤将通用设置应用于 Linux 上的 Kubernetes 节点。

如果你确定不需要某个特定设置,则可以跳过它。

有关更多信息,请参阅网络插件要求或特定容器运行时的文档

转发 IPv4 并让 iptables 看到桥接流量

- 通过运行

lsmod | grep br_netfilter来验证br_netfilter模块是否已加载;如果未加载运行sudo modprobe br_netfilter - 为了让 Linux 节点的 iptables 能够正确查看桥接流量,请确认

sysctl配置中的net.bridge.bridge-nf-call-iptables设置为 1

cat <<EOF | sudo tee /etc/modules-load.d/k8s.conf

overlay

br_netfilter

EOF

sudo modprobe overlay

sudo modprobe br_netfilter

# 设置所需的 sysctl 参数,参数在重新启动后保持不变

cat <<EOF | sudo tee /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-iptables = 1

net.bridge.bridge-nf-call-ip6tables = 1

net.ipv4.ip_forward = 1

EOF

# 应用 sysctl 参数而不重新启动

sudo sysctl --system

cgroup 驱动 (了解)

在 Linux 上, 控制组(CGroup)用于限制分配给进程的资源

kubelet 和底层容器运行时都需要对接控制组来强制执行 为 Pod 和容器管理资源 并为诸如 CPU、内存这类资源设置请求和限制。若要对接控制组,kubelet 和容器运行时需要使用一个 cgroup 驱动。 关键的一点是 kubelet 和容器运行时需使用相同的 cgroup 驱动并且采用相同的配置。

可用的 cgroup 驱动有两个:

cgroupfs 驱动

cgroupfs 驱动是 kubelet 中默认的 cgroup 驱动。当使用 cgroupfs 驱动时, kubelet 和容器运行时将直接对接 cgroup 文件系统来配置 cgroup。

📌

当 systemd 是初始化系统时, 不 推荐使用 cgroupfs 驱动,因为 systemd 期望系统上只有一个 cgroup 管理器。 此外,如果你使用 cgroup v2, 则应用 systemd cgroup 驱动取代 cgroupfs

systemd cgroup 驱动

当某个 Linux 系统发行版使用

systemd 作为其初始化系统时,初始化进程会生成并使用一个 root 控制组(

cgroup),并充当 cgroup 管理器。

systemd 与 cgroup 集成紧密,并将为每个 systemd 单元分配一个 cgroup。 因此,如果你 systemd 用作初始化系统,同时使用 cgroupfs 驱动,则系统中会存在两个不同的 cgroup 管理器。

问题:

同时存在两个 cgroup 管理器将造成系统中针对可用的资源和使用中的资源出现两个视图。某些情况下, 将 kubelet 和容器运行时配置为使用cgroupfs、但为剩余的进程使用systemd的那些节点将在资源压力增大时变得不稳定。

解决办法:

当 systemd 是选定的初始化系统时,缓解这个不稳定问题的方法是针对 kubelet 和容器运行时将systemd用作 cgroup 驱动

要将 systemd 设置为 cgroup 驱动,需编辑 KubeletConfiguration 的 cgroupDriver 选项,并将其设置为 systemd

apiVersion: kubelet.config.k8s.io/v1beta1

kind: KubeletConfiguration

...

cgroupDriver: systemd🔔

注意:

注意:更改已加入集群的节点的 cgroup 驱动是一项敏感的操作。

如果 kubelet 已经使用某 cgroup 驱动的语义创建了 Pod,更改运行时以使用别的 cgroup 驱动,当为现有 Pod 重新创建 PodSandbox 时会产生错误。 重启 kubelet 也可能无法解决此类问题。

如果你有切实可行的自动化方案,使用其他已更新配置的节点来替换该节点, 或者使用自动化方案来重新安装。

将 kubeadm 管理的集群迁移到 systemd 驱动

如果你希望将现有的由 kubeadm 管理的集群迁移到 systemd cgroup 驱动, 请按照配置 cgroup 驱动操作。

CRI 版本支持

你的容器运行时必须至少支持 v1alpha2 版本的容器运行时接口。

Kubernetes 1.25 默认使用 v1 版本的 CRI API。如果容器运行时不支持 v1 版本的 API, 则 kubelet 会回退到使用(已弃用的)v1alpha2 版本的 API。

容器运行时

containerd

按照开始使用 containerd 的说明进行操作。 创建有效的配置文件 config.toml 后返回此步骤

在 Linux 上,containerd 的默认 CRI 套接字是 /run/containerd/containerd.sock。 在 Windows 上,默认 CRI 端点是 npipe://./pipe/containerd-containerd。

配置 systemd cgroup 驱动

结合 runc 使用 systemd cgroup 驱动,在 /etc/containerd/config.toml 中设置:

[plugins."io.containerd.grpc.v1.cri".containerd.runtimes.runc]

...

[plugins."io.containerd.grpc.v1.cri".containerd.runtimes.runc.options]

SystemdCgroup = true如果你使用 cgroup v2,则推荐 systemd cgroup 驱动。

说明:

如果你从软件包(例如,RPM 或者.deb)中安装 containerd,你可能会发现其中默认禁止了 CRI 集成插件。

你需要启用 CRI 支持才能在 Kubernetes 集群中使用 containerd。 要确保cri没有出现在/etc/containerd/config.toml文件中disabled_plugins列表内。如果你更改了这个文件,也请记得要重启containerd。

如果你应用此更改,请确保重新启动 containerd:

sudo systemctl restart containerd当使用 kubeadm 时,请手动配置 kubelet 的 cgroup 驱动。

在你的 containerd 配置中, 你可以通过设置以下选项重载沙箱镜像:

[plugins."io.containerd.grpc.v1.cri"] sandbox_image = "registry.k8s.io/pause:3.2"一旦你更新了这个配置文件,可能就同样需要重启 containerd:systemctl restart containerd

CRI-O

本节包含安装 CRI-O 作为容器运行时的必要步骤。

要安装 CRI-O,请按照 CRI-O 安装说明执行操作。

Redhet版本下载

curl -L -o /etc/yum.repos.d/devel:kubic:libcontainers:stable.repo https://download.opensuse.org/repositories/devel:/kubic:/libcontainers:/stable/$OS/devel:kubic:libcontainers:stable.repo

curl -L -o /etc/yum.repos.d/devel:kubic:libcontainers:stable:cri-o:$VERSION.repo https://download.opensuse.org/repositories/devel:kubic:libcontainers:stable:cri-o:$VERSION/$OS/devel:kubic:libcontainers:stable:cri-o:$VERSION.repo

yum install cri-ocgroup 驱动

CRI-O 默认使用 systemd cgroup 驱动,这对你来说可能工作得很好。 要切换到 cgroupfs cgroup 驱动,请编辑 /etc/crio/crio.conf 或在 /etc/crio/crio.conf.d/02-cgroup-manager.conf 中放置一个插入式配置,例如:

[crio.runtime]conmon_cgroup = "pod"cgroup_manager = "cgroupfs"你还应该注意当使用 CRI-O 时,并且 CRI-O 的 cgroup 设置为 cgroupfs 时,必须将 conmon_cgroup 设置为值 pod。 通常需要保持 kubelet 的 cgroup 驱动配置(通常通过 kubeadm 完成)和 CRI-O 同步。

对于 CRI-O,CRI 套接字默认为 /var/run/crio/crio.sock。

重载沙箱(pause)镜像

在你的 CRI-O 配置中, 你可以设置以下配置值:

[crio.image]pause_image="registry.k8s.io/pause:3.6"这一设置选项支持动态配置重加载来应用所做变更:systemctl reload crio。 也可以通过向 crio 进程发送 SIGHUP 信号来实现

Docker Engine

说明:

以下操作假设你使用 cri-dockerd 适配器来将 Docker Engine 与 Kubernetes 集成。

- 在你的每个节点上,遵循安装 Docker Engine 指南为你的 Linux 发行版安装 Docker。

- 按照源代码仓库中的说明安装 cri-dockerd。

对于 cri-dockerd,默认情况下,CRI 套接字是 /run/cri-dockerd.sock。

Mirantis 容器运行时

Mirantis Container Runtime (MCR) 是一种商用容器运行时,以前称为 Docker 企业版。 你可以使用 MCR 中包含的开源 cri-dockerd 组件将 Mirantis Container Runtime 与 Kubernetes 一起使用。

要了解有关如何安装 Mirantis Container Runtime 的更多信息, 请访问 MCR 部署指南。

检查名为 cri-docker.socket 的 systemd 单元以找出 CRI 套接字的路径。

重载沙箱(pause)镜像

cri-dockerd 适配器能够接受指定用作 Pod 的基础容器的容器镜像(“pause 镜像”)作为命令行参数。 要使用的命令行参数是 --pod-infra-container-image。

4.使用 kubeadm 创建集群

使用kubeadm,你能创建一个符合最佳实践的最小化 Kubernetes 集群。

,你可以使用kubeadm配置一个通过 Kubernetes 一致性测试的集群。kubeadm还支持其他集群生命周期功能, 例如 启动引导令牌和集群升级。

你可以在各种机器上安装和使用 kubeadm:笔记本电脑, 一组云服务器,Raspberry Pi 等。无论是部署到云还是本地, 你都可以将 kubeadm 集成到预配置系统中,例如 Ansible 或 Terraform。

目标

- 安装单个控制平面的 Kubernetes 集群

- 在集群上安装 Pod 网络,以便你的 Pod 可以相互连通

👋

问题:

- 开启cri

- 共享master配置

#node节点操作

#1.开启cri

vim /etc/containerd/config.toml

distablePlugins=['cri'] #注释掉

systemctl restart containerd

#or

systemctl start crio

kubeadm reset

#2.共享master配置信息

#master

scp /etc/kubernetes/admin.conf ip:/etc/kubernetes/admin.conf

#node

echo "export KUBECONFIG=/etc/kubernetes/admin.conf" >> /etc/profile

source /etc/profilekubadm引导安装完之后,在节点服务器下执行join命令

#将admin登录信息拷贝到各个节点信息

scp /etc/kubernetes/admin.conf 10.*.*.*:/etc/kubernetes/admin.conf

kubeadm join 10.13.34.152:6443 --token si03a8.5qr8kcg5ofjzl85c \

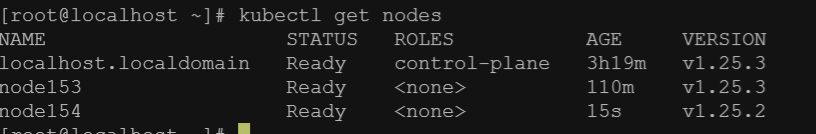

--discovery-token-ca-cert-hash sha256:bb1aac1f58eaedb5cd1acb4eabd55e4ff40e82dad4e9ad817218ac124ec81681最后获取节点信息:

kubectl get nodes

如果没有令牌,可以通过在控制平面节点上运行以下命令来获取令牌:

kubeadm token list默认情况下,令牌会在 24 小时后过期。如果要在当前令牌过期后将节点加入集群, 则可以通过在控制平面节点上运行以下命令来创建新令牌:

kubeadm token create输出类似于以下内容:

5didvk.d09sbcov8ph2amjw如果你没有 --discovery-token-ca-cert-hash 的值,则可以通过在控制平面节点上执行以下命令链来获取它:

openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | \ openssl dgst -sha256 -hex | sed 's/^.* //'输出类似于以下内容:

8cb2de97839780a412b93877f8507ad6c94f73add17d5d7058e91741c9d5ec78

2245

2245

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?