收藏关注不迷路

前言

Scrapy是一个Python编写的强大,灵活的网络爬虫框架和数据提取工具。它使用异步I/O网络库Twisted进行高效的爬取,并将提取到的数据存储到多种格式中。然而,在需要大规模爬取复杂的网站时,单机爬虫速度会受到限制。为了解决这个问题,Scrapy提供了分布式爬虫系统。

分布式爬虫系统可以加快爬虫速度,提高效率。它通过将爬虫任务分配给不同的计算机节点来实现这一目的。每个节点处理爬取请求,并将结果传输回主控节点进行汇总。这使得爬虫可以同时运行在多台计算机上,从而实现水平扩展和负载均衡。这样可以大大加快爬取速度,应对大规模的爬取任务。

除了基础的分布式方案,Scrapy还支持一些高级功能,如从Redis中分配URL设置。通过此机制,爬虫可以从分布式存储中读取URL,使其更加智能化和高效。此外,它还具有任务调度,负载均衡和故障容错等强。

本文首先介绍了scrapy分布式爬虫的发展背景与发展现状,然后遵循软件常规开发流程,首先针对系统选取适用的语言和开发平台,根据需求分析制定模块并设计数据库结构,再根据系统总体功能模块的设计绘制系统的功能模块图,流程图以及E-R图。然后,设计框架并根据设计的框架编写代码以实现系统的各个功能模块。最后,对初步完成的系统进行测试,主要是功能测试、单元测试和性能测试。测试结果表明,该系统能够实现所需的功能,运行状况尚可并无明显缺点。

一、项目介绍

随着社会的快速发展,计算机的影响是全面且深入的。人们生活水平的不断提高,日常生活中人们对scrapy分布式爬虫方面的要求也在不断提高,scrapy分布式爬虫得到广大用户的青睐,使得scrapy分布式爬虫的开发成为必需而且紧迫的事情。scrapy分布式爬虫主要是借助计算机,通过对scrapy分布式爬虫所需的信息管理,增加用户的选择,同时也方便对广大用户信息的及时查询、修改以及对用户信息的及时了解。scrapy分布式爬虫对用户带来了更多的便利,该系统通过和数据库管理系统软件协作来满足用户的需求。计算机技术在现代管理中的应用,使计算机成为人们应用现代技术的重要工具。能够有效的解决获取信息便捷化、全面化的问题,提高效率。

随着网络技术的不断发展,多媒体技术应用渐渐的出现在教育领域中,用户网购已经成为社会的一个热门话题。互联网应用在全球范围内日益普及,在许多的网络服务中,Web给人耳目一新的感觉。在这其中,网络平台开展的工作已经越来越流行,当今网络技术的发展,已经成为一种新的工作方式,人们可以通过网络所提供的平台解决相关事务。在众多网络开发技术中,Python是当前很热门的一种软件,因为它可以进行数据库操作及方便用户控制管理。

二、开发环境

开发语言:Python

python框架:django

软件版本:python3.7/python3.8

数据库:mysql 5.7或更高版本

数据库工具:Navicat11

开发软件:PyCharm/vs code

前端框架:vue.js

————————————————

三、功能介绍

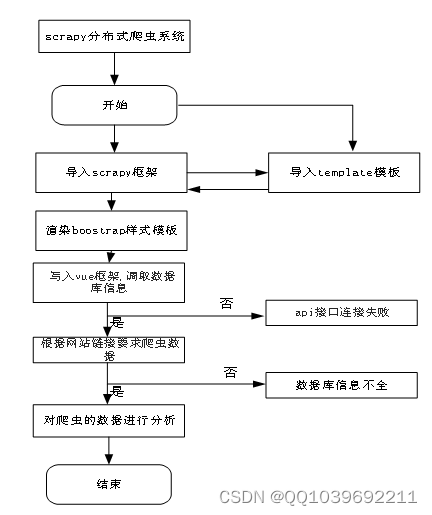

为了更好的去理清本系统整体思路,对该系统以结构图的形式表达出来,设计实现该scrapy分布式爬虫的流程图如下所示。

Scrapy 分布式爬虫的设计和实现涉及以下主要步骤:

- 设置分布式环境: 需要使用一个调度器来协调不同机器之间的任务分配和通信,常用的有 Redis 或 RabbitMQ。

- 定义数据模型: 确定你要抓取的数据信息的键值对格式,用于传递数据给节点处理。

- 编写爬虫代码: 编写常规的 Scrapy 爬虫代码,并根据需要添加一些分布式的功能,如去重、分发任务等。同时配置好 scrapy-redis 库,使其能够实现与分布式环境的数据通信。

- 部署节点: 将编写好的代码部署在多个节点上,启动各自的 scrapy 服务,在运行时注册到分布式环境中的调度器,使其可以接收来自全局的任务请求。

- 启动调度器: 启动分布式环境中的调度器,监控每个节点的状态和任务执行情况,并将任务分配给空闲的节点。

- 检查数据结果: 检查从各个节点中返回的数据结果,将其组合起来以生成最终结果。

通过以上步骤,我们就能够设计和实现一个基本的 Scrapy 分布式爬虫系统。

图4-1 系统爬虫流程图

四、核心代码

部分代码:

def users_login(request):

if request.method in ["POST", "GET"]:

msg = {'code': normal_code, "msg": mes.normal_code}

req_dict = request.session.get("req_dict")

if req_dict.get('role')!=None:

del req_dict['role']

datas = users.getbyparams(users, users, req_dict)

if not datas:

msg['code'] = password_error_code

msg['msg'] = mes.password_error_code

return JsonResponse(msg)

req_dict['id'] = datas[0].get('id')

return Auth.authenticate(Auth, users, req_dict)

def users_register(request):

if request.method in ["POST", "GET"]:

msg = {'code': normal_code, "msg": mes.normal_code}

req_dict = request.session.get("req_dict")

error = users.createbyreq(users, users, req_dict)

if error != None:

msg['code'] = crud_error_code

msg['msg'] = error

return JsonResponse(msg)

def users_session(request):

'''

'''

if request.method in ["POST", "GET"]:

msg = {"code": normal_code,"msg":mes.normal_code, "data": {}}

req_dict = {"id": request.session.get('params').get("id")}

msg['data'] = users.getbyparams(users, users, req_dict)[0]

return JsonResponse(msg)

def users_logout(request):

if request.method in ["POST", "GET"]:

msg = {

"msg": "退出成功",

"code": 0

}

return JsonResponse(msg)

def users_page(request):

'''

'''

if request.method in ["POST", "GET"]:

msg = {"code": normal_code, "msg": mes.normal_code,

"data": {"currPage": 1, "totalPage": 1, "total": 1, "pageSize": 10, "list": []}}

req_dict = request.session.get("req_dict")

tablename = request.session.get("tablename")

try:

__hasMessage__ = users.__hasMessage__

except:

__hasMessage__ = None

if __hasMessage__ and __hasMessage__ != "否":

if tablename != "users":

req_dict["userid"] = request.session.get("params").get("id")

if tablename == "users":

msg['data']['list'], msg['data']['currPage'], msg['data']['totalPage'], msg['data']['total'], \

msg['data']['pageSize'] = users.page(users, users, req_dict)

else:

msg['data']['list'], msg['data']['currPage'], msg['data']['totalPage'], msg['data']['total'], \

msg['data']['pageSize'] = [],1,0,0,10

return JsonResponse(msg)

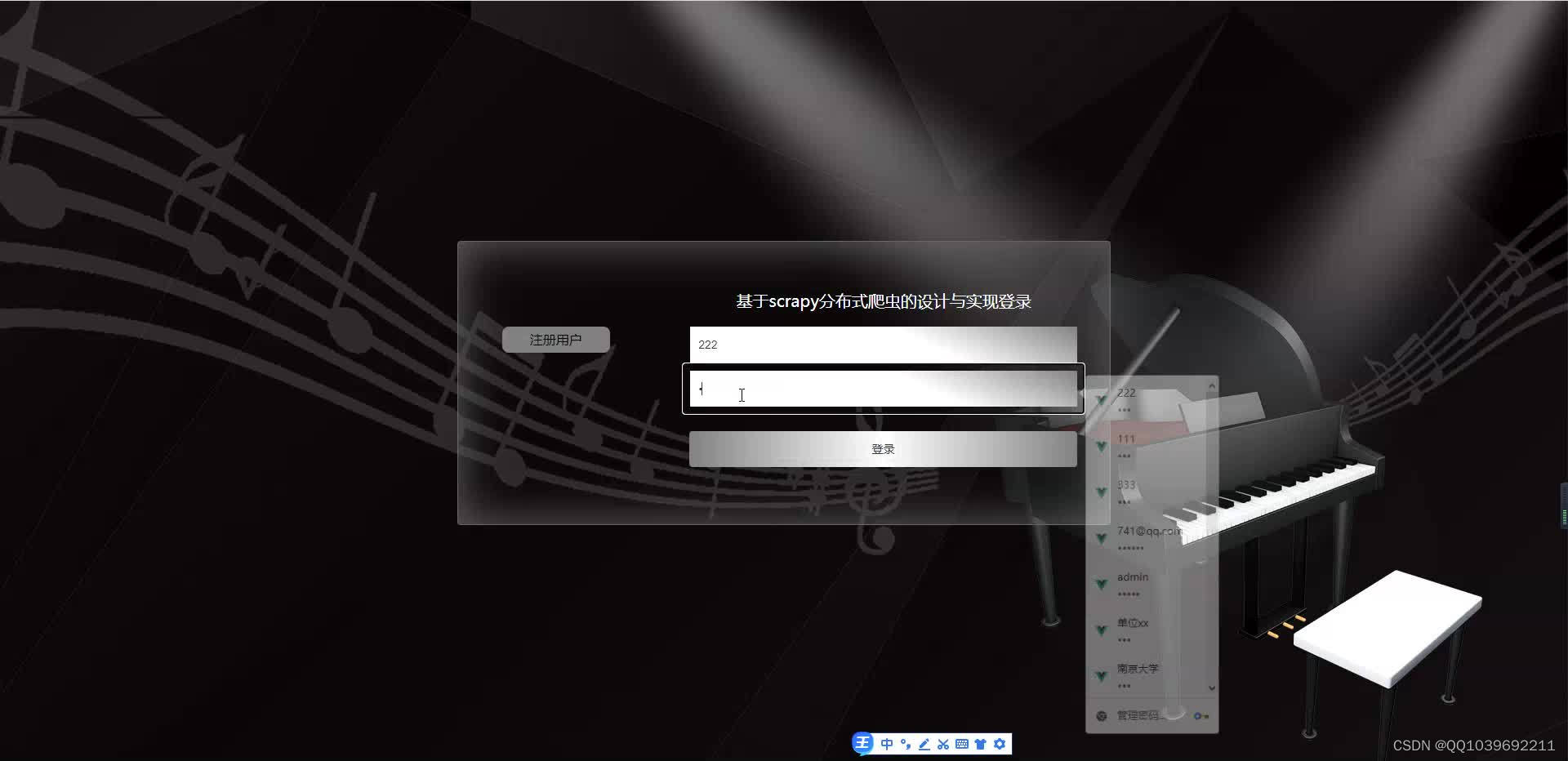

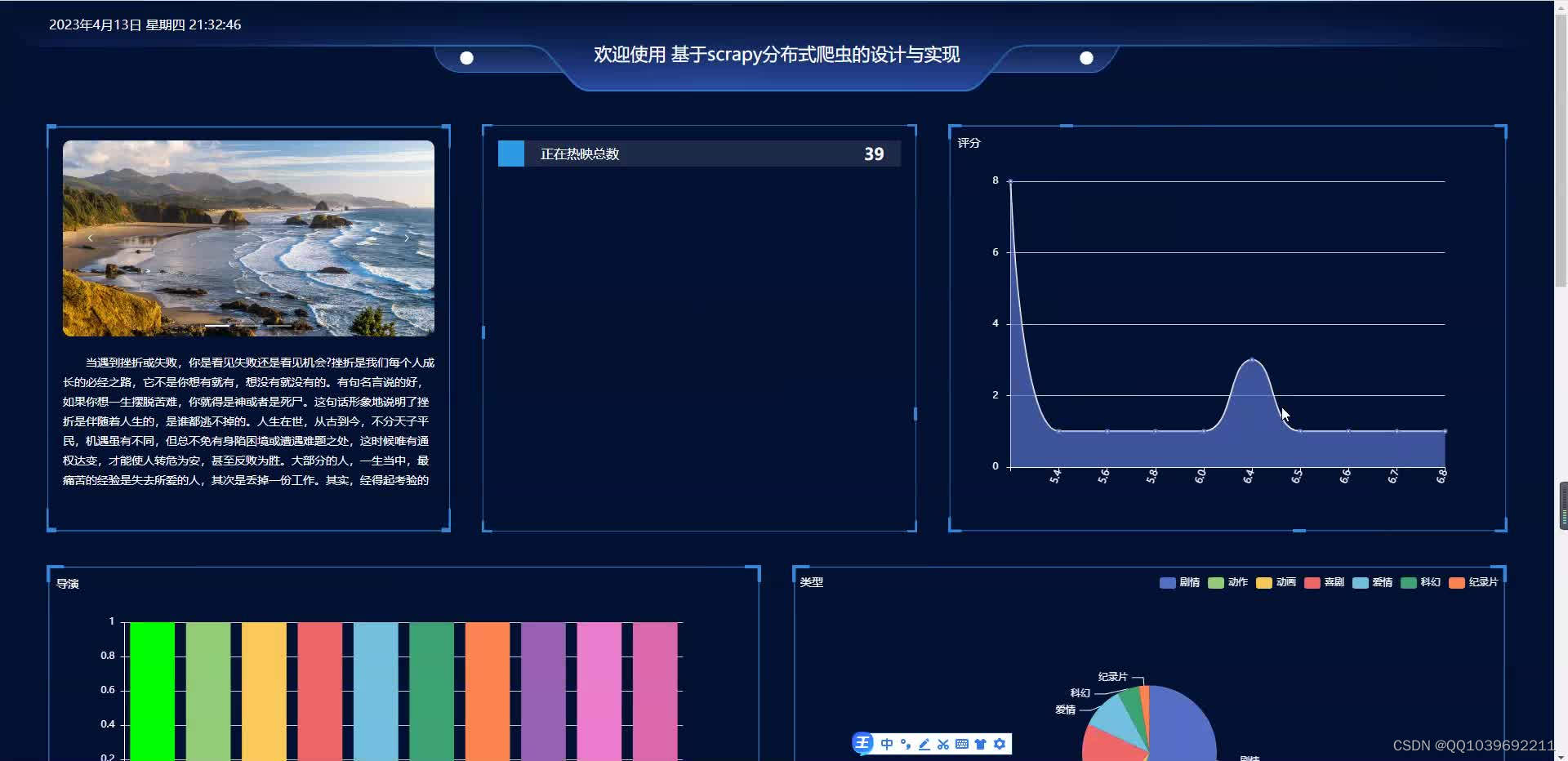

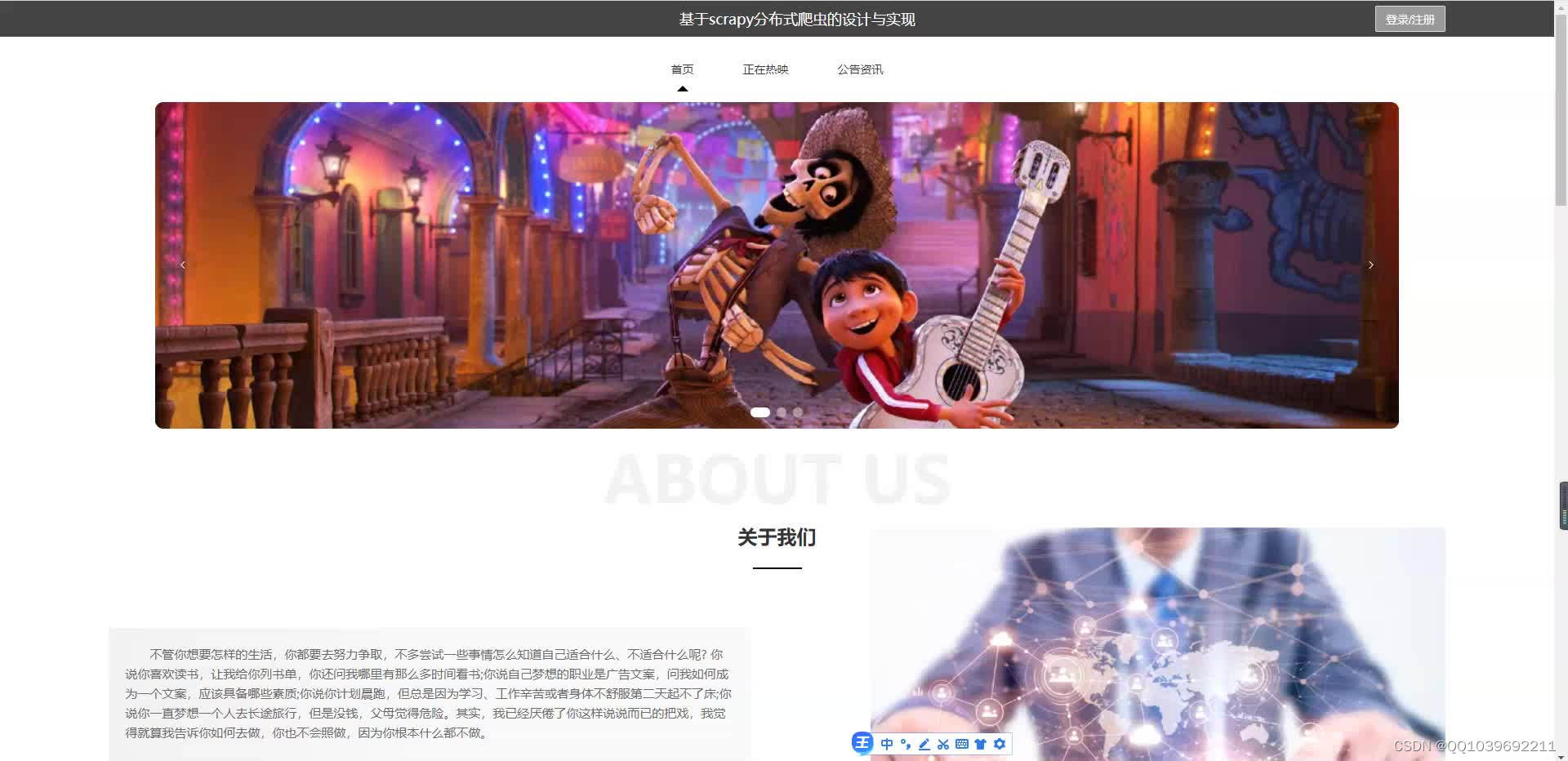

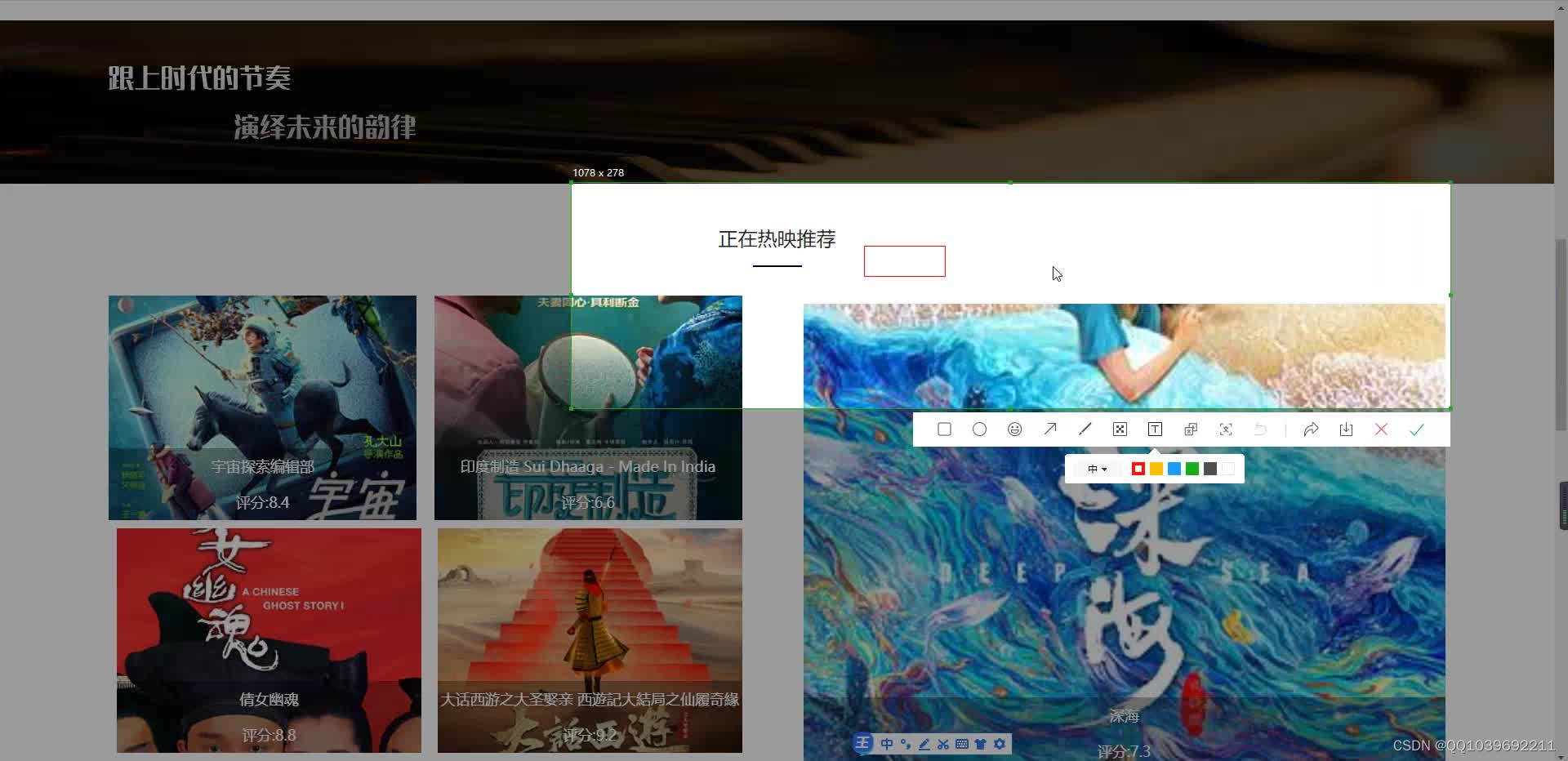

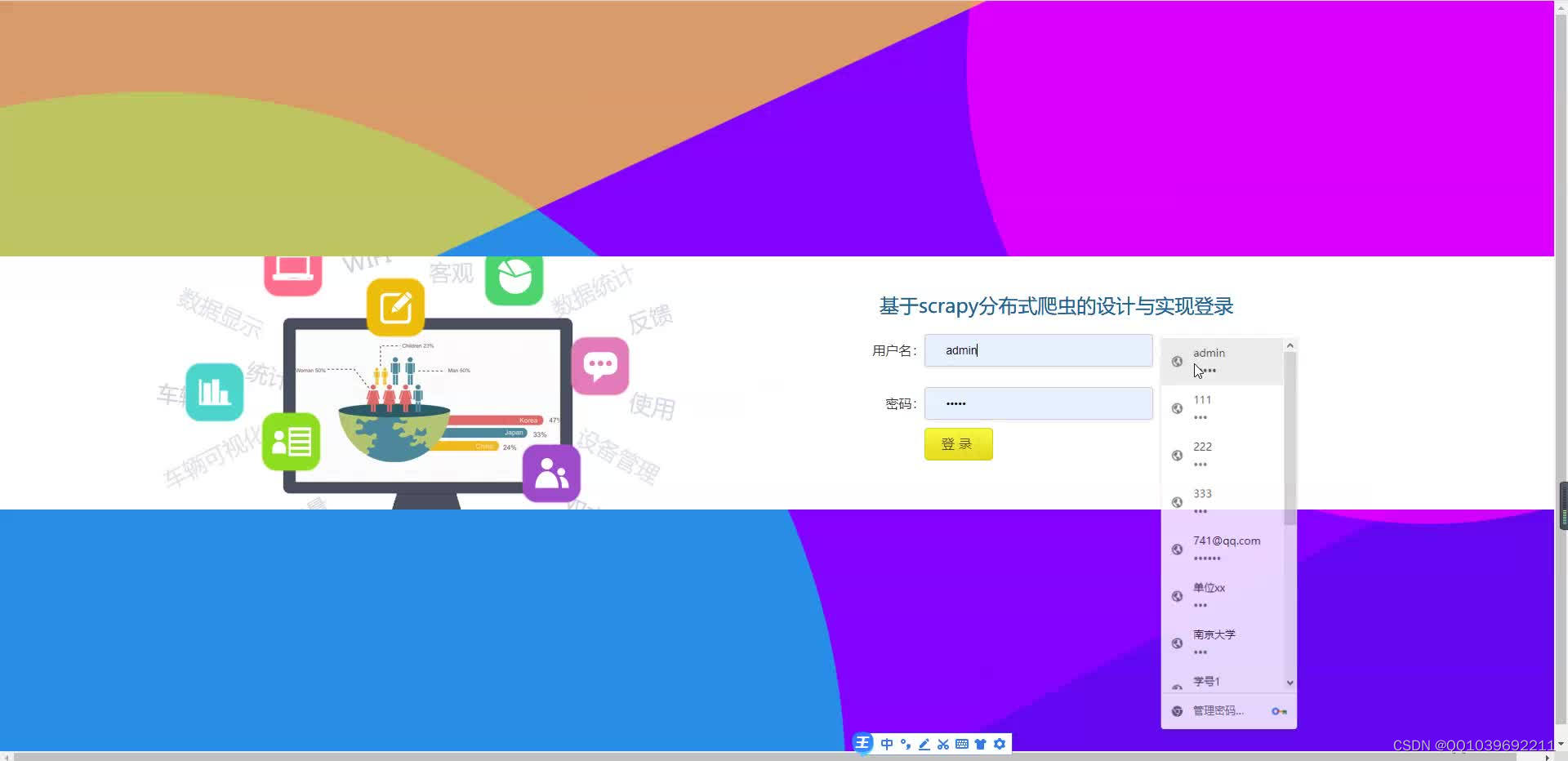

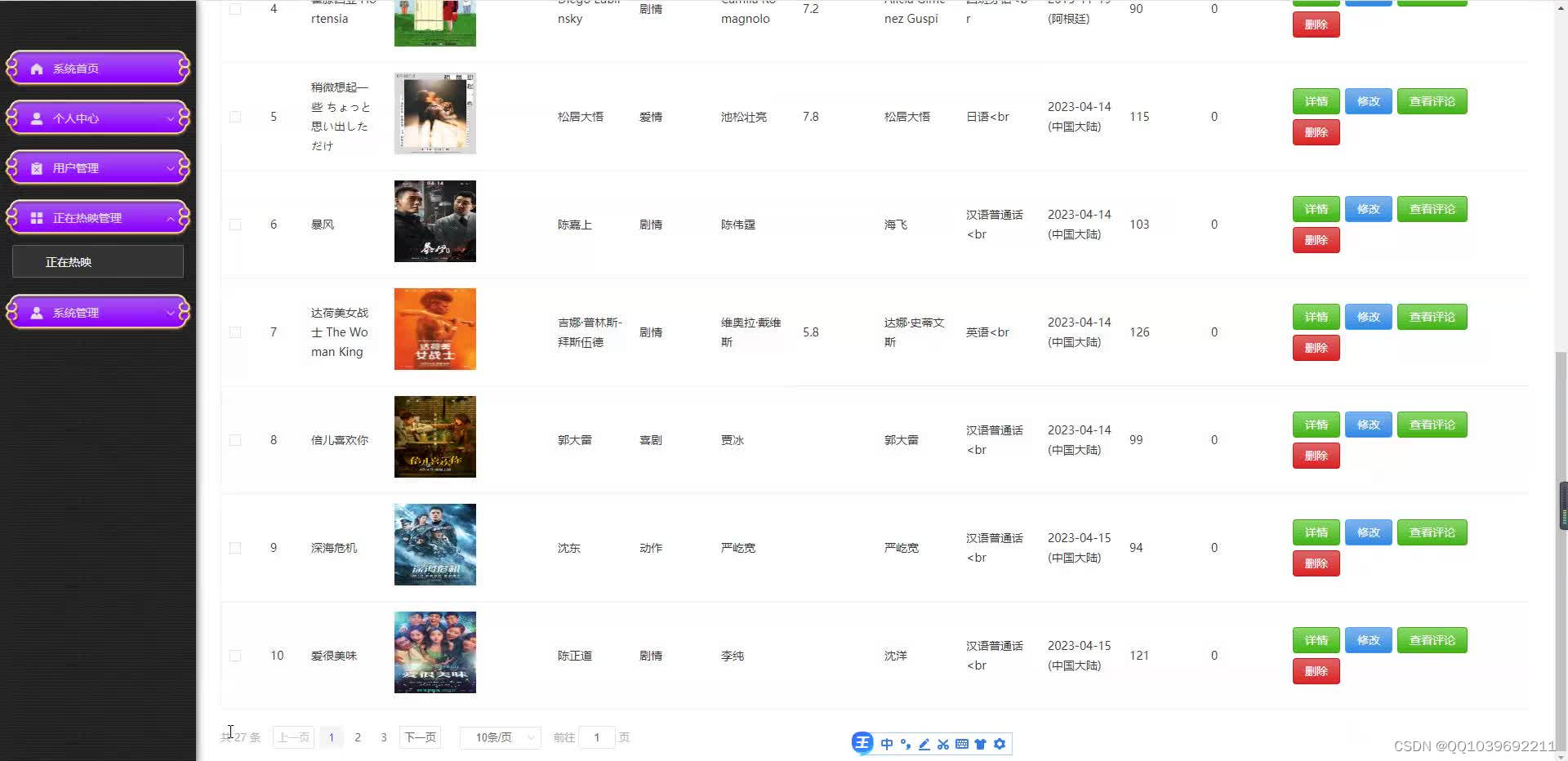

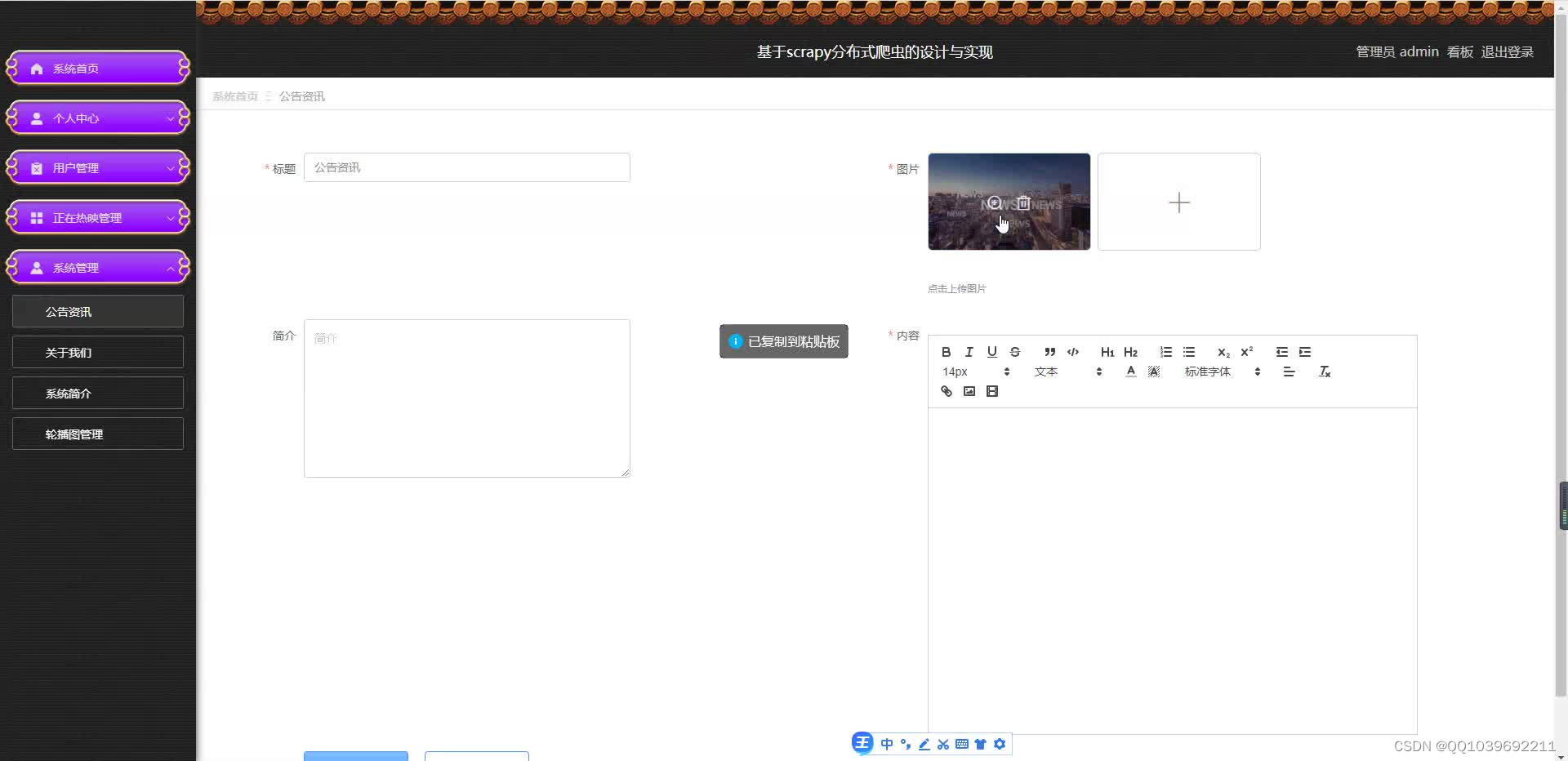

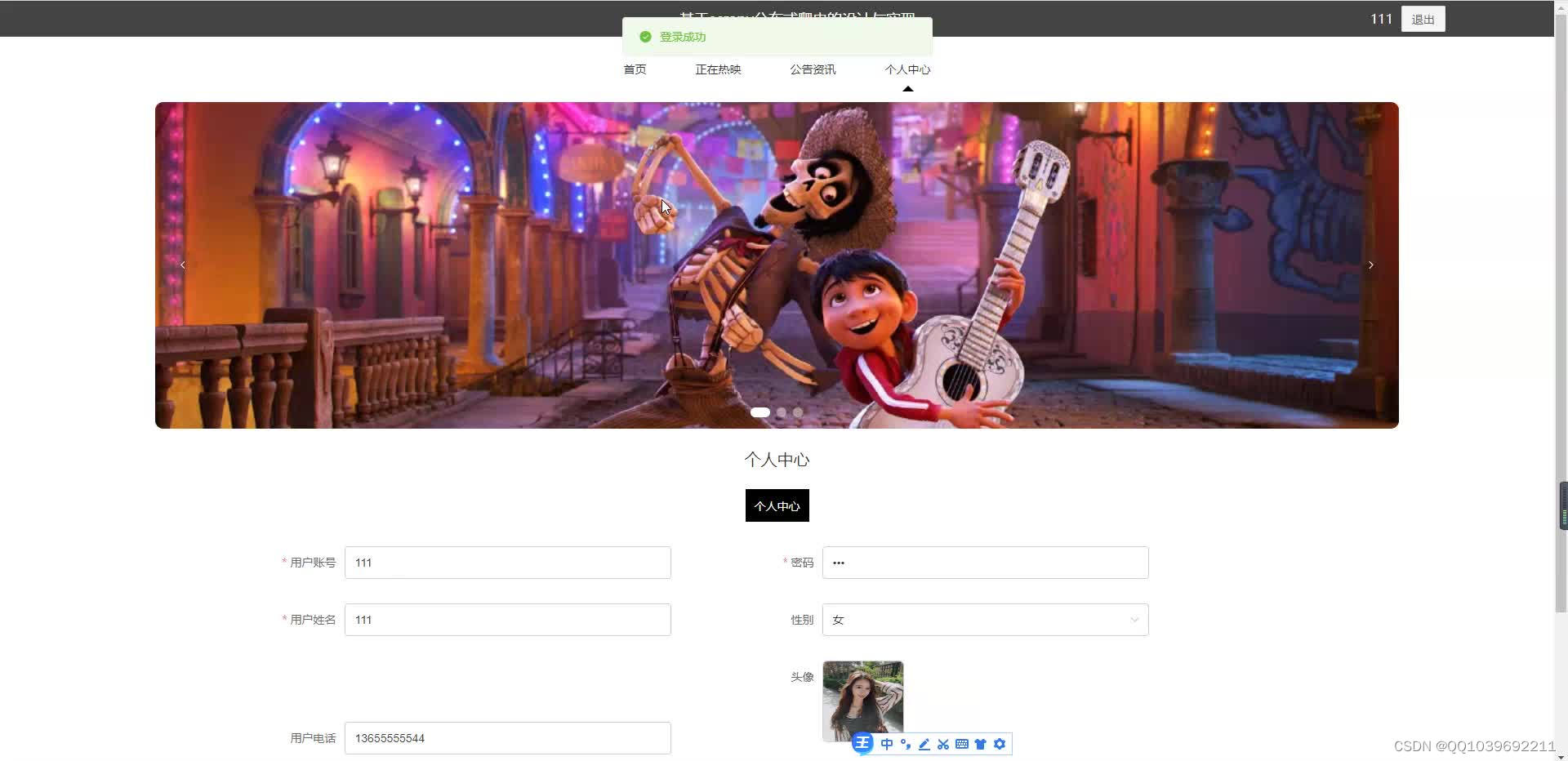

五、效果图

六、文章目录

目 录

摘 要 I

ABSTRACT II

目 录 II

第1章 绪论 1

1.1背景及意义 1

1.2 国内外研究概况 1

1.3 研究的内容 1

第2章 相关技术 3

2.1 Python简介 4

2.2 Django 框架介绍 6

2.3 B/S结构 4

2.4 MySQL数据库 4

第3章 系统分析 5

3.1 需求分析 5

3.2 系统可行性分析 5

3.2.1技术可行性:技术背景 5

3.2.2经济可行性 6

3.2.3操作可行性: 6

3.3 项目设计目标与原则 6

3.4系统流程分析 7

3.4.1操作流程 7

3.4.2添加信息流程 8

3.4.3删除信息流程 9

第4章 系统设计 11

4.1 系统体系结构 11

4.2开发流程设计系统 12

4.3 数据库设计原则 13

4.4 数据表 15

第5章 系统详细设计 19

5.1管理员功能模块 20

5.2用户功能模块 23

5.3前台功能模块 19

第6章 系统测试 25

6.1系统测试的目的 25

6.2系统测试方法 25

6.3功能测试 26

结 论 28

致 谢 29

317

317

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?