金磊 萧箫 发自 凹非寺

量子位 报道 | 公众号 QbitAI

快,着实有点快。

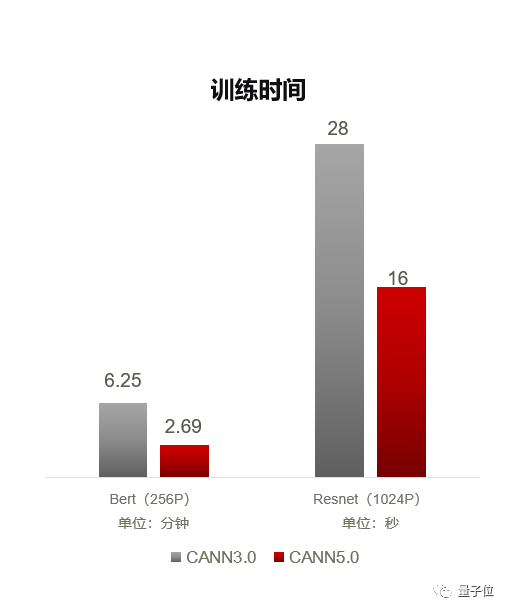

现在,经典模型BERT只需2.69分钟、ResNet只需16秒。

啪的一下,就能完成训练!

这是华为全联接2021上,针对异构计算架构CANN 5.0放出的最新性能“预热”:

4K老电影AI修复,原本需要几天时间,现在几小时就能完成;

针对不同模型进行智能优化,300+模型平均可获得30%性能收益;

支持超大参数模型、超大图片计算,几乎无需手动修改原代码……

不同于训练推理框架,异构计算架构在设计时,还需要兼顾硬件和软件的特点。

为的就是尽可能提升AI模型的计算效率,减少在训练和推理上占用的时间。

它的存在,能让开发者在使用AI模型时,最大程度地发挥硬件的性能。

异构计算架构究竟为什么重要,昇腾CANN 5.0又究竟有哪些特性和优势?

我们对华为昇腾计算业务副总裁金颖进行了采访,从CANN 5.0的功能解读中一探究竟。

为什么需要AI异构计算架构?

首先来看看,AI异构计算架构到底是什么。

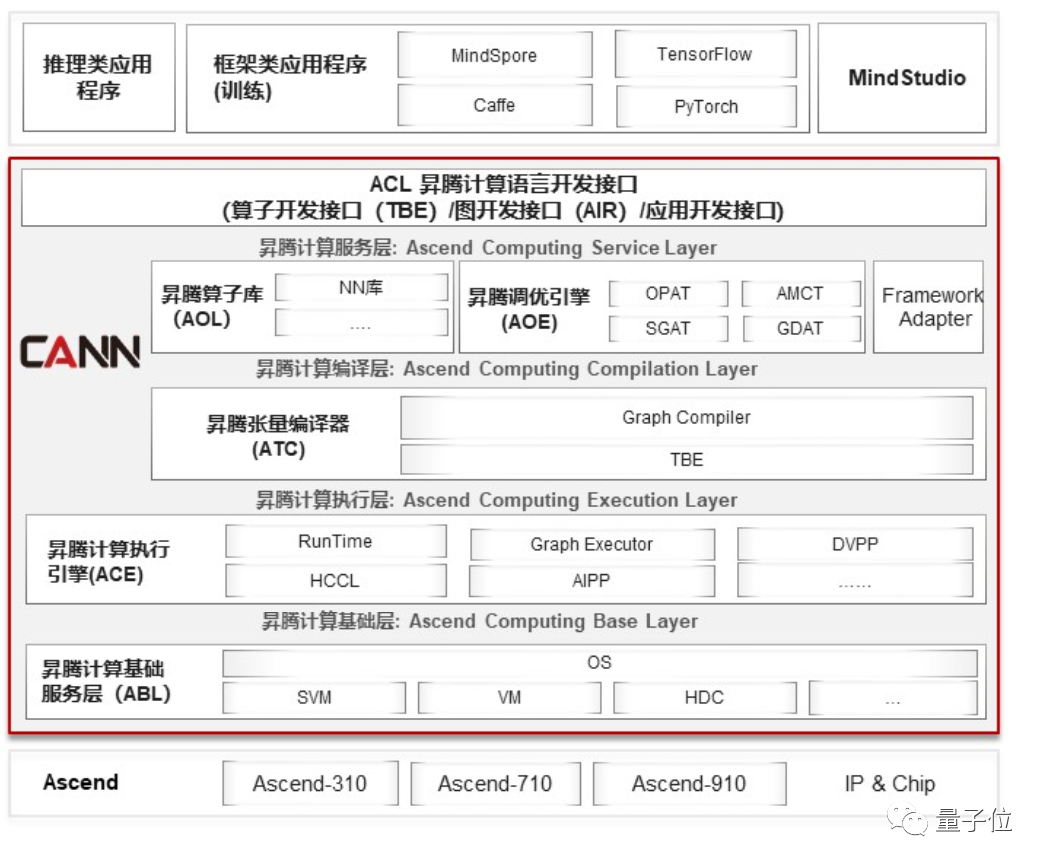

通常做AI模型分两步,先选用一种框架来搭建AI模型,像常见的Caffe、Tensorflow、PyTorch、MindSpore等;再选用合适的硬件(CPU、GPU等)来训练AI模型。

BUT,在AI训练框架和硬件之间,其实还有一层不可或缺的“中间架构”,用来优化AI模型在处理器上的运行性能,这就是AI异构计算架构。

区别于同构计算(同类硬件分布式计算,像多核CPU),异构计算指将任务高效合理地分配给不同的硬件,例如GPU做浮点运算、NPU做神经网络运算、FPGA做定制化编程计算……

面对各种AI任务,AI异构计算架构会充当“引路员”,针对硬件特点进行分工,用“组合拳”加速训练/推理速度,最大限度地发挥异构计算的优势。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2

2

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?