前言

前面我们安装了StandAlone HA模式的spark,但在企业中,最为常用的spark模式是Spark on YARN,如果你已经安装了StandAlone HA,不用担心Spark on YARN的部署需要从头来过,因为它的配置比较简单,所需要的部署条件在 StandAlone模式 就已经满足了。

Spark on YARN部署前提条件:

1. YARN 集群正确安装

2. 具备Spark客户端工具,如spark-submit

3. 具备待提交的代码程序,如官方示例 或 自行开发的程序

如果你是没有部署过StandAlone模式 或 是干净的没有安装过spark的环境,想直接部署Spark on YARN,参考这篇文章即可:

Spark on YARN环境部署(完整版)

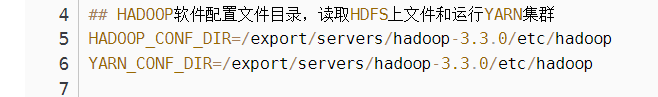

一、环境变量

只需要确保spark-env.sh文件里,有 HADOOP_CONF_DIR 和 YARN_CONF_DIR 这两个环境变量即可,这一步在之前的StandAlone环境部署时,就已经设置好了。

二、连接YARN

连接方式还是之前的那几种,pyspark、spark-shell、spark-submit等,我这里以pyspark为例。

#以yarn模式启动pyspark

bin/pyspark --master yarn

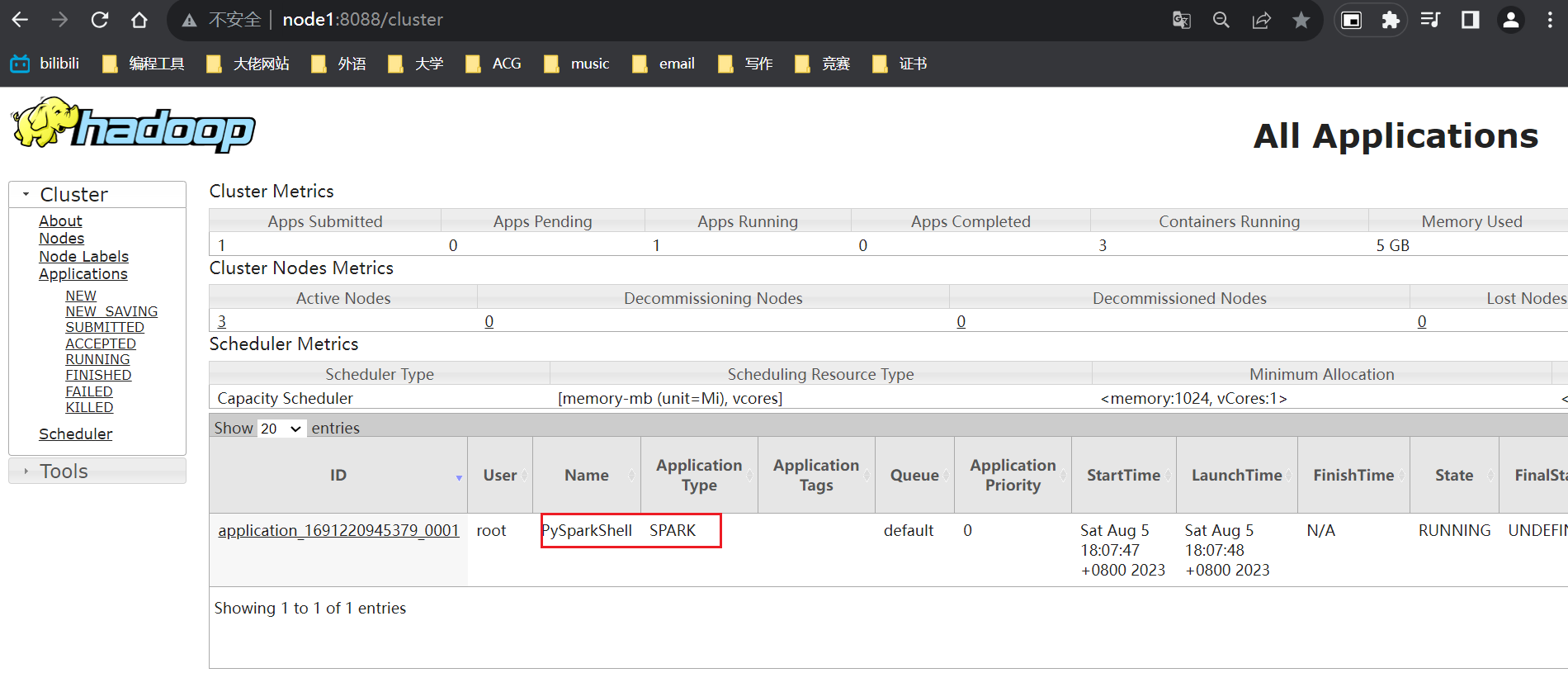

根据返回信息,我们查看一下监控页面

8088是yarn的web UI页面,可以看到刚才启动的pyspark

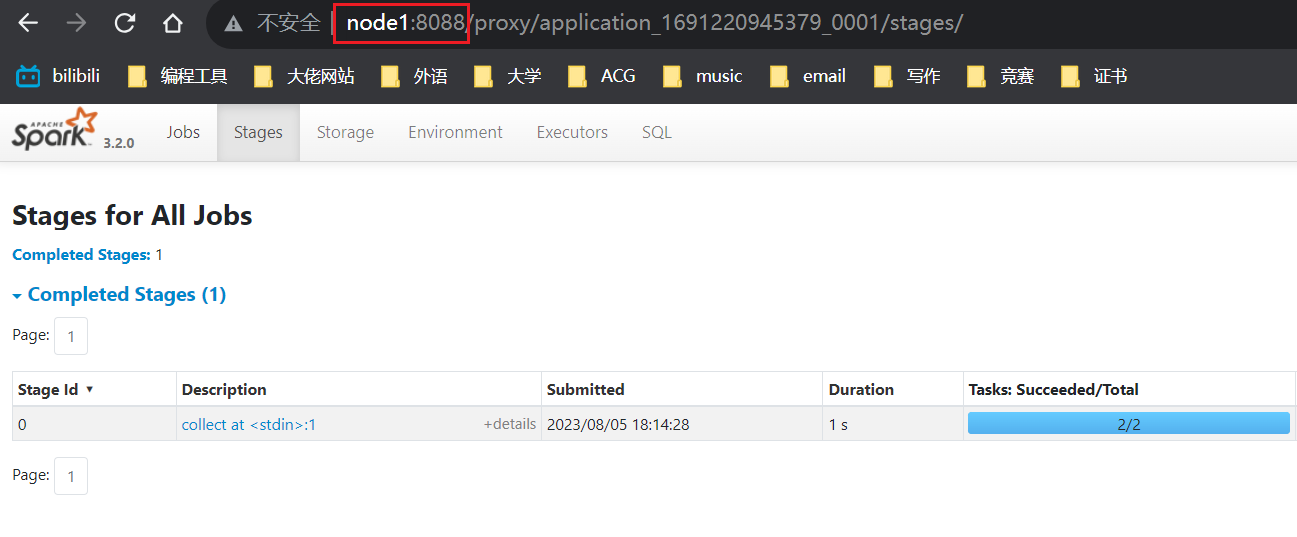

运行的程序,在提交任务之后,4040端口就能被正常访问,这里我们提交一个任务来检验4040端口

sc.parallelize([1,2,3,4,5]).map(lambda x: x*10).collect()

在浏览器上输入node1:4040,得到以下结果

当回车之后,端口号就变为了node1:8088,这不是我们地址输入错了,而是当我们输入4040时,yarn的自动跳转机制(webproxyserver服务)帮我们将页面跳转到Application Master页面上,这也侧面验证了我们的spark是运行在yarn上的。

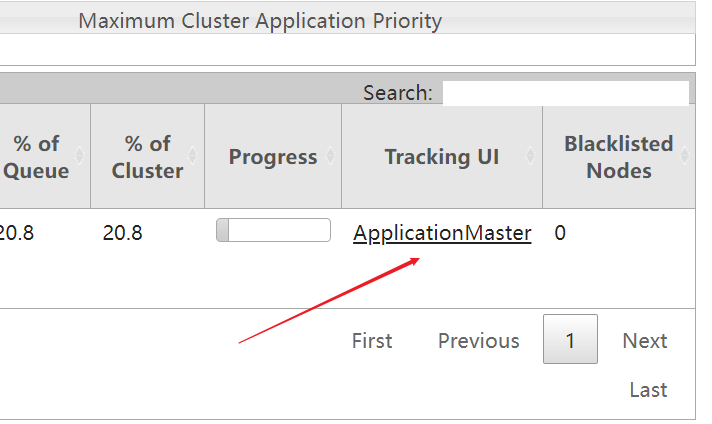

此外,我们也可以不输入node1:4040,直接在8088页面上的右下角,点击如图按钮,也能跳转到刚才的页面。

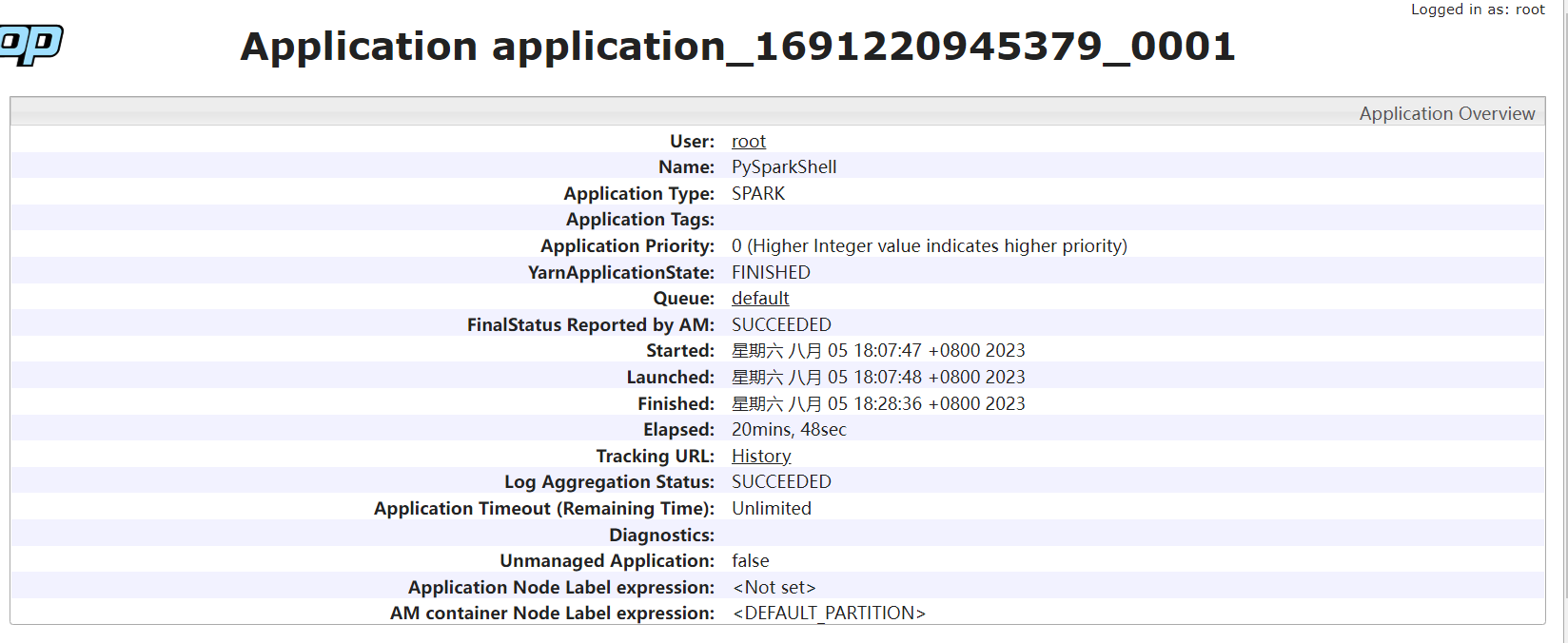

当我们把pyspark结束后,再刷新查看此页面,就成了以下效果,内容很详细

754

754

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?