1、Github监控

GitHub是搞计算机使用较多的平台,有很多项目,我们监控他可以:

(1)便于收集整理最新exp或poc

(POC全称是Proof of Concept,中文译作概念验证。它是专门为了验证漏洞是否真的存在的脚本。而EXP全称是Exploit,中文译作漏洞利用程序。它是对POC验证结果的一种漏洞利用脚本。)

(2)便于发现相关测试目标的资产

创建一个git.py文件:

# Title: wechat push CVE-2020

# Date: 2020-5-9

# Exploit Author: weixiao9188

# Version: 4.0

# Tested on: Linux,windows

# cd /root/sh/git/ && nohup python3 /root/sh/git/git.py &

# coding:UTF-8

import requests

import json

import time

import os

import pandas as pd

time_sleep = 60 # 每隔 20 秒爬取一次

while (True):

headers1 = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko)Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3741.400 QQBrowser/10.5.3863.400"}

# 判断文件是否存在

datas = []

response1 = None

response2 = None

if os.path.exists("olddata.csv"):

# 如果文件存在则每次爬取 10 个

df = pd.read_csv("olddata.csv", header=None)

datas = df.where(df.notnull(), None).values.tolist()

# 将提取出来的数据中的 nan 转化为 None

requests.packages.urllib3.disable_warnings()

response1 = requests.get(url="https://api.github.com/search/repositories?q=CVE-2020&sort=updated&perpage = 10",headers=headers1,verify=False)

response2 =requests.get(url="https://api.github.com/search/repositories?q=RCE&ssort=updated&per_page=10", headers = headers1, verify = False)

else:

# 不存在爬取全部

datas = []

requests.packages.urllib3.disable_warnings()

response1 = requests.get(url="https://api.github.com/search/repositories?q=CVE-2020&sort=updated&order=desc",headers=headers1, verify=False)

response2 =requests.get(url="https://api.github.com/search/repositories?q=ctcms&ssort=updated&order=desc", headers=headers1,verify=False)

data1 = json.loads(response1.text)

data2 = json.loads(response2.text)

for j in [data1['items'], data2['items']]:

for i in j:

s = {"name": i['name'], "html": i['html_url'], "description": i['description']}

s1 = [i['name'], i['html_url'], i['description']]

if s1 not in datas:

# print(s1)

# print(datas)

params = {

"text": s["name"],

"desp": "链接:" + str(s["html"]) + "\n简介" + str(s["description"])

}

print("当前推送为" + str(s) + "\n")

# print(params)

requests.packages.urllib3.disable_warnings()

requests.get("https://sct.ftqq.com/SCT185331TtMYVH3JjRXBysR1eY4U7pb7N.send", params=params, headers=headers1, timeout=10, verify=False)

time.sleep(1)

# 以防推送太快

print("推送成功!\n")

datas.append(s1)

else:

pass

print("数据已经存在!")

pd.DataFrame(datas).to_csv("olddata.csv", header=Nonne, Index=None)

time.sleep(time_sleep)

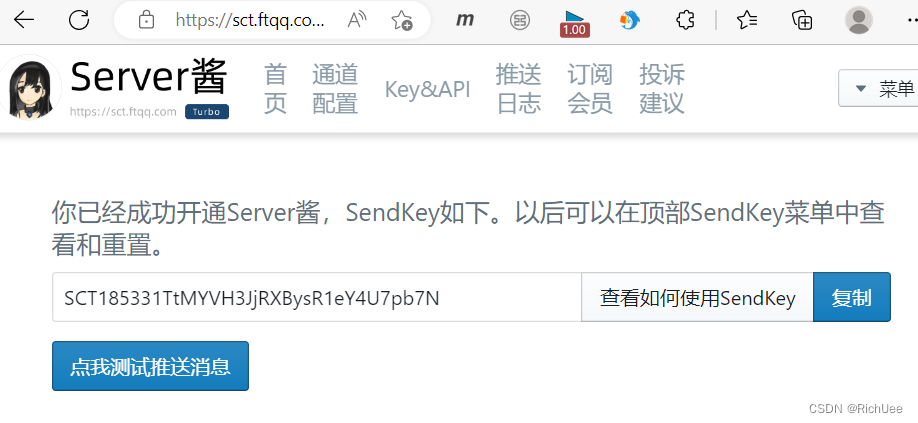

注册server酱

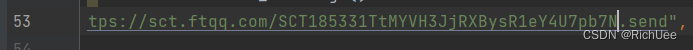

修改此行代码:

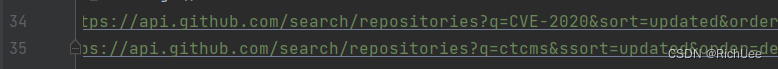

监控CVE-2020和ctcms:

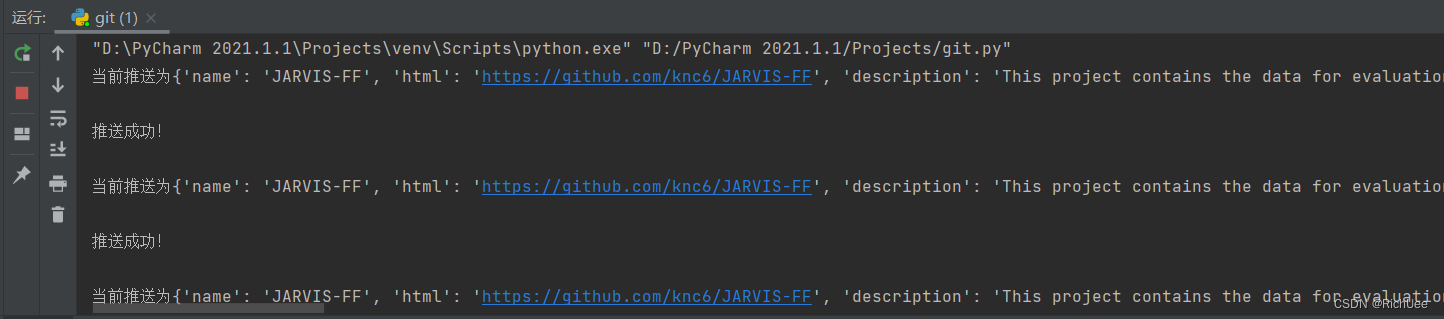

运行git.py:

2、各种子域名查询

(1)通过DNS解析记录

看域名上曾经有哪些东西被解析过。

(2)通过HTTPS证书日志搜集

通过证书也可以查到域名信息;

(3)通过搜索引擎

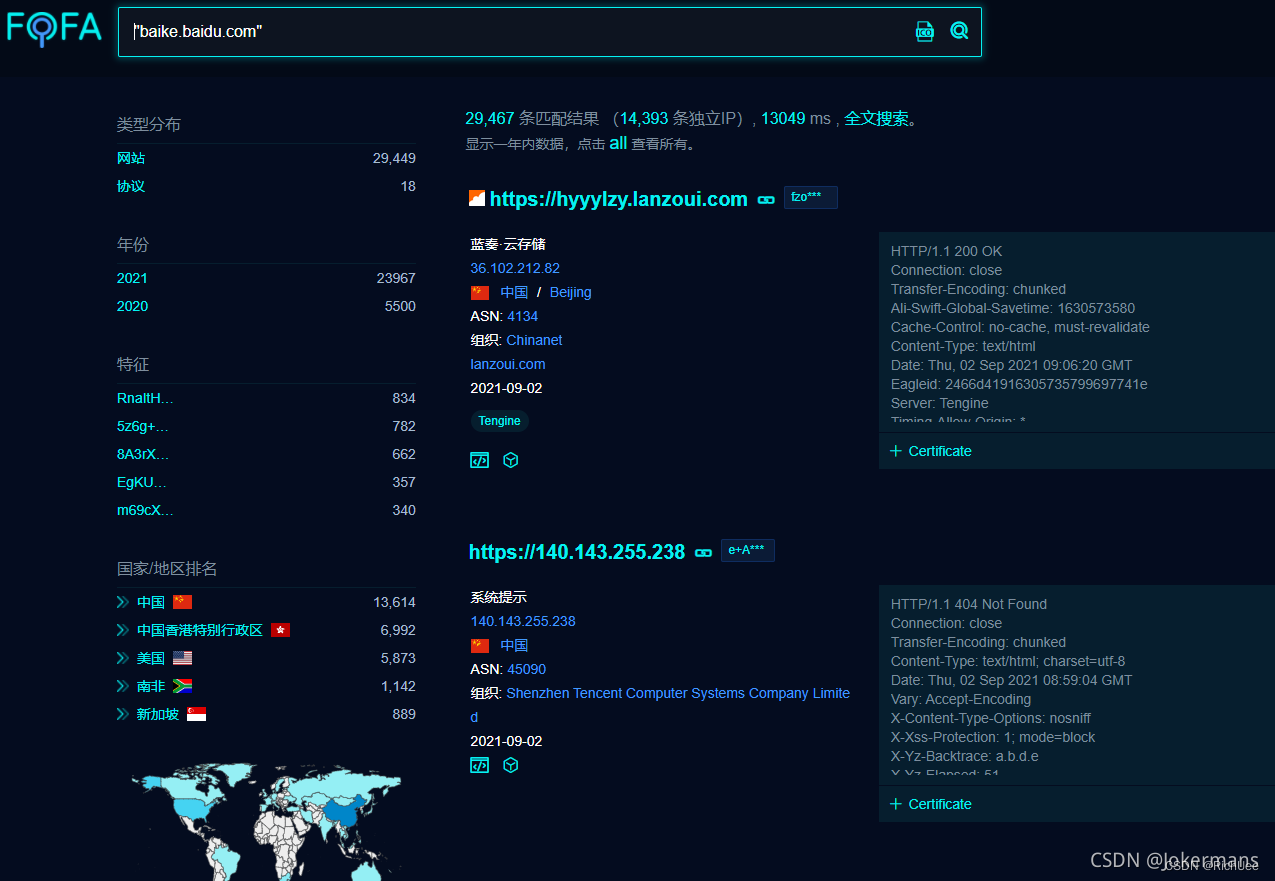

比如谷歌、百度这种正经点的搜索网站,或者使用fofa、shodan、zoomeye等这些黑暗引擎来查询一些信息;

黑暗引擎实现域名端口收集

fofa好用但是要付费

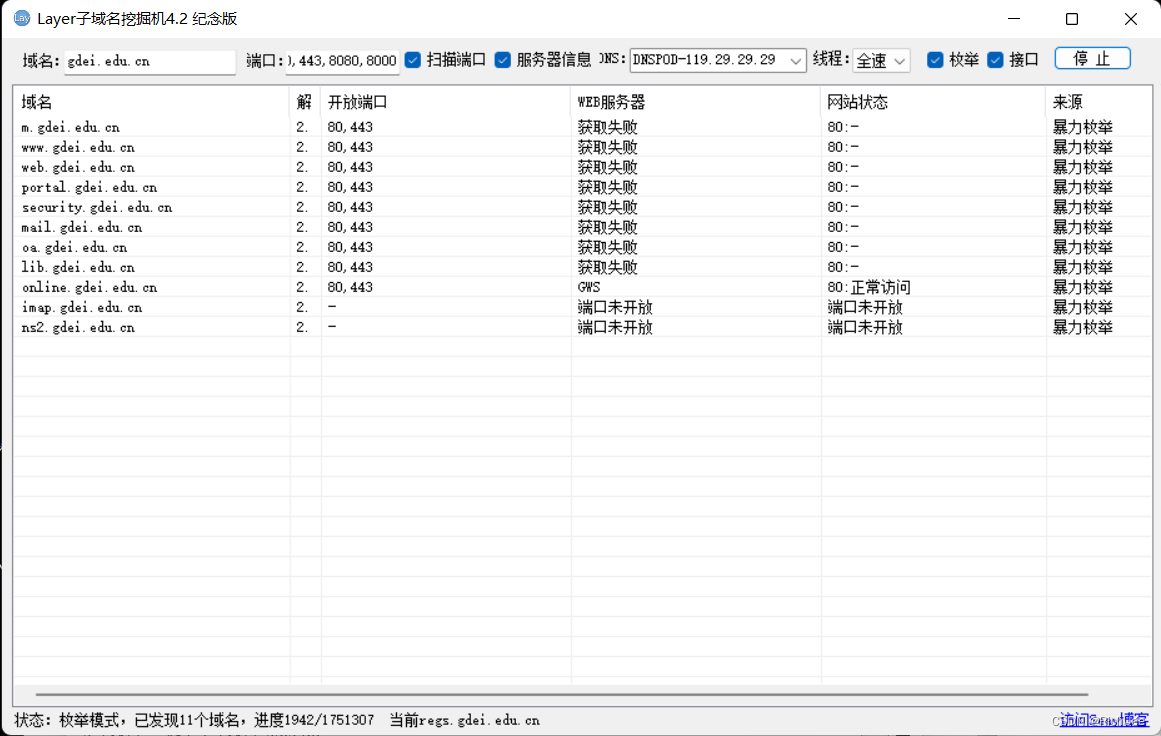

(4)枚举

就是采用暴力破解,关键是字典、速度—多线程、dns服务器选择;

(5)利用漏洞

不常使用,讲解较少;

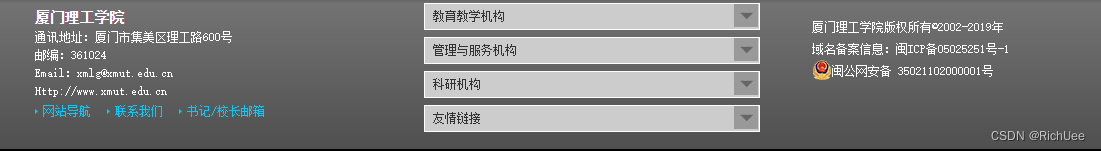

(6)从主站爬取

在一些网站的下面会有一些导航,这个导航可能会把一些网站的子域名导航出来;

(7)whois查询和关联查询

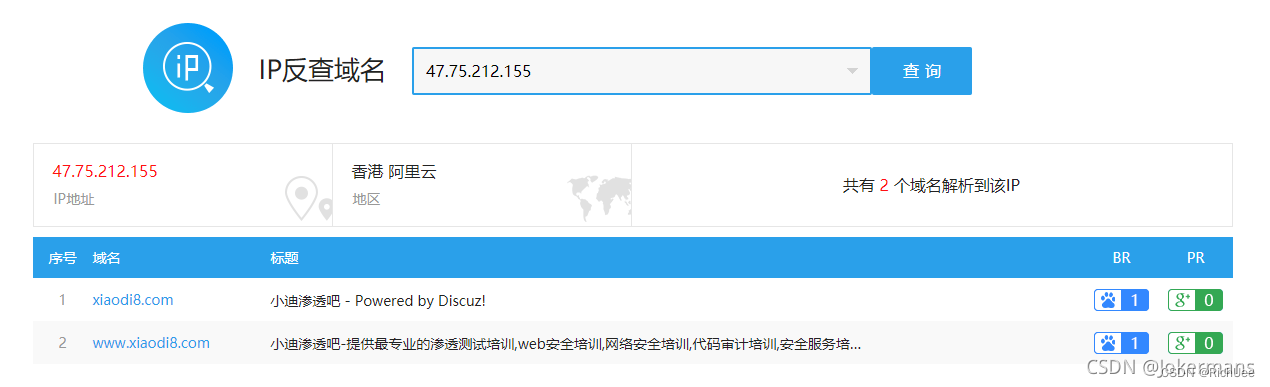

(8)IP反查域名

(9)全自动域名收集脚本

下载地址:提莫

3、DNS,备案,证书

4、全球节点请求cdn

用国外地址去找真实ip:IPIP

枚举爆破或解析子域名对应

用layer查询二级域名

5、SRC目标中的信息收集全覆盖

补天上SRC上简易测试

查地区ip:OPENGPS

635

635

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?