一、背景

目前实时数仓提供的投放实时指标优先级别越来越重要,特别下游为规则引擎提供的数仓数据,直接对投放运营的广告投放产生直接影响,数据延迟或者异常均可能产生直接或者间接的资产损失;从投放管理平台的链路全景图投放全景图来看,目前投放是一个闭环的运行流程,实时数仓处于数据链路中的关键节点,实时数据直接支持规则引擎的自动化操作,以及投放管理平台的手动控盘;实时节点事故,将可能导致整个投放链路无法正常运行;为使投放链路达到99.9%的稳定性,需要对链路任务做相关的稳定性提升,优先级提升。

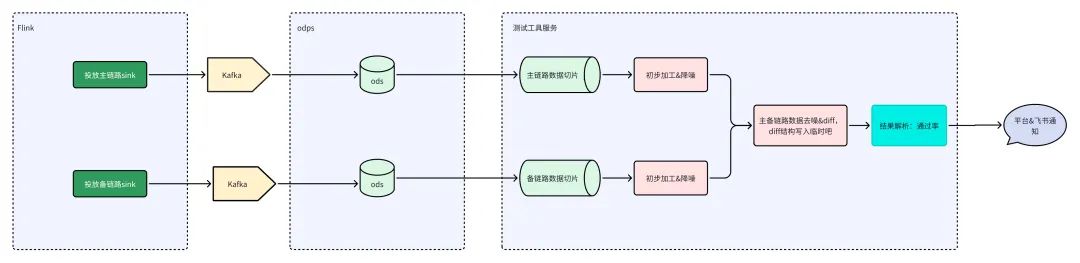

研发测试综合评估方案对投放实时链路增加一条备链路,投放需求迭代,通过备链路进行迭代修改,完成修改后进行主备链路Diff,确保Diff通过率99.9%,即可上线。

二、实现方案

- 数据准备:主备链路产出的数据分别实时写入到ODPS中。

- 数据采集:测试工具服务同时采集主备链路数据切片,保留2份同一个时间周期的数据。

- 数据降噪&Diff:工具采集数据后将进行第一步的降噪处理;主备数据开始对比&第二步降噪处理。

- 数据Diff结果:加工数据对比的结果,判断出每个字段的差异量,再最终判断出整体数据的差异量,给出结果。

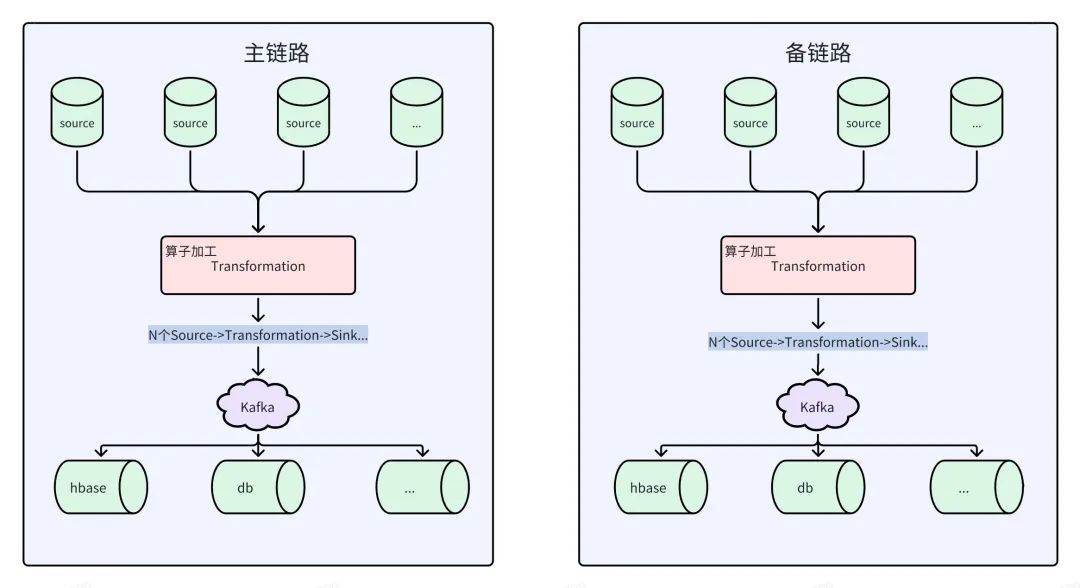

三、搭建主备链路

实时链路解释:源头数据写入Kafka,Flink消费Kafka数据作为数据源(Source),结合属性字段做算子加工处理(Transformatin),处理结果写入Kafka(Sink),做下一步处理。经过一个个Flink任务节点加工分流到应用数据库中。

四、数据准备-数据切片

时间窗口切片

根据测试时间点,进行切片,取当天0点~执行时间段数据进行固定,确保数据不再更新。

业务场景切片

不同业务场景迭代进行切片,下发数据流提供多种下游场景数据,针对发生迭代的业务场景数据进行切片固定。如:fields_a='b'

五、主备链路数据Diff-去噪

数据漂移问题

问题现象:数据流在不断更新,同一条业务数据的数据流更新的最新的一条,主链路可能进入当天分区中,备链路可能进入到第二天分区中。

去噪方案:数据流取末尾1条数据。

数据更新频率问题

问题现象:同一条业务数据在更新过程中,主链路可能发生了10次更新,后面五次数据不发生改动,备链路只发生了5次更新。

去噪方案:同一个业务数据取数据流的N条数据。

数据更新时效问题

问题现象:同一条业务数据更新过程中,主链路更新三个数据为11.68、12.9、13.05;备链路更新三个数据为11.68、12.9、13.1;可以看出后面1次更新的数据并不一样。

去噪方案:同一个业务数据的数据流融合成一个list,主备相互判断末尾数据是否存在于对方截取的数据流list中。

属性字段值不统一问题

问题现象:存在空字符和null、0和0.0的情况,Diff结果为不通过,实际业务含义是OK的。

去噪方案:统一转换后进行Diff。

主备链路message字段解析属性字段不一致问题

问题现象:message字段存储数据JSON格式。同一条业务数据,主备链路解析的JSON对应的属性字段并不是完全一致的,两者之间存在差异。

去噪方案:通过代码解析出全量的属性字段,确保可以完全Diff。

message范本:

{"fields_a":"20230628","fields_b":"2023-06-22 19:48:24","fields_c":"2","fields_d":"plan","fields_e":"3******","fields_f":"0.0","fields_g":"2","fields_h":"4*****","fields_i":"ext","fields_j":"binlog+odps","fields_k":"2","fields_l":"STATUS_*****","fields_m":"1********","fields_n":"孙**","fields_o":"2023-06-28T22:19:43.872"}

转换JSON:

{

"fields_a": "20230717",

"fields_d": "plan",

"fields_e": "3******",

"fields_aj": "33761.125",

"fields_p": "37934.0",

"fields_r": "1250.412",

"fields_s":

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

721

721

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?