我们通过命令bin/hdfs dfs -cat /xxx.log查看一个文件的时候,对于NN、DN之间的操作我们是无感知的,具体中间都发生了什么,下面来简单描述一下。

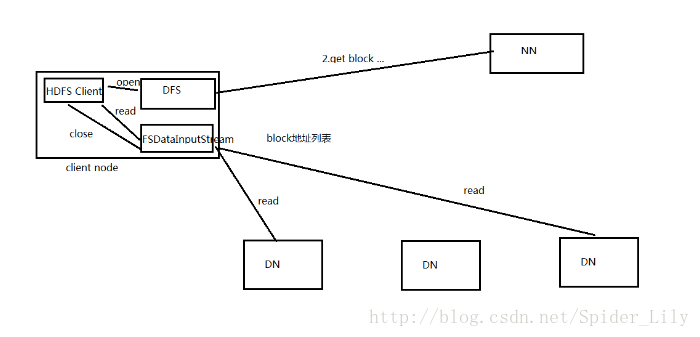

读操作

操作步骤:

1、Client通过FileSystem.open(filePath)方法,去与NameNode进行RPC通信,返回该文件的部分或全部的block列表(也包含该列表各block分布在DataNode地址的列表),返回FSDataInputStream对象;

2、Client调用FSDataInputStream对象的read()方法

2.1)、去与第一块的最近的DataNode进行read,读取完后,会check,假如successful,会关闭与当前DataNode通信;(假如check fail,会记录失败的块+DataNode信息,下次就不会读取;然后会去该快的第二个DataNode地址读取)

2.2)、然后去第二个块的最近的DataNode上进行读取,check后,会关闭与此DataNode的通信;

2.3)、如果block列表读取完了,文件还未结束,那么FileSystem会从NameNode获取下一批的block的列表。(读操作对于Client端是透明的,感觉就是连续的数据流)

3、Client调用FSDataInputStream.close()方法,关闭输入流。

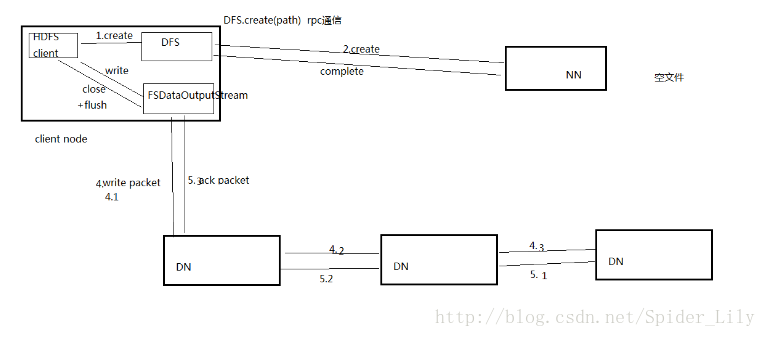

写操作

综合描述:

客户端要向HDFS写数据,首先和NameNode通信,确认可以写文件并获得接受文件block的DataNode,然后客户端按顺序将文件逐个block上传给相应的DataNode,并由接受到block的DataNode负责向其他DataNode复制block副本。

操作步骤:

1、Client调用FileSystem.create(filePath)方法,与NameNode进行RPC通信,check该路径的文件是否存在以及有没有权限创建该文件,如果都ok,就创建一个新文件,但是并不关联任何block,返回一个FSDataInputStream对象;(如果都不ok,就返回错误信息,所以要try-catch);

2、Client调用FSDataInputStream对象的write() 方法,会将第一个块写入第一个DataNode,第一个DataNode写完传给第二个节点,第二个写完传给第三个节点,当第三个节点写完返回一个ack packet给第二个节点,第二个返回一个ack packet给第一个节点,第一个节点返回ack packet给FSDataInputStream对象,意思标识第一个块写完,副本数为3,剩余的block依次这样写;

3、当向文件写入数据完成后,Client调用FSDataIputStream.close()方法,关闭输出流,flush缓存区的数据包;

4、再调用FileSystem.complete()方法,告诉NameNode节点写入成功。

1800

1800

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?