最后一章学习 Spark安装与配置以下是实验步骤

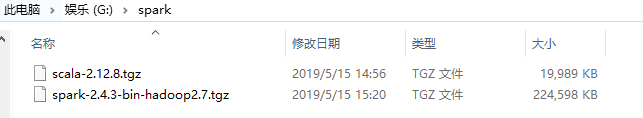

一、在Windows下下载Scala和Spark

官网下载安装Spark:spark-2.4.2-bin-hadoop2.7.tgz

官网下载安装Scala: https://www.scala-lang.org/download/

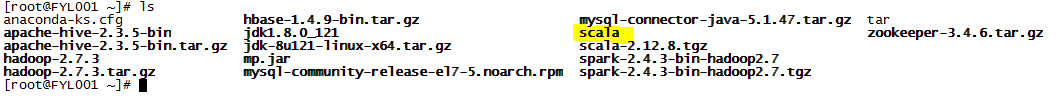

二、将压缩包从Windows传输到Linux当前目录下:

put G:\spark\scala-2.12.8.tgz

put G:\spark\spark-2.4.3-bin-hadoop2.7.tgz

三、解压

tar -zxvf scala-2.12.8.tgz -C /home/shui

tar -zxvf spark-2.4.3-bin-hadoop2.7.tgz -C /home/shui

四、重命名

(1)把scala-2.12.8 重命名为 scala

运行命令

mvs cala-2.12.8 scala

(2)把 spark-2.4.3-bin-hadoop2.7 重命名为 spark

运行命令

mv spark-2.4.3-bin-hadoop2.7 spark

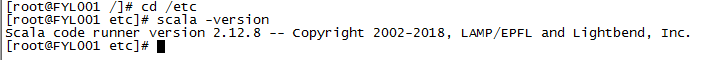

四、测试

scala -version

五、

1

实验七 Spark安装与配置

最新推荐文章于 2023-10-23 22:32:47 发布

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2664

2664

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?