目录

1、简单了解

-

$*表示传递给函数或脚本的所有参数,被双引号""包含时,“$*”会将所有的参数作为一个整体

-

延时函数

sleep,默认以秒为单位,也可以自己指定延迟的单位。sleep 1s 延迟一秒

sleep 1m 延迟一分钟

sleep 1h 延迟一小时

sleep 1d 延迟一天

2、脚本源码

#!/bin/bash

USAGE="使用方法:sh ha-hadoop.sh start/stop/status"

if [ $# -ne 1 ];then

echo $USAGE

exit 1

fi

SHELL_ZK=/home/xiaokang/bin/zk.sh

HADOOP_HOME=/opt/software/hadoop-2.7.7

NODES=("hadoop01" "hadoop02" "hadoop03")

case $1 in

"start")

#启动zookeeper集群

sh $SHELL_ZK start

sleep 4s

#开始启动ha-hadoop集群

for NODE in ${NODES[*]};do

echo "--------$NODE启动ha-hadoop集群--------"

if [ "hadoop01" = $NODE ];then

ssh $NODE "$HADOOP_HOME/sbin/start-dfs.sh && $HADOOP_HOME/sbin/mr-jobhistory-daemon.sh start historyserver"

fi

if [ "hadoop02" = $NODE ];then

ssh $NODE "$HADOOP_HOME/sbin/yarn-daemon.sh start resourcemanager"

fi

if [ "hadoop03" = $NODE ];then

ssh $NODE "$HADOOP_HOME/sbin/start-yarn.sh"

fi

done

;;

"stop")

#开始停止ha-hadoop集群

for NODE in ${NODES[*]};do

echo "--------$NODE停止ha-hadoop集群--------"

if [ "hadoop01" = $NODE ];then

ssh $NODE "$HADOOP_HOME/sbin/stop-dfs.sh && $HADOOP_HOME/sbin/mr-jobhistory-daemon.sh stop historyserver"

fi

if [ "hadoop02" = $NODE ];then

ssh $NODE "$HADOOP_HOME/sbin/yarn-daemon.sh stop resourcemanager"

fi

if [ "hadoop03" = $NODE ];then

ssh $NODE "$HADOOP_HOME/sbin/stop-yarn.sh"

fi

done

#停止zookeeper集群

sh $SHELL_ZK stop

;;

"status")

for NODE in ${NODES[*]};do

echo "--------$NODE查看ha-hadoop集群进程--------"

ssh $NODE "jps"

done

;;

*)

echo $USAGE

;;

esac

echo "----------------------------------------------------------------------------------------"

echo "--------ha-hadoop.sh脚本执行完成!--------"

3、测试使用

# 修改脚本权限

[xiaokang@hadoop01 bin]$ chmod 777 ha-hadoop.sh

执行方式:

# 方式一

[xiaokang@hadoop01 bin]$ ./ha-hadoop.sh start

# 方式二

[xiaokang@hadoop01 bin]$ sh ha-hadoop.sh start

# 方式三

# 1.将shell脚本所在目录配置为环境变量(/etc/profile),记得source生效

export SHELL_HOME=/home/xiaokang/bin

export PATH=${JAVA_HOME}/bin:${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:${ZOOKEEPER_HOME}/bin:${HIVE_HOME}/bin:${HBASE_HOME}/bin:${KYLIN_HOME}/bin:${KAFKA_HOME}/bin:${SCALA_HOME}/bin:${SCALA_HOME}/sbin:${SPARK_HOME}/bin:${SHELL_HOME}/:$PATH

# 2.在任意目录都可以使用自己编写的shell脚本

[xiaokang@hadoop01 ~]$ ha-hadoop.sh start

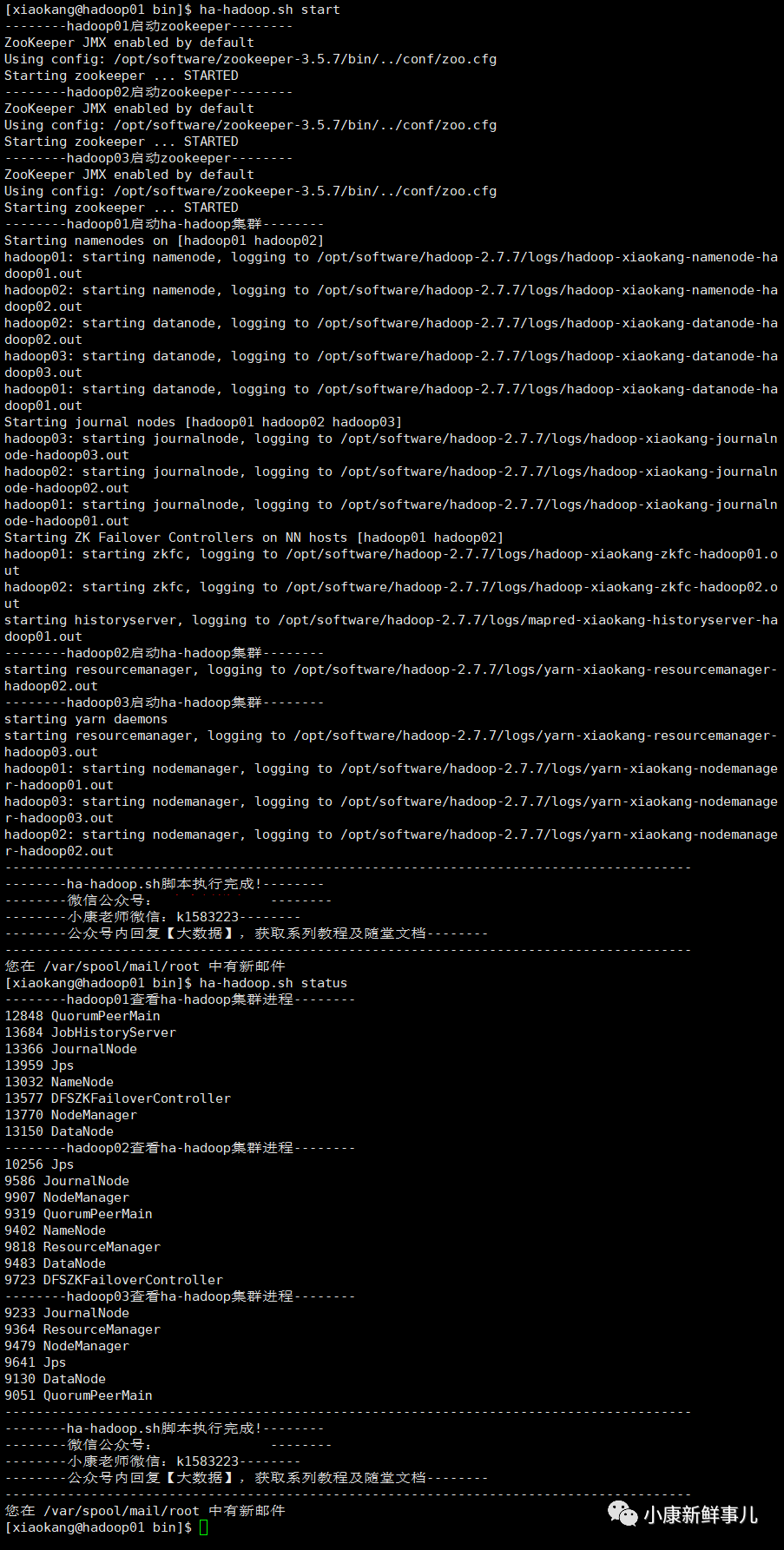

使用脚本进行启动和查看进程测试,成功如下图所示:

195

195

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?